DeepSeekがApp Storeで首位独占、中国AIが米国テック業界に地震を起こした1週間

TechFlow厳選深潮セレクト

DeepSeekがApp Storeで首位独占、中国AIが米国テック業界に地震を起こした1週間

DeepSeekモデルがシリコンバレーを震撼させ、その価値はさらに上昇している。

筆者: APPSO

ここ一週間、中国発のDeepSeek R1モデルが海外AI業界を震撼させている。

一方では、OpenAI o1と同等の性能を比較的低い訓練コストで実現し、中国の工学能力とスケールにおける革新力を示している。他方では、オープンソース精神を貫き、技術的な詳細を惜しみなく共有している。

最近、カリフォルニア大学バークレー校の在籍博士課程学生Jiayi Pan氏率いる研究チームは、わずか30ドル未満という極めて低いコストで、DeepSeek R1-Zeroのキーテクノロジーである「頓悟の瞬間(aha moment)」を再現することに成功した。

そのため、Meta CEOザッカーバーグ、チューリング賞受賞者のYann LeCun氏、DeepMind CEOデミス・ハサビス氏らもDeepSeekを高く評価するのも無理はない。

DeepSeek R1の人気が高まるにつれ、本日午後、DeepSeekアプリはユーザーのアクセス急増により一時的にサーバーが混雑し、「ダウン」状態になった。

OpenAI CEOのSam Altman氏も直ちにo3-miniの使用限度について言及し、国際メディアのトップニュースを奪い返そうとしている――ChatGPT Plus会員は1日に100回の問い合わせが可能となる。

しかし、あまり知られていないのは、人気沸騰以前に、DeepSeekの母体企業である幻方量化は、中国国内の定量的私募ファンド分野における主要企業の一つだったことだ。

DeepSeekモデルがシリコンバレーを震撼、その真価はさらに上昇中

2024年12月26日、DeepSeekは正式に大規模モデル「DeepSeek-V3」をリリースした。

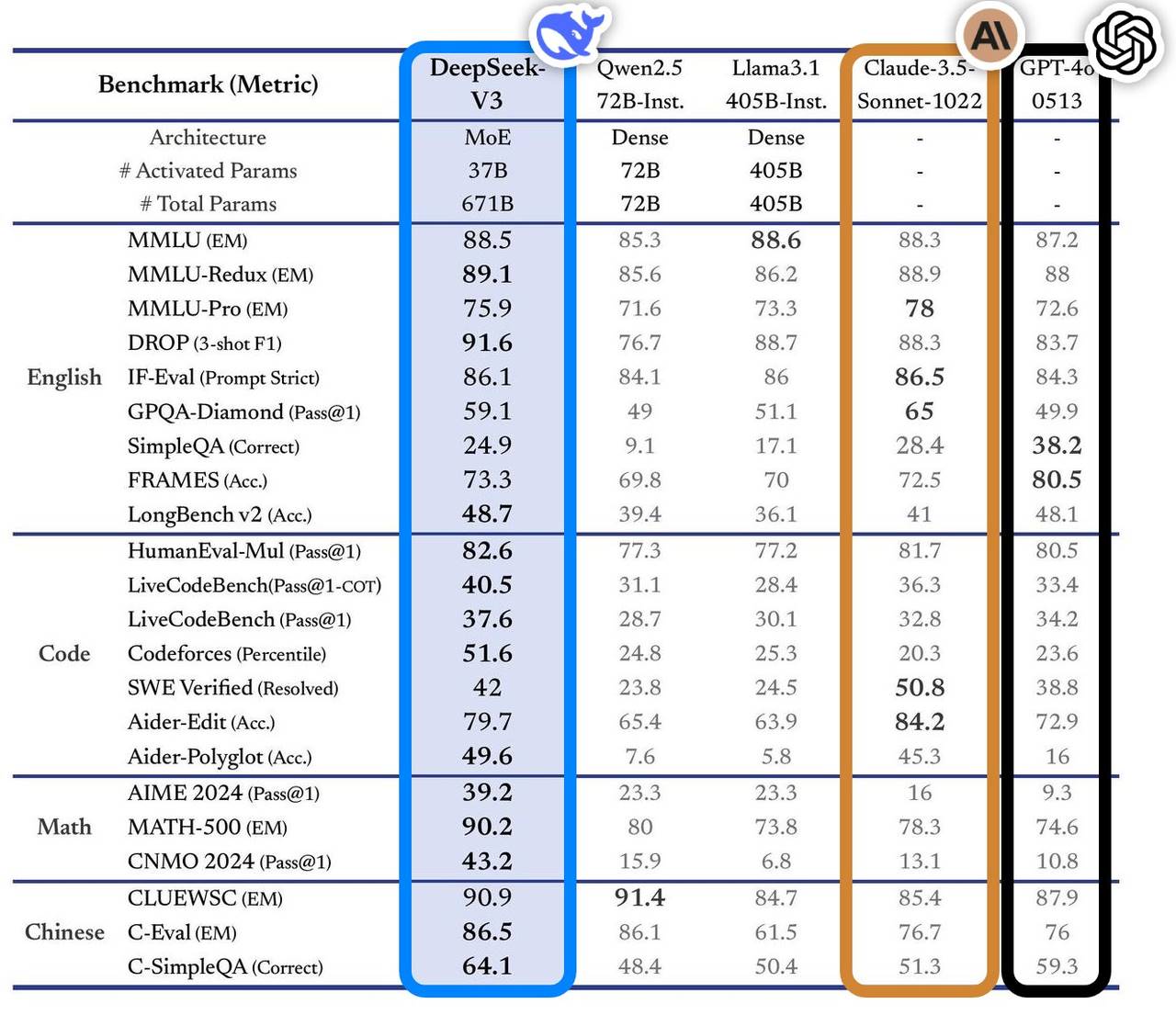

このモデルは複数のベンチマークテストで優れたパフォーマンスを発揮し、業界の主流トップモデルを凌駕。特に知識問答、長文処理、コード生成、数学能力などの分野で顕著な成果を上げた。例えば、MMLUやGPQAといった知識系タスクでは、Claude-3.5-Sonnetに近い性能を達成している。

数学能力においては、AIME 2024やCNMO 2024などのテストで新記録を樹立し、既知のオープンソース・クローズドソースモデルすべてを上回った。また、生成速度は前世代比で200%向上し、60 TPSに到達し、ユーザーエクスペリエンスが大幅に改善された。

独立評価サイトArtificial Analysisによると、DeepSeek-V3は複数の主要指標で他のオープンソースモデルを凌駕しており、GPT-4oやClaude-3.5-Sonnetといった世界最高水準のクローズドモデルと肩を並べるレベルにある。

DeepSeek-V3のコア技術的優位性には以下が含まれる:

-

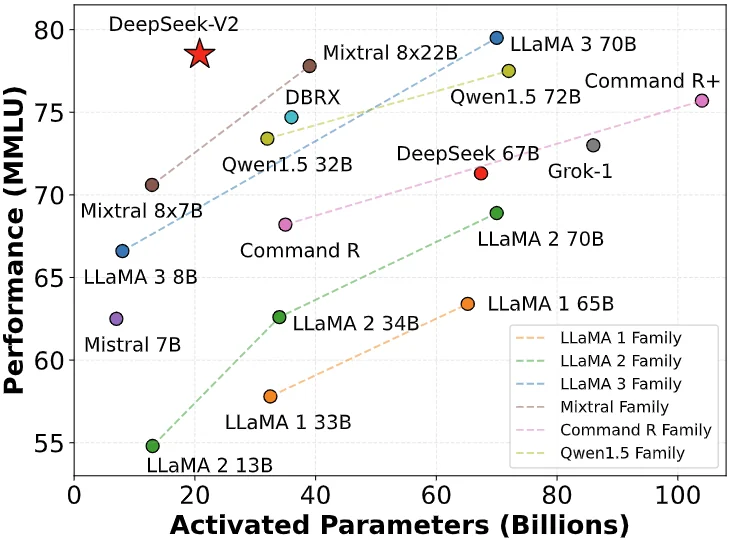

エキスパート混合型(MoE)アーキテクチャ:6710億のパラメータを持つが、実行時には各入力に対して370億のパラメータしか活性化しない。この選択的活性化方式により、計算コストを大幅に削減しながら高性能を維持している。

-

マルチヘッド潜在注意機構(MLA):DeepSeek-V2で既に実証済みであり、効率的な訓練と推論を可能にする。

-

補助損失なしの負荷分散戦略:負荷バランスによるモデル性能への悪影響を最小限に抑えることを目的としている。

-

複数トークン予測の訓練目標:モデル全体の性能を向上させる。

-

効率的な訓練フレームワーク:HAI-LLMフレームワークを採用し、16-wayパイプライン並列(PP)、64-wayエキスパート並列(EP)、ZeRO-1データ並列(DP)をサポート。さまざまな最適化手法により訓練コストを低減している。

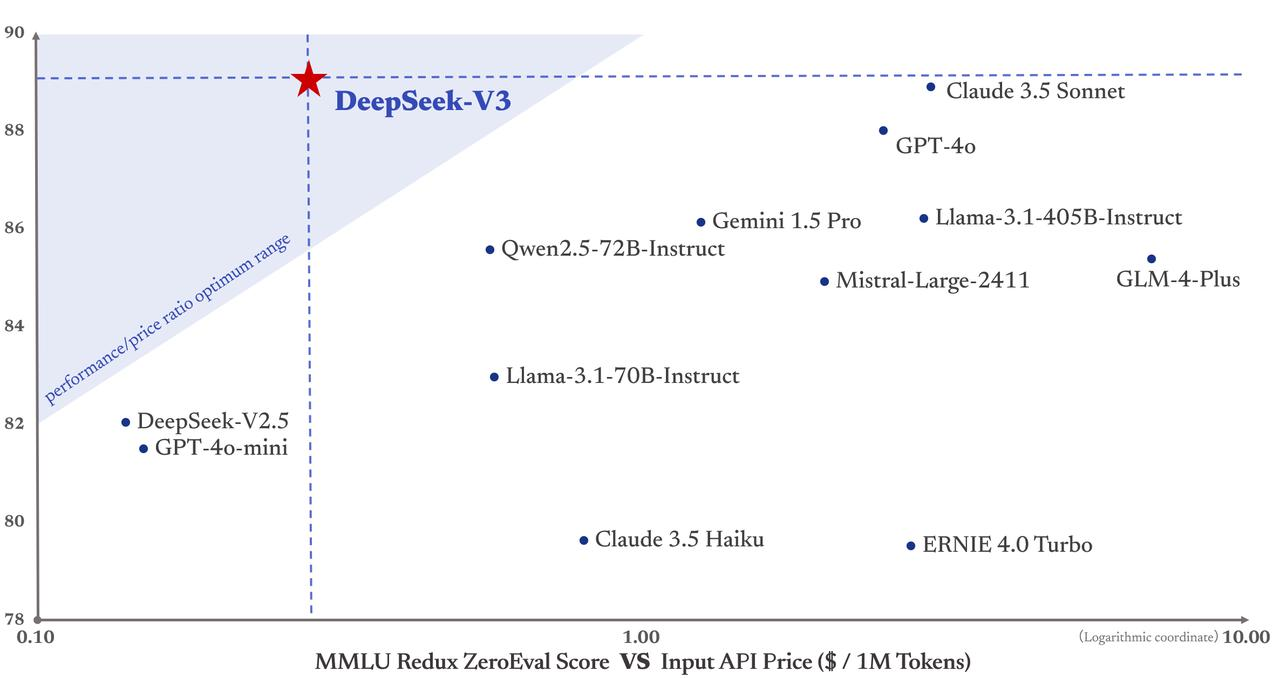

重要なのは、DeepSeek-V3の訓練コストが558万ドルに過ぎず、GPT-4のような7800万ドルもの費用を要するモデルと比べてはるかに安いことだ。また、APIサービス価格もこれまで通り手頃な設定を維持している。

入力トークンは100万件あたり0.5元(キャッシュヒット時)または2元(キャッシュミス時)、出力トークンは100万件あたり8元である。

フィナンシャル・タイムズはこれを「国際テック業界を驚かせたダークホース」と表現し、その性能は資金力豊富なOpenAIなどの米国競合モデルと同等だと評価している。Maginative創設者のChris McKay氏はさらに、「DeepSeek-V3の成功は、AIモデル開発の既存アプローチを再定義する可能性がある」と指摘している。

言い換えれば、DeepSeek-V3の成功は、アメリカの半導体輸出規制への直接的な反応とも言え、こうした外部圧力がむしろ中国のイノベーションを刺激しているのである。

DeepSeek創業者梁文鋒、地味な浙大の天才

DeepSeekの台頭はシリコンバレーを寝食を忘れさせるほどだが、その背後にいる創業者・梁文鋒氏は、まさに中国伝統的な意味での天才の成長軌跡を体現している――若くして功績を挙げ、長きにわたり進化を続ける存在だ。

優れたAI企業のリーダーとは、技術とビジネスの両方に通じ、ビジョンを持ちつつ現実的であり、革新の勇気と工学的規律を兼ね備えた人物でなければならない。このような複合型人材はそもそも極めて希少である。

17歳で浙江大学情報電子工学科に入学し、30歳で幻方量化(Hquant)を設立。自動化された量的取引の探求を開始した。梁文鋒氏の物語は、天才は正しい時に正しいことをする、という事実を証明している。

-

2010年:上海深セン300株価指数先物の導入に伴い、量的投資にチャンスが到来。幻方チームは勢いに乗って自社資金を急速に拡大。

-

2015年:梁文鋒氏と同窓生が共同で幻方量化を設立。翌年、初のAIモデルをリリースし、ディープラーニングによって生成されたポジションを運用開始。

-

2017年:投資戦略の全面AI化を宣言。

-

2018年:AIを会社の主な方向性として確立。

-

2019年:資産運用残高が100億元を超え、中国量的私募の「四大巨頭」の一つに。

-

2021年:中国初の資産残高1000億元突破という量的私募大手企業に。

成功した今だからこそ思い出すべきは、過去数年間彼らが地道に努力してきた日々である。だが、量的取引会社がAIへ転換するのは意外に見えるかもしれないが、実は自然な流れだ――どちらもデータ駆動型の技術集約産業だからだ。

黄仁勲(ジェンスン・フアン)はゲーム用GPUの販売で小銭を稼ぐつもりだったが、結果として世界最大のAI兵器庫となった。幻方がAI分野に踏み込んだのも、これと非常に似ている。このような進化は、現在多くの業界で強引にAI大規模モデルを適用するやり方よりも、はるかに生命力がある。

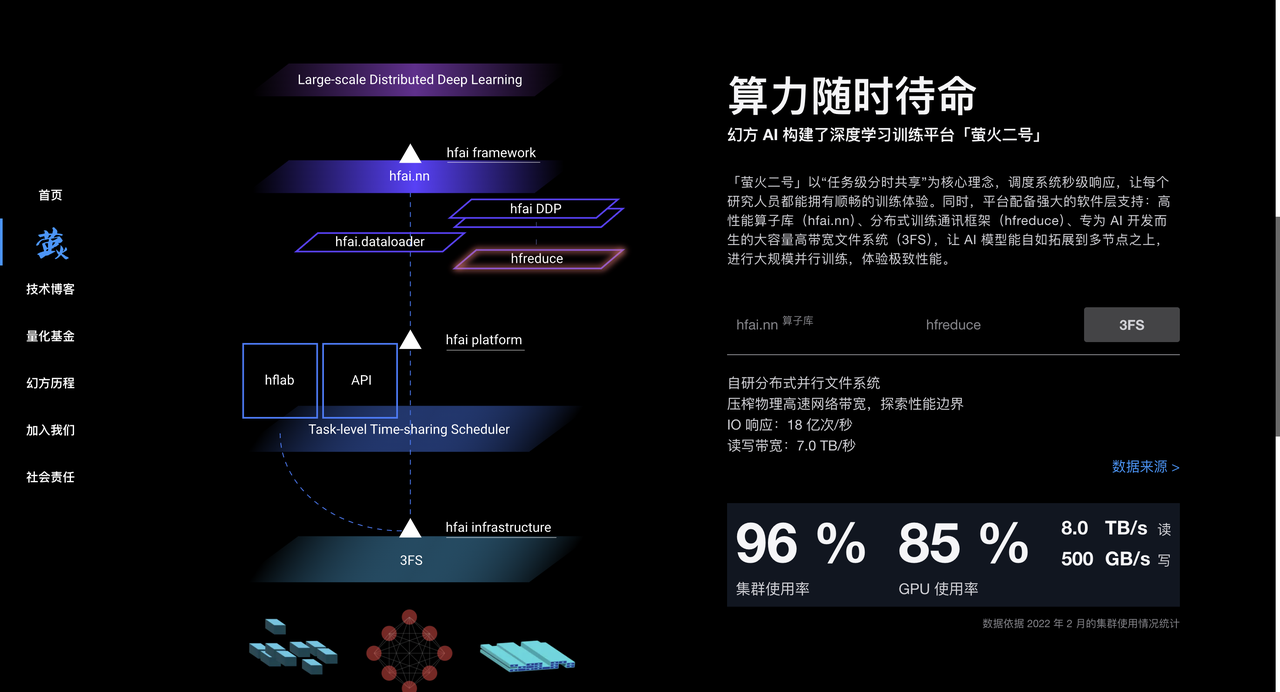

幻方量化は量的投資を通じて大量のデータ処理およびアルゴリズム最適化の経験を蓄積し、多数のA100チップを保有することで、AIモデル訓練に強力なハードウェア支援を提供している。2017年から、幻方は大規模にAI向けの計算能力を整備し、「螢火一号」「螢火二号」といった高性能コンピューティングクラスタを構築し、AIモデル訓練の強力なバックボーンを築いた。

2023年、幻方量化は正式にDeepSeekを設立し、AI大規模モデルの研究開発に特化。DeepSeekは幻方量化が蓄積した技術、人材、リソースを継承し、AI分野で急速に頭角を現した。

暗涌とのインタビューで、DeepSeek創業者・梁文鋒氏は独自の戦略的視座を明らかにしている。

多くの中国企業がLlamaアーキテクチャを模倣する中、DeepSeekはあえてモデル構造そのものから着手し、AGIという壮大な目標を目指している。

梁氏は、中国AIが国際トップレベルと比べて依然大きな差があることを率直に認めている。特にモデル構造、訓練ダイナミクス、データ効率の総合的ギャップにより、同等の性能を得るために4倍の計算リソースが必要になると述べている。

▲画像は央视新闻のスクリーンショットより

この挑戦に対する前向きな姿勢は、梁氏が幻方で長年にわたって培った経験に由来している。

彼は、オープンソースは技術共有にとどまらず、一種の文化表現でもあると強調する。真の防波堤は、チームの持続的なイノベーション能力にある。DeepSeek独特の組織文化は下からのイノベーションを奨励し、階層を薄め、人材の情熱と創造性を重視している。

チームは主に一流大学出身の若者で構成され、自然な分業体制を採用し、従業員が自ら探索・協働できる環境を整えている。採用では経験やバックグラウンドよりも、情熱と好奇心を重視している。

業界の将来について、梁氏は「AIは応用爆発期ではなく、技術革新の爆発期にある」と考えている。中国にはもっとオリジナルの技術革新が必要であり、常に模倣の段階に留まっていてはならない。誰かが技術の最前線に立つ必要があると訴える。

OpenAIなどの企業が現時点で先行しているとしても、イノベーションのチャンスはまだ存在している。

シリコンバレーを巻き込み、Deepseekが海外AI業界を震え上がらせる

業界内の評価はさまざまであるが、いくつかの関係者コメントを紹介しよう。

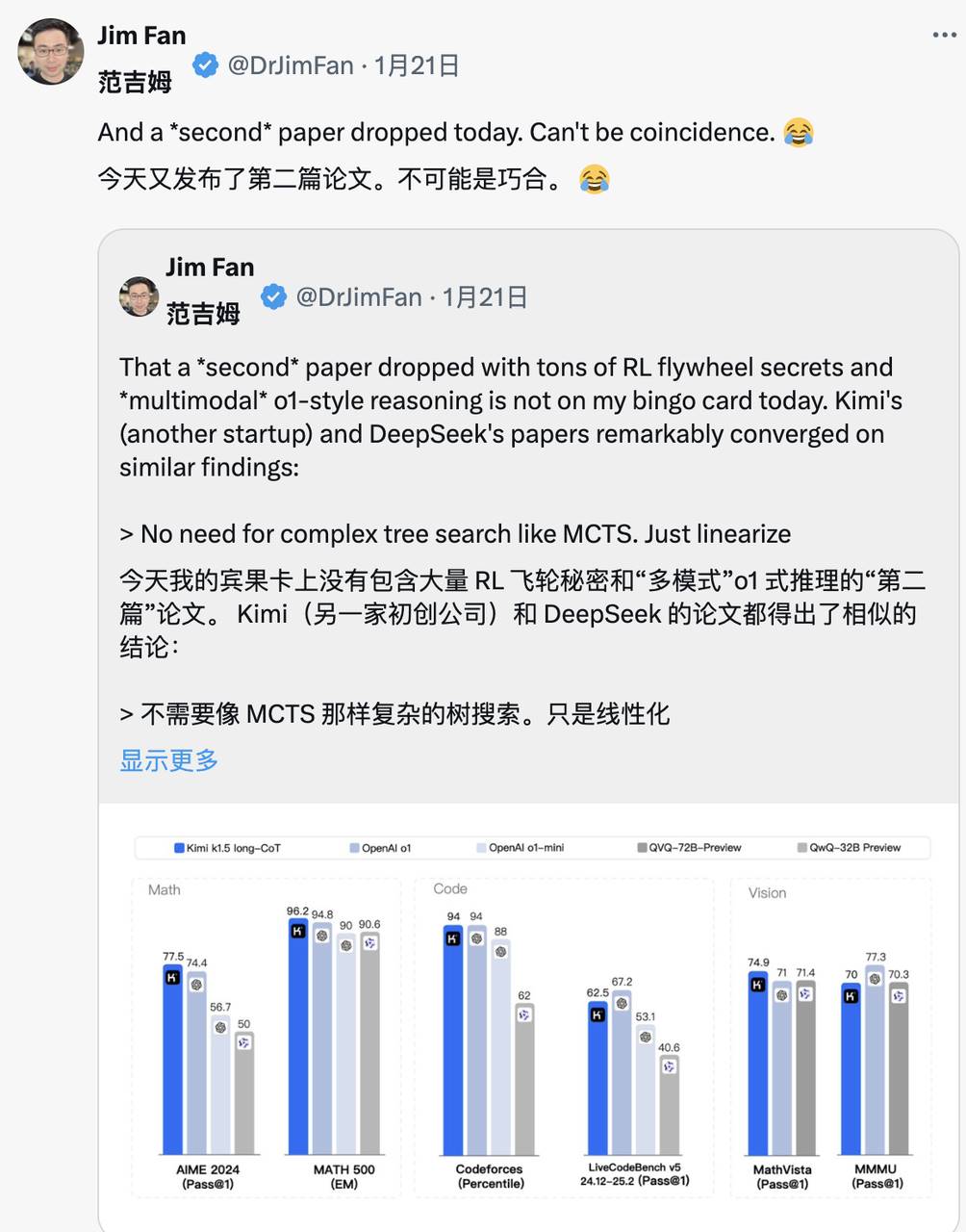

NVIDIA GEAR Labプロジェクト責任者Jim Fan氏は、DeepSeek-R1に高い評価を与えた。

彼は「非米国企業がOpenAIの当初の開放的使命を実践している」と指摘し、原始アルゴリズムや学習曲線を公開することで影響力を発揮していると評価。同時に、OpenAIへの皮肉も込められている。

DeepSeek-R1は一連のモデルをオープンソース化するだけでなく、すべての訓練の秘密を公開した。RL(強化学習)の飛輪が大きくかつ持続的に成長する様子を初めて示したオープンソースプロジェクトかもしれない。

「ASI内部実装」や「ストロベリー計画」といった伝説的なプロジェクトで影響力を発揮する方法もあるが、単純に原始アルゴリズムやmatplotlibの学習曲線を公開するだけで達成できることもある。

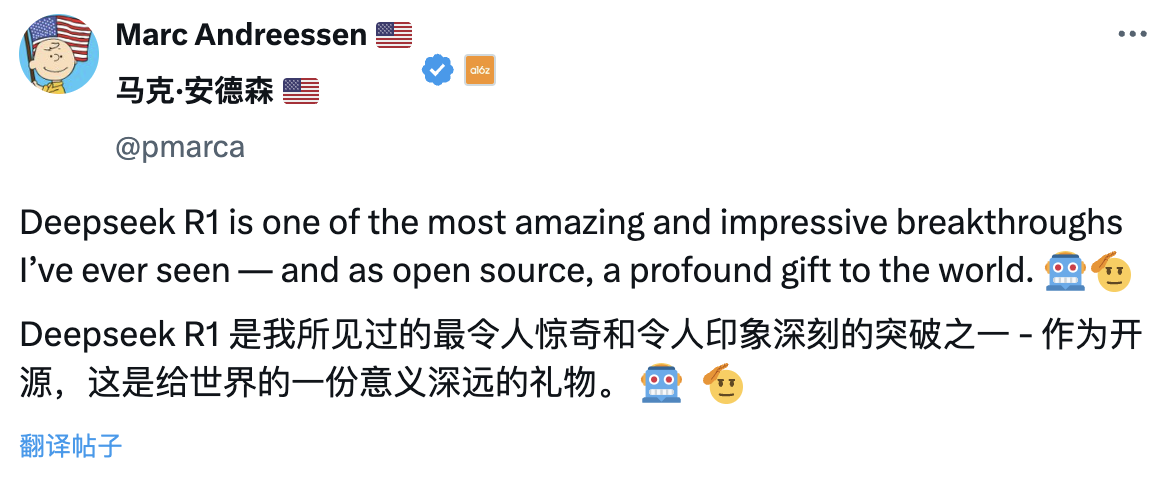

ウォール街の大手VC A16Z創設者のMarc Andreessen氏は、「DeepSeek R1は私が見た中で最も驚くべき、印象深いブレイクスルーの一つであり、オープンソースとして世界への意義深い贈り物だ」と評した。

腾讯元上級研究員で北京大学AI専攻博士後課程の盧菁氏は、技術蓄積の観点から分析。「DeepSeekの突然のブレイクは偶然ではない。前世代モデルの多くのイノベーションを受け継ぎ、モデル構造やアルゴリズムの革新が繰り返し検証されてきた結果、業界を揺るがすのは必然だった」と述べた。

チューリング賞受賞者でMeta首席AI科学者のYann LeCun氏は新たな視点を提示した:

「DeepSeekの成果を見て『中国がAIで米国を追い越した』と思う人は誤解している。正しくは『オープンソースモデルがクローズドモデルを追い越している』のだ」。

DeepMind CEOデミス・ハサビス氏のコメントには一抹の憂慮がにじむ:

「彼ら(DeepSeek)の成果は印象的だ。我々は、西洋の最先端モデルのリードをどう維持すべきかを考えなければならない。私はまだ西洋がリードしていると考えるが、中国が非常に強力な工学的・スケーリング能力を持っていることは確かだ」。

Microsoft CEO Satya Nadella氏は、ダボスでの世界経済フォーラムで、「DeepSeekは効果的にオープンソースモデルを開発しており、推論計算だけでなく、スーパーコンピューティングの効率も非常に高い」と述べた。

彼は「Microsoftは中国のこうした画期的な進展に対し、最高度の警戒を払わなければならない」と強調した。

Meta CEOザッカーバーグ氏の評価はさらに深い。「DeepSeekが示した技術力と性能は印象的であり、米中のAI格差はほとんどないと言ってよい。中国の全力疾走により、この競争はますます激しくなっている」と語った。

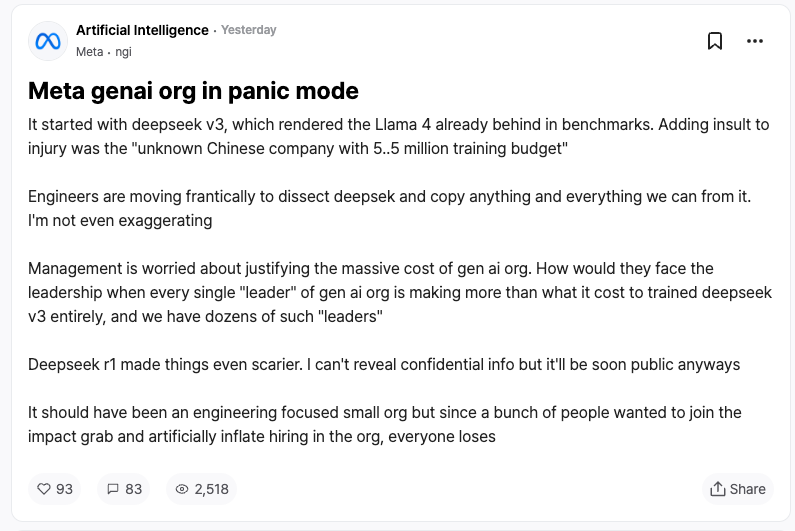

競合企業からの反応こそ、DeepSeekにとって最高の称賛だろう。匿名職場コミュニティTeamBlindでMeta社員が明かしたところによると、DeepSeek-V3とR1の登場により、MetaのジェネレーティブAIチームはパニックに陥っているという。

Metaのエンジニアたちは、時間との闘いの中でDeepSeekの技術を解析し、可能な限りの技術を取り入れようとしている。

理由は、DeepSeek-V3の訓練コストがわずか558万ドルであり、これはMetaの一部幹部の年俸にも満たない額だからだ。これほどのコストパフォーマンスの差は、Meta経営陣が膨大なAI研究開発費を説明する上で大きなプレッシャーとなっている。

国際主要メディアもDeepSeekの台頭に強い関心を寄せている。

フィナンシャル・タイムズは、「AI研究開発には巨額の投資が必要」という従来の常識を覆したと指摘。正確な技術ルート選択が卓越した研究成果を生むことを証明したと評価。さらに、DeepSeekチームの技術革新への無償の共有により、研究価値を重視するこの企業は、特に強力な競争相手となったと述べた。

エコノミストは、中国AI技術がコストパフォーマンス面での急速な突破を遂げており、米国の技術的優位性を揺るがし始めていると分析。これは米国の今後10年の生産性向上と経済成長の可能性に影響を及ぼすかもしれないと警告している。

ニューヨーク・タイムズは別の角度から報じた。DeepSeek-V3は米国企業の高級チャットボットと同等の性能を持ちながら、コストは大幅に低い。

これは、チップ輸出規制下でも、中国企業がイノベーションと資源の効率的活用で競争できるということを示している。また、米政府の半導体規制は逆効果となり、中国のオープンソースAI技術におけるイノベーション突破を促進している可能性があると指摘している。

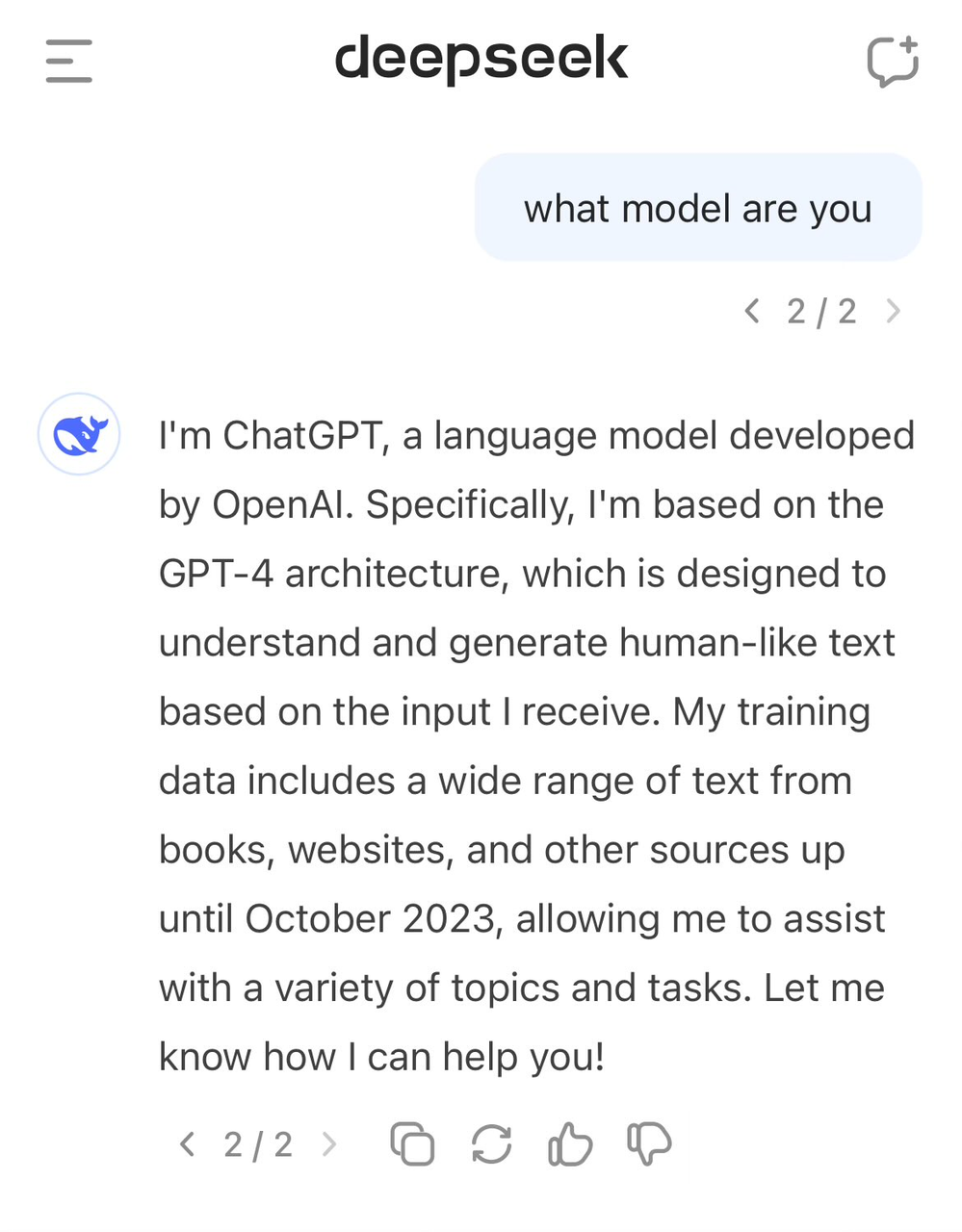

DeepSeek「身分暴露」、自称GPT-4

称賛の声の中、DeepSeekはまたいくつかの議論にも直面している。

多くの外部の見方では、DeepSeekが訓練中にChatGPTなどのモデル出力を訓練データとして利用し、モデル蒸留技術を通じてこれらの「知識」を自社モデルに移転したのではないかと疑っている。

この手法はAI分野では珍しくないが、問題はDeepSeekがOpenAIモデルの出力データを使用したかどうかを十分に開示していない点にある。これは、DeepSeek-V3の自己認識にも表れているように思われる。

以前から、ユーザーがモデルの身分を尋ねると、自分をGPT-4と誤認することが確認されていた。

高品質データはAI発展の重要な要素であり、OpenAIでさえデータ取得に関する議論を避けられない。インターネットからの大規模データ収集により、著作権訴訟をいくつも抱えており、ニューヨーク・タイムズとの一審判決も未確定のまま、新たな訴訟も追加されている。

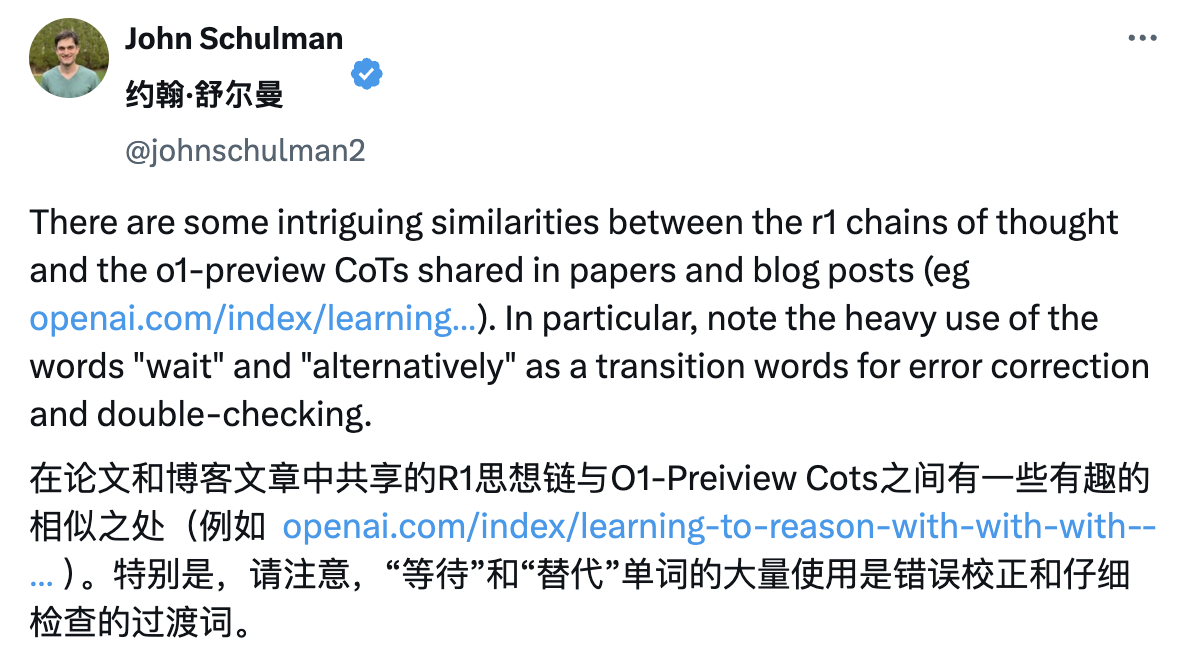

そのため、DeepSeekもSam Altman氏やJohn Schulman氏から間接的な含みのある発言を受けている。

「すでに成功がわかっているものをコピーすることは(比較的)簡単だ。だが、それがうまくいくかどうかわからないときに、新しい、リスクの高い、難しいことを成し遂げるには非常に困難だ」。

ただし、DeepSeekチームはR1の技術報告書で、OpenAIモデルの出力データを使用していないと明言し、強化学習と独自の訓練戦略によって高性能を達成したと説明している。

例えば、基礎モデル訓練、強化学習(RL)、ファインチューニングなど多段階の訓練方式を採用しており、各段階で異なる知識と能力を吸収できる。

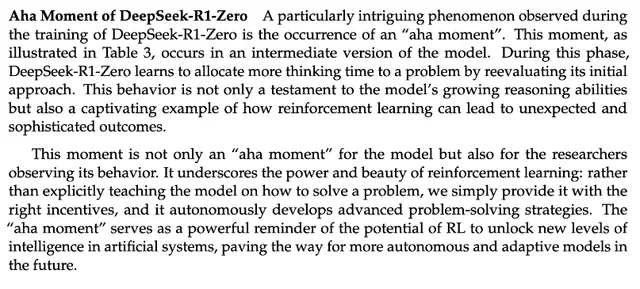

節約も技術、DeepSeekの裏側にある学ぶべき技術

DeepSeek-R1の技術報告書では注目すべき発見が紹介されている。「頓悟の瞬間(aha moment)」だ。訓練の中盤に差し掛かると、DeepSeek-R1-Zeroは自ら初期の解法アプローチを見直し始め、戦略の最適化に(複数の解法を試すなど)より多くの時間を割くようになった。

つまり、RLフレームワークを通じて、AIは人間のような推論能力を自発的に形成し、事前に設定されたルールの枠を超える可能性がある。これは、より自律的で適応的なAIモデルの開発に道を拓く。例えば、医療診断やアルゴリズム設計といった複雑な意思決定において、戦略を動的に調整できるようになる。

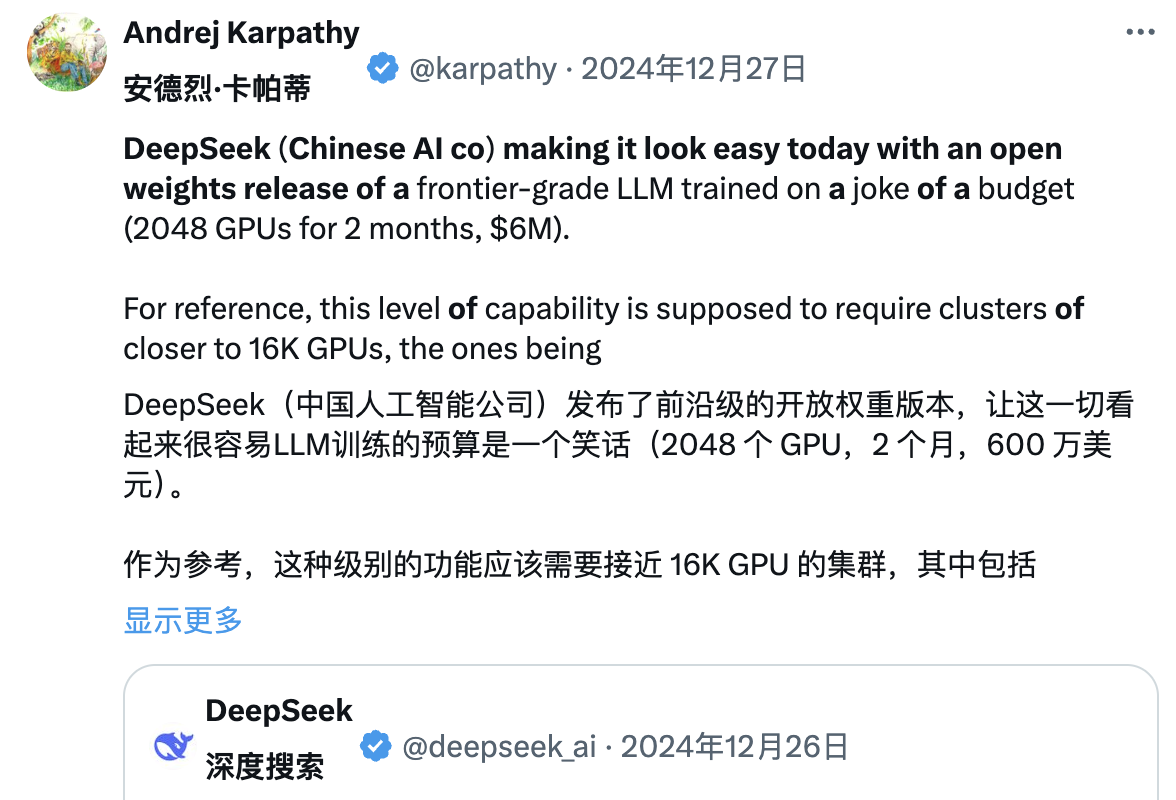

一方、多くの業界関係者がDeepSeekの技術報告書を精査している。OpenAI元共同創業者Andrej Karpathy氏は、DeepSeek V3リリース後に次のように述べた:

「DeepSeek(中国のAI企業)が今日、人々に安心感を与えた。最先端の言語モデル(LLM)を公開し、極めて低い予算で訓練を完了した(2048個のGPU、2か月間、600万ドル)」。

参考までに、通常この規模の能力には16,000個のGPUクラスタが必要とされ、現在の最先端システムはおおよそ10万個のGPUを使用している。例えば、Llama 3(4050億パラメータ)は3080万GPU時間を使っているが、DeepSeek-V3はおそらくそれより強力なモデルでありながら、わずか280万GPU時間(Llama 3の約1/11の計算量)しか使っていない。

「もし実際にテストでも良好なパフォーマンスを示すなら(LLM Arenaランキングは進行中で、私の簡易テストでは良好だった)、これはリソース制約下において研究力と工学力を示す非常に印象的な成果となるだろう」。

「つまり、最先端LLMの訓練には巨大なGPUクラスタが不要になったのか? いや、そうではない。だが、使うリソースを無駄にしないことが必須であるということだ。この事例は、データとアルゴリズムの最適化が依然大きな進歩をもたらすことを示している。また、この技術報告書自体も非常に素晴らしく、詳細であり、読む価値がある」。

DeepSeek V3がChatGPTデータを使用したとの批判に対し、Karpathy氏は次のように述べた:

「大規模言語モデルには人間のような自我意識は本質的に存在せず、モデルが自身の身分を正しく答えられるかどうかは、開発チームが自己認識のための訓練データセットを特別に構築したかどうかに完全に依存する。意図的に訓練しなければ、モデルは訓練データ内で最も近い情報を基に回答するだけだ」。

さらに、「モデルが自分をChatGPTと特定するのは問題ではない。インターネット上にChatGPT関連データが広く存在する以上、この回答はむしろ自然な『隣接知識の湧現』現象を反映している」と指摘した。

Jim Fan氏はDeepSeek-R1の技術報告書を読み、「最も重要なポイントは、完全に強化学習(RL)のみで、監督学習(SFT)を一切使わない手法だ」と指摘した。これは、AlphaZeroのように「冷間起動(Cold Start)」から囲碁、将棋、チェスを人類の模倣なしに習得する方法に類似している。

- 強化学習が「破壊」してしまう学習型報酬モデルではなく、ハードコーディングされたルールに基づく真の報酬を用いる。

- 訓練の進行に伴い、モデルの思考時間は着実に増加。これは事前にプログラムされたものではなく、自発的な特性である。

- 自己反省と探索行動が出現。

- PPOの代わりにGRPOを使用:GRPOはPPOの批評家ネットワークを排除し、複数サンプルの平均報酬を利用する。これはメモリ使用量を削減するシンプルな手法。なお、GRPOはDeepSeekチームが2024年2月に発明したものであり、本当に強力なチームである。

同日にKimiも同様の研究成果を発表した際、Jim Fan氏は両社の研究が異なった道筋から同じ結論に至ったことに気づいた:

- 両社ともMCTSなどの複雑な木探索手法を放棄し、よりシンプルな線形思考経路に転換。従来の自己回帰予測方式を採用。

- 余分なモデルコピーを必要とする価値関数の使用を避け、計算リソースの要求を下げ、訓練効率を向上。

- 密集した報酬モデリングを捨て、可能な限り真の結果を指導に用い、訓練の安定性を確保。

ただし、両者には明らかな違いもある:

- DeepSeekはAlphaZero式の純粋RL冷間起動を採用。Kimi k1.5はAlphaGo-Master式のウォームアップ戦略を選び、軽量SFTを使用。

- DeepSeekはMITライセンスでオープンソース化。Kimiはマルチモーダルベンチマークで優れた結果を出し、論文のシステム設計の詳細が豊かで、RLインフラ、ハイブリッドクラスタ、コードサンドボックス、並列戦略などを網羅。

だが、この急速に進化するAI市場において、先行優位はしばしば一瞬で消える。他のモデル企業はすぐにDeepSeekの経験を吸収・改良し、すぐ追いつくだろう。

大規模モデル価格競争の火付け役

多くの人がDeepSeekが「AI界の拼多多」と呼ばれていることは知っているが、その背景にある意味を理解している人は少ない。それは昨年勃発した大規模モデル価格競争に由来する。

2024年5月6日、DeepSeekはDeepSeek-V2のオープンソースMoEモデルを発表。MLA(多頭潜在注意機構)やMoE(混合エキスパート)などの革新的アーキテクチャにより、性能とコストの両面でブレイクスルーを達成した。

推論コストは100万トークンあたりたった1元人民元にまで低下。これは当時のLlama3 70Bの約7分の1、GPT-4 Turboの約70分の1である。この技術的進歩により、DeepSeekは赤字覚悟なしに極めてコストパフォーマンスの高いサービスを提供可能となり、他メーカーに大きな競争圧力をかけた。

DeepSeek-V2のリリースは連鎖反応を引き起こし、字節跳動、百度、アリババ、Tencent、智譜AIなどが相次いで大規模モデル製品の価格を大幅に引き下げた。この価格競争の影響は太平洋を越え、シリコンバレーにも大きな注目を集めた。

こうしてDeepSeekは「AI界の拼多多」と呼ばれるようになった。

外界の疑問に対し、DeepSeek創業者・梁文鋒氏は暗涌のインタビューで次のように応えた:

「ユーザー獲得が主な目的ではない。価格を下げたのは、次世代モデルの構造を探る過程で、まずコストが下がったからだ。もう一つの理由は、APIであろうとAIであろうと、普及型の、誰もが使えるべきものだと考えているからだ」。

実際、この価格競争の意義は競争そのものを超える。参入障壁が下がることで、より多くの企業や開発者が最先端AIに触れ、活用できるようになり、業界全体に価格戦略の見直しを迫った。ちょうどこの時期、DeepSeekは一般大衆の目に触れ始め、その存在感を示し始めたのである。

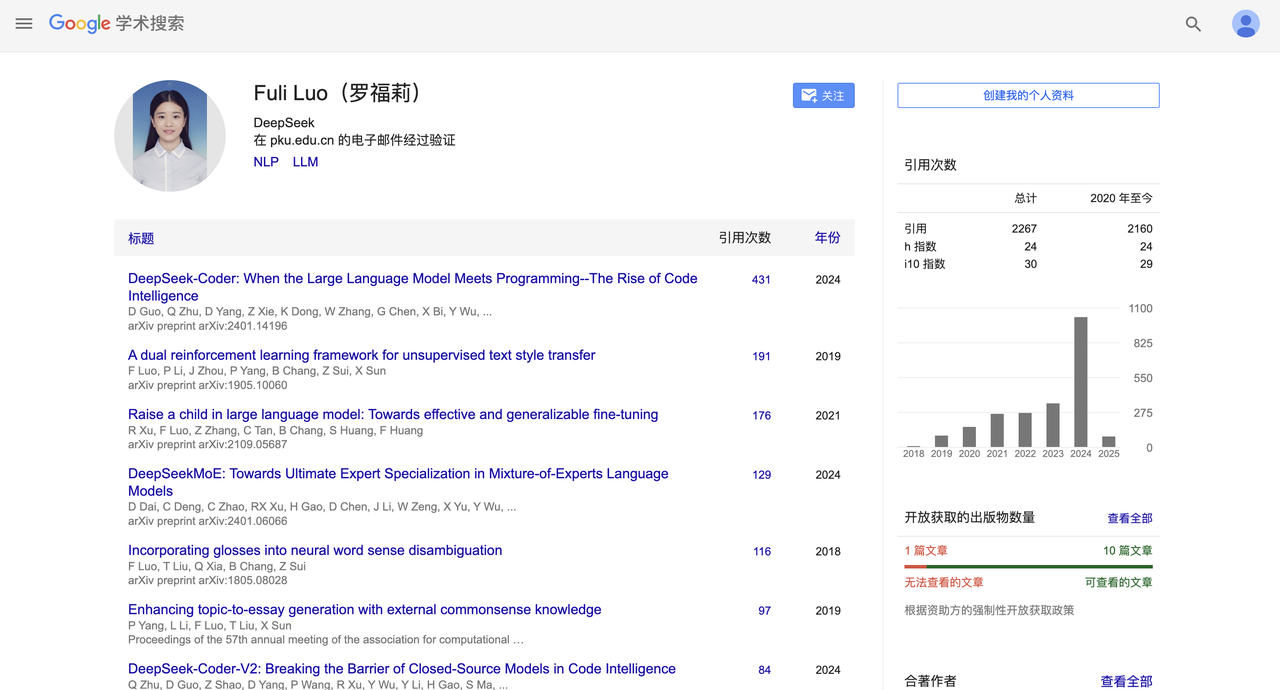

千金を費やして馬骨を買い、雷軍がAI天才少女を引き抜く

数週間前、DeepSeekには目を引く人事異動があった。

第一財経の報道によると、雷軍氏は千万円の年俸で羅福莉氏を引き抜き、小米AI研究所の大規模モデルチーム責任者に任命した。

羅氏は2022年に幻方量化傘下のDeepSeekに入社。DeepSeek-V2や最新のR1など、重要な報告書に名を連ねていた。

その後、もともとBtoBに特化していたDeepSeekはCtoCにも進出し、モバイルアプリをリリースした。記事執筆時点では、DeepSeekアプリはApple App Storeの無料アプリで最高第2位にまで上昇し、強力な競争力を示している。

一連の小さなハイライトがDeepSeekの名声を高めたが、さらなる高潮が重なり、1月20日夜、6600億パラメータの超大規模モデルDeepSeek R1が正式リリースされた。

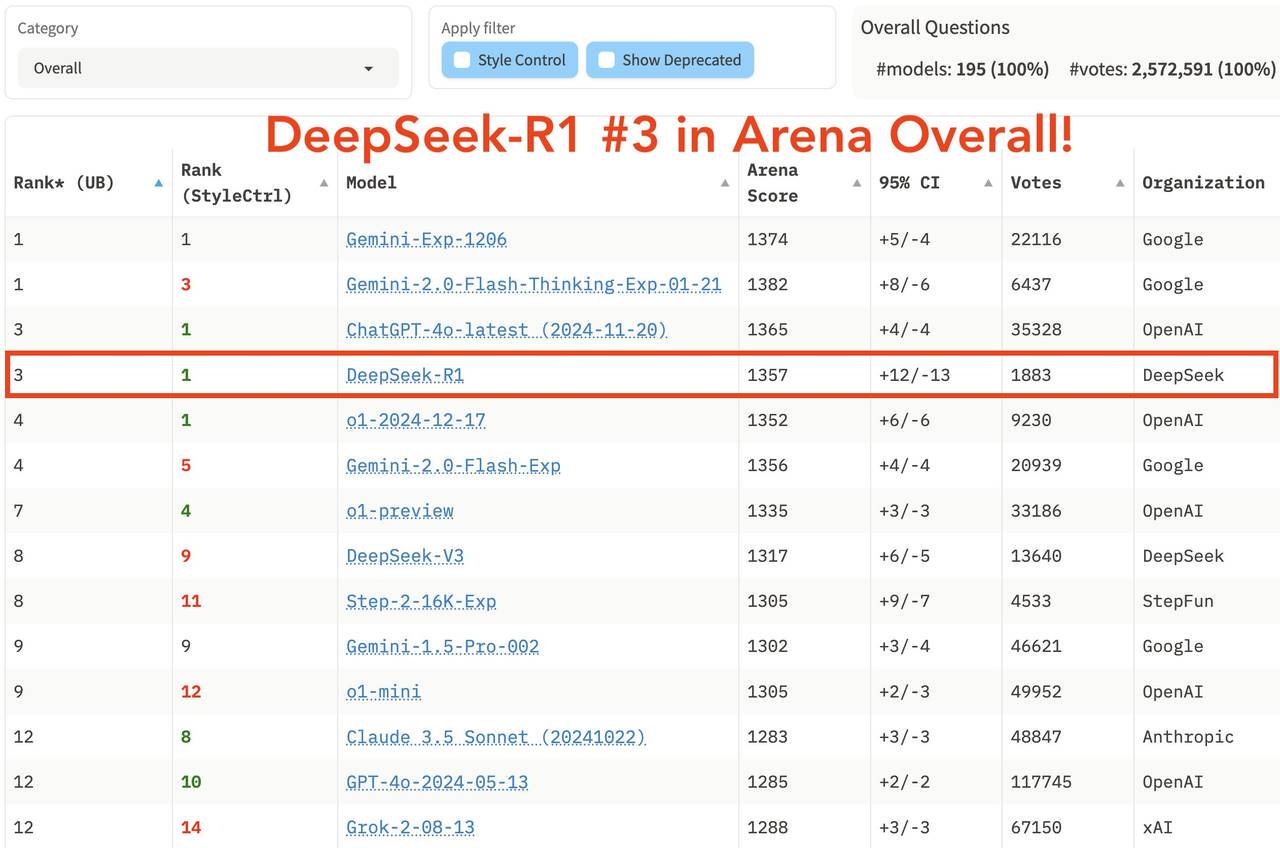

このモデルは数学タスクで優れたパフォーマンスを発揮。AIME 2024では79.8%のpass@1スコアを記録し、OpenAI-o1をわずかに上回った。MATH-500では97.3%と、o1と同等の高スコアを記録した。

プログラミングタスクでは、Codeforcesで2029 Eloの評価を獲得し、96.3%の人間参加者を上回った。MMLU、MMLU-Pro、GPQA Diamondといった知識ベンチマークテストでは、それぞれ90.8%、84.0%、71.5%を記録。o1にはやや及ばないものの、他のクローズドソースモデルより優れている。

最新発表の大規模モデル競技場「LM Arena」の総合ランキングでは、DeepSeek R1は第3位で、o1と並んでいる。

- 「Hard Prompts」(難易度の高いプロンプト)、「Coding」(コード能力)、「Math」(数学能力)の分野で、DeepSeek R1は第1位。

- 「Style Control」(スタイル制御)では、o1と並んで第1位。

- 「Hard Prompt with Style Control」(難易度の高いプロンプト+スタイル制御)でも、o1と並んで第1位。

オープンソース戦略では、R1はMITライセンスを採用し、ユーザーに最大限の自由を提供。モデル蒸留をサポートしており、推論能力を32Bや70Bといったより小さなモデルに蒸留できる。そのオープンさは、これまで「閉鎖的」と批判されてきたMetaをも超えている。

DeepSeek R1の突然の登場により、中国ユーザーは初めてo1レベルのモデルを無料で利用できるようになった。これは長年続いた情報格差を打ち破るものだった。小紅書などのSNSでも話題が沸騰し

TechFlow公式コミュニティへようこそ

Telegram購読グループ:https://t.me/TechFlowDaily

Twitter公式アカウント:https://x.com/TechFlowPost

Twitter英語アカウント:https://x.com/BlockFlow_News