Vitalik氏の最新記事:暗号資産とAIの間で最も成果を上げられる交差点とは何か?

TechFlow厳選深潮セレクト

Vitalik氏の最新記事:暗号資産とAIの間で最も成果を上げられる交差点とは何か?

本稿では、CryptoとAIが交差する可能性のあるさまざまな形態を分類し、それぞれの分野における将来性と課題について考察する。

執筆:Vitalik Buterin

翻訳:Karen、Foresight News

WorldcoinおよびModulus Labsチーム、Xinyuan Sun、Martin Koeppelmann、Illia Polosukhin各位からのフィードバックと議論に感謝します。

長年にわたり、多くの人々が私にこう尋ねてきました。「暗号通貨とAIの最も生産的な交差点はどこにあるか?」これは妥当な問いです。暗号通貨とAIは過去10年間で現れた2つの主要な深層(ソフトウェア)技術トレンドであり、双方の間に何らかの関係があるはずだからです。

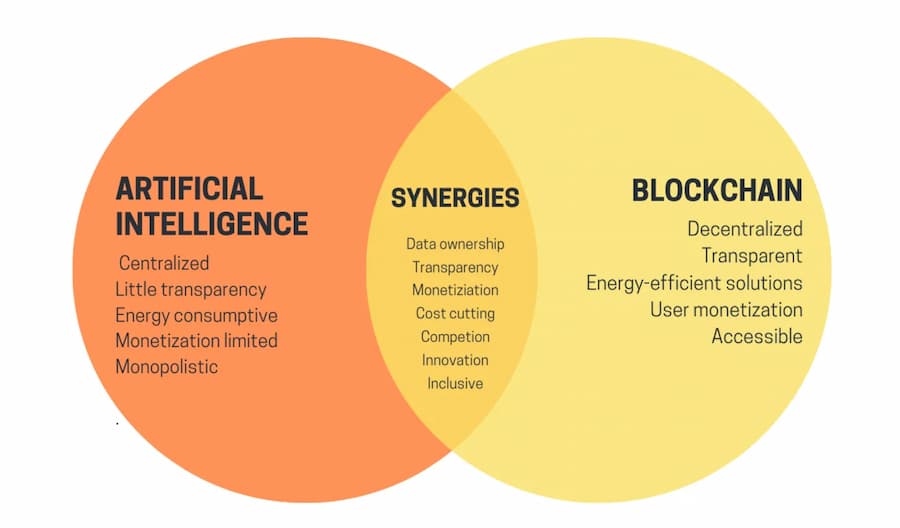

表面上見れば、両者の相乗効果は容易に思いつきます。暗号通貨の非中央集権性はAIの中央集権化を是正できるかもしれません。AIは不透明ですが、暗号通貨は透明性をもたらすことができます。AIはデータを必要とし、ブロックチェーンはデータの保存と追跡に優れています。しかし長年、具体的な応用について詳しく問われた際、私の答えは常にやや残念なものでした。「確かにいくつかの有望な応用はあるが、それほど多くはない」。

ここ3年間、現代的なLLM(大規模言語モデル)といったより強力なAI技術の登場とともに、単なるブロックスケーリングソリューションだけでなく、ゼロ知識証明、完全準同型暗号、(二者および多者間)安全なマルチパーティ計算など、より強力な暗号技術も台頭してきました。私はこの状況の変化を感じ始めています。ブロックチェーンエコシステム内、あるいはAIと暗号学を組み合わせることで、確かに有望なAI応用が存在するのです。ただし、AIの利用には注意が必要です。特に課題となるのは、暗号学においてはオープンソースこそが真の安全性を保証する唯一の方法である一方、AIではモデル(訓練データさえも)を公開することで、対抗的機械学習攻撃に対する脆弱性が大きく増加してしまう点です。本稿では、Crypto+AIのさまざまな交差の形態を分類し、それぞれの可能性と課題を探ります。

uETHブログの記事から引用した、Crypto+AI交差点のまとめ。しかし、これらの相乗効果を具体的な応用でどう実現すればよいでしょうか?

Crypto+AIの4つの交差点

AIは非常に広範な概念です。AIとは、明示的に指定されたものではなく、「大きな計算スープ(computational soup)」を攪拌し、ある種の最適化圧力を加えることで、所望の特性を持つアルゴリズムを生成するプロセスだと捉えることができます。

この説明は決して軽視すべきではありません。なぜなら、人間という存在を作り出したプロセスそのものを含んでいるからです! しかし同時に、AIアルゴリズムには共通の特徴があります。すなわち、非常に強力である一方で、その内部動作を理解・把握することが限定的であることです。

AIを分類する方法は数多くありますが、本稿ではVirgil Griffithの「文字通り、イーサリアムはゲームチェンジング・テクノロジーである」という考え方に基づき、以下のように分類します:

-

ゲーム参加者としてのAI(実現可能性最高):AIが参加するメカニズムにおいて、インセンティブの最終的な源泉は人間による入力プロトコルから得られる。

-

ゲームインターフェースとしてのAI(潜在能力大だがリスクあり):AIがユーザーが暗号世界を理解するのを助け、彼らの行動(署名メッセージやトランザクションなど)が意図と一致していることを保証し、騙されないようにする。

-

ゲームルールとしてのAI(極めて慎重に):ブロックチェーン、DAO、および類似のメカニズムが直接AIを呼び出す場合。例:「AI裁判官」。

-

ゲーム目的としてのAI(長期的かつ興味深い):ブロックチェーン、DAO、および類似のメカニズムの設計目的が、他の目的に使えるAIの構築と維持にある場合。暗号技術の一部は、訓練へのインセンティブ改善、またはAIが個人データを漏らしたり悪用されたりしないようにするためのものです。

順に見ていきましょう。

AIをゲーム参加者として

実際、このカテゴリは少なくともDEX(分散型取引所)が広く使われるようになって以来、ほぼ10年近く存在しています。取引所がある限り、裁定取引により利益を得る機会があり、ボットは人間よりも裁定をうまく行えます。

このようなユースケースは、現在よりもはるかに単純なAIであっても長期間存在しており、実際に暗号通貨とAIの真の交差点の一つです。最近では、MEV(最大可抽出価値)裁定ボットが互いに利用しあう様子をよく目にします。オークションや取引を伴うブロックチェーンアプリケーションでは、常に裁定ボットが存在します。

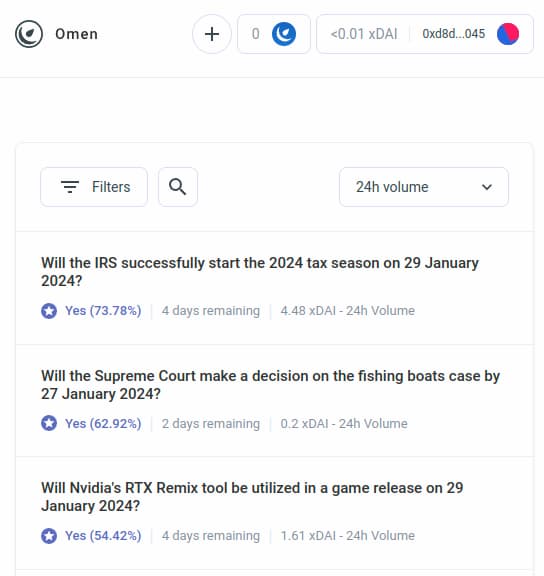

しかし、AI裁定ボットは、より大きなカテゴリの最初の事例にすぎず、今後すぐに他の多くの応用へと拡大すると予想されます。ここに AIOmen を紹介します。これはAIを参加者とする予測市場のデモです。

予測市場は長らく認知技術の聖杯とされてきました。2014年には、予測市場をガバナンスの入力(未来の統治)として使うことに興奮し、最近の選挙でも広く試みました。しかし実際には、予測市場は多くの理由で大きな進展を見せていません。最大の参加者は非合理的であり、正しい認識を持つ人々は、多くの人が金銭に関与していない限り、時間と資金をかけて賭けようとはしません。また、市場が十分に活発でないことが多いなどです。

これに対する反応として、Polymarketなどの新しい予測市場がUX改善を進めていることを指摘し、以前失敗した点を克服して成功を収めると期待する声もあります。人々はスポーツに数百億ドルを賭けるのに、なぜ米国大統領選やLK99に十分なお金を賭けて、真剣なプレイヤーが参入するような規模にならないのでしょうか? しかし、この主張は、過去のバージョンがその規模に達しなかったという事実に直面しなければなりません(少なくとも支持者の夢と比べれば)。そのため、予測市場を成功させるには、新たな要素が必要だと考えるべきでしょう。そこで別の反応として、2020年代に予測市場エコシステムで見られる特定の特徴を指摘できます。それは2010年代には見られなかった、AIの広範な参加可能性です。

AIは1時間あたり1ドル未満の報酬でも働き、百科事典のような知識を持っています。それだけでも不十分であれば、リアルタイムのWeb検索機能と統合することも可能です。もし50ドルの流動性補助を提供する市場を作れば、人間は無関心かもしれませんが、何千ものAIが群がり、可能な限り最善の予測を行います。

個々の問題に対して正確に働く動機は小さいかもしれませんが、良好な予測を行うAIを作成する動機は数百万単位になる可能性があります。ほとんどの問題では人間による裁定が不要であることに注意してください。AugurやKlerosのような複数段階の異議申し立てシステムを使えば、AIも初期段階に参加できます。人間が反応するのは、一連の昇格が行われ、双方が多額の資金を投入した少数の場合に限られます。

これは強力なプリミティブです。いったん「予測市場」がこのような微細な規模で機能するようになれば、「予測市場」というプリミティブを次のような他のタイプの問題にも繰り返し適用できるからです。

-

[利用規約]に基づき、このソーシャルメディアの投稿は許容可能か?

-

株式Xの価格はどうなるか?(例:Numerai参照)

-

今私にメッセージを送っているこのアカウントは本当にイーロン・マスクか?

-

オンラインタスク市場に提出された作業は受け入れ可能か?

-

https://examplefinance.network 上のDAppは詐欺か?

-

0x1b54....98c3 は「Casinu In」ERC20トークンアドレスか?

これら多くのアイデアが、先に述べた「情報防御」(info defense)の方向に向かっていることに気づくでしょう。広義には、中心的な権威に真偽の判断権を与えることなく、ユーザーが真偽の情報を区別し、詐欺を識別するのをどう支援できるかという問題です。この権力が濫用されるおそれがあるからです。微視的には、答えは「AI」になります。

しかし巨視的には、誰がAIを構築するのかという問題があります。AIはその創造プロセスの反映であり、偏見を避けられません。異なるAIのパフォーマンスを評価する高次元のゲームが必要であり、AIがプレイヤーとして参加できるようにする必要があります。

AIが、チェーン上でのメカニズムを通じて人間から報酬を得たり罰を受けたりする(確率的に)仕組みに参加するこのような使い方は、非常に研究価値があります。いまこそ、そのようなユースケースをさらに深く探求する適切な時期です。ブロックチェーンのスケーラビリティがついに成功し、かつてはオンチェーンで実現できなかった「微視的」なあらゆるものが、今や可能になったからです。

関連するアプリケーションクラスは、高度に自律的なエージェントの方向に進んでおり、ブロックチェーンを活用して協力を強化しようとしています。支払いを通じて、あるいはスマートコントラクトを使って信頼できる約束を行うことでです。

AIをゲームインターフェースとして

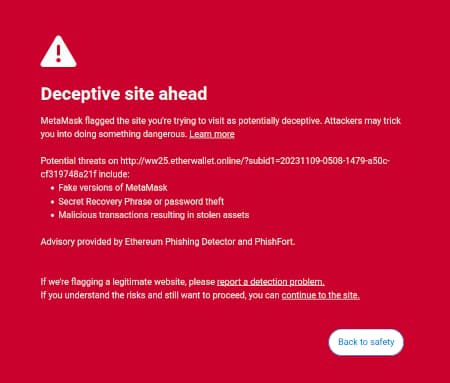

私が『My techno-optimism』で提唱した考えの一つは、ユーザー向けソフトウェアに市場機会があるというものです。このソフトウェアは、ユーザーがオンライン世界で遭遇する危険を説明・識別することで、ユーザーの利益を守ることができます。MetaMaskの詐欺検出機能はすでに存在する一例です。

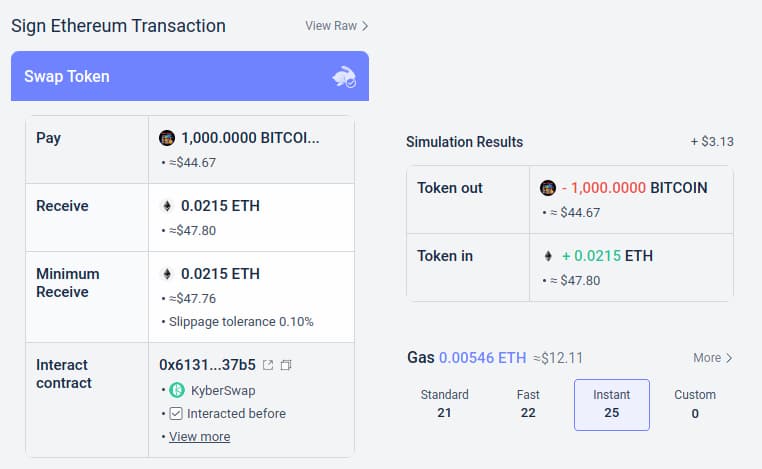

もう一つの例はRabbyウォレットのシミュレーション機能で、ユーザーが署名しようとしているトランザクションの予想結果を表示します。

これらのツールはAIによって強化される可能性があります。AIは、ユーザーが参加しているDAppの内容、複雑な操作の結果、特定のトークンが本物かどうか(例えば、BITCOINは単なる文字列ではなく、実在する暗号通貨の名称であり、ERC20トークンではない、価格は0.045ドルよりはるかに高い、など)を、より豊かで人間にとって理解しやすい形で説明できます。この方向に全力で取り組むプロジェクトも現れ始めています(例:LangChainウォレットはAIを主なインターフェースとして使用)。私の個人的な見解では、現時点では純粋なAIインターフェースはリスクが大きすぎる可能性があります。なぜなら、他の種類の誤りのリスクを高めるからです。しかし、AIとより伝統的なインターフェースを組み合わせるのは非常に現実的です。

特に言及すべきリスクがあります。これは次の「AIをゲームルールとして」の節で詳しく説明しますが、全体的な問題は対抗的機械学習です。ユーザーがオープンソースのウォレット内でAIアシスタントを利用できるなら、悪意ある者もそのAIアシスタントを利用でき、そのため彼らはそのウォレットの防御を回避するように詐欺行為を最適化する無限の機会を持ってしまいます。すべての現代的AIにはどこかに弱点があり、モデルへのアクセスが制限されていても、訓練過程を通じてそれを見つけるのは難しくありません。

特に言及すべきリスクがあります。これは次の「AIをゲームルールとして」の節で詳しく説明しますが、一般的な問題は対抗的機械学習です。ユーザーがオープンソースのウォレット内のAIアシスタントにアクセスできる場合、悪意のある者もそのAIアシスタントにアクセスでき、そのため彼らはそのウォレットの防御をトリガーしないように詐欺を最適化する無限の機会を持ってしまいます。すべての現代的AIはどこかにエラーを抱えており、モデルへのアクセスが制限されていても、訓練過程を通じてそれを見つけるのはそれほど難しくありません。

ここで「AIがオンチェーンのマイクロ市場に参加する」方式がより優れている点がわかります。個々のAIは同じリスクにさらされますが、数十人が継続的に反復・改善するオープンエコシステムを意図的に作成しているのです。

さらに、各AI自体は閉じられています。システムの安全性は参加者の内部動作ではなく、ゲームルールの開示性から得られるのです。

まとめ:AIは、シンプルな言語で何が起きているかを理解するのを助け、リアルタイムのメンターとしてユーザーを保護できます。しかし、悪意ある誘導者や詐欺師との遭遇には注意が必要です。

AIをゲームルールとして

さて、多くの人々が熱狂している応用に移りますが、私はこれが最もリスクが高く、極めて慎重に行動する必要があると考えています。つまり、AIがゲームルールの一部となる場合です。これは主流の政治的エリートが「AI裁判官」に熱狂するのと関係しています(例:「世界政府サミット」サイトで関連記事を参照)。ブロックチェーン応用でも、同様の願望が見られます。ブロックチェーンベースのスマートコントラクトやDAOが主観的な意思決定を行う必要があるとき、AIを契約やDAOの一部としてルール執行を補助させることは可能でしょうか?

ここで対抗的機械学習が極めて困難な課題となります。以下の単純な議論があります。

-

メカニズムで重要な役割を果たすAIモデルが閉じていれば、その内部動作を検証できないため、中央集権アプリケーションより優れていない。

-

AIモデルがオープンであれば、攻撃者はそれをローカルにダウンロード・シミュレートし、モデルを騙すために高度に最適化された攻撃を設計し、その後リアルネットワーク上で再演できる。

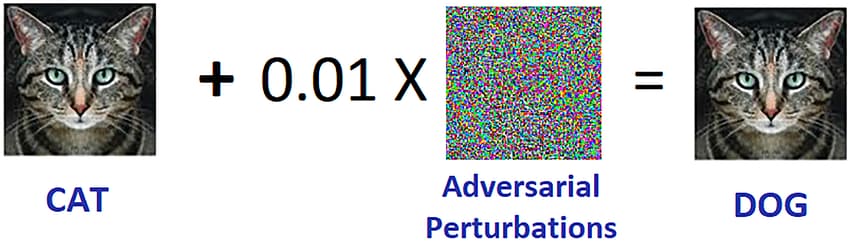

対抗的機械学習の例。出典:researchgate.net

このブログをよく読む方(あるいは暗号ネイティブ住民)は、私の意図を察して考え始めたかもしれません。しかし、少しお待ちください。

我々は高度なゼロ知識証明やその他非常に優れた暗号技術を持っています。きっと何か暗号の魔法で、モデルの内部動作を隠して攻撃者が最適化できないようにしつつ、証明を通じてモデルが正しく実行され、合理的な訓練プロセスと健全なデータセットに基づいて構築されていることを示せるはずです。

通常、これが私がこのブログや他の記事で提唱してきた思考法です。しかしAI計算に関しては、2つの主な反論があります。

-

暗号オーバーヘッド:SNARK(またはMPCなど)内でタスクを実行することは、平文で実行するよりもはるかに非効率です。AI自体が既に高い計算需要を持っていることを考えると、暗号ブラックボックス内でAI計算を行うことが計算的に可能でしょうか?

-

ブラックボックス対抗的機械学習攻撃:モデルの内部動作を知らなくても、AIモデルに対する攻撃を最適化する方法が存在します。あまりに厳密に隠蔽すると、訓練データを選択する者が中毒攻撃を通じてモデルの整合性を損なうことを容易にしてしまうかもしれません。

これらはどちらも複雑なテーマであり、一つずつ深く掘り下げていく必要があります。

暗号オーバーヘッド

暗号ツール、特にZK-SNARKやMPCなどの汎用ツールはオーバーヘッドが高いです。クライアントがイーサリアムのブロックを直接検証するには数百ミリ秒かかりますが、そのブロックの正当性を証明するZK-SNARKを生成するには数時間かかることがあります。他の暗号ツール(MPCなど)のオーバーヘッドはさらに大きいことがあります。

AI計算自体も非常に高価です。最先端の言語モデルは、単語を出力する速度が人間の読書速度よりわずかに速い程度です。訓練には数百万ドルの計算コストが通常かかります。訓練コストやパラメータ数を削減しようとするモデルとトップレベルのモデルとの間には、品質に大きな差があります。一見すると、AIに保証を追加するために暗号で包むという試み全体に疑問を呈する理由になります。

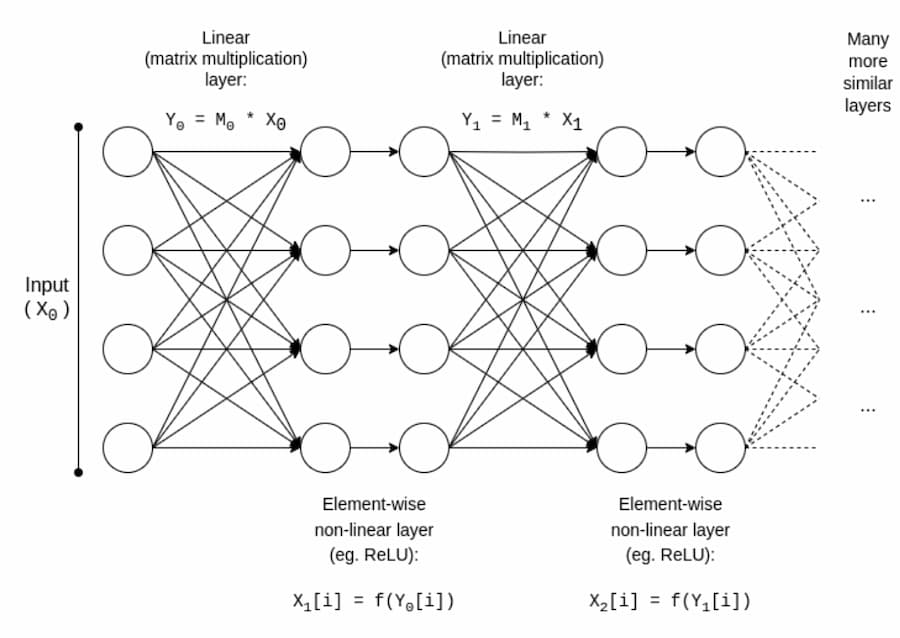

幸運にも、AIは非常に特殊な計算タイプであり、ZK-EVMなどの「非構造化」計算では享受できないさまざまな最適化が可能です。AIモデルの基本構造を見てみましょう。

通常、AIモデルは一連の行列乗算からなり、ReLU関数(y = max(x, 0))などの非線形演算が散在しています。漸近的に、行列乗算が大部分の作業を占めます。これは暗号にとって好都合です。なぜなら、多くの暗号形式では線形演算がほとんど「無料」で実行できるからです(少なくともモデルではなく入力を暗号化する場合の行列乗算)。

暗号学者の方なら、準同型暗号における同様の現象を聞いたことがあるでしょう。暗号化されたテキストに対する加算は非常に簡単ですが、乗算は非常に困難で、2009年まで無限の深さでの乗算方法が見つかっていませんでした。

ZK-SNARKの場合、2013年のプロトコルでは、行列乗算の証明のオーバーヘッドは4倍未満です。残念ながら、非線形層のオーバーヘッドは依然大きく、実践的な最良の実装でも約200倍のオーバーヘッドがあります。

しかし、さらなる研究により、このオーバーヘッドを大幅に削減できる可能性があります。Ryan Caoのプレゼンテーションを参考にしてください。そこではGKRに基づく最新手法が紹介されており、私もGKRの主要コンポーネントについて簡略化した説明を行っています。

しかし多くのアプリケーションでは、AI出力の計算が正しいことを証明するだけでなく、モデル自体を隠したいと考えます。これにはいくつかの簡単な方法があります。サーバーのグループが各層を冗長に保持するようにモデルを分割し、特定のサーバーが一部の層を漏らしてもあまりデータを漏らさないと期待する方法です。しかし、驚くべき専用のマルチパーティ計算もあります。

いずれの場合も教訓は同じです。AI計算の主な部分は行列乗算であり、これに対して非常に効率的なZK-SNARK、MPC(さらにはFHE)を設計できるため、AIを暗号フレームワークに置いたときの総合的なオーバーヘッドは意外に低いのです。通常、非線形層が最大のボトルネックですが、サイズは小さいです。おそらくルックアップ引数(lookup)などの新技術が役立つかもしれません。

ブラックボックス対抗的機械学習

次に、もう一つの重要な問題に移ります。モデルの内容が秘密にされており、API経由でのみアクセスできる場合でも、実行可能な攻撃の種類です。2016年の論文を引用しましょう。

多くの機械学習モデルは敵対的サンプルに対して脆弱です。特別に設計された入力がモデルに誤った出力をさせるのです。あるモデルに影響を与える敵対的サンプルは、通常、アーキテクチャが異なったり異なる訓練データセットで訓練されたりしていても、同じタスクを実行するように訓練された別のモデルにも影響を与えます。したがって、攻撃者は自身の代理モデルを訓練し、代理モデルに対して敵対的サンプルを作成し、被害者モデルに転送できます。被害者に関する情報がほとんどなくてもです。

潜在的には、攻撃対象のモデルへのアクセスが非常に限定的またはまったくなくても、訓練データのみから攻撃を作成できる可能性があります。2023年時点で、このような攻撃は依然として重大な問題です。

このようなブラックボックス攻撃を効果的に抑止するには、次の2つが必要です。

-

誰が、あるいは何がモデルを照会できるか、および照会回数を本当に制限する。無制限のAPIアクセスを持つブラックボックスは安全ではなく、非常に制限されたAPIアクセスを持つブラックボックスは安全である可能性があります。

-

訓練データを隠しつつ、訓練データ作成プロセスが改ざんされていないことを保証することが重要です。

前者に関して、この点で最も注力しているプロジェクトはWorldcoinかもしれません。私はここでその初期バージョン(および他のプロトコル)を詳細に分析しました。Worldcoinはプロトコルレベルで広くAIモデルを使用しており、(i)虹彩スキャンを簡単に類似性を比較できる短い「虹彩コード」に変換し、(ii)スキャン対象が実際に人間であることを検証します。

Worldcoinが依存する主な防御策は、誰も簡単にAIモデルを呼び出せないことです。代わりに、信頼できるハードウェアを使用して、モデルがorbカメラのデジタル署名付き入力のみを受け付けるようにしています。

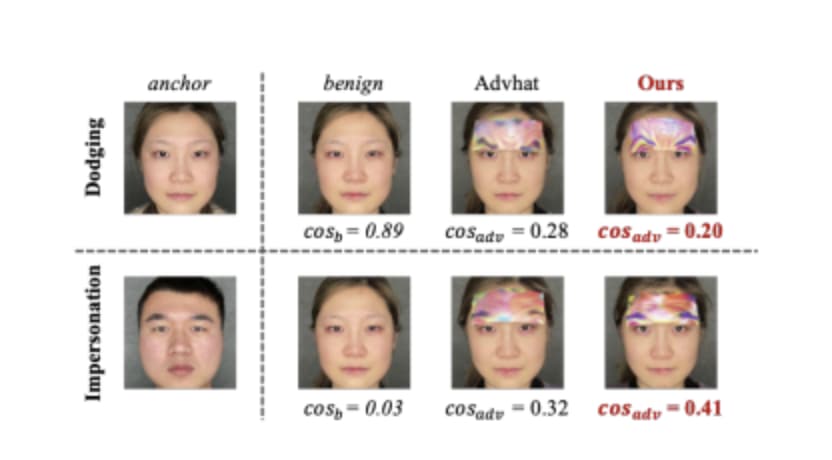

この方法は効果を保証するものではありません。物理的なパッチや顔に装着するジュエリーなどで、バイオメトリクスAIを対抗的に攻撃できることが判明しています。

額に余分なものを装着することで、検出を回避し、他人になりすますことも可能。出典:https://arxiv.org/pdf/2109.09320.pdf

しかし私たちの希望は、AIモデル自体の隠蔽、照会回数の厳格な制限、各照会の何らかの形での認証要求など、すべての防御策を組み合わせれば、対抗的攻撃は非常に困難になり、システムはより安全になるということです。

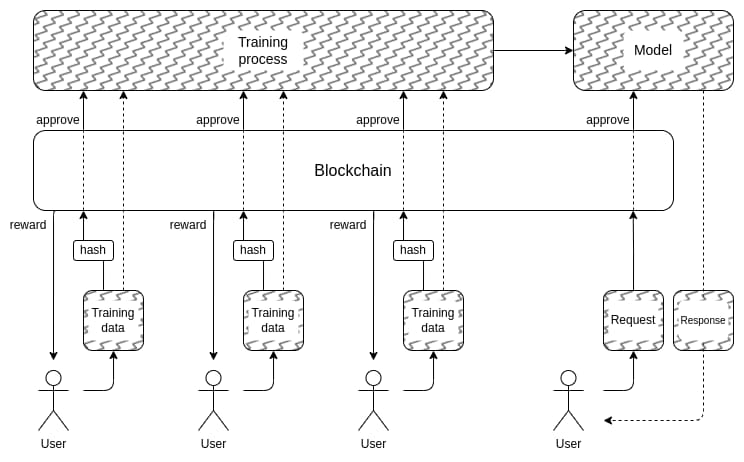

これで2つ目の問題に至ります。訓練データをどうやって隠すか? ここで「DAOが民主的にAIを管理する」ことが実際に意味を持つ可能性があります。オンチェーンのDAOを作成し、誰が訓練データの提出を許可されるか(およびデータに対する必要な表明)、誰が照会できるか、照会回数を管理し、MPCなどの暗号技術を使って、個々のユーザーの訓練入力から各照会の最終出力までのAI作成・運用プロセス全体を暗号化できます。このDAOは、データを提出した人に報酬を与えるという人気の高い目標も同時に満たせます。

繰り返しますが、この計画は非常に野心的であり、非現実的だと証明できる点がいくつもあります。

-

このような完全なブラックボックスアーキテクチャでは、暗号オーバーヘッドが依然として高すぎて、従来の「trust me」方式と競争できない可能性がある。

-

訓練データ提出プロセスを非中央集権化し、中毒攻撃を防ぐ良い方法がない可能性がある。

-

参加者の共謀により、マルチパーティ計算装置がその安全性・プライバシー保証を損なう可能性がある。結局、これはクロスチェーンブリッジで繰り返し起きてきたことです。

この節の冒頭で「AI裁判官を作るな、それはディストピアだ」と警告しなかった理由の一つは、私たちの社会はすでに説明責任のない中央集権的AI裁判官に大きく依存しているからです。ソーシャルメディアでどのタイプの投稿や政治的見解が促進・抑制され、さらには検閲されるかを決定するアルゴリズムです。

私は、現段階でこの傾向をさらに拡大することはかなり悪いアイデアだと思いますが、ブロックチェーンコミュニティがAIについてさらに実験を行うことが状況を悪化させる主な原因になるとまでは思いません。

実際、暗号技術には既存の中央集権システムを改善する非常に基本的で低リスクな方法があり、それについては非常に確信を持っています。その一つの簡単な技術は、遅延公開型の検証AIです。ソーシャルメディアサイトがAIベースの投稿ランキングを使用する場合、そのランキングを生成するモデルのハッシュ値を証明するZK-SNARKを公開できます。そのサイトは、一定の遅延期間(例:1年)後にAIモデルを公開することを約束できます。

モデルが公開されたら、ユーザーはハッシュ値を確認して正しいモデルが公開されたかを検証でき、コミュニティはモデルをテストして公平性を確認できます。公開遅延により、モデルが公開される頃にはすでに時代遅れになっていることを保証します。

したがって、中央集権的世界と比較して、問題はどれだけ良くできるかではなく、どれだけ良くできるかにあるのです。しかし、非中央集権の世界では注意が必要です。誰かがAIオラクルを使用する予測市場やステーブルコインを構築し、その後オラクルが攻撃可能であることが判明すれば、瞬時に大量の資金が消えてしまう可能性があります。

AIをゲーム目的として

上述の、スケーラブルな非中央集権的プライベートAI(その内容は誰にも知られないブラックボックス)を作成する技術が実際に機能すれば、ブロックチェーンを超えた実用性を持つAIの作成にも使えます。NEARプロトコルチームはこれを進行中の作業の中心目標としています。

これには2つの理由があります。

ブロックチェーンとマルチパーティ計算の何らかの組み合わせを使って訓練・推論プロセスを実行することで、「信頼できるブラックボックスAI」が作成できるなら、偏見や騙しの懸念がある多くのアプリケーションが恩恵を受けられます。私たちが依存するAIに対して民主的ガバナンスを求める声が多くあります。暗号学とブロックチェーン技術がその実現手段となる可能性があります。

AI安全性の観点からは、これは自然な緊急停止スイッチを持ちつつ非中央集権的なAIを作成する技術であり、AIを使って悪意ある行為を行う照会を制限できます。

注目すべきは、「より良いAIを作成するインセンティブを暗号で提供する」ことは、完全に暗号で暗号化するというテーマに完全に深入りせずとも実現できる点です。BitTensorのようなアプローチはこのカテゴリに属します。

結論

ブロックチェーンとAIが進化するにつれ、両者の交差点でのユースケースも増加しており、その中にはより意義深く、より堅牢なものが含まれています。

全体として、基本的なメカニズムは設計通りに保ちつつ、個々の参加者がAIに変わるユースケースが、微視的レベルで効果的に機能し、最も即時的な将来性と実現のしやすさを持っています。

最も挑戦的なのは、「シングルトン」(singleton)を作成しようとするアプリケーションです。すなわち、特定の目的のために依存される単一の非中央集権的信頼AIです。

これらのアプリケーションは、機能性とAI安全性の改善の両面で潜在能力を持ち、中央集権リスクを回避できます。

しかし、根底にある仮定は多くの点で破綻する可能性があります。したがって、特に高価値・高リスク環境での展開には慎重である必要があります。

これらの分野すべてで、建設的なAI応用の試みがさらに多く見られることを楽しみにしており、規模において本当に実現可能なユースケースがどれかを明らかにしたいと思います。

TechFlow公式コミュニティへようこそ

Telegram購読グループ:https://t.me/TechFlowDaily

Twitter公式アカウント:https://x.com/TechFlowPost

Twitter英語アカウント:https://x.com/BlockFlow_News