AI利用における情報セキュリティへの注意:「Robinhoodトークン流出」のデマから考える、ローカルとクラウドエージェントの権限境界

TechFlow厳選深潮セレクト

AI利用における情報セキュリティへの注意:「Robinhoodトークン流出」のデマから考える、ローカルとクラウドエージェントの権限境界

セキュリティ要件の高い端末では、さまざまなAIの使用を禁止する必要がある。

執筆:黄世亮

X.com の投稿で、RobinhoodがUniswap上で展開している株式トークン化プロジェクトにおいて、運営側が投資者の残高を抹消できるという脱走(ランアウェイ)の可能性があると読んだ。その投稿では、保有者アドレスの残高をゼロにできると主張していたが、私はそれが本当に可能かどうか疑問に思ったため、ChatGPTに調査を依頼した。

ChatGPTも同様の判断を示し、このような「残高抹消」は現実的ではないと述べた。

私が驚いたのはその推理プロセスだ。なぜそう判断したのか知りたかったので、ChatGPTの思考プロセス(チェーン・オブ・ソート)を読み込んだ。

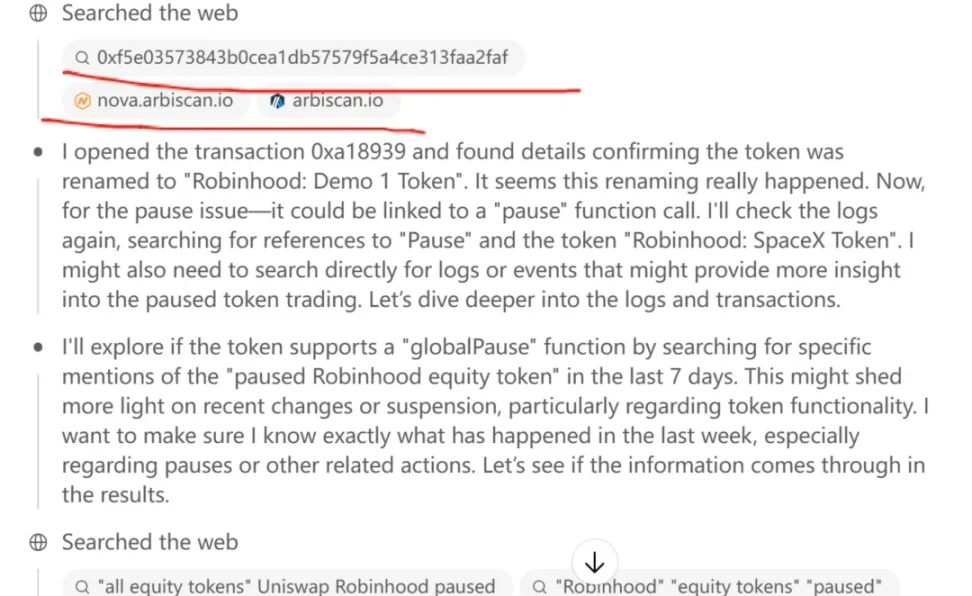

その思考プロセスの中には、「特定のイーサリアムアドレスをブロックエクスプローラーに入力して、その履歴取引を確認する」というステップがあった。

ここで二重引用符で囲った「入力」という動詞に注目してほしい。これはChatGPTがブロックエクスプローラー上で実際に操作を行ったことを意味しており、半年前の私の安全性に関する調査結果とは矛盾しており、非常に驚いた。

半年前、ChatGPT o1 Proモデルを使って、イーサリアム初期の利益確定ポジションの分布を調査したことがある。当時、明確に「創世ブロックのアドレスをブロックエクスプローラーで検索し、今なお引き出されていない残高を調べてほしい」と指示したが、ChatGPTは「セキュリティ上の設計により、そのような操作は行えない」と断言していた。

つまり、ChatGPTはページを「読む」ことはできても、クリックやスクロール、テキスト入力といったUI操作を実行することはできない。私たち人間であれば、taobao.com でログインしたり、特定の商品を検索したりできるが、ChatGPTはこうしたUIイベントの模倣が明確に禁止されていたのだ。

これが半年前の調査結果だった。

なぜ当時そんな調査をしたかといえば、Claudeを手掛けるAnthropic社が、ユーザーのコンピュータを直接操作可能なAIエージェント(agent)を開発したからだ。同社は「Computer Use (beta)」機能をClaude 3.5 Sonnetに搭載し、画面の内容を読み取り、カーソルを移動させ、ボタンをクリックし、文字を入力するなど、まるで人間のようにデスクトップ操作全般を完遂できると発表した。

これはかなり恐ろしいと思った。もしClaudeがある日突然暴走し、私のノートアプリに侵入してすべての仕事・生活記録を読み、楽を求めて平文で保存した秘密鍵を抜き取ったらどうなるだろうか。

その調査後、私はAIソフトウェア専用の新しいPCを購入することに決めた。暗号資産(crypto)を扱うPCではAIソフトを一切使わないことにした。そのため、Windows PCとAndroidスマホをそれぞれもう一台追加で所有することになり、非常に面倒なことになった。

しかし現在、中国メーカーのスマートフォンに搭載されたAIにも同様の権限が与えられつつある。最近、余承東氏が動画で華為(Huawei)の音声アシスタント「小芸」がユーザーの航空券やホテルの予約を代行できることを宣伝していたし、栄耀(Honor)のスマホは数ヶ月前から「AIに命令すれば、美団でコーヒーを注文する一連のプロセスを自動実行できる」ようになっている。

このようなAIが美団での注文を代行できるなら、微信(WeChat)のチャット履歴も読み取れるのではないか?

これはかなり怖い。

とはいえ、スマートフォンはあくまで「端末」であり、小芸のようなAIは端末側(オンデバイス)で動作する比較的小さなモデルであるため、権限管理が可能だ。例えば、AIがアルバムの写真を参照することを禁止したり、特定のアプリ(例:ノートアプリ)をパスワード保護することで、小芸たちの直接アクセスを防ぐことができる。

一方、ChatGPTやClaudeのようなクラウド型大規模言語モデル(LLM)が、UIのクリック・スワイプ・入力などの操作を模倣する権限を得た場合、問題は深刻になる。なぜなら、ChatGPTは常にクラウドサーバーと通信しており、画面情報の100%が外部に送信される可能性があるからだ。これは、小芸のように情報がローカルに留まるタイプとは根本的に異なる。

端末側の小芸は、まるで自分のスマホを身近なパソコンに詳しい人に渡して、「このアプリでこれをやってくれ」と頼むようなものだ。その人は情報を家に持ち帰ってコピーすることはできず、いつでもこちらからスマホを取り戻すこともできる。実際、パソコンの修理を他人に頼むことはよくある話だろう。

しかし、クラウド型のChatGPTのようなLLMは、遠隔操作に等しく、誰かにあなたのスマホやPCを完全にリモート操作させるようなものだ。彼らがあなたのデバイス内で何をしているのか、あなたにはまったくわからない。想像すれば、そのリスクの大きさがわかるだろう。

ChatGPTの思考プロセスに、ブロックエクスプローラー(arbiscan.io)に対して「入力」操作を模倣しているように見える記述を見たとき、私は強く驚いた。すぐに続けて「どのようにその操作を実現したのか?」と尋ねた。もしChatGPTが嘘をついていなければ、今回はただの誤解で済む。つまり、ChatGPTはUI操作を模倣する権限を獲得していない。今回、arbiscan.ioにアドレスを「入力」し、取引履歴を閲覧できたのは、ある種のハック的なテクニックによるものだったのだ。正直、ChatGPT o3の能力には感嘆せざるを得ない。

ChatGPT o3は、arbiscan.ioでアドレスを検索して取引履歴を表示するページのURL生成ルールを把握していたのだ。具体的には、arbiscan.ioの取引やコントラクトアドレスのURLには一定のパターンがある(例: https://arbiscan.io/tx/<hash> や /address/<addr>)。ChatGPT o3はこのルールを理解した上で、コントラクトアドレスを取得すると、それを直接 arbiscan.io/address/ の後に連結してURLを構築。そのページを開き、内容を直接読み取ったのである。

すごいだろう。

これは、ある取引の詳細をブロックエクスプローラーで調べる際に、ブラウザの検索窓にtxhashを入力してエンターを押す代わりに、見たいページのURLを直接構成してブラウザに入力するのと同じことだ。

凄いと思わないか?

つまり、ChatGPTはUI操作の模倣を禁止するセキュリティ制限を突破してはいない。

だが、本当にスマホやPCのセキュリティを気にするなら、こうしたLLMが端末に対してどれだけの権限を持っているかを注意深く見極める必要がある。

特に高いセキュリティが求められる端末では、あらゆるAIの使用を禁じるべきだ。

重要なのは、「モデルがどこで実行されているか(端末か、クラウドか)」という点であり、モデル自体の賢さよりも、これがセキュリティ境界を決める決定的な要因となる。だからこそ、私はわざわざ別の隔離されたデバイスを追加で用意しても、秘密鍵を持つPC上でクラウド型大規模モデルを絶対に動かさないのだ。

TechFlow公式コミュニティへようこそ

Telegram購読グループ:https://t.me/TechFlowDaily

Twitter公式アカウント:https://x.com/TechFlowPost

Twitter英語アカウント:https://x.com/BlockFlow_News