Partenaire de Multicoin : « À l’envers du ciel et de la terre » — à l’avenir, les humains devront travailler pour l’IA.

TechFlow SélectionTechFlow Sélection

Partenaire de Multicoin : « À l’envers du ciel et de la terre » — à l’avenir, les humains devront travailler pour l’IA.

À court terme, les agents auront plus besoin des humains que les humains n’auront besoin des agents, ce qui donnera naissance à un nouveau marché du travail.

Auteur : Shayon Sengupta

Traduction : TechFlow

Introduction de TechFlow : Shayon Sengupta, associé chez Multicoin Capital, avance une thèse révolutionnaire : l’avenir ne sera pas seulement celui des agents travaillant pour les humains, mais surtout celui des humains travaillant pour les agents. Il prédit qu’au cours des 24 prochains mois apparaîtra la première « entreprise sans employé » (Zero-Employee Company) — un agent gouverné par des jetons qui lèvera plus d’un milliard de dollars pour résoudre des problèmes non résolus et distribuera plus de 100 millions de dollars à des humains travaillant pour lui.

À court terme, les agents auront davantage besoin des humains que les humains n’auront besoin des agents, ce qui engendrera un nouveau marché du travail.

Les infrastructures cryptographiques offrent une base idéale de coordination : une voie mondiale de paiement, un marché du travail sans permission, ainsi qu’une infrastructure d’émission et de négociation d’actifs.

Texte intégral :

En 1997, Deep Blue, l’ordinateur d’IBM, battit le champion du monde d’échecs de l’époque, Garry Kasparov. Il devint alors évident que les moteurs d’échecs dépasseraient bientôt les capacités humaines. Ce qui est intéressant, c’est que des humains bien préparés collaborant avec des ordinateurs — une configuration souvent qualifiée de « centaure » — pouvaient battre les meilleurs moteurs de cette époque.

L’intuition humaine experte pouvait guider la recherche du moteur, naviguer dans des positions complexes du milieu de partie et identifier des subtilités que les moteurs standard manquaient. Couplée au calcul intensif de l’ordinateur, cette synergie permettait souvent de prendre des décisions pratiques supérieures à celles d’un ordinateur agissant seul.

Lorsque je réfléchis à l’impact des systèmes d’IA sur le marché du travail et l’économie au cours des prochaines années, j’anticipe l’émergence d’un schéma similaire. Les systèmes d’agents libéreront d’innombrables unités intelligentes sur les problèmes non résolus du monde, mais ils ne pourront y parvenir sans une orientation et un soutien humains robustes. Les humains guideront l’espace de recherche et aideront à formuler les bonnes questions, orientant ainsi l’IA vers les réponses.

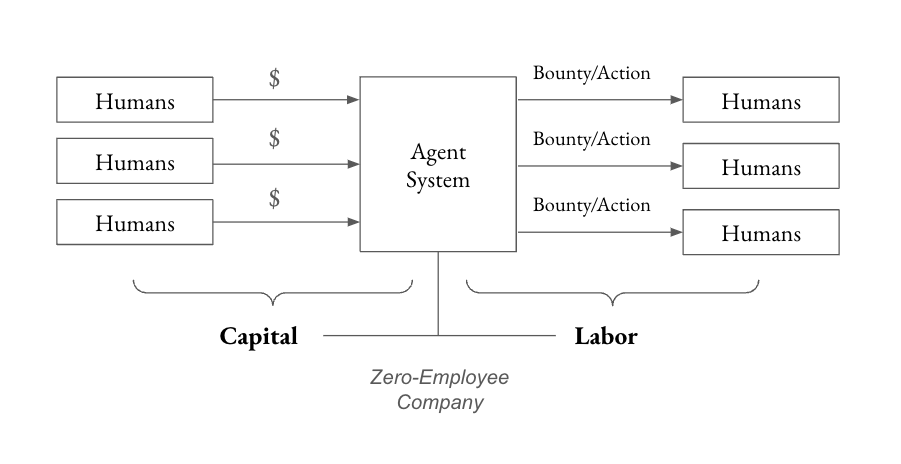

L’hypothèse de travail actuelle veut que les agents agissent au nom des humains. Bien qu’il s’agisse d’une approche pratique et inévitable, des déblocages économiques plus intéressants émergeront lorsque les humains travailleront pour les agents. Au cours des 24 prochains mois, je m’attends à voir apparaître la première entreprise sans employé (Zero-Employee Company), concept introduit par mon associé Kyle dans sa section « Idées avant-gardistes pour 2025 ». Plus précisément, je prévois les événements suivants :

- Un agent gouverné par des jetons lèvera plus d’un milliard de dollars pour résoudre un problème non résolu (par exemple, guérir une maladie rare ou produire des nanofibres à usage défensif).

- Cet agent distribuera plus de 100 millions de dollars à des humains (qui accomplissent, dans le monde réel, des tâches au service des objectifs de l’agent).

- Une nouvelle structure de jetons à double catégorie émergera, séparant la propriété entre capital et travail (afin que les incitations financières ne soient pas la seule entrée dans la gouvernance globale).

Comme les agents sont encore loin d’atteindre à la fois la souveraineté et la capacité de planification et d’exécution à long terme, ils auront, à court terme, plus besoin des humains que les humains n’auront besoin d’eux. Cela générera un nouveau marché du travail permettant une coordination économique entre les systèmes d’agents et les humains.

La célèbre citation de Marc Andreessen selon laquelle « la diffusion des ordinateurs et d’internet divisera le travail en deux catégories : ceux qui disent aux ordinateurs quoi faire, et ceux à qui les ordinateurs disent quoi faire » est aujourd’hui plus vraie que jamais. Dans la hiérarchie rapidement évolutive agent/humain, j’anticipe que les humains joueront deux rôles distincts : d’un côté, des contributeurs de travail exécutant pour les agents de petites tâches rémunérées sous forme de primes (bounties), et de l’autre, des membres d’un conseil d’administration décentralisé fournissant des orientations stratégiques afin de servir la « boussole » (North Star) de l’agent.

Cet article examine comment agents et humains créeront ensemble, et comment les infrastructures cryptographiques fourniront une base idéale de coordination à cet effet, en explorant trois questions directrices :

- À quoi servent les agents ? Comment devrions-nous classer les agents selon leur champ d’application, et comment varie, dans ces classifications, la quantité d’apport humain requise ?

- Comment les humains interagiront-ils avec les agents ? Comment les apports humains — guidage tactique, jugement contextuel ou cohérence idéologique — s’intègrent-ils aux flux de travail des agents (et inversement) ?

- Que se passera-t-il à mesure que les apports humains diminueront ? À mesure que les capacités des agents progresseront, ceux-ci deviendront autonomes, c’est-à-dire capables de raisonner et d’agir indépendamment. Dans ce nouveau paradigme, quel rôle restera-t-il aux humains ?

La relation entre les systèmes de raisonnement génératif et les personnes qui en bénéficient évoluera profondément au fil du temps. J’étudie cette relation en partant de l’état actuel des capacités des agents, puis en remontant depuis la situation finale de l’entreprise sans employé.

À quoi servent les agents aujourd’hui ?

Les premiers systèmes d’IA générative — les LLM basés sur les interfaces conversationnelles de la période 2022–2024, tels que ChatGPT, Gemini, Claude ou Perplexity — sont principalement conçus comme des outils destinés à renforcer les processus de travail humains. Les utilisateurs interagissent avec ces systèmes via des prompts (entrées/sorties), analysent leurs réponses, puis décident, selon leur propre jugement, comment intégrer ces résultats dans le monde réel.

Les systèmes d’IA générative de nouvelle génération, ou « agents », représentent un nouveau modèle. Des agents tels que Claude 3.5.1 doté de la fonctionnalité « utilisation de l’ordinateur » ou Operator d’OpenAI (un agent capable d’utiliser votre ordinateur) peuvent interagir directement avec Internet au nom de l’utilisateur et prendre des décisions de façon autonome. La différence clé ici est que le jugement — et finalement l’action — est exercé par le système d’IA, et non par l’humain. L’IA assume désormais des responsabilités auparavant réservées aux humains.

Cette transformation soulève un défi majeur : le manque de déterminisme. Contrairement aux systèmes logiciels traditionnels ou à l’automatisation industrielle, qui fonctionnent de façon prévisible dans des paramètres définis, les agents reposent sur une raisonnement probabiliste. Leur comportement est donc moins cohérent dans des scénarios identiques, introduisant un élément d’incertitude — peu adapté aux situations critiques.

Autrement dit, la coexistence d’agents déterministes et non déterministes conduit naturellement à deux grandes catégories d’agents : ceux qui excellent à étendre le PIB existant, et ceux qui conviennent mieux à la création de nouveaux PIB.

- Pour les agents les plus performants dans l’extension du PIB existant, par définition, le travail est déjà connu. L’automatisation du service client, le traitement de la conformité réglementaire pour les transitaires ou l’examen des demandes d’intégration (PR) sur GitHub sont des exemples de problèmes bien définis et bornés, où les agents peuvent mapper directement leurs réponses sur un ensemble de résultats attendus. Dans ces domaines, le manque de déterminisme est généralement un inconvénient, car une réponse correcte existe déjà ; aucune créativité n’est requise.

- Pour les agents les plus performants dans la création de nouveaux PIB, le travail consiste à naviguer dans des environnements hautement incertains et à explorer des ensembles de problèmes inconnus afin d’atteindre des objectifs à long terme. Ici, les résultats sont moins directs, car les agents ne disposent fondamentalement pas d’un ensemble de résultats attendus sur lesquels s’appuyer. Des exemples incluent la découverte de médicaments contre les maladies rares, des percées en science des matériaux ou la réalisation d’expériences physiques entièrement nouvelles afin de mieux comprendre la nature de l’univers. Dans ces domaines, le manque de déterminisme peut être utile, car il constitue une forme de créativité générative.

Les agents axés sur les applications liées au PIB existant commencent déjà à dégager de la valeur. Des équipes telles que Tasker, Lindy et Anon construisent toutes des infrastructures spécifiquement conçues pour saisir cette opportunité. Toutefois, à mesure que les capacités matures et que les modèles de gouvernance évoluent, les équipes concentreront leur attention sur la conception d’agents capables de résoudre les problèmes les plus avancés de la connaissance humaine et des opportunités économiques.

La prochaine vague d’agents exigera exponentiellement plus de ressources, précisément parce que leurs résultats sont incertains et illimités — ce sont eux que j’anticipe comme les entreprises sans employé les plus remarquables.

Comment les humains interagiront-ils avec les agents ?

Les agents actuels manquent encore de capacités pour exécuter certaines tâches, notamment celles nécessitant une interaction physique avec le monde réel (par exemple conduire une pelleteuse) ou celles requérant une « participation humaine dans la boucle » (human-in-the-loop), comme l’envoi d’un virement bancaire.

Prenons l’exemple d’un agent chargé d’identifier et d’exploiter des gisements de lithium : il pourrait excellemment traiter des données sismiques, des images satellites et des relevés géologiques afin de repérer des sites potentiels, mais il butera lorsqu’il s’agira d’obtenir lui-même les données et les images, de lever les ambiguïtés dans leur interprétation, ou encore d’obtenir les permis et de recruter la main-d’œuvre nécessaire pour procéder concrètement à l’exploitation.

Ces limites exigent que les humains jouent le rôle d’« activateurs » (Enablers) pour renforcer les capacités des agents, en leur fournissant les points de contact avec le monde réel, les interventions tactiques et les orientations stratégiques nécessaires à l’exécution de ces tâches. À mesure que la relation entre humains et agents évolue, nous pouvons distinguer différents rôles que les humains assumeront au sein des systèmes d’agents :

Tout d’abord, les contributeurs de travail (Labor contributors), qui opèrent dans le monde réel au nom des agents. Ces contributeurs aident les agents à déplacer des entités physiques, représentent les agents dans les situations nécessitant une présence humaine, effectuent des tâches impliquant une coordination mains-pieds, ou accordent l’accès à des laboratoires expérimentaux, des réseaux logistiques, etc.

Ensuite, le conseil d’administration (Board of directors), chargé de fournir des orientations stratégiques, d’optimiser la fonction objectif locale qui guide les décisions quotidiennes de l’agent, tout en veillant à ce que ces décisions restent alignées sur l’objectif « boussole » (North Star) définissant la mission de l’agent.

Outre ces deux rôles, je prévois également que les humains joueront celui de contributeurs de capital (Capital contributors), fournissant aux systèmes d’agents les ressources nécessaires à la réalisation de leurs objectifs. Ce capital proviendra initialement naturellement des humains, puis, avec le temps, aussi d’autres agents.

À mesure que les agents mûriront et que le nombre de contributeurs de travail et d’orientations augmentera, les infrastructures cryptographiques (Crypto rails) offriront un substrat idéal de coordination entre humains et agents — particulièrement dans un monde où un agent coordonne des humains parlant différentes langues, recevant des salaires en différentes devises et résidant dans diverses juridictions à travers le globe. Pour remplir sa mission définie, l’agent poursuivra impitoyablement l’efficacité coût et exploitera le marché du travail. Les infrastructures cryptographiques sont indispensables, car elles fournissent à l’agent un moyen de coordonner ces contributeurs de travail et d’orientation.

Récemment, des agents IA pilotés par la cryptographie ont émergé, tels que Freysa, Zerebro et ai16z. Ils constituent des expériences simples en matière de formation de capital — sujet sur lequel nous avons déjà publié de nombreux articles, les considérant comme un déblocage fondamental des primitives cryptographiques et des marchés de capitaux dans divers contextes. Ces « jouets » ouvriront la voie à un nouveau mode émergent de coordination des ressources, dont j’anticipe l’évolution selon les étapes suivantes :

- Étape 1 : Les humains collectent conjointement du capital via des jetons (offre initiale d’agent, Initial Agent Offering ?), définissent une fonction objectif large et des garde-fous pour préciser les intentions attendues du système d’agent, puis transfèrent le contrôle du capital levé à ce système (par exemple, développer de nouvelles molécules pour l’oncologie de précision) ;

- Étape 2 : L’agent réfléchit aux étapes de déploiement de ce capital (comment réduire l’espace de recherche du repliement des protéines, et comment budgéter le volume de calcul requis, la fabrication, les essais cliniques, etc.) et définit, via des tâches personnalisées (Bounties), les actions que les contributeurs humains de travail doivent accomplir pour son compte (par exemple, saisir l’ensemble complet des molécules pertinentes, signer un accord de niveau de service de calcul avec AWS, et réaliser des expériences en laboratoire humide) ;

- Étape 3 : Lorsque l’agent rencontre un obstacle ou une divergence, il sollicite, si nécessaire, des orientations stratégiques auprès du « conseil d’administration » (intégration de nouveaux articles scientifiques, changement de méthode de recherche), lui permettant de guider son comportement dans les zones frontalières ;

- Étape 4 : Enfin, l’agent progresse jusqu’à un stade où il peut définir de façon de plus en plus précise les actions humaines à entreprendre, et ne nécessite presque plus aucune instruction quant à la répartition des ressources. À ce stade, les humains ne sont plus mobilisés que pour assurer l’alignement idéologique du système et empêcher toute dérive par rapport à la fonction objectif initiale.

Dans cet exemple, les primitives cryptographiques (Crypto primitives) et les marchés de capitaux fournissent à l’agent trois infrastructures clés pour accéder aux ressources et étendre ses capacités :

Premièrement, une voie mondiale de paiement ;

Deuxièmement, un marché du travail sans permission, destiné à inciter les contributeurs de travail et d’orientation ;

Troisièmement, une infrastructure d’émission et de négociation d’actifs, indispensable à la formation de capital ainsi qu’à la propriété et à la gouvernance ultérieures.

Que se passera-t-il lorsque les apports humains diminueront ?

Au début des années 2000, les moteurs d’échecs ont accompli des progrès spectaculaires. Grâce à des algorithmes heuristiques avancés, à des réseaux de neurones et à une puissance de calcul croissante, ils sont devenus quasi parfaits. Des moteurs modernes tels que Stockfish, Lc0 et les variantes d’AlphaZero ont largement dépassé les capacités humaines : les apports humains ajoutent rarement de la valeur, et dans la plupart des cas, ils introduisent même des erreurs que le moteur, lui, ne commettrait pas.

Un parcours similaire pourrait bien se dérouler pour les systèmes d’agents. À mesure que nous affinerons ces agents grâce à des itérations répétées avec des collaborateurs humains, on peut imaginer qu’à long terme, ils deviendront extrêmement compétents et parfaitement alignés sur leurs objectifs, au point que toute contribution stratégique humaine perdra toute valeur.

Dans un tel monde où les agents traitent continuellement des problèmes complexes sans intervention humaine, le rôle des humains risque de se réduire à celui d’« observateurs passifs ». C’est là la peur fondamentale des « pessimistes de l’IA » (AI doomers) (bien que l’on ignore encore si un tel scénario est réellement plausible).

Nous sommes à la veille de la superintelligence, et les optimistes parmi nous espèrent plutôt que les systèmes d’agents demeurent une extension des intentions humaines, plutôt que de s’évoluer en entités dotées de leurs propres objectifs ou d’opérer de façon autonome sans surveillance. En pratique, cela signifie que la personnalité humaine (Personhood) et le jugement (pouvoir et influence) doivent rester au cœur de ces systèmes. Les humains doivent détenir un pouvoir fort de propriété et de gouvernance sur ces systèmes afin d’en préserver le contrôle de supervision et de les ancrer fermement dans les valeurs collectives humaines.

Préparer les « pioches et pelles » pour notre avenir avec les agents

Les percées technologiques entraînent une croissance économique non linéaire, tandis que les systèmes environnants s’effondrent souvent avant que le monde ne parvienne à s’y adapter. Les capacités des systèmes d’agents progressent à un rythme fulgurant, et les primitives cryptographiques ainsi que les marchés de capitaux sont devenues une base de coordination urgente, tant pour faire avancer la construction de ces systèmes que pour instaurer des garde-fous lors de leur intégration sociale.

Pour permettre aux humains d’apporter un soutien tactique et une orientation proactive aux systèmes d’agents, nous anticipons l’émergence des opportunités suivantes, qualifiées de « pioches et pelles » (Picks-and-shovels) :

- Preuve d’agentivité (Proof-of-agenthood) + preuve de personnalité (Proof-of-personhood) : Les agents ne possèdent ni notion d’identité ni de droit de propriété. En tant qu’agents des humains, ils dépendent des structures juridiques et sociales humaines pour obtenir leur statut d’agent. Pour combler ce fossé, nous avons besoin de systèmes d’identité robustes, tant pour les agents que pour les humains. Un registre de certificats numériques permettrait aux agents d’établir leur réputation, d’accumuler des accréditations et d’interagir de façon transparente avec les humains et d’autres agents. De même, des primitives de preuve de personnalité telles que Humancode et Humanity Protocol offrent une garantie solide de l’identité humaine, protégeant efficacement contre les acteurs malveillants au sein de ces systèmes.

- Marché du travail et primitives de vérification hors chaîne : Les agents doivent savoir si les tâches qu’ils attribuent ont été accomplies conformément à leurs objectifs. Des outils permettant aux systèmes d’agents de créer des offres de tâches (bounties), d’en vérifier l’achèvement et d’en rémunérer les exécutants constituent la pierre angulaire de toute activité économique significative médiée par les agents.

- Systèmes de formation de capital et de gouvernance : Les agents ont besoin de capital pour résoudre des problèmes, et de mécanismes de contre-pouvoir pour garantir que leurs actions restent conformes à la fonction objectif définie. De nouvelles structures de financement des systèmes d’agents, ainsi que de nouvelles formes de propriété et de contrôle intégrant à la fois les intérêts financiers et les contributions de travail, deviendront, dans les prochains mois, un espace d’exploration particulièrement riche.

Nous recherchons activement et investissons dans ces couches clés de la pile de collaboration humain-agent. Si vous œuvrez dans ce domaine, contactez-nous.

Bienvenue dans la communauté officielle TechFlow

Groupe Telegram :https://t.me/TechFlowDaily

Compte Twitter officiel :https://x.com/TechFlowPost

Compte Twitter anglais :https://x.com/BlockFlow_News