Donner un milliard à Nokia, Huang Renxun veut en gagner 200 milliards

TechFlow SélectionTechFlow Sélection

Donner un milliard à Nokia, Huang Renxun veut en gagner 200 milliards

Huang Renxun a dévoilé une série de nouveautés majeures lors du GTC 2025.

Lors du GTC 2025, Jensen Huang a dévoilé une information choc : NVIDIA va investir un milliard de dollars dans Nokia. Oui, ce même Nokia, l'ancienne entreprise de téléphonie Symbian populaire il y a vingt ans.

Dans son discours, Jensen Huang a déclaré que les réseaux de télécommunications sont en pleine transition d'une architecture traditionnelle vers des systèmes nativement conçus pour l'IA, et que l'investissement de NVIDIA accélérera ce processus. Ainsi, NVIDIA et Nokia collaboreront pour créer conjointement une plateforme IA dédiée aux réseaux 6G, intégrant l'intelligence artificielle dans les réseaux RAN traditionnels.

Concrètement, NVIDIA souscrira à environ 166 millions de nouvelles actions de Nokia au prix unitaire de 6,01 dollars, ce qui lui permettra de détenir environ 2,9 % du capital de Nokia.

Au moment de l'annonce du partenariat, le cours de l'action Nokia a bondi de 21 %, sa plus forte hausse depuis 2013.

01

Qu'est-ce que l'AI-RAN ?

RAN signifie « réseau d'accès radio », et l'AI-RAN est une nouvelle architecture réseau intégrant directement la puissance de calcul IA dans les stations de base sans fil. Alors que les systèmes RAN traditionnels se contentent de transmettre des données entre les stations de base et les appareils mobiles, l'AI-RAN ajoute des capacités de calcul en périphérie (edge computing) et de traitement intelligent.

Cela permet aux stations de base d'utiliser des algorithmes d'IA afin d'optimiser l'utilisation du spectre et l'efficacité énergétique, améliorant ainsi les performances globales du réseau. En outre, les actifs RAN inutilisés peuvent héberger des services IA en périphérie, créant ainsi de nouvelles sources de revenus pour les opérateurs.

Les opérateurs peuvent exécuter directement des applications IA sur site, sans avoir à transférer toutes les données vers un centre de données central, réduisant considérablement la charge du réseau.

Jensen Huang donne un exemple : près de 50 % des utilisateurs de ChatGPT y accèdent via des appareils mobiles, et les téléchargements mensuels de l'application dépassent désormais 40 millions. À l'ère de l'explosion des applications d'IA, les systèmes RAN traditionnels ne peuvent plus faire face à l'essor de l'IA générative et aux réseaux mobiles pilotés par des agents intelligents.

L'AI-RAN, grâce à ses capacités distribuées de raisonnement IA en périphérie, permet aux prochaines applications d'IA – comme les agents intelligents ou les chatbots – de répondre plus rapidement. Par ailleurs, l'AI-RAN prépare également le terrain aux applications intégrées de communication et de détection prévues pour l'ère 6G.

Jensen Huang cite une prévision de l'analyste Omdia : cette société anticipe que le marché RAN dépassera cumulativement 200 milliards de dollars d'ici 2030, dont la part liée à l'AI-RAN deviendra le segment à la croissance la plus rapide.

Dans une déclaration commune, Justin Hotard, président-directeur général de Nokia, affirme que ce partenariat placera un centre de données IA dans la poche de chacun, permettant une refonte fondamentale du passage de la 5G à la 6G.

Il précise que Nokia collabore avec trois entreprises aux profils différents : NVIDIA, Dell et T-Mobile. T-Mobile, premier partenaire annoncé, entamera des tests sur le terrain dès 2026 pour valider les gains de performance et d'efficacité. Selon Justin, ces essais fourniront des données précieuses pour l'innovation 6G et aideront les opérateurs à construire des réseaux intelligents adaptés aux besoins de l'IA.

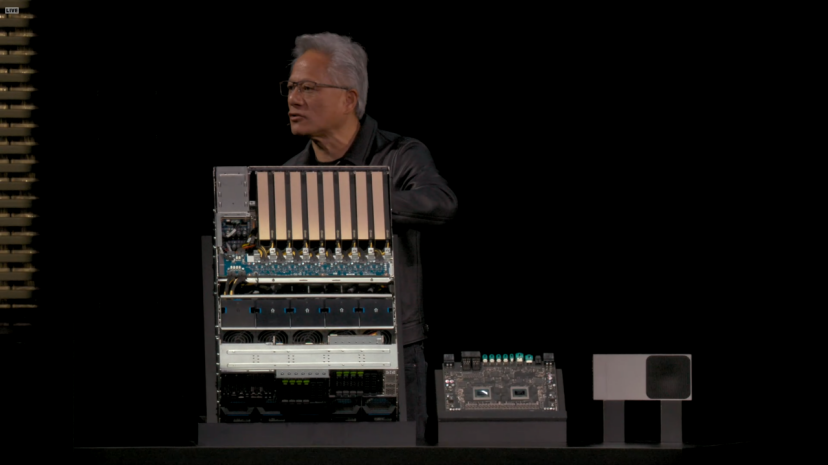

Le nouveau produit lancé par NVIDIA basé sur l'AI-RAN s'appelle Aerial RAN Computer Pro (ARC-Pro), une plateforme de calcul accéléré destinée à la 6G. Sa configuration matérielle centrale inclut deux types de GPU de NVIDIA : le CPU Grace et le GPU Blackwell.

Cette plateforme fonctionne avec NVIDIA CUDA, permettant au logiciel RAN d'être directement intégré dans la pile technologique CUDA. Elle peut donc non seulement gérer les fonctions classiques de réseau d'accès radio, mais aussi exécuter simultanément des applications IA populaires. C’est précisément cette approche qui incarne les deux lettres « AI » dans AI-RAN chez NVIDIA.

Compte tenu de l'historique bien établi de CUDA, le principal avantage de cette plateforme réside en sa programmabilité. Jensen Huang a en outre annoncé que le framework logiciel Aerial sera rendu open source, avec une publication prévue sur GitHub à partir de décembre 2025 sous licence Apache 2.0.

La principale différence entre ARC-Pro et son prédécesseur ARC réside dans leur lieu de déploiement et leurs cas d'utilisation. Le modèle ARC précédent était principalement utilisé pour des implémentations cloud RAN centralisées, tandis qu'ARC-Pro peut être déployé directement sur site dans les stations de base, permettant ainsi une véritable mise en œuvre du calcul en périphérie.

Ronnie Vasishta, responsable des activités télécoms chez NVIDIA, explique que jusqu’ici, RAN et IA nécessitaient deux ensembles distincts de matériel, mais que ARC-Pro peut allouer dynamiquement les ressources de calcul selon les besoins du réseau, privilégiant soit les fonctions d’accès radio, soit les tâches de raisonnement IA pendant les périodes d’inactivité.

ARC-Pro intègre également la plateforme AI Aerial de NVIDIA, une pile logicielle complète comprenant des logiciels RAN accélérés par CUDA, les outils de jumeau numérique Aerial Omniverse et le nouveau Aerial Framework. Ce dernier permet de convertir du code Python en code CUDA haute performance exécutable sur la plateforme ARC-Pro. La plateforme prend également en charge des modèles de réseaux neuronaux pilotés par l'IA pour des estimations avancées de canal.

Jensen Huang déclare que les télécommunications constituent le système nerveux numérique de l'économie et de la sécurité. Grâce à la collaboration avec Nokia et l'écosystème télécom, cette révolution sera lancée, aidant les opérateurs à construire des réseaux intelligents et adaptables, définissant ainsi la connectivité mondiale de la prochaine génération.

02

En regardant l'année 2025, NVIDIA a effectivement investi massivement.

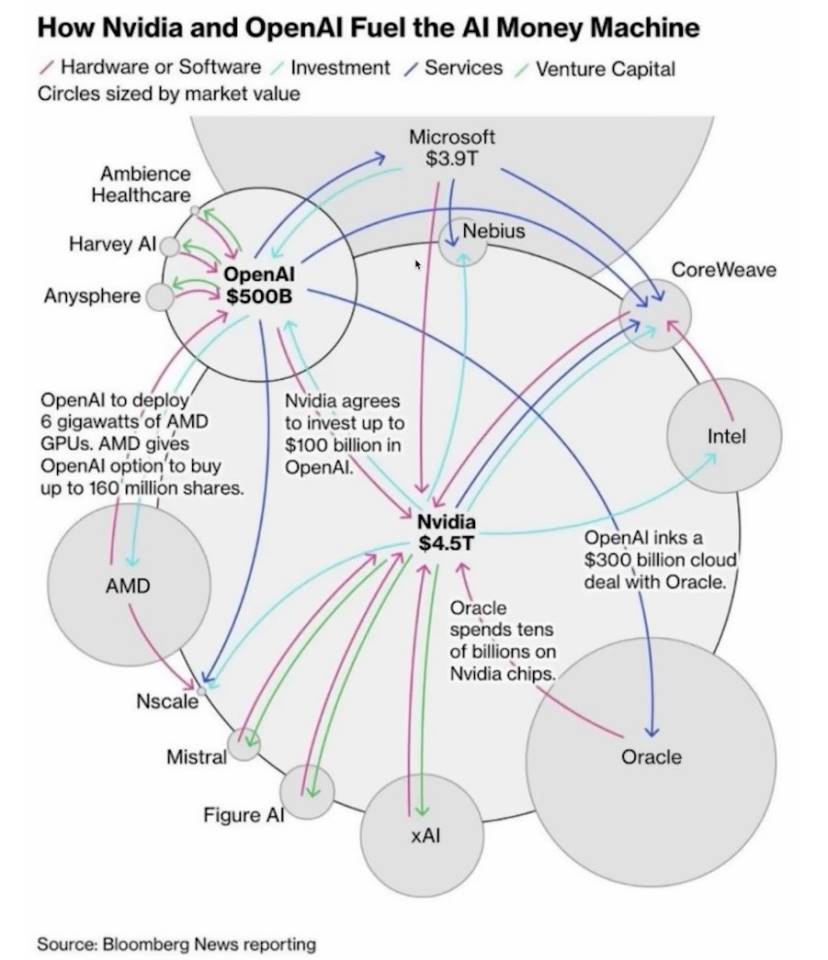

Le 22 septembre, NVIDIA et OpenAI ont conclu un partenariat, par lequel NVIDIA prévoit d'investir progressivement 100 milliards de dollars dans OpenAI, accélérant ainsi le développement de ses infrastructures.

Jensen Huang indique qu'OpenAI avait sollicité un investissement de NVIDIA depuis longtemps, mais que l'entreprise disposait alors de moyens limités. Il plaisante en disant qu'à l'époque, ils étaient trop pauvres, et qu'ils auraient dû tout donner à OpenAI.

Il estime que la croissance du raisonnement IA n'est pas de 100 ou 1000 fois, mais de 1 milliard de fois. Cette collaboration ne se limite pas au matériel, elle inclut aussi l'optimisation logicielle, garantissant qu'OpenAI utilise efficacement les systèmes NVIDIA.

Cela pourrait être dû au fait qu'il a appris la collaboration entre OpenAI et AMD, craignant qu'OpenAI n'abandonne CUDA. Si le plus grand modèle fondamental d'IA au monde cessait d'utiliser CUDA, il serait naturel que d'autres fabricants de grands modèles suivent cet exemple.

Dans l'émission du podcast BG2, Jensen Huang prédit qu'OpenAI deviendra probablement la prochaine entreprise valorisée mille milliards de dollars, atteignant un rythme de croissance inégalé dans l'industrie. Il réfute l'idée d'une bulle IA, affirmant que les dépenses mondiales annuelles en infrastructure IA atteindront 5 000 milliards de dollars.

C'est précisément grâce à cet investissement qu'OpenAI a annoncé le 29 octobre avoir finalisé une restructuration financière. L'entreprise a été divisée en deux entités : une fondation à but non lucratif et une société commerciale à but lucratif.

La fondation à but non lucratif exercera un contrôle juridique sur la partie lucrative, tout en devant prendre en compte l'intérêt public. Elle pourra néanmoins lever des fonds ou acquérir des sociétés librement. La fondation détiendra 26 % des actions de la société commerciale ainsi qu'un warrant. Si l'entreprise continue de croître, la fondation pourra obtenir des actions supplémentaires.

Outre OpenAI, NVIDIA a également investi dans xAI, l'entreprise de Musk, en 2025. Le tour de financement actuel de cette société a été porté à 20 milliards de dollars, dont environ 7,5 milliards levés par voie d'actions, et jusqu'à 12,5 milliards par voie de dettes via une entité à usage spécifique (SPV).

Le mécanisme de cette entité SPV consiste à utiliser les fonds collectés pour acheter des processeurs haute performance de NVIDIA, puis à les louer à xAI.

Ces processeurs seront utilisés pour le projet Colossus 2 de xAI. Colossus, première version, est un centre de supercalcul situé à Memphis, dans le Tennessee. Déjà équipé de 100 000 GPU H100 de NVIDIA, ce centre figure parmi les plus grands clusters d'entraînement IA au monde. xAI construit maintenant Colossus 2, qui prévoit d'étendre le nombre de GPU à plusieurs centaines de milliers, voire davantage.

Le 18 septembre, NVIDIA a également annoncé un investissement de 5 milliards de dollars dans Intel, établissant une coopération stratégique approfondie. NVIDIA souscrira à des actions ordinaires nouvellement émises par Intel au prix unitaire de 23,28 dollars, pour un montant total de 5 milliards de dollars. À l'issue de l'opération, NVIDIA détiendra environ 4 % du capital d'Intel, devenant ainsi un investisseur stratégique clé.

03

Bien sûr, lors de ce GTC, Jensen Huang a dit bien d'autres choses encore.

Par exemple, NVIDIA a lancé plusieurs familles de modèles IA open source, notamment Nemotron pour l'IA numérique, Cosmos pour l'IA physique, Isaac GR00T pour la robotique et Clara pour l'IA biomédicale.

Par ailleurs, Jensen Huang a présenté la plateforme de développement DRIVE AGX Hyperion 10 pour la conduite autonome. Il s'agit d'une plateforme destinée à la conduite autonome de niveau 4, intégrant les puces de calcul NVIDIA et un ensemble complet de capteurs, notamment lidar, caméras et radar.

NVIDIA a également lancé le programme de certification Halos, le premier système du secteur chargé d'évaluer et certifier la sécurité de l'IA physique, spécialement conçu pour les véhicules autonomes et les technologies robotiques.

Le cœur du programme Halos est le système Halos AI, le premier laboratoire du secteur reconnu par le comité d'accréditation ANSI. ANSI, l'Institut national américain des normes, confère à cette certification une grande autorité et crédibilité.

Le rôle de ce système est d'utiliser l'IA physique de NVIDIA pour vérifier si les systèmes de conduite autonome respectent les normes. Les entreprises AUMOVIO, Bosch, Nuro et Wayve figurent parmi les premiers membres du laboratoire de test Halos AI.

Pour promouvoir la conduite autonome de niveau 4, NVIDIA a publié un jeu de données multimodal provenant de 25 pays, contenant 1 700 heures de données issues de caméras, de radars et de lidars.

Jensen Huang souligne que la valeur de ce jeu de données réside dans sa diversité et son ampleur, couvrant différentes conditions routières, règles de circulation et cultures de conduite, offrant ainsi une base solide pour entraîner des systèmes de conduite autonome plus universels.

Mais la vision de Jensen Huang va bien au-delà.

Lors du GTC, il a annoncé une série de collaborations avec des laboratoires gouvernementaux américains et des entreprises de premier plan, visant à construire l'infrastructure IA américaine. Jensen Huang affirme que nous sommes à l'aube de la révolution industrielle de l'IA, qui définira l'avenir de chaque secteur et de chaque nation.

Le point fort de ces collaborations est celui noué avec le Département de l'Énergie américain. NVIDIA aide ce département à construire deux centres de supercalcul : l'un au Laboratoire national d'Argonne, l'autre au Laboratoire national de Los Alamos.

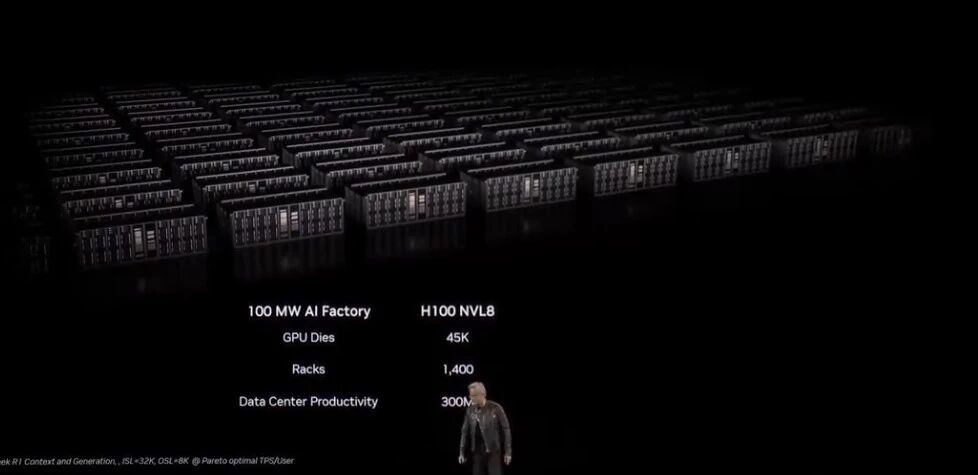

Le laboratoire d'Argonne recevra un superordinateur nommé Solstice, équipé de 100 000 GPU Blackwell de NVIDIA. Quelle est l'échelle de 100 000 GPU ? Cela en fera le plus grand superordinateur d'IA jamais possédé par le Département de l'Énergie. Un autre système, Equinox, doté de 10 000 GPU Blackwell, entrera en service prévisionnel en 2026. Ensemble, ces deux systèmes offriront une puissance de calcul IA de 2200 exaflops.

Paul Kearns, directeur du laboratoire d'Argonne, déclare que ces systèmes redéfiniront la performance, l'évolutivité et le potentiel scientifique. À quoi serviront-ils ? De la science des matériaux à la modélisation climatique, du calcul quantique à la simulation d'armes nucléaires, tous exigent un tel niveau de puissance de calcul.

Outre les laboratoires gouvernementaux, NVIDIA construit également un centre de recherche sur les usines IA en Virginie. Ce centre est particulier car il ne s'agit pas simplement d'un centre de données, mais d'un champ d'expérimentation. NVIDIA y testera un produit appelé Omniverse DSX, un plan directeur pour la construction d'usines IA de l'ordre du gigawatt.

Un centre de données classique consomme peut-être quelques dizaines de mégawatts, alors qu’un gigawatt équivaut à la production d’une centrale nucléaire de taille moyenne.

L'idée centrale du plan Omniverse DSX est de transformer l'usine IA en un système auto-apprenant. Des agents IA surveilleront continuellement l'alimentation électrique, le refroidissement et la charge de travail, ajustant automatiquement les paramètres pour améliorer l'efficacité. Par exemple, lorsque la charge du réseau est élevée, le système peut automatiquement réduire sa consommation ou passer à l'alimentation par batteries de stockage.

Ce type de gestion intelligente est crucial pour des installations de l'ordre du gigawatt, car les coûts d'électricité et de refroidissement seraient autrement astronomiques.

Cette vision est ambitieuse. Jensen Huang affirme qu'il lui faudra trois ans pour la concrétiser. Les tests AI-RAN ne commenceront qu'en 2026, les véhicules autonomes basés sur DRIVE AGX Hyperion 10 ne rouleront qu'en 2027, et les superordinateurs du Département de l'Énergie entreront également en service en 2027.

NVIDIA détient CUDA, son arme fatale, qui constitue la norme de facto du calcul IA. Des phases d'entraînement au raisonnement, des centres de données aux dispositifs périphériques, de la conduite autonome à la biomédecine, les GPU de NVIDIA sont omniprésents. Les investissements et collaborations annoncés lors de ce GTC renforcent encore davantage cette position dominante.

Bienvenue dans la communauté officielle TechFlow

Groupe Telegram :https://t.me/TechFlowDaily

Compte Twitter officiel :https://x.com/TechFlowPost

Compte Twitter anglais :https://x.com/BlockFlow_News