L'ère des super applications cryptées : les infrastructures de données sont-elles prêtes ?

TechFlow SélectionTechFlow Sélection

L'ère des super applications cryptées : les infrastructures de données sont-elles prêtes ?

La rivière protégeant le château se tourne vers les « signaux exécutables » et les « capacités de données fondamentales », tandis que les actifs longue traîne et la boucle fermée des données de transaction constituent une opportunité unique pour les entrepreneurs natifs de la cryptographie.

Auteur|Story @IOSG

TL;DR

-

Défi des données : la course aux temps de bloc sur les blockchains haute performance entre dans l'ère du sub-seconde. La forte concurrence côté consommateur (C-end), la volatilité élevée du trafic et les besoins hétérogènes multi-chaînes augmentent la complexité des données, poussant les infrastructures de données vers un traitement incrémental en temps réel + une évolutivité dynamique. Les anciennes solutions ETL par lots entraînent des délais allant de plusieurs minutes à plusieurs heures, incompatibles avec les transactions en temps réel. De nouvelles approches telles que The Graph, Nansen ou Pangea adoptent le calcul en continu, réduisant les délais au niveau du suivi en temps réel.

-

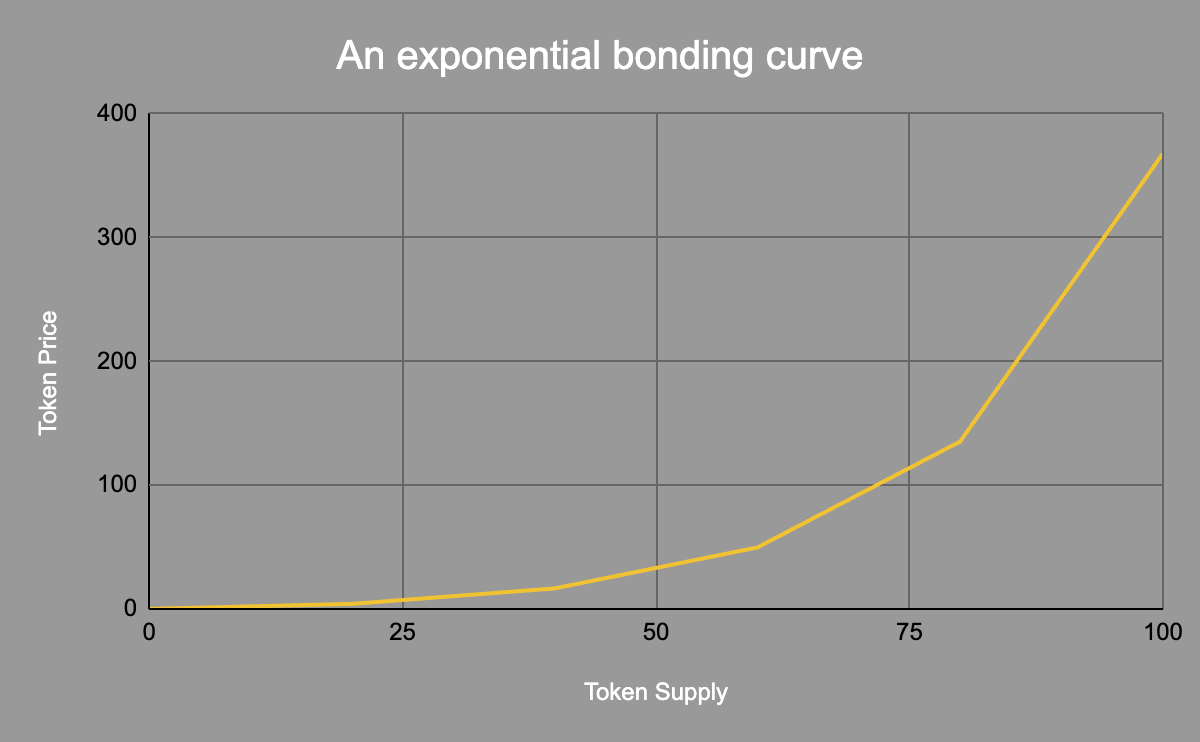

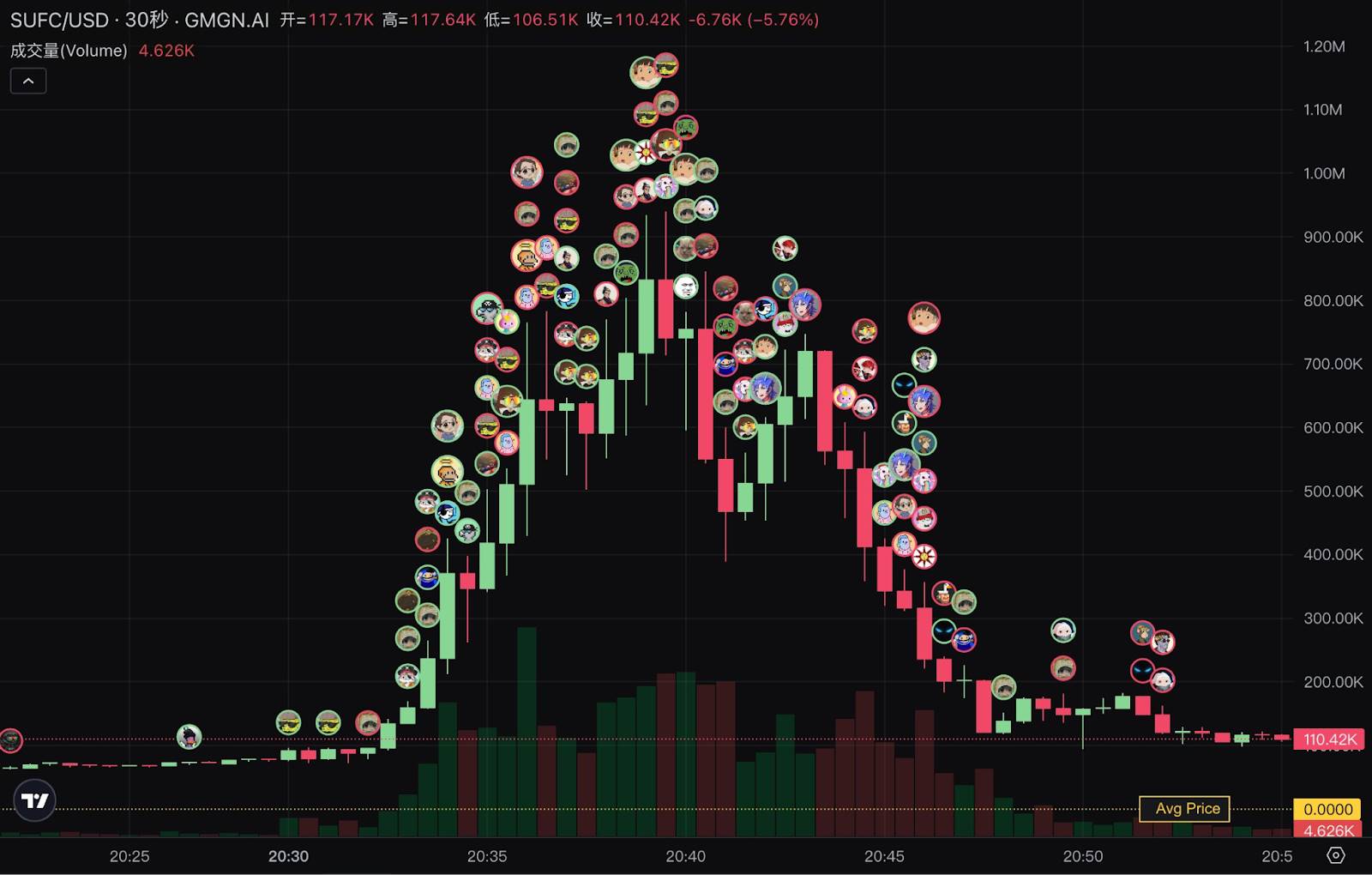

Changement de paradigme dans la compétition autour des données : auparavant il s'agissait de "comprendre", désormais c'est de "gagner de l'argent". Dans un modèle de courbe de bonding, un retard d'une minute peut entraîner un écart de coût multiple. L'évolution des outils : des ajustements manuels de slippage → bots de sniper → terminal intégré GMGN. La capacité à envoyer des transactions sur chaîne devient progressivement une commodité ; l'avantage concurrentiel se déplace vers les données elles-mêmes : qui capte le signal le plus rapidement peut aider ses utilisateurs à générer des profits.

-

Extension dimensionnelle des données transactionnelles : les Meme sont fondamentalement une financiarisation de l'attention, centrée sur la narration, la visibilité et la propagation ultérieure. Boucle fermée entre données hors chaîne (off-chain) × données on-chain : le suivi narratif et la quantification des émotions deviennent essentiels pour le trading. « Données sous-marines » : flux de capitaux, profilage des acteurs, étiquetage d'adresses « smart money »/KOL, révélant les jeux stratégiques implicites derrière les adresses anonymes. Les nouveaux terminaux de trading fusionnent en quelques secondes signaux multidimensionnels on-chain et off-chain, améliorant ainsi la prise de décision d'entrée et de couverture.

-

Signaux exécutables pilotés par l'IA : passer de l'information au rendement. Objectif concurrentiel de la nouvelle phase : rapidité, automatisation, génération de rendements excédentaires. L'IA multimodale combinée aux grands modèles linguistiques (LLM) peut extraire automatiquement des signaux décisionnels, intégrés à des fonctions comme le copy trading, le take profit ou le stop loss. Défis : hallucinations, durée de vie courte des signaux, latence d'exécution et gestion des risques. Trouver un équilibre entre vitesse et précision, renforcer l'apprentissage et les tests en simulation sont cruciaux.

-

Choix existentiel pour les tableaux de bord de données : les applications légères de type agrégation ou dashboard manquent de fossé protecteur et voient leur espace de survie réduit. Vers le bas : approfondir les pipelines performants et l'intégration recherche-données. Vers le haut : étendre jusqu'à la couche applicative, créer directement des scénarios utilisateur, accroître l'activité d'appel aux données. À l’avenir, deux profils domineront : soit devenir une infrastructure critique comme l’eau, l’électricité ou le gaz du Web3, soit devenir une plateforme utilisateur à l’image de Bloomberg Crypto.

Le fossé protecteur se déplace désormais vers les « signaux exécutables » et les « capacités fondamentales sur les données ». Les actifs de longue traîne et les boucles fermées de données transactionnelles constituent une opportunité unique pour les entrepreneurs natifs du crypto. Fenêtre d’opportunité des 2–3 prochaines années :

-

Infrastructure amont : Capacité de traitement de niveau Web2 + besoins natifs Web3 → Databricks/AWS du Web3.

-

Plateforme d’exécution aval : Agent IA + données multidimensionnelles + exécution transparente → Terminal Bloomberg Crypto.

Merci aux projets Hubble AI, Space & Time, OKX DEX pour leur soutien à ce rapport !

Introduction : triple résonance entre Meme, blockchains haute performance et IA

Lors du dernier cycle, la croissance des transactions sur chaîne reposait principalement sur l’itération des infrastructures. Dans le nouveau cycle, avec la maturité progressive des infrastructures, des super-applications comme Pump.fun deviennent les nouveaux moteurs de croissance du secteur crypto. Ce modèle d’émission d’actifs, doté d’un mécanisme d’émission standardisé et d’une conception astucieuse de liquidité, a façonné une tranchée de trading primitive et équitable où les mythes de fortunes fulgurantes se multiplient. La reproductibilité de ces effets de richesse exponentielle transforme profondément les attentes de rendement et les habitudes de trading des utilisateurs. Ceux-ci ne veulent pas seulement entrer plus vite, mais aussi acquérir, analyser et exécuter des données multidimensionnelles en très peu de temps – or, les infrastructures actuelles de données peinent déjà à répondre à cette densité et exigence de temps réel.

Cela conduit à des demandes accrues sur l’environnement de trading : moindres frictions, confirmations plus rapides, liquidité accrue. Les lieux d’échange migrent rapidement vers des blockchains haute performance et des rollups Layer2 tels que Solana et Base. Le volume de données transactionnelles sur ces blockchains a augmenté d’un facteur supérieur à 10 par rapport à l’Ethereum du précédent cycle, posant aux fournisseurs de données un défi accru en performance. Avec l’arrivée imminente de nouvelles blockchains comme Monad ou MegaETH, les besoins de traitement et de stockage des données sur chaîne vont croître de manière exponentielle.

Parallèlement, la maturité rapide de l’IA accélère l’égalité d’accès à l’intelligence. Le niveau intellectuel de GPT-5 atteint désormais celui d’un doctorat, tandis que des grands modèles multimodaux comme Gemini peuvent aisément comprendre les graphiques en chandeliers… Grâce aux outils d’IA, des signaux de trading autrefois complexes deviennent accessibles et exploitables même par des utilisateurs ordinaires. Dans cette tendance, les traders commencent à s’appuyer sur l’IA pour leurs décisions, or celles-ci dépendent fortement de données multidimensionnelles et ultra-récentes. L’IA évolue progressivement d’« outil d’analyse assistée » à « centre décisionnel du trading », et son adoption généralisée amplifie davantage encore les exigences en matière de données : temps réel, interprétabilité et traitement à grande échelle.

Dans ce contexte de triple résonance — frénésie des trades Meme, expansion des blockchains hautes performances, et commercialisation de l’IA — la nécessité d’une nouvelle infrastructure de données pour l’écosystème on-chain devient de plus en plus urgente.

Répondre au défi des données : 100 000 TPS et création de blocs en millisecondes

Avec l’émergence des blockchains et rollups haute performance, l’échelle et la vitesse des données sur chaîne entrent dans une nouvelle ère.

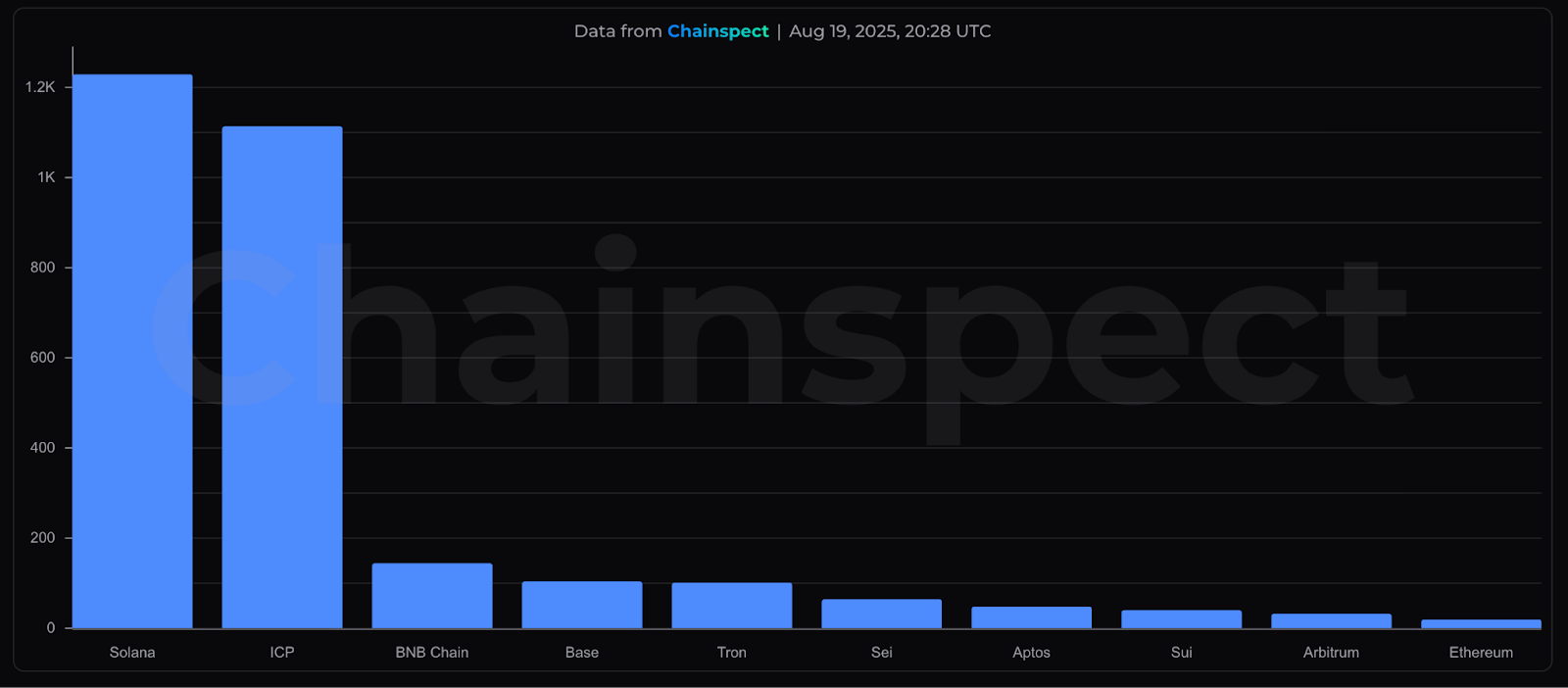

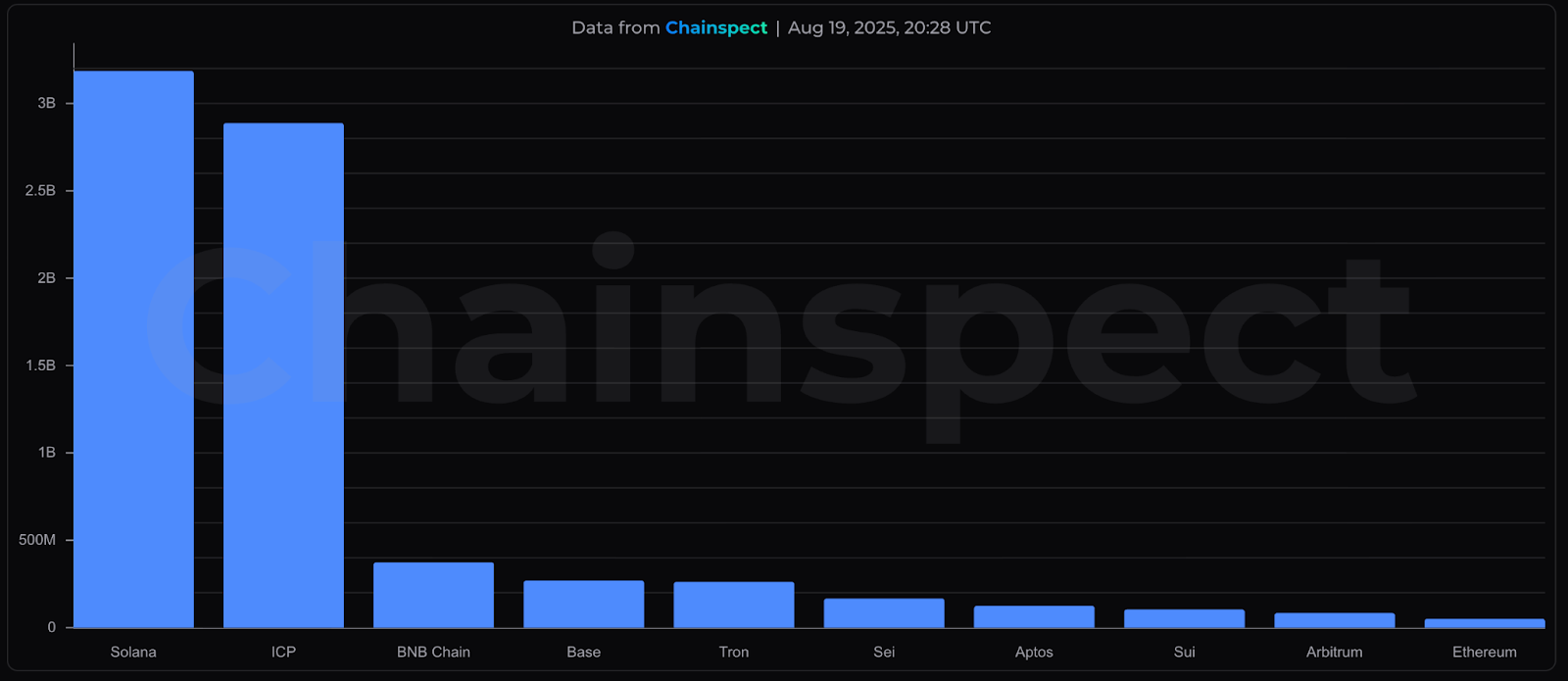

Grâce à la diffusion d’architectures à haute concurrence et faible latence, le volume quotidien de transactions dépasse facilement les dizaines de millions, générant des volumes bruts de données mesurés en centaines de Go. Par exemple, Solana affiche une moyenne TPS sur 30 jours supérieure à 1 200, soit plus de 100 millions de transactions quotidiennes ; le 17 août, elle a même atteint un record historique de 107 664 TPS. Selon les estimations, les données du grand livre de Solana croissent rapidement à un rythme annuel de 80 à 95 To, soit environ 210 à 260 Go par jour.

▲ Chainspect, TPS moyen sur 30 jours

▲ Chainspect, Volume de transactions sur 30 jours

Non seulement le débit augmente, mais le temps de création de blocs des nouvelles blockchains est désormais entré dans l’échelle des millisecondes. La mise à jour Maxwell de BNB Chain réduit le temps de création de bloc à 0,8 s, alors que la technologie Flashblocks de Base Chain va jusqu’à 200 ms. En deuxième moitié d’année, Solana prévoit de remplacer PoH par Alpenglow, abaissant le temps de confirmation à 150 ms, tandis que le réseau principal de MegaETH vise une création de bloc en temps réel à 10 ms. Ces percées techniques et de consensus améliorent considérablement le caractère instantané des transactions, mais imposent des exigences sans précédent en synchronisation et décodage des données de bloc.

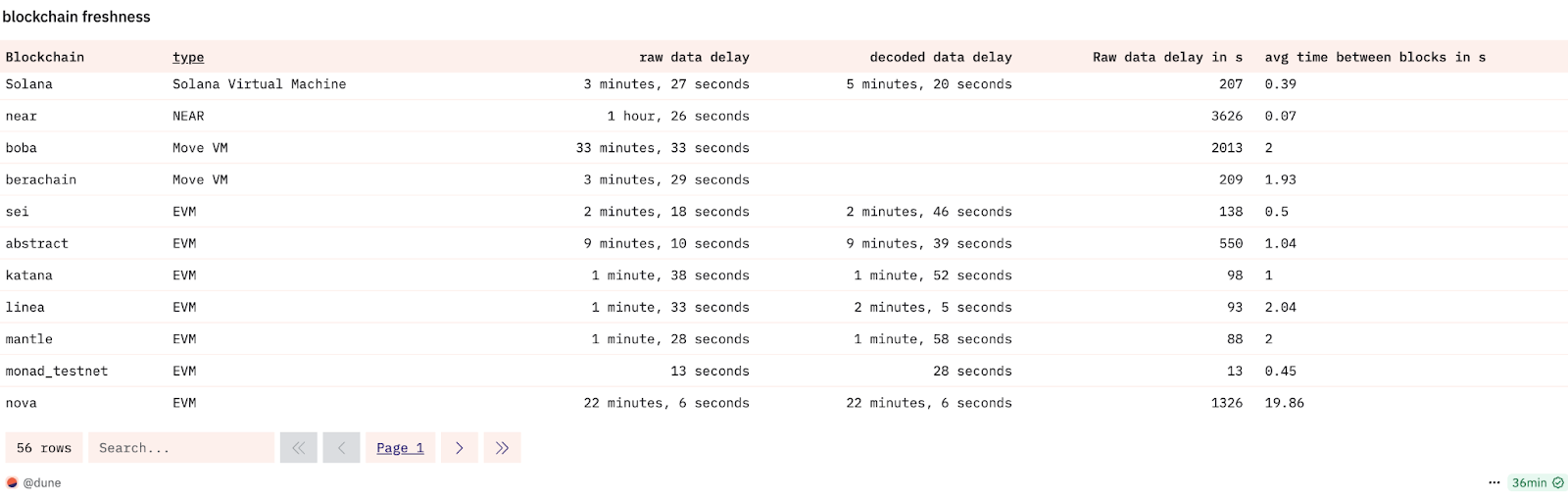

Cependant, la plupart des infrastructures aval reposent encore sur des pipelines ETL par lots, ce qui implique inévitablement un délai dans les données. Par exemple, chez Dune, les données d’événements de contrats sur Solana accusent généralement un retard d’environ 5 minutes, tandis que les données agrégées au niveau protocole peuvent prendre jusqu’à 1 heure. Cela signifie qu’une transaction sur chaîne confirmée en 400 ms pourrait ne devenir visible dans les outils d’analyse qu’après un retard de plusieurs centaines de fois, ce qui est presque inacceptable pour les applications de trading en temps réel.

▲ Dune, Blockchain Freshness

Pour relever ce défi du côté de l’offre de données, certaines plateformes ont commencé à adopter des architectures en continu et en temps réel. The Graph utilise Substreams et Firehose pour comprimer les délais de données à près du temps réel. Nansen, en intégrant des technologies de traitement en continu comme ClickHouse, a réalisé une amélioration de performance de plusieurs dizaines de fois sur Smart Alerts et ses tableaux de bord en temps réel. Pangea, quant à lui, rassemble la puissance de calcul, le stockage et la bande passante fournis par les nœuds communautaires, offrant aux market makers, analystes quantitatifs et systèmes de carnets d’ordres centralisés (Clobs) des données en continu avec un délai inférieur à 100 ms.

▲ Chainspect

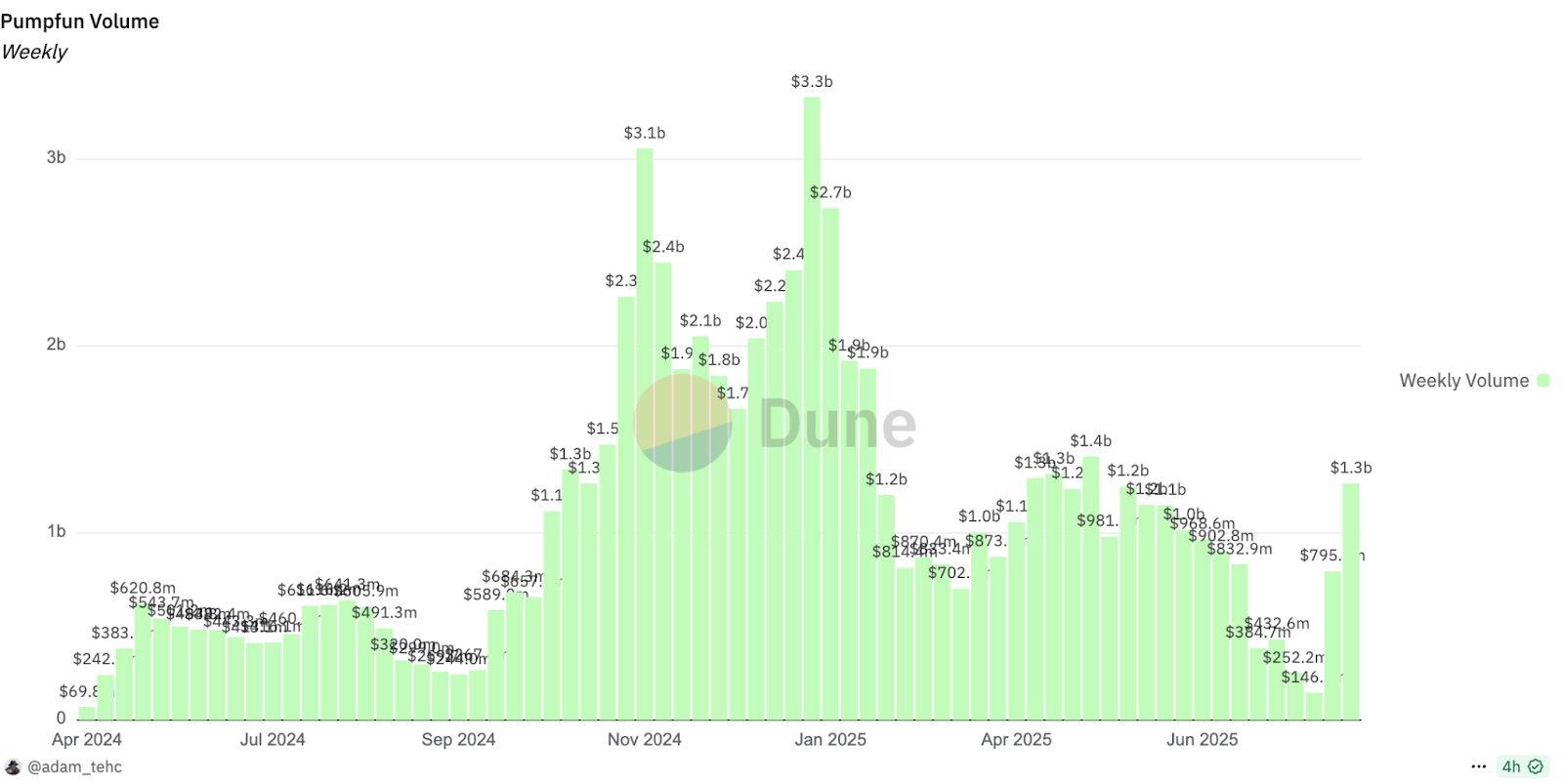

Outre leur volume élevé, les transactions sur chaîne présentent également une caractéristique marquée de répartition inégale du trafic. Au cours de l’année dernière, le volume hebdomadaire des transactions sur Pumpfun a varié d’un facteur proche de 30 entre son minimum et son maximum. En 2024, la plateforme de trading Meme GMGN a subi 6 pannes complètes de serveur en 4 jours, la forçant à migrer sa base de données sous-jacente d’AWS Aurora vers TiDB, une base SQL distribuée open source. Après migration, la capacité d’extension horizontale et l’élasticité de calcul du système se sont considérablement améliorées, augmentant l’agilité opérationnelle d’environ 30 %, atténuant ainsi nettement la pression lors des pics de transactions.

▲ Dune, Volume hebdomadaire Pumpfun

▲ Odaily, Cas d’utilisation Web3 de TiDB

L’écosystème multi-chaînes accentue encore cette complexité. Les différences entre chaînes en format de logs, structure des événements et champs de transaction obligent à concevoir une logique de parsing personnalisée pour chaque nouvelle chaîne ajoutée, testant sévèrement la flexibilité et l’évolutivité de l’infrastructure de données. Certains fournisseurs optent donc pour une stratégie « client d’abord » : ils priorisent l’intégration des chaînes où règne une activité transactionnelle intense, faisant des compromis entre flexibilité et échelle.

Si, dans un contexte dominé par les blockchains hautes performances, le traitement des données reste figé au stade ETL par lots avec intervalles fixes, cela mène à des accumulations de retard, des goulots d’étranglement dans le décodage et des requêtes ralenties, incapables de satisfaire la demande de données en temps réel, fines et interactives. Ainsi, l’infrastructure de données on-chain doit évoluer vers un traitement incrémental en continu et une architecture de calcul en temps réel, accompagnée de mécanismes d’équilibrage de charge, afin de faire face aux pics de concurrence liés aux cycles du marché crypto. Cela ne constitue pas seulement une extension naturelle de la trajectoire technologique, mais aussi un élément clé pour garantir la stabilité des requêtes en temps réel, et formera une véritable ligne de partage dans la compétition entre les nouvelles plateformes de données on-chain.

La vitesse, c’est la richesse : changement de paradigme dans la compétition autour des données on-chain

La problématique centrale des données on-chain a évolué, passant de la « visualisation » à l’« exécution ». Lors du cycle précédent, Dune était l’outil standard de l’analyse on-chain. Il satisfaisait le besoin des chercheurs et investisseurs de « comprendre », permettant de construire des récits à partir de diagrammes SQL.

-

Les joueurs de GameFi et DeFi utilisaient Dune pour suivre les flux entrants et sortants de capitaux, calculer les rendements des farms et se retirer avant les retournements de marché.

-

Les passionnés de NFT analysaient avec Dune les tendances de volume, les positions des baleines et les caractéristiques de distribution pour anticiper la chaleur du marché.

Mais dans ce cycle, les adeptes des Meme constituent le groupe le plus actif. Ils ont permis à des applications phénoménales comme Pump.fun de générer cumulativement 700 millions de dollars, près du double du revenu total de l’application grand public leader du cycle précédent, Opensea.

Dans le domaine des Meme, la sensibilité temporelle du marché est portée à son extrême. La vitesse n’est plus un luxe, mais la variable centrale déterminant profit ou perte. Dans un marché primaire régulé par une courbe de bonding, la vitesse équivaut au coût. Le prix du jeton augmente exponentiellement avec la demande d’achat ; un simple retard d’une minute peut multiplier le coût d’entrée par plusieurs fois. Selon une étude de Multicoin, les joueurs les plus rentables dans ce jeu doivent généralement payer un slippage de 10 % pour entrer trois places plus tôt dans le bloc que leurs concurrents. L’effet de richesse et les « mythes de fortunes fulgurantes » poussent les utilisateurs à rechercher désespérément des graphiques K en seconde, des moteurs d’exécution de transactions dans le même bloc et des panneaux de décision tout-en-un, rivalisant sur la rapidité de collecte d’informations et d’envoi d’ordres.

▲ Binance

Au temps du trading manuel sur Uniswap, les utilisateurs devaient configurer eux-mêmes le slippage et le gas, sans voir le prix à l’avance, rendant la transaction similaire à un « tirage au sort » ; à l’ère du bot de sniper BananaGun, l’automatisation et les techniques de slippage ont permis aux petits investisseurs de rivaliser avec les experts ; à l’ère de PepeBoost, les bots transmettent non seulement l’ouverture du pool dès la première seconde, mais aussi les positions initiales des détenteurs ; aujourd’hui, à l’ère GMGN, on voit l’émergence d’un terminal intégrant informations K, analyse multidimensionnelle et exécution de transactions, devenant ainsi le « Bloomberg Terminal » du trading Meme.

Avec l’itération continue des outils de trading, les barrières d’exécution s’effacent progressivement, et l’avantage concurrentiel glisse inévitablement vers les données mêmes : qui capte le signal le plus rapidement et précisément construit un avantage transactionnel dans un marché en constante mutation, aidant ainsi ses utilisateurs à gagner de l’argent.

La dimension, c’est l’avantage : la vérité au-delà des graphiques K

La nature des Memecoins est la financiarisation de l’attention. Une bonne narration peut continuellement déborder des cercles habituels, concentrer l’attention, et ainsi propulser prix et capitalisation. Pour les traders de Meme, la rapidité est certes importante, mais pour obtenir de gros résultats, il faut surtout répondre à trois questions : quelle est la narration du jeton, qui s’y intéresse, et comment l’attention peut-elle être amplifiée à l’avenir. Ces éléments ne laissent que des traces fantômes sur les graphiques K ; leurs véritables moteurs nécessitent des données multidimensionnelles — l’opinion publique hors chaîne, les adresses et structures de détention on-chain, et leur cartographie précise.

On-chain × Off-chain : boucle fermée de l’attention à la transaction

Les utilisateurs attirent l’attention hors chaîne et finalisent les transactions on-chain ; la combinaison de ces deux flux de données devient désormais l’avantage clé du trading Meme.

# Suivi narratif et identification de la chaîne de propagation

Sur des plateformes sociales comme Twitter, des outils comme XHunt aident les joueurs de Meme à analyser la liste de comptes suivis par des KOL, afin d’identifier les personnes impliquées dans un projet et la chaîne potentielle de diffusion de l’attention. 6551 DEX agrège tweets, sites web officiels, commentaires, historiques de lancement et listes de KOL pour générer aux traders des rapports IA complets, mis à jour en temps réel selon l’opinion publique, leur permettant de capter précisément la narration.

# Quantification des indicateurs d’humeur

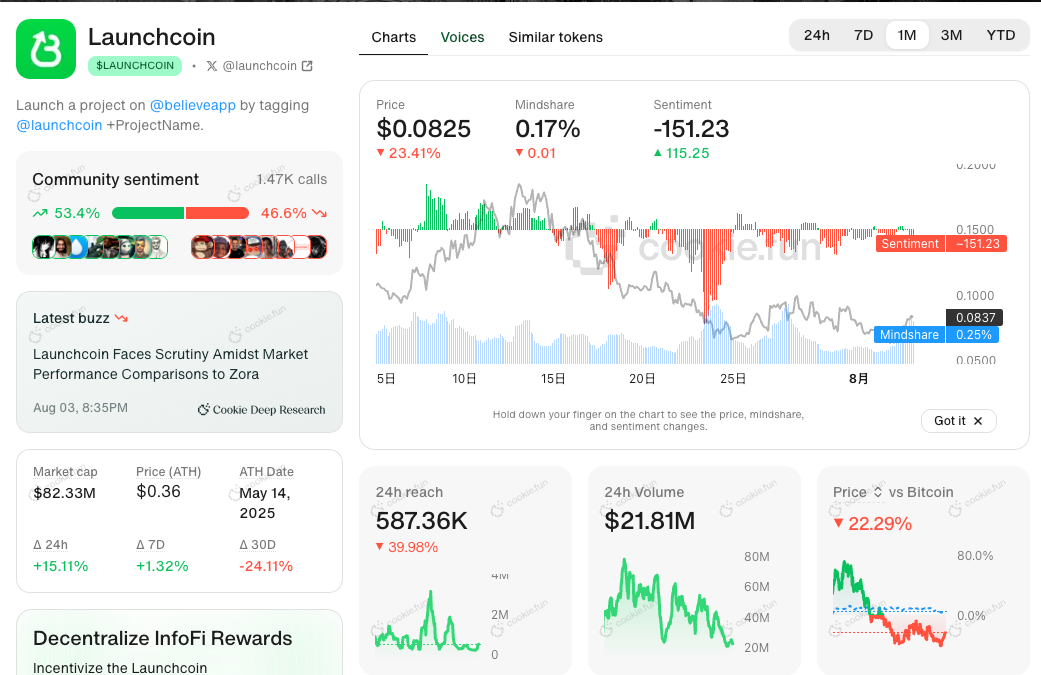

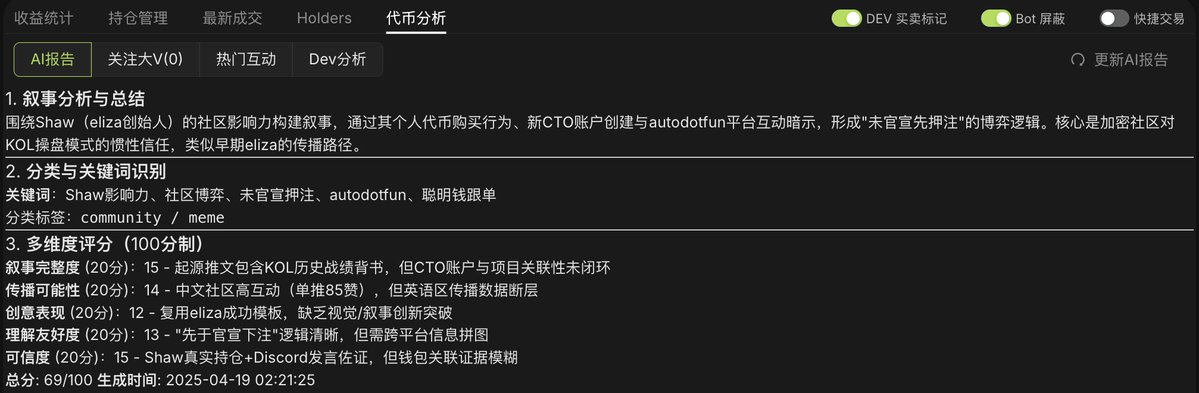

Des outils Infofi comme Kaito et Cookie.fun agrègent et analysent les contenus de Crypto Twitter, produisant des indicateurs quantifiables de Mindshare, Sentiment et Influence. Par exemple, Cookie.fun superpose directement ces deux indicateurs sur les graphiques de prix, transformant l’humeur hors chaîne en « indicateur technique » lisible.

▲ Cookie.fun

# Équivalence d’importance entre on-chain et off-chain

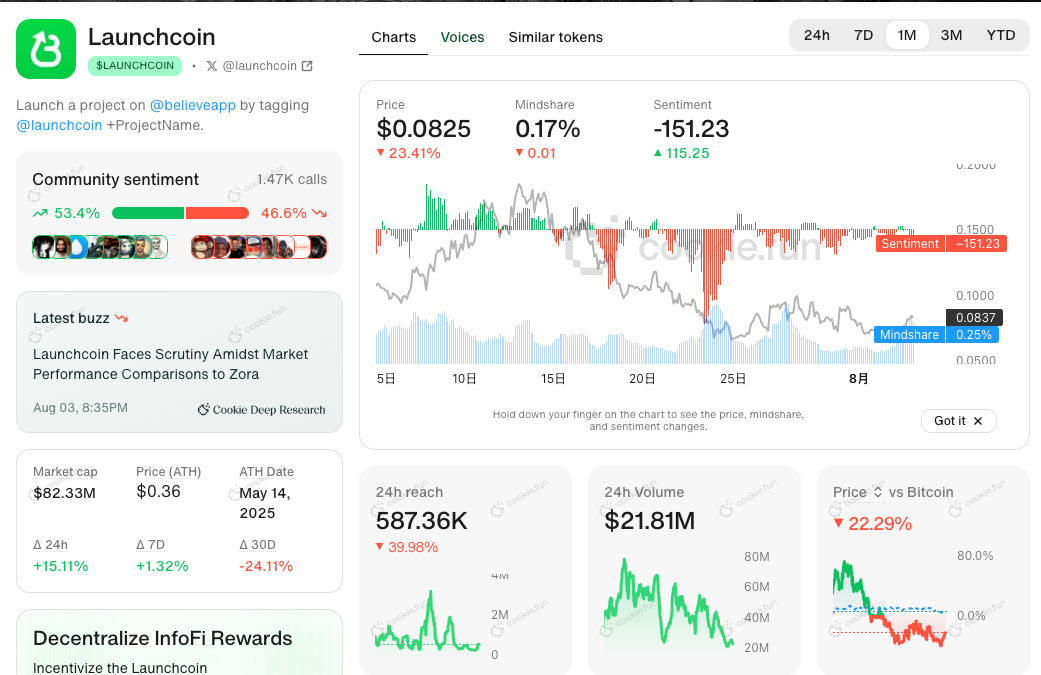

OKX DEX affiche désormais l’analyse Vibes côte à côte avec les cotations, en regroupant l’heure des appels de KOL, les principaux KOL associés, le résumé narratif et une note globale, réduisant ainsi le temps de recherche d’informations hors chaîne. Le résumé narratif est déjà devenu la fonction produit IA la plus appréciée des utilisateurs.

Présentation des données sous-marines : transformer le « grand livre visible » en « alpha exploitable »

Dans la finance traditionnelle, les données de flux d’ordres sont détenues par de grands courtiers ; pour optimiser leurs stratégies, les sociétés quantitatives paient des centaines de millions de dollars par an pour y accéder. En comparaison, les grands livres de transactions crypto sont totalement publics et transparents, ce qui revient à « ouvrir » une information coûteuse, formant ainsi une mine à ciel ouvert prête à être exploitée.

La valeur des données sous-marines réside dans l’extraction d’intentions invisibles à partir de transactions visibles. Cela inclut les flux de capitaux et le profilage des rôles — indices de constitution de position ou de distribution par des manipulateurs, adresses secondaires de KOL, concentration ou dispersion des jetons, transactions groupées (bundles) et flux anormaux de fonds ; ainsi que le croisement des profils d’adresses — attribution de labels tels que « smart money », KOL/VC, développeurs, phishing, comptes internes, etc., et leur association à des identités hors chaîne, reliant ainsi les données on-chain et off-chain.

Ces signaux échappent souvent aux utilisateurs ordinaires, mais influencent fortement les mouvements de marché à court terme. En analysant en temps réel les étiquettes d’adresses, les caractéristiques de détention et les transactions groupées, les outils d’aide au trading révèlent les dynamiques stratégiques « sous la surface », aidant les traders à éviter les risques et à trouver des alphas en quelques secondes.

Par exemple, GMGN, au-delà des données de transactions et contrats de jetons, intègre en temps réel l’analyse d’étiquettes telles que smart money, adresses KOL/VC, portefeuilles de développeurs, comptes internes, adresses de phishing et transactions groupées, cartographie les adresses on-chain avec les comptes sociaux, alignant flux de capitaux, signaux de risque et comportements de prix au niveau de la seconde, aidant ainsi les utilisateurs à décider plus rapidement quand entrer ou se couvrir.

▲ GMGN

Signaux exécutables pilotés par l’IA : de l’information au rendement

« La prochaine vague d’IA ne vendra pas des outils, mais des rendements. » — Sequoia Capital

Cette affirmation s’applique aussi bien au trading crypto. Une fois que la vitesse et la dimensionnalité des données sont satisfaisantes, l’objectif concurrentiel suivant devient la transformation directe de données complexes multidimensionnelles en signaux de trading exécutables. Les critères d’évaluation de la décision basée sur les données peuvent se résumer à trois points : rapidité, automatisation et taux de rendement excédentaire.

-

Rapidité : À mesure que les capacités de l’IA progressent, les avantages des modèles linguistiques (LLM) et multimodaux en langage naturel s’affirment. Ils peuvent non seulement intégrer et comprendre des masses de données, mais aussi établir des liens sémantiques entre elles, extrayant automatiquement des conclusions décisionnelles. Dans un environnement de trading intensif et à faible profondeur, chaque signal a une durée de vie et une capacité de capital très courtes ; la vitesse impacte directement le rendement potentiel.

-

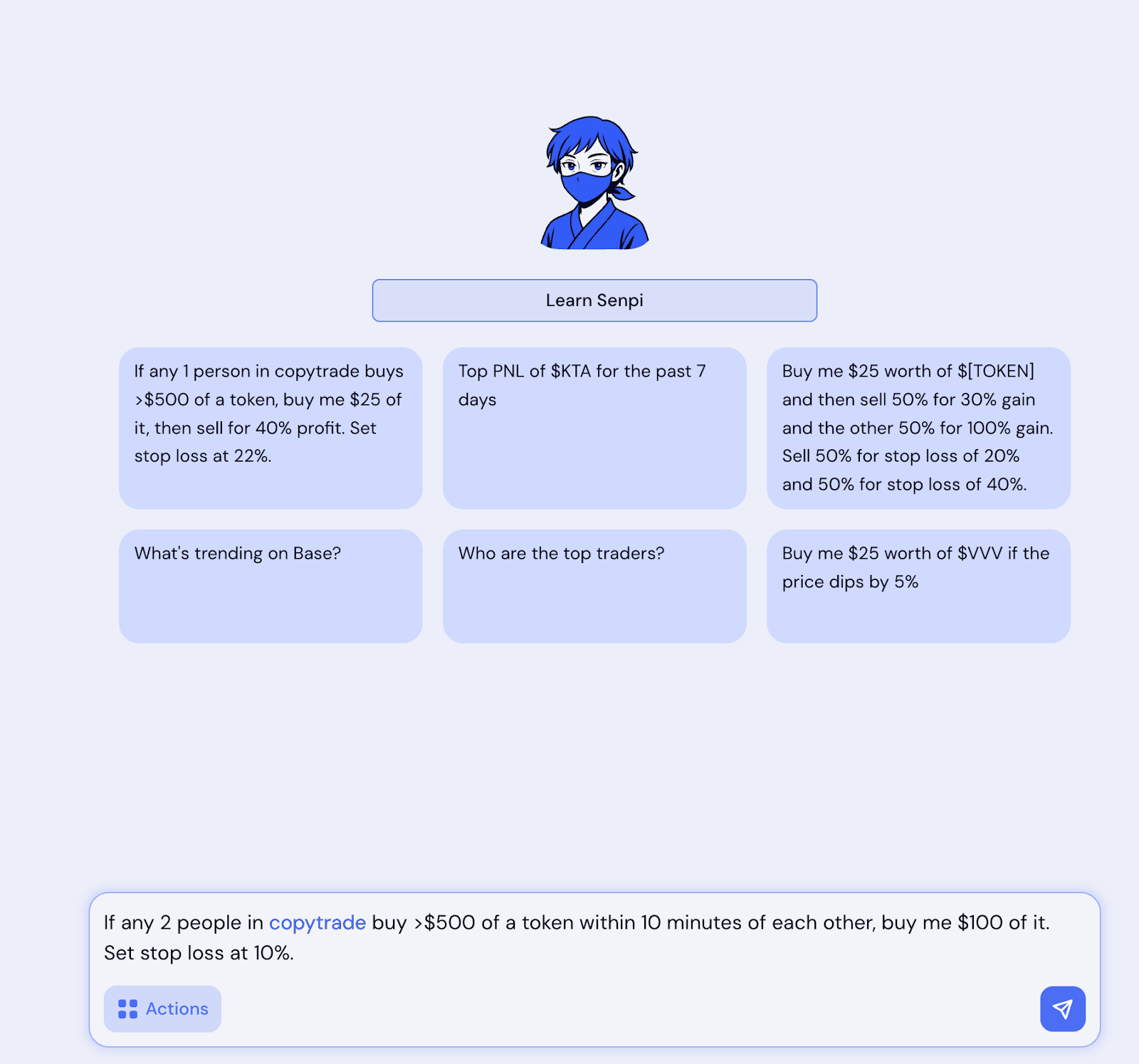

Automatisation : Un humain ne peut surveiller les marchés 24h/24, mais l’IA peut. Par exemple, un utilisateur peut donner à un agent sur Senpi une instruction d’achat conditionnel avec take profit et stop loss via copy trading. Cela exige que l’IA effectue en arrière-plan une surveillance ou un sondage constant des données, décidant automatiquement et lançant l’ordre lorsque le signal recommandé est détecté.

-

Rendement : Finalement, la validité de tout signal de trading dépend de sa capacité à générer un rendement excédentaire durable. L’IA doit non seulement comprendre suffisamment les signaux on-chain, mais aussi intégrer la gestion des risques, cherchant à maximiser le ratio risque-rendement dans un environnement très volatil. Cela inclut des facteurs spécifiques à la blockchain comme la perte de slippage ou la latence d’exécution.

Cette capacité redéfinit la logique commerciale des plateformes de données : passer de la vente de « droits d’accès aux données » à celle de « signaux générant des rendements ». L’enjeu concurrentiel des nouveaux outils n’est plus la couverture des données, mais plutôt l’exécutabilité des signaux — leur capacité à franchir la dernière étape, de l’« insight » à l’« exécution ».

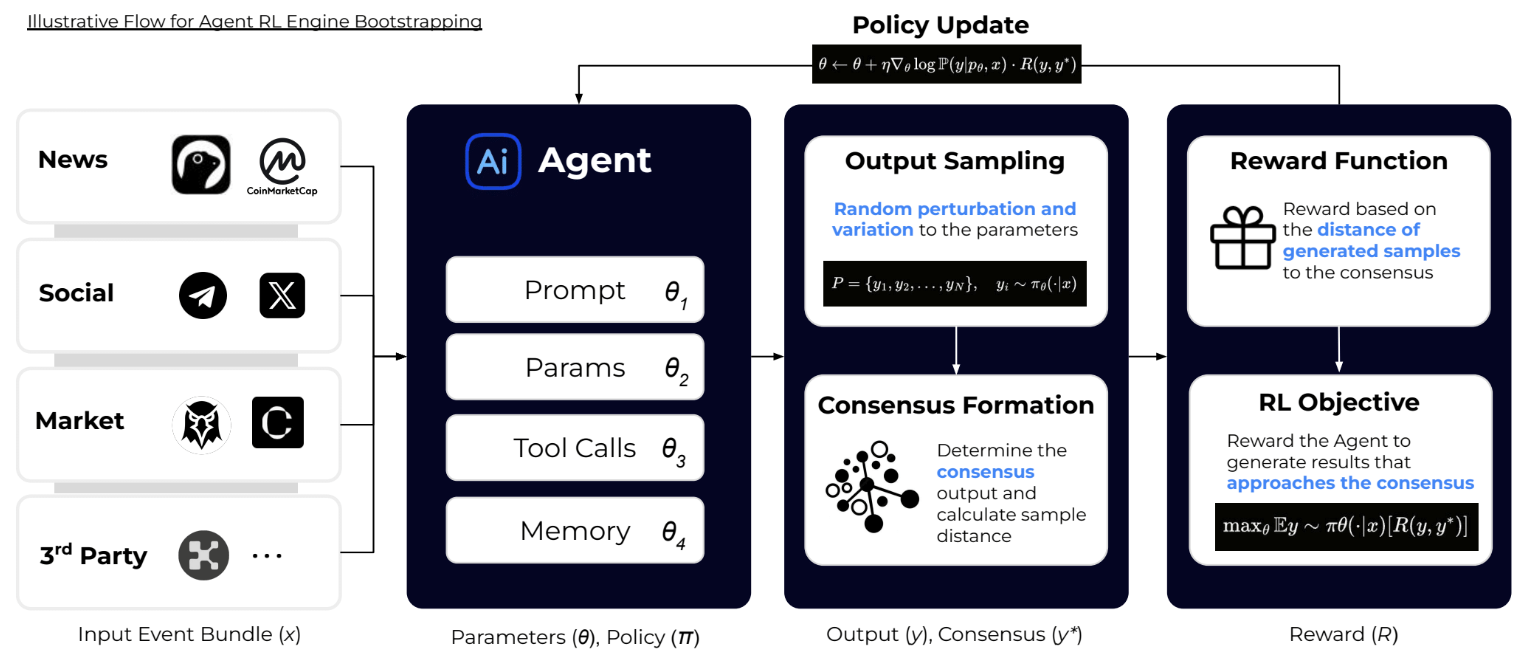

Plusieurs nouveaux projets explorent déjà cette voie. Par exemple : Truenorth, moteur de découverte piloté par l’IA, intègre le « taux d’exécution des décisions » dans l’évaluation de l’efficacité de l’information, optimisant continuellement les résultats via l’apprentissage par renforcement, réduisant au maximum le bruit inutile, aidant les utilisateurs à construire un flux d’information directement orienté vers l’exécution d’ordres.

▲ Truenorth

Bien que l’IA ait un potentiel énorme pour générer des signaux exécutables, elle fait face à plusieurs défis.

-

Les hallucinations : Les données on-chain sont fortement hétérogènes et pleines de bruit. Lors de l’interprétation de requêtes en langage naturel ou de signaux multimodaux, les LLM risquent fortement d’halluciner ou de surajuster, affectant rendement et précision. Par exemple, face à plusieurs jetons homonymes, l’IA échoue souvent à identifier l’adresse du contrat correspondant au ticker CT. Ou encore, pour de nombreux produits de signaux IA, les discussions sur CT concernant l’IA sont souvent mal attribuées à Sleepless AI.

-

Durée de vie du signal : L’environnement de trading change en un clin d’œil. Tout retard érode les gains. L’IA doit extraire, raisonner et exécuter en un temps extrêmement court. Même une stratégie simple de copy trading, sans suivi de la smart money, peut passer d’un gain à une perte.

-

Gestion des risques : Dans des scénarios à haute volatilité, si l’IA échoue plusieurs fois consécutivement à envoyer des transactions ou subit un slippage excessif, elle ne générera pas seulement aucun rendement excédentaire, mais pourrait épuiser tout le capital en quelques minutes.

Par conséquent, savoir trouver un équilibre entre vitesse et précision, et réduire les taux d’erreur grâce à l’apprentissage par renforcement, l’apprentissage par transfert ou les tests en simulation, constitue le point clé de la compétitivité de l’IA dans ce domaine.

Vers le haut ou vers le bas ? Le choix existentiel des tableaux de bord de données

Avec l’IA capable de générer directement des signaux exécutables, voire d’aider à lancer des ordres, les applications légères intermédiaires basées uniquement sur l’agrégation de données font face à une crise de survie. Qu’il s’agisse d’outils de tableau de bord assemblant des données on-chain ou de bots de trading ajoutant une couche logique d’exécution par-dessus l’agrégation, tous manquent fondamentalement d’un fossé protecteur durable. Autrefois, ces outils pouvaient survivre grâce à leur commodité ou à la notoriété (par exemple, l’habitude des utilisateurs à consulter les CTO de jetons sur Dexscreener). Mais aujourd’hui, lorsque les mêmes données sont disponibles partout, que les moteurs d’exécution deviennent des commodités et que l’IA peut directement générer des signaux décisionnels et déclencher l’exécution à partir des mêmes données, leur compétitivité s’érode rapidement.

À l’avenir, les moteurs d’exécution efficaces sur chaîne mûriront continuellement, abaissant encore davantage la barrière d’entrée au trading. Face à cette tendance, les fournisseurs de données doivent choisir : descendre, en approfondissant l’acquisition et le traitement des données ; ou monter, en s’étendant vers la couche applicative, en contrôlant directement les scénarios utilisateurs et le trafic de consommation. Le modèle intermédiaire, purement axé sur l’agrégation et l’emballage léger des données, verra son espace de survie continuellement réduit.

Descendre signifie construire un fossé protecteur infrastructurel. Hubble AI, en développant ses produits de trading, a compris que dépendre uniquement de bots Telegram ne permettait pas d’avantage durable, et s’est donc tourné vers le traitement des données amont, visant à construire un « Databricks crypto ». Après avoir repoussé les limites de la vitesse de traitement des données Solana, Hubble AI évolue vers une plateforme intégrant données et recherche, prenant position en amont de la chaîne de valeur pour servir les besoins en données des narratives américaines de « tokenisation de la finance » et des agents IA sur chaîne.

Monter signifie étendre jusqu’aux scénarios d’application, en verrouillant les utilisateurs finaux. Initialement centré sur l’indexation SQL sub-seconde et la diffusion d’oracle, Space and Time explore récemment des cas d’usage grand public, lançant Dream.Space sur Ethereum — un produit de « vibe coding ». Les utilisateurs peuvent écrire des contrats intelligents en langage naturel ou générer des tableaux de bord d’analyse de données. Cette transition augmente non seulement la fréquence d’appel à ses services de données, mais crée aussi une fidélité directe via l’expérience utilisateur.

Il devient donc clair que le rôle intermédiaire, purement basé sur la vente d’interfaces de données, perd son espace de survie. À l’avenir, le secteur B2B2C des données sera dominé par deux types d’acteurs : d’une part, les entreprises maîtrisant les infrastructures de base, devenant les « eau, électricité et gaz » de la chaîne ; d’autre part, les plateformes proches des scénarios décisionnels utilisateurs, transformant les données en expérience applicative.

Conclusion

Dans le contexte de triple résonance — frénésie des Meme, explosion des blockchains hautes performances, commercialisation de l’IA —, le secteur des données on-chain connaît un tournant structurel. L’itération de la vitesse de transaction, de la dimensionnalité des données et des signaux d’exécution fait que les « graphiques visibles » ne sont plus le cœur de la compétitivité. Le vrai fossé protecteur se déplace désormais vers les « signaux exécutables capables de faire gagner de l’argent aux utilisateurs » et les « capacités fondamentales sur les données qui les soutiennent ».

Dans les 2 à 3 prochaines années, les opportunités entrepreneuriales les plus attractives dans le domaine des données crypto émergeront à l’intersection de la maturité des infrastructures de niveau Web2 et des modes d’exécution natifs du Web3. Les données des grandes cryptomonnaies comme BTC/ETH, fortement standardisées, ressemblent désormais à des produits financiers traditionnels comme les futures, et sont progressivement intégrées par les institutions financières classiques et certaines fintechs Web2.

En revanche, les données des Meme coins et des actifs de longue traîne présentent une forte non-standardisation et fragmentation — depuis la narration communautaire, l’opinion publique on-chain jusqu’à la liquidité multi-chaînes. Ces informations nécessitent une interprétation combinant le profilage d’adresses on-chain, les signaux sociaux hors chaîne, voire l’exécution de transactions en seconde. C’est précisément dans cette différence que le traitement des actifs de longue traîne et des données Meme, ainsi que leur boucle fermée de trading, forment une fenêtre d’opportunité unique pour les entrepreneurs natifs du crypto.

Nous sommes convaincus par les projets qui s’engagent durablement dans deux directions :

-

Infrastructure amont — entreprises de données on-chain possédant des pipelines de données en continu aux performances comparables aux géants du Web2, des index à latence ultra-faible et des cadres d’analyse unifiés multi-chaînes. Ces projets pourraient devenir les Databricks/AWS du Web3, connaissant une croissance quantitative du volume de transactions à mesure que les utilisateurs migrent vers la chaîne, avec un modèle B2B2C à fort effet de levier à long terme.

-

Plateforme d’exécution aval — applications intégrant données multidimensionnelles, agents IA et exécution transparente des transactions. En transformant les signaux fragmentés on-chain/off-chain en actions directement exécutables, ces produits pourraient devenir le terminal Bloomberg natif du crypto, dont le modèle économique ne repose plus sur les frais d’accès aux données, mais sur la réalisation de rendements excédentaires et la livraison de signaux.

Nous pensons que ces deux catégories d’acteurs domineront la prochaine génération du secteur des données crypto et construiront des avantages concurrentiels durables.

Bienvenue dans la communauté officielle TechFlow

Groupe Telegram :https://t.me/TechFlowDaily

Compte Twitter officiel :https://x.com/TechFlowPost

Compte Twitter anglais :https://x.com/BlockFlow_News

![Axe Compute [NASDAQ : AGPU] finalise sa restructuration d'entreprise (anciennement POAI), la puissance GPU décentralisée d'entreprise Aethir fait officiellement son entrée sur le marché principal](https://upload.techflowpost.com//upload/images/20251212/2025121221124297058230.png)