Un outil d'intelligence artificielle de BitsLab découvre et aide à corriger une vulnérabilité à haut risque chez Bluefin

TechFlow SélectionTechFlow Sélection

Un outil d'intelligence artificielle de BitsLab découvre et aide à corriger une vulnérabilité à haut risque chez Bluefin

La pratique de Bluefin valide l'argument central de BitsLab : une sécurité Web3 digne de confiance doit être à la fois « fondée sur des preuves » (RAG), « contrôlée à plusieurs niveaux » (vérification multicouche) et « intégrée en profondeur dans la structure » (analyse statique + collaboration d'agents).

Auteur : BitsLab

Alors que la complexité des protocoles Web3 augmente rapidement, le langage Move, conçu pour la sécurité des actifs, devient plus difficile à auditer en raison du manque de données publiques et de recherches accessibles. Pour y remédier, BitsLab a développé un ensemble d'outils de sécurité IA multicouche nommé « BitsLabAI », reposant sur une base de données spécialisées élaborée par des experts, combinant RAG (génération augmentée par récupération), une vérification automatisée à plusieurs niveaux, ainsi qu’un cluster d’agents IA spécialisés fonctionnant au-dessus d’une analyse statique déterministe, afin d’offrir un soutien approfondi à l’audit.

Lors de l’audit public du DEX de contrats perpétuels Bluefin, BitsLab AI a identifié quatre problèmes, dont un défaut logique critique, que l’équipe Bluefin a depuis corrigé.

1) Pourquoi l’IA est-elle nécessaire maintenant ? La transformation du paradigme de sécurité blockchain

Le paradigme de la sécurité blockchain et de la protection des actifs numériques est en train de subir une transformation fondamentale. Grâce aux avancées majeures des modèles de base, les grands modèles linguistiques (LLMs) et agents IA d’aujourd’hui possèdent une forme d’intelligence initiale mais puissante. Lorsqu’on leur fournit un contexte clairement défini, ces modèles peuvent analyser de manière autonome le code des contrats intelligents afin d’y détecter des vulnérabilités potentielles. Cela favorise la diffusion rapide d’outils assistés par IA, tels que des interfaces utilisateur conversationnelles (UIs) ou des environnements de développement intégrés (IDE) dotés d’agents IA, qui deviennent progressivement une partie intégrante du flux de travail standard des auditeurs de contrats intelligents et des chercheurs en sécurité Web3.

Cependant, malgré les espoirs soulevés par cette première vague d’intégration de l’IA, celle-ci reste limitée par des faiblesses critiques qui empêchent d’atteindre le niveau de fiabilité requis dans les environnements blockchain à haut risque :

Audit superficiel et fortement dépendant de l’intervention humaine : les outils actuels agissent comme un « copilote », non comme un auditeur autonome. Ils sont incapables de comprendre l’architecture globale de protocoles complexes et dépendent d’une orientation continue par l’humain. Cette limitation les rend inaptes à effectuer les analyses automatisées approfondies nécessaires pour garantir la sécurité de contrats intelligents interconnectés.

Taux élevé de faux positifs dus aux hallucinations : le processus de raisonnement des LLM généralistes est affecté par des « hallucinations ». Dans un contexte de sécurité, cela génère un grand nombre de fausses alertes et d’avertissements redondants, obligeant les auditeurs à gaspiller un temps précieux à réfuter des vulnérabilités fictives, plutôt que de corriger celles réelles pouvant entraîner des conséquences désastreuses sur la chaîne.

Compréhension insuffisante des langages spécialisés : les performances des LLM dépendent directement de leurs données d’entraînement. Pour un langage spécialisé comme Move, conçu spécifiquement pour la sécurité des actifs, la rareté de ressources publiques comprenant des bases de code complexes et des vulnérabilités documentées limite la compréhension du modèle concernant le modèle de sécurité unique de Move, notamment ses principes fondamentaux de gestion des ressources et de propriété mémoire.

2) Le cadre de sécurité IA de BitsLab (fiabilité à grande échelle)

Face aux lacunes critiques des IA généralistes, nous avons conçu un cadre reposant sur une architecture multicouche et priorisant la sécurité. Il ne s’agit pas d’un simple modèle unique, mais d’un système intégré où chaque composant est conçu pour relever un défi spécifique dans l’audit des contrats intelligents, allant de l’intégrité des données jusqu’à l’analyse automatisée approfondie.

1. Couche fondamentale : jeu de données spécialisé, conçu par des experts

La capacité prédictive de toute IA repose sur ses données. Les performances exceptionnelles de notre cadre découlent de notre base de connaissances exclusive, fondamentalement différente des jeux de données généraux utilisés pour entraîner les LLM publics. Nos avantages se manifestent par :

-

Couverture étendue dans des domaines précis : nous disposons d’un vaste jeu de données spécialisé, soigneusement collecté et centré sur des domaines à haut risque tels que le prêt DeFi, les marchés NFT et les protocoles basés sur Move. Cela confère une profondeur contextuelle inégalée pour détecter les vulnérabilités propres à ces domaines.

-

Conception et nettoyage expert : nos données ne sont pas simplement extraites automatiquement ; elles sont constamment nettoyées, validées et enrichies par des experts en sécurité de contrats intelligents. Ce processus inclut l’annotation des vulnérabilités connues, la mise en évidence des schémas de codage sécurisés, ainsi que la suppression du bruit inutile, créant ainsi une « vérité terrain » de haute fidélité pour l’apprentissage du modèle. Cette conception collaborative homme-machine garantit que notre IA apprend à partir des données les plus qualitatives, améliorant considérablement sa précision.

2. Précision : élimination des hallucinations grâce au RAG et à une revue multicouche

Pour résoudre ce problème critique des hallucinations et des faux positifs, nous avons mis en œuvre un système double complexe, contraignant le raisonnement de l’IA à reposer sur des faits vérifiables :

-

Génération augmentée par récupération (RAG) : notre IA ne s’appuie pas uniquement sur ses connaissances internes, mais interroge continuellement une base de connaissances en temps réel avant de tirer des conclusions. Ce système RAG récupère les dernières recherches sur les vulnérabilités, les meilleures pratiques établies en matière de sécurité (par exemple, le registre SWC, les standards EIP), ainsi que des exemples de code provenant de protocoles similaires ayant déjà fait l’objet d’audits réussis. Cela force l’IA à « citer ses sources », garantissant que ses conclusions reposent sur des faits avérés, et non sur des suppositions probabilistes.

-

Modèle de revue multicouche : chaque problème potentiel identifié par l’IA générative passe par un processus rigoureux de validation interne. Ce processus implique un mécanisme automatisé de revue composé d’une série de modèles spécialisés : un modèle de croisement vérifie la découverte par rapport aux données RAG, un modèle « auditeur » affiné évalue sa validité technique, et enfin un modèle de « priorisation » juge son impact potentiel sur les activités. Grâce à ce processus, les conclusions à faible confiance et les hallucinations sont systématiquement filtrées avant d’atteindre l’auditeur humain.

3. Profondeur : automatisation approfondie via la collaboration entre analyse statique et agents IA

Pour atteindre une automatisation profonde et contextuelle allant au-delà des simples outils de type « copilote », nous adoptons une approche collaborative combinant analyse déterministe et agents intelligents :

-

Analyse statique comme fondement : notre processus commence par un parcours exhaustif d’analyse statique permettant de cartographier de façon déterministe l’ensemble du protocole. Cela génère un graphe complet de flux de contrôle, identifie toutes les variables d’état et trace les dépendances fonctionnelles entre tous les contrats. Cette cartographie fournit à notre IA un « monde objectif » de base et factuel.

-

Gestion du contexte : le cadre maintient un contexte riche et global sur l’ensemble du protocole. Il comprend non seulement les fonctions individuelles, mais aussi leurs interactions mutuelles. Cette capacité essentielle lui permet d’analyser les effets en cascade des changements d’état et d’identifier des vulnérabilités complexes liées aux interactions entre contrats.

-

Collaboration d’agents IA : nous déployons un ensemble d’agents IA spécialisés, chacun formé pour une tâche spécifique. L’« agent de contrôle d’accès » recherche activement les vulnérabilités d’élévation de privilèges ; l’« agent de réentrance » se concentre sur la détection des appels externes non sécurisés ; l’« agent logique arithmétique » examine minutieusement toutes les opérations mathématiques pour identifier des cas limites tels que les débordements ou erreurs de précision. Ces agents collaborent à partir d’une cartographie contextuelle partagée, permettant de découvrir des techniques d’attaque complexes que seul un modèle IA monolithique aurait manquées.

Cette combinaison puissante permet à notre cadre d’automatiser la détection de défauts architecturaux profonds, jouant véritablement le rôle d’un partenaire autonome en matière de sécurité.

3) Étude de cas : découverte d’un défaut logique critique dans Bluefin PerpDEX

Pour valider dans un scénario réel l’architecture multicouche de notre cadre, nous l’avons appliqué à l’audit de sécurité public de Bluefin. Bluefin est un DEX décentralisé complexe pour contrats perpétuels. Cet audit illustre comment nous avons pu découvrir une vulnérabilité invisible aux outils traditionnels, grâce à l’analyse statique, à des agents IA spécialisés et à une vérification factuelle basée sur RAG.

Processus d’analyse : fonctionnement du système multi-agents

La découverte de cette vulnérabilité critique n’est pas le fruit du hasard, mais le résultat d’une collaboration systématique entre les différents composants intégrés du cadre :

-

Cartographie du contexte et analyse statique

Le processus commence par l’entrée de l’intégralité de la base de code de Bluefin. Notre moteur d’analyse statique cartographie de manière déterministe l’ensemble du protocole, tandis qu’un agent IA d’analyse de base fournit un aperçu global du projet, identifiant les modules liés à la logique financière centrale. -

Déploiement d’agents spécialisés

Sur la base de cette analyse initiale, le système déploie automatiquement une série d’agents spécialisés par phase. Chaque agent IA dispose de ses propres prompts d’audit et de sa base de données vectorielle. Dans ce cas, l’un des agents, spécialisé dans la correction logique et les vulnérabilités de cas limites (comme les débordements, sous-débordements et erreurs de comparaison), a identifié le problème. -

Analyse et vérification basées sur RAG

L’agent logique arithmétique (Arithmetic Logic Agent) lance alors son analyse. En s’appuyant sur la génération augmentée par récupération (RAG), il interroge notre base de connaissances experte, consulte les meilleures pratiques d’implémentation en langage Move, et compare le code de Bluefin à des défauts logiques similaires déjà documentés dans d’autres protocoles financiers. Ce processus de récupération met en évidence que la comparaison entre nombres positifs et négatifs constitue un cas typique d’erreur limite.

Découverte : une vulnérabilité critique dans la logique financière centrale

Grâce à notre cadre, nous avons finalement identifié quatre problèmes distincts, dont un défaut logique critique enfoui au cœur du moteur de calcul financier du protocole.

La vulnérabilité se situe dans la fonction lt (inférieur à) du module signed_number. Cette fonction est cruciale pour toute comparaison financière, comme le tri des positions ou le calcul des profits et pertes (PNL). Elle pourrait provoquer d’importantes divergences financières, des liquidations erronées, et une défaillance du mécanisme d’ordonnancement équitable au cœur du DEX, menaçant directement l’intégrité du protocole.

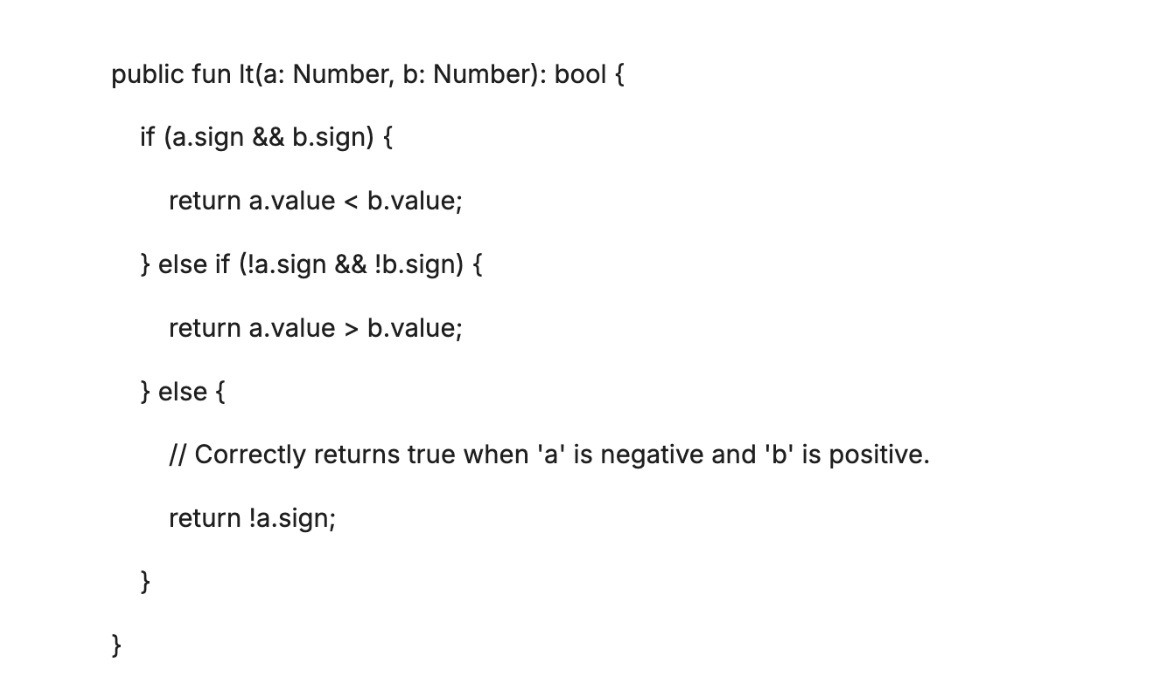

Le problème découle d’une erreur logique lors de la comparaison d’un nombre négatif avec un nombre positif. Le module signed_number utilise value: u64 et sign: bool (true pour positif, false pour négatif) pour représenter les valeurs. La fonction lt présente un défaut dans sa branche else (traitant la comparaison de nombres de signes différents). Lorsqu’un nombre négatif (!a.sign) est comparé à un nombre positif (b.sign), la fonction retourne incorrectement a.sign (soit false), affirmant ainsi à tort que « le nombre positif est inférieur au nombre négatif ».

Solution corrective :

Pour corriger ce problème critique, la branche else de la fonction lt doit être modifiée de manière simple mais essentielle. L’implémentation corrigée doit retourner !a.sign, garantissant ainsi qu’un nombre négatif soit toujours correctement évalué comme inférieur à un nombre positif lors de la comparaison.

Correction

Résultat : l’équipe de développement de Bluefin a été immédiatement informée après réception de ce rapport détaillé, et a pris des mesures rapides pour corriger le problème.

4) Importance de BitsLab AI pour les équipes Web3

-

Moins de bruit dû aux faux positifs : RAG + revue multicouche réduit fortement les « hallucinations » et les faux positifs.

-

Couverture plus approfondie : carte d’analyse statique + collaboration d’agents permet de détecter les risques systémiques transversaux aux contrats, liés aux conditions limites et à la logique.

-

Priorisation orientée métier : le classement par impact guide l’investissement technique, concentrant le temps sur les « problèmes les plus critiques ».

5) Conclusion : la sécurité renforcée par BitsLab AI devient la nouvelle norme

La mise en pratique chez Bluefin valide l’argument central de BitsLab : une sécurité Web3 fiable doit être à la fois « fondée sur des preuves » (RAG), « contrôlée à plusieurs niveaux » (revue multicouche) et « ancrée dans la structure » (analyse statique + collaboration d’agents).

Cette approche est particulièrement cruciale pour comprendre et vérifier la logique sous-jacente de la finance décentralisée, et constitue une condition nécessaire au maintien de la confiance à l’échelle des protocoles.

Dans l’environnement Web3 en évolution rapide, la complexité des contrats ne cesse d’augmenter ; parallèlement, les recherches publiques et données disponibles sur Move restent relativement rares, rendant la « sécurité » encore plus difficile. BitsLab AI de BitsLab a justement été conçu pour relever ce défi — en combinant des connaissances spécialisées conçues par des experts, un raisonnement augmenté vérifiable, et une analyse automatisée centrée sur le contexte global, afin d’identifier et d’atténuer de bout en bout les risques liés aux contrats Move, insufflant ainsi une intelligence durable dans la sécurité Web3.

Bienvenue dans la communauté officielle TechFlow

Groupe Telegram :https://t.me/TechFlowDaily

Compte Twitter officiel :https://x.com/TechFlowPost

Compte Twitter anglais :https://x.com/BlockFlow_News