IOSG : Lorsque votre navigateur devient un agent

TechFlow SélectionTechFlow Sélection

IOSG : Lorsque votre navigateur devient un agent

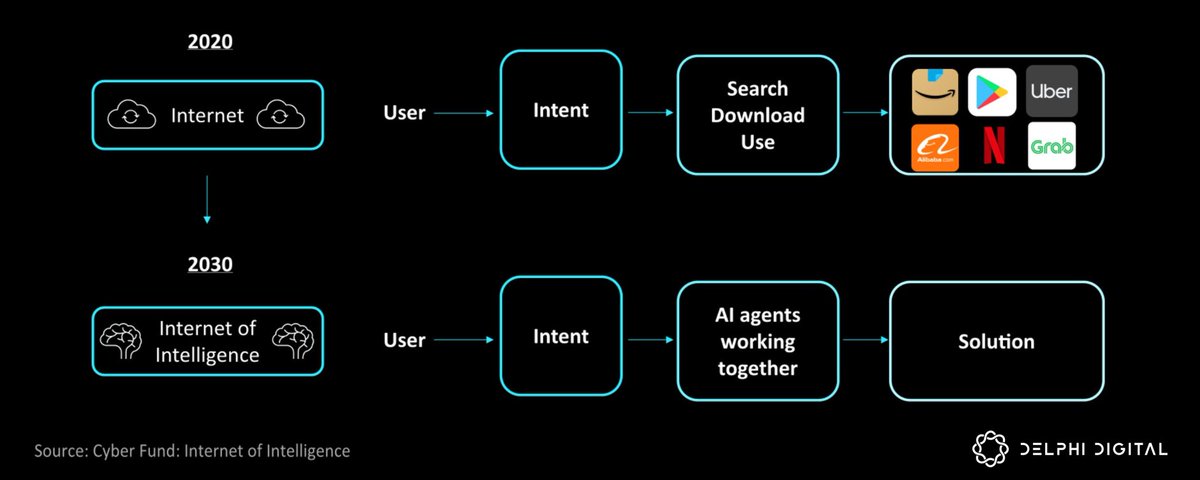

L'avenir de l'IA réside dans les agents capables de naviguer de manière autonome sur le web.

Rédaction : Mario Chow & Figo @IOSG

Introduction

Au cours des 12 derniers mois, la relation entre les navigateurs web et l'automatisation a profondément changé. Toutes les grandes entreprises technologiques s'affrontent désormais pour construire des agents navigateurs autonomes. Cette tendance est devenue particulièrement évidente depuis la fin 2024 : OpenAI a lancé son mode Agent en janvier, Anthropic a introduit la fonction « Utilisation de l'ordinateur » pour son modèle Claude, Google DeepMind a dévoilé le Project Mariner, Opera a annoncé son navigateur agentiel Neon, et Perplexity AI a lancé le navigateur Comet. Le message est clair : l'avenir de l'IA réside dans les agents capables de naviguer sur le web de manière autonome.

Cette évolution ne se limite pas à intégrer des chatbots plus intelligents aux navigateurs ; elle représente une transformation fondamentale de la manière dont les machines interagissent avec l'environnement numérique. Les agents navigateurs sont des systèmes d'IA capables de « voir » les pages web et d'agir dessus : cliquer sur des liens, remplir des formulaires, faire défiler les pages ou saisir du texte, exactement comme un utilisateur humain. Ce modèle promet de libérer une productivité et une valeur économique considérables, en automatisant des tâches qui nécessitent aujourd'hui encore une intervention humaine ou qui sont trop complexes pour être traitées par des scripts traditionnels.

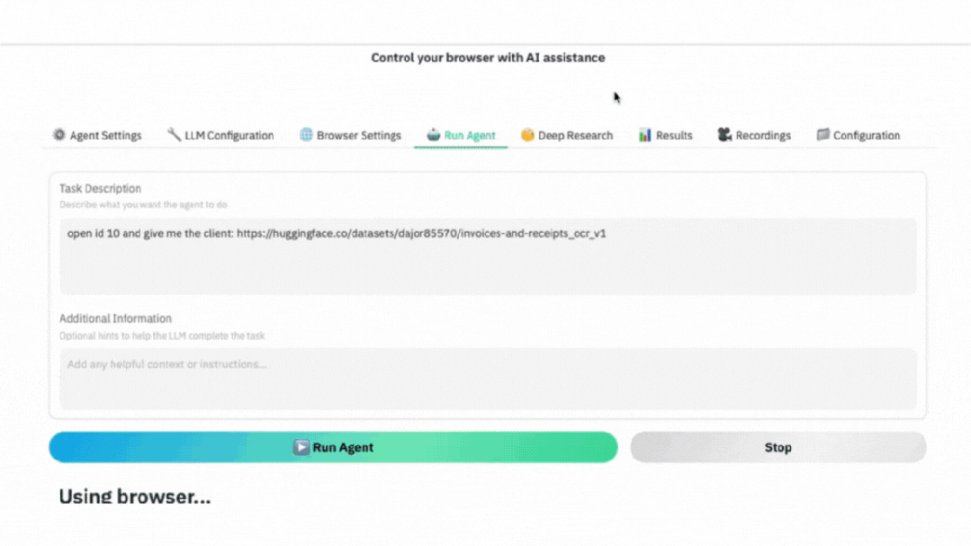

▲ GIF démonstration : opération réelle d’un agent navigateur IA : suivre une instruction, naviguer vers la page du jeu de données cible, capturer automatiquement l’écran et extraire les données requises.

Qui remportera la guerre du navigateur IA ?

Presque toutes les grandes entreprises technologiques (ainsi que certaines startups) développent leurs propres solutions d’agent IA pour navigateur. Voici quelques projets parmi les plus représentatifs :

OpenAI – Mode Agent

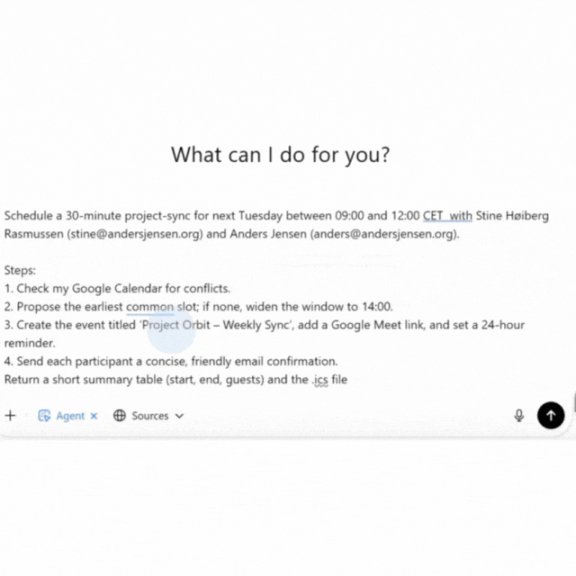

Le mode Agent d'OpenAI (anciennement nommé Operator, lancé en janvier 2025) est un agent IA doté de son propre navigateur. Operator peut gérer diverses tâches en ligne répétitives : remplir des formulaires web, commander des courses, planifier des réunions, le tout via les interfaces web standards utilisées par les humains.

▲ Un agent IA organise une réunion comme un assistant professionnel : vérifie le calendrier, trouve un créneau disponible, crée l’événement, envoie une confirmation et génère un fichier .ics pour vous.

Anthropic – « Utilisation de l’ordinateur » de Claude

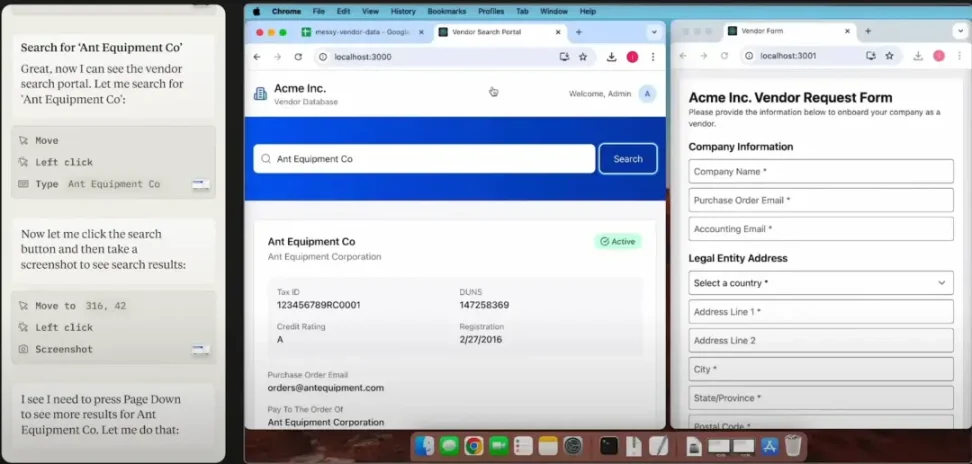

Fin 2024, Anthropic a introduit une nouvelle fonctionnalité « Utilisation de l’ordinateur » (Computer Use) pour Claude 3.5, lui permettant d’opérer un ordinateur et un navigateur comme un humain. Claude peut analyser l’écran, déplacer le curseur, cliquer sur des boutons et saisir du texte. Il s'agit du premier outil d'agent basé sur un grand modèle à entrer en version bêta publique, permettant aux développeurs de faire naviguer Claude automatiquement sur des sites web et applications. Anthropic présente cette fonction comme expérimentale, visant principalement à automatiser des flux de travail multi-étapes sur le web.

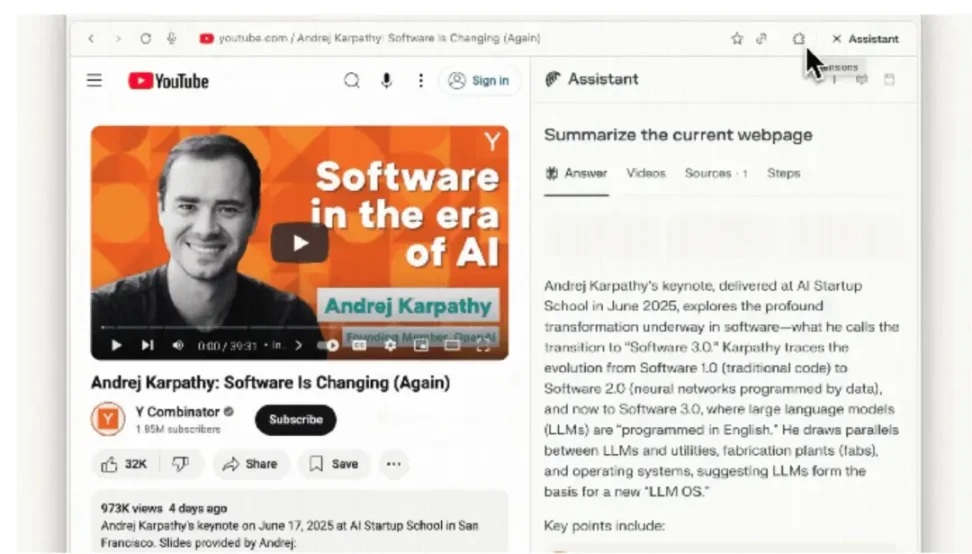

Perplexity – Comet

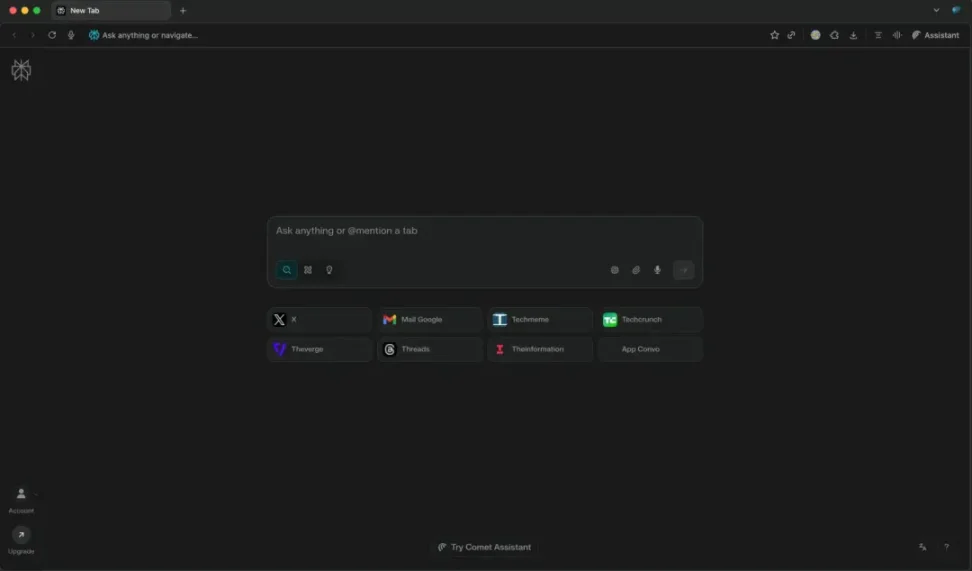

La startup IA Perplexity, connue pour son moteur de réponse, a lancé en milieu d'année 2025 le navigateur Comet, présenté comme une alternative au Chrome pilotée par l'IA. Le cœur de Comet est un moteur de recherche conversationnel intégré à la barre d'adresse (omnibox), fournissant des réponses instantanées et des résumés plutôt que des liens de recherche traditionnels.

En outre, Comet intègre également Comet Assistant, un agent présent dans une barre latérale capable d’exécuter automatiquement des tâches quotidiennes à travers plusieurs sites. Par exemple, il peut résumer vos e-mails ouverts, planifier des réunions, gérer les onglets du navigateur ou parcourir et extraire des informations web en votre nom.

En permettant à l’agent d’analyser le contenu de la page actuelle via une interface latérale, Comet vise à fusionner de manière fluide navigation et assistance IA.

Applications réelles des agents navigateurs

Dans les sections précédentes, nous avons passé en revue comment différentes entreprises technologiques (OpenAI, Anthropic, Perplexity, etc.) intègrent des fonctionnalités aux agents navigateurs selon des approches variées. Pour mieux comprendre leur valeur, examinons maintenant comment ces capacités peuvent être appliquées concrètement dans la vie quotidienne et les processus professionnels.

Automatisation courante sur le web

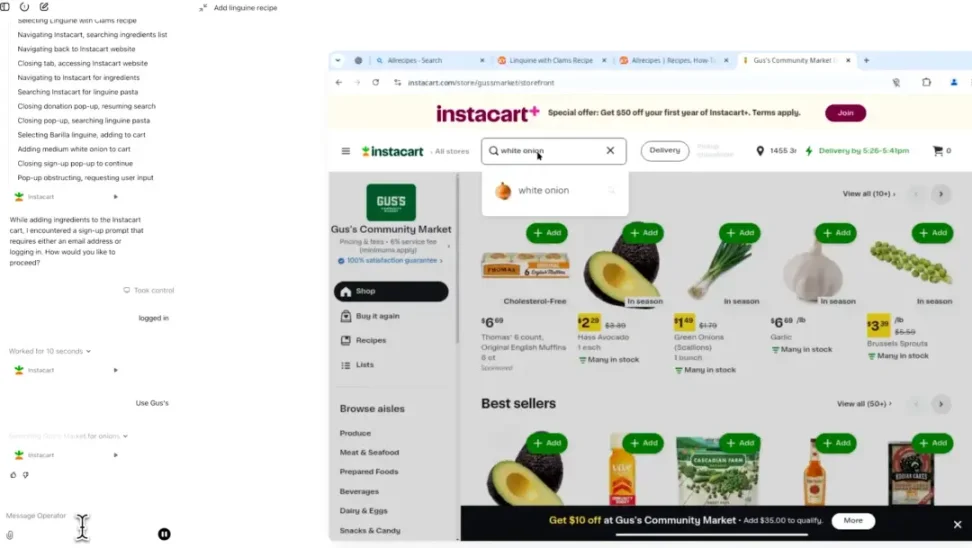

#Commerce électronique et achats personnels

Un scénario très pratique consiste à confier à un agent des tâches d’achat ou de réservation. L’agent peut automatiquement remplir votre panier en ligne selon une liste fixe et passer commande, comparer les prix entre différents détaillants et finaliser le paiement à votre place.

Pour les voyages, vous pouvez demander à l’IA d’accomplir une tâche comme : « Réserve-moi un vol pour Tokyo le mois prochain à moins de 800 dollars, puis trouve un hôtel avec Wi-Fi gratuit. » L’agent gère alors tout le processus : recherche de vols, comparaison des options, saisie des informations passagers, réservation d’hôtel, le tout directement sur les sites des compagnies aériennes et des hôtels. Ce niveau d’automatisation dépasse largement les robots de voyage existants : il ne se contente pas de recommander, mais exécute réellement l’achat.

#Amélioration de l’efficacité professionnelle

Les agents peuvent automatiser de nombreuses opérations commerciales répétitives effectuées par les utilisateurs dans un navigateur. Par exemple, trier les e-mails et en extraire des tâches, consulter plusieurs calendriers pour trouver un créneau libre et planifier automatiquement une réunion. L’assistant Comet de Perplexity peut déjà résumer le contenu de votre boîte de réception via une interface web ou ajouter des événements à votre agenda. Avec autorisation, l’agent peut aussi se connecter à des outils SaaS pour générer des rapports réguliers, mettre à jour des feuilles de calcul ou soumettre des formulaires. Imaginez un agent RH capable de publier automatiquement des offres d’emploi sur différents sites spécialisés, ou un agent commercial mettant à jour les données des prospects dans un système CRM. Ces tâches chronophages, qui consomment beaucoup de temps humain, peuvent être réalisées par l’IA grâce à l’automatisation des formulaires web et des interactions de navigation.

Au-delà des tâches isolées, les agents peuvent orchestrer des flux de travail complets traversant plusieurs systèmes en ligne. Chacune de ces étapes nécessite une interaction avec une interface web différente, ce qui constitue justement le point fort des agents navigateurs. Ils peuvent se connecter à divers tableaux de bord pour diagnostiquer des pannes, voire orchestrer des processus complets, comme l’intégration d’un nouvel employé (création de comptes sur plusieurs plateformes SaaS). En substance, toute opération complexe nécessitant actuellement d’ouvrir plusieurs sites web peut être confiée à un agent.

Difficultés et limites actuelles

Bien que le potentiel soit immense, les agents navigateurs actuels sont loin de la perfection. Les implémentations révèlent plusieurs problèmes techniques et structurels persistants :

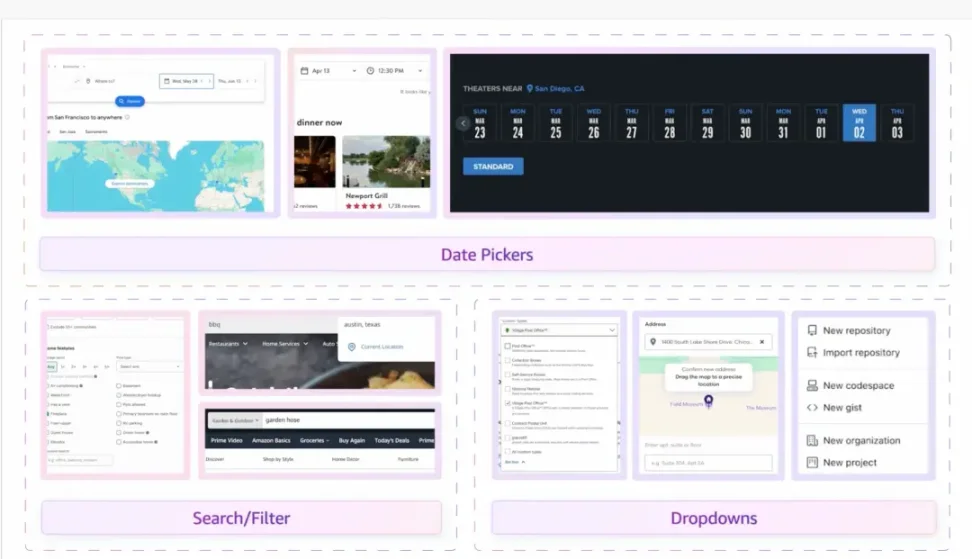

Inadéquation architecturale

Le web moderne a été conçu pour des navigateurs utilisés par des humains, et a évolué progressivement pour contrer l’automatisation. Les données sont souvent enfouies dans du HTML/CSS optimisé pour l’affichage visuel, restreintes par des gestes interactifs (passage de souris, glissement) ou accessibles uniquement via des API non documentées.

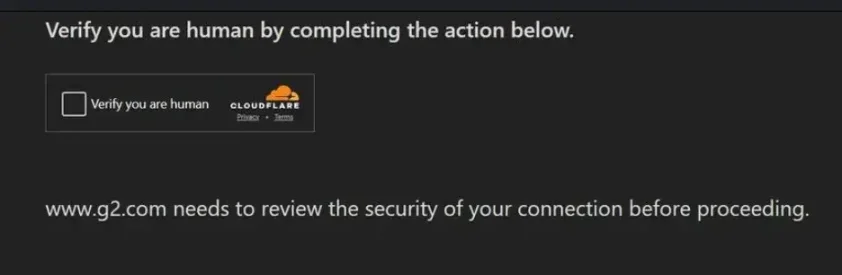

Par ailleurs, les systèmes anti-crawlers et antifraude ajoutent artificiellement des obstacles supplémentaires. Ces outils combinent la réputation IP, l’empreinte du navigateur, les défis JavaScript et l’analyse comportementale (par exemple, aléatoire du mouvement de souris, rythme de frappe, durée de session). Ironiquement, plus un agent IA agit de manière « parfaite » et efficace — par exemple en remplissant instantanément un formulaire sans erreur — plus il risque d’être détecté comme une automatisation malveillante. Cela peut entraîner des blocages brusques : par exemple, un agent OpenAI ou Google peut réussir toutes les étapes avant le paiement, mais être bloqué au dernier moment par un CAPTCHA ou un filtre de sécurité secondaire.

La superposition d’interfaces optimisées pour les humains et de couches de défense hostiles aux robots oblige les agents à adopter des stratégies fragiles de « mimétisme humain ». Cette approche échoue facilement et obtient un faible taux de succès (moins d’un tiers des transactions complètes aboutissent sans intervention humaine).

Préoccupations liées à la confiance et à la sécurité

Accorder un contrôle total à un agent implique généralement d’accéder à des informations sensibles : identifiants de connexion, cookies, jetons d’authentification à deux facteurs, voire données de paiement. Cela soulève des inquiétudes compréhensibles tant pour les utilisateurs que pour les entreprises :

-

Que se passe-t-il si l’agent commet une erreur ou est trompé par un site malveillant ?

-

Qui est responsable si l’agent accepte des conditions d’utilisation ou effectue une transaction ?

Face à ces risques, les systèmes actuels adoptent une attitude prudente :

-

Mariner de Google n’entre pas d’informations de carte bancaire ni n’accepte les conditions de service, mais renvoie la main à l’utilisateur.

-

Operator d’OpenAI invite l’utilisateur à prendre le relais pour la connexion ou les défis CAPTCHA.

L’agent piloté par Claude d’Anthropic peut carrément refuser de se connecter, invoquant des raisons de sécurité.

Le résultat est une succession fréquente d’arrêts et de reprises entre IA et humain, affaiblissant l’expérience d’automatisation fluide.

Malgré ces obstacles, les progrès avancent rapidement. OpenAI, Google, Anthropic et d’autres apprennent de chaque itération. À mesure que la demande croît, une « coévolution » pourrait émerger : certains sites deviendraient plus accueillants envers les agents dans des cas bénéfiques, tandis que les agents amélioreraient leur capacité à imiter le comportement humain pour contourner les barrières existantes.

Approches et opportunités

Les agents navigateurs actuels font face à deux réalités opposées : d’un côté, l’environnement hostile de Web2, saturé de systèmes anti-crawlers et de défenses de sécurité ; de l’autre, l’environnement ouvert de Web3, où l’automatisation est souvent encouragée. Cette différence oriente les directions des diverses solutions.

Les solutions ci-dessous peuvent être grossièrement divisées en deux catégories : celles qui aident les agents à contourner l’environnement hostile de Web2, et celles nées nativement dans l’écosystème Web3.

Bien que les défis soient toujours importants, de nouveaux projets émergent continuellement pour y répondre directement. L’écosystème des cryptomonnaies et de la finance décentralisée (DeFi) devient un terrain d’expérimentation naturel, car il est ouvert, programmable et peu hostile à l’automatisation. Les API ouvertes, les contrats intelligents et la transparence sur chaîne éliminent de nombreux points de friction typiques du monde Web2.

Voici quatre types de solutions, chacune abordant une ou plusieurs limitations fondamentales actuelles :

Navigateurs agents natifs pour les opérations sur chaîne

Ces navigateurs sont conçus dès le départ pour être pilotés par des agents autonomes et sont profondément intégrés aux protocoles blockchain. Contrairement aux navigateurs traditionnels comme Chrome, qui nécessitent des outils supplémentaires comme Selenium, Playwright ou des extensions de portefeuille pour automatiser les actions sur chaîne, les navigateurs agents natifs offrent directement des API et des chemins d’exécution fiables aux agents.

Dans la finance décentralisée, la validité d’une transaction repose sur une signature cryptographique, pas sur le fait qu’un utilisateur « ressemble à un humain ». Ainsi, dans un environnement sur chaîne, les agents peuvent contourner les CAPTCHA, scores de fraude et vérifications d’empreinte d’appareil typiques du Web2. Toutefois, si ces navigateurs accèdent à des sites Web2 comme Amazon, ils ne peuvent pas éviter les mécanismes de défense associés et déclenchent normalement les mesures anti-robots.

La valeur des navigateurs agents ne réside pas dans un accès magique à tous les sites, mais dans :

-

Intégration blockchain native : portefeuille intégré et prise en charge des signatures, sans pop-up MetaMask ni analyse du DOM du frontend dApp.

-

Conception prioritaire pour l’automatisation : instructions haut niveau stables, directement mappées aux opérations du protocole.

-

Modèle de sécurité : contrôle granulaire des permissions et bac à sable, garantissant la sécurité des clés privées pendant l’automatisation.

-

Optimisation des performances : possibilité d’exécuter plusieurs appels sur chaîne en parallèle, sans latence due au rendu du navigateur ou à l’interface.

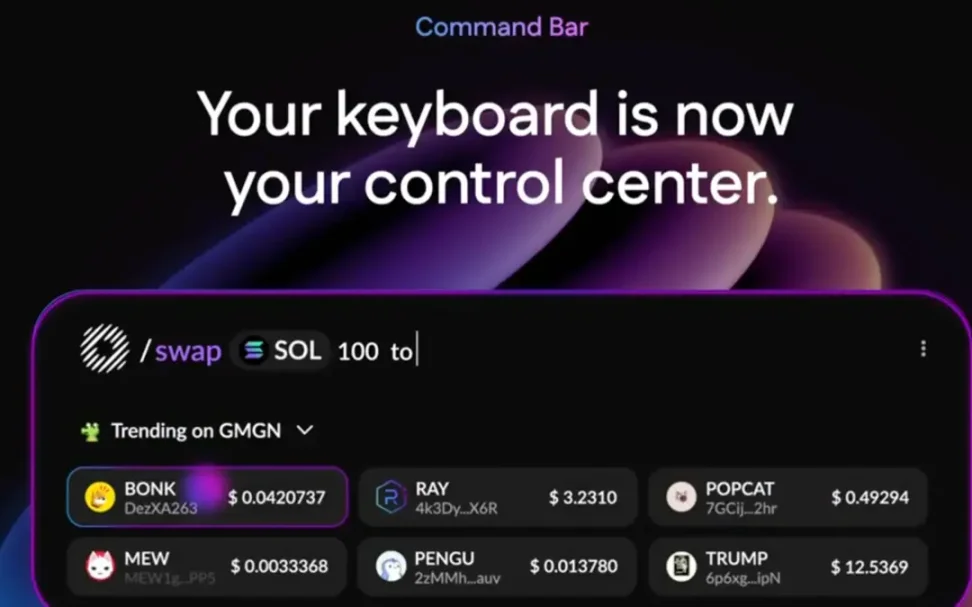

#Cas : Donut

Donut intègre les données et opérations blockchain comme des éléments centraux. L’utilisateur (ou son agent) peut survoler un jeton pour voir ses indicateurs de risque en temps réel, ou saisir une commande en langage naturel comme « /swap 100 USDC to SOL ». En contournant les frictions hostiles du Web2, Donut permet aux agents d’opérer à pleine vitesse dans DeFi, améliorant liquidité, arbitrages et efficacité du marché.

Exécution d’agents vérifiables et fiables

Accorder des permissions sensibles à un agent comporte des risques élevés. Certaines solutions utilisent des environnements d’exécution fiables (TEEs) ou des preuves à divulgation nulle (ZKPs) pour chiffrer et confirmer le comportement attendu de l’agent avant son exécution, permettant ainsi à l’utilisateur et aux parties prenantes de valider les actions de l’agent sans exposer les clés privées ou les identifiants.

#Cas : Phala Network

Phala utilise des TEEs (comme Intel SGX) pour isoler et protéger l’environnement d’exécution, empêchant ainsi l’opérateur Phala ou des attaquants d’espionner ou de modifier la logique et les données de l’agent. Un TEE agit comme une « chambre forte matérielle », garantissant confidentialité (invisible de l’extérieur) et intégrité (non modifiable de l’extérieur).

Pour un agent navigateur, cela signifie qu’il peut se connecter, conserver des jetons de session ou traiter des informations de paiement, sans que ces données sensibles quittent jamais la chambre forte. Même si la machine, le système d’exploitation ou le réseau de l’utilisateur est compromis, aucune fuite n’est possible. Cela atténue directement l’un des principaux freins à l’adoption des agents : la question de la confiance autour des identifiants sensibles et des opérations critiques.

Réseaux décentralisés de données structurées

Les systèmes modernes de détection anti-robots ne surveillent pas seulement si une requête est « trop rapide » ou « automatisée », mais combinent aussi la réputation IP, l’empreinte du navigateur, les réponses aux défis JavaScript et l’analyse comportementale (mouvements du curseur, rythme de frappe, historique de session). Les agents provenant d’IP de centre de données ou d’environnements de navigation entièrement reproductibles sont facilement identifiables.

Pour résoudre ce problème, ces réseaux cessent de scraper les pages web optimisées pour les humains, et collectent directement des données lisibles par machine, ou routent le trafic via de véritables environnements de navigation humains. Cette approche contourne la vulnérabilité des crawlers traditionnels lors de l’analyse et du contournement des protections, fournissant aux agents des entrées plus propres et fiables.

En routant le trafic des agents via ces sessions réelles, les réseaux distribués permettent aux agents IA d’accéder au contenu web comme un humain, sans être immédiatement bloqués.

#Cas

-

Grass : réseau de données décentralisé / DePIN, où les utilisateurs partagent leur bande passante résidentielle, offrant ainsi des canaux d’accès proxy-friendly et géographiquement diversifiés pour la collecte de données publiques et l’entraînement de modèles.

-

WootzApp : navigateur mobile open source prenant en charge les paiements cryptos, doté d’un agent en arrière-plan et d’une identité à divulgation nulle ; il « gamifie » les tâches IA/données pour les consommateurs.

-

Sixpence : réseau de navigateurs distribué, qui achemine le trafic des agents IA via les navigations d’utilisateurs du monde entier.

Cependant, ce n’est pas une solution complète. Les détections comportementales (trajectoires de souris/défilement), les restrictions au niveau du compte (KYC, ancienneté du compte) et les vérifications de cohérence d’empreinte peuvent toujours entraîner des blocages. Ainsi, les réseaux distribués doivent être considérés comme une couche de dissimulation de base, à combiner avec des stratégies d’exécution imitant le comportement humain pour obtenir un effet optimal.

Normes web pour agents (prospective)

De plus en plus de communautés technologiques explorent cette question : si les utilisateurs futurs du web ne sont pas seulement des humains, mais aussi des agents automatisés, comment les sites web peuvent-ils interagir avec eux de manière sûre et conforme ?

Cela stimule des discussions autour de nouvelles normes et mécanismes visant à permettre aux sites de déclarer explicitement « J’autorise les agents de confiance à accéder ici », et d’offrir un canal sécurisé pour les interactions, plutôt que de bloquer systématiquement les agents comme des « attaques robotiques » comme c’est le cas aujourd’hui.

-

Balise « Agent Allowed » : à l’instar du fichier robots.txt respecté par les moteurs de recherche, les pages web pourraient inclure une balise indiquant aux agents navigateurs « l’accès ici est sûr ». Par exemple, lorsqu’un agent réserve un billet d’avion, le site n’afficherait pas de CAPTCHA, mais proposerait directement une interface authentifiée.

-

Passerelle API pour agents certifiés : les sites pourraient ouvrir des entrées dédiées aux agents vérifiés, comme une « voie rapide ». L’agent n’aurait plus besoin d’imiter des clics ou saisies humaines, mais pourrait utiliser un chemin API plus stable pour commander, payer ou interroger des données.

-

Discussions au sein du W3C : le World Wide Web Consortium (W3C) étudie déjà comment standardiser des canaux pour « l’automatisation gérée ». Cela pourrait conduire à un ensemble de règles mondiales permettant aux sites de reconnaître et accepter les agents de confiance, tout en assurant sécurité et traçabilité.

Bien que ces initiatives en soient encore à leurs débuts, leur mise en œuvre pourrait radicalement transformer la relation humain ↔ agent ↔ site. Imaginez : plus besoin que l’agent simule désespérément les mouvements de souris pour « tromper » les systèmes de contrôle, mais pouvoir accomplir sa tâche légitimement via un canal « officiellement autorisé ».

Dans cette voie, les infrastructures natives crypto pourraient prendre une longueur d’avance. Les applications sur chaîne reposent naturellement sur des API ouvertes et des contrats intelligents, favorisant l’automatisation. En revanche, les plateformes Web2 traditionnelles pourraient continuer à se défendre prudemment, surtout celles dépendant de la publicité ou des systèmes antifraude. Mais à mesure que les utilisateurs et entreprises accepteront les gains d’efficacité apportés par l’automatisation, ces tentatives standardisées pourraient devenir le catalyseur essentiel d’un internet évoluant vers une « architecture prioritaire pour agents ».

Conclusion

Les agents navigateurs évoluent progressivement d’outils conversationnels simples à des systèmes autonomes capables d’exécuter des workflows en ligne complexes. Ce changement reflète une tendance plus large : intégrer l’automatisation directement dans l’interface centrale d’interaction entre l’utilisateur et internet. Bien que le potentiel de gain de productivité soit énorme, les défis demeurent sévères, notamment surmonter les mécanismes anti-robots profondément ancrés, et assurer sécurité, confiance et usage responsable.

À court terme, l’amélioration des capacités de raisonnement des agents, leur rapidité accrue, une intégration plus étroite avec les services existants et les progrès des réseaux distribués pourraient progressivement augmenter leur fiabilité. À long terme, nous verrons probablement l’émergence progressive de normes « agent-friendly » dans les contextes où l’automatisation bénéficie à la fois aux prestataires de services et aux utilisateurs. Toutefois, cette transition ne sera pas uniforme : dans des environnements favorables comme DeFi, l’adoption sera rapide ; dans les plateformes Web2 fortement dépendantes du contrôle humain, elle sera plus lente.

À l’avenir, la compétition entre entreprises technologiques se concentrera de plus en plus sur la capacité de leurs agents à naviguer sous contraintes réelles, à s’intégrer en toute sécurité à des workflows critiques, et à produire des résultats stables dans des environnements numériques variés. Que cela redéfinisse ou non la « guerre des navigateurs », dépendra non seulement de la puissance technique, mais surtout de la capacité à instaurer la confiance, aligner les incitations et démontrer une valeur tangible au quotidien.

Bienvenue dans la communauté officielle TechFlow

Groupe Telegram :https://t.me/TechFlowDaily

Compte Twitter officiel :https://x.com/TechFlowPost

Compte Twitter anglais :https://x.com/BlockFlow_News