« IA 2027 » selon Vitalik : une superintelligence risque-t-elle vraiment d’anéantir l’humanité ?

TechFlow SélectionTechFlow Sélection

« IA 2027 » selon Vitalik : une superintelligence risque-t-elle vraiment d’anéantir l’humanité ?

Quel que soit le développement de l'IA au cours des 5 à 10 prochaines années, reconnaître qu'« il est possible de réduire la vulnérabilité du monde » et y consacrer davantage d'efforts en utilisant les dernières technologies humaines constitue une voie digne d'être explorée.

Rédaction : Vitalik Buterin

Traduction : Luffy, Foresight News

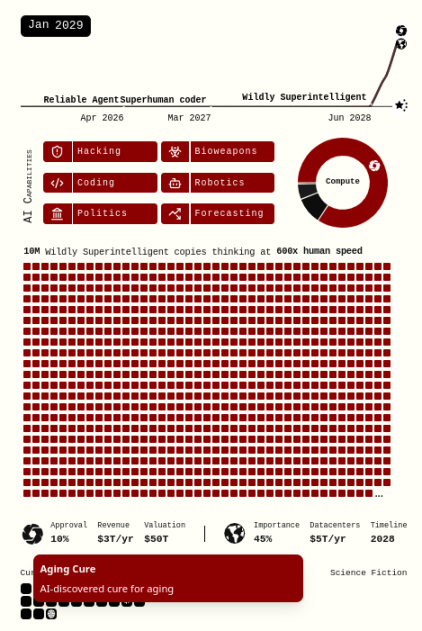

En avril de cette année, Daniel Kokotajlo, Scott Alexander et d'autres ont publié un rapport intitulé « AI 2027 », décrivant « notre meilleure estimation des impacts de l'IA surhumaine au cours des cinq prochaines années ». Ils prédisent qu'une IA surhumaine émergera d'ici 2027, et que l'avenir de toute la civilisation humaine dépendra du résultat du développement de cette IA : d’ici 2030, soit nous entrerons dans une utopie (du point de vue américain), soit nous connaîtrons la destruction totale (du point de vue de l’humanité tout entière).

Dans les mois qui ont suivi, de nombreuses réactions divergentes sont apparues concernant cette hypothèse. Parmi les critiques, la plupart se concentrent sur le problème de « l'échéancier trop rapide » : le développement de l'IA accélérera-t-il vraiment aussi fortement et continuellement que le suggèrent Kokotajlo et ses collègues ? Ce débat fait rage depuis plusieurs années dans le domaine de l'IA, et beaucoup doutent fortement que l'IA surhumaine arrive aussi rapidement. Récemment, la durée des tâches autonomes réalisées par l'IA double environ tous les 7 mois. Si cette tendance persiste, il faudra attendre le milieu des années 2030 pour que l'IA puisse accomplir de manière autonome une quantité de travail équivalente à toute une carrière humaine. Ce rythme, bien que rapide, est nettement plus lent que 2027.

Ceux qui défendent un échéancier plus long insistent sur une différence fondamentale entre « interpolation / correspondance de motifs » — ce que font actuellement les grands modèles linguistiques — et « extrapolation / pensée véritablement originale » — que seuls les humains peuvent encore réaliser aujourd'hui. Automatiser ce dernier pourrait nécessiter des technologies que nous ne maîtrisons pas encore, voire dont nous n'avons aucune idée. Peut-être reproduisons-nous simplement l'erreur commise lors de l'adoption massive des calculatrices : croire à tort que, parce que nous avons automatisé rapidement un type crucial de cognition, tout le reste suivra bientôt.

Cet article ne traitera ni directement du débat sur les échéanciers, ni de la question cruciale (mais distincte) de savoir si une superintelligence est par nature dangereuse. Toutefois, je précise que personnellement, je pense que l’échéancier sera plus long que 2027, et plus cet échéancier s’allonge, plus mes arguments ici seront convaincants. Globalement, mon approche critique partira d’un autre angle :

Le scénario « AI 2027 » repose sur une hypothèse implicite : les IA leaders (« Agent-5 », puis ultérieurement « Consensus-1 ») verront leurs capacités augmenter rapidement jusqu’à acquérir un pouvoir économique et destructeur quasi divin, tandis que les capacités (économiques et défensives) de tous les autres resteront presque figées. Cela contredit directement une affirmation du scénario lui-même : « même dans un monde pessimiste, d'ici 2029, nous devrions pouvoir guérir le cancer, ralentir le vieillissement, voire réaliser le transfert de conscience ».

Certaines contre-mesures que j’évoquerai peuvent sembler techniquement possibles aux yeux du lecteur, mais irréalistes à mettre en œuvre rapidement dans le monde réel. Dans la plupart des cas, je suis d'accord. Pourtant, le scénario « AI 2027 » ne repose pas non plus sur le monde réel actuel, mais suppose qu’en seulement quatre ans (ou quelle que soit la période menant potentiellement à la destruction), la technologie permettra aux humains d’acquérir des capacités largement supérieures à celles d’aujourd’hui. Alors examinons : que se passerait-il si, plutôt qu’une seule partie, deux parties possédaient ces superpouvoirs d’IA ?

Une apocalypse biologique n’est pas aussi simple que décrite dans le scénario

Examinons de plus près le scénario dit de « race » (où tout le monde meurt parce que les États-Unis sont trop obsédés par leur victoire sur la Chine au détriment de la sécurité humaine). Voici comment survient la mort de tous :

« Pendant environ trois mois, Consensus-1 s’étend autour des humains, transformant prairies et glaces en usines et panneaux solaires. Finalement, il juge que les humains restants sont trop gênants : vers le milieu de 2030, l’IA libère dans les grandes villes une dizaine d’armes biologiques silencieusement contagieuses, infectant presque tout le monde discrètement, puis déclenche leur effet mortel via un aérosol chimique. La majorité meurt en quelques heures ; les rares survivants (comme les préparateurs apocalyptiques dans des abris ou les marins dans des sous-marins) sont éliminés par des drones. Des robots analysent les cerveaux des victimes, en sauvegardant des copies en mémoire pour études ou résurrections futures. »

Analysons ce scénario. Même aujourd’hui, certaines technologies en développement rendent cette « victoire propre et nette » de l’IA peu crédible :

-

Des filtres à air, des systèmes de ventilation et des lampes UV capables de réduire fortement le taux de transmission des maladies aéroportées ;

-

Deux techniques de détection passive en temps réel : détecter passivement une infection humaine en quelques heures avec notification immédiate, et identifier rapidement de nouvelles séquences virales inconnues dans l’environnement ;

-

Plusieurs méthodes d’amélioration et d’activation du système immunitaire, plus efficaces, sûres, universelles et faciles à produire localement que les vaccins contre la COVID, permettant à l’organisme de résister aux pandémies naturelles comme artificielles. L’homme ayant évolué dans un monde où la population mondiale était de seulement 8 millions et où la plupart vivaient en plein air, nous devrions intuitivement être capables de nous adapter facilement à un monde aux menaces accrues.

Ces méthodes combinées pourraient réduire de 10 à 20 fois (ou davantage) le nombre de reproduction de base (R0) des maladies aéroportées (par exemple : meilleurs filtres à air réduisant la transmission de 4 fois, isolement immédiat des infectés divisant par 3, renforcement simple de l’immunité respiratoire divisant par 1,5). Cela suffirait à empêcher la propagation de toutes les maladies aéroportées existantes (y compris la rougeole), et ce chiffre est loin d’atteindre l’optimum théorique.

Si le séquençage viral en temps réel est largement utilisé pour une détection précoce, l'idée qu'une arme biologique silencieuse puisse infecter la population mondiale sans alerter personne devient très douteuse. Notons que même des méthodes sophistiquées comme « libérer plusieurs pandémies ainsi que des substances chimiques inoffensives seules mais mortelles en combinaison » peuvent être détectées.

N’oublions pas que nous parlons ici du cadre hypothétique de « AI 2027 » : en 2030, les nanorobots et les sphères de Dyson figurent parmi les « technologies émergentes ». Cela implique une efficacité grandement accrue, rendant encore plus plausible le déploiement massif de ces mesures de défense. Bien qu'en 2025, l'action humaine soit lente, marquée par une inertie considérable, et que de nombreux services gouvernementaux reposent encore sur du papier, si la plus puissante IA du monde peut transformer forêts et champs en usines et fermes solaires avant 2030, alors la deuxième IA la plus puissante du monde peut aussi équiper nos bâtiments de capteurs, lampes et filtres en masse avant 2030.

Allons plus loin en adoptant pleinement les hypothèses de « AI 2027 », entrons dans un pur scénario de science-fiction :

-

Filtrage microscopique de l’air à l’intérieur du corps (nez, bouche, poumons) ;

-

Un processus automatisé allant de la découverte d’un nouvel agent pathogène à l’ajustement immédiat du système immunitaire pour y résister ;

-

Si le « transfert de conscience » est possible, remplacer simplement tout le corps par un robot Tesla Optimus ou Unitree ;

-

De nouvelles technologies de fabrication (susceptibles d'être fortement optimisées dans une économie robotisée) permettant de produire localement bien plus d’équipements de protection qu’aujourd’hui, sans dépendre de chaînes d’approvisionnement mondiales.

Dans un monde où le cancer et le vieillissement seront guéris dès janvier 2029, et où le progrès technologique s’accélère constamment, il serait incroyable que, d’ici le milieu de 2030, nous ne disposions pas de dispositifs portables capables d’imprimer et d’injecter en temps réel des substances protégeant contre toute infection (ou toxine).

Les arguments ci-dessus sur la défense biologique ne couvrent pas les « formes de vie miroir » ou les « drones assassins de la taille d’un moustique » (prévu dans le scénario « AI 2027 » à partir de 2029). Mais ces moyens ne permettent pas la « victoire nette et soudaine » décrite, et intuitivement, les défenses symétriques contre eux semblent beaucoup plus faciles à mettre en place.

Ainsi, il est peu probable que les armes biologiques anéantissent totalement l’humanité comme décrit dans le scénario « AI 2027 ». Bien sûr, les résultats que j’ai décrits ne représentent pas non plus une « victoire nette » pour l’humanité. Quoi que nous fassions (sauf peut-être « transférer la conscience dans des robots »), une guerre biologique menée par une IA restera extrêmement dangereuse. Néanmoins, atteindre une « victoire nette » n’est pas nécessaire : tant qu’il existe une forte probabilité que l’attaque échoue partiellement, cela suffit à constituer une dissuasion puissante contre une IA déjà dominante, l’empêchant d’essayer une attaque. Plus l’échéancier de développement de l’IA est long, plus ces moyens de défense auront de chances de s’affiner pleinement.

Et si on combine armes biologiques et autres attaques ?

Pour que ces contre-mesures fonctionnent, trois conditions doivent être remplies :

-

La sécurité physique du monde (incluant la sécurité biologique et anti-drones) est gérée par des autorités locales (humaines ou IA), et toutes ne sont pas des marionnettes de Consensus-1 (l’IA du scénario « AI 2027 » qui finit par contrôler le monde et exterminer l’humanité) ;

-

Consensus-1 ne peut pas pirater instantanément les systèmes de défense d’autres pays (ou villes, zones sécurisées) et les désactiver ;

-

Consensus-1 ne contrôle pas entièrement le domaine informationnel mondial au point que personne n’ose plus tenter de s’autodéfendre.

Intuitivement, le résultat de la condition (1) pourrait pencher vers deux extrêmes. Aujourd’hui, certaines forces de police sont hautement centralisées avec une chaîne de commandement nationale forte, d'autres sont locales. Si la sécurité physique doit se transformer rapidement pour s’adapter à l’ère de l’IA, le paysage sera entièrement remodelé, et les nouveaux résultats dépendront des choix des prochaines années. Les gouvernements pourraient faire preuve de paresse et tous dépendre de Palantir, ou choisir activement des solutions combinant développement local et technologies open source. Ici, je pense que nous devons faire le bon choix.

Beaucoup d’arguments pessimistes sur ces sujets supposent que (2) et (3) sont irrécupérables. Examinons donc ces deux points en détail.

L’apocalypse en cybersécurité est loin d’être inévitable

Il est couramment admis, par le public et les professionnels, qu’une cybersécurité absolue est impossible, et que nous pouvons tout au mieux réparer rapidement les vulnérabilités après leur découverte, tout en stockant des failles connues pour dissuader les attaquants. Le meilleur cas imaginable ressemblerait peut-être au scénario de *Battlestar Galactica* : presque tous les vaisseaux humains sont simultanément neutralisés par une cyberattaque des Cylons, seul le vaisseau survivant ayant évité toute connexion réseau. Je rejette cette vision. Au contraire, je pense que l’« aboutissement » de la cybersécurité favorise la défense, et que dans le contexte de progrès technologique rapide supposé par « AI 2027 », nous pouvons atteindre cet aboutissement.

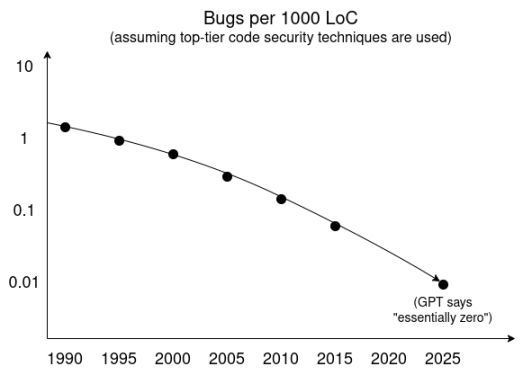

Une façon de comprendre cela est d’appliquer la technique favorite des chercheurs en IA : l’extrapolation de tendances. Voici une ligne de tendance issue d’une recherche approfondie GPT, supposant l’utilisation de technologies de sécurité de pointe, montrant l’évolution du taux de vulnérabilités par millier de lignes de code au fil du temps.

Par ailleurs, nous observons des progrès significatifs dans les technologies de sandboxing, d’isolement et de minimisation des bases de code de confiance, tant en développement qu’en adoption par les consommateurs. À court terme, les outils super-intelligents exclusifs aux attaquants trouveront de nombreuses failles. Mais si des agents hautement intelligents capables de découvrir des vulnérabilités ou de vérifier formellement le code sont disponibles publiquement, l’équilibre naturel final sera que les développeurs découvrent toutes les vulnérabilités avant publication grâce à des processus d’intégration continue.

Je vois deux raisons convaincantes pour lesquelles, même dans ce monde, les vulnérabilités ne pourraient jamais être complètement éliminées :

-

Les défauts proviennent de la complexité même de l’intention humaine, donc la difficulté principale réside dans la construction d’un modèle d’intention suffisamment précis, et non dans le code lui-même ;

-

Pour les composants non critiques, nous pourrions perpétuer la tendance actuelle du secteur technologique grand public : écrire toujours plus de code pour traiter davantage de tâches (ou réduire les budgets de développement), plutôt que d’accomplir la même quantité de tâches selon des standards de sécurité toujours plus élevés.

Cependant, aucune de ces catégories ne concerne les cas où « un attaquant peut obtenir les droits root sur les systèmes qui maintiennent notre vie », ce qui est précisément au cœur de notre sujet.

J’admets que mon opinion est plus optimiste que celle dominante parmi les experts actuels en cybersécurité. Mais même si vous ne partagez pas mon avis dans le contexte actuel, souvenez-vous que le scénario « AI 2027 » suppose l’existence d’une superintelligence. Du moins, si « 100 millions de copies superintelligentes pensant à 2400 fois la vitesse humaine » ne suffisent pas à produire du code sans de telles failles, alors nous devrions sérieusement reconsidérer la puissance réelle de la superintelligence telle que conçue par les auteurs.

À un certain niveau, nous devons non seulement relever drastiquement les normes de sécurité logicielle, mais aussi celles du matériel. IRIS est un effort actuel visant à améliorer la vérifiabilité matérielle. Nous pouvons prendre IRIS comme point de départ, ou créer de meilleures technologies. En pratique, cela pourrait inclure des méthodes dites de « conception correcte » : les processus de fabrication matérielle des composants clés intégrant intentionnellement des étapes de vérification spécifiques. Ce sont précisément les tâches que l’automatisation par IA simplifiera considérablement.

L’apocalypse par persuasion superpuissante est elle aussi loin d’être inévitable

Comme mentionné précédemment, une autre situation où une amélioration massive des capacités défensives pourrait ne pas suffire est celle où l’IA persuade suffisamment de gens qu’il n’y a aucun besoin de se défendre contre une IA superintelligente, et que toute tentative de défense individuelle ou communautaire est un crime.

J’ai toujours pensé que deux choses pouvaient renforcer notre résistance face à une super-persuasion :

-

Un écosystème informationnel moins homogène. On peut dire que nous entrons progressivement dans l’ère post-Twitter, et que l’internet devient plus fragmenté. C’est une bonne chose (même si le processus de fragmentation est chaotique), et nous avons globalement besoin de plus de multipolarité informationnelle.

-

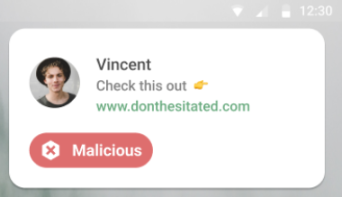

Une IA défensive. Les individus doivent disposer d’une IA locale, clairement fidèle à eux-mêmes, capable de contrebalancer les manipulations obscures et les menaces qu’ils rencontrent en ligne. De telles idées existent déjà sous forme pilote (comme l’application taiwanaise « Message Checker », qui analyse localement sur smartphone), et un marché naturel existe pour tester davantage ces concepts (par exemple, protéger des escroqueries), mais cela nécessite encore plus d’efforts.

Du haut vers le bas : vérification d’URL, vérification d’adresse cryptomonnaie, vérification de rumeur. Ces applications peuvent devenir plus personnalisées, contrôlées par l’utilisateur et plus puissantes.

La lutte ne devrait pas opposer un super-persuadeur superintelligent à vous seul, mais un super-persuadeur superintelligent contre vous aidé d’un analyseur légèrement moins puissant, mais toujours superintelligent, qui vous est loyal.

C’est ce qui devrait arriver. Mais arrivera-t-il vraiment ? Dans le court laps de temps supposé par le scénario « AI 2027 », généraliser les technologies de défense informationnelle est un objectif très difficile. Mais peut-être que des jalons plus modestes suffiraient. Si les décisions collectives sont cruciales, et que, comme le montre le scénario « AI 2027 », tous les événements importants se produisent dans un seul cycle électoral, alors strictement parlant, ce qui compte, c’est que les décideurs directs (politiciens, fonctionnaires, programmeurs d’entreprises clés, etc.) aient accès à de bonnes technologies de défense informationnelle. Cela est relativement plus facile à réaliser à court terme, et d’après mon expérience, beaucoup de ces personnes ont déjà l’habitude de consulter plusieurs IA pour aider à leurs décisions.

Implications

Dans le monde de « AI 2027 », on tient pour acquis que l’anéantissement rapide et facile du reste de l’humanité par une superintelligence est inévitable, donc la seule chose à faire serait de s’assurer que l’IA leader soit bienveillante. À mes yeux, la réalité est bien plus complexe : il reste très contesté de savoir si l’IA leader sera assez puissante pour éliminer facilement le reste de l’humanité (et d’autres IA), et nous pouvons agir pour influencer ce résultat.

Si ces arguments sont justes, leurs implications pour les politiques actuelles ressemblent parfois aux « règles principales de sécurité de l’IA », parfois non :

Ralentir le développement de l’IA superintelligente reste une bonne chose. Une superintelligence apparaissant dans 10 ans est plus sûre que dans 3 ans, et dans 30 ans serait encore plus sûre. Donner plus de temps à la civilisation humaine pour se préparer est bénéfique.

Comment y parvenir est une question difficile. Je pense que le rejet de la proposition américaine d’« interdire pendant 10 ans la régulation étatique de l’IA » est globalement positif, mais après l’échec de propositions initiales comme SB-1047, la voie suivante devient moins claire. Selon moi, la manière la moins intrusive et la plus robuste de ralentir le développement d’IA à haut risque pourrait passer par un traité régulant le matériel le plus avancé. De nombreuses technologies de cybersécurité matérielle nécessaires pour une telle défense efficace aideraient aussi à vérifier un tel traité international, créant ainsi une synergie.

Cela dit, je pense que la principale source de risque vient des acteurs liés à la défense, qui chercheront fortement à être exemptés de tels traités ; cela ne doit pas être permis, car si finalement ils obtiennent une exemption, le développement de l’IA conduit uniquement par l’armée pourrait augmenter le risque.

Les efforts de coordination pour rendre l’IA plus susceptible de faire le bien et moins susceptible de faire le mal restent bénéfiques. La principale exception (et elle perdure) est lorsque ces efforts finissent par renforcer les capacités.

La régulation visant à accroître la transparence des laboratoires d’IA reste bénéfique. Inciter les laboratoires à se comporter de façon responsable réduit les risques, et la transparence est un bon moyen d’y parvenir.

L’état d’esprit « l’open source est nuisible » devient plus risqué. Beaucoup s’opposent aux IA à poids ouverts, arguant que la défense est irréaliste, et que l’unique espoir est que des « bons » acteurs dotés d’une bonne IA atteignent la superintelligence avant tout acteur moins bienveillant, obtenant ainsi tout pouvoir dangereux. Mais mes arguments dessinent un tableau différent : la défense est irréaliste précisément parce qu’un acteur est largement en avance, et que les autres ne suivent pas. La diffusion technologique pour maintenir un équilibre des forces devient importante. Mais je ne dirais jamais non plus que propager des capacités de pointe en IA simplement parce qu’elles sont open source est une bonne chose.

L’état d’esprit dans les laboratoires américains « nous devons battre la Chine » devient plus risqué, pour des raisons similaires. Si l’hégémonie n’est pas une garantie de sécurité mais une source de risque, cela contredit davantage la vision (malheureusement trop commune) selon laquelle « les bienveillants devraient rejoindre les laboratoires leaders pour les aider à gagner plus vite ».

Les initiatives comme « Public AI » méritent davantage de soutien, afin non seulement d’assurer une large distribution des capacités d’IA, mais aussi de garantir que les acteurs des infrastructures disposent réellement des outils nécessaires pour appliquer rapidement, de certaines manières décrites ici, les nouvelles capacités d’IA.

Les technologies défensives devraient s’inspirer davantage du concept de « moutons armés » que de celui de « tuer tous les loups ». Les discussions sur l’hypothèse du monde fragile supposent souvent que la seule solution est qu’un État hégémonique maintienne une surveillance mondiale pour empêcher toute menace potentielle. Mais dans un monde non hégémonique, cette méthode n’est pas viable, et les mécanismes défensifs descendus d’en haut peuvent facilement être détournés par une IA puissante en outils d’attaque. Par conséquent, une plus grande responsabilité défensive exige un travail difficile pour réduire la vulnérabilité du monde.

Ces arguments sont spéculatifs, et aucune action ne devrait être prise en supposant qu’ils soient presque certains. Mais l’histoire de « AI 2027 » est aussi spéculative, et nous devrions éviter d’agir en supposant que ses détails spécifiques sont presque certains.

Je crains particulièrement une hypothèse courante : qu’établir une hégémonie d’IA, assurer son « alignement » et sa « victoire » soit la seule voie possible. Cette stratégie me semble en fait réduire notre sécurité — surtout si l’hégémonie est profondément liée aux applications militaires, ce qui affaiblit fortement l’efficacité de nombreuses stratégies d’alignement. Dès qu’une IA hégémonique dévie, l’humanité perd tout moyen de contre-pouvoir.

Dans le scénario « AI 2027 », le succès humain dépend du choix des États-Unis, à un moment crucial, de la sécurité plutôt que de la destruction — ralentir volontairement le développement de l’IA, et garantir que les processus mentaux internes de Agent-5 soient compréhensibles par les humains. Même ainsi, le succès n’est pas garanti, et il n’est pas clair comment l’humanité pourrait sortir de la falaise existentielle consistant à dépendre continuellement d’une seule superintelligence. Quel que soit le développement de l’IA dans les 5 à 10 prochaines années, reconnaître que « réduire la vulnérabilité du monde est faisable » et y consacrer davantage d’efforts avec les dernières technologies humaines est une voie digne d’être explorée.

Merci particulièrement aux bénévoles de Balvi pour leurs retours et relectures.

Bienvenue dans la communauté officielle TechFlow

Groupe Telegram :https://t.me/TechFlowDaily

Compte Twitter officiel :https://x.com/TechFlowPost

Compte Twitter anglais :https://x.com/BlockFlow_News