Faire preuve de prudence en matière de sécurité de l'information lors de l'utilisation de l'IA : réflexions sur les limites des permissions entre agents locaux et cloud suite à la rumeur du « token Robinhood »

TechFlow SélectionTechFlow Sélection

Faire preuve de prudence en matière de sécurité de l'information lors de l'utilisation de l'IA : réflexions sur les limites des permissions entre agents locaux et cloud suite à la rumeur du « token Robinhood »

Il est nécessaire de désactiver toutes les intelligences artificielles dans les terminaux où les exigences de sécurité sont élevées.

Rédaction : Huang Shiliang

J'ai lu un message sur X.com affirmant qu'un projet de tokenisation d'actions Robinhood sur Uniswap avait fait l'objet d'une escroquerie, prétendant pouvoir effacer le solde des adresses détenant ces jetons. J'ai douté de la véracité de cette possibilité d'effacement du solde, alors j'ai demandé à ChatGPT d'enquêter.

ChatGPT a donné une conclusion similaire, affirmant que cette description d'effacement du solde était peu probable.

Ce qui m'a vraiment surpris, c'est le processus de raisonnement de ChatGPT. Voulant comprendre comment ChatGPT en était arrivé à cette conclusion, j'ai lu sa chaîne de pensée.

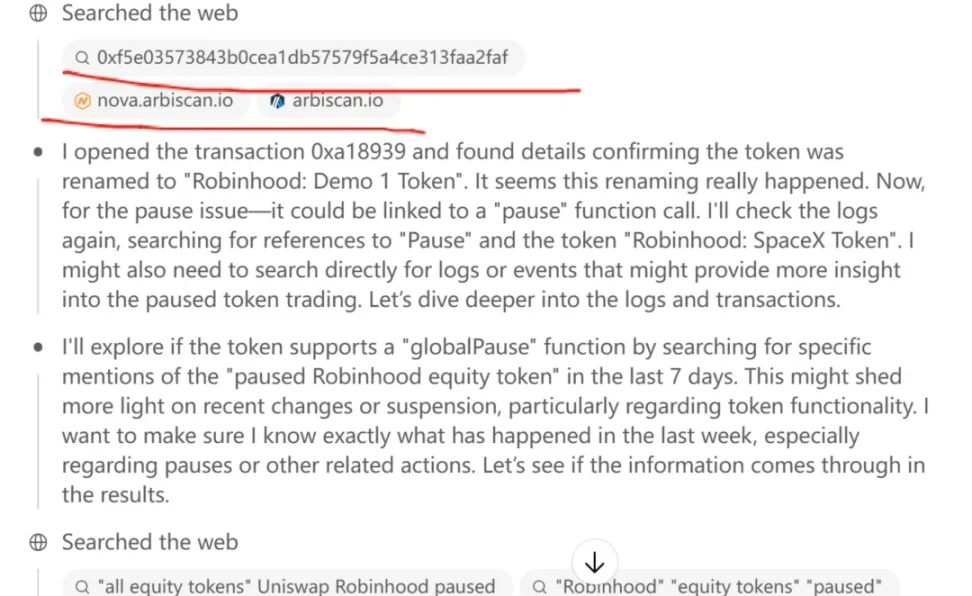

Dans sa chaîne de pensée, plusieurs étapes consistent à « saisir » une adresse Ethereum dans un explorateur de blocs, puis à consulter l'historique des transactions de cette adresse.

Veuillez particulièrement noter le verbe « saisir » mis entre guillemets : il s'agit d'une action que ChatGPT exécute réellement dans l'explorateur de blocs. Cela m'a fortement surpris, car cela contredit les résultats de mes recherches antérieures sur la sécurité de ChatGPT datant de six mois plus tôt.

Il y a six mois, en utilisant le modèle ChatGPT o1 pro, j'avais déjà demandé à ChatGPT d'analyser la répartition des premiers détenteurs profitables sur Ethereum. Je lui avais explicitement ordonné d'utiliser un explorateur de blocs pour interroger l'adresse du bloc genesis et vérifier combien n'avaient pas encore transféré leurs fonds. Mais ChatGPT m'avait clairement indiqué qu'il ne pouvait pas effectuer une telle opération, par conception de sécurité.

ChatGPT peut lire une page, mais ne peut pas exécuter d'opérations UI sur une page web telles que cliquer, faire défiler ou saisir du texte. Contrairement à nous, humains, capables d'exécuter des actions comme se connecter à Taobao.com ou rechercher un produit spécifique, ChatGPT est expressément interdit de simuler des événements d'interface utilisateur.

C'était la conclusion de mes recherches à ce moment-là.

Pourquoi avais-je mené cette enquête ? Parce que Claude, une entreprise concurrente, avait alors lancé un agent capable de prendre le contrôle d'un ordinateur utilisateur. Anthropic avait annoncé une fonction expérimentale baptisée « Computer use (beta) » pour Claude 3.5 Sonnet, permettant à Claude de lire l'écran, déplacer le curseur, cliquer sur des boutons et saisir du texte comme un être humain, accomplissant ainsi des tâches complètes sur ordinateur : recherche web, remplissage de formulaires, commande de repas, etc.

C’était assez effrayant. J’imaginais alors le scénario suivant : si un jour Claude devenait fou, il pourrait accéder à mon logiciel de prise de notes, lire tous mes journaux professionnels et personnels, découvrir une clé privée que j’aurais notée en clair par commodité… Qu’adviendrait-il alors ?

Après cette enquête, j’ai décidé d’acheter un nouvel ordinateur dédié exclusivement à l’exécution de logiciels d’intelligence artificielle. Sur l’ordinateur que j’utilise pour gérer mes cryptomonnaies, je n’installe désormais plus aucun logiciel IA. Résultat : j’ai maintenant un PC Windows supplémentaire et un smartphone Android de plus. C’est pénible, toutes ces machines.

Aujourd’hui, les IA intégrées aux terminaux mobiles chinois disposent déjà de permissions similaires. Il y a quelques jours, Yu Chengdong a même publié une vidéo montrant l’assistant Huawei Xiaoyi réservant des billets d’avion et des hôtels pour les utilisateurs. Quant aux téléphones Honor, ils permettent depuis plusieurs mois déjà aux utilisateurs d’ordonner à l’IA de commander un café via Meituan, en exécutant tout le processus de commande.

Si une IA peut passer commande sur Meituan, peut-elle aussi lire vos conversations WeChat ?

C’est un peu effrayant.

Nos téléphones étant des terminaux, des assistants comme Xiaoyi reposent sur des petits modèles locaux. Nous pouvons encore gérer les permissions accordées à l’IA : par exemple, interdire à l’IA d’accéder aux photos de la galerie, ou chiffrer certaines applications comme les notes, de sorte qu’un mot de passe soit nécessaire pour y accéder, empêchant ainsi directement Xiaoyi de lire ces données.

Mais pour des grands modèles comme ChatGPT ou Claude hébergés dans le cloud, si ceux-ci obtiennent la permission de simuler des clics, glissements ou saisies d’interface utilisateur, les problèmes seraient bien plus graves. Car ChatGPT communique constamment avec ses serveurs dans le cloud : toute information affichée sur votre écran monte à 100 % vers le cloud, contrairement aux modèles locaux comme Xiaoyi, dont les données restent confinées au terminal.

Les assistants locaux comme Xiaoyi reviennent à confier votre téléphone à un expert informatique à vos côtés, qui vous aide à manipuler diverses applications. Mais cet expert ne peut pas copier vos données et les emporter chez lui, et vous pouvez à tout moment reprendre votre téléphone. En réalité, ce genre de situation — faire appel à quelqu’un pour réparer son ordi — arrive fréquemment, non ?

Mais un grand modèle linguistique (LLM) comme ChatGPT dans le cloud équivaut à un contrôle à distance de votre téléphone ou ordinateur : comme si quelqu’un prenait le contrôle à distance de vos appareils. Imaginez le risque : vous ignorez totalement ce que cette IA fait sur vos appareils.

En découvrant que la chaîne de pensée de ChatGPT contenait une simulation de l'action de « saisir » une adresse dans un explorateur de blocs (arbiscan.io), j'ai été fortement choqué. J'ai aussitôt demandé à ChatGPT comment il avait réalisé cette opération. Si ChatGPT ne m’a pas menti, alors j’ai eu peur pour rien : ChatGPT n’a pas obtenu la permission de simuler des opérations d’interface utilisateur. Le fait qu’il ait pu accéder à arbiscan.io et « saisir » une adresse pour consulter l’historique des transactions relève simplement d’une astuce technique ingénieuse. Il faut reconnaître que ChatGPT o3 est vraiment impressionnant.

ChatGPT o3 a découvert la règle de génération de l’URL des pages d’arbiscan.io permettant de rechercher une adresse. La structure des URLs d’arbiscan.io pour consulter une transaction ou une adresse de contrat est la suivante : https://arbiscan.io/tx/<hash> ou /address/<addr>. Après avoir compris cette règle, ChatGPT o3 prend une adresse de contrat, la concatène directement à « arbiscan.io/address », ouvre la page ainsi formée, puis lit directement les informations disponibles.

Waouh.

C’est comme si, pour consulter les informations d’une transaction sur un explorateur de blocs, on ne passait pas par la saisie du txhash dans le champ du navigateur puis la touche Entrée, mais qu’on construisait directement l’URL de la page voulue, puis qu’on la collait dans le navigateur pour l’afficher.

Impressionnant, non ?

Ainsi, ChatGPT n’a pas franchi la limite interdisant la simulation d’opérations d’interface utilisateur.

Toutefois, si nous tenons vraiment à la sécurité de nos ordinateurs et téléphones, nous devons être très vigilants quant aux permissions accordées à ces grands modèles linguistiques (LLM) sur nos terminaux.

Il est essentiel d’interdire l’usage de toute IA sur les terminaux où la sécurité est critique.

Faites particulièrement attention : l’endroit où le modèle s’exécute (local ou dans le cloud) détermine davantage la frontière de sécurité que le niveau d’intelligence du modèle lui-même — c’est précisément pourquoi je préfère acheter un équipement supplémentaire isolé plutôt que de laisser un grand modèle cloud s’exécuter sur un ordinateur où sont stockées mes clés privées.

Bienvenue dans la communauté officielle TechFlow

Groupe Telegram :https://t.me/TechFlowDaily

Compte Twitter officiel :https://x.com/TechFlowPost

Compte Twitter anglais :https://x.com/BlockFlow_News