Nouvel article de Vitalik : Comment l'IA et la cryptographie transforment-elle la vie privée ?

TechFlow SélectionTechFlow Sélection

Nouvel article de Vitalik : Comment l'IA et la cryptographie transforment-elle la vie privée ?

La vie privée, c'est la liberté.

Rédaction : Vitalik Buterin, fondateur d'Ethereum

Traduction : Baishui, Jinse Finance

Merci particulièrement aux bénévoles de Balvi Paul Dylan-Ennis, pcaversaccio, vectorized, Bruce Xu et Luozhu Zhang pour leurs discussions et retours.

Récemment, je me suis de plus en plus préoccupé par l'amélioration de la situation de la confidentialité dans l'écosystème Ethereum. La confidentialité est une garantie essentielle de la décentralisation : qui détient l'information détient le pouvoir, donc nous devons éviter un contrôle centralisé de l'information. Dans le monde réel, les inquiétudes concernant les infrastructures technologiques centralisées portent parfois sur le fait que les opérateurs pourraient accidentellement modifier les règles ou supprimer des utilisateurs, mais tout aussi souvent, elles concernent la collecte de données. Bien que le domaine des cryptomonnaies ait vu le jour à partir de projets comme Ecash de Chaum, qui plaçaient la protection de la vie privée financière numérique au premier plan, il a dernièrement sous-estimé la confidentialité — une erreur fondamentalement due au fait qu'avant l'apparition des ZK-SNARK, nous ne pouvions pas offrir de protection de la vie privée de manière décentralisée, alors nous avons minimisé son importance et nous sommes concentrés sur d'autres garanties que nous pouvions fournir à l'époque.

Cependant, aujourd'hui, la confidentialité ne peut plus être ignorée. L'intelligence artificielle renforce considérablement les capacités de collecte et d'analyse centralisées des données, tout en élargissant grandement la gamme de données que nous partageons volontairement. À l'avenir, de nouvelles technologies telles que les interfaces cerveau-machine poseront davantage de défis : nous pourrions vraiment parler d'une IA capable de lire nos pensées. Parallèlement, nous disposons d'outils bien plus puissants que ceux imaginés par les cypherpunks des années 1990 pour protéger la confidentialité, notamment dans le domaine numérique : les preuves à divulgation nulle de connaissance efficaces (ZK-SNARK) peuvent révéler suffisamment d'informations pour prouver notre fiabilité tout en protégeant notre identité ; le chiffrement homomorphe complet (FHE) permet de calculer sur des données sans les voir ; et les techniques d'obfuscation pourraient bientôt offrir encore plus de fonctionnalités.

La confidentialité ne signifie pas s'isoler les uns des autres, mais s'unir ensemble.

À ce stade, il convient de revenir sur cette question : pourquoi avons-nous besoin de confidentialité ? Chacun y répond différemment. Dans cet article, je donnerai ma propre réponse, divisée en trois parties :

-

La confidentialité, c’est la liberté : elle nous donne l’espace nécessaire pour vivre selon nos besoins, sans avoir constamment à craindre comment nos actions seront perçues dans divers jeux politiques et sociaux.

-

La confidentialité, c’est l’ordre : de nombreux mécanismes fondamentaux du fonctionnement social dépendent de la confidentialité pour fonctionner correctement.

-

La confidentialité, c’est le progrès : si nous trouvons de nouveaux moyens de partager sélectivement des informations tout en les protégeant contre les abus, nous libérerons une immense valeur et accélérerons le progrès technologique et social.

La confidentialité, c'est la liberté

Au début des années 2000, une idée similaire à celle exposée par David Brin en 1998 dans son livre *La Société transparente* était largement répandue : la technologie rendrait l'information plus transparente partout dans le monde. Bien que cela entraîne certains inconvénients nécessitant adaptation continue, cela restait globalement très positif, et on pouvait rendre cela plus équitable en permettant aux citoyens de surveiller (ou plutôt, contrôler) le gouvernement. En 1999, Scott McNealy, PDG de Sun Microsystems, lança sa célèbre déclaration : « La vie privée est morte, acceptez-le ! » Ce type de mentalité était très courant lors de la conception initiale et du développement de Facebook, où les pseudonymes étaient interdits. Je me souviens personnellement avoir entendu, lors d’un événement Huawei à Shenzhen en 2015, un conférencier (occidental) mentionner incidemment « la vie privée est morte », illustrant parfaitement la fin de cette mentalité.

« La société transparente » représentait le meilleur et le plus lumineux avenir que l'idéologie de la transparence pouvait offrir : promettant un monde meilleur, plus juste et plus équitable, utilisant la transparence pour tenir les gouvernements responsables plutôt que d'opprimer les individus et minorités. Rétrospectivement, même cette idée semble clairement être le produit de son temps, écrite au sommet de l'euphorie de la coopération mondiale, de la paix et de la « fin de l'histoire », reposant sur plusieurs hypothèses excessivement optimistes sur la nature humaine :

-

Les élites politiques mondiales seraient généralement bienveillantes et rationnelles, rendant ainsi la confidentialité verticale (ne pas divulguer d'informations aux personnes ou institutions puissantes) de moins en moins nécessaire. Les abus de pouvoir seraient limités localement, donc la meilleure façon de les combattre serait de les exposer à la lumière du jour.

-

La culture progresserait continuellement jusqu'à ce que la confidentialité horizontale (ne pas divulguer d'informations aux autres membres du public) devienne inutile. Les intellos, les homosexuels, et finalement tous les autres pourraient sortir du placard, car la société cesserait de juger sévèrement les particularités des individus, devenant plus ouverte et inclusive.

Aujourd'hui, aucun grand pays ne considère universellement la première hypothèse comme correcte, et plusieurs grands pays la jugent clairement fausse. Quant à la seconde, l'inclusion culturelle recule rapidement – une simple recherche Twitter sur des phrases comme « l'intimidation, c'est bien » en témoigne, bien que de nombreuses autres preuves soient facilement trouvables.

J'ai personnellement malheureusement souvent subi les inconvénients de la « société transparente », chaque action que je fais à l'extérieur pouvant devenir involontairement une information publique relayée par les médias :

Le pire fut une vidéo d’une minute filmée alors que j’utilisais mon ordinateur portable à Chiang Mai, publiée ensuite sur Xiaohongshu, obtenant immédiatement des dizaines de milliers de likes et de partages. Bien sûr, mon cas personnel est loin d'être la norme humaine – mais la vie privée a toujours été ainsi : ceux dont la situation est relativement normale ont moins besoin de confidentialité, tandis que ceux dont la situation s’écarte de la norme en ont davantage besoin, peu importe la direction. Une fois que vous additionnez toutes les directions importantes, le nombre de personnes ayant vraiment besoin de confidentialité devient considérable – vous ne savez jamais quand vous pourriez en faire partie. C’est aussi une raison majeure pour laquelle la vie privée est si souvent sous-estimée : elle ne concerne pas seulement votre situation actuelle et vos informations, mais aussi l’inconnu quant à ce que ces informations deviendront à l’avenir (et comment elles vous affecteront).

Aujourd’hui, même parmi les partisans de l’IA, la confidentialité des mécanismes tarifaires des entreprises reste un sujet marginal, mais avec l’émergence des outils d’analyse basés sur l’IA, cela pourrait devenir un problème croissant : plus une entreprise en sait sur vous, plus elle peut vous proposer des prix personnalisés afin de maximiser ses profits multipliés par la probabilité que vous payiez.

Je peux résumer mon argument général sur la confidentialité comme liberté en une phrase :

La confidentialité vous permet de vivre librement de la manière qui correspond le mieux à vos objectifs et besoins personnels, sans devoir constamment équilibrer chaque action entre « le jeu privé » (vos propres besoins) et « le jeu public » (la manière dont divers autres, via divers mécanismes incluant les cascades des médias sociaux, les incitations commerciales, la politique, les institutions, etc., percevront et réagiront à vos actions).

Sans confidentialité, tout devient un combat incessant centré sur la question : « Comment les autres (et les robots) vont-ils percevoir ce que je fais ? » – que ce soit par les puissants, les entreprises ou les pairs, maintenant ou à l’avenir. Avec la confidentialité, nous pouvons maintenir un équilibre. Aujourd’hui, cet équilibre est rapidement érodé, surtout dans le monde physique. Le chemin par défaut du capitalisme technologique moderne, avide de trouver un modèle économique permettant d’extraire de la valeur des utilisateurs sans frais explicites, érode davantage cet équilibre (jusqu’à pénétrer des domaines hautement sensibles, voire nos propres pensées). Nous devons donc contrer cet effet, soutenir explicitement la confidentialité, surtout là où nous pouvons le faire concrètement : dans le domaine numérique.

Mais pourquoi ne pas autoriser une porte dérobée aux gouvernements ?

Une réponse courante face à ce raisonnement est la suivante : les inconvénients de la vie privée que je décris proviennent largement de la connaissance excessive du public sur notre vie privée, et même en cas d’abus, ils sont dus à une connaissance excessive par les entreprises, patrons et politiciens. Mais nous ne donnons pas toutes ces données au public, aux entreprises, aux patrons ou aux politiciens. Au contraire, nous permettons à un petit groupe de professionnels des forces de l’ordre, soigneusement formés et rigoureusement sélectionnés, d’accéder aux données provenant des caméras de surveillance urbaines, des câbles Internet et des écoutes des applications de messagerie, sous un cadre strict de responsabilité, afin que personne d’autre ne puisse les voir.

Cette position silencieuse mais largement tenue doit être explicitement traitée. Même mise en œuvre avec les meilleures intentions et des standards élevés, cette stratégie comporte une instabilité intrinsèque, pour plusieurs raisons :

-

En réalité, non seulement les gouvernements, mais aussi de nombreuses entités commerciales font face à des risques de fuites de données, avec des niveaux de sécurité variables. Dans les systèmes financiers traditionnels, les informations KYC et de paiement sont détenues par des processeurs de paiement, banques et autres intermédiaires. Les fournisseurs de messagerie consultent d’immenses volumes de données. Les opérateurs télécoms connaissent votre localisation et revendent illégalement régulièrement ces données. Globalement, réguler strictement toutes ces entités pour qu’elles prennent réellement au sérieux les données des utilisateurs exige une énorme énergie, tant pour les surveillants que les surveillés, ce qui pourrait entrer en conflit avec un marché libre compétitif.

-

Les individus ayant accès aux données seront toujours tentés de les utiliser abusivement (y compris en les vendant à des tiers). En 2019, plusieurs employés de Twitter ont été inculpés, puis condamnés, pour avoir vendu les données personnelles de dissidents saoudiens.

-

Les données peuvent toujours être piratées. En 2024, les données collectées légalement par un opérateur américain ont été piratées, apparemment par des hackers chinois. En 2025, de vastes données sensibles détenues par le gouvernement ukrainien ont été piratées par des hackers russes. Inversement, des bases gouvernementales et commerciales chinoises hautement sensibles ont également été piratées, notamment par le gouvernement américain.

-

Les régimes peuvent changer. Un gouvernement digne de confiance aujourd’hui peut ne plus l’être demain. Ceux au pouvoir aujourd’hui peuvent être persécutés demain. Une institution policière respectueuse et irréprochable aujourd’hui pourrait devenir, dix ans plus tard, un instrument sadique et cruel.

D’un point de vue personnel, si leurs données sont volées, les individus ne peuvent pas anticiper à quel moment ni comment elles seront abusées à l’avenir. Jusqu’à présent, la méthode la plus sûre pour gérer les données à grande échelle consiste à limiter dès le départ leur concentration. Les données doivent être autant que possible détenues par les utilisateurs eux-mêmes, et les statistiques utiles doivent être agrégées via des méthodes cryptographiques sans compromettre la vie privée.

L’argument selon lequel les gouvernements devraient avoir le droit d’accéder à toute information sur mandat ignore un point crucial : historiquement, la quantité d’information accessible sur mandat était bien inférieure à ce qu’elle est aujourd’hui, voire inférieure à ce qu’elle serait même avec les mesures de protection de la vie privée les plus strictes. Au XIXe siècle, chaque personne effectuait en moyenne une seule conversation orale, jamais enregistrée par personne. Ainsi, la panique morale autour de la « confidentialité des informations » va à l’encontre de l’histoire : pendant des millénaires, les conversations ordinaires, même les transactions financières, ont été entièrement et inconditionnellement privées.

Une conversation ordinaire en 1950. Hormis les participants présents au moment de la discussion, personne n’a jamais enregistré, surveillé, « intercepté légalement », analysé par IA ou autrement consulté cette conversation à aucun moment.

Un autre motif important pour limiter la collecte centralisée de données est que la majeure partie des interactions économiques et communicationnelles mondiales est intrinsèquement internationale. Si tout le monde vivait dans le même pays, on pourrait au moins affirmer que le « gouvernement » aurait le droit d'accéder aux données de leurs interactions. Mais si les gens sont dans différents pays ? En théorie, on pourrait concevoir une solution « super-cerveau galactique » attribuant chaque donnée à une entité légale responsable – bien que même ainsi, il faille gérer de nombreux cas limites impliquant des données multiples. Mais même si c’était faisable, ce n’est pas le résultat par défaut de la réalité. Le résultat réel par défaut des portes dérobées gouvernementales est une concentration des données dans quelques juridictions centrales, contrôlant les données de tous parce qu’elles contrôlent les applications – fondamentalement, une hégémonie technologique mondiale. Une forte confidentialité est à ce jour la solution alternative la plus stable.

La confidentialité, c’est l’ordre

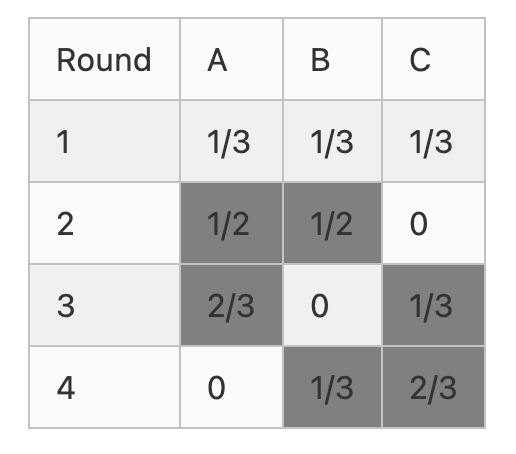

Depuis plus d’un siècle, on reconnaît qu’un élément technique clé du bon fonctionnement des démocraties est le vote secret : personne ne sait pour qui vous avez voté, et même si vous vouliez le prouver, vous ne pourriez pas le démontrer à quiconque. Sans le vote secret par défaut, les électeurs feraient face à diverses incitations annexes influençant leur vote : corruption, promesses de récompenses rétroactives, pression sociale, menaces, etc.

Un simple argument mathématique montre que ces incitations annexes détruisent complètement la démocratie : dans une élection de N personnes, la probabilité que vous influenciez le résultat est environ 1/N, donc toute considération sur la supériorité d’un candidat est divisée par N. En revanche, les « jeux annexes » (corruption, coercition, pression sociale) affectent directement l’individu selon son vote (pas selon le résultat global), donc ils ne sont pas divisés par N. Ainsi, sauf si ces jeux annexes sont strictement contrôlés, ils dominent par défaut l’ensemble du jeu, noyant toute considération sur la qualité réelle des politiques des candidats.

Cela ne s’applique pas uniquement aux démocraties nationales. Théoriquement, cela concerne presque tous les problèmes de principal-agent dans les entreprises ou gouvernements :

-

Les juges décident comment trancher des affaires

-

Les fonctionnaires décident avec quelle entreprise signer des contrats ou accorder des subventions

-

Les agents d’immigration décident d’émettre ou refuser des visas

-

Les employés des réseaux sociaux décident comment appliquer les politiques de modération

-

Les employés d’entreprise participent aux décisions commerciales (ex : choix du fournisseur)

Le problème fondamental est le même dans tous les cas : si l’agent agit honnêtement, il ne tire qu’une petite fraction du bénéfice de ses actions pour l’entité qu’il représente ; s’il suit les incitations d’un jeu annexe, il en obtient la totalité. Ainsi, même aujourd’hui, nous avons besoin d’une grande dose de bonne volonté morale pour empêcher que toutes nos institutions soient englouties par un chaos de jeux annexes mutuellement destructeurs. Si la confidentialité est encore affaiblie, ces jeux annexes deviendront plus puissants, et la bonne volonté morale nécessaire pour maintenir la société pourrait devenir irréaliste.

Peut-on redessiner les systèmes sociaux pour éviter ce problème ? Malheureusement, la théorie des jeux indique presque clairement que c’est impossible (sauf dans un cas : la dictature totale). Dans la version de la théorie des jeux axée sur les choix individuels – supposant que chaque participant décide indépendamment, sans possibilité de coordination entre groupes d’agents pour un intérêt commun – les concepteurs de mécanismes ont une grande liberté pour « concevoir » le jeu vers des résultats spécifiques. Il existe même des preuves mathématiques affirmant que tout jeu possède au moins un équilibre de Nash stable, rendant l’analyse de tels jeux traitable. Mais dans la version coopérative de la théorie des jeux, où les coalitions (« collusion ») sont possibles, on peut prouver qu’il existe de nombreux jeux sans aucun résultat stable (appelé « cœur »). Dans de tels jeux, quelle que soit la situation actuelle, certaines coalitions peuvent toujours tirer profit en changeant d’orientation.

Si l’on prend au sérieux les mathématiques, on en conclut que la seule manière d’établir des structures sociales stables est de limiter le niveau de coordination possible entre participants – ce qui signifie une forte confidentialité (incluant la possibilité de nier). Si l’on ne prend pas les mathématiques au sérieux, observer le monde réel, ou simplement imaginer à quoi ressembleraient les situations ci-dessus si les jeux marginaux prenaient le dessus, conduit à la même conclusion.

Notez que cela soulève un autre argument contre les portes dérobées gouvernementales. Si chacun pouvait coordonner avec les autres sur tout, le résultat serait le chaos. Mais si seuls quelques-uns peuvent le faire grâce à un accès privilégié à l’information, alors ils dominent. Qu’un parti politique ait une porte dérobée sur les communications d’un autre parti signifie facilement la fin de la viabilité du multipartisme.

Un autre exemple important d’ordre social dépendant de la limitation de la collusion est celui des activités intellectuelles et culturelles. Participer à ces activités est fondamentalement un acte altruiste motivé par des raisons internes : il est difficile de créer des incitations externes visant à contribuer positivement à la société, précisément parce que ces activités déterminent en partie ce que la société juge comme un comportement positif. On peut mettre en place des incitations commerciales et sociales approximatives pour guider dans la bonne direction, mais elles doivent être fortement complétées par une motivation interne. Cela signifie aussi que ces activités sont extrêmement vulnérables aux déséquilibres d’incitations externes, notamment aux jeux marginaux comme la pression sociale ou la coercition. Pour limiter ces effets, la confidentialité est à nouveau indispensable.

La confidentialité, c’est le progrès

Imaginez un monde sans chiffrement asymétrique ni symétrique. Dans ce monde, envoyer un message sécurisé à distance serait fondamentalement plus difficile – pas impossible, mais très difficile. Cela réduirait fortement la coopération internationale, poussant davantage de collaborations vers des canaux hors ligne en face-à-face. Le monde en serait plus pauvre, plus inégal.

Je pense que, comparé à un monde futur hypothétique, nous sommes aujourd’hui exactement dans cette situation : un monde où des formes plus puissantes de cryptographie – en particulier la cryptographie programmable – seront largement utilisées, accompagnées par une sécurité complète de bout en bout et une vérification formelle robuste, nous assurant que ces outils sont correctement utilisés.

Protocole Égyptien : trois structures puissantes et hautement universelles nous permettant de calculer sur des données tout en gardant celles-ci totalement privées.

La santé illustre bien ce point. Si vous parlez à des personnes ayant travaillé ces dix dernières années sur la longévité, les épidémies ou d’autres domaines de la santé, elles vous diront toutes que les traitements et préventions de l’avenir seront personnalisés, et que les solutions efficaces dépendront fortement de données de haute qualité, incluant des données personnelles et environnementales. Protéger efficacement les gens contre les maladies aéroportées requiert de savoir où la qualité de l’air est bonne ou mauvaise, et où les pathogènes se trouvent à un moment donné. Les cliniques de longévité les plus avancées offrent déjà des recommandations et traitements personnalisés basés sur vos données corporelles, préférences alimentaires et mode de vie.

Pourtant, tout cela comporte aussi d’énormes risques pour la vie privée. Je connais personnellement un cas où une entreprise a fourni un capteur d’air à un employé « télétravaillant », et les données collectées permettaient de déterminer quand cet employé avait des rapports sexuels. Pour des raisons similaires, je prévois que beaucoup des données les plus précieuses ne seront pas collectées par défaut, simplement par peur des risques pour la vie privée. Même quand les données sont collectées, elles ne sont presque jamais largement partagées ou fournies aux chercheurs – en partie pour des raisons commerciales, mais tout aussi souvent par souci de confidentialité.

Le même schéma se répète dans d'autres domaines. Les documents que nous rédigeons, les messages envoyés sur diverses applications et nos comportements sur les réseaux sociaux contiennent une mine d'informations sur nous-mêmes, pouvant être utilisées pour mieux prédire et fournir ce dont nous avons besoin quotidiennement. De plus, d'importantes données existent sur notre interaction avec l'environnement physique, indépendamment de la santé. Aujourd'hui, nous manquons d'outils efficaces pour exploiter ces informations sans cauchemar dystopique de vie privée. Mais à l'avenir, nous pourrions bien les avoir.

La meilleure façon de relever ces défis est d'utiliser des techniques de chiffrement fort, nous permettant de bénéficier du partage des données sans en subir les effets négatifs. À l'ère de l'IA, la nécessité d'accéder aux données (y compris personnelles) ne fera que croître, car la capacité d'entraîner localement et d'exécuter des « doubles numériques » capables de prendre des décisions basées sur une approximation fidèle de nos préférences aura une immense valeur. Cela inclura éventuellement l'utilisation d'interfaces cerveau-machine (BCI) lisant des entrées à bande passante élevée depuis notre cerveau. Pour éviter une hégémonie mondiale fortement centralisée, nous devons trouver des moyens d'y parvenir tout en respectant la vie privée. La cryptographie programmable est la solution la plus fiable.

Mon capteur de qualité de l'air AirValent. Imaginez un appareil qui collecte des données sur la qualité de l'air, publie des statistiques agrégées sur une carte de données ouvertes, et vous récompense pour vos données – le tout via de la cryptographie programmable, évitant ainsi de divulguer vos données de localisation personnelles et vérifiant l'authenticité des données.

La confidentialité peut favoriser le progrès de la sécurité sociale

Les technologies de cryptographie programmable, comme les preuves à divulgation nulle, sont extrêmement puissantes car elles agissent comme des briques Lego pour les flux d'information. Elles permettent un contrôle fin de qui voit quelles informations, et surtout, de quelles informations peuvent être révélées. Par exemple, je peux prouver que je possède un passeport canadien attestant que j'ai plus de 18 ans, sans divulguer aucune autre information personnelle.

Cela rend possibles de nombreuses combinaisons intéressantes. Voici quelques exemples :

-

Preuve d'identité à divulgation nulle : prouver que vous êtes une personne unique (via diverses formes d'identification : passeport, biométrie, preuve basée sur un graphe social décentralisé), sans révéler aucune autre information d'identité. Utile pour « prouver que vous n'êtes pas un robot », des cas d'usage « maximum N par personne », tout en protégeant pleinement la vie privée lorsque les règles ne sont pas violées.

-

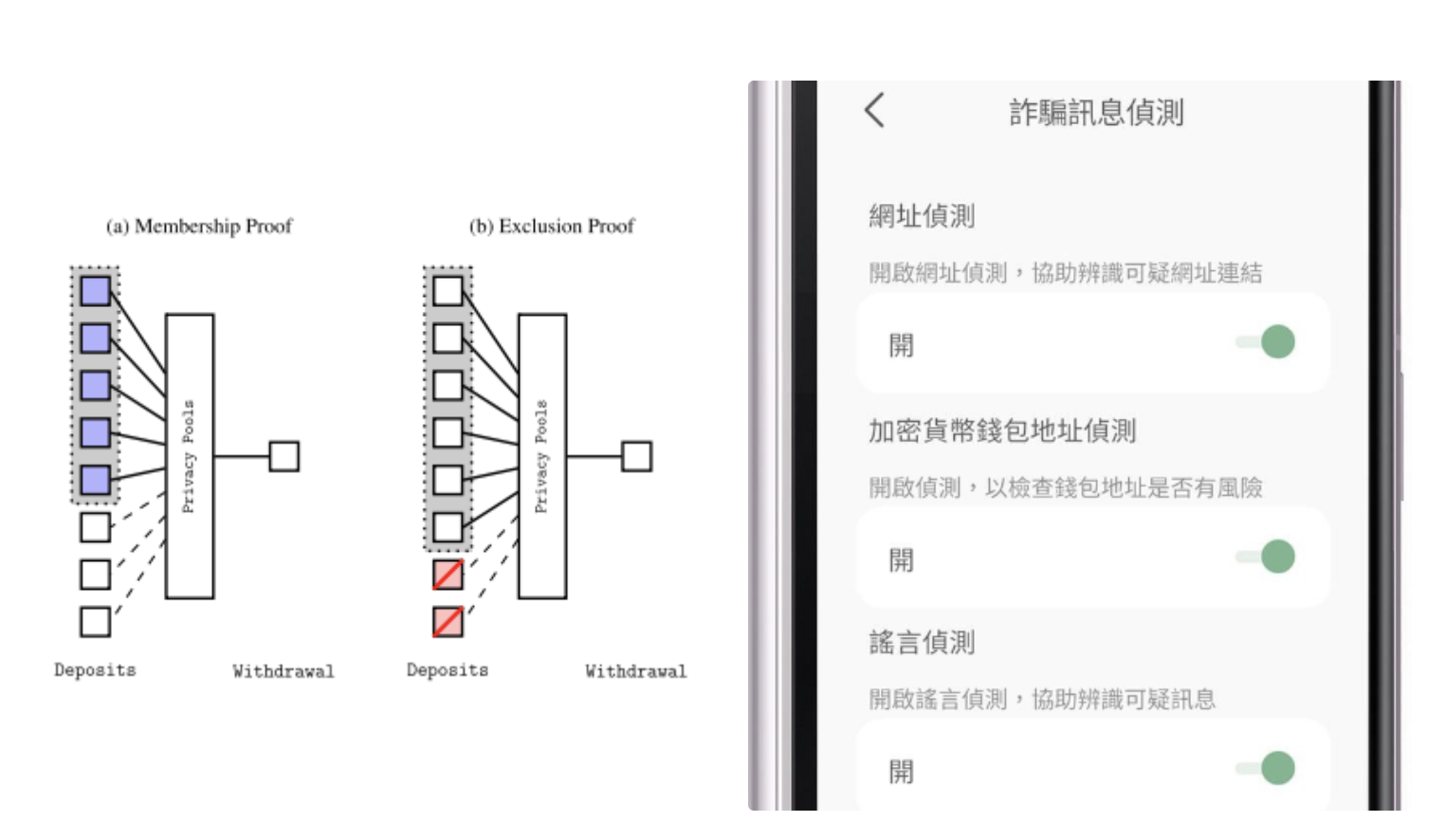

Privacy Pools : une solution de confidentialité financière excluant les mauvais acteurs sans porte dérobée. À la consommation, l'utilisateur peut prouver que ses jetons ne proviennent pas de listes publiques de hack ou de vols ; seuls les pirates et voleurs ne peuvent pas générer une telle preuve, donc ils ne peuvent pas se cacher. Railgun et privacypools.com utilisent actuellement ce type de système.

-

Analyse anti-fraude embarquée : ne repose pas sur les ZKP, mais appartient à cette catégorie. Vous pouvez utiliser des filtres intégrés dans l'appareil (y compris des LLM) pour analyser les messages entrants et automatiquement détecter la désinformation ou les escroqueries. Effectué sur l'appareil, cela ne nuit pas à la vie privée de l'utilisateur, et peut être fait avec son autorisation, permettant à chaque utilisateur de choisir quels filtres activer.

-

Preuve d'origine physique : combinant blockchain et preuves à divulgation nulle, permet de tracer divers attributs d'un objet le long de sa chaîne de fabrication. Par exemple, cela permettrait de tarifer les externalités environnementales sans divulguer publiquement la chaîne d'approvisionnement.

À gauche : schéma de Privacy Pools. À droite : application Message Checker, où l'utilisateur peut activer/désactiver plusieurs filtres, de haut en bas : vérification d'URL, vérification d'adresse crypto, vérification de rumeurs

Confidentialité et intelligence artificielle

Récemment, ChatGPT a annoncé qu'il commencerait à intégrer vos conversations passées comme contexte pour les futures discussions. Cette tendance ira inévitablement plus loin : l'IA qui analyse votre historique de conversations pour en extraire des insights est fondamentalement très utile. Bientôt, on verra probablement des produits d'IA encore plus intrusifs : collectant passivement vos habitudes de navigation, e-mails, messages, données biométriques, etc.

Théoriquement, vos données sont privées pour vous. Mais en pratique, ce n'est pas toujours le cas :

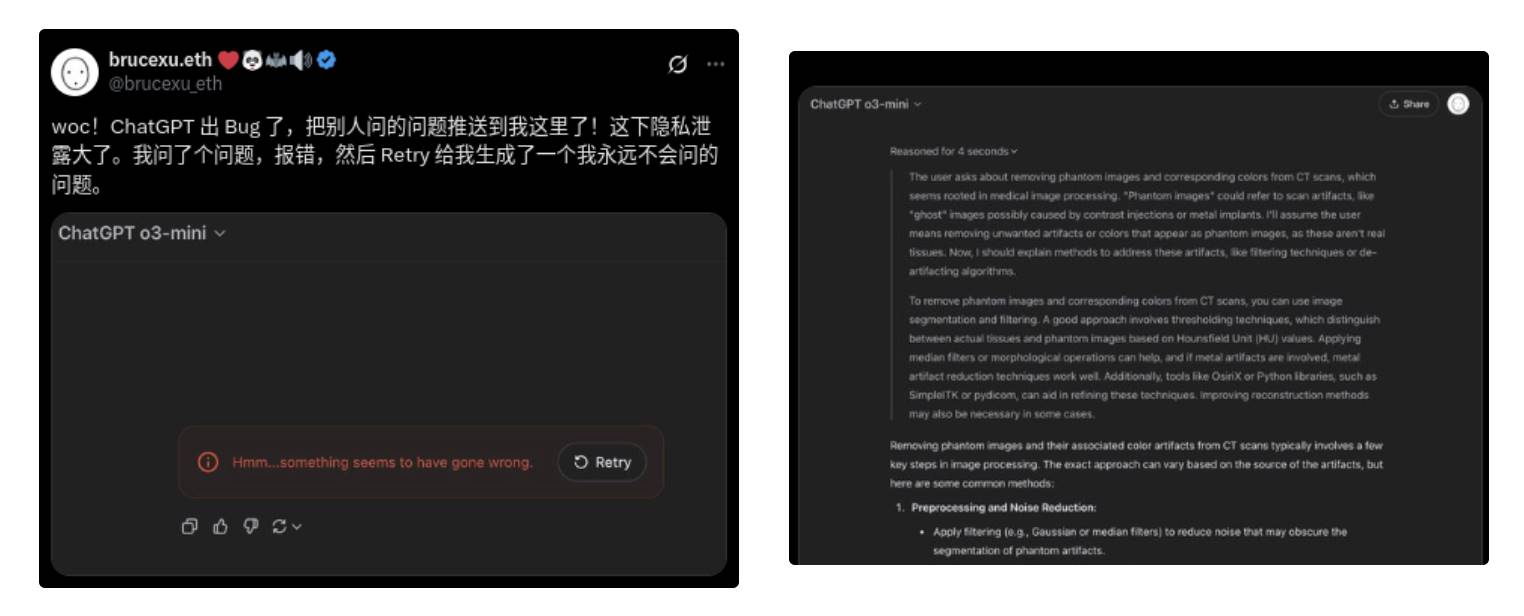

Wow ! ChatGPT a un bug, il pousse les questions des autres vers moi ! Grave fuite de vie privée. J'ai posé une question, erreur, puis en « réessayant », il a généré une question que je n'aurais jamais posée.

Il est tout à fait possible que les mécanismes de confidentialité fonctionnent bien, et que dans ce cas, l'IA ait eu une hallucination, générant et répondant à une question que Bruce n'a jamais posée. Mais on ne peut pas le vérifier. De même, on ne peut pas vérifier si nos conversations sont utilisées pour l'entraînement.

Tout cela est profondément inquiétant. Plus inquiétant encore sont les cas d'usage explicites de surveillance par l'IA, collectant et analysant massivement les données (physiques et numériques) des utilisateurs sans leur consentement. La reconnaissance faciale aide déjà les régimes autoritaires à réprimer massivement les dissidents politiques. Et le front final le plus inquiétant de la collecte et analyse de données par l'IA : l'esprit humain.

Théoriquement, les interfaces cerveau-machine ont un potentiel incroyable pour améliorer les capacités humaines. Prenons l’exemple de Noland Arbaugh, le premier patient Neuralink de l’année dernière :

Ce dispositif expérimental a redonné à Arbaugh, âgé de 30 ans, un sentiment d’indépendance. Avant, l’utilisation d’une baguette buccale nécessitait qu’on le tienne droit. Si la baguette tombait, quelqu’un devait la ramasser. Et il ne pouvait pas l’utiliser longtemps sans développer d’escarres. Grâce au dispositif Neuralink, il peut désormais contrôler presque entièrement son ordinateur. Il peut naviguer sur le web, jouer à des jeux quand il veut, et Neuralink affirme qu’il a établi le record humain de contrôle du curseur par interface cerveau-machine (BCI).

Aujourd’hui, ces dispositifs sont assez puissants pour aider les blessés. À l’avenir, ils seront assez puissants pour permettre aux personnes en pleine santé de collaborer avec les ordinateurs, voire de communiquer télépathiquement entre eux avec une efficacité inimaginable (!!). Mais pour véritablement interpréter les signaux cérébraux et rendre cette communication possible, l’intelligence artificielle est nécessaire.

Ces tendances combinées pourraient naturellement mener à un avenir sombre : nous verrions des super-agents en silicium absorber et analyser les informations de chacun, y compris leur écriture, comportements et modes de pensée. Mais il existe aussi un avenir plus lumineux : profiter des avantages de ces technologies tout en protégeant notre vie privée.

Cela peut être réalisé en combinant plusieurs technologies :

-

Exécuter autant que possible les calculs localement – de nombreuses tâches (analyse d’image de base, traduction, transcription, analyse de base des ondes cérébrales pour BCI) sont suffisamment simples pour être effectuées entièrement localement. En fait, l’exécution locale présente même des avantages en termes de latence et de vérifiabilité. Si quelque chose peut être fait localement, cela devrait l’être. Cela inclut les calculs intermédiaires comme l’accès à Internet ou la connexion à des comptes sociaux.

-

Utiliser la cryptographie pour rendre les calculs distants totalement privés – le chiffrement homomorphe complet (FHE) permet d’exécuter des calculs d’IA à distance sans que le serveur distant ne voie les données ou les résultats. Historiquement, le FHE était très coûteux, mais (i) son efficacité augmente rapidement récemment, (ii) les LLM sont une forme de calcul fortement structurée, asymptotiquement presque entièrement linéaire, ce qui les rend particulièrement adaptés à des implémentations FHE ultra-efficaces. Les calculs impliquant des données privées multiples peuvent être réalisés via le calcul multipartite ; les cas à deux parties peuvent être traités extrêmement efficacement par des techniques comme les circuits obfusqués.

-

Utiliser la vérification matérielle pour étendre les garanties au monde physique – nous pouvons exiger que le matériel capable de lire nos pensées (interne ou externe au crâne) soit ouvert et vérifiable, utilisant des technologies comme IRIS pour validation. Nous pouvons aussi le faire ailleurs : par exemple, installer des caméras de sécurité qui ne sauvegardent et transfèrent le flux vidéo que si un LLM local le marque comme violence physique ou urgence médicale, le supprimant dans tous les autres cas, avec des vérifications aléatoires communautaires via IRIS pour confirmer la conformité.

Un futur imparfait

En 2008, le philosophe libéral David Friedman a écrit un livre intitulé *The Future of Freedom*. Il y esquisse comment les nouvelles technologies pourraient transformer la société, mais pas toutes les transformations lui conviennent (ni à nous). Dans une section, il décrit un futur potentiel : une interaction complexe entre vie privée et surveillance, où la croissance de la confidentialité numérique compense celle de la surveillance du monde réel :

Si un moustique caméra est collé au mur en train de me regarder taper, chiffrer fortement mes emails n’a aucun sens. Ainsi, dans une société transparente, une forte confidentialité nécessite un moyen de protéger l’interface entre mon corps dans l’espace physique et le cyberespace… Une solution basse technologie consiste à taper sous une cagoule. Une solution haute technologie serait d’établir une connexion entre esprit et machine qui ne passe pas par les doigts – ou tout canal visible par un observateur extérieur.

Le conflit entre transparence physique et confidentialité numérique va aussi dans l’autre sens… Mon assistant personnel chiffre mon message avec ta clé publique, le transmet à ton assistant, qui le déchiffre et l’affiche via tes lunettes de réalité virtuelle. Pour s’assurer que personne ne puisse lire par-dessus ton épaule, les lunettes n’affichent pas via un écran, mais gravent l’image sur ta rétine avec un mini-laser. Si tout va bien, l’intérieur de tes yeux reste un espace privé.

Nous pourrions finir par vivre dans un monde où les activités corporelles sont totalement publiques, mais les échanges d’information totalement privés. Cela présente des aspects attrayants. Les citoyens ordinaires pourraient encore utiliser l’avantage de la forte confidentialité pour retrouver un tueur, mais le coût de l’engager pourrait dépasser leurs moyens, car dans un monde assez transparent, tous les meurtres seraient résolus. Chaque tueur serait emprisonné après une seule mission.

Et que dire de l’interaction avec les technologies de traitement des données ? D’un côté, les techniques modernes de traitement rendent la société transparente une menace – sans elles, même enregistrer tout ce qui se passe dans le monde serait inutile, car personne ne pourrait retrouver la portion de six pouces qu’il cherche parmi des millions de miles de bandes vidéo produites chaque jour. D’un autre côté, les technologies soutenant une forte confidentialité offrent la possibilité de restaurer la vie privée, même dans un monde doté de technologies modernes de traitement, en protégeant vos échanges d’information contre toute interception.

Un tel monde pourrait être le meilleur des mondes possibles : si tout va bien, nous verrons un futur presque sans violence physique, tout en préservant notre liberté numérique, garantissant le fonctionnement fondamental des processus politiques, civiques, culturels et intellectuels de la société, processus dont la survie dépend d’une certain

Bienvenue dans la communauté officielle TechFlow

Groupe Telegram :https://t.me/TechFlowDaily

Compte Twitter officiel :https://x.com/TechFlowPost

Compte Twitter anglais :https://x.com/BlockFlow_News