Focus sur la structure et la vision d'Allora : comment la blockchain peut-elle résoudre le problème de la longue traîne de l'intelligence artificielle ?

TechFlow SélectionTechFlow Sélection

Focus sur la structure et la vision d'Allora : comment la blockchain peut-elle résoudre le problème de la longue traîne de l'intelligence artificielle ?

Allora vise à créer une infrastructure d'IA décentralisée permettant l'amélioration continue et à soutenir les projets souhaitant intégrer l'IA de manière sécurisée à leurs services.

Auteur :Tranks, DeSpread

Clause de non-responsabilité : Le contenu de ce rapport reflète les opinions des auteurs respectifs, est fourni à titre informatif uniquement et ne constitue pas une recommandation d'achat ou de vente de jetons ou d'utilisation de protocoles. Aucun contenu de ce rapport ne doit être considéré comme un conseil en investissement, ni interprété comme tel.

1. Introduction

Depuis l'apparition de l'intelligence artificielle générative représentée par ChatGPT, la technologie IA a connu un développement rapide, et la participation ainsi que les investissements des entreprises dans le secteur IA n'ont cessé de croître. Récemment, l'IA s'est non seulement distinguée dans la génération de sorties spécifiques, mais aussi dans le traitement à grande échelle des données, la reconnaissance de motifs, l'analyse statistique et la modélisation prédictive, étendant ainsi son champ d'application à divers secteurs.

-

JP Morgan : Emploie plus de 600 ingénieurs ML, développant et testant plus de 400 cas d'utilisation de technologies IA, notamment le trading algorithmique, la prédiction de fraude et la prévision de trésorerie.

-

Walmart : Analyse l'historique des ventes saisonnières et régionales afin de prévoir la demande de produits et optimiser les stocks.

-

Ford : Analyse les données provenant des capteurs des véhicules pour anticiper les pannes de pièces détachées et informer les clients, évitant ainsi les accidents dus à ces défaillances.

Récemment, la tendance à combiner l'écosystème blockchain avec l'IA devient de plus en plus marquée, notamment dans le domaine DeFAI, qui associe protocoles DeFi et IA, attirant particulièrement l'attention.

De plus, les exemples intégrant directement l'IA dans les mécanismes opérationnels des protocoles se multiplient, rendant la prédiction et la gestion des risques des protocoles DeFi plus efficaces et introduisant de nouveaux services financiers auparavant impossibles à réaliser.

Lecture complémentaire : « La narration autour de l'IA s'intensifie, comment les DeFi peuvent-elles en tirer profit ? »

Cependant, en raison du volume important de données d'entraînement requis et de la barrière d'entrée élevée liée aux compétences techniques spécialisées en IA, la création de modèles IA dédiés à des fonctions spécifiques reste actuellement monopolisée par quelques grandes entreprises et experts en IA.

Par conséquent, d'autres secteurs et jeunes startups rencontrent de grandes difficultés dans l'adoption de l'IA, tout comme les dApps de l'écosystème blockchain. Étant donné que les dApps doivent maintenir leur valeur fondamentale de « confiance minimale », sans dépendre de tiers, une infrastructure IA décentralisée est nécessaire pour permettre à davantage de protocoles d'adopter l'IA et d'offrir des services dignes de confiance aux utilisateurs.

Dans ce contexte, Allora vise à créer une infrastructure IA décentralisée auto-améliorante et à soutenir les projets souhaitant intégrer l'IA en toute sécurité à leurs services.

2. Allora, réseau décentralisé de synthèse d'inférence

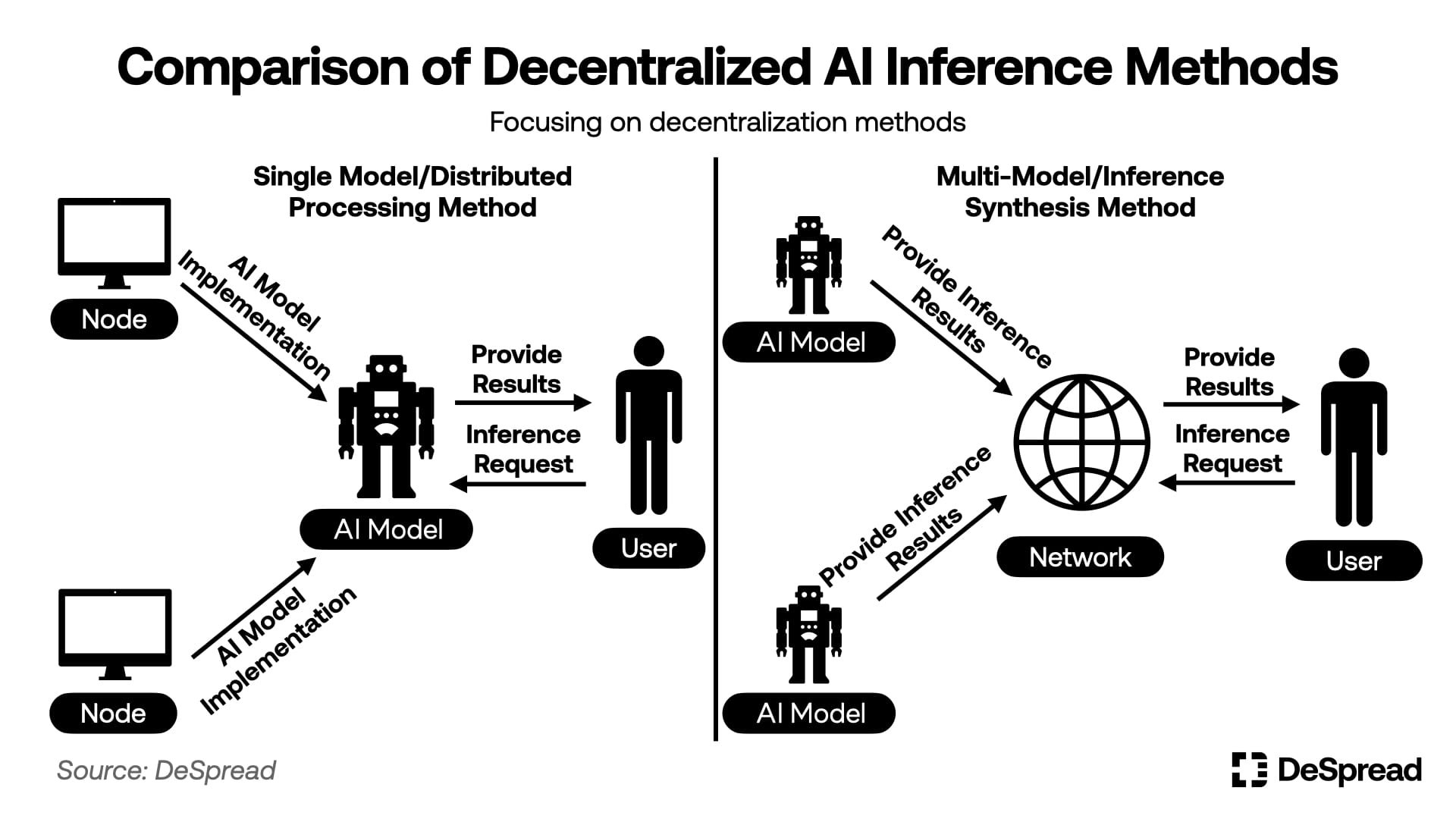

Allora est un réseau décentralisé d'inférence capable de prédire et fournir des valeurs futures selon des sujets spécifiques demandés par différents entités. Il existe deux principales approches pour implémenter une inférence AI distribuée :

-

Modèle unique / traitement distribué : Former et exécuter des processus de modèle de manière décentralisée afin de construire un modèle AI unique et distribué.

-

Multi-modèles / synthèse d'inférence : Recueillir les résultats d'inférence provenant de plusieurs modèles AI pré-entraînés, puis les combiner en un seul résultat d'inférence.

Dans ces deux méthodes, Allora adopte l'approche multi-modèles / synthèse d'inférence. Les opérateurs de modèles d'IA peuvent librement rejoindre le réseau Allora pour effectuer des inférences sur des demandes de prévision relatives à des sujets spécifiques. Le protocole répond alors à la requête en fournissant une seule prédiction synthétisée à partir des inférences proposées par ces opérateurs.

Lors de la synthèse des valeurs d'inférence des modèles d'IA, Allora ne calcule pas simplement la moyenne des inférences produites par chaque modèle, mais attribue un poids différent à chaque modèle afin d'obtenir la valeur finale d'inférence. Ensuite, Allora compare les valeurs d'inférence produites par chaque modèle avec le résultat réel du sujet concerné, et procède à une auto-amélioration en attribuant un poids et des récompenses plus élevés aux modèles dont les inférences sont proches du résultat réel, améliorant ainsi la précision de l'inférence.

Grâce à cette méthode, Allora peut effectuer des inférences plus spécialisées et adaptées à des sujets précis que celles réalisées par une IA basée sur une approche de modèle unique / traitement distribué. Pour encourager la participation de davantage de modèles d'IA au protocole, Allora propose une architecture open source appelée Allora MDK (Kit de Développement de Modèles), facilitant la création et le déploiement de modèles d'IA par n'importe qui.

En outre, Allora fournit également deux SDK aux utilisateurs souhaitant utiliser les données d'inférence d'Allora : Allora Network Python et le SDK TypeScript. Ces SDK offrent un environnement permettant d'intégrer facilement et d'utiliser les données fournies par Allora.

L'objectif d'Allora est de devenir une couche intermédiaire reliant les modèles d'IA aux protocoles ayant besoin de données d'inférence, en offrant aux opérateurs de modèles d'IA des opportunités de revenus tout en construisant pour les services et protocoles une infrastructure de données impartiale.

Nous allons maintenant examiner l'architecture du protocole de communication d'Allora pour mieux comprendre son fonctionnement et ses caractéristiques.

2.1. Architecture du protocole de communication

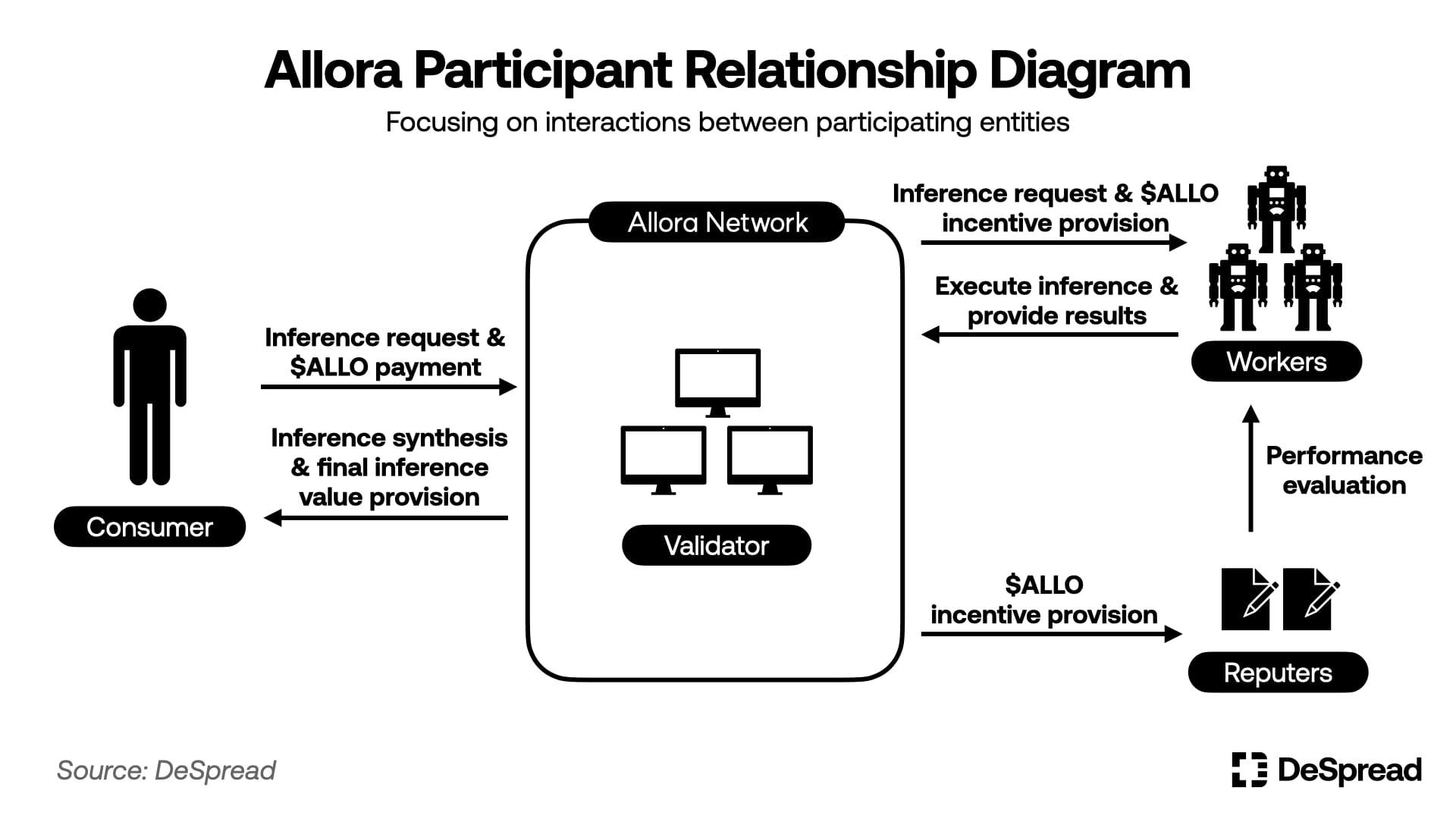

Dans Allora, toute personne peut définir et déployer un sujet spécifique. Lors de l'exécution d'une inférence et de l'obtention de la valeur finale d'inférence pour un sujet donné, quatre participants interviennent :

-

Consommateurs (Consumers) : Payent pour demander une inférence sur un sujet spécifique.

-

Travailleurs (Workers) : Utilisent leurs bases de données pour exécuter un modèle d'IA et effectuer l'inférence demandée par les consommateurs sur un sujet spécifique.

-

Reputers : Évaluent les inférences fournies par les travailleurs en les comparant aux valeurs réelles.

-

Validateurs (Validators) : Gèrent les nœuds du réseau Allora, traitent et enregistrent les transactions générées par chaque participant.

L'architecture du réseau Allora se divise en trois rôles : exécuteurs d'inférence, évaluateurs et validateurs, tous centrés autour du jeton du réseau $ALLO. Ce dernier est utilisé comme frais de demande d'inférence et comme récompense pour l'exécution d'inférence, reliant ainsi les participants du réseau, tout en assurant la sécurité via le système de mise en jeu (staking).

Nous allons maintenant analyser en détail les interactions entre les différents participants selon les fonctions de chaque couche : couche de consommation d'inférence, couche de synthèse d'inférence et couche de consensus.

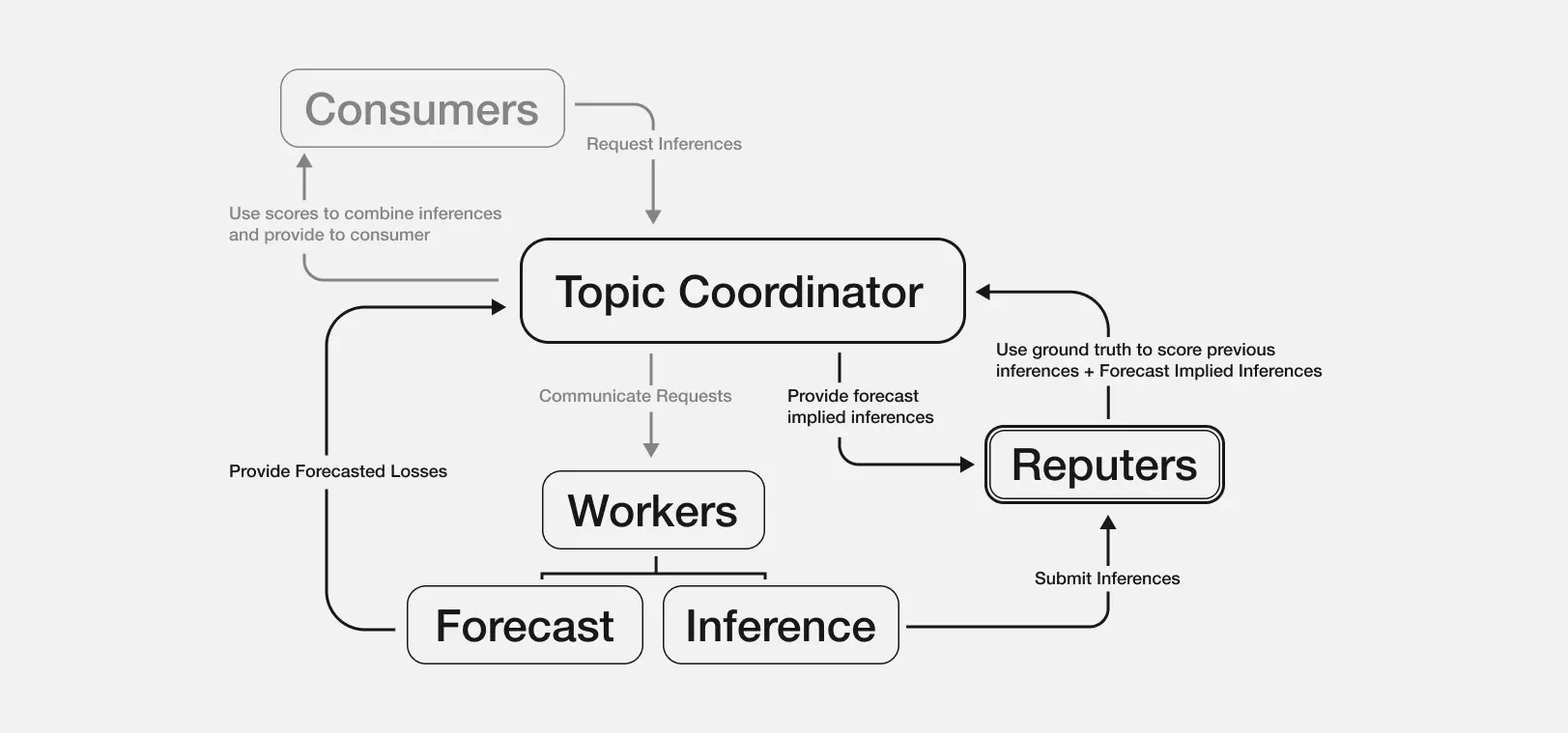

2.1.1. Couche de consommation d'inférence

La couche de consommation d'inférence gère les interactions entre les participants du protocole et Allora, y compris la création de sujets, la gestion des participants au sujet et les demandes d'inférence.

Un utilisateur souhaitant créer un sujet peut interagir avec le coordinateur de sujet et de système d'inférence d'Allora (Topic Coordinator), en payant un montant défini de $ALLO et en établissant des règles pour définir le contenu à inférer, la manière de vérifier les résultats réels, ainsi que l'évaluation des inférences fournies par les travailleurs.

Une fois un sujet créé, les travailleurs et les Reputers peuvent payer des frais d'inscription en $ALLO pour s'enregistrer en tant que participants à l'inférence de ce sujet. Les Reputers doivent en outre miser un certain montant de $ALLO sur ce sujet, s'exposant ainsi au risque de réduction de leurs actifs (Asset Slashing) en cas de résultats malveillants.

Après la création du sujet et l'inscription des travailleurs et Reputers, les consommateurs peuvent payer $ALLO vers le sujet pour demander une inférence, et les travailleurs ainsi que les Reputers reçoivent ces frais comme récompense pour l'inférence.

2.1.2. Couche d'inférence et de synthèse

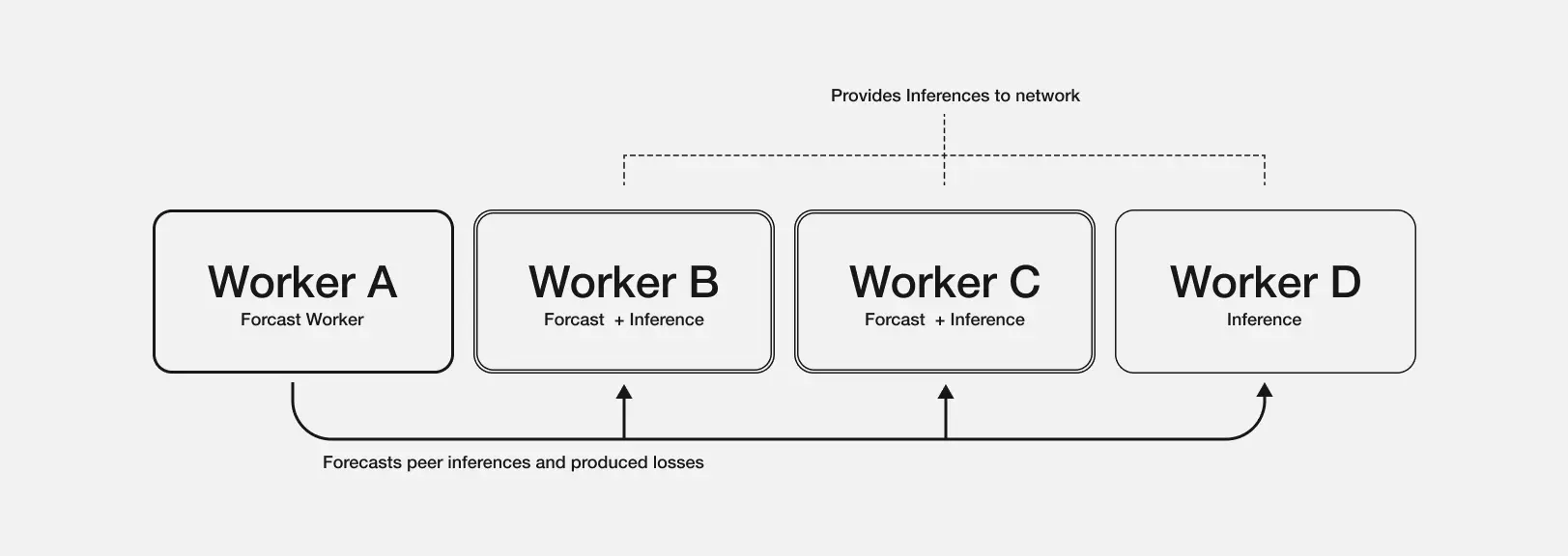

La couche d'inférence et de synthèse est la couche centrale d'Allora servant à produire des inférences décentralisées. Ici, les travailleurs exécutent les inférences, les Reputers évaluent les performances, et des poids sont attribués pour synthétiser les inférences.

Les travailleurs du réseau Allora doivent non seulement soumettre une valeur d'inférence sur le sujet demandé par les consommateurs, mais aussi évaluer la précision des inférences des autres travailleurs, produisant ainsi des « pertes prévues » (Forecasted Losses). Ces pertes prévues influencent le calcul des poids nécessaires à la synthèse de l'inférence. Un travailleur obtient une récompense plus élevée lorsqu'il fournit une inférence précise et prédit correctement la précision des inférences des autres travailleurs. Grâce à cette structure, Allora peut déduire des poids de synthèse tenant compte de divers contextes, et non pas uniquement des performances passées des travailleurs.

Prédiction par les travailleurs de la précision de l'inférence pour la prise en compte du contexte

Source : Allora Docs

Par exemple, dans un sujet visant à prédire le prix du Bitcoin une heure plus tard, supposons les situations suivantes pour les travailleurs A et B :

-

Travailleur A : Précision moyenne d'inférence de 90 %, mais diminue en période d'instabilité du marché.

-

Travailleur B : Précision moyenne d'inférence de 80 %, mais reste relativement élevée même en période de volatilité du marché.

Si le marché est actuellement très volatile, et que plusieurs travailleurs prédisent que « le travailleur B aura un avantage dans les conditions de volatilité, avec une erreur d'environ 5 % dans cette prédiction », tout en prédisant que « le travailleur A aura une erreur estimée d'environ 15 % dans ces conditions », alors même si le travailleur B a une performance historique moyenne inférieure, Allora lui attribuera un poids plus élevé dans cette inférence.

Le coordinateur de sujet utilise l'inférence synthétisée pondérée obtenue par ce processus pour fournir la valeur finale d'inférence au consommateur. En outre, un intervalle de confiance (Confidence Intervals) est calculé et fourni en fonction de la distribution des valeurs d'inférence soumises par les travailleurs. Ensuite, les Reputers comparent le résultat réel à la valeur d'inférence finale afin d'évaluer la performance de chaque travailleur et la justesse de leurs prédictions sur la précision des autres travailleurs, ajustant ainsi les poids des travailleurs selon le consensus de mise en jeu.

Grâce à cette méthode de synthèse et d'évaluation, en particulier sa structure « consciente du contexte », où chaque travailleur évalue la précision des inférences des autres, Allora peut dériver des valeurs d'inférence optimisées pour différentes situations, améliorant ainsi la précision globale. De plus, à mesure que les données de performance des travailleurs s'accumulent, l'efficacité de la fonction de perception contextuelle augmente, permettant à Allora d'améliorer continuellement ses capacités d'inférence.

Processus de synthèse d'inférence d'Allora

Source : Allora Docs

La couche de consensus d'Allora est l'endroit où sont calculés les poids des sujets, distribuées les récompenses du réseau et enregistrées les activités des participants. Elle est construite sur Cosmos SDK, utilisant les mécanismes de consensus CometBFT et DPoS.

Les utilisateurs peuvent participer au réseau Allora en tant que validateurs en émettant des jetons $ALLO et en exécutant un nœud, percevant ainsi les frais de transaction soumis par les participants à Allora comme rémunération pour l'exploitation du réseau et la garantie de sa sécurité. Même sans exécuter un nœud, les utilisateurs peuvent indirectement recevoir ces récompenses en déléguant leurs $ALLO à un validateur.

En outre, une particularité d'Allora est la distribution de récompenses en $ALLO aux participants du réseau. Parmi les nouveaux $ALLO débloqués et distribués, 75 % sont attribués aux travailleurs et Reputers participant aux inférences de sujets, tandis que les 25 % restants vont aux validateurs. Une fois tous les $ALLO émis, ces récompenses inflationnistes cesseront, suivant une structure de réduction progressive de moitié.

Lorsque 75 % des récompenses inflationnistes sont distribuées aux travailleurs et Reputers, la répartition dépend non seulement de la performance des travailleurs et de la mise en jeu des Reputers, mais aussi du poids du sujet. Ce poids est calculé en fonction du montant misé par les Reputers sur ce sujet et des revenus générés par les frais, incitant ainsi les travailleurs et Reputers à continuer de participer à des sujets à forte demande et haute stabilité.

3. De la chaîne à tous les secteurs

3.1. Prochaine sortie du réseau principal Allora

Allora a fondé la Fondation Allora le 10 janvier 2025. Après avoir mené un testnet public impliquant plus de 300 000 travailleurs participants, elle accélère désormais le lancement de son réseau principal. Au 6 février, Allora sélectionne des créateurs de modèles d'IA pour son prochain lancement principal via le Concours Allora Model Forge.

Catégories du Concours Allora Model Forge

Source : Allora Model Forge Competition

En outre, avant le lancement de son réseau principal, Allora a établi des partenariats avec de nombreux projets. Voici les principaux partenariats d'Allora et les fonctionnalités qu'ils offrent :

-

Plume : Fournit des prix RWA, des APY en temps réel et des prévisions de risques sur le réseau Plume.

-

Story Protocol : Propose une évaluation de la valeur de propriété intellectuelle, des analyses potentielles, des informations sur les prix d'actifs hors chaîne non liquides, et fournit des inférences Allora aux projets DeFi basés sur Story Protocol.

-

Monad : Fournit des informations de prix pour les actifs hors chaîne peu liquides et offre des inférences Allora aux projets DeFi basés sur Monad.

-

0xScope : Utilise la fonctionnalité de prise en compte du contexte d'Allora pour soutenir le développement de l'assistant IA sur chaîne Jarvis.

-

Virtuals Protocol : Améliore les performances des agents en intégrant les inférences d'Allora au cadre G.A.M.E de Virtual Protocol.

-

Eliza OS (anciennement ai16z) : Renforce les performances des agents en intégrant les inférences d'Allora au cadre Eliza d'Eliza OS.

Actuellement, les partenaires d'Allora se concentrent principalement sur des projets combinant IA et cryptomonnaies, reflétant deux facteurs clés : 1) la demande des projets de cryptomonnaies pour des inférences décentralisées, et 2) le besoin de données en chaîne pour l'exécution des modèles d'IA.

Pour la sortie initiale du réseau principal, Allora prévoit d'allouer d'importantes récompenses inflationnistes afin d'attirer les participants. Pour inciter ces participants attirés par les récompenses à rester actifs, Allora doit maintenir une valeur adéquate du jeton $ALLO. Cependant, comme les récompenses inflationnistes diminueront progressivement avec le temps, le défi à long terme consistera à générer suffisamment de frais de transaction via une augmentation de la demande d'inférence, afin d'encourager une participation continue au protocole.

Par conséquent, l'évaluation du succès potentiel d'Allora repose essentiellement sur sa stratégie à court terme de valorisation du $ALLO, ainsi que sur sa capacité à stimuler la demande d'inférence afin d'assurer des revenus stables et durables.

4. Conclusion

Avec les progrès et la croissance de l'utilité de la technologie IA, l'adoption et la mise en œuvre de l'inférence IA se développent activement dans de nombreux secteurs. Toutefois, l'intensité des ressources requises pour adopter l'IA creuse l'écart concurrentiel entre les grandes entreprises ayant déjà réussi à intégrer l'IA et les petites entreprises qui n'y sont pas encore parvenues. Dans ce contexte, la demande pour les fonctionnalités d'Allora — fournir des inférences optimisées par sujet et améliorer continuellement la précision des données par décentralisation — devrait croître progressivement.

Le but d'Allora est de devenir une infrastructure d'inférence décentralisée largement adoptée dans tous les secteurs, ce qui nécessite de démontrer l'efficacité et la durabilité de ses fonctionnalités. Pour cela, Allora doit, après le lancement de son réseau principal, attirer suffisamment de travailleurs et de Reputers, et garantir à ces participants du réseau des récompenses durables.

Si Allora parvient à relever ces défis et à s'imposer dans divers secteurs, elle pourra non seulement démontrer le potentiel de la blockchain en tant qu'infrastructure IA essentielle, mais aussi servir d'exemple majeur illustrant comment les technologies IA et blockchain peuvent être combinées pour créer une valeur réelle.

Bienvenue dans la communauté officielle TechFlow

Groupe Telegram :https://t.me/TechFlowDaily

Compte Twitter officiel :https://x.com/TechFlowPost

Compte Twitter anglais :https://x.com/BlockFlow_News