L'impact de DeepSeek sur les protocoles amont et aval de l'IA Web3

TechFlow SélectionTechFlow Sélection

L'impact de DeepSeek sur les protocoles amont et aval de l'IA Web3

DeepSeek fait éclater la dernière bulle du secteur des Agents, DeFAI pourrait donner naissance à une nouvelle ère, et les modes de financement du secteur connaissent un changement.

Rédaction : Kevin, chercheur chez BlockBooster

TL ; DR

-

L'émergence de DeepSeek brise la tranchée de protection du calcul, l'optimisation des performances grâce aux modèles open source devenant une nouvelle direction ;

-

DeepSeek bénéficie aux couches modèle et application dans la chaîne industrielle, mais affecte négativement les protocoles de puissance de calcul au niveau infrastructure ;

-

L'effet positif de DeepSeek a accidentellement fait éclater la dernière bulle du secteur Agent, DeFAI ayant le plus de potentiel pour donner naissance à quelque chose de nouveau ;

-

Le jeu à somme nulle autour du financement des projets pourrait prendre fin, un nouveau modèle combinant lancement communautaire et participation limitée de VC pourrait devenir la norme.

L'onde de choc provoquée par DeepSeek aura des effets profonds sur l'industrie de l'IA cette année. DeepSeek a réussi à accomplir avec des cartes graphiques grand public ce que seules d'importantes GPU haut de gamme pouvaient faire auparavant : entraîner de grands modèles. La première ligne de défense du développement de l'IA – la puissance de calcul – commence à s'effondrer. Lorsque l'efficacité algorithmique progresse à un rythme effréné de 68 % par an tandis que les performances matérielles suivent la loi de Moore en progression linéaire, les modèles d'évaluation bien établis ces trois dernières années ne sont plus valables. Le prochain chapitre de l'IA sera ouvert par les modèles open source.

Bien que les protocoles Web3 AI soient fondamentalement différents de ceux du Web2, ils subissent inévitablement l'impact de DeepSeek. Cet impact va engendrer de nouveaux cas d'utilisation au sein des différentes couches du Web3 AI : infrastructure, intermédiaires, modèles et applications.

Analyser les relations de collaboration entre les protocoles amont et aval

À travers l'analyse de l'architecture technique, du positionnement fonctionnel et des cas réels, j'ai divisé l'écosystème en quatre couches : infrastructure, intermédiaire, modèle et application, puis examiné leurs dépendances :

Couche infrastructure

La couche infrastructure fournit des ressources décentralisées de base (calcul, stockage, L1). Parmi les protocoles de calcul on trouve : Render, Akash, io.net, etc. ; pour le stockage : Arweave, Filecoin, Storj, etc. ; pour les L1 : NEAR, Olas, Fetch.ai, etc.

Les protocoles de calcul soutiennent l'entraînement, l'inférence et le fonctionnement des cadres de modèles ; les protocoles de stockage conservent les données d'entraînement, les paramètres de modèles et les journaux d'interactions sur chaîne ; les L1 optimisent l'efficacité du transfert de données via des nœuds spécialisés afin de réduire la latence.

Couche intermédiaire

La couche intermédiaire sert de pont entre l'infrastructure et les applications supérieures, offrant des outils de développement de frameworks, des services de données et la protection de la vie privée. Les protocoles d'annotation de données incluent : Grass, Masa, Vana, etc. ; les frameworks de développement : Eliza, ARC, Swarms, etc. ; les protocoles de calcul privé : Phala, etc.

La couche de service de données fournit le carburant nécessaire à l'entraînement des modèles ; les frameworks de développement dépendent de la puissance de calcul et du stockage de la couche infrastructure ; la couche de calcul privé assure la sécurité des données durant l'entraînement et l'inférence.

Couche modèle

La couche modèle est dédiée au développement, à l'entraînement et à la distribution des modèles, notamment la plateforme d'entraînement de modèles open source : Bittensor.

Cette couche dépend de la puissance de calcul de l'infrastructure et des données fournies par la couche intermédiaire ; les modèles sont déployés sur chaîne via des frameworks de développement ; les marchés de modèles transmettent les résultats d'entraînement à la couche application.

Couche application

La couche application comprend les produits IA destinés aux utilisateurs finaux, dont les Agents comme GOAT, AIXBT, etc., et les protocoles DeFAI tels que Griffain, Buzz, etc.

Cette couche appelle les modèles pré-entraînés de la couche modèle ; elle dépend du calcul privé de la couche intermédiaire ; les applications complexes nécessitent une puissance de calcul en temps réel fournie par la couche infrastructure.

DeepSeek pourrait avoir un impact négatif sur le calcul décentralisé

Selon une enquête échantillonnée, environ 70 % des projets Web3 AI utilisent réellement OpenAI ou des plateformes cloud centralisées, seulement 15 % exploitent des GPU décentralisés (comme les sous-réseaux de Bittensor), les 15 % restants adoptant une architecture hybride (traitement local des données sensibles, tâches générales sur le cloud).

Le taux d'utilisation réel des protocoles de puissance de calcul décentralisée est largement inférieur aux attentes et ne correspond pas à leur capitalisation boursière effective. Trois raisons expliquent ce faible taux d'adoption : les développeurs Web2 qui migrent vers le Web3 continuent d'utiliser leurs chaînes d'outils existantes ; les plateformes de GPU décentralisées n'ont pas encore atteint un avantage concurrentiel en termes de prix ; certains projets utilisent le terme « décentralisé » uniquement pour éviter les contrôles de conformité des données, tout en restant dépendants de clouds centralisés pour la puissance de calcul.

AWS/GCP détiennent plus de 90 % du marché du calcul IA, comparé à quoi la puissance équivalente d'Akash représente seulement 0,2 % celle d'AWS. Les avantages concurrentiels des plateformes cloud centralisées incluent la gestion de clusters, les réseaux haute vitesse RDMA et la capacité d'extension élastique. Les plateformes cloud décentralisées proposent des versions web3 améliorées de ces technologies, mais souffrent de lacunes critiques : latence élevée (la communication entre nœuds distribués est 6 fois plus lente que dans les clouds centralisés) ; fragmentation des chaînes d'outils (PyTorch/TensorFlow ne prennent pas nativement en charge l'ordonnancement décentralisé).

DeepSeek réduit la consommation de puissance de calcul de 50 % grâce à l'entraînement parcimonieux (Sparse Training) et permet d'entraîner des modèles de centaines de milliards de paramètres sur des GPU grand public via l'élagage dynamique de modèles. Les anticipations de demande à court terme pour des GPU haut de gamme ont fortement baissé, redéfinissant ainsi le potentiel du marché du calcul périphérique. Comme illustré ci-dessus, avant l'apparition de DeepSeek, la grande majorité des protocoles et applications du secteur utilisaient des plateformes telles qu’AWS, avec très peu de cas déployés sur des réseaux GPU décentralisés. Ces cas isolés misaient sur l'avantage tarifaire des GPU grand public et ignoraient les effets de la latence.

Cette situation risque de s'aggraver avec l'émergence de DeepSeek. Ce dernier libère les développeurs de longue traîne, et des modèles d'inférence efficaces et peu coûteux vont se généraliser à une vitesse sans précédent. En réalité, plusieurs plateformes cloud centralisées et de nombreux pays ont déjà commencé à déployer DeepSeek. La baisse drastique du coût d'inférence va stimuler l'émergence massive d'applications frontales, qui auront une forte demande en GPU grand public. Face à ce vaste marché à venir, les plateformes cloud centralisées vont entamer une nouvelle bataille pour conquérir les utilisateurs, non seulement contre les grandes plateformes, mais aussi contre d'innombrables petites plateformes centralisées. Le moyen le plus direct de concurrencer ? Réduire les prix. On peut donc s'attendre à une baisse des prix des 4090 sur les plateformes centralisées, ce qui constituerait une catastrophe pour les plateformes web3 de calcul. Lorsque le prix cesse d'être l'unique avantage concurrentiel de ces dernières, elles seront contraintes de baisser elles aussi leurs tarifs, conduisant à des pertes insupportables pour io.net, Render ou Akash. Une guerre des prix détruira leur plafond d'évaluation résiduel, et la spirale mortelle de baisse des revenus et de perte d'utilisateurs pourrait forcer les protocoles de calcul décentralisé à pivoter vers de nouvelles orientations.

Impacts concrets de DeepSeek sur les protocoles amont et aval

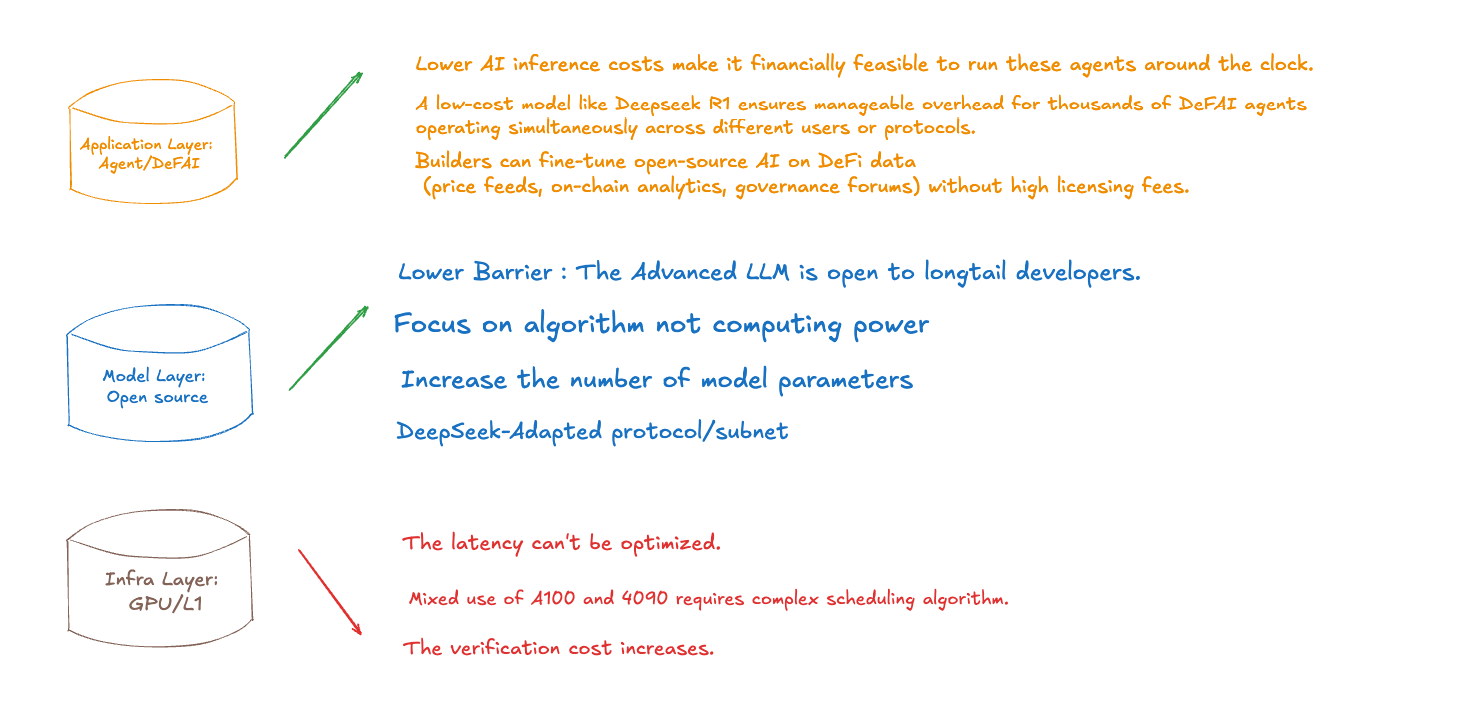

Comme illustré ci-dessus, je pense que DeepSeek aura des effets différents sur les couches infrastructure, modèle et application. En voici les aspects positifs :

-

La couche application bénéficiera d'une réduction majeure des coûts d'inférence, permettant à davantage d'applications d'assurer la disponibilité prolongée d'Agents à faible coût et d'exécuter des tâches en temps réel ;

-

Des modèles à faible coût comme DeepSeek permettront aux protocoles DeFAI de constituer des SWARM plus complexes, mobilisant des milliers d'Agents pour un même cas d'utilisation, chacun ayant une répartition des tâches très fine et claire, améliorant ainsi considérablement l'expérience utilisateur et évitant les erreurs de découpage et d'exécution des entrées ;

-

Les développeurs de la couche application pourront ajuster finement les modèles, alimenter les applications IA liées à la DeFi avec des données de prix, d'analyse on-chain et de gouvernance, sans payer de coûteuses licences ;

-

Après l'apparition de DeepSeek, la pertinence de la couche modèle open source est confirmée ; l'ouverture des modèles haut de gamme aux développeurs de longue traîne stimulera une vague étendue de développement ;

-

Le mur de puissance de calcul construit autour des GPU haut de gamme au cours des trois dernières années est désormais complètement brisé. Les développeurs disposent de plus de choix, orientant fermement les modèles open source : à l'avenir, la compétition entre modèles IA ne portera plus sur la puissance de calcul mais sur l'algorithme. Ce changement de paradigme deviendra la pierre angulaire de la confiance des développeurs open source.

Des sous-réseaux spécialisés autour de DeepSeek émergeront en continu, augmentant le nombre de paramètres des modèles pour une puissance de calcul équivalente, attirant davantage de développeurs vers la communauté open source.

Concernant les impacts négatifs :

-

La latence inhérente aux protocoles de puissance de calcul dans l'infrastructure ne peut être optimisée ;

-

De plus, les réseaux hybrides composés de A100 et de 4090 imposent des exigences plus élevées en matière d'algorithme de coordination, ce qui n'est pas un avantage des plateformes décentralisées.

DeepSeek fait éclater la dernière bulle du secteur Agent, DeFAI pourrait renaître, et le modèle de financement connaît une transformation

Agent représentait le dernier espoir de l'industrie IA. L'apparition de DeepSeek, en levant les contraintes de puissance de calcul, dessine un avenir prometteur d'explosion des applications. Bien qu'il s'agisse d'un énorme coup de pouce pour le secteur Agent, la forte corrélation entre l'industrie, Wall Street et la politique de la Réserve fédérale a fait éclater la dernière bulle subsistante, faisant chuter la capitalisation du secteur à son plus bas niveau.

Dans la vague d'intégration de l'IA et de l'industrie, percées technologiques et jeux de marché vont toujours de pair. Les répercussions des fluctuations de la capitalisation de NVIDIA ont agi comme un miroir révélateur, exposant les difficultés profondes de la narration IA dans le secteur : derrière une cartographie écologique apparemment complète, allant des Agents on-chain aux moteurs DeFAI, se cachent une infrastructure technique fragile, une logique de valeur creuse et une réalité dominée par le capital. La prospérité apparente de l'écosystème on-chain dissimule des maladies latentes : de nombreux jetons à haute FDV se disputent une liquidité limitée, des actifs obsolètes survivent grâce à l'émotion FOMO, et les développeurs s'épuisent dans une concurrence stérile. Lorsque la croissance des capitaux et des utilisateurs atteint son plafond, l'ensemble du secteur tombe dans le « dilemme de l'innovateur » – aspirant désespérément à une rupture narrative, tout en étant incapable de rompre avec sa dépendance structurelle. Cette tension crée justement une opportunité historique pour l'Agent IA : il ne s'agit pas seulement d'une mise à niveau de la boîte à outils technique, mais d'une refonte du paradigme de création de valeur.

Au cours de l'année passée, de plus en plus d'équipes ont constaté que le modèle traditionnel de financement perd sa validité – le schéma consistant à céder une petite part à des VC, garder un contrôle total et attendre une cotation pour tirer les prix n'est plus viable. Avec les VC qui resserrent leur budget, les particuliers refusant de racheter, et les grandes bourses exigeant des seuils élevés pour la cotation, une nouvelle approche adaptée au marché baissier est en train d'émerger : s'associer à quelques KOL influents et à un petit nombre de VC, lancer massivement vers la communauté, et démarrer avec une faible capitalisation.

Des innovateurs comme Soon et Pump Fun ouvrent de nouvelles voies via le « lancement communautaire » – en s'associant à des KOL influents, ils distribuent directement 40 % à 60 % des jetons à la communauté, lançant le projet avec une FDV aussi basse que 10 millions de dollars, réalisant ainsi un financement de plusieurs millions. Ce modèle construit une FOMO de consensus via l'influence des KOL, permettant aux équipes de sécuriser des gains précocement, tout en échangeant une forte liquidité contre une profondeur de marché. Bien qu'ils renoncent à un contrôle à court terme, ils peuvent racheter les jetons à bas prix en période de marché baissier via des mécanismes de market making conformes. En substance, il s'agit d'un changement de paradigme dans la structure du pouvoir : passer d'un jeu de relais dominé par les VC (rachat institutionnel - cotation - vente aux particuliers) à un jeu transparent basé sur le consensus communautaire, où les équipes et la communauté forment une nouvelle relation symbiotique autour de la prime de liquidité. Alors que le secteur entre dans un cycle de révolution de la transparence, les projets attachés à la logique traditionnelle de contrôle deviendront les vestiges d'une ère dépassée.

La douleur à court terme du marché témoigne précisément de l'irréversibilité de la vague technologique à long terme. Quand l'Agent IA réduira le coût des interactions on-chain de deux ordres de grandeur, quand les modèles auto-adaptatifs optimiseront continuellement l'efficacité des capitaux dans les protocoles DeFi, le secteur pourrait enfin connaître l'adoption massive tant attendue. Cette transformation ne repose pas sur la spéculation conceptuelle ou la maturation accélérée par le capital, mais sur la pénétration technique ancrée dans des besoins réels – tout comme la révolution électrique n'a pas été arrêtée par la faillite des entreprises d'ampoules, l'Agent finira par devenir le véritable filon après l'éclatement de la bulle. Et DeFAI pourrait bien être le terrain fertile de cette renaissance. Lorsque l'inférence à faible coût deviendra quotidienne, nous verrons rapidement des cas d'utilisation combinant des centaines d'Agents en un seul Swarm. À puissance équivalente, l'augmentation significative du nombre de paramètres des modèles garantira que les Agents de l'ère open source puissent être finement ajustés, capables de décomposer des instructions complexes des utilisateurs en pipelines de tâches exécutables par des Agents individuels. Chaque Agent optimisant les opérations on-chain pourrait stimuler l'activité globale des protocoles DeFi et accroître la liquidité. Un plus grand nombre de produits DeFi complexes, menés par DeFAI, apparaîtront, marquant précisément l'endroit où de nouvelles opportunités émergent après l'éclatement de la précédente bulle.

Bienvenue dans la communauté officielle TechFlow

Groupe Telegram :https://t.me/TechFlowDaily

Compte Twitter officiel :https://x.com/TechFlowPost

Compte Twitter anglais :https://x.com/BlockFlow_News