Les géants se précipitent pour s'imposer, les fonds de capital-risque investissent à tour de bras : toutes ces entreprises s'engagent dans une course effrénée pour réaliser l'« intelligence artificielle capable de lire dans les pensées »

TechFlow SélectionTechFlow Sélection

Les géants se précipitent pour s'imposer, les fonds de capital-risque investissent à tour de bras : toutes ces entreprises s'engagent dans une course effrénée pour réaliser l'« intelligence artificielle capable de lire dans les pensées »

La première étape de l'IA pour bouleverser l'humanité : comprendre le cœur humain.

Rédaction : Lexie

Édition : Lu

Dans le grand débat sur l'IA, on lui attribue soit le rôle de notre assistant ultra-efficace, soit celui d'une « armée de machines » qui nous bouleverserait. Qu'elle soit amie ou ennemie, l'IA ne doit pas seulement accomplir les tâches que les humains lui confient, elle doit aussi être capable de « lire dans nos pensées ». Cette capacité à comprendre les émotions humaines est précisément devenue l'un des sujets phares du domaine de l'IA cette année.

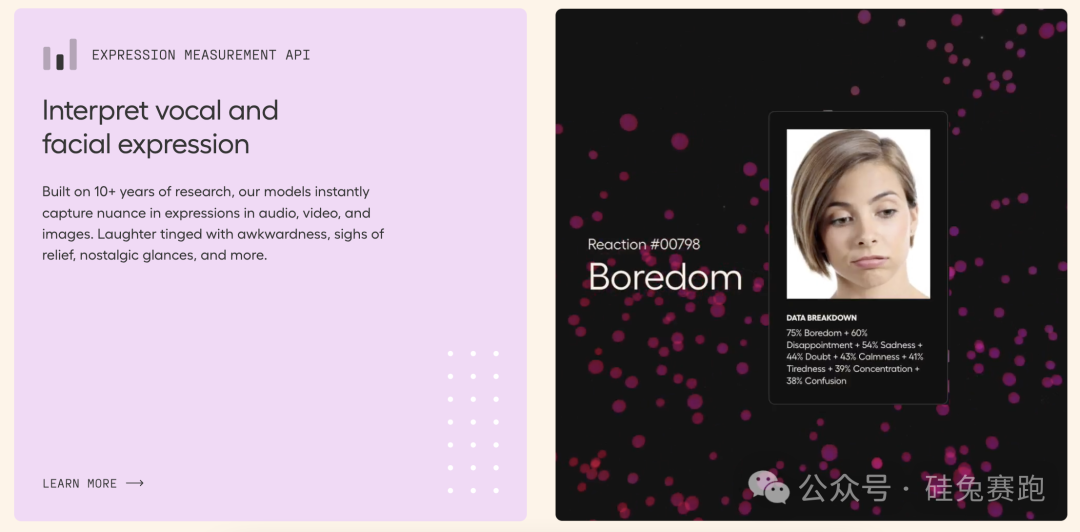

Dans le rapport 2024 de PitchBook sur les technologies émergentes dans les entreprises SaaS, l'« IA émotionnelle » (Emotion AI) s'est imposée comme une innovation majeure. Elle désigne l'utilisation du calcul émotionnel et des technologies d'intelligence artificielle pour percevoir, comprendre et interagir avec les émotions humaines. En analysant le texte, les expressions faciales, la voix et d'autres signaux physiologiques, elle tente de décoder les états émotionnels des individus. En résumé, l'IA émotionnelle vise à permettre aux machines de « comprendre les émotions », non seulement comme les humains, mais potentiellement mieux qu'eux.

Ses principales technologies comprennent :

-

Analyse des expressions faciales : grâce à des caméras, à la vision par ordinateur et à l'apprentissage profond, elle détecte les micro-expressions et les mouvements des muscles faciaux.

-

Analyse vocale : elle identifie l'état émotionnel à partir de la biométrie vocale, du ton et du rythme de la parole.

-

Analyse textuelle : elle utilise le traitement du langage naturel (NLP) pour interpréter les phrases et leur contexte.

-

Surveillance des signaux physiologiques : via des dispositifs portables, elle analyse le rythme cardiaque, les réactions cutanées, etc., afin d'améliorer la personnalisation et la richesse émotionnelle des interactions.

Emotion AI

L'IA émotionnelle découle de la technologie d'analyse émotionnelle, qui se concentrait principalement sur l'analyse des interactions textuelles — par exemple, extraire et analyser les émotions des utilisateurs sur les réseaux sociaux à partir de leurs messages. Grâce au soutien de l'IA, en intégrant plusieurs modes d'entrée tels que la vision et l'audio, l'IA émotionnelle promet une analyse émotionnelle plus précise et complète.

01 Les VC investissent massivement, les startups lèvent des fonds colossaux

TechFlow observe que le potentiel de l'IA émotionnelle attire un nombre croissant d'investisseurs. Des startups spécialisées comme Uniphore ou MorphCast ont déjà levé d'importants financements dans ce domaine.

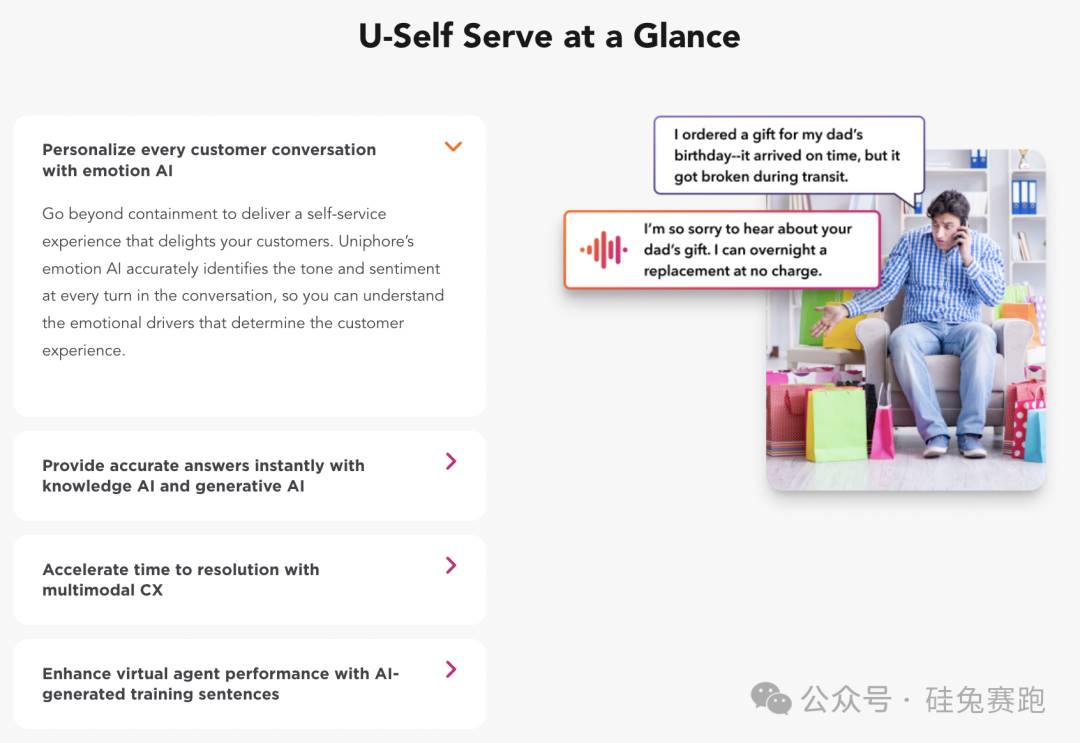

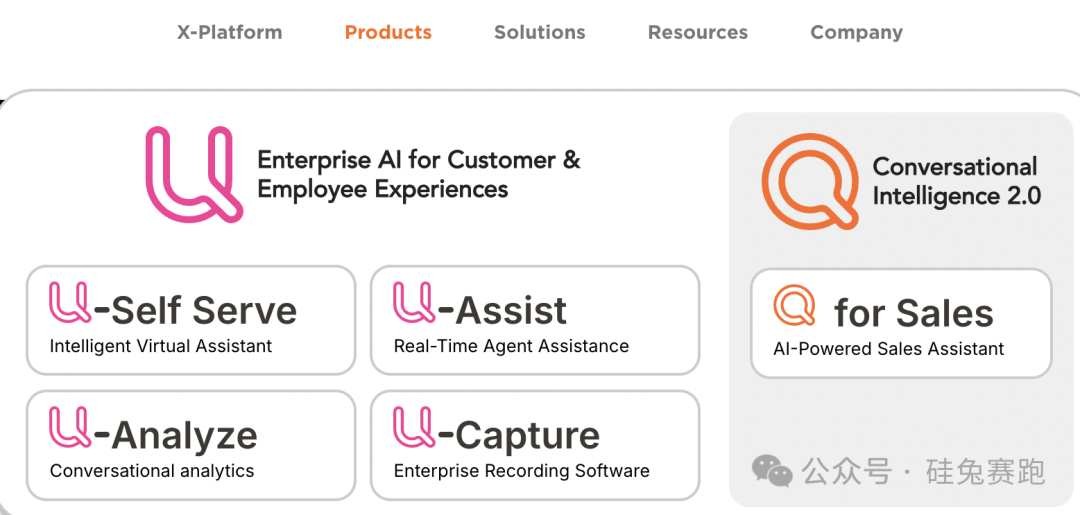

Fondée en Californie, Uniphore explore depuis 2008 des solutions d'automatisation conversationnelle pour les entreprises. Elle a développé plusieurs gammes de produits, notamment U-Self Serve, U-Assist, U-Capture et U-Analyze, aidant les clients à créer des interactions plus personnalisées et riches en émotions grâce aux technologies vocales, textuelles, visuelles et émotionnelles. U-Self Serve se distingue par sa capacité à identifier précisément les émotions et les tons dans les conversations, permettant aux entreprises d'offrir un service plus personnalisé et d'améliorer la satisfaction client.

U-Self Serve

U-Assist augmente l'efficacité des agents du service clientèle en fournissant des indications en temps réel et en automatisant les flux de travail. U-Capture collecte et analyse automatiquement les données émotionnelles, offrant aux entreprises une compréhension approfondie des besoins et du niveau de satisfaction des clients. Quant à U-Analyze, il aide les clients à identifier les tendances clés et les changements émotionnels dans les interactions, fournissant un soutien décisionnel basé sur les données pour renforcer la fidélité à la marque.

La technologie d'Uniphore ne vise pas simplement à faire comprendre le langage aux machines, mais à leur permettre de capter et d'interpréter les émotions dissimulées derrière le ton et les expressions pendant les interactions humaines. Cette capacité permet aux entreprises d'aller au-delà de simples réponses mécaniques pour mieux répondre aux besoins émotionnels des clients. L'utilisation d'Uniphore permettrait ainsi d'atteindre un taux de satisfaction client de 87 % et d'améliorer la performance du service client de 30 %.

À ce jour, Uniphore a levé plus de 620 millions de dollars. Son dernier tour de financement, réalisé en 2022, a été mené par NEA avec 400 millions de dollars, auxquels ont participé March Capital et d'autres investisseurs existants. Cette opération a valorisé l'entreprise à 2,5 milliards de dollars.

Uniphore

Hume AI, quant à elle, a lancé le premier assistant vocal empathique au monde. Fondée par Alan Cowen, ancien scientifique chez Google, célèbre pour avoir développé la théorie de l'espace sémantique émotionnel. Cette théorie révèle les subtilités de la voix, du visage et des gestes afin de comprendre l'expérience et l'expression des émotions. Les travaux de Cowen ont été publiés dans des revues prestigieuses telles que « Nature » et « Trends in Cognitive Sciences », couvrant à ce jour les échantillons d'émotions les plus vastes et diversifiés jamais étudiés.

Inspirée par ces recherches, Hume a développé une API vocale conversationnelle appelée EVI. Combinant grands modèles linguistiques et algorithmes d'empathie, EVI peut comprendre en profondeur l'état émotionnel humain. Non seulement elle reconnaît les émotions dans la voix, mais elle produit également des réponses plus nuancées et personnalisées lors des interactions avec les utilisateurs. Les développeurs peuvent intégrer ces fonctionnalités en quelques lignes de code dans n'importe quelle application.

Hume AI

L'une des limites majeures des systèmes d'IA actuels réside dans le fait que leurs instructions proviennent essentiellement des humains, ce qui introduit des erreurs et empêche d'exploiter pleinement le potentiel de l'IA. Le modèle de langage empathique (eLLM) développé par Hume adapte ses mots et son ton selon le contexte et l'expression émotionnelle de l'utilisateur. En prenant le bonheur humain comme principe fondamental de l'apprentissage, de l'ajustement et de l'interaction, il offre une expérience plus naturelle et authentique dans des domaines variés tels que la santé mentale, la formation, les appels d'urgence ou encore l'analyse de marque.

En mars dernier, Hume AI a levé 50 millions de dollars lors d'un tour de série B mené par EQT Ventures. Parmi les autres investisseurs figurent Union Square Ventures, Nat Friedman & Daniel Gross, Metaplanet et Northwell Holdings.

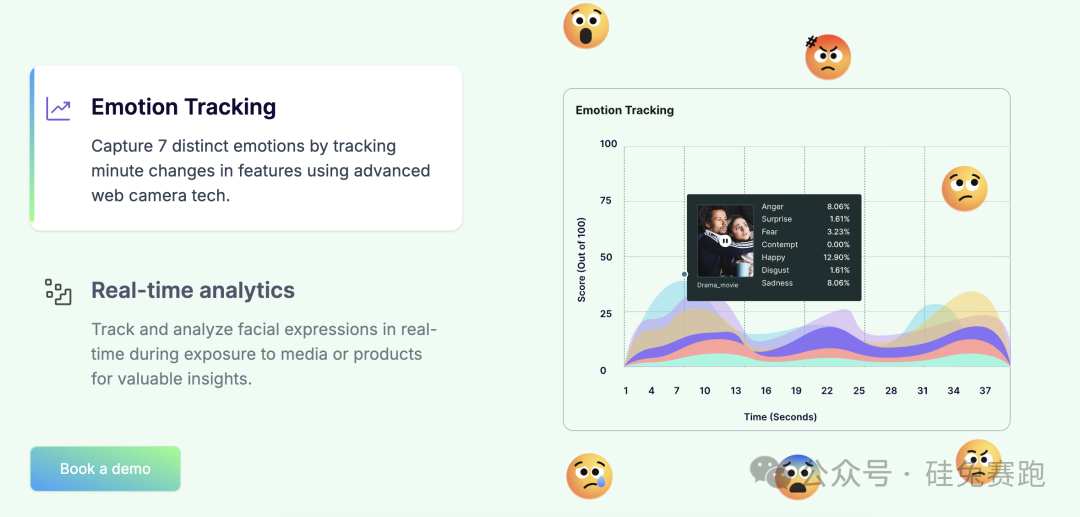

D'autres acteurs, comme Entropik, se concentrent spécifiquement sur la mesure des réactions cognitives et émotionnelles des consommateurs. Grâce à sa fonction « Decode », qui combine IA émotionnelle, IA comportementale, IA générative et IA prédictive, Entropik parvient mieux à comprendre les comportements et préférences des consommateurs, proposant ainsi des recommandations marketing plus personnalisées. En février 2023, Entropik a levé 25 millions de dollars lors d'un tour de série B, avec SIG Venture Capital et Bessemer Venture Partners parmi ses investisseurs.

Entropik

02 Les géants entrent en jeu, concurrence féroce

Les grandes entreprises technologiques, profitant de leurs avantages structurels, se positionnent également sur le créneau de l'IA émotionnelle.

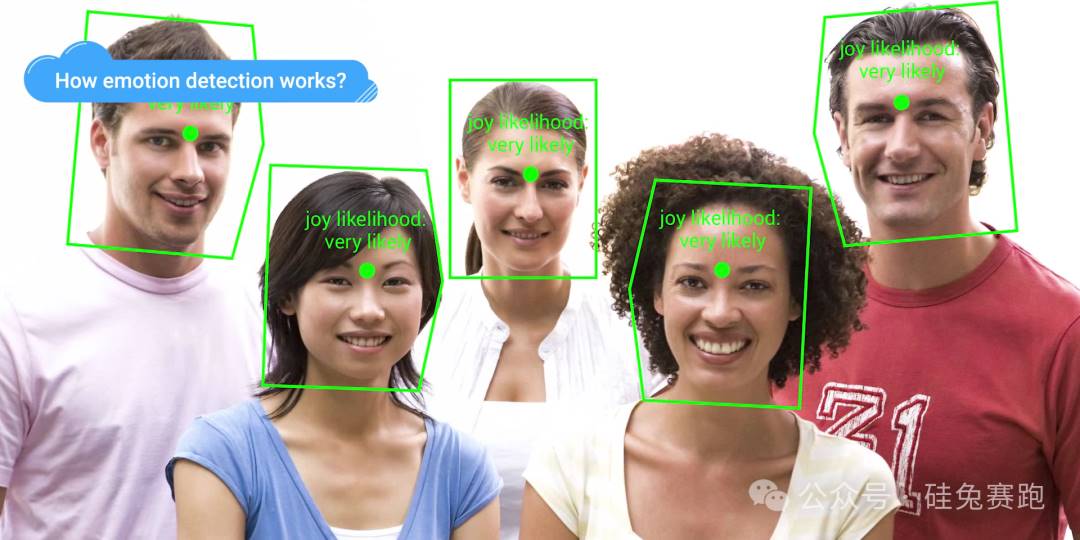

Par exemple, Microsoft Azure propose une API de détection des émotions dans ses services cognitifs, capable d'identifier des émotions telles que la joie, la colère, la tristesse ou la surprise dans des images et vidéos, en analysant les expressions faciales.

IBM Watson dispose d'une API de compréhension du langage naturel qui traite de grandes quantités de données textuelles pour identifier les orientations émotionnelles (positives, négatives ou neutres), permettant ainsi une interprétation plus précise des intentions des utilisateurs.

Google Cloud AI intègre dans son Cloud Vision API des fonctions puissantes d'analyse d'images, capables d'identifier rapidement les expressions émotionnelles dans les photos, tout en supportant la reconnaissance de texte et l'association aux émotions.

AWS Rekognition peut également détecter les émotions, identifier les traits du visage, suivre l'évolution des expressions, et s'intégrer à d'autres services AWS pour former des solutions complètes d'analyse des médias sociaux ou de marketing pilotées par l'IA émotionnelle.

Cloud Vision API

Certaines startups progressent si rapidement dans le domaine de l'IA émotionnelle que même les géants du secteur cherchent à les racheter ou à recruter leurs talents. Par exemple, Microsoft a porté un vif intérêt à l'équipe IA et aux modèles d'Inflection AI, une startup devenue licorne. Après avoir investi 1,3 milliard de dollars aux côtés de Bill Gates, Eric Schmidt et NVIDIA, Microsoft a fait une offre à Mustafa Suleyman, figure de proue de l'IA et co-fondateur d'Inflection AI. Celui-ci, accompagné de plus de 70 employés, a rejoint Microsoft, pour lequel cette opération a coûté près de 650 millions de dollars.

Cependant, Inflection AI s'est rapidement redressée en formant une nouvelle équipe composée de talents venant de Google Translate, de conseil en IA et de réalité augmentée, continuant à développer activement son produit phare, Pi. Ce dernier est un assistant personnel capable de comprendre et de répondre aux émotions des utilisateurs. Contrairement aux IA traditionnelles, Pi met l'accent sur l'établissement d'un lien émotionnel avec l'utilisateur, montrant de l'empathie dans les dialogues après avoir perçu les émotions à travers la voix ou le texte. Inflection AI conçoit Pi comme un coach, un confident, un auditeur et un partenaire créatif, bien plus qu'un simple assistant IA. En outre, Pi dispose d'une mémoire puissante lui permettant de se souvenir de l'historique des conversations précédentes, améliorant ainsi la continuité et la personnalisation de l'interaction.

Inflection AI Pi

03 Développement en suspens : espoirs et critiques

Bien que l'IA émotionnelle incarne notre aspiration à des interactions plus humaines, comme toutes les technologies d'IA, son déploiement suscite à la fois intérêt et scepticisme. Premièrement, l'IA émotionnelle est-elle vraiment capable d'interpréter fidèlement les émotions humaines ? Théoriquement, cette technologie pourrait enrichir considérablement l'expérience utilisateur, mais en pratique, les émotions humaines sont fondamentalement floues et subjectives. Dès 2019, des chercheurs ont remis en question cette technologie, affirmant que les expressions faciales ne reflètent pas de manière fiable les véritables émotions humaines. Ainsi, compter uniquement sur des machines pour simuler les expressions, postures et intonations humaines comporte des limites importantes.

Deuxièmement, la réglementation stricte constitue un obstacle constant au développement de l'IA. Par exemple, la loi européenne sur l'IA interdit l'utilisation de systèmes de détection émotionnelle par vision informatique dans des domaines comme l'éducation, ce qui pourrait limiter certaines applications de l'IA émotionnelle. Des États américains comme l'Illinois ont également adopté des lois interdisant la collecte de données biométriques sans autorisation préalable, restreignant directement les conditions d'utilisation de certaines technologies d'IA émotionnelle. En outre, la confidentialité et la protection des données constituent un enjeu majeur. L'IA émotionnelle étant souvent utilisée dans des secteurs sensibles comme l'éducation, la santé ou l'assurance — où la protection des données est cruciale —, garantir la sécurité et l'usage légal des données émotionnelles est un défi incontournable pour toute entreprise du secteur.

Enfin, la communication et l'interprétation des émotions varient fortement selon les cultures et les régions, ce qui représente un défi complexe même pour les humains — et encore davantage pour l'IA. Les différences dans la perception et l'expression des émotions selon les zones géographiques peuvent affecter l'efficacité et la fiabilité des systèmes d'IA émotionnelle. De plus, ces systèmes peuvent rencontrer des difficultés notables dans la gestion des biais raciaux, de genre ou liés à l'identité de genre.

L'IA émotionnelle promet à la fois efficacité en réduisant la main-d'œuvre humaine et attention aux émotions, mais parviendra-t-elle à devenir une solution universelle dans les interactions humaines, ou finira-t-elle par ressembler à Siri, un assistant intelligent aux performances médiocres dans les tâches exigeant une véritable compréhension émotionnelle ? Peut-être que la « lecture de pensée » de l'IA révolutionnera un jour les interactions homme-machine, voire entre humains. Mais pour l'instant, comprendre et répondre véritablement aux émotions humaines nécessite probablement encore davantage la participation humaine et une grande prudence.

Bienvenue dans la communauté officielle TechFlow

Groupe Telegram :https://t.me/TechFlowDaily

Compte Twitter officiel :https://x.com/TechFlowPost

Compte Twitter anglais :https://x.com/BlockFlow_News