Domaine négligé du modularité : les couches d'exécution, de règlement et d'agrégation

TechFlow SélectionTechFlow Sélection

Domaine négligé du modularité : les couches d'exécution, de règlement et d'agrégation

Les piles modulaires ne se limitent pas à la disponibilité des données et aux couches de classement comme seuls éléments dignes d'intérêt.

Rédaction : Bridget Harris

Traduction : Luffy, Foresight News

En termes d'attention et d'innovation, tous les composants de la pile modulaire ne se valent pas. Bien que de nombreux projets aient déjà innové au niveau de la disponibilité des données (DA) et de la couche de séquençage, ce n'est que récemment que les couches d'exécution et de règlement ont commencé à être prises en compte comme parties intégrantes de la pile modulaire.

Le marché des séquenceurs partagés est fortement concurrentiel, avec de nombreux projets tels qu'Espresso, Astria, Radius, Rome ou Madara qui luttent pour conquérir des parts de marché. S'ajoutent à cela des fournisseurs de RaaS comme Caldera et Conduit, qui développent des séquenceurs partagés pour les Rollups construits sur leurs infrastructures. Ces fournisseurs RaaS peuvent proposer des frais plus avantageux aux Rollups car leur modèle économique sous-jacent ne dépend pas entièrement des revenus générés par le séquençage. De nombreux Rollups choisissent toutefois d’exploiter leurs propres séquenceurs afin de percevoir directement ces revenus.

Contrairement au domaine de la DA, le marché des séquenceurs présente des particularités uniques. Le secteur de la DA est essentiellement un oligopole dominé par Celestia, Avail et EigenDA, rendant extrêmement difficile pour de nouveaux entrants plus petits de réussir à perturber ce domaine. Les projets doivent soit utiliser une solution existante (comme Ethereum), soit choisir parmi les couches de DA matures selon leur type de pile technologique et leurs besoins en cohérence. Bien que l'utilisation d'une couche DA permette de réaliser d'importantes économies, externaliser la partie séquençage n'est pas une décision évidente (du point de vue des frais, pas de la sécurité), principalement en raison du coût d'opportunité lié à l'abandon des revenus générés par le séquençage. Beaucoup pensent également que la DA deviendra une commodité, mais dans le domaine de la cryptographie, nous constatons que des barrières de liquidité exceptionnelles combinées à des technologies sous-jacentes uniques (difficiles à reproduire) rendent extrêmement difficile la transformation d’une couche de la pile en simple produit standardisé. Quelles que soient ces discussions, de nombreux produits de DA et de séquençage sont en cours de lancement. En résumé, pour certaines piles modulaires, « chaque service dispose de plusieurs concurrents ».

Je pense que les couches d’exécution et de règlement (ainsi que d’agrégation) restent relativement sous-explorées, mais commencent maintenant à être itérées différemment afin de mieux s’intégrer au reste de la pile modulaire.

Relation entre les couches d’exécution et de règlement

Les couches d'exécution et de règlement sont étroitement intégrées, la couche de règlement servant à définir le résultat final de l'état après exécution. Elle peut également renforcer les résultats de la couche d'exécution, rendant ainsi celle-ci plus puissante et plus sécurisée. Cela peut prendre diverses formes concrètes : par exemple, la couche de règlement peut servir d’environnement pour résoudre les litiges de fraude, valider des preuves et interconnecter différentes couches d'exécution.

Il convient de noter que certaines équipes intègrent directement dans leurs protocoles le développement d'environnements d'exécution personnalisés. Repyh Labs en est un exemple, en construisant un L1 appelé Delta. Cette approche constitue fondamentalement une conception opposée à celle de la pile modulaire, mais elle offre néanmoins une grande flexibilité au sein d’un environnement unifié, avec un avantage technique majeur : les équipes n’ont pas besoin de passer du temps à intégrer manuellement chaque composant de la pile modulaire. Bien sûr, l’inconvénient est qu’elles sont isolées en termes de liquidité, ne peuvent pas choisir les couches modulaires les mieux adaptées à leur conception, et que les coûts sont élevés.

D'autres équipes choisissent plutôt de construire un L1 centré sur une fonctionnalité ou une application clé. Hyperliquid en est un exemple, ayant conçu un L1 dédié à sa plateforme phare (un échange de contrats perpétuels). Bien que ses utilisateurs doivent franchir un pont depuis Arbitrum, son architecture centrale ne repose ni sur Cosmos SDK ni sur un autre cadre existant, lui permettant ainsi une personnalisation et une optimisation poussées pour son cas d’utilisation principal.

Avancées au niveau de la couche d’exécution

Lors du dernier cycle, la seule caractéristique des alt-L1 généralistes surpassant Ethereum était un débit supérieur. Cela signifiait que si un projet voulait améliorer significativement ses performances, il devait presque inévitablement construire son propre L1 à partir de zéro, car Ethereum ne disposait pas encore de cette technologie. Historiquement, cela impliquait simplement d'intégrer des mécanismes d'efficacité directement dans des protocoles généralistes. Ce cycle-ci, ces améliorations de performance sont réalisées grâce à une conception modulaire, directement sur la principale plateforme de contrats intelligents qu'est Ethereum. Ainsi, tant les projets existants que les nouveaux peuvent tirer parti de nouvelles infrastructures d'exécution sans sacrifier la liquidité, la sécurité et les avantages communautaires d'Ethereum.

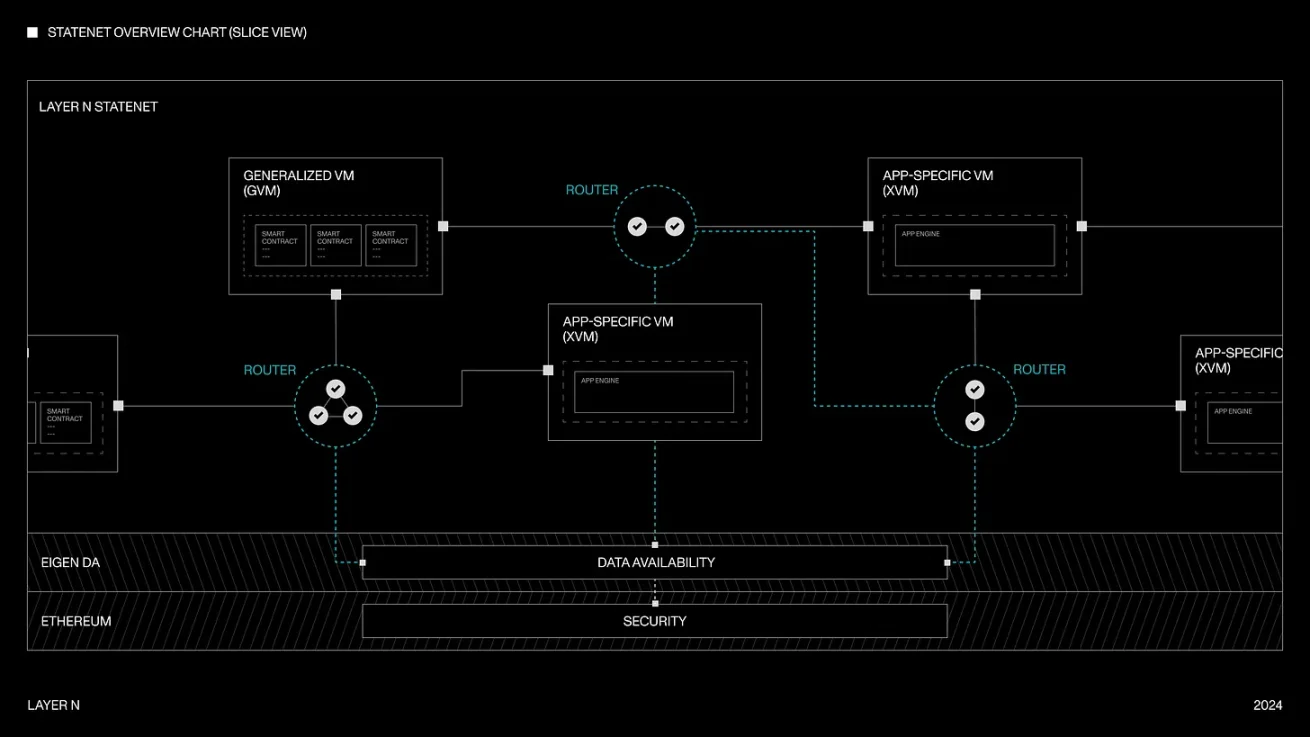

Actuellement, on observe aussi une augmentation croissante du mixage et de l’appariement de différentes machines virtuelles (environnements d'exécution) au sein de réseaux partagés, offrant ainsi plus de souplesse aux développeurs et une meilleure personnalisation au niveau de la couche d’exécution. Par exemple, Layer N permet aux développeurs d’exécuter sur sa machine d’état partagée des nœuds de Rollup génériques (comme SolanaVM, MoveVM, etc.) ou des nœuds de Rollup spécifiques à une application (par exemple, DEX de contrats perpétuels, DEX à livres d’ordres). Ils travaillent également à assurer une composable complète et un partage total de la liquidité entre ces différentes architectures de VM — un problème d’ingénierie blockchain historiquement difficile à résoudre à grande échelle. Chaque application sur Layer N peut transmettre des messages de manière asynchrone sans latence au niveau du consensus, ce qui évite généralement le « surcoût de communication » dans la cryptographie. Chaque xVM peut aussi utiliser différentes architectures de bases de données, qu’il s’agisse de RocksDB, LevelDB ou de bases de données synchrones/asynchrones personnalisées créées de toutes pièces. L’interopérabilité fonctionne via un « système de snapshots » (algorithme similaire à celui de Chandy-Lamport), permettant aux chaînes de passer à un nouveau bloc de manière asynchrone sans interruption du système. Sur le plan de la sécurité, des preuves de fraude peuvent être soumises si une transition d’état est incorrecte. Grâce à cette conception, leur objectif est de minimiser le temps d’exécution tout en maximisant le débit global du réseau.

Layer N

Pour pousser davantage la personnalisation, Movement Labs utilise le langage Move (initialement conçu par Facebook et utilisé par des réseaux comme Aptos et Sui) pour la VM / l'exécution. Move présente des avantages structurels par rapport à d'autres frameworks, notamment en matière de sécurité et de flexibilité pour les développeurs — deux problèmes majeurs historiquement rencontrés lors de la construction d'applications blockchain avec les technologies existantes. Il est important de noter que les développeurs peuvent aussi simplement écrire en Solidity et déployer sur Movement. Pour y parvenir, Movement a créé un runtime EVM entièrement compatible au niveau du bytecode, pouvant être utilisé conjointement avec la pile Move. Leur Rollup M2 exploite le parallélisme BlockSTM, permettant un débit plus élevé tout en conservant l'accès au fossé de liquidité d'Ethereum (historiquement, BlockSTM était uniquement utilisé par des alt-L1 comme Aptos, qui manquaient clairement de compatibilité EVM).

MegaETH fait aussi progresser le domaine de la couche d’exécution, notamment via son moteur de parallélisation et sa base de données en mémoire, où le séquenceur peut stocker tout l’état en mémoire. Sur le plan architectural, ils utilisent :

-

La compilation en code natif, offrant des performances supérieures au niveau du L2 (accélération importante pour les contrats intensifs en calcul, et toujours un gain d’au moins 2 fois pour les contrats moins intensifs).

-

Une production de blocs relativement centralisée, mais une validation et une confirmation décentralisées.

-

Une synchronisation d’état efficace, où les nœuds complets n’ont pas besoin de rejouer les transactions, mais doivent connaître les deltas d’état applicables à leur base de données locale.

-

Une structure de mise à jour des arbres de Merkle (généralement gourmande en stockage), alors que leur méthode repose sur une nouvelle structure de données trie, efficace à la fois en mémoire et sur disque. Le calcul en mémoire leur permet de compresser l’état de la chaîne en mémoire, de sorte que lors de l’exécution des transactions, elles accèdent uniquement à la mémoire et non au disque.

Un autre aspect récemment exploré et itéré dans le cadre de la pile modulaire est l’agrégation de preuves : définie comme un prouveur qui crée une preuve concise unique à partir de plusieurs preuves concises. Commençons par examiner globalement la couche d’agrégation, son histoire et les tendances actuelles dans le domaine de la cryptographie.

Valeur de la couche d’agrégation

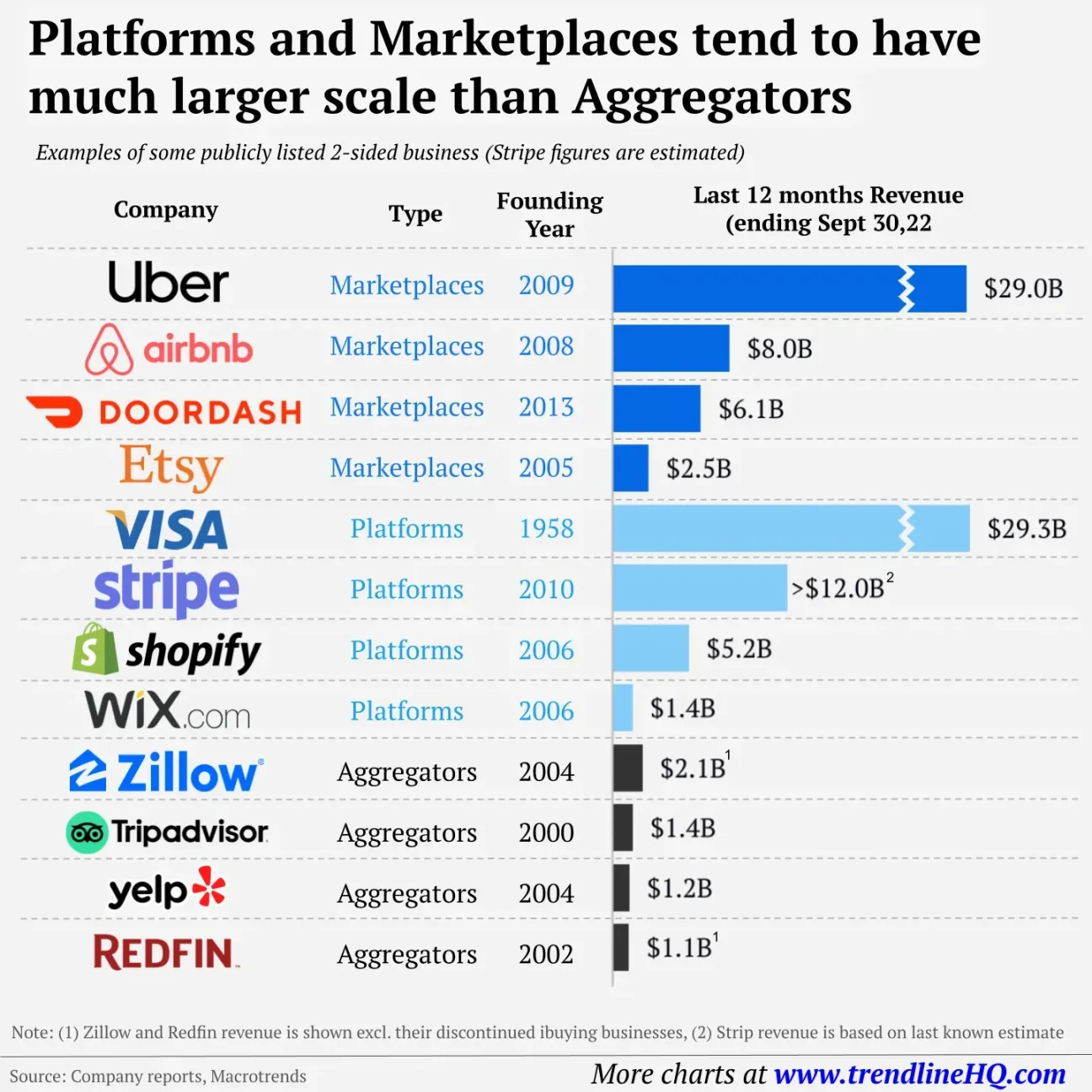

Historiquement, sur les marchés non-cryptographiques, la part de marché des agrégateurs est inférieure à celle des plateformes :

Bien que je ne sois pas certain que cela s’applique à tous les cas de la cryptographie, cela reste vrai pour les DEX, les ponts multichaînes et les protocoles de prêt.

Par exemple, la capitalisation boursière combinée de 1inch et 0x (deux principaux agrégateurs de DEX) est d’environ 1 milliard de dollars, bien inférieure à celle d’Uniswap (environ 7,6 milliards). La situation est similaire pour les ponts multichaînes : comparés à des plateformes comme Across, les agrégateurs de ponts tels que Li.Fi ou Socket/Bungee ont une part de marché moindre. Bien que Socket supporte 15 ponts différents, son volume total de transactions est en réalité comparable à celui d’Across (Socket : 2,2 milliards, Across : 1,7 milliard), alors qu’Across ne représente qu’une petite fraction du volume récent de Socket/Bungee.

Dans le domaine du prêt, Yearn Finance fut le premier protocole de rendement agrégé décentralisé, avec une capitalisation actuelle d’environ 250 millions de dollars. Comparativement, des plateformes comme Aave (~1,4 milliard) et Compound (~560 millions) ont des valorisations bien plus élevées.

Le marché financier traditionnel suit une tendance similaire. Par exemple, ICE US et le groupe CME ont chacun une capitalisation d’environ 75 milliards de dollars, tandis que des « agrégateurs » comme Charles Schwab ou Robinhood ont respectivement environ 132 milliards et 15 milliards. Chez Schwab, qui route les ordres clients vers de nombreux marchés dont ICE et CME, le volume routé via ces derniers est disproportionné par rapport à leur part de marché. Robinhood traite environ 119 millions de contrats d'options mensuellement, contre environ 35 millions pour ICE — or, les options ne représentent même pas le cœur du modèle économique de Robinhood. Malgré cela, ICE est valorisé environ cinq fois plus que Robinhood sur le marché public. Ainsi, en tant qu'interfaces d'agrégation applicatives, Schwab et Robinhood dirigent les flux d'ordres de leurs clients vers divers marchés, mais malgré leur volume élevé, leurs valorisations restent inférieures à celles d'ICE et du CME.

En tant que consommateurs, nous accordons peu de valeur aux agrégateurs.

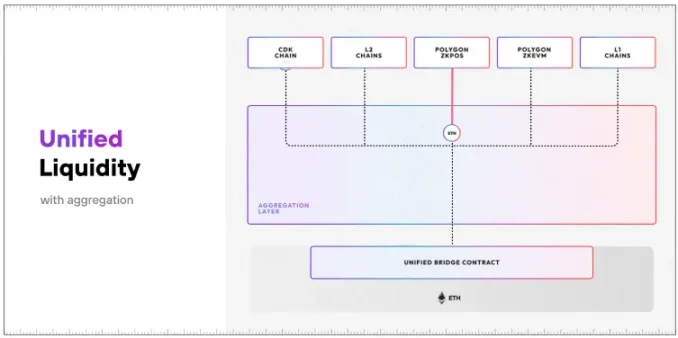

Cependant, cette règle pourrait ne pas s’appliquer en cryptographie si la couche d’agrégation est intégrée directement au produit / plateforme / chaîne. Si l’agrégateur est étroitement intégré à la chaîne, il s’agit clairement d’une architecture différente, et j’aimerais voir comment cela va évoluer. Un exemple est AggLayer de Polygon, qui permet aux développeurs de connecter facilement leurs L1 et L2 en un seul réseau capable d’agréger des preuves et d’offrir une couche de liquidité unifiée entre les chaînes utilisant CDK.

AggLayer

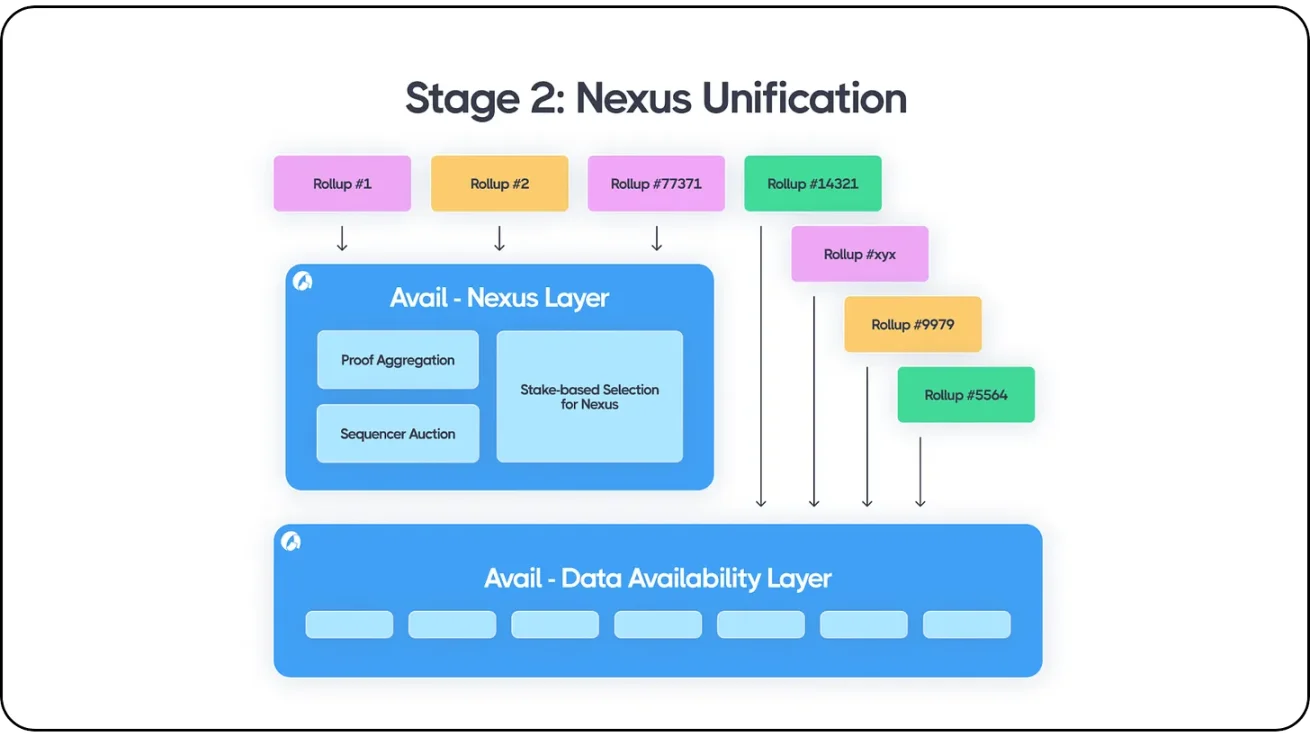

Ce modèle fonctionne de manière similaire à la couche d’interopérabilité Nexus d’Avail, qui inclut l’agrégation de preuves et un mécanisme d’enchères de séquençage, renforçant ainsi son produit de DA. À l’instar d’AggLayer de Polygon, chaque chaîne ou Rollup intégré à Avail peut interagir au sein de l’écosystème existant d’Avail. De plus, Avail regroupe les données de transactions ordonnées provenant de diverses plateformes blockchain et Rollups, y compris Ethereum, tous les Rollups Ethereum, les chaînes Cosmos, les Rollups Avail, les Rollups Celestia, ainsi que différentes structures hybrides telles que Validiums, Optimiums et les parachains Polkadot. Les développeurs de n’importe quel écosystème peuvent construire librement sur la couche DA d’Avail tout en utilisant Avail Nexus, qui permet l’agrégation de preuves et l’échange de messages entre écosystèmes.

Avail Nexus

Nebra se concentre sur l’agrégation de preuves et le règlement, avec la capacité d’agréger entre différents systèmes de preuves. Par exemple, agréger les preuves du système xyz et du système abc pour obtenir agg_xyzabc (plutôt qu’agréger à l’intérieur de chaque système, obtenant ainsi agg_xyz et agg_abc). Cette architecture utilise UniPlonK, qui normalise le travail du vérificateur pour les séries de circuits, rendant ainsi la vérification des preuves entre différents circuits PlonK plus efficace et faisable. En substance, elle utilise la preuve à divulgation nulle elle-même (SNARK récursif) pour étendre la partie vérification, généralement le goulot d’étranglement dans ces systèmes. Pour les clients, le règlement « dernière étape » devient plus simple, car Nebra gère toute l’agrégation par lots et le règlement ; les équipes doivent seulement modifier l’appel de contrat API.

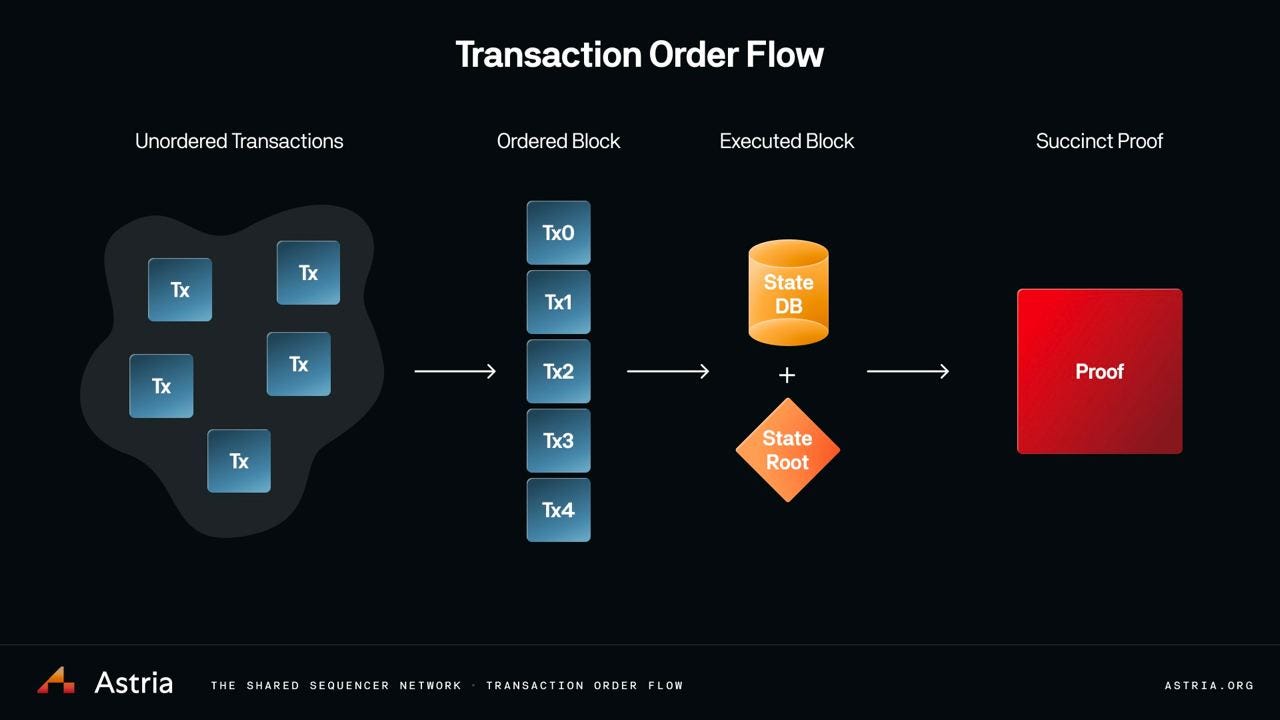

Astria explore également des conceptions intéressantes, notamment la façon dont leur séquenceur partagé peut fonctionner conjointement avec l’agrégation de preuves. Ils laissent la partie exécution aux Rollups eux-mêmes, qui exécutent un logiciel de couche d’exécution sur un espace de noms donné du séquenceur partagé, ce qui constitue essentiellement une « API d’exécution », une manière pour le Rollup de recevoir les données de la couche de séquençage. Ils peuvent également facilement ajouter ici un support pour les preuves de validité afin de garantir que les blocs ne violent pas les règles de la machine d’état EVM.

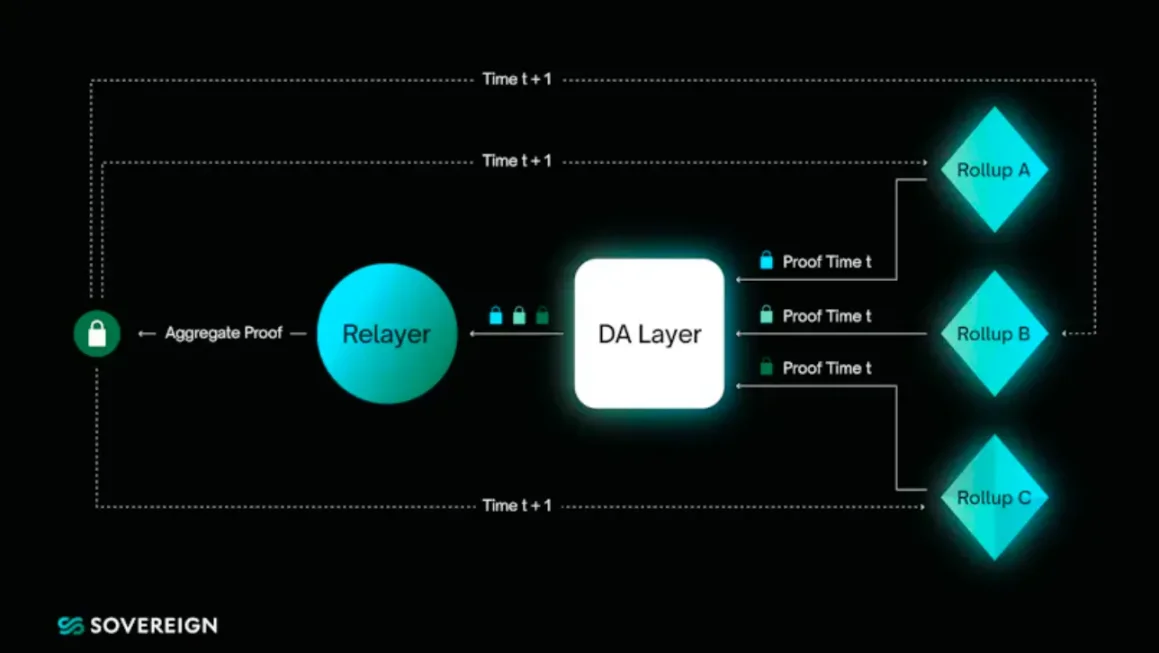

Ici, un produit comme Astria joue le rôle du processus #1 → #2 (transactions non ordonnées → blocs ordonnés), le nœud de couche d’exécution/Rollup correspond à #2 → #3, et un protocole comme Nebra agit comme la dernière étape #3 → #4 (blocs exécutés → preuve concise). Nebra pourrait aussi représenter un cinquième pas théorique, où les preuves sont agrégées puis validées. Sovereign Labs travaille également sur un concept similaire à cette dernière étape, où les ponts basés sur l’agrégation de preuves sont au cœur de leur architecture.

Globalement, certaines applications commencent à posséder des infrastructures sous-jacentes, en partie parce que conserver uniquement l’application de niveau supérieur sans contrôler la pile sous-jacente peut poser des problèmes d’incitation et entraîner des coûts élevés d’adoption utilisateur. D’un autre côté, la concurrence et les progrès technologiques continuent de réduire les coûts des infrastructures, rendant l’intégration des applications / chaînes d’applications aux composants modulaires de plus en plus abordable. Je crois que cette dynamique deviendra encore plus forte, du moins pour le moment.

Grâce à toutes ces innovations (couche d’exécution, couche de règlement, couche d’agrégation), une efficacité accrue, une intégration facilitée, une meilleure interopérabilité et des coûts réduits deviennent possibles. Tout cela se traduit finalement par de meilleures applications pour les utilisateurs et une meilleure expérience de développement. C’est une combinaison gagnante, susceptible de stimuler davantage d’innovations et d’accélérer leur rythme.

Bienvenue dans la communauté officielle TechFlow

Groupe Telegram :https://t.me/TechFlowDaily

Compte Twitter officiel :https://x.com/TechFlowPost

Compte Twitter anglais :https://x.com/BlockFlow_News