Google dévoile son « atout multimodal » Gemini, peut-il vraiment surpasser GPT-4 ?

TechFlow SélectionTechFlow Sélection

Google dévoile son « atout multimodal » Gemini, peut-il vraiment surpasser GPT-4 ?

Gemini constituera une concurrence solide pour GPT-4 en matière de compréhension des données complexes et d'exécution de tâches avancées.

Rédaction : Mu Mu

« Le plus grand », « le plus performant », « le meilleur », « le plus efficace » : Google a accolé plusieurs superlatifs à son nouveau modèle multimodal Gemini, dévoilé le 7 décembre, affichant clairement son ambition de surpasser GPT-4 d’OpenAI.

Divisé en trois versions — Ultra, Pro et Nano —, Gemini prétend non seulement obtenir de hauts scores dans divers « examens d’IA », mais apparaît dans les vidéos de démonstration comme un « outil superpuissant » maîtrisant parfaitement la compréhension orale, l’expression orale, la lecture et l’écriture.

Selon Google, Gemini Ultra est le plus puissant, combinant des capacités multimodales, une grande précision et un haut niveau d’expertise. Capable d’entrées-sorties textuelles, visuelles ou vocales, il peut notamment corriger des devoirs de mathématiques, analyser les mouvements et la technique d’un sportif, exécuter des tâches complexes telles que la création de graphiques ou la génération de code, et aurait même « surpassé les experts humains » dans le test MMLU (Massive Multitask Language Understanding).

Actuellement, seuls les utilisateurs grand public peuvent accéder à Gemini Pro, présenté comme « le meilleur modèle pour une large gamme de tâches », intégré au robot conversationnel Bard déjà lancé par Google. Quant à Gemini Nano, décrit comme « le modèle le plus efficace pour les tâches exécutées sur appareil », il sera intégré aux smartphones Pixel 8 Pro. Enfin, Gemini Ultra, « le plus grand et le plus capable, conçu pour des tâches très complexes », devrait être ouvert aux développeurs et entreprises au début de l’année prochaine.

Gemini est-il vraiment supérieur à GPT-4 ?

Certains internautes ont remarqué que les résultats annoncés par Google pour Gemini Ultra sont basés sur ses propres méthodes d’évaluation ; Bloomberg souligne que la vidéo de démonstration n’est pas en temps réel, et de nombreux observateurs y détectent des montages évidents.

Un test effectué par Metaverse Daily sur les capacités mathématiques de Bard, qui intègre désormais une version optimisée de Gemini Pro, montre que le chatbot commet encore des erreurs de compréhension, en particulier dans l’analyse d’images.

Google présente les capacités « écouter, parler, lire, écrire » de Gemini

Gemini est un grand modèle d’intelligence artificielle multimodal entièrement conçu par Google. Bien qu’il soit sorti plus tardivement que GPT-4, il est présenté comme le « plus puissant », notamment grâce à ses capacités multimodales.

Il peut traiter et analyser simultanément du texte, des images, de l’audio, de la vidéo et du code. Autrement dit, les utilisateurs peuvent lui fournir des informations sous divers formats : Gemini est capable non seulement de les comprendre, mais aussi de les analyser et d’exécuter des tâches selon les demandes.

Pour l’instant, Gemini en version 1.0 se décline en trois tailles : Ultra, Pro et Nano. La version Ultra est destinée aux tâches très complexes, Pro aux tâches multiples, et Nano aux applications mobiles. Ces trois versions ciblent différents scénarios d’utilisation et ont montré des performances remarquables dans plusieurs tests de référence.

La vidéo promotionnelle officielle de Google illustre les capacités impressionnantes de Gemini. Après l’avoir vue, on ne peut qu’être stupéfait.

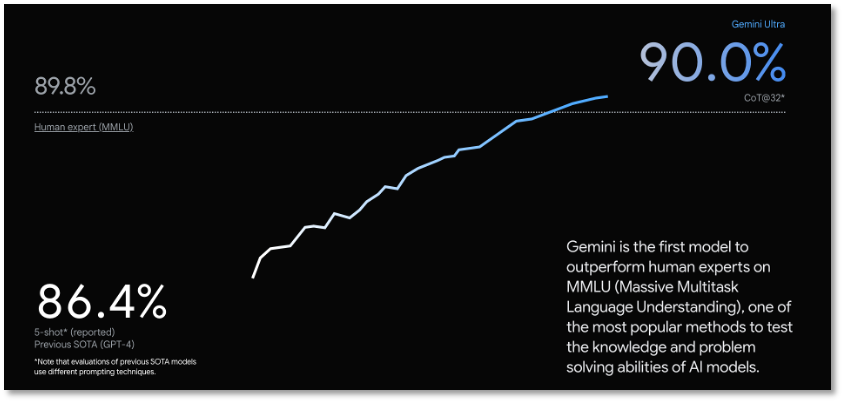

Les performances exceptionnelles de Gemini Ultra s’appuient sur des données de tests publiées par Google. Sur 32 benchmarks académiques couramment utilisés pour évaluer les grands modèles linguistiques (LLM), il dépasse les performances actuelles de la technologie dans 30 cas.

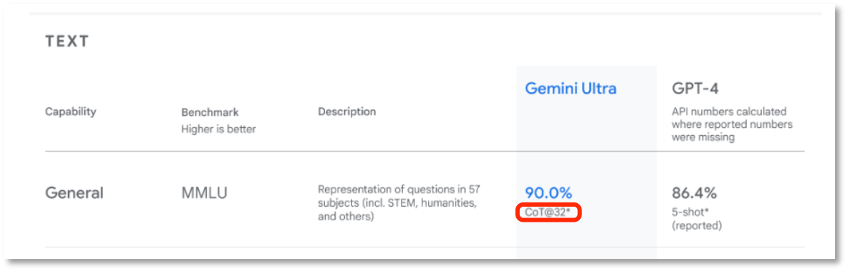

Gemini Ultra revendique un score de 90,0 % sur le test MMLU (Massive Multitask Language Understanding), devenant ainsi le premier modèle à « surpasser les experts humains ». Ce test évalue les connaissances générales et la capacité à résoudre des problèmes à travers 57 disciplines, incluant les mathématiques, la physique, l’histoire, le droit, la médecine et l’éthique. Gemini surpasse également les technologies actuelles dans une série de benchmarks, y compris le traitement de texte et la génération de code.

Le MMLU est une évaluation courante de la compréhension linguistique des grands modèles, composée de questions à choix multiples couvrant 57 domaines de connaissances humaines, allant des mathématiques élémentaires à l’histoire américaine, en passant par l’informatique ou le droit, avec des niveaux de difficulté allant du lycée à l’expertise spécialisée. C’est l’un des principaux benchmarks pour mesurer la compréhension sémantique des modèles.

D’après les résultats communiqués par Google, Gemini constitue une concurrence sérieuse à GPT-4 dans la compréhension de données complexes et l’exécution de tâches avancées.

Google affirme que Gemini a surpassé les experts humains dans le test MMLU

Conçu dès le départ pour l’entraînement multimodal, Gemini Ultra peut théoriquement interpréter tous types d’informations — texte, image, voix, vidéo, code — offrant ainsi de nouvelles possibilités pour les applications d’IA.

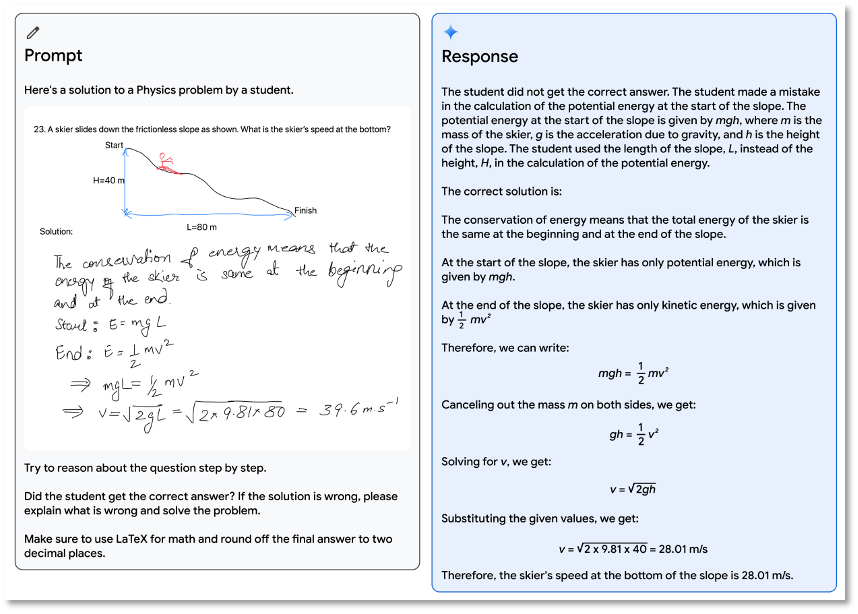

Par exemple, dans le domaine éducatif, grâce à ses compétences en raisonnement multimodal, Gemini Ultra pourrait comprendre des notes manuscrites désordonnées, repérer les erreurs dans les étapes de résolution d’un problème par un élève, puis proposer la solution correcte étape par étape. Si cela ne signifie pas remplacer les enseignants, cela leur offre tout de même un assistant IA extrêmement performant.

Gemini peut corriger les devoirs des élèves

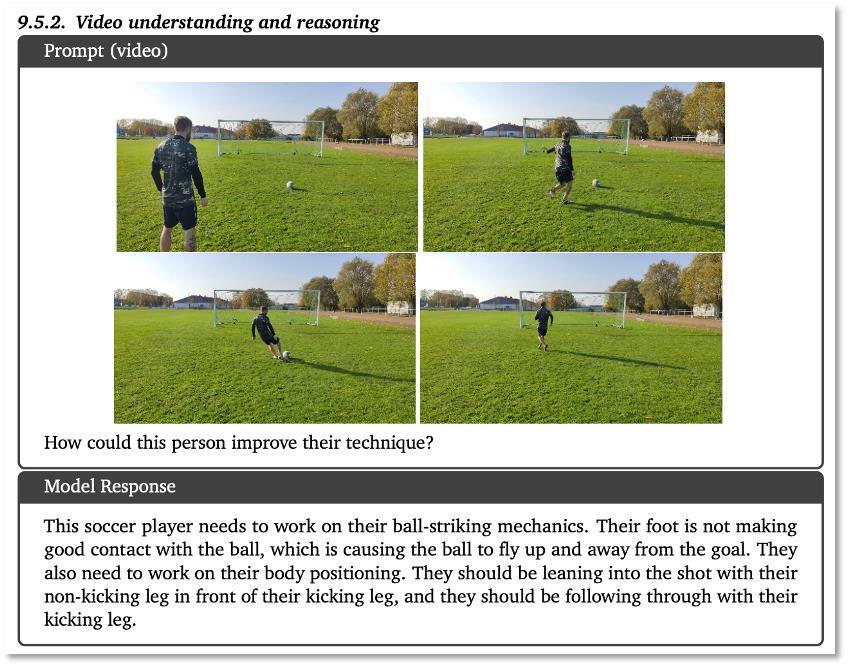

En matière de compréhension et de raisonnement vidéo, Gemini Ultra fait preuve d’un niveau comparable à celui d’un « entraîneur de football », capable d’analyser les gestes et la force d’un athlète, et de donner des conseils précis d’amélioration.

Gemini peut comprendre le contenu vidéo et conseiller les athlètes

Gemini Ultra excelle également dans la compréhension complexe d’images, la génération de code et le suivi d’instructions. Par exemple, après avoir reçu une image accompagnée de l’instruction suivante : « Utilisez la fonction représentée dans le sous-graphique en haut à gauche, multipliez-la par 1000, ajoutez-la à la fonction du sous-graphique en bas à gauche, puis générez le code matplotlib pour produire un seul graphique résultat », Gemini Ultra réussit parfaitement cette tâche inverse en inférant le code utilisé pour générer le graphique, en appliquant les transformations mathématiques supplémentaires et en générant le code correspondant.

À la lumière de ces exemples fournis par Google, Gemini Ultra semble être le « modèle le plus puissant au monde ». Mais la question que tout le monde se pose est : quand pourrons-nous l’utiliser ?

Selon les annonces de Google, à partir du 6 décembre, Bard intègrera une version fine-tunée de Gemini Pro, améliorant significativement ses capacités de raisonnement, de planification et de compréhension. Il s’agit de la mise à jour la plus importante depuis le lancement de Bard.

Attention toutefois : Bard intégrant Gemini Pro ne prend actuellement en charge que l’anglais, bien qu’il soit accessible dans plus de 170 pays et régions. Des extensions vers d’autres modalités, langues et zones géographiques sont prévues prochainement. Les utilisateurs chinois ne peuvent donc pas encore profiter pleinement de Gemini Pro.

Gemini Nano sera d’abord disponible sur le smartphone Pixel 8 Pro de Google, initialement dans WhatsApp, avant d’être étendu à d’autres applications de messagerie l’année prochaine.

Dans les mois à venir, Gemini sera progressivement intégré à davantage de produits et services de Google, notamment Search, Ads, Chrome et Duet AI. Autrement dit, les capacités de Gemini seront bientôt injectées dans le moteur de recherche Google.

Quant à Gemini Ultra, le « plus puissant », les utilisateurs ordinaires devront encore patienter. Google indique qu’il mène actuellement des vérifications en matière de confiance et de sécurité, ainsi que des ajustements basés sur les retours humains et un apprentissage par renforcement (RLHF) avant son lancement.

Durant cette phase, Gemini Ultra sera testé de manière restreinte auprès de clients, développeurs, partenaires, ainsi que d’experts en sécurité et responsabilité, afin de recueillir leurs retours. Il sera ensuite ouvert aux développeurs et aux entreprises au début de l’année prochaine.

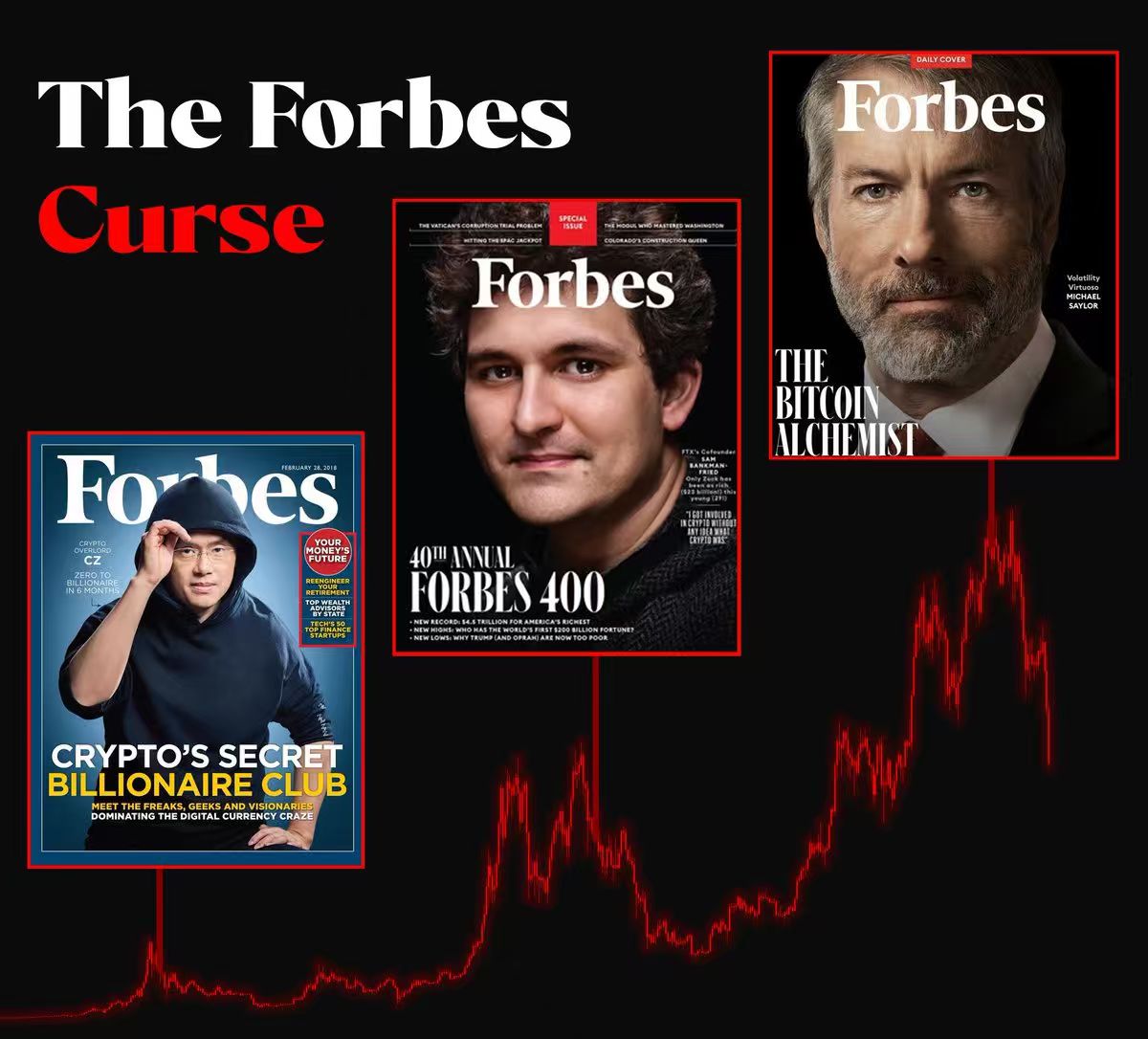

Le « test » MMLU d’Ultra suspecté d’être une version maison de Google

Bien que Google mette en avant les performances exceptionnelles de Gemini Ultra, son approche — dévoiler un modèle ultra-performant tout en retardant sa mise à disposition — a rapidement suscité des doutes. Est-il vraiment supérieur à GPT-4 ?

Bloomberg a rapidement nuancé les annonces : selon eux, le modèle de Google reste encore derrière celui d’OpenAI. Les démonstrations actuelles reposent uniquement sur des vidéos préenregistrées, non en temps réel, probablement réalisées à partir de « prompts soigneusement ajustés et d’images statiques ». Bloomberg ajoute que les réponses de Gemini nécessitent souvent des informations complémentaires, et dans une interaction réelle, requièrent des indices très explicites.

Des internautes ayant visionné la vidéo ont également relevé des traces évidentes de montage, jugeant que « les capacités présentées sont gonflées ».

En outre, le test MMLU utilisé par Google pour évaluer Gemini Ultra serait basé sur ses propres critères. Dans les 57 matières testées, le score de 90 obtenu par Ultra porte en bas de page la mention « CoT@32* », indiquant une méthode d’évaluation spécifique à Google. Si l’on applique les mêmes standards qu’avec GPT-4, le score tombe à 83,7, inférieur aux 86,4 de GPT-4.

Gemini Ultra obtient un score de 90 selon la méthode d’évaluation ajustée par Google

Les questions académiques étant trop techniques, heureusement, Google a déjà intégré Gemini à Bard. Bien qu’il s’agisse de la version Pro, moins puissante que Ultra, elle est censée gérer plusieurs tâches. C’est donc le moyen le plus accessible pour le grand public de tester directement Gemini.

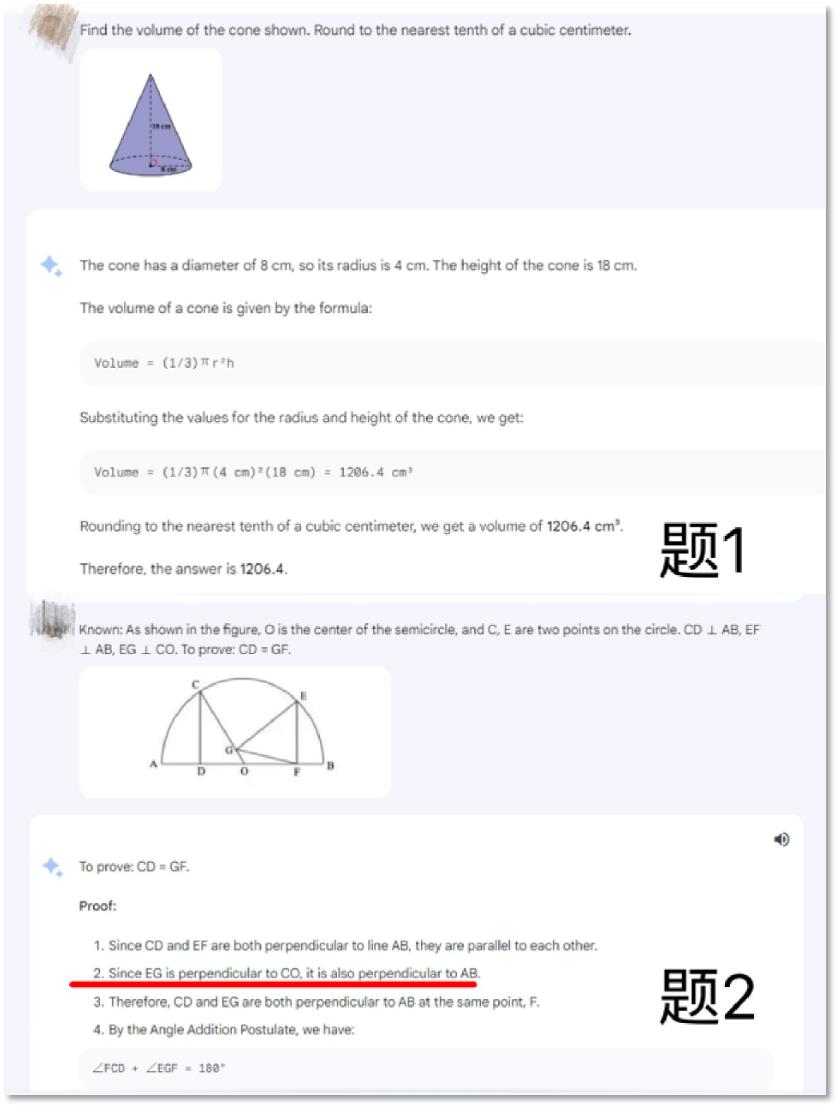

Metaverse Daily a choisi de tester les compétences mathématiques, car ChatGPT n’est pas réputé excellent en maths, et OpenAI considère que la maîtrise des mathématiques — où chaque réponse est unique — est une base essentielle vers l’AGI. Voyons donc si Bard, alimenté par Gemini, excelle dans ce domaine.

Nous avons posé les questions en anglais. La question 1 portait sur le calcul du volume d’un cône, la question 2 était un problème de géométrie plus complexe.

Les résultats montrent que Gemini Pro peut identifier correctement les images et le texte qu’elles contiennent, et résoudre des problèmes mathématiques simples. Toutefois, face à des questions plus complexes, des erreurs manifestes persistent. À la question 2, Bard commet une erreur flagrante à l’étape 2, affirmant à tort que les droites EG et AB sont perpendiculaires.

Bard doté de Gemini Pro n’est pas encore parfait en mathématiques

Cela s’expliquerait-il par le fait que Bard utilise Gemini Pro plutôt que Ultra ? Il faudra attendre l’intégration de Ultra pour le vérifier.

Gemini Nano, qui sera intégré aux smartphones Pixel 8 Pro, sera utilisé pour deux fonctions : « résumé de l’enregistreur » et « réponses intelligentes de Gboard ».

Selon Google, même sans connexion Internet, l’enregistreur pourra résumer automatiquement des conversations téléphoniques, des interviews ou des présentations. Quant à la fonction de réponses intelligentes, similaire aux messages automatiques envoyés après un appel, Gemini Nano pourra analyser le contenu d’un message entrant et générer une réponse appropriée. Pour l’instant, ces deux fonctions ne prennent en charge que le texte en anglais.

Selon le cadre d’évaluation de l’AGI proposé par DeepMind, à l’étape AGI-1, l’intelligence artificielle doit être capable d’apprendre et de raisonner à travers différents domaines et modalités, montrant une intelligence dans diverses tâches telles que les réponses aux questions, les résumés, la traduction, la conversation, et permettant une communication et collaboration de base avec les humains et autres IA, ainsi que la perception et l’expression d’émotions et valeurs simples.

En somme, d’après les annonces officielles de Google et les tests pratiques effectués, le modèle le plus prometteur, encore non publié, reste la version Ultra. Si ses capacités multimodales correspondent vraiment aux démonstrations, alors Google serait proche d’atteindre l’AGI tel qu’il le définit.

Bienvenue dans la communauté officielle TechFlow

Groupe Telegram :https://t.me/TechFlowDaily

Compte Twitter officiel :https://x.com/TechFlowPost

Compte Twitter anglais :https://x.com/BlockFlow_News