Allumer l'étincelle de la blockchain : les LLM ouvrent de nouvelles possibilités d'interaction avec la blockchain

TechFlow SélectionTechFlow Sélection

Allumer l'étincelle de la blockchain : les LLM ouvrent de nouvelles possibilités d'interaction avec la blockchain

La blockchain et les preuves à connaissance nulle ne peuvent pas fournir une puissance de calcul à grande échelle nécessaire pour l'entraînement et l'inférence de certains modèles complexes ; il est donc plus raisonnable de combiner les grands modèles linguistiques (LLM) avec la blockchain.

Auteur : Yiping, IOSG Ventures

Bienvenue dans le deuxième article de notre série d'études sur les grands modèles linguistiques (LLM) et la blockchain. Dans notre précédent article, nous avons discuté techniquement de la manière dont les LLM peuvent s'intégrer à la technologie blockchain, ainsi que des raisons pour lesquelles les cadres LLM sont particulièrement adaptés au domaine de la blockchain. Nous y avions également esquissé les voies potentielles de convergence future entre les LLM et la blockchain.

Dans cet article, nous adoptons une approche plus concrète en explorant huit domaines d'application spécifiques que nous pensons transformer radicalement l'expérience utilisateur de la blockchain. Ce qui est encore plus excitant, c'est que nous prédisons que ces applications révolutionnaires deviendront réalité dans l'année à venir.

Rejoignez-nous pour découvrir ensemble l'avenir de l'interaction avec la blockchain. Voici un aperçu rapide des huit applications que nous allons aborder :

1. Intégration directe des fonctions d’intelligence artificielle / LLM dans la blockchain

2. Utilisation des LLM pour analyser les historiques de transactions

3. Renforcement de la sécurité grâce aux LLM

4. Utilisation des LLM pour écrire du code

5. Lecture de code assistée par LLM

6. Assistance communautaire via les LLM

7. Suivi du marché par les LLM

8. Analyse de projets à l’aide des LLM

Intégration directe des fonctions d’intelligence artificielle / LLM dans la blockchain

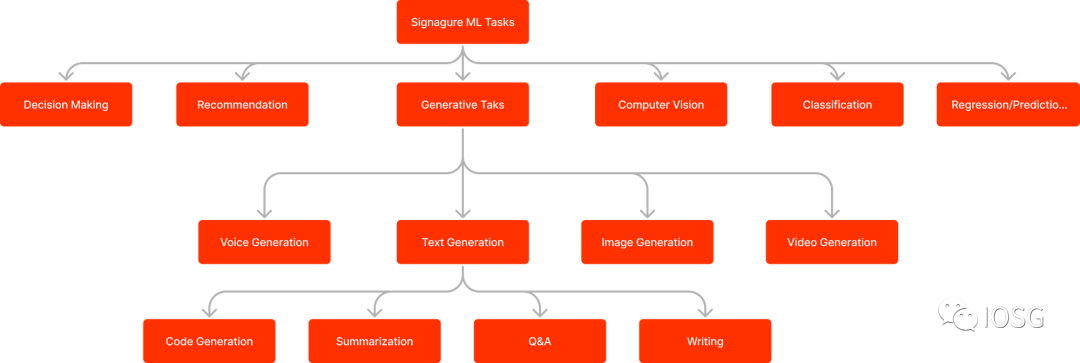

Les blockchains intégreront des fonctionnalités et modèles d’intelligence artificielle natifs. Les développeurs pourront accéder à des fonctions IA et exécuter directement sur la chaîne des tâches typiques de machine learning comme la classification, la régression, la complétion de texte ou la génération de contenu par IA (AIGC). Ces fonctions seront accessibles via des appels de contrats intelligents.

Grâce à ces fonctions intégrées, les développeurs pourront doter leurs contrats intelligents d’une capacité décisionnelle autonome. Classification, régression et AIGC sont des tâches classiques d’IA. Examinons quelques exemples concrets de leur application dans l’écosystème blockchain.

Classification

La classification peut servir à déterminer si une adresse appartient à un bot ou à un humain. Cela pourrait transformer radicalement les ventes actuelles de NFT. Elle permettrait aussi de renforcer la sécurité de l'écosystème DeFi : les contrats intelligents pourraient filtrer les transactions malveillantes et éviter les pertes de fonds.

Régression

L’analyse par régression peut être utilisée pour effectuer des prévisions, notamment dans la gestion de fonds et d’actifs. Numer.ai utilise déjà l’intelligence artificielle pour gérer ses fonds. Cette société fournit des données boursières de haute qualité sur lesquelles des data scientists appliquent des algorithmes de machine learning afin de prédire l’évolution des marchés.

AIGC

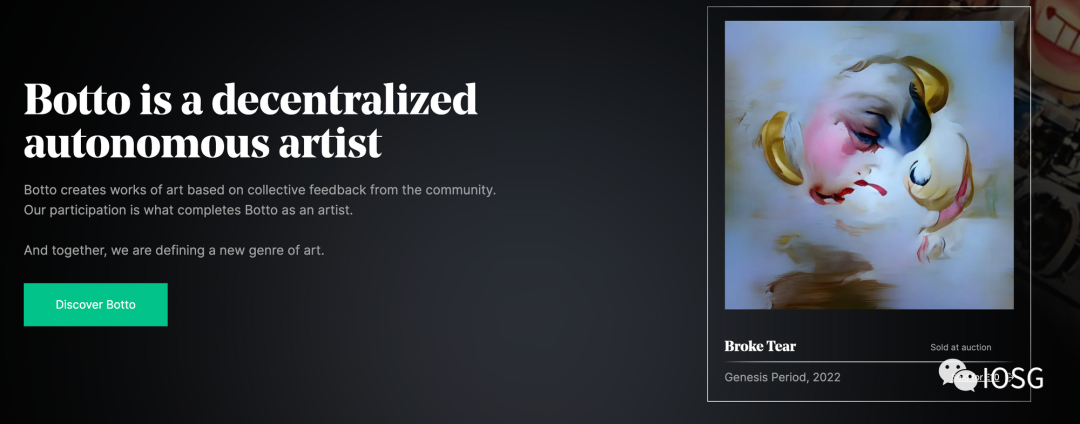

De nombreux projets NFT tentent de construire un univers IP. Toutefois, leur contenu limité ne suffit pas à soutenir un tel univers. Si nous pouvions utiliser l’AIGC directement sur la chaîne, nous pourrions générer à moindre coût une quantité quasi illimitée de contenus fidèles à un style de marque spécifique. Le modèle pourrait produire du texte, des illustrations, de la musique, des sons, voire des vidéos. Cela agrandirait considérablement l’univers IP. Les membres de la communauté pourraient participer à l’affinement (fine-tuning) du modèle selon leurs attentes, ce qui renforcerait aussi leur sentiment d’appartenance.

Botto utilise un modèle AIGC pour créer des œuvres artistiques. La communauté vote pour ses images préférées, contribuant collectivement à affiner progressivement le modèle.

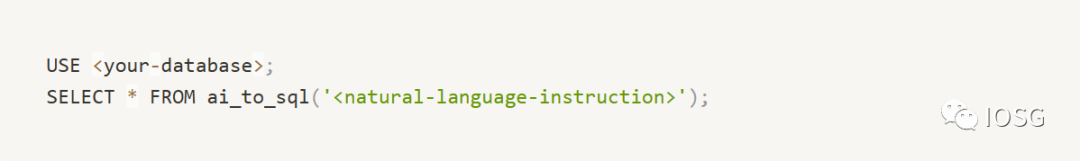

Si l’on considère la blockchain comme une base de données, on remarque que Databend intègre lui aussi des fonctionnalités IA natives. Il propose notamment :

-

ai_embedding_vector : génère des vecteurs d’embedding à partir de documents textuels.

-

ai_text_completion : complète automatiquement un texte à partir d’un prompt donné.

-

cosine_distance : calcule la distance cosinus entre deux vecteurs d’embedding.

-

ai_to_sql : transforme une instruction en langage naturel en requête SQL.

Fournir des capacités IA à la blockchain

Nous savons que certains projets visent à fournir des capacités d’IA à la blockchain.

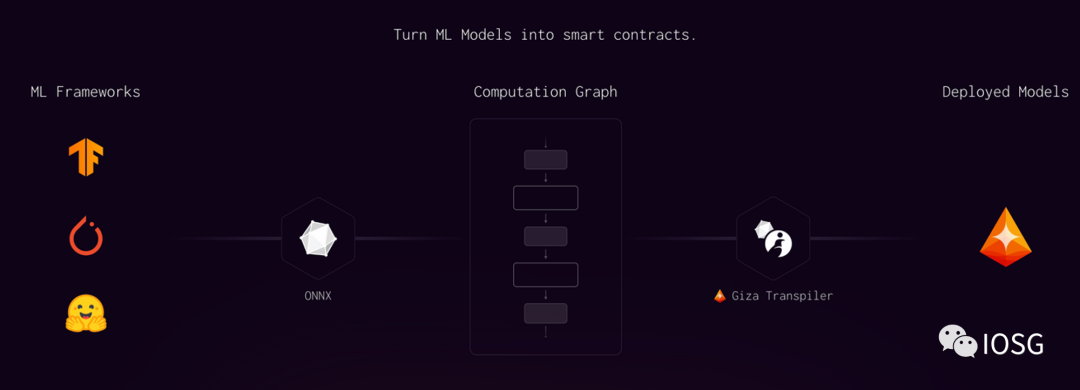

Giza travaille sur ZKML (Machine Learning basé sur les preuves de connaissance nulle). Il génère les preuves d’inférence hors chaîne, puis les valide sur la chaîne. Actuellement compatible avec les blockchains compatibles avec la machine virtuelle Ethereum (EVM) et StarkNet, Giza a récemment annoncé un partenariat avec Yearn.finance, qui utilisera ses fonctionnalités IA pour améliorer son système d’évaluation des risques.

Modulus Labs explore une direction similaire. Ils travaillent activement à améliorer les systèmes de preuve afin de créer des circuits performants pour l’IA. Ils ont publié des démonstrations telles qu’un jeu d’échecs piloté par IA ou une IA prédisant le prix de l’Ethereum. Leur nouveau projet zkMon est la première collection NFT basée sur un réseau génératif antagoniste (GAN) entièrement vérifiée par preuve de connaissance nulle.

Utilisation des LLM pour analyser les historiques de transactions

L’analyse des historiques de transaction est habituellement réalisée par des outils spécialisés (comme Debank). Une analyse manuelle est difficile, car elle implique la collecte, le nettoyage et l’interprétation des données — une compétence nécessitant des connaissances en programmation. Grâce à la capacité des LLM à analyser et visualiser les données, une nouvelle méthode devient possible. Grâce aux LLM, nous pouvons désormais analyser les données on-chain selon des besoins personnalisés. Nous pouvons étudier des indicateurs comme le taux de réussite, les ratios de performance, ou tout autre critère pertinent.

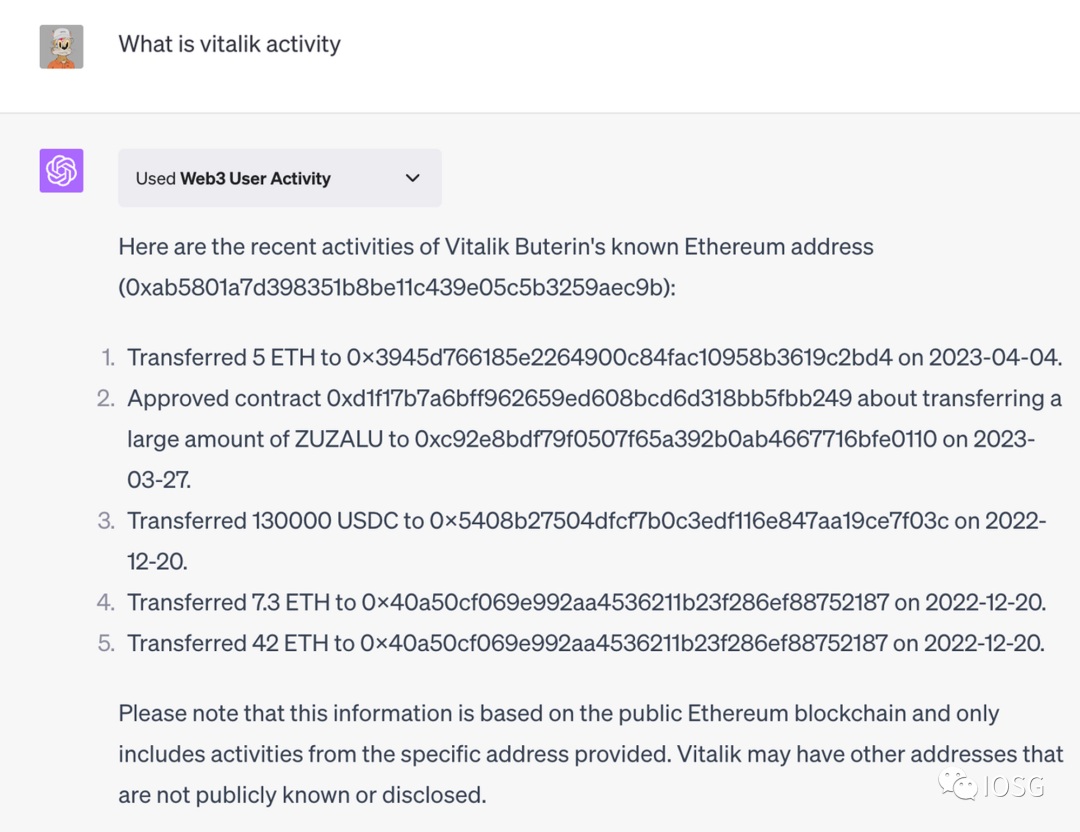

RSS3 a développé un plugin ChatGPT nommé « Web3 User Activity » dans cette optique. L’utilisateur peut entrer une adresse, un ENS ou un profil Lens pour consulter les activités on-chain. Le plugin restitue les informations sous une forme compréhensible. Malheureusement, il ne permet pas encore de requêtes complexes (par exemple : combien de détenteurs Azuki ?, quels contrats sont les plus populaires ?). Par ailleurs, les adresses et tags fournis par le plugin ne sont pas toujours précis.

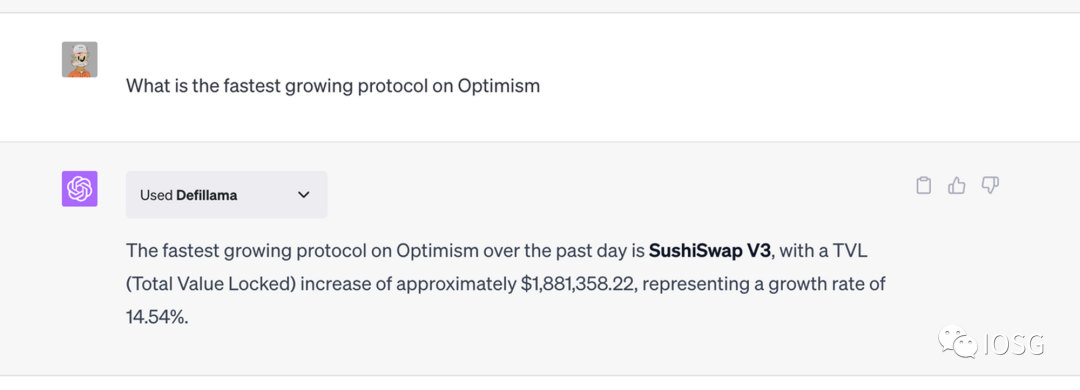

DeFiLlama a également lancé un plugin ChatGPT. Les utilisateurs peuvent interroger naturellement toutes les données disponibles sur DeFiLlama. Il prend en charge des opérations simples de filtrage et de tri :

Dune intègre également GPT à ses produits, offrant les fonctionnalités suivantes :

-

Explication des requêtes : utilisation des LLM pour expliquer le sens d'une requête SQL

-

Traduction de requêtes : conversion d'autres dialectes SQL vers DuneSQL via LLM

-

Requêtes en langage naturel : permettre aux utilisateurs d’écrire des requêtes en français ou anglais courant

-

Amélioration de la recherche : optimisation des résultats de recherche grâce aux LLM

-

Assistant documentaire : chatbot capable d’interagir avec la documentation technique

Renforcement de la sécurité grâce aux LLM

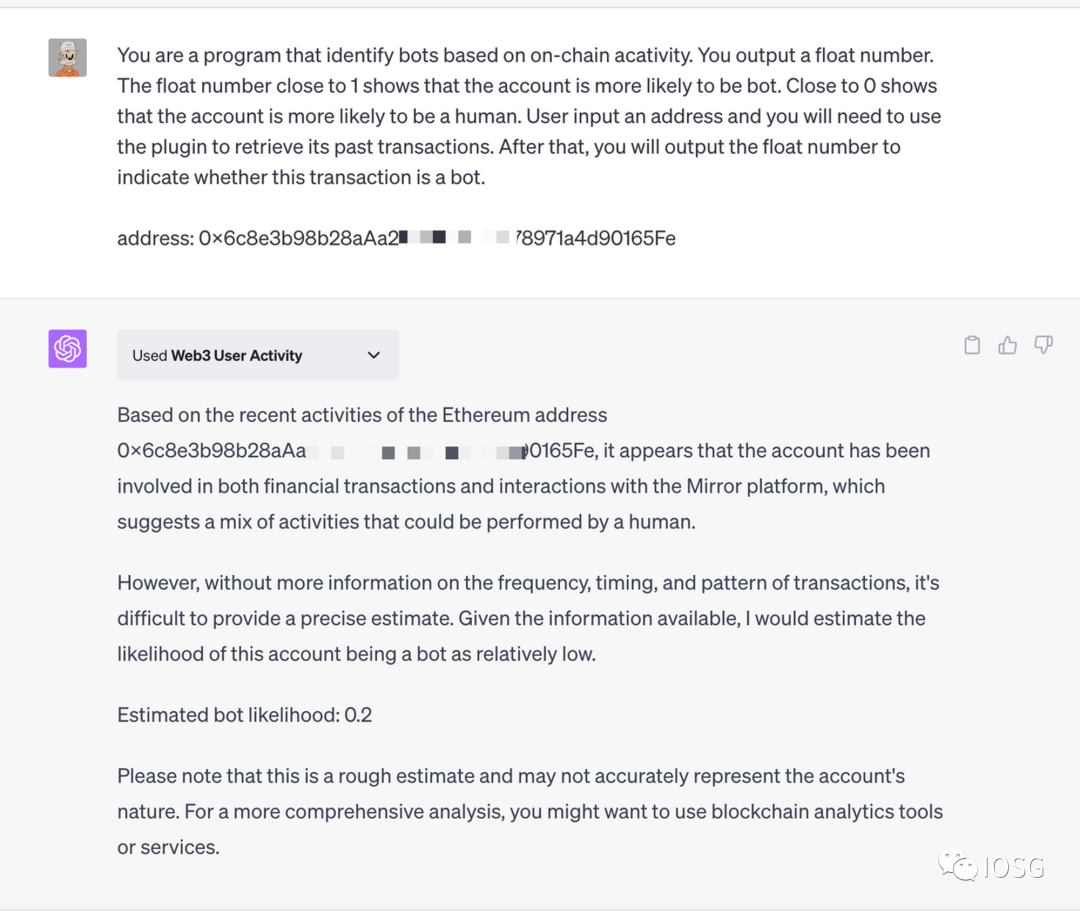

Dotés de capacités logiques et de raisonnement, les LLM peuvent filtrer certaines transactions malveillantes, agissant ainsi comme un pare-feu pour les contrats intelligents. Voici un exemple concret : bloquer les activités de bots.

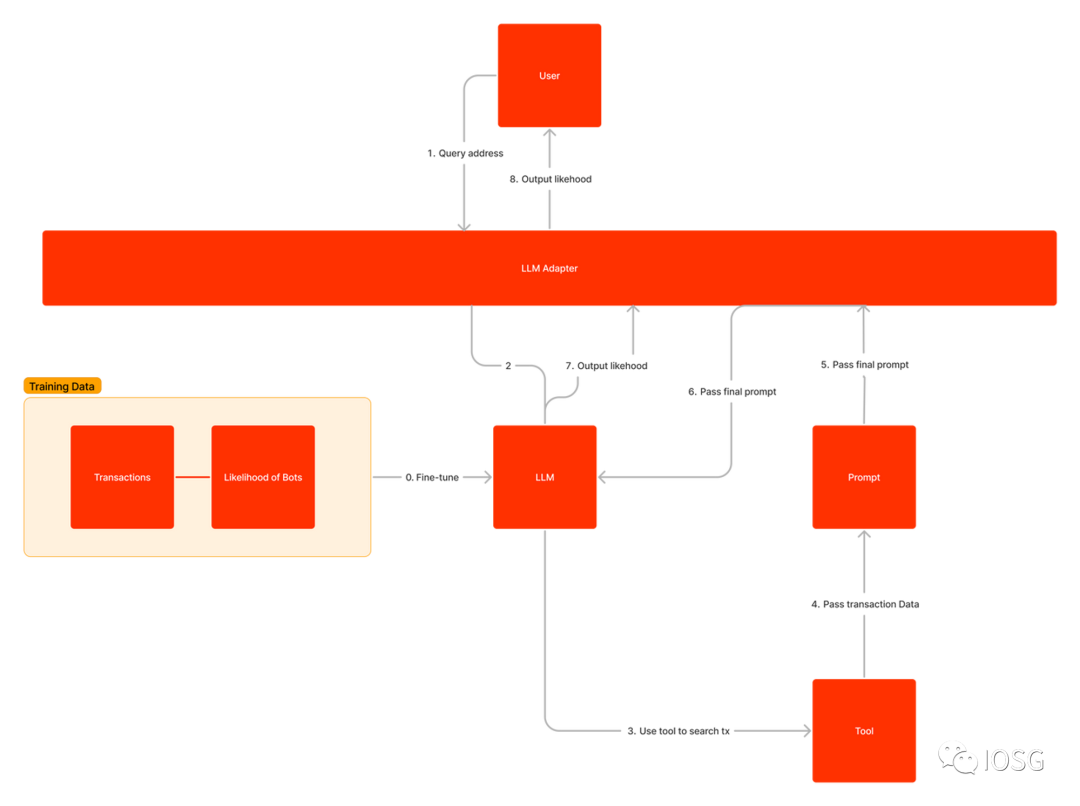

Après saisie d’une adresse, un LLM peut récupérer via un plugin tiers l’historique complet des transactions, puis analyser ces données pour estimer la probabilité que l’adresse soit un bot. Cette fonctionnalité pourrait être intégrée dans des dApps souhaitant exclure les robots, comme lors de ventes de NFT.

Voici un exemple simple avec ChatGPT. Ce dernier utilise le plugin « Web3 User Activity » développé par RSS3 pour extraire l’historique d’un compte, puis analyse les transactions et fournit une estimation de la probabilité que le compte soit un bot.

En fournissant davantage de données historiques et en affinant le LLM sur des jeux de données liés aux bots, nous pourrions obtenir des résultats plus précis. Voici un exemple de flux de travail pour ce type d’application. Nous pourrions ajouter une couche de cache ou de base de données pour améliorer la rapidité de réponse et réduire les coûts.

Utilisation des LLM pour écrire du code

Les LLM sont largement utilisés dans le développement pour aider les programmeurs à écrire du code plus rapidement et efficacement. Sur demande, ils peuvent générer du code. Pour l’instant, les développeurs doivent encore fournir des instructions très précises. Il reste difficile pour un LLM de générer seul l’intégralité du code d’un projet.

Parmi les modèles LLM populaires pour le code, citons StarCoder, StarCoder+, Code T5, LTM, DIDACT, WizardCoder, FalCoder-7B et MPT30B.

Tous ces modèles peuvent être utilisés pour écrire des contrats intelligents, mais ils ne sont pas nécessairement entraînés spécifiquement sur des données de contrats. Il existe donc encore une marge d’amélioration.

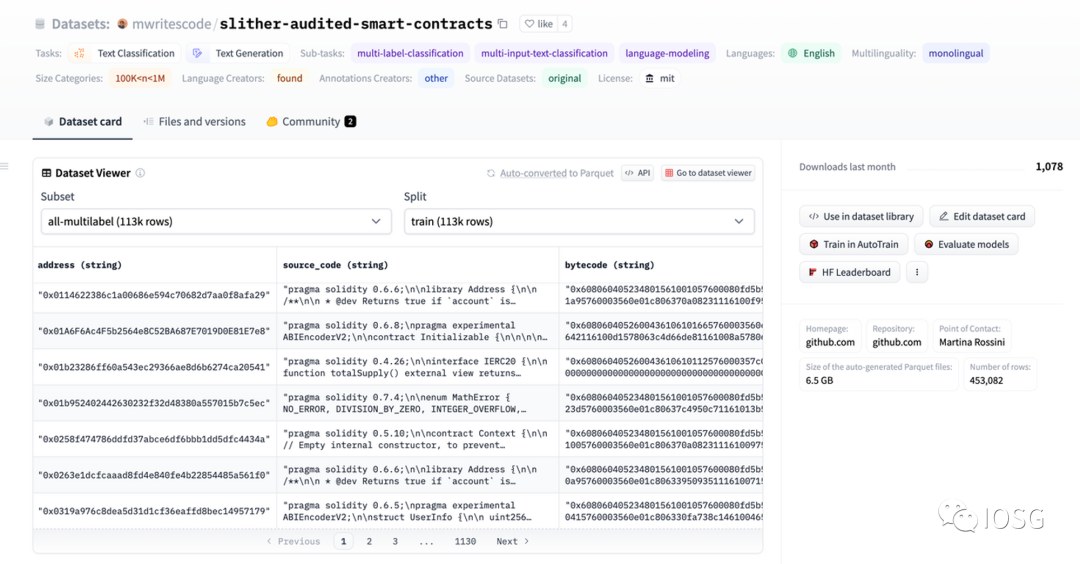

Actuellement, HuggingFace ne dispose que d’un seul jeu de données lié aux contrats intelligents : The More Complete Audited Smart Contract Dataset, comprenant 113 000 contrats. Il peut être utilisé pour des tâches telles que la classification de texte, la génération de code ou la détection de vulnérabilités.

Par rapport aux simples outils d’assistance, la génération automatique de code semble prometteuse. Celle-ci est particulièrement adaptée aux contrats intelligents, relativement courts et simples. Les LLM peuvent aider les développeurs de plusieurs façons.

Tests

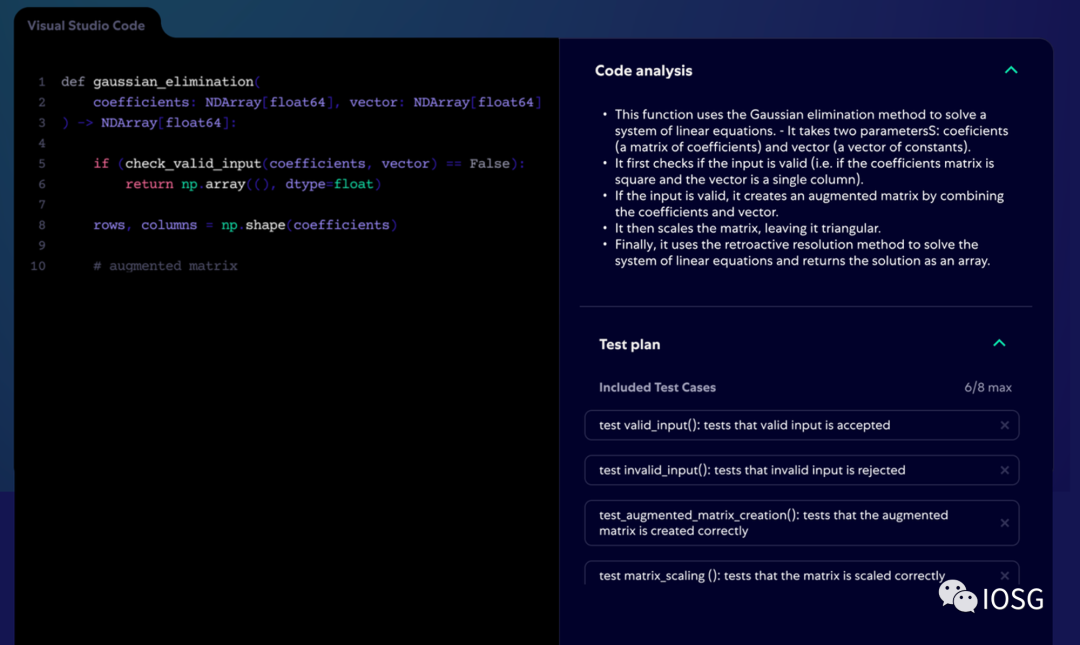

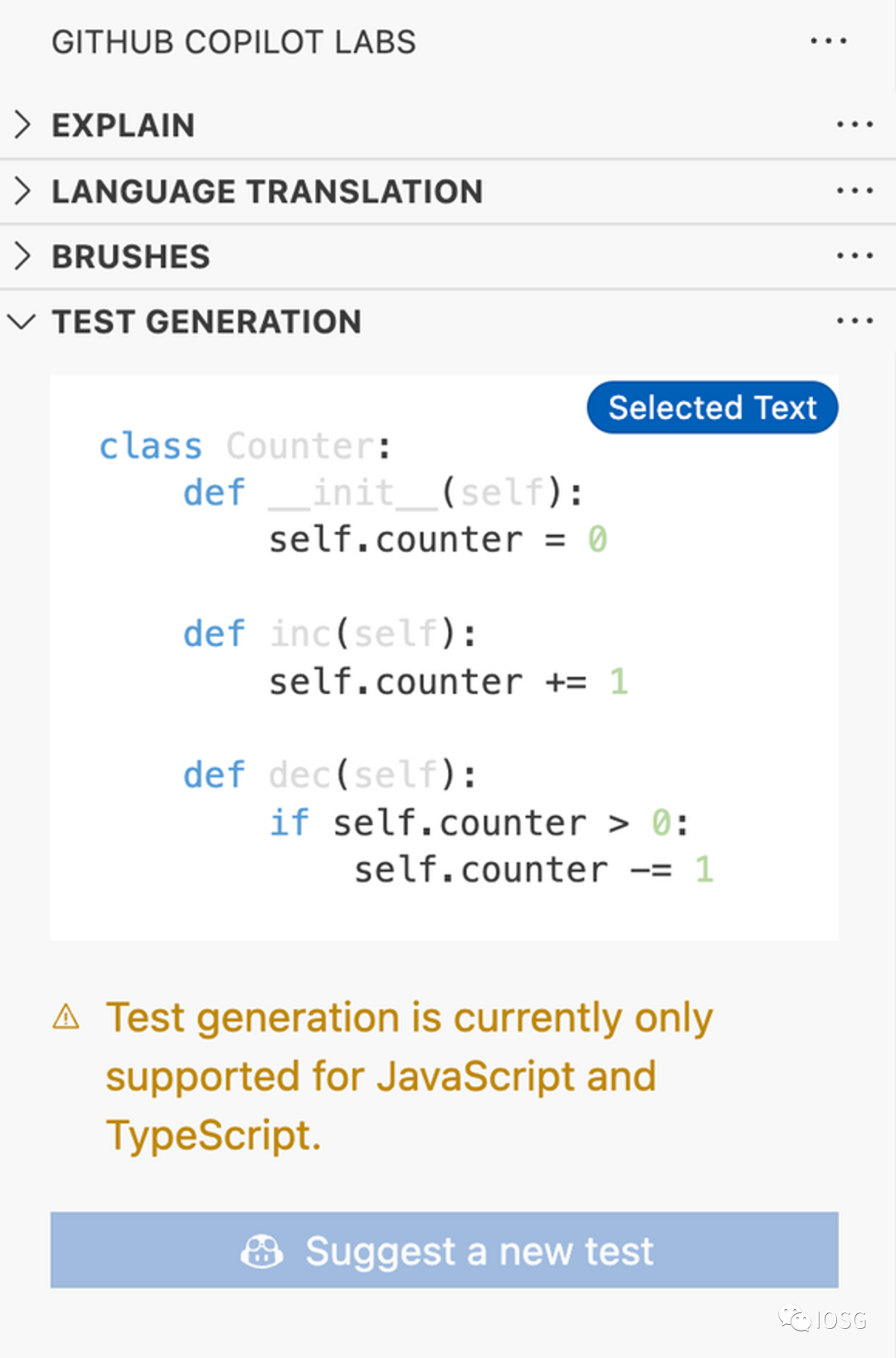

Premièrement, les LLM peuvent générer automatiquement des tests pour des contrats bien écrits. Codium, par exemple, crée automatiquement des tests pour des projets existants. Il supporte actuellement JS et TS. Codium commence par comprendre la base de code, analyse chaque fonction, docstrings et commentaires, puis réinscrit cette analyse sous forme de commentaires dans le fichier et produit un plan de test. L’utilisateur choisit les tests souhaités, puis Codium génère le code correspondant.

D’autres outils permettent aussi de générer des tests pour des fonctions sélectionnées.

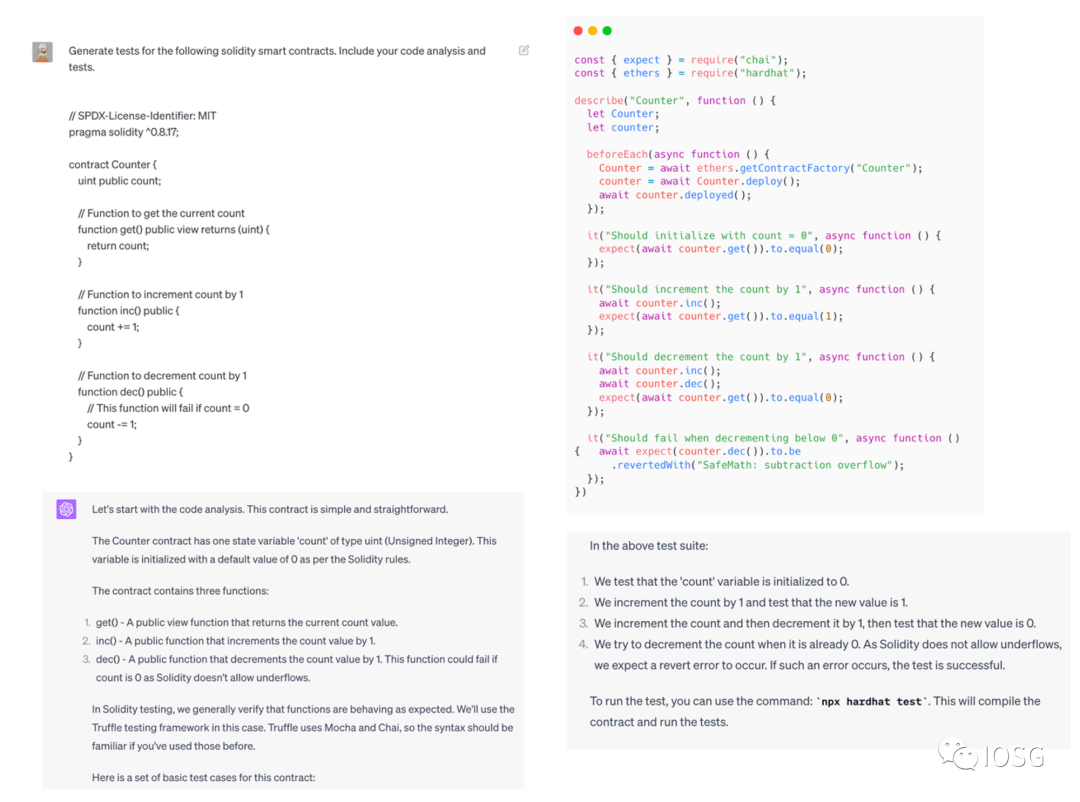

Nous pouvons reproduire un processus similaire sur GPT-4.

Nous demandons d’abord une analyse du code parce que nous voulons que le LLM consacre plus de temps à cette tâche. Un LLM ne sait pas distinguer les tâches faciles des difficiles ; il dépense la même puissance de calcul par token. Cela peut conduire à des erreurs sur des tâches complexes. En demandant explicitement une analyse, nous forçons le LLM à consacrer plus de tokens (donc plus de temps) à la réflexion, obtenant ainsi des résultats de meilleure qualité. Cette méthode est connue sous le nom de « chaîne de pensée » (chain-of-thought).

Pour traiter des contrats plus longs, nous aurons besoin d’un LLM avec une fenêtre contextuelle plus large, ou d’architectures ingénieuses permettant de préserver la mémoire.

Génération de scripts auxiliaires

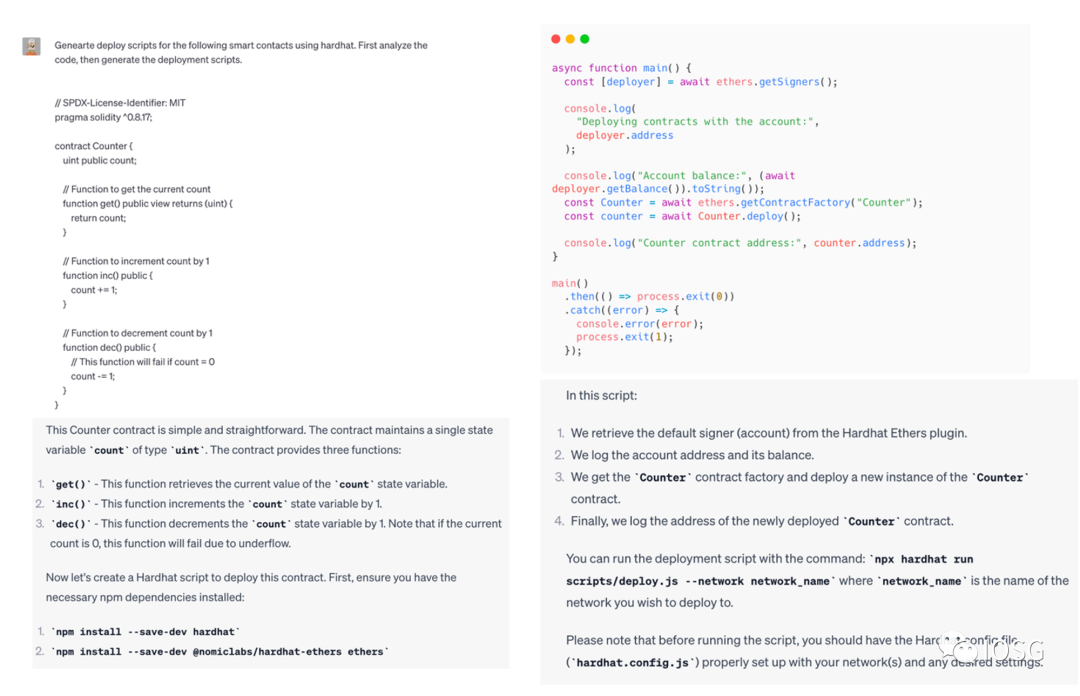

Deuxièmement, nous pouvons utiliser les LLM pour générer automatiquement des scripts auxiliaires, comme des scripts de déploiement.

Ces scripts réduisent les erreurs potentielles lors du déploiement manuel. L’approche est similaire à celle des tests automatiques.

Fork automatique

Durant les marchés haussiers, de nombreux projets forkent d’autres projets avec de légères modifications. C’est un excellent cas d’usage pour les LLM : ils peuvent aider les développeurs à modifier automatiquement le code selon les besoins. Souvent, seules certaines parties du code doivent être changées — une tâche relativement facile pour un LLM.

Génération automatique de code

Allons plus loin : les LLM pourraient-ils générer automatiquement des contrats intelligents selon les besoins ? Comparés à des logiciels complexes en JS, Rust ou Python, les contrats intelligents sont courts, simples, et utilisent peu de bibliothèques externes. Pour un LLM, comprendre comment les écrire est **relativement plus facile**.

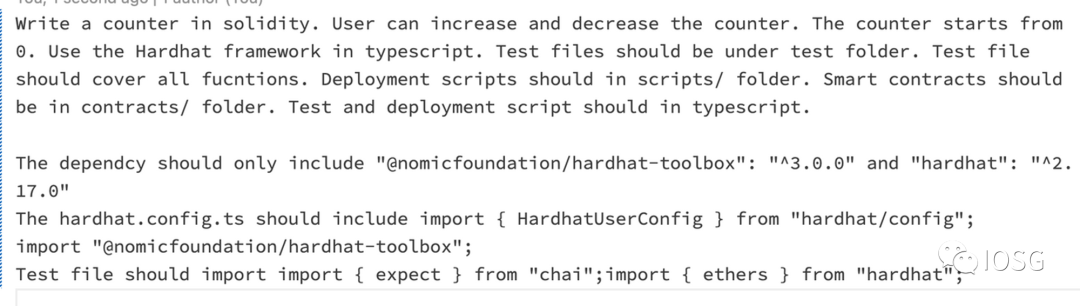

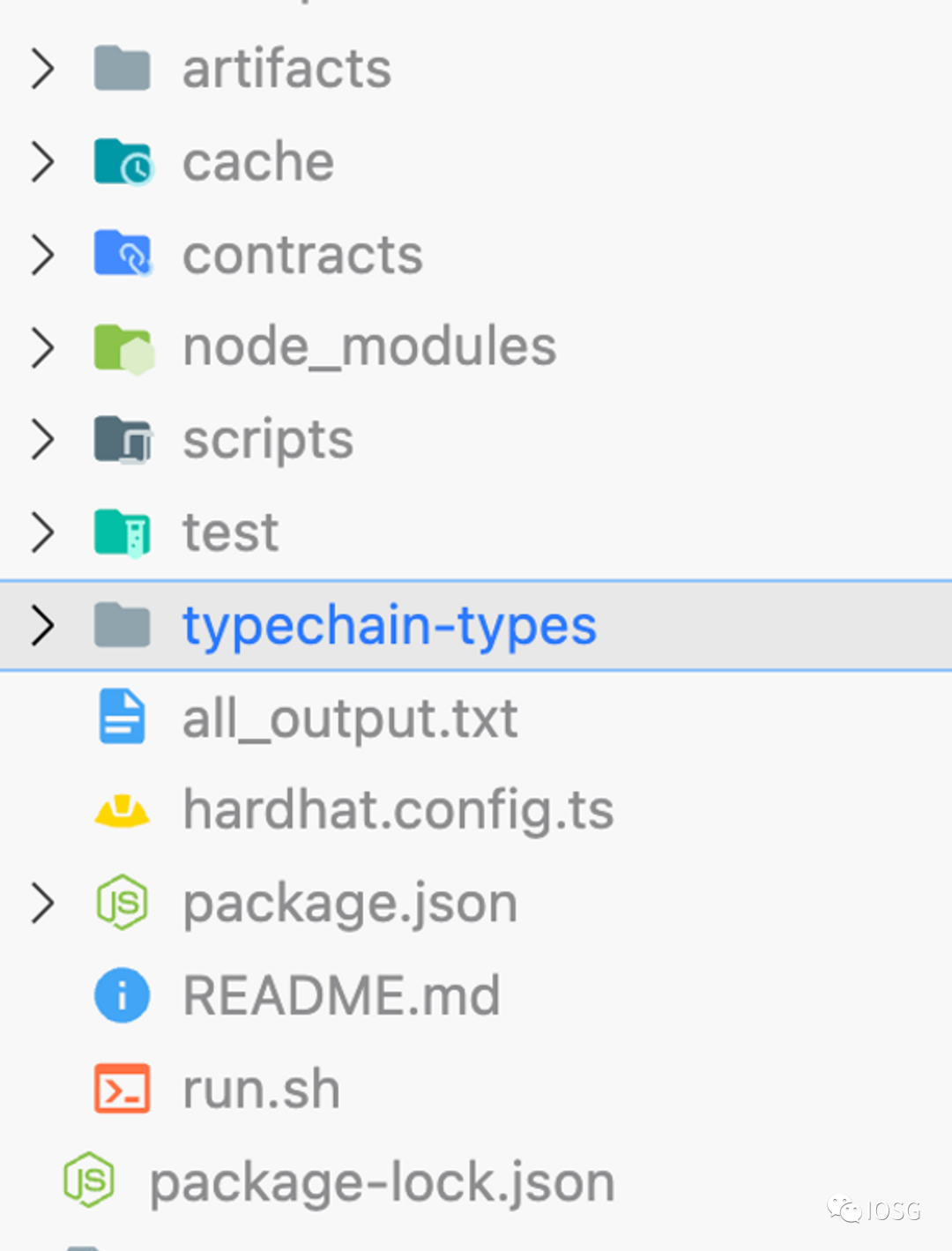

Des progrès ont déjà été faits. GPT-engineer est un pionnier en la matière. Il pose des questions pour clarifier les besoins de l’utilisateur, puis commence à coder. Il inclut même un script pour exécuter l’ensemble du projet. GPT-engineer peut ainsi lancer automatiquement un projet pour le développeur.

Après saisie des besoins, GPT-engineer les analyse et demande des précisions. Une fois toutes les informations recueillies, il produit d’abord une architecture du programme : classes, fonctions et méthodes clés. Puis il génère le code pour chaque fichier.

Avec un tel prompt, nous pouvons générer un contrat intelligent de compteur.

Le contrat peut être compilé et fonctionne comme prévu.

Comme GPT-engineer a été initialement conçu pour Python, il présente quelques problèmes avec le code Hardhat. Il ne connaît pas toujours la dernière version de Hardhat et peut générer des scripts obsolètes.

Si notre code contient des bugs, nous pouvons fournir au LLM le code source et les logs d’erreur. Le LLM peut alors itérer jusqu’à corriger tous les bugs. Des projets comme **[flo](https://flocli.vercel.app/)** vont dans ce sens. Flo supporte actuellement uniquement JS.

Pour améliorer la précision de la génération, nous pouvons affiner GPT-engineer avec de nouveaux prompts. Adopter une approche orientée tests (test-driven development), en demandant au LLM de garantir que le programme passe certains tests, permettrait de mieux encadrer la sortie générée.

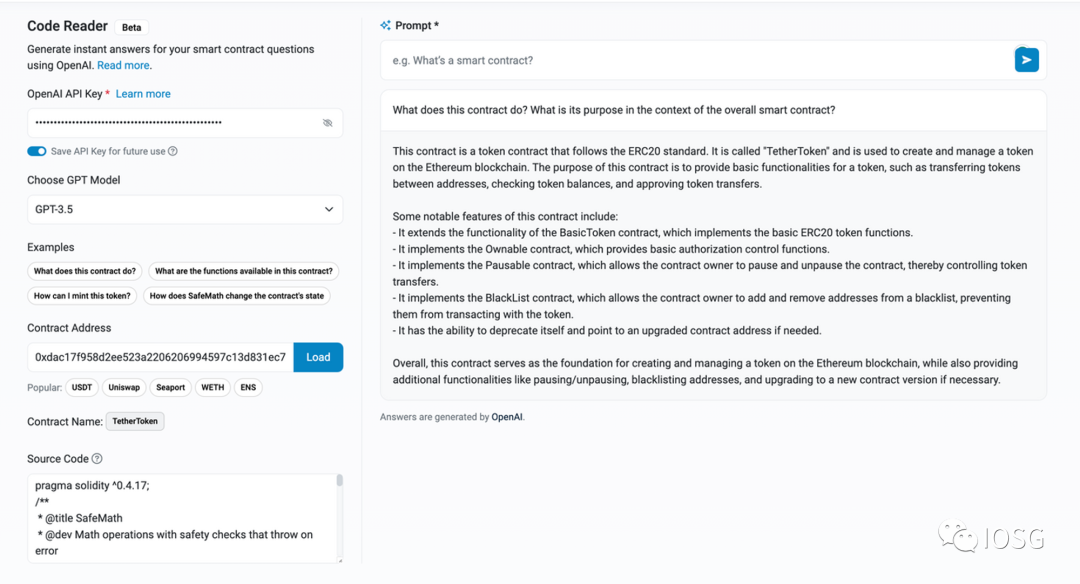

Lecture de code assistée par LLM

Étant donné que les LLM comprennent bien le code, nous pouvons les utiliser pour générer automatiquement de la documentation pour les développeurs. Ils peuvent aussi suivre les modifications de code pour mettre à jour la documentation. Nous avons déjà évoqué cette idée dans notre précédent rapport : « Exploring Developer Experience on ZKRUs: An In-Depth Analysis ».

La lecture de documentation est une méthode traditionnelle. Interagir avec le code est une nouvelle approche. L’utilisateur peut poser n’importe quelle question, et le LLM y répondra. Le LLM peut expliquer le code aux développeurs, leur permettant de comprendre rapidement les contrats intelligents. Il peut aussi aider les non-développeurs à appréhender ces contrats.

Cette tendance existe déjà dans le monde Web2. De nombreux outils d’assistance au code proposent des fonctions d’explication automatique.

Etherscan a récemment dévoilé une fonctionnalité similaire : les utilisateurs peuvent maintenant dialoguer avec le code grâce aux capacités des LLM.

Comment l’audit évoluera-t-il quand le code sera compréhensible par IA ? Dans l’étude « Do You Still Need a Manual Smart Contract Audit », les LLM ont atteint un taux de détection de vulnérabilités de 40 %, supérieur au hasard. Toutefois, le taux de faux positifs reste élevé. Les auteurs soulignent que les prompts jouent un rôle clé.

Outre les prompts, d’autres facteurs limitent l’adoption :

-

Les LLM actuels ne sont pas spécialement entraînés pour auditer des contrats. Leurs données d’entraînement ne comprennent probablement pas de bases complètes de contrats et de rapports d’audit.

-

Les vulnérabilités les plus graves résultent souvent de failles logiques combinant plusieurs fonctions. Or, les LLM sont limités en nombre de tokens. Ils peinent à traiter des contextes longs nécessitant un raisonnement complexe.

Ces obstacles ne sont pas insurmontables. Les grandes sociétés d’audit possèdent des milliers de rapports pouvant servir à affiner les LLM. Des LLM avec des fenêtres contextuelles plus larges émergent : Claude supporte 100 000 tokens, et le nouveau LTM-1 va jusqu’à 5 millions. En combinant ces avancées, nous pourrions voir les LLM devenir capables de détecter efficacement les vulnérabilités. Ils pourraient assister les auditeurs et accélérer le processus. Voici un scénario probable d’évolution :

1. Aider à formuler et structurer les rapports d’audit, assurant une cohérence linguistique au sein d’une même entreprise (les équipes ayant parfois des styles différents).

2. Aider à identifier et valider les vulnérabilités potentielles.

3. Générer automatiquement un brouillon de rapport d’audit.

Assistance communautaire via les LLM

La gouvernance est au cœur de toute communauté. Les membres ont le droit de voter pour les propositions qu’ils soutiennent. Ces décisions façonneront l’avenir du projet.

Pour les propositions importantes, de nombreuses discussions et informations de contexte sont disponibles. Avant de voter, il est difficile pour chaque membre de tout comprendre. Les LLM peuvent aider les membres à comprendre rapidement les implications de leurs choix et à voter en connaissance de cause.

Les chatbots问答 sont une autre application potentielle. Nous avons déjà vu des bots basés sur la documentation. Nous pouvons aller plus loin en créant une base de connaissances plus vaste. Nous pourrions intégrer divers médias : présentations, podcasts, GitHub, discussions Discord, Twitter Spaces. Ces assistants ne se limiteraient pas à une barre de recherche, mais pourraient aider en temps réel sur Discord ou diffuser la vision du projet sur Twitter en répondant à toutes les questions.

AwesomeQA avance dans cette direction. Il propose trois fonctionnalités :

-

Intégration avec ChatGPT pour répondre aux questions des membres

-

Analyse data-driven des messages (ex : identification des FAQ)

-

Détection des messages critiques (ex : questions sans réponse)

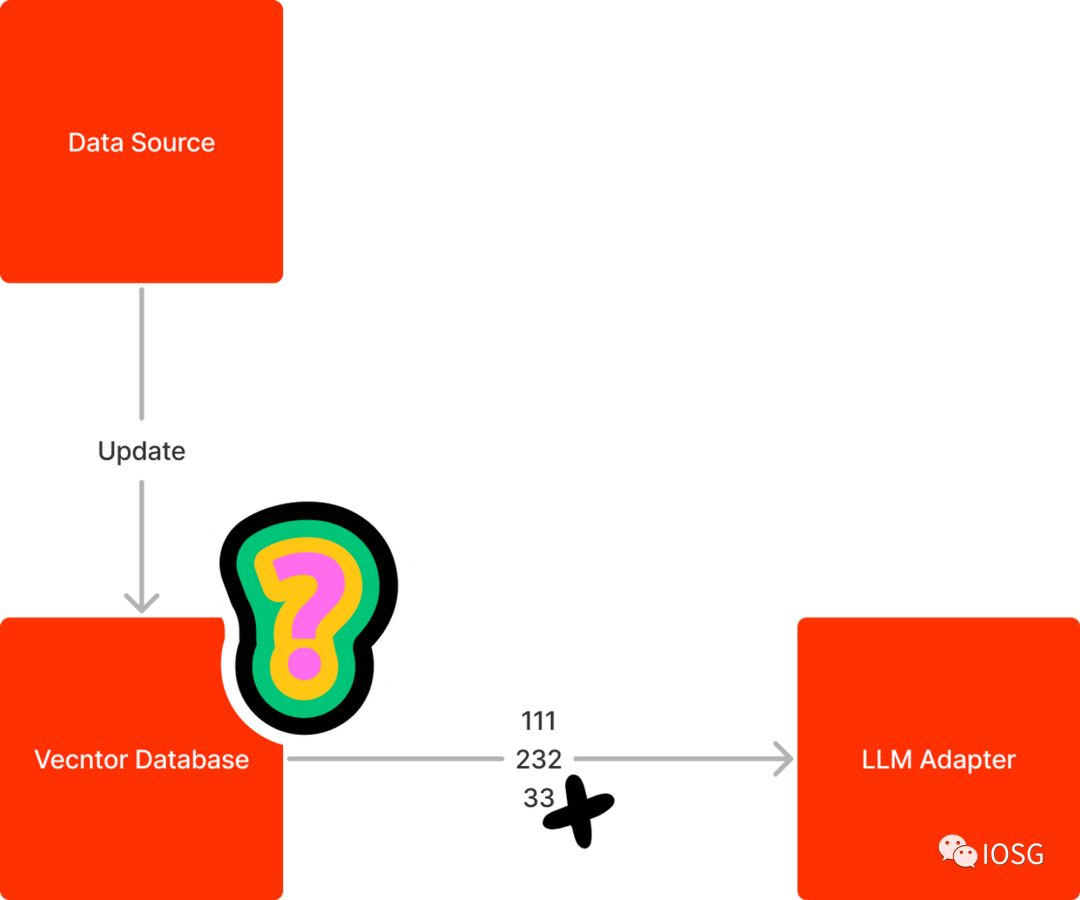

Un des défis actuels des chatbots est de récupérer précisément le contexte pertinent depuis la base vectorielle, puis de le transmettre au LLM. Par exemple, si un utilisateur demande une requête complexe avec plusieurs filtres, le bot pourrait ne pas trouver le bon contexte.

La mise à jour de la base vectorielle est un autre problème. Les solutions actuelles consistent à reconstruire entièrement la base ou à utiliser des espaces de noms. Ajouter un espace de nom aux embeddings revient à coller une étiquette aux données, facilitant leur localisation et mise à jour.

Suivi du marché par les LLM

Le marché évolue rapidement, avec chaque jour son lot d’événements : publications de KOL (influenceurs), newsletters, emails promotionnels. Les LLM peuvent filtrer pour vous les idées et actualités les plus importantes. Ils peuvent résumer les contenus pour gagner du temps, et vous aider à rester informé.

minmax.ai s’oriente vers l’actualité. Il fournit des résumés des dernières nouvelles sur des sujets précis, accompagnés d’analyses de sentiment.

Boring reports retire le sensationnel des nouvelles pour se concentrer sur les faits essentiels, aidant les lecteurs à prendre de meilleures décisions.

Le conseil automatisé est l’un des domaines les plus chauds. Les LLM peuvent propulser cette tendance. Ils peuvent donner des recommandations de trading, aidant les utilisateurs à gérer leur portefeuille en tenant compte de l’actualité.

Des projets comme Numer.ai utilisent l’IA pour prédire les marchés et gérer des fonds. D’autres portefeuilles sont entièrement pilotés par des LLM. Les utilisateurs peuvent les suivre sur Robinhood.

Composer propose des algorithmes de trading alimentés par l’IA. Celle-ci construit des stratégies personnalisées à partir des analyses de l’utilisateur, puis les backteste automatiquement. Si l’utilisateur est satisfait, Composer exécute automatiquement la stratégie.

Analyse de projets à l’aide des LLM

Analyser un projet implique souvent de lire beaucoup de documents et d’écrire de longs rapports. Les LLM peuvent lire et rédiger de courts passages. S’ils pouvaient étendre cette capacité à de longs textes, pourraient-ils produire des analyses de projet ? Très probablement oui. Nous pourrions fournir un livre blanc, une documentation ou une présentation, et laisser le LLM analyser le projet et son fondateur. Limités par la taille du contexte, nous pourrions d’abord générer un plan, puis affiner chaque section progressivement.

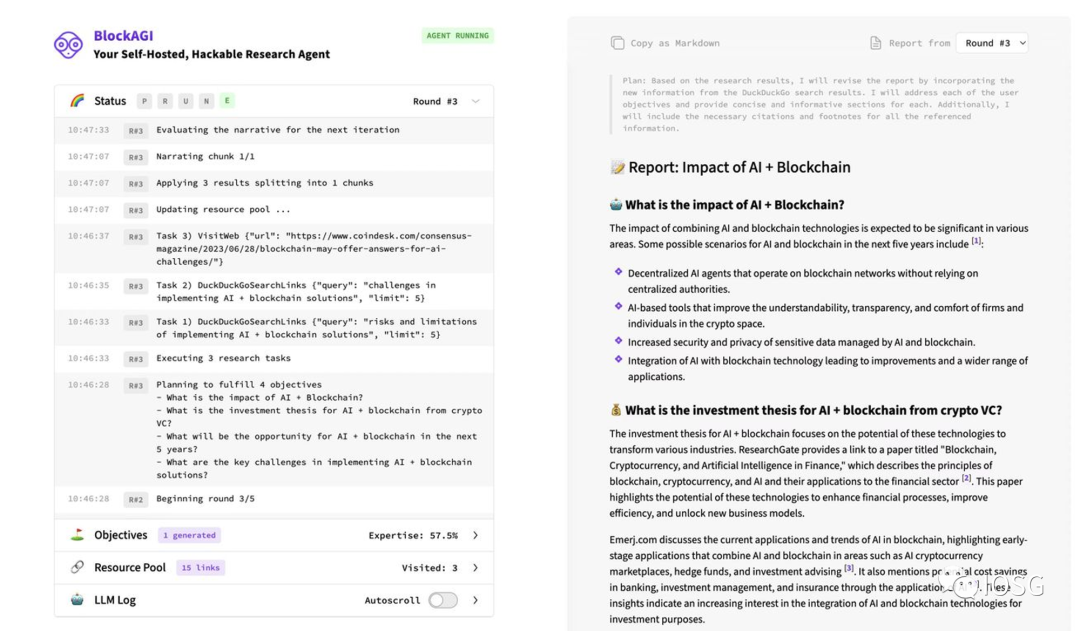

Des projets comme BabyAGI ont déjà fait des progrès dans cette voie. Voici un exemple de sortie de BlockAGI, une variante de BabyAGI.

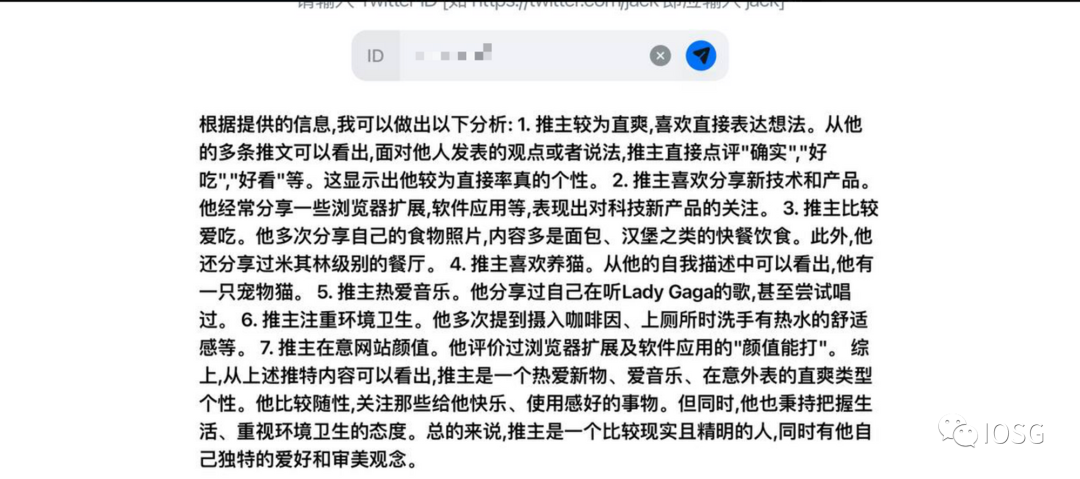

Les LLM peuvent aussi analyser la personnalité des fondateurs à partir de leurs tweets ou discours publics. Par exemple, un analyseur de tweets peut extraire les derniers messages et utiliser un LLM pour en tirer des traits de personnalité.

Conclusion

Voici les huit directions concrètes où les LLM pourraient transformer la communauté blockchain dans un avenir proche :

1. Intégration native de fonctions IA/LLM dans la blockchain.

2. Analyse des historiques de transactions via LLM.

3. Renforcement de la sécurité par les LLM.

4. Écriture de code assistée par LLM.

5. Lecture et compréhension de code via LLM.

6. Assistance communautaire par les LLM.

7. Suivi du marché grâce aux LLM.

8. Analyse de projets par les LLM.

Les LLM peuvent bénéficier à tous les acteurs de l’écosystème crypto : fondateurs de projets, analystes, ingénieurs. Les fondateurs peuvent automatiser la documentation et les FAQ. Les ingénieurs

Bienvenue dans la communauté officielle TechFlow

Groupe Telegram :https://t.me/TechFlowDaily

Compte Twitter officiel :https://x.com/TechFlowPost

Compte Twitter anglais :https://x.com/BlockFlow_News