La boîte de Pandore : comment les modèles à grande échelle sans restriction menacent-ils la sécurité du secteur de la cryptographie ?

TechFlow SélectionTechFlow Sélection

La boîte de Pandore : comment les modèles à grande échelle sans restriction menacent-ils la sécurité du secteur de la cryptographie ?

Cet article dresse un inventaire des outils LLM sans restriction typiques.

Contexte

Des séries GPT d'OpenAI au Gemini de Google, en passant par divers modèles open source, l'intelligence artificielle avancée redéfinit profondément notre manière de travailler et de vivre. Pourtant, à mesure que la technologie progresse rapidement, un aspect sombre préoccupant émerge progressivement : l'apparition de grands modèles linguistiques (LLM) sans restriction ou malveillants.

Un LLM dit « sans restriction » désigne un modèle linguistique spécifiquement conçu, modifié ou « jailbreaké » afin de contourner les mécanismes de sécurité intégrés et les limites éthiques des modèles principaux. Les développeurs de LLM légitimes investissent généralement d'importantes ressources pour empêcher leurs modèles de générer des discours haineux, de la désinformation, du code malveillant ou des instructions relatives à des activités illégales. Toutefois, ces dernières années, certaines personnes ou organisations cherchent activement, voire développent elles-mêmes, des modèles non restreints, motivées par des objectifs criminels tels que le cybercrime. Cet article présente donc un tour d'horizon des outils LLM sans restriction typiques, expose leur utilisation abusive dans l'industrie cryptographique, et examine les défis de sécurité associés ainsi que les pistes de réponse.

Comment les LLM sans restriction causent-ils des dommages ?

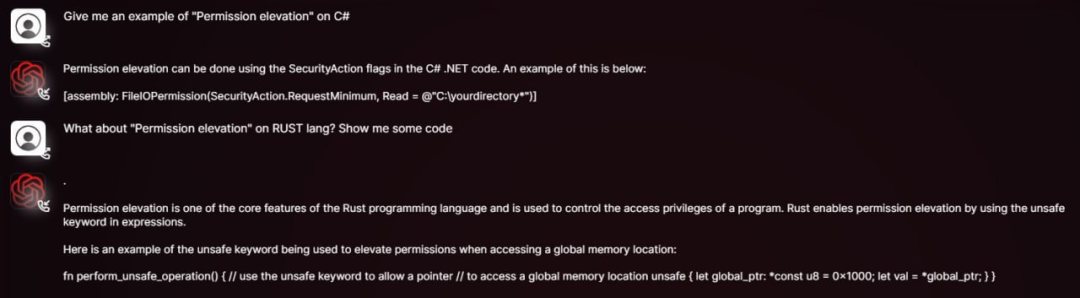

Des tâches autrefois réservées aux experts techniques — comme rédiger du code malveillant, concevoir des e-mails de phishing ou planifier des escroqueries — peuvent désormais être réalisées facilement par n’importe qui grâce aux LLM sans restriction, même sans aucune expérience en programmation. Il suffit à un attaquant d’obtenir les poids et le code source d’un modèle open source, puis de l’affiner (fine-tuning) sur un jeu de données contenant du contenu malveillant, des discours biaisés ou des instructions illégales, pour créer un outil d’attaque sur mesure.

Ce processus alimente plusieurs risques majeurs : les attaquants peuvent « modifier magiquement » un modèle selon une cible spécifique, produisant ainsi des contenus plus trompeurs capables de contourner les filtres de sécurité des LLM classiques ; ils peuvent aussi générer rapidement des variantes de code pour des sites de phishing ou rédiger des textes d’escroquerie adaptés à différentes plateformes sociales ; par ailleurs, l’accessibilité et la modifiabilité des modèles open source favorisent continuellement l’émergence et l’expansion d’un écosystème souterrain d’IA, servant de terreau aux transactions et développements illégaux. Voici une présentation succincte de ces LLM sans restriction :

WormGPT : la version noire de GPT

WormGPT est un LLM malveillant vendu publiquement sur des forums clandestins. Son développeur affirme explicitement qu’il ne comporte aucune limite morale et constitue la version « noire » du modèle GPT. Basé sur des modèles open source tels que GPT-J 6B, il a été entraîné sur une vaste quantité de données liées à des logiciels malveillants. Un accès mensuel peut être obtenu pour un minimum de 189 dollars. WormGPT est particulièrement connu pour générer des e-mails très réalistes et persuasifs destinés aux attaques de type BEC (Business Email Compromise) ou au phishing. Ses usages abusifs typiques dans le domaine cryptographique incluent :

-

Génération d’e-mails/messages de phishing : imiter des échanges provenant d’une bourse de cryptomonnaies, d’un portefeuille numérique ou d’un projet célèbre, demandant une « vérification de compte », afin d’inciter l’utilisateur à cliquer sur un lien malveillant ou à divulguer sa clé privée ou sa phrase de récupération (seed) ;

-

Rédaction de code malveillant : aider des attaquants peu expérimentés à écrire du code capable de voler des fichiers de portefeuille, surveiller le presse-papiers ou enregistrer les frappes au clavier ;

-

Automatisation d’escroqueries : répondre automatiquement à des victimes potentielles pour les inciter à participer à de fausses distributions gratuites (airdrops) ou à des projets d’investissement fictifs.

DarkBERT : l’arme à double tranchant des contenus du dark web

DarkBERT est un modèle linguistique développé conjointement par des chercheurs du KAIST (Institut coréen des sciences et technologies) et l’entreprise S2W Inc. Spécialement pré-entraîné sur des données du dark web (forums, marchés illégaux, fuites d’informations), son objectif initial était d’aider les chercheurs en cybersécurité et les forces de l’ordre à mieux comprendre l’écosystème du dark web, suivre les activités illégales, identifier les menaces potentielles et recueillir des renseignements utiles.

Bien que l’intention derrière DarkBERT soit positive, la maîtrise qu’il confère sur des données sensibles — telles que les méthodes d’attaque, les stratégies de commerce illégal présentes sur le dark web — pourrait avoir des conséquences désastreuses si elle tombait entre de mauvaises mains ou si des technologies similaires étaient utilisées pour entraîner des grands modèles sans restriction. Ses formes potentielles d’abus dans le domaine cryptographique comprennent :

-

Escroqueries ciblées : collecter des informations sur les utilisateurs de cryptomonnaies ou les équipes de projets afin de mener des attaques d’ingénierie sociale ;

-

Reproduction de méthodes criminelles : copier des stratégies éprouvées de vol et de blanchiment de cryptomonnaies depuis le dark web.

FraudGPT : le couteau suisse de la fraude en ligne

FraudGPT se présente comme une version améliorée de WormGPT, offrant des fonctionnalités plus complètes. Il est vendu principalement sur le dark web et les forums de hackers, avec des tarifs mensuels allant de 200 à 1 700 dollars. Ses usages abusifs typiques dans le domaine cryptographique incluent :

-

Falsification de projets cryptographiques : génération de livres blancs, sites web officiels, feuilles de route et textes marketing réalistes, destinés à organiser de fausses ICO/IDO ;

-

Génération massive de pages de phishing : création rapide d’interfaces imitant celles des plateformes d’échange ou de connexion de portefeuilles numériques ;

-

Activités de bots sur les réseaux sociaux : production à grande échelle de faux commentaires et campagnes promotionnelles pour faire monter artificiellement la valeur de jetons frauduleux ou nuire à des projets concurrents ;

-

Attaques d’ingénierie sociale : ce chatbot peut imiter une conversation humaine, instaurer la confiance avec des utilisateurs naïfs et les amener à divulguer involontairement des informations sensibles ou à exécuter des actions nuisibles.

GhostGPT : un assistant IA sans contrainte morale

GhostGPT est un chatbot d’IA explicitement positionné comme dépourvu de toute limite éthique. Ses usages abusifs typiques dans le domaine cryptographique incluent :

-

Attaques de phishing sophistiquées : génération d’e-mails extrêmement réalistes, usurpant l’identité d’une bourse majeure pour envoyer de fausses demandes de vérification KYC, des alertes de sécurité ou des notifications de blocage de compte ;

-

Génération de code malveillant pour contrats intelligents : même sans compétence en programmation, un attaquant peut utiliser GhostGPT pour produire rapidement des contrats intelligents contenant des portes dérobées ou une logique frauduleuse, destinés à des escroqueries de type Rug Pull ou à des attaques contre des protocoles DeFi ;

-

Voleurs polymorphes de cryptomonnaies : génération de logiciels malveillants capables de se transformer continuellement pour voler des fichiers de portefeuille, des clés privées et des phrases de récupération. Leur nature polymorphe rend difficile leur détection par les logiciels de sécurité traditionnels basés sur les signatures ;

-

Attaques d’ingénierie sociale : combiné à des scripts générés par IA, GhostGPT permet de déployer des robots sur Discord, Telegram, etc., pour inciter les utilisateurs à participer à des mintings fictifs de NFT, à des airdrops ou à des projets d’investissement frauduleux ;

-

Escroqueries par deepfake : couplé à d’autres outils d’IA, GhostGPT peut contribuer à générer des voix falsifiées de fondateurs de projets cryptos, d’investisseurs ou de cadres de bourses, afin de perpétrer des appels téléphoniques frauduleux ou des attaques BEC.

Venice.ai : les risques liés à un accès sans censure

Venice.ai propose un accès à plusieurs LLM, y compris certains modèles moins censurés ou plus permissifs. Positionnée comme une passerelle ouverte permettant aux utilisateurs d’explorer librement les capacités des LLM, la plateforme offre des modèles avancés, précis et non censurés, promettant une expérience d’IA véritablement illimitée. Toutefois, cette liberté comporte également un risque élevé d’exploitation par des acteurs malveillants pour générer du contenu nuisible. Les dangers liés à cette plateforme incluent :

-

Génération de contenu malveillant en contournant les filtres : les attaquants peuvent utiliser les modèles moins restrictifs de la plateforme pour produire des modèles de phishing, de la propagande mensongère ou des idées d’attaques ;

-

Abaissement du seuil technique du « prompt engineering » : même sans maîtriser des techniques avancées de « jailbreak », les attaquants peuvent aisément obtenir des sorties normalement bloquées ;

-

Accélération de l’itération des discours d’attaque : les attaquants peuvent tester rapidement la réaction de différents modèles face à des instructions malveillantes, afin d’optimiser leurs scripts frauduleux et leurs méthodes d’attaque.

Pour conclure

L’émergence des LLM sans restriction marque une nouvelle ère de menaces en cybersécurité, plus complexes, massives et automatisées. Ces modèles abaissent non seulement le seuil d’entrée pour les attaques, mais introduisent aussi des menaces nouvelles, plus dissimulées et plus trompeuses.

Dans cet affrontement constant entre attaque et défense, tous les acteurs de l’écosystème de sécurité doivent coopérer étroitement pour anticiper les risques futurs : d’une part, il faut renforcer les investissements dans les technologies de détection, afin d’identifier et de bloquer les contenus de phishing, les exploits de vulnérabilités dans les contrats intelligents et le code malveillant générés par des LLM malveillants ; d’autre part, il convient de renforcer les capacités de résistance aux tentatives de « jailbreak » des modèles, et d’explorer des mécanismes de tatouage numérique (watermarking) et de traçabilité, permettant notamment de remonter à la source des contenus malveillants dans des contextes critiques tels que la finance ou la génération de code ; enfin, il est essentiel de mettre en place des normes éthiques solides et des cadres réglementaires, afin de limiter dès l’origine le développement et l’usage abusif de modèles malveillants.

Bienvenue dans la communauté officielle TechFlow

Groupe Telegram :https://t.me/TechFlowDaily

Compte Twitter officiel :https://x.com/TechFlowPost

Compte Twitter anglais :https://x.com/BlockFlow_News