Les applications pilotées par l'IA : où se situe exactement le « nouveau fossé défensif » ?

TechFlow SélectionTechFlow Sélection

Les applications pilotées par l'IA : où se situe exactement le « nouveau fossé défensif » ?

Pour créer une entreprise durablement rentable, vous devez établir autour de celle-ci un fossé défensif solide.

Dans les affaires, je recherche des châteaux commerciaux protégés par un fossé défensif solide.

— Warren Buffett

Il y a six ans, Jerry Chen a publié sur Greylock un article intitulé « The New Moats : Why Intelligent Systems Are the Next Defensible Business Model », suggérant que les startups devraient tirer parti de l’intelligence artificielle pour construire des fossés défensifs durables. Aujourd’hui, avec la prolifération croissante de modèles LLM open source, il semble que la construction d’un grand modèle linguistique propriétaire ne constitue plus une barrière suffisante. Alors, quelle sera la prochaine ligne de défense pour les entreprises d’IA ? Il y a quelques jours, Jerry Chen a réexaminé les systèmes intelligents et les fossés traditionnels des entreprises technologiques, tout en proposant une vision prospective du nouveau fossé à l’ère de l’ouverture massive des LLM.

Réflexion TechFlow

- Fossés commerciaux traditionnels : les économies d’échelle, les effets de réseau, les technologies profondes/PI/acquis sectoriels, les coûts élevés de changement et la marque/la fidélité client constituent les fossés classiques des entreprises technologiques.

- Nouveaux fossés à l’ère Gen-AI :

1. Barrières du modèle fondamental : 1) La manière de résoudre des problèmes complexes passe désormais moins par la conception fine du produit ou de l’interface, mais plutôt par le modèle lui-même. Le modèle de base devient ainsi l’un des principaux fossés technologiques/de propriété intellectuelle actuels. En revanche, les startups situées au niveau applicatif n’ont pour l’instant pas réussi à établir des barrières suffisantes. 2) Les fossés basés sur la technologie profonde persistent, à condition qu’ils reposent sur des solutions peu substituables, nécessitant des efforts d’ingénierie importants et des savoir-faire opérationnels pour atteindre l’échelle.

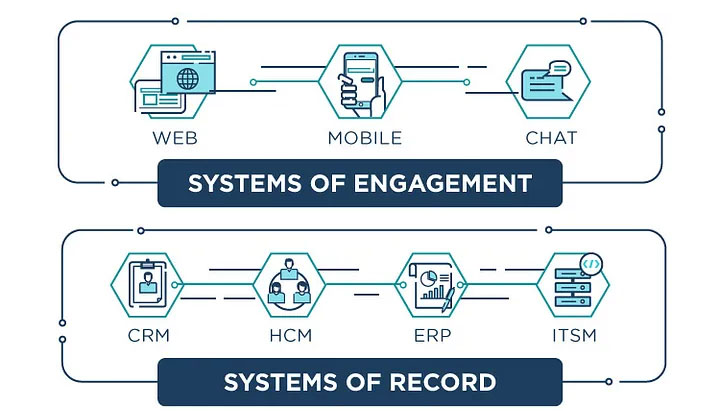

2. Barrières des systèmes intelligents : 1) Les systèmes d’entreprise peuvent être divisés entre « systèmes d’enregistrement » (systems of record) et « systèmes d’engagement » (systems of engagement). La valeur stratégique est maximale pour les seconds. Les interactions multimodales vont bouleverser les systèmes d’engagement, ce qui aura un impact sur les systèmes d’enregistrement. 2) Un « système intelligent » relie et gère plusieurs jeux de données et systèmes d’enregistrement. Trois domaines principaux se distinguent : les applications orientées client centrées sur le parcours client, les applications destinées aux employés (gestion RH, services IT, finance, etc.) et les systèmes d’infrastructure (sécurité, calcul/mémorisation/réseau, surveillance/gestion).

- Ce qui ne change pas : la valeur d’une application réside dans sa capacité à délivrer de la valeur. Les flux de travail, l’intégration aux données et à d’autres applications, la marque/confiance, les effets de réseau, l’échelle et l’efficacité coût restent des sources de création de valeur économique et de barrières. L’IA ne transforme ni la commercialisation, ni la vente, ni les partenariats des startups. Maîtriser la mise sur marché reste essentiel.

Introduction

Pour créer une entreprise durablement rentable, il faut construire autour d’elle des fossés défensifs solides. Cela est particulièrement crucial à l’heure où nous traversons la plus grande transformation de plateforme depuis une génération : les applications migrent vers le cloud, sont consommées sur iPhone, Echo ou Tesla, s’appuient sur des composants open source et sont pilotées par l’IA et les données. Ces bouleversements rendent obsolètes certains anciens fossés, laissant les PDG avec le sentiment presque impossible de bâtir une activité défendable.

L’essor continu de modèles open source comme LLaMA, Alpaca, Vicuna ou RedPajama pousse Google à déclarer : « Nous n’avons pas de fossé, OpenAI non plus. » Les avantages propriétaires détenus par Google et OpenAI sont progressivement minés par l’open source, notamment après le lancement du modèle LLaMA par Meta, qui a engendré tout un écosystème de modèles dérivés (et améliorés) basés sur LLaMA. Google reconnaît ironiquement : « Le seul gagnant clair ici, c’est Meta. Puisque le modèle fuité est le leur, ils bénéficient en réalité d’une main-d’œuvre gratuite fournie par toute la planète. »

Cependant, Meta n’est pas le seul bénéficiaire de cette évolution. Toutes les startups du marché, grandes ou petites, tirent également profit de cette dynamique. Dans l’article original « The New Moats » publié il y a six ans, l’auteur avait correctement anticipé le pouvoir de l’open source, mais s’était trompé en supposant qu’il ne bénéficierait qu’aux grands fournisseurs cloud capables de distribuer massivement des services open source. Au contraire, cette nouvelle génération de modèles IA pourrait recentraliser le pouvoir entre les mains des startups, qui peuvent désormais exploiter ces modèles fondamentaux — qu’ils soient open source ou non — dans leurs produits.

En réalité, parmi les premiers bénéficiaires de cette vague d’IA figurent des entreprises existantes et des startups ayant déjà réussi à intégrer l’IA générative dans leurs applications, telles qu’Adobe, Abnormal, Coda, Notion, Cresta, Instabase, Harvey, EvenUp, CaseText et Fermat.

Pour paraphraser Darwin : « Ce ne sont pas les entreprises les plus puissantes (ni les plus grandes, ni les mieux financées, ni les plus connues) qui survivront, mais celles qui s’adapteront le mieux à l’intégration de l’IA. » L’objectif de cet article n’est pas de discuter de l’existence même des fossés, mais d’identifier où la valeur de l’IA s’accumule et explose.

Historiquement, les technologies open source ont eu tendance à réduire la valeur de la couche sur laquelle elles reposent, tout en transférant celle-ci vers les couches adjacentes. Par exemple, des systèmes d’exploitation open source comme Linux ou Android ont diminué la dépendance des applications à Windows ou iOS, transférant davantage de valeur vers la couche applicative. Cela ne signifie pas que la couche open source soit sans valeur (Windows et iOS ont clairement de la valeur !). On peut toujours créer de la valeur via des modèles commerciaux open source basés sur le cloud, comme Databricks, MongoDB ou Chronosphere.

Dans l’article de six ans, l’auteur insistait sur la manière dont les couches adjacentes profitaient des grands plateformes cloud. Mais concernant les modèles fondamentaux open source, on observe désormais que certaines parties de la valeur autrefois capturée par OpenAI ou Google peuvent se rediriger vers les applications, startups et infrastructures gravitant autour des LLM. OpenAI et Google continuent certes de capter de la valeur, et la capacité à construire et faire tourner ces modèles géants reste un fossé. Construire une communauté développeurs et des effets de réseau demeure aussi une barrière, mais dans un monde doté d’alternatives open source, la valeur capturée par ces fossés diminue.

Dans cet article, nous allons revoir les fossés commerciaux traditionnels utilisés par les entreprises technologiques, comprendre comment ils sont remis en cause, et montrer pourquoi les startups d’aujourd’hui doivent construire des systèmes intelligents — des applications pilotées par l’IA — qui constituent le « nouveau fossé ». Les entreprises peuvent développer différents types de fossés et les adapter au fil du temps.

Fossés commerciaux traditionnels

Pour bâtir une entreprise durablement rentable, il faut entourer son activité de fossés défensifs solides. À l’heure de la plus grande transformation de plateforme depuis une génération — avec des applications migrées vers le cloud, consommées sur iPhone, Echo ou Tesla, bâties sur des logiciels libres et pilotées par l’IA et les données — cette nécessité est plus cruciale que jamais. Ces mutations rendent caduques certains anciens fossés, donnant aux dirigeants l’impression quasi impossible de construire une entreprise défendable.

01. Économies d’échelle

Certaines des entreprises technologiques les plus grandes et les plus anciennes possèdent des fossés puissants. Par exemple, Microsoft, Google et Facebook (aujourd’hui Meta) bénéficient tous de fossés fondés sur les économies d’échelle et les effets de réseau.

À ce moment charnière de transformation technologique, les composants clés permettant de construire des produits IA de valeur sont les modèles fondamentaux — entraînés sur des dizaines de milliards, voire des trillions de paramètres, nécessitant des centaines de millions de dollars pour l’entraînement, ainsi que des ressources informatiques colossales. Sans la publication de LLaMA, la majeure partie de cette valeur serait probablement revenue à des entreprises comme Google, ou à des startups comme OpenAI, Anthropic et Inflection, disposant du capital (et des GPU) nécessaires pour entraîner ces modèles. Une question se pose : quel équilibre émergera entre les modèles de taille trillonnaire et les petits modèles ? Si la course favorise des modèles toujours plus gros, alors l’échelle pourrait bien devenir le fossé ultime.

Plus une entreprise est grande, plus elle bénéficie de leviers opérationnels, ce qui réduit ses coûts. Les services SaaS et cloud offrent de fortes économies d’échelle : on peut augmenter ses revenus et sa base clients sans avoir à modifier fondamentalement l’ingénierie du produit.

Les trois grands fournisseurs cloud mondiaux — AWS, Microsoft et Google —, en tant que partenaires clés des startups développant des modèles fondamentaux, exploitent justement ces économies d’échelle et ces effets de réseau pour rester compétitifs dans l’actuelle vague d’IA. Former un modèle IA est devenu un problème à l’échelle d’un centre de données, combinant calcul et réseau en un supercalculateur à dimension architecturale.

La dépendance aux grands fournisseurs cloud pour exécuter des modèles d’apprentissage machine complexes a même provoqué le retour en grâce d’Oracle comme partenaire privilégié. Cette entreprise, initialement en retard sur le cloud, a rattrapé son retard grâce à un partenariat avec NVIDIA et une série d’initiatives dans le domaine de l’IA. Oracle collabore aujourd’hui avec plusieurs startups de pointe, notamment Adept, Character et Cohere.

02. Effets de réseau

La loi de Metcalfe stipule qu’un produit ou service présente un « effet de réseau » si chaque utilisateur supplémentaire apporte davantage de valeur à tous les autres utilisateurs. Des applications comme Slack ou WhatsApp, ou encore le réseau social Facebook, illustrent parfaitement cet effet. Les systèmes d’exploitation comme iOS, Android ou Windows possèdent aussi de forts effets de réseau : plus il y a d’utilisateurs, plus d’applications sont développées dessus.

L’un des fournisseurs cloud les plus réussis, Amazon Web Services (AWS), combine avantage d’échelle et puissance des effets de réseau. Parce que « les clients et les données sont là », de plus en plus d’applications et services sont construits sur AWS. Réciproquement, l’écosystème d’infrastructures qui propose des solutions attire davantage de clients et développeurs, qui créent plus d’applications et génèrent plus de données, alimentant un cercle vertueux, tout en réduisant les coûts d’Amazon grâce à l’économie d’échelle.

Les premiers innovateurs à gagner des utilisateurs peuvent établir des effets de réseau. OpenAI construit rapidement un premier fossé basé sur cet effet autour de ses modèles. En particulier, ses fonctions d’appel et son architecture de plugins pourraient transformer OpenAI en un véritable « cloud IA ». Cependant, la course aux effets de réseau en est encore à ses débuts, et aucun vainqueur ne peut être désigné. De nombreux acteurs étendent déjà ce concept, créant des agents comme LlamaIndex, Langchain, AutoGPT, BabyAGI, tous visant à automatiser une partie de votre application, infrastructure ou vie quotidienne.

03. Technologies profondes / Propriété intellectuelle / Expertise sectorielle

La plupart des entreprises technologiques commencent par un logiciel ou une méthode propriétaire. Ces secrets industriels peuvent inclure des solutions clés à des problèmes techniques difficiles, de nouvelles inventions, procédés ou technologies, ainsi que des brevets protégeant la propriété intellectuelle (PI) développée par la suite. Avec le temps, la PI d’une entreprise peut évoluer depuis des solutions d’ingénierie spécifiques vers un savoir-faire opérationnel accumulé ou une compréhension approfondie d’un problème ou processus.

Aujourd’hui, certaines entreprises IA construisent leurs propres modèles, utilisés à la fois pour développer des applications et fournis comme service. Parmi ces startups figurent Adept, Inflection, Anthropic, Poolside, Cohere, etc. Comme mentionné précédemment, la clé réside dans l’équilibre entre coût d’entraînement et performance. Reste à savoir si les pionniers des modèles fondamentaux, comme OpenAI ou Google, parviendront à transformer leur technologie profonde en fossé durable, ou s’ils finiront par ne constituer qu’un modèle parmi tant d’autres, face à l’open source et à la recherche académique en IA.

04. Coûts élevés de changement

Une fois qu’un client utilise votre produit, vous souhaitez qu’il lui soit le plus difficile possible de passer à un concurrent. Vous pouvez instaurer cette fidélité via la standardisation, l’absence d’alternatives, l’intégration avec d’autres applications et sources de données, ou en concevant un flux de travail ancré et précieux auquel vos clients deviennent dépendants. Chacun de ces éléments peut créer une forme de verrouillage, rendant le départ du client difficile.

On peut se demander s’il existe un coût de changement au niveau du modèle ou de l’application. Par exemple, Midjourney compte des millions d’utilisateurs générant des images via son modèle de diffusion. Si un meilleur modèle apparaît, combien serait-il difficile pour Midjourney de remplacer le sien ? Même s’il existe un meilleur modèle, combien serait-il difficile pour les utilisateurs de changer d’application ? Au cours des prochaines années, nous verrons les entreprises tenter d’établir des coûts de changement au niveau applicatif, voire au niveau du modèle.

05. Marque / Fidélité client

Une marque forte peut constituer un fossé. À chaque interaction positive entre le produit et le client, l’avantage de marque s’accroît avec le temps, mais disparaît rapidement si la confiance est perdue.

Dans le domaine de l’IA, la confiance est primordiale, mais pour beaucoup, elle n’a pas encore été conquise. Ces premiers modèles peuvent produire des « hallucinations », donner des réponses erronées ou adopter des comportements étranges, comme Sydney dans Bing. Une course s’engage donc pour bâtir une IA digne de confiance, accompagnée d’outils comme Trulens, afin de gagner la confiance des clients.

Les anciens fossés seront remodelés

De solides fossés peuvent aider une entreprise à survivre aux grandes transformations de plateforme, mais survivre ne doit pas être confondu avec prospérer.

Par exemple, les coûts élevés de changement expliquent en partie pourquoi les systèmes mainframe et « ordinateurs centraux » existent encore aujourd’hui. Les entreprises traditionnelles aux fossés profonds ne sont peut-être plus les moteurs de croissance explosive qu’elles étaient à leur apogée, mais elles continuent de générer des profits. Les entreprises doivent reconnaître et réagir à la transformation sectorielle globale, sous peine de devenir victimes de leur propre succès.

« Coût de changement » comme fossé : le chiffre d’affaires des serveurs x86 n’a dépassé celui des mainframes et autres « ordinateurs centraux » qu’en 2009.

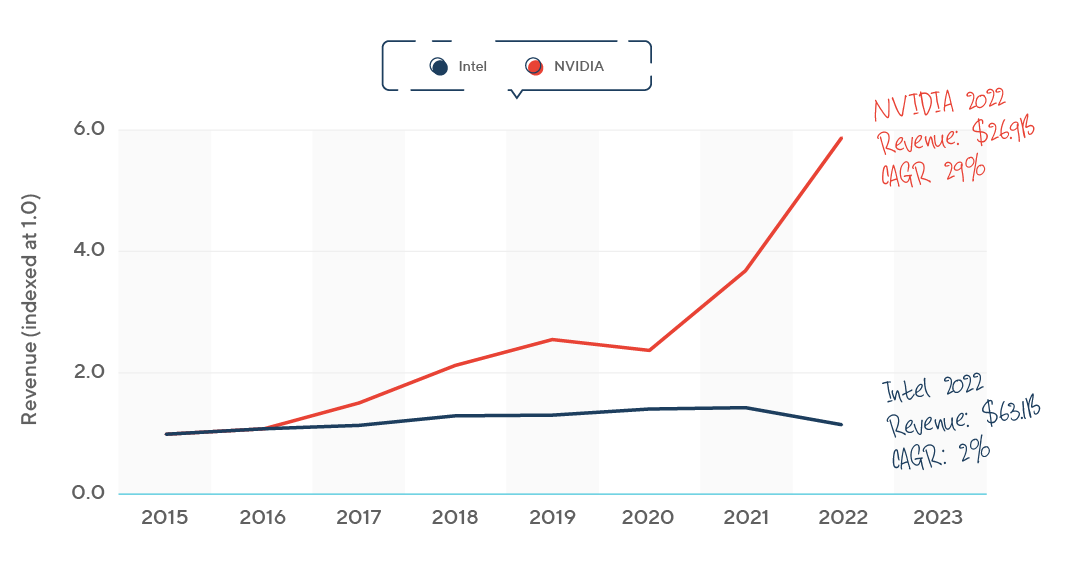

On observe la transition vers la plateforme IA à travers la performance financière de NVIDIA, principal fournisseur de GPU, comparée à Intel, leader historique des CPU. En 2020, NVIDIA a dépassé Intel pour devenir le fabricant de puces le plus valorisé. En 2023, sa capitalisation a atteint mille milliards de dollars.

Ces grandes transitions de plateforme — comme le cloud ou le mobile — sont des vagues technologiques qui créent des opportunités pour les nouveaux entrants, permettant aux fondateurs de tracer leur chemin même face à des fossés établis.

Les fondateurs de startups réussies adoptent souvent une stratégie en deux volets : 1) attaquer les fossés des entreprises traditionnelles ; 2) construire simultanément leurs propres fossés solides en phase avec la nouvelle tendance.

L’IA devient aujourd’hui la technologie de plateforme, et cette nouvelle vague de LLM pourrait rompre la hiérarchie existante entre les entreprises. Par exemple, grâce à son intégration avec ChatGPT d’OpenAI, le moteur de recherche Bing, longtemps critiqué, pourrait enfin briser le fossé de Google dans la recherche. De même, bien que Facebook possède le réseau social le plus solide, Instagram a construit une application photo centrée mobile, surfant sur la vague des smartphones, jusqu’à être racheté pour un milliard de dollars. Dans les services d’entreprise, des sociétés SaaS comme Salesforce cassent le modèle des éditeurs de logiciels locaux comme Oracle. Aujourd’hui, avec l’avènement du cloud, AWS, Azure et Google Cloud créent des canaux directs vers les clients. Ces transformations modifient aussi les rôles des acheteurs et des utilisateurs finaux. En entreprise, l’acheteur est passé de l’équipe IT centralisée aux travailleurs de bureau, puis aux utilisateurs d’iPhone, et enfin à tout développeur possédant un compte GitHub.

Aujourd’hui, les nouveaux modèles LLM ont créé une nouvelle catégorie d’utilisateurs : les ingénieurs de prompts. Avec l’entraînement des modèles d’IA générative pour divers secteurs, le rôle de l’utilisateur devient plus vaste et varié. La pérennité du rôle d’ingénieur de prompt reste à observer, à mesure que l’IA devient une composante intrinsèque de chaque produit.

Un nouveau fossé ?

Dans cette vague de disruption, est-il encore possible de construire des fossés durables ? Pour les fondateurs, chaque avantage qu’ils bâtissent semble reproductible par une autre équipe, ou limité à ceux qui opèrent à très grande échelle. Les outils open source et le cloud ont transféré le pouvoir vers les « nouvelles entreprises établies » — celles qui opèrent à grande échelle, disposent de réseaux de distribution puissants, de coûts élevés de changement et de marques fortes. Cela inclut Apple, Facebook, Google, Amazon et Salesforce.

Pourquoi a-t-on l’impression qu’« il n’y a plus de fossé » à construire ? Au temps du cloud et de l’open source, la technologie profonde pour résoudre des problèmes difficiles devient un fossé plus superficiel. L’open source rend la monétisation du progrès technologique plus ardue, tandis que la livraison via le cloud déplace la défense vers d’autres aspects du produit. Les entreprises trop focalisées sur la technologie, sans la replacer dans le contexte des besoins clients, risquent de rester coincées « entre open source et cloud ». Par exemple, les bases de données propriétaires comme celles d’Oracle subissent la concurrence de solutions open source comme Hadoop ou MongoDB, ainsi que d’innovations cloud comme Amazon Aurora ou Google Spanner. En revanche, les entreprises excellentes en expérience client peuvent trouver une défense dans les flux logiciels.

Nous pensons que le fossé technologique profond n’a pas disparu, et qu’on peut bâtir des modèles commerciaux solides autour de la propriété intellectuelle. En choisissant un segment de la stack technologique et en devenant la solution absolument meilleure, on peut créer une entreprise de valeur. Cela suppose toutefois de choisir un problème technique peu substituable, exigeant un effort d’ingénierie important et un savoir-faire opérationnel pour l’échelle.

Les modèles fondamentaux sont aujourd’hui l’un des fossés de technologie profonde / propriété intellectuelle. Les propriétaires de modèles fondamentaux publient des API et des plugins, tout en travaillant en interne à améliorer continuellement leur produit. Les développeurs peuvent relativement facilement construire des applications par-dessus les LLM open source, ce qui a donné naissance à de nombreuses startups offrant des produits spécialisés. Mais il est désormais clair que la majorité de ces startups au niveau applicatif n’ont pas construit de fossé suffisant. Elles risquent d’être accusées de « PI mince » (essentiellement des emballages simples autour de ChatGPT), et font face à un risque direct de concurrence avec les fournisseurs de modèles fondamentaux, comme illustré par la tension entre OpenAI et Jasper.

Une possibilité envisageable est que les grands modèles résolvent la plupart des problèmes complexes, tandis que les petits modèles s’attaquent à des cas spécifiques ou alimentent des dispositifs périphériques comme les téléphones, voitures ou objets connectés domestiques.

Aujourd’hui, le marché penche en faveur des entreprises « full-stack », offrant SaaS intégrant logique applicative, middleware et base de données. La technologie devient un composant invisible de la solution complète (exemple : « peu importe quelle base de données utilise votre application mobile, du moment que votre repas arrive à temps ! »). Dans le domaine grand public, Apple popularise l’expérience intégrée, fusionnant parfaitement matériel et logiciel. Cette approche domine aussi progressivement les logiciels d’entreprise. Le cloud et le SaaS permettent désormais de toucher directement les clients de façon rentable. Ainsi, les clients préfèrent de plus en plus acheter des solutions technologiques complètes sous forme d’applications SaaS, plutôt que d’acquérir séparément les composants de la stack et de construire eux-mêmes leurs applications. L’accent mis sur l’expérience applicative globale ou la « cime de la stack » explique aussi pourquoi l’auteur analyse les entreprises à travers un cadre supplémentaire : la pile des systèmes d’entreprise.

La pile des systèmes d’entreprise

01. Systèmes d’enregistrement (Systems of Record)

La couche inférieure d’un système est généralement une base de données, sur laquelle repose une application. Si les données et l’application soutiennent des fonctions critiques de l’entreprise, cela devient un « système d’enregistrement ». En entreprise, on distingue trois grands systèmes d’enregistrement : clients, employés et actifs. La gestion de la relation client (CRM) gère les clients, la gestion des talents (HCM) les employés, et la gestion des ressources d’entreprise (ERP)/finance gère les actifs.

Des générations d’entreprises se sont bâties autour de la possession d’un système d’enregistrement, chaque vague technologique produisant un nouveau vainqueur. Dans le CRM, Salesforce a remplacé Siebel comme système d’enregistrement des données clients, Workday a succédé à Oracle PeopleSoft pour les données employés. Workday s’est étendu aux données financières. D’autres applications peuvent s’appuyer sur un système d’enregistrement, mais elles sont généralement moins stratégiques ou valorisées. Par exemple, Marketo et Responsys ont bâti de grands business autour du CRM, mais n’ont jamais atteint la valeur stratégique de Salesforce.

Les modèles fondamentaux ne remplacent pas les systèmes d’enregistrement existants, mais servent à en libérer la valeur et la compréhension. Comme indiqué, plusieurs modèles fondamentaux coexistent aujourd’hui. On ignore encore si le monde évoluera vers quelques grands modèles, affinés pour divers usages, ou s’il subsistera un marché de petits modèles. Quoi qu’il en soit, ces modèles sont les éléments clés des « systèmes intelligents » évoqués dans l’article « The New Moats » de l’auteur, publié il y a six ans.

02. Systèmes d’engagement (Systems of Engagement)

Les systèmes d’engagement sont l’interface entre l’utilisateur et les systèmes d’enregistrement. Ils peuvent devenir des activités puissantes, car ils contrôlent l’interaction avec l’utilisateur final.

À l’époque des mainframes, système d’enregistrement et système d’engagement étaient liés : mainframe et terminal formaient un seul produit. La vague client-serveur a vu l’émergence d’entreprises tentant de s’imposer sur le poste de travail, mais elles ont été renversées par des entreprises basées sur le navigateur, elles-mêmes détrônées par des entreprises centrées mobile.

Parmi les entreprises actuelles qui se disputent la propriété des systèmes d’engagement figurent Slack, Amazon Alexa et diverses startups spécialisées dans les interfaces vocales/textuelles/dialogiques. En Chine, WeChat est devenu le système d’engagement dominant, évoluant en plateforme unifiée couvrant e-commerce, jeux, etc.

Les systèmes d’engagement peuvent évoluer plus vite que les systèmes d’enregistrement. Généralement, les générations successives ne disparaissent pas, mais les utilisateurs ajoutent simplement de nouveaux modes d’interaction avec leurs applications. Dans un monde multicanal, posséder le système d’engagement est extrêmement stratégique : si vous contrôlez l’essentiel des interactions utilisateur, ou si vous êtes un système transversal capable de les rejoindre partout.

Un de leurs principaux atouts stratégiques est leur capacité à coexister avec plusieurs systèmes d’enregistrement et à collecter toutes les données transitant par votre produit. Avec le temps, vous pouvez exploiter ces données cumulées pour transformer votre position d’engagement en un véritable système d’enregistrement.

Il y a six ans, l’auteur mettait en avant le chat comme nouveau système d’engagement. Slack et Microsoft Teams ont tenté de devenir le système d’engagement principal en entreprise, offrant une interface conversationnelle aux applications, mais n’ont pas atteint leurs objectifs. Cette vision « chat-first » n’est pas encore réalisée, mais les modèles fondamentaux pourraient y parvenir. Nous pourrions bientôt commander notre dîner ou planifier nos vacances en interrogeant notre assistant IA, plutôt qu’en ouvrant des applications comme Uber ou Instacart. Dans un futur où chacun possède son assistant IA, toutes les interactions pourraient ressembler à des échanges dans une messagerie. Des systèmes vocaux basés IA comme Siri ou Alexa seront remplacés par des assistants intelligents comme Pi (développé par Inflection.ai).

Le lancement des plugins et des appels d’API par OpenAI construit une nouvelle manière de créer et distribuer des applications, faisant effectivement de GPT une nouvelle plateforme. Dans ce monde, le chat pourrait devenir la porte d’entrée universelle, le système d’engagement quotidien. Observer l’évolution de l’expérience utilisateur des applications IA dans les mois à venir sera fascinant. Bien que le chat semble populaire aujourd’hui, nous prévoyons que les modèles d’interaction multimodaux créeront de nouveaux systèmes d’engagement allant au-delà du chat.

03. Nouveau fossé : systèmes intelligents (Systems of Intelligence)

Les systèmes intelligents restent le nouveau fossé.

« Qu’est-ce qu’un système intelligent, et pourquoi est-il si défendable ? »

Un système intelligent est généralement précieux parce qu’il couvre plusieurs jeux de données et plusieurs systèmes d’enregistrement. Par exemple, en combinant analyses web, données clients et données sociales, on peut prédire le comportement des utilisateurs, la désaffection, la valeur à vie (LTV), ou offrir du contenu plus pertinent. On peut construire de l’intelligence sur une seule source de données, mais cette position sera plus vulnérable face à la concurrence des fournisseurs qui possèdent les données.

Pour qu’une startup prospère autour d’acteurs établis comme Oracle ou SAP, elle doit combiner leurs données avec d’autres sources (publiques ou privées) afin de créer de la valeur pour ses clients. Les entreprises historiques ont un avantage sur leurs propres données. Par exemple, Salesforce construit un système intelligent appelé Einstein, en partant de son propre système d’enregistrement, le CRM.

Depuis la proposition du concept de « système intelligent » il y a six ans, nous avons vu émerger des applications IA incroyables : Tome, Notable Health, RunwayML, Glean, Synthesia, Fermat, et des centaines d’autres startups. Bien qu’on ignore encore où exactement la valeur s’accumulera dans cette nouvelle pile, cette transformation offre aux startups des opportunités abondantes.

Comme mentionné plus tôt, nous n’avions pas anticipé pleinement la puissance des grands modèles linguistiques, qui viennent réellement amplifier la valeur des systèmes intelligents tels que définis il y a six ans.

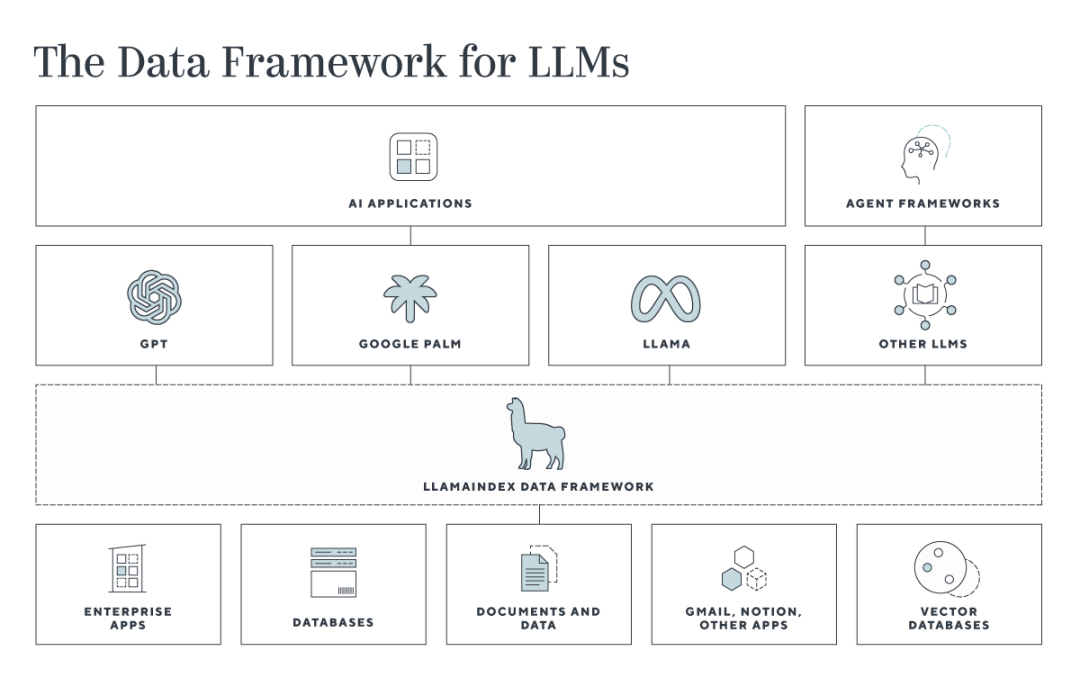

Dans les applications LLM, une « nouvelle pile » est apparue, composée d’outils intermédiaires pour chaîner les prompts ou combiner des modèles. Tout comme des entreprises ont émergé pour rendre le cloud et le stockage plus accessibles, nous voyons maintenant des startups visant à simplifier l’utilisation des modèles fondamentaux.

Cette nouvelle pile intermédiaire inclura des frameworks de données, comme LlamaIndex, pour connecter les données d’entreprise aux LLM ; des frameworks d’agents, comme Langchain, pour construire des applications et relier des modèles. En outre, une nouvelle génération d’outils de sécurité et d’observabilité sera nécessaire pour assurer disponibilité et sûreté de ces nouvelles applications.

La prochaine génération de produits d’entreprise utilisera différentes technologies d’IA pour construire des systèmes intelligents. Non seulement les applications seront transformées par l’IA, mais aussi les produits de datacenter et d’infrastructure. On peut regrouper les principaux domaines des systèmes intelligents en trois catégories : applications orientées client centrées sur le parcours client, applications destinées aux employés (gestion RH, services IT, finance, etc.), et systèmes d’infrastructure (sécurité, calcul/mémorisation/réseau, surveillance/gestion). Outre ces cas d’usage horizontaux, les startups peuvent se concentrer sur des secteurs spécifiques, construis

Bienvenue dans la communauté officielle TechFlow

Groupe Telegram :https://t.me/TechFlowDaily

Compte Twitter officiel :https://x.com/TechFlowPost

Compte Twitter anglais :https://x.com/BlockFlow_News