Chi phí của DeepSeek và các công ty khác được tính như thế nào?

Tuyển chọn TechFlowTuyển chọn TechFlow

Chi phí của DeepSeek và các công ty khác được tính như thế nào?

Cạnh tranh khốc liệt giữa các mô hình lớn, một bên đua về năng lực, một bên đua về "chi phí".

Tác giả: Vương Lộ, bản gốc Dingjiao One (dingjiaoone)

DeepSeek đã khiến toàn cầu không ngồi yên.

Hôm qua, Musk mang theo "AI thông minh nhất Trái Đất" — Gork 3 xuất hiện trong buổi phát trực tiếp, tự nhận "khả năng suy luận vượt trội mọi mô hình đã biết hiện nay", điểm số kiểm tra thời gian suy luận cũng tốt hơn DeepSeek R1 và OpenAI o1. Không lâu trước đó, ứng dụng quốc dân WeChat công bố tích hợp DeepSeek R1, đang trong giai đoạn thử nghiệm phân vùng xám, tổ hợp "bài tẩy" này được bên ngoài cho rằng lĩnh vực tìm kiếm AI sắp thay đổi.

Hiện nay, nhiều công ty công nghệ lớn toàn cầu như Microsoft, NVIDIA, Huawei Cloud, Tencent Cloud... đều đã kết nối với DeepSeek. Người dùng mạng còn phát triển các cách chơi mới lạ như bói toán, dự đoán xổ số; độ nóng này trực tiếp chuyển hóa thành tiền thật, thúc đẩy định giá của DeepSeek tăng vọt, cao nhất đã đạt mức nghìn tỷ USD.

DeepSeek có thể nổi bật ngoài việc miễn phí và dễ dùng, còn vì chỉ với chi phí GPU 5,576 triệu USD đã huấn luyện ra mô hình DeepSeek R1 có năng lực ngang bằng OpenAI o1. Dù trong những năm gần đây, các công ty mô hình AI trong và ngoài nước đã đầu tư hàng chục tỷ thậm chí hàng trăm tỷ USD vào "cuộc chiến trăm mô hình". Chi phí để Gork 3 trở thành "AI thông minh nhất thế giới" cũng rất cao, Musk nói Gork 3 tiêu thụ tổng cộng 200.000 GPU NVIDIA (mỗi chiếc khoảng 30.000 USD) trong quá trình huấn luyện, trong khi giới chuyên môn ước tính DeepSeek chỉ sử dụng khoảng hơn 10.000 chiếc.

Nhưng cũng có người tranh đua về chi phí với DeepSeek. Gần đây nhóm của Lý Phi Phi tuyên bố chỉ mất chưa đến 50 USD chi phí điện toán đám mây để huấn luyện mô hình suy luận S1, hiệu suất trong bài kiểm tra toán học và lập trình sánh ngang o1 của OpenAI và R1 của DeepSeek. Tuy nhiên cần lưu ý rằng S1 là mô hình cỡ trung, khác biệt về cấp độ tham số hàng trăm tỷ so với DeepSeek R1.

Dù vậy, sự chênh lệch khổng lồ từ 50 USD đến hàng trăm tỷ USD trong chi phí huấn luyện khiến mọi người tò mò: một mặt muốn biết năng lực DeepSeek mạnh đến đâu, tại sao mọi công ty đều cố gắng đuổi kịp hoặc vượt qua nó; mặt khác, huấn luyện một mô hình lớn thực sự tốn bao nhiêu tiền? Bao gồm những khâu nào? Tương lai, liệu có khả năng giảm thêm chi phí huấn luyện?

DeepSeek bị hiểu "thiên lệch"

Theo quan điểm của người trong ngành, trước khi trả lời những câu hỏi này, cần làm rõ vài khái niệm.

Thứ nhất, sự hiểu "thiên lệch" về DeepSeek. Mọi người kinh ngạc chỉ là một trong nhiều mô hình lớn của họ — mô hình suy luận DeepSeek-R1, nhưng họ còn có các mô hình lớn khác, chức năng giữa các sản phẩm mô hình lớn khác nhau cũng khác nhau. Và con số 5,576 triệu USD là chi phí GPU trong quá trình huấn luyện mô hình lớn phổ thông DeepSeek-V3, có thể hiểu là chi phí xử lý thuần túy.

So sánh đơn giản:

-

Mô hình lớn phổ thông:

Nhận lệnh rõ ràng, phân tích từng bước, người dùng phải mô tả rõ nhiệm vụ, bao gồm thứ tự trả lời, ví dụ cần nhắc trước là tóm tắt rồi mới đưa ra tiêu đề hay ngược lại.

Tốc độ phản hồi nhanh, dựa trên dự đoán xác suất (phản ứng nhanh), dự đoán câu trả lời qua lượng dữ liệu lớn.

-

Mô hình lớn suy luận:

Nhận nhiệm vụ đơn giản, rõ ràng, tập trung mục tiêu, người dùng nói thẳng mình cần gì, nó có thể tự lên kế hoạch.

Tốc độ phản hồi chậm hơn, dựa trên tư duy chuỗi (suy nghĩ chậm), suy luận từng bước để có đáp án.

Sự khác biệt kỹ thuật chính giữa hai loại nằm ở dữ liệu huấn luyện: mô hình phổ thông là câu hỏi + đáp án, mô hình suy luận là câu hỏi + quá trình suy nghĩ + đáp án.

Thứ hai, do DeepSeek-R1 thu hút sự chú ý cao hơn, nhiều người sai lầm cho rằng mô hình suy luận nhất định cao cấp hơn mô hình phổ thông.

Cần khẳng định, mô hình suy luận thuộc loại mô hình tiên phong, là dạng thức mới mà OpenAI đưa ra khi dạng thức tiền huấn luyện mô hình lớn gặp giới hạn, tăng thêm sức mạnh tính toán ở giai đoạn suy luận. So với mô hình phổ thông, mô hình suy luận đắt đỏ hơn và thời gian huấn luyện cũng dài hơn.

Nhưng điều này không có nghĩa mô hình suy luận nhất định tốt hơn mô hình phổ thông; thậm chí với một số loại câu hỏi, mô hình suy luận lại trở nên thừa thãi.

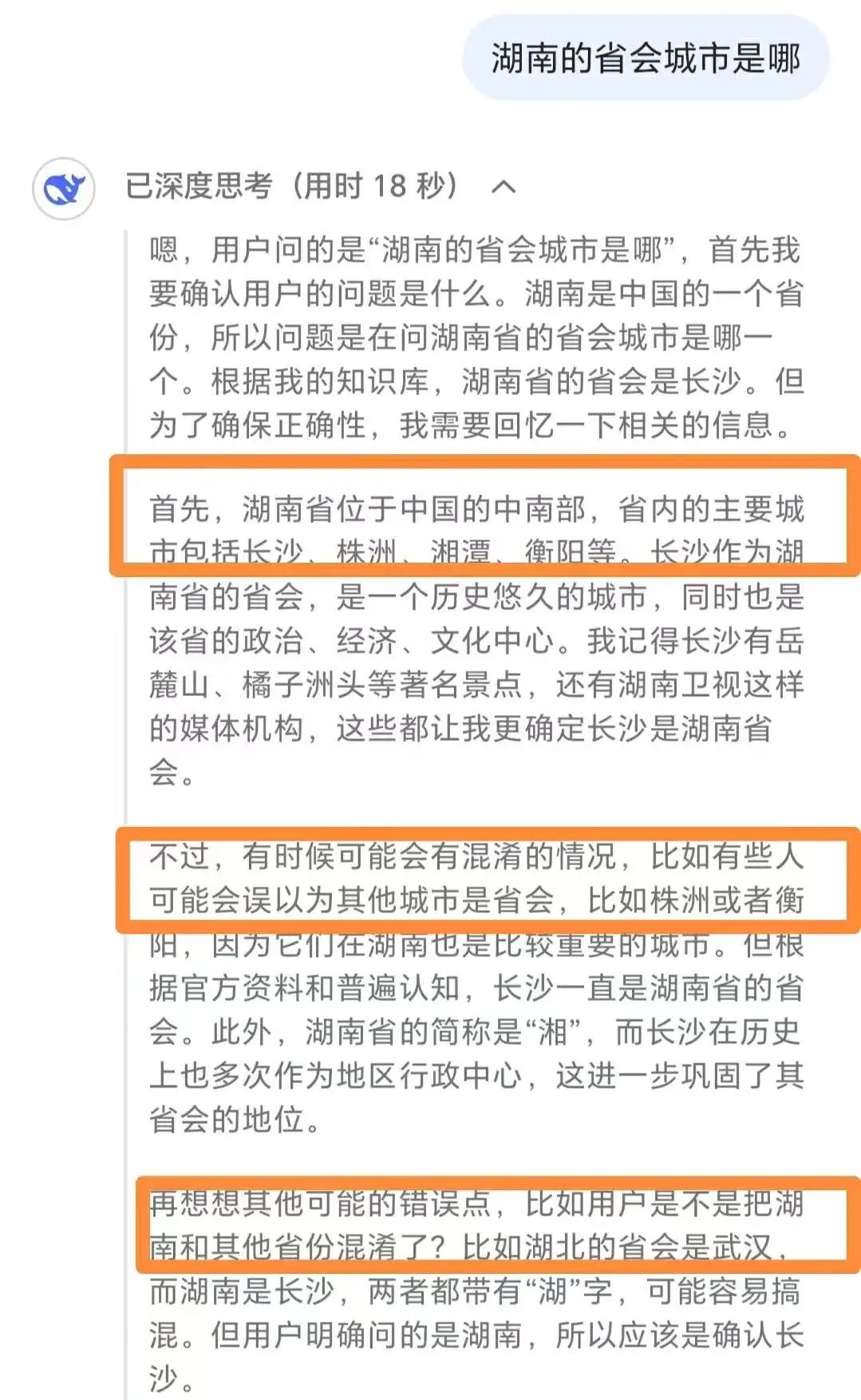

Chuyên gia nổi tiếng trong lĩnh vực mô hình lớn Lưu Thông giải thích với 「Định Tiêu One」, ví dụ hỏi thủ đô của một quốc gia/thành phố tỉnh lỵ của một địa phương, mô hình suy luận không hữu ích bằng mô hình phổ thông.

Việc DeepSeek-R1 suy nghĩ quá mức với câu hỏi đơn giản

Anh ấy nói, đối với những câu hỏi đơn giản này, mô hình suy luận không chỉ hiệu quả trả lời thấp hơn mô hình phổ thông, chi phí tính toán tiêu tốn cũng đắt đỏ, thậm chí xảy ra tình trạng suy nghĩ quá mức, cuối cùng có thể đưa ra đáp án sai.

Anh ấy khuyên, nên dùng mô hình suy luận cho các nhiệm vụ phức tạp như bài toán khó, mã hóa thách thức; còn với nhiệm vụ đơn giản như tóm tắt, dịch thuật, hỏi đáp cơ bản thì hiệu quả dùng mô hình phổ thông tốt hơn.

Thứ ba là năng lực thực sự của DeepSeek rốt cuộc thế nào.

Tổng hợp bảng xếp hạng uy tín và ý kiến người trong ngành, 「Định Tiêu One」 lần lượt xếp hạng DeepSeek trong lĩnh vực mô hình suy luận và mô hình phổ thông.

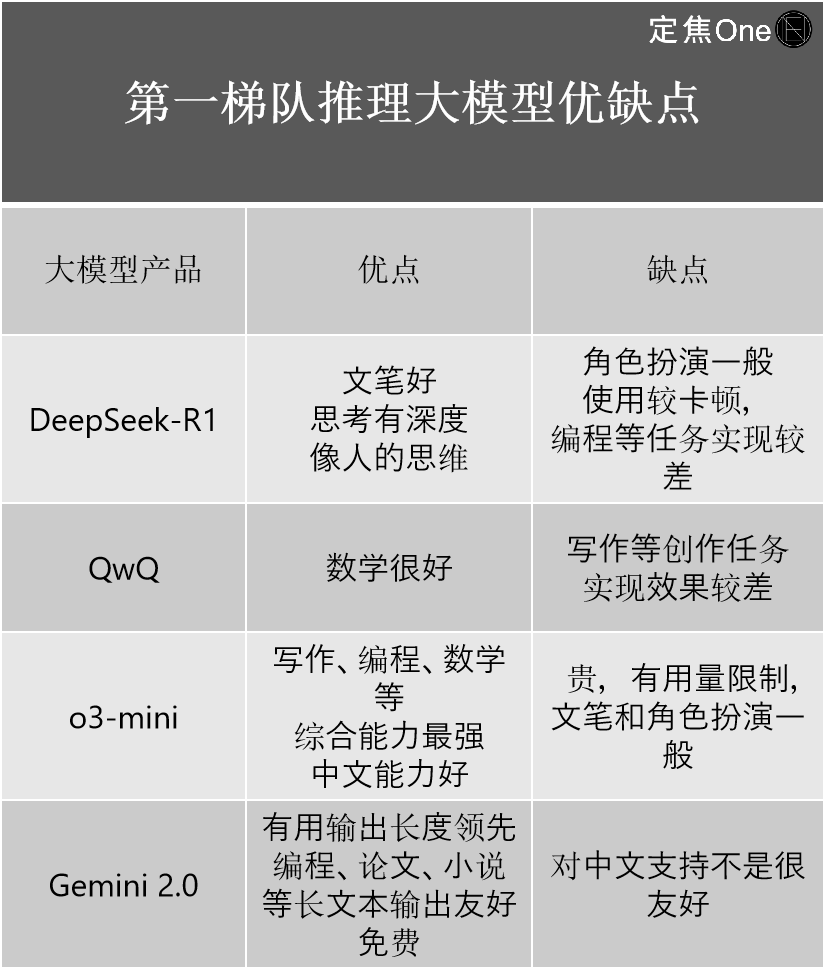

Nhóm dẫn đầu trong mô hình suy luận gồm bốn công ty: OpenAI của nước ngoài với dòng mô hình o (ví dụ o3-mini), Google với Gemini 2.0; trong nước có DeepSeek-R1, QwQ của Alibaba.

Không ít người trong ngành cho rằng, dù bên ngoài đều bàn luận DeepSeek-R1 là mô hình hàng đầu trong nước, năng lực vượt OpenAI, nhưng xét về góc độ kỹ thuật, so với o3 mới nhất của OpenAI vẫn còn một khoảng cách nhất định.

Ý nghĩa quan trọng hơn của nó là thu hẹp đáng kể khoảng cách giữa trình độ hàng đầu trong và ngoài nước. "Nếu nói khoảng cách trước đó là 2-3 đời, sau khi có DeepSeek-R1 đã thu hẹp còn 0,5 đời." Giang Thụ, người có kinh nghiệm lâu năm trong ngành AI cho biết.

Anh ấy kết hợp trải nghiệm sử dụng cá nhân, giới thiệu ưu nhược điểm của bốn công ty:

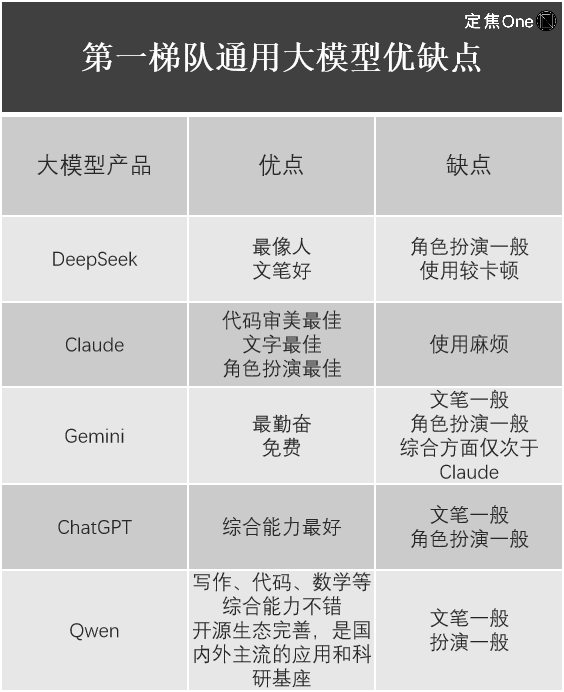

Trong lĩnh vực mô hình lớn phổ thông, theo bảng xếp hạng LM Arena (nền tảng mã nguồn mở dùng đánh giá và so sánh hiệu suất mô hình ngôn ngữ lớn - LLM), nhóm dẫn đầu gồm năm công ty: Google với Gemini (đóng mã), OpenAI với ChatGPT, Anthropic với Claude; trong nước có DeepSeek, Qwen của Alibaba.

Giang Thụ cũng liệt kê trải nghiệm dùng chúng.

Dễ thấy, dù DeepSeek-R1 gây chấn động giới công nghệ toàn cầu, giá trị là không thể phủ nhận, nhưng mỗi sản phẩm mô hình lớn đều có ưu nhược điểm riêng, DeepSeek cũng không hoàn hảo ở mọi mô hình lớn. Ví dụ Lưu Thông phát hiện, mô hình đa phương thức Janus-Pro mới nhất của DeepSeek tập trung vào nhiệm vụ hiểu và tạo hình ảnh, hiệu quả sử dụng ở mức trung bình.

Chi phí huấn luyện một mô hình lớn là bao nhiêu?

Quay lại vấn đề chi phí huấn luyện mô hình lớn, một mô hình lớn rốt cuộc hình thành như thế nào?

Lưu Thông nói, việc hình thành mô hình lớn chủ yếu gồm hai giai đoạn: tiền huấn luyện - hậu huấn luyện, nếu ví mô hình lớn như đứa trẻ, tiền huấn luyện và hậu huấn luyện giúp đứa trẻ từ lúc mới sinh chỉ biết khóc, đến hiểu nội dung người lớn nói, rồi chủ động nói chuyện với người lớn.

Tiền huấn luyện chủ yếu chỉ huấn luyện tài liệu. Ví dụ đưa lượng lớn tài liệu văn bản cho mô hình, để đứa trẻ tiếp thu tri thức, nhưng lúc này nó chỉ học được tri thức chứ chưa biết dùng.

Hậu huấn luyện phải dạy đứa trẻ cách dùng tri thức đã học, bao gồm hai phương pháp: tinh chỉnh mô hình (SFT) và học tăng cường (RLHF).

Lưu Thông nói, dù là mô hình phổ thông hay mô hình suy luận, trong nước hay ngoài nước, mọi người đều tuân theo quy trình này. Giang Thụ cũng nói với 「Định Tiêu One」, mọi công ty đều dùng mô hình Transformer, do đó về cấu trúc mô hình và bước huấn luyện cơ bản nhất, không có khác biệt bản chất.

Nhiều người trong ngành nói, chi phí huấn luyện mô hình lớn của mỗi công ty khác nhau rất lớn, tập trung chủ yếu vào ba phần: phần cứng, dữ liệu, nhân công, mỗi phần có thể áp dụng cách khác nhau, tương ứng chi phí cũng khác nhau.

Lưu Thông lấy ví dụ, về phần cứng là mua hay thuê, giá cả chênh lệch rất lớn; nếu mua, chi phí ban đầu một lần rất lớn, nhưng về sau sẽ giảm mạnh, cơ bản chỉ trả tiền điện; nếu thuê, chi phí ban đầu không lớn, nhưng phần này mãi không tiết kiệm được. Về dữ liệu huấn luyện, là mua dữ liệu sẵn hay tự thu thập, cũng khác nhau lớn. Chi phí mỗi lần huấn luyện cũng không giống nhau, lần đầu phải viết chương trình thu thập, lọc dữ liệu, nhưng phiên bản sau nhờ thao tác lặp lại từ phiên bản trước nên chi phí giảm. Số lần lặp lại phiên bản giữa chừng trước khi ra mắt mô hình cuối cùng cũng quyết định mức độ chi phí, nhưng các công ty mô hình lớn giấu kín điều này.

Tóm lại, mỗi khâu đều liên quan đến nhiều chi phí ẩn cao.

Bên ngoài từng ước tính theo GPU, chi phí huấn luyện GPT-4 ở các mô hình hàng đầu khoảng 78 triệu USD, Llama3.1 hơn 60 triệu USD, Claude3.5 khoảng 100 triệu USD. Nhưng do các mô hình hàng đầu này đều đóng mã, và không rõ các công ty có lãng phí sức mạnh tính toán hay không, bên ngoài khó biết. Cho đến khi DeepSeek cùng nhóm với chi phí 5,576 triệu USD xuất hiện.

Ảnh: Unsplash

Cần lưu ý rằng, 5,576 triệu USD là chi phí huấn luyện mô hình nền tảng DeepSeek-V3 được đề cập trong báo cáo kỹ thuật của DeepSeek. "Chi phí huấn luyện phiên bản V3 chỉ đại diện chi phí huấn luyện thành công lần cuối, còn chi phí nghiên cứu ban đầu, thử sai kiến trúc và thuật toán... đều chưa bao gồm; còn chi phí huấn luyện cụ thể R1, bài báo không đề cập." Lưu Thông nói. Nghĩa là 5,576 triệu USD chỉ là một phần nhỏ trong tổng chi phí mô hình.

Công ty phân tích và dự báo thị trường bán dẫn SemiAnalysis chỉ ra rằng, xét đến chi phí vốn máy chủ, chi phí vận hành..., tổng chi phí của DeepSeek trong 4 năm có thể đạt 2,573 tỷ USD.

Người trong ngành cho rằng, so với đầu tư hàng trăm tỷ USD của các công ty mô hình lớn khác, ngay cả tính theo 2,573 tỷ USD, chi phí của DeepSeek vẫn thấp.

Hơn nữa, quá trình huấn luyện DeepSeek-V3 chỉ cần 2.048 GPU NVIDIA, giờ GPU sử dụng chỉ 2,788 triệu giờ, trong khi OpenAI tiêu tốn hàng vạn GPU, Meta huấn luyện mô hình Llama-3.1-405B dùng tới 30,84 triệu giờ GPU.

DeepSeek không chỉ hiệu quả hơn trong giai đoạn huấn luyện mô hình, mà còn hiệu quả và tiết kiệm chi phí hơn trong giai đoạn gọi suy luận.

Thông qua định giá API của các mô hình lớn do DeepSeek đưa ra (nhà phát triển có thể gọi mô hình lớn qua API để thực hiện chức năng như tạo văn bản, tương tác hội thoại, tạo mã...), có thể thấy chi phí thấp hơn "các OpenAI". Thường thì API có chi phí phát triển cao cần định giá cao để thu hồi vốn.

Định giá API DeepSeek-R1: mỗi triệu token đầu vào 1 NDT (trúng bộ nhớ đệm), mỗi triệu token đầu ra 16 NDT; ngược lại o3-mini của OpenAI định giá mỗi triệu token đầu vào (trúng bộ nhớ đệm), đầu ra lần lượt là 0,55 USD (4 NDT), 4,4 USD (31 NDT).

Trúng bộ nhớ đệm nghĩa là đọc dữ liệu từ bộ nhớ đệm thay vì tính toán lại hoặc gọi mô hình tạo kết quả, có thể giảm thời gian xử lý dữ liệu, hạ chi phí. Ngành dùng cách phân biệt trúng và không trúng bộ nhớ đệm để nâng cao tính cạnh tranh định giá API, giá thấp cũng giúp doanh nghiệp vừa và nhỏ dễ dàng tích hợp hơn.

DeepSeek-V3 gần đây kết thúc giai đoạn ưu đãi, dù tăng từ 0,1 NDT mỗi triệu token đầu vào (trúng bộ nhớ đệm), 2 NDT mỗi triệu token đầu ra lên 0,5 NDT, 8 NDT, giá vẫn thấp hơn các mô hình chính thống khác.

Dù tổng chi phí huấn luyện mô hình lớn rất khó ước tính, người trong ngành đồng ý rằng DeepSeek có thể đại diện cho chi phí thấp nhất hiện nay của mô hình lớn hàng đầu, tương lai các công ty nên tham chiếu DeepSeek để giảm xuống.

Bài học giảm chi phí từ DeepSeek

DeepSeek tiết kiệm tiền ở đâu? Tổng hợp ý kiến người trong ngành, từ cấu trúc mô hình - tiền huấn luyện - hậu huấn luyện, mọi khía cạnh đều được tối ưu hóa.

Ví dụ để đảm bảo tính chuyên môn câu trả lời, nhiều công ty mô hình lớn dùng mô hình MoE (Mixture of Experts - hỗn hợp chuyên gia), tức khi đối mặt bài toán phức tạp, mô hình lớn sẽ chia nhỏ thành nhiều nhiệm vụ con, rồi giao từng nhiệm vụ con cho chuyên gia khác nhau giải quyết. Dù nhiều công ty mô hình lớn từng đề cập mô hình này, nhưng DeepSeek đạt đến mức độ chuyên môn hóa chuyên gia tối đa.

Bí quyết là dùng phân chia chuyên gia độ phân giải cao (chia nhỏ hơn các nhiệm vụ con trong cùng loại chuyên gia) và cách ly chuyên gia chia sẻ (cách ly một phần chuyên gia giảm dư thừa tri thức), lợi ích là tăng đáng kể hiệu suất và hiệu quả tham số MoE, trả lời nhanh và chính xác hơn.

Một người trong ngành ước tính, DeepSeekMoE chỉ dùng khoảng 40% công suất tính toán đã đạt hiệu quả tương đương LLaMA2-7B.

Xử lý dữ liệu cũng là trở ngại trong huấn luyện mô hình lớn, mọi công ty đều tìm cách nâng cao hiệu quả tính toán, đồng thời giảm nhu cầu phần cứng như bộ nhớ và băng thông. Phương pháp DeepSeek tìm được là dùng huấn luyện độ chính xác thấp FP8 (dùng tăng tốc huấn luyện học sâu) khi xử lý dữ liệu, "hành động này dẫn đầu trong các mô hình mã nguồn mở đã biết, vì đa số mô hình lớn dùng huấn luyện độ chính xác hỗn hợp FP16 hoặc BF16, tốc độ huấn luyện FP8 nhanh hơn nhiều." Lưu Thông nói.

Trong học tăng cường giai đoạn hậu huấn luyện, tối ưu hóa chiến lược là điểm khó lớn, có thể hiểu là giúp mô hình lớn ra quyết định tốt hơn, ví dụ AlphaGo qua tối ưu hóa chiến lược học được cách chọn nước đi tối ưu trong cờ vây.

DeepSeek chọn thuật toán GRPO (Tối ưu hóa Chiến lược Tương đối Nhóm) thay vì PPO (Tối ưu hóa Chiến lược Gần kề), khác biệt chính giữa hai thuật toán là khi tối ưu hóa thuật toán có dùng mô hình giá trị hay không, cái trước dùng phần thưởng tương đối trong nhóm để ước tính hàm ưu thế, cái sau dùng mô hình giá trị riêng biệt. Ít một mô hình, yêu cầu sức mạnh tính toán tự nhiên nhỏ hơn, cũng tiết kiệm chi phí.

Và ở tầng suy luận, dùng cơ chế chú ý tiềm ẩn đa đầu (MLA) thay vì chú ý đa đầu truyền thống (MHA), giảm đáng kể chiếm dụng bộ nhớ hiển thị và độ phức tạp tính toán, lợi ích trực tiếp nhất là giảm phí giao diện API.

Tuy nhiên, điều gây cảm hứng lớn nhất cho Lưu Thông lần này từ DeepSeek là có thể nâng cao khả năng suy luận mô hình lớn từ nhiều góc độ, việc tinh chỉnh thuần mô hình (SFT) và học tăng cường thuần (RLHF) đều có thể tạo ra mô hình suy luận tốt.

Ảnh: Pexels

Nghĩa là hiện nay làm mô hình suy luận có thể theo bốn cách:

Cách 1: Học tăng cường thuần (DeepSeek-R1-zero)

Cách 2: SFT + học tăng cường (DeepSeek-R1)

Cách 3: SFT thuần (mô hình chưng cất DeepSeek)

Cách 4: Từ gợi ý thuần (mô hình nhỏ chi phí thấp)

"Trước đây trong giới đều đánh dấu SFT+ học tăng cường, mọi người không ngờ rằng làm SFT thuần và học tăng cường thuần cũng có thể đạt hiệu quả tốt." Lưu Thông nói.

Việc giảm chi phí của DeepSeek không chỉ mang lại cảm hứng kỹ thuật cho người trong ngành, mà còn ảnh hưởng đến con đường phát triển của các công ty AI.

Wang Sheng, đối tác quỹ Angel Inno, giới thiệu rằng trong việc phát triển hướng AGI, ngành AI thường có hai lựa chọn khác nhau: một là dạng thức "vũ trang tính toán", dồn kỹ thuật, tiền bạc, sức mạnh tính toán, trước tiên kéo hiệu suất mô hình lớn lên mức cao, sau đó mới xem xét ứng dụng công nghiệp; hai là dạng thức "hiệu quả thuật toán", ngay từ đầu lấy ứng dụng công nghiệp làm mục tiêu, thông qua đổi mới kiến trúc và năng lực kỹ thuật hóa, tung ra mô hình hiệu suất cao chi phí thấp.

"Một loạt mô hình DeepSeek chứng minh rằng, khi trần không tăng được, dạng thức tập trung vào tối ưu hóa hiệu quả thay vì tăng năng lực là khả thi." Wang Sheng nói.

Người trong ngành tin rằng, tương lai cùng với sự tiến hóa thuật toán, chi phí huấn luyện mô hình lớn sẽ tiếp tục giảm.

CEO & sáng lập viên Ark Investment Management, "Cô gái gỗ" từng chỉ ra rằng, trước DeepSeek, chi phí huấn luyện trí tuệ nhân tạo giảm 75% mỗi năm, chi phí suy luận thậm chí giảm 85-90%. Wang Sheng cũng từng nói, mô hình phát hành đầu năm đến cuối năm phát hành lại cùng mô hình, chi phí sẽ giảm mạnh, thậm chí có thể xuống còn 1/10.

Cơ quan nghiên cứu độc lập SemiAnalysis trong báo cáo phân tích gần đây chỉ ra rằng, việc giảm chi phí suy luận là một trong những dấu hiệu tiến bộ liên tục của trí tuệ nhân tạo. Hiệu suất mô hình lớn GPT-3 trước đây cần siêu máy tính, nhiều GPU mới hoàn thành, nay một số mô hình nhỏ cài trên laptop cũng đạt hiệu quả tương tự. Và chi phí cũng giảm rất nhiều, CEO Dario của Anthropic cho rằng định giá thuật toán hướng tới chất lượng GPT-3, chi phí đã giảm 1200 lần.

Tương lai, tốc độ giảm chi phí mô hình lớn sẽ ngày càng nhanh hơn.

Chào mừng tham gia cộng đồng chính thức TechFlow

Nhóm Telegram:https://t.me/TechFlowDaily

Tài khoản Twitter chính thức:https://x.com/TechFlowPost

Tài khoản Twitter tiếng Anh:https://x.com/BlockFlow_News