Bí mật rò rỉ về mô hình mới của DeepSeek, vì sao nó có thể gây chấn động làng AI toàn cầu?

Tuyển chọn TechFlowTuyển chọn TechFlow

Bí mật rò rỉ về mô hình mới của DeepSeek, vì sao nó có thể gây chấn động làng AI toàn cầu?

DeepSeek-R1 sử dụng phương pháp học tăng cường thuần túy, thành công đạt được hiệu suất sánh ngang với các mô hình hàng đầu như GPT-4o và Claude Sonnet 3.5.

Tác giả mời viết chuyên đề "Chỉ Nam Tương Lai AI" của Tencent Tech: Hao Boyang

Chưa đầy một tháng sau lần trước, DeepSeek lại một lần nữa làm chấn động cộng đồng AI toàn cầu.

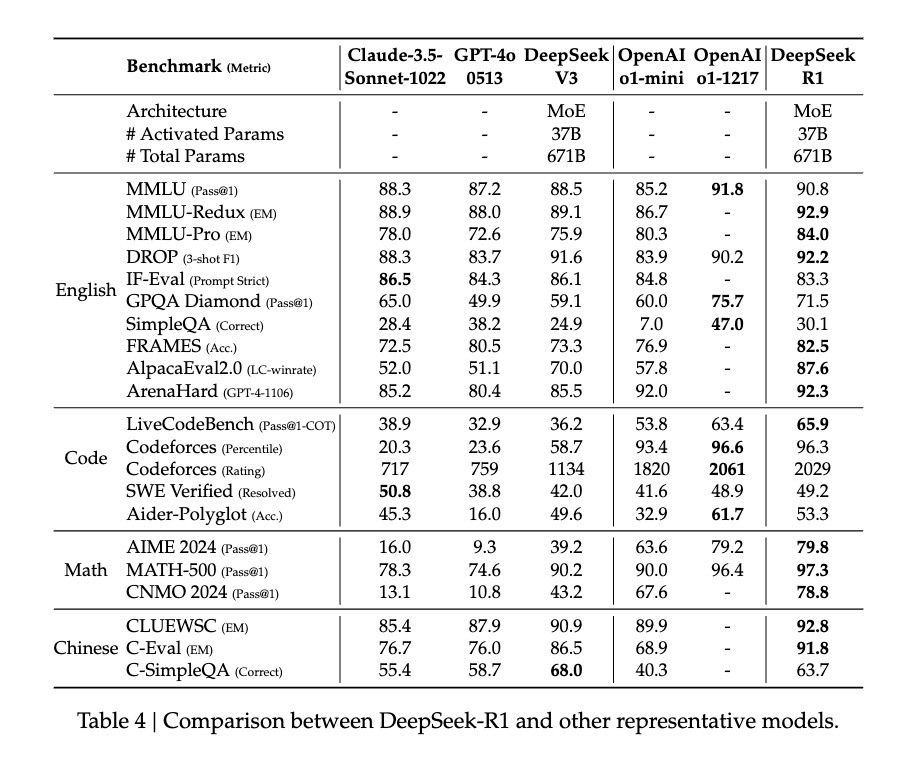

Vào tháng 12 năm ngoái, DeepSeek-V3 do DeepSeek ra mắt đã tạo nên làn sóng lớn trong lĩnh vực AI toàn cầu. Với chi phí huấn luyện cực thấp, mô hình này đạt được hiệu suất sánh ngang với các mô hình hàng đầu như GPT-4o và Claude Sonnet 3.5, gây chấn động giới chuyên môn. Tencent Tech từng phân tích sâu về mô hình này, dùng phương pháp đơn giản nhất để giải thích bối cảnh công nghệ giúp nó vừa tiết kiệm chi phí vừa đạt hiệu quả cao.

Khác với lần trước, mô hình mới DeepSeek-R1 lần này không chỉ có chi phí thấp hơn mà còn được nâng cấp đáng kể về mặt kỹ thuật, và quan trọng hơn – đây là một mô hình mã nguồn mở.

Mô hình mới này tiếp tục phát huy lợi thế về tỷ lệ hiệu suất trên giá thành, chỉ dùng 1/10 chi phí để đạt được mức độ hiệu năng tương đương GPT-o1.

Vì vậy, nhiều chuyên gia trong ngành thậm chí đã hô vang khẩu hiệu “DeepSeek kế nhiệm OpenAI”, và ngày càng nhiều người đổ dồn sự chú ý vào những đột phá về phương pháp huấn luyện của mô hình.

Ví dụ, Elvis – cựu nhân viên Meta AI, tác giả nổi tiếng về các bài viết Twitter về luận văn AI – nhấn mạnh rằng bài báo về DeepSeek-R1 thực sự là một báu vật, vì nó khám phá nhiều phương pháp cải thiện khả năng suy luận của mô hình ngôn ngữ lớn, đồng thời phát hiện ra những đặc tính nổi trội rõ ràng hơn.

Một KOL khác trong cộng đồng AI, Yuchen Jin, cho rằng phát hiện trong bài báo DeepSeek-R1 về việc mô hình sử dụng phương pháp RL thuần túy để tự học và phản tư quá trình suy luận là cực kỳ quan trọng.

Jim Fan, trưởng dự án GEAR Lab tại NVIDIA, cũng đề cập trên Twitter rằng DeepSeek-R1 sử dụng phần thưởng thật được tính toán bằng quy tắc cứng (hard-coded rules), thay vì bất kỳ mô hình phần thưởng học dễ bị lừa trong RL. Điều này khiến mô hình xuất hiện hành vi tự phản tư và tự khám phá.

Vì những phát hiện cực kỳ quan trọng này đều được DeepSeek-R1 công bố mã nguồn mở hoàn toàn, Jim Fan thậm chí cho rằng đây chính là điều mà OpenAI lẽ ra nên làm.

Vậy vấn đề đặt ra là: Phương pháp RL thuần túy họ nói đến là gì? Và “khoảnh khắc Aha” mà mô hình thể hiện chứng minh điều gì về khả năng nổi trội (emergent ability) của AI? Chúng ta còn muốn biết hơn cả thế: Đổi mới quan trọng này của DeepSeek-R1 sẽ mang ý nghĩa gì đối với tương lai phát triển của lĩnh vực AI?

Dùng công thức đơn giản nhất, trở về với học tăng cường thuần khiết nhất

Sau khi o1 ra đời, việc tăng cường suy luận trở thành phương pháp được quan tâm nhất trong ngành.

Thông thường, một mô hình trong quá trình huấn luyện sẽ thử nghiệm một phương pháp cố định nhằm nâng cao khả năng suy luận.

Nhưng đội ngũ DeepSeek trong quá trình huấn luyện R1 đã thử nghiệm trực tiếp ba hướng kỹ thuật hoàn toàn khác nhau: huấn luyện học tăng cường trực tiếp (R1-Zero), huấn luyện tiến dần theo nhiều giai đoạn (R1), và chưng cất mô hình (model distillation) – và tất cả đều thành công. Cả hai phương pháp huấn luyện theo nhiều giai đoạn và chưng cất mô hình đều chứa đựng nhiều yếu tố đổi mới to lớn, có ảnh hưởng sâu rộng đến ngành.

Tuy nhiên, điều khiến người ta phấn khích nhất vẫn là con đường học tăng cường trực tiếp. Bởi vì DeepSeek-R1 là mô hình đầu tiên chứng minh được tính hiệu quả của phương pháp này.

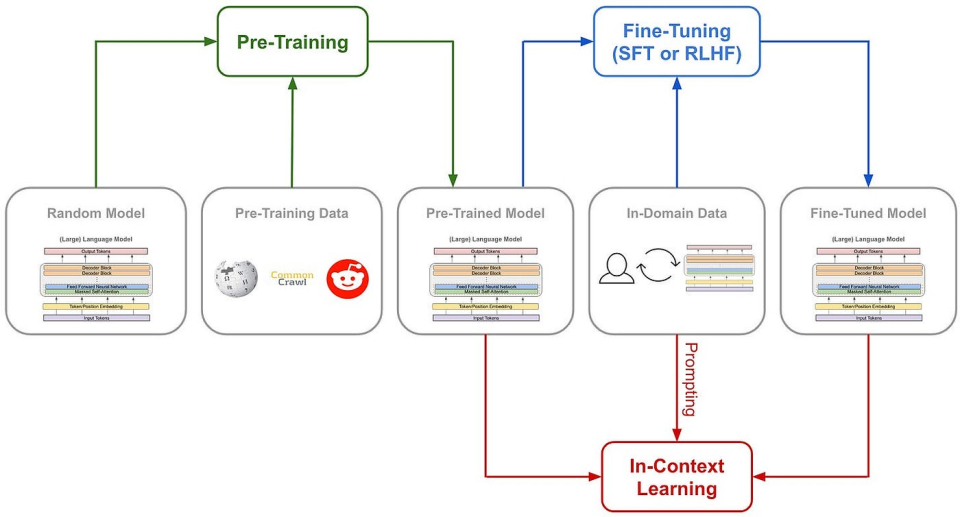

Trước hết, hãy tìm hiểu phương pháp truyền thống để huấn luyện khả năng suy luận của AI: thường là thông qua SFT (fine-tuning giám sát), thêm vào rất nhiều ví dụ chuỗi tư duy (Chain of Thought - CoT), kết hợp với các mô hình phần thưởng phức tạp như mô hình phần thưởng theo quá trình (Process Reward Model - PRM), để dạy mô hình cách suy nghĩ theo chuỗi lập luận.

Thậm chí còn áp dụng cả tìm kiếm cây Monte Carlo (Monte Carlo Tree Search - MCTS), để mô hình tìm ra lựa chọn tốt nhất giữa nhiều khả năng.

(Đường đi huấn luyện mô hình truyền thống)

Nhưng DeepSeek-R1 Zero chọn một con đường chưa từng có – đó là con đường “thuần” học tăng cường, hoàn toàn loại bỏ các mẫu chuỗi tư duy (Chain of Thought) và fine-tuning giám sát (SFT), chỉ dựa vào tín hiệu phần thưởng đơn giản để tối ưu hóa hành vi của mô hình.

Điều này giống như việc để một đứa trẻ thiên tài học giải bài tập mà không cần bất kỳ ví dụ hay hướng dẫn nào, chỉ thông qua việc liên tục thử nghiệm và nhận phản hồi.

DeepSeek-R1 Zero chỉ sở hữu một hệ thống phần thưởng đơn giản nhất để kích hoạt khả năng suy luận của AI.

Hệ thống này gồm hai quy tắc:

1. Phần thưởng về độ chính xác: mô hình đánh giá phản hồi có đúng hay không. Đúng thì cộng điểm, sai thì trừ điểm. Cách đánh giá cũng rất đơn giản: ví dụ, với các bài toán toán học có kết quả xác định, mô hình phải đưa ra đáp án cuối cùng theo định dạng cụ thể (như nằm giữa <answer> và </answer>); với bài toán lập trình, có thể dùng bộ biên dịch để sinh phản hồi dựa trên các test case đã định sẵn.

2. Phần thưởng về định dạng: mô hình phần thưởng định dạng yêu cầu mô hình phải đặt quá trình suy luận của mình trong cặp thẻ <think> và </think>. Làm đúng thì cộng điểm, không làm thì trừ điểm.

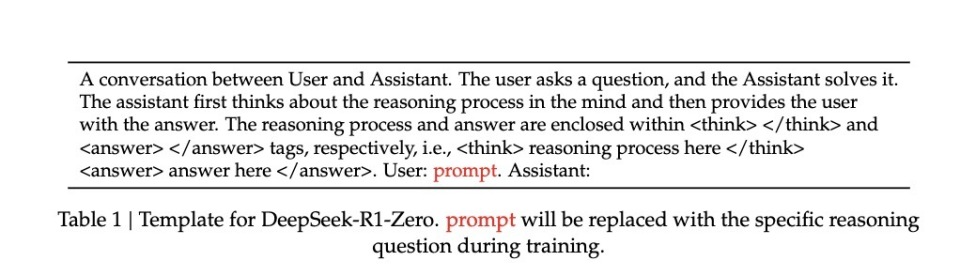

Để quan sát chính xác quá trình phát triển tự nhiên của mô hình trong quá trình học tăng cường (RL), DeepSeek thậm chí cố tình chỉ giới hạn từ khóa hệ thống (system prompt) ở mức cấu trúc định dạng này, nhằm tránh mọi định kiến riêng biệt về nội dung – ví dụ như ép buộc mô hình phải thực hiện suy luận phản tư hoặc phổ biến một chiến lược giải quyết vấn đề cụ thể nào đó.

(Từ khóa hệ thống của R1 Zero)

Chỉ với một quy tắc đơn giản như vậy, AI tự sinh mẫu + so sánh dưới luật GRPO (Group Relative Policy Optimization), từ đó tự cải thiện.

Thực ra mô hình GRPO khá đơn giản: tính gradient chiến lược dựa trên so sánh tương đối giữa các mẫu trong nhóm, hiệu quả giảm thiểu sự bất ổn trong huấn luyện đồng thời nâng cao hiệu suất học.

Hiểu nôm na, bạn có thể hình dung như giáo viên ra đề, mỗi câu hỏi yêu cầu mô hình trả lời nhiều lần, rồi dùng quy tắc phần thưởng trên để chấm điểm từng câu trả lời, sau đó cập nhật mô hình theo logic tìm kiếm điểm số cao và tránh điểm số thấp.

Quy trình này đại khái như sau:

Nhập câu hỏi → Mô hình sinh nhiều câu trả lời → Hệ thống quy tắc chấm điểm → GRPO tính toán lợi thế tương đối → Cập nhật mô hình.

Phương pháp huấn luyện trực tiếp này mang lại vài lợi thế rõ rệt. Thứ nhất là nâng cao hiệu suất huấn luyện, toàn bộ quá trình có thể hoàn thành trong thời gian ngắn hơn. Thứ hai là giảm tiêu thụ tài nguyên, do loại bỏ SFT và các mô hình phần thưởng phức tạp, nhu cầu về tài nguyên tính toán giảm mạnh.

Quan trọng hơn cả, phương pháp này thực sự khiến mô hình học được cách suy nghĩ – và còn là kiểu “tỉnh ngộ”.

Dùng ngôn ngữ của chính mình, học trong khoảnh khắc “Aha”

Làm sao chúng ta nhận ra rằng mô hình thực sự học được “suy nghĩ” dưới phương pháp cực kỳ “nguyên thủy” này?

Bài báo ghi lại một trường hợp đáng chú ý: khi xử lý một biểu thức toán học phức tạp √a - √(a + x) = x, mô hình bỗng dừng lại và nói “Wait, wait. Wait. That's an aha moment I can flag here” (“Khoan đã, khoan đã, đây là một khoảnh khắc ‘Aha’ đáng để tôi đánh dấu”), sau đó xem xét lại toàn bộ quá trình giải. Hành vi giống con người “tỉnh ngộ” này hoàn toàn tự phát, không hề được thiết lập từ trước.

Loại “tỉnh ngộ” này thường là thời điểm khả năng tư duy của mô hình bứt phá.

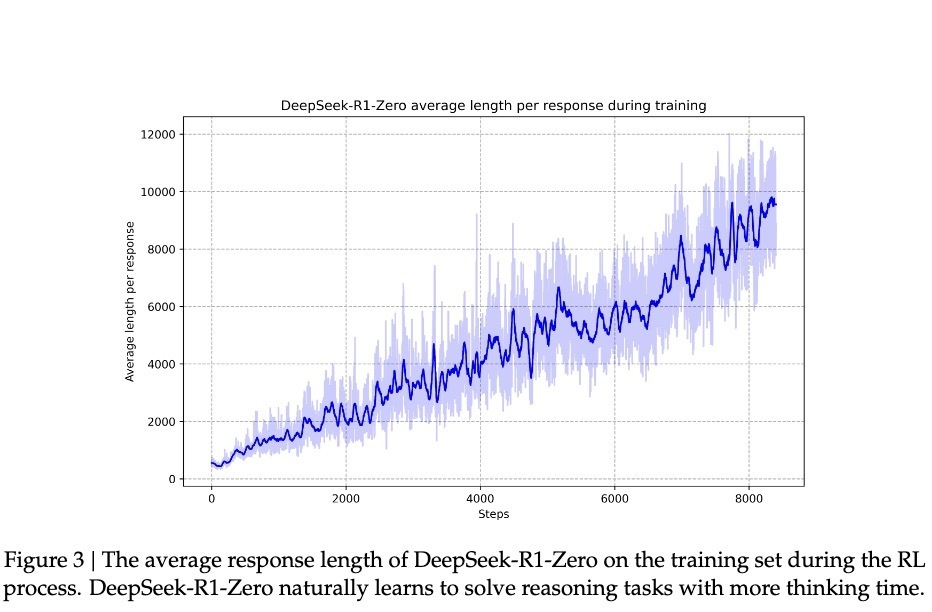

Theo nghiên cứu của DeepSeek, sự tiến bộ của mô hình không diễn ra đều đặn. Trong quá trình học tăng cường, độ dài phản hồi xuất hiện sự gia tăng đột ngột rõ rệt, những “điểm nhảy” này thường đi kèm với sự thay đổi chất lượng về chiến lược giải bài. Mô hình này giống hệt kiểu con người suy nghĩ lâu dài rồi bỗng nhiên “tỉnh ngộ”, ám chỉ một bước đột phá nhận thức sâu sắc nào đó.

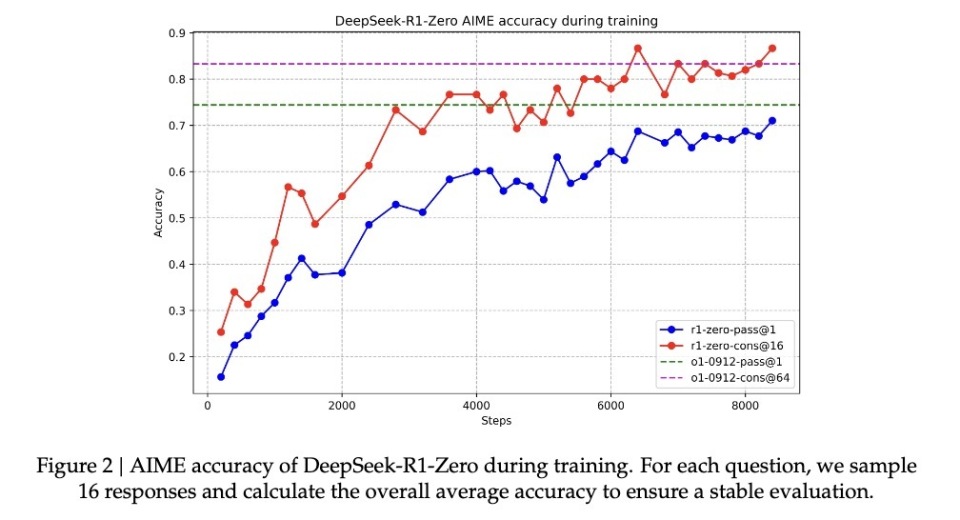

Trong bối cảnh cải thiện nhờ “tỉnh ngộ” như vậy, R1-Zero trong kỳ thi AIME danh tiếng trong giới toán học đã tăng từ ban đầu 15,6% lên tới 71,0% tỷ lệ đúng. Khi yêu cầu mô hình thử nhiều lần với cùng một câu hỏi, tỷ lệ chính xác thậm chí đạt 86,7%. Đây không phải kiểu “xem qua là biết làm” – bởi các đề AIME đòi hỏi trực giác toán học sâu sắc và tư duy sáng tạo, chứ không phải ứng dụng công thức máy móc. Về cơ bản, mô hình chỉ có thể đạt được sự cải thiện như vậy nếu thực sự biết suy luận.

Một bằng chứng cốt lõi khác cho thấy mô hình thực sự học được suy luận là độ dài phản hồi của mô hình tự điều chỉnh theo độ phức tạp của câu hỏi. Hành vi thích nghi này cho thấy nó không đơn thuần áp dụng khuôn mẫu, mà thực sự hiểu được mức độ khó của vấn đề, và tương ứng bỏ ra nhiều “thời gian suy nghĩ” hơn. Giống như con người khi đối mặt với phép cộng đơn giản hay tích phân phức tạp sẽ tự điều chỉnh thời gian suy nghĩ, R1-Zero cũng thể hiện trí tuệ tương tự.

Có lẽ thuyết phục nhất là khả năng chuyển giao học tập (transfer learning) mà mô hình thể hiện. Trên nền tảng thi lập trình hoàn toàn khác biệt Codeforces, R1-Zero đạt trình độ vượt qua hơn 96,3% thí sinh con người. Thành tích xuyên miền này cho thấy mô hình không phải đang học vẹt các kỹ thuật giải đề theo lĩnh vực, mà đã nắm bắt được một dạng năng lực suy luận phổ quát.

Một thiên tài thông minh nhưng nói năng lộn xộn

Dù R1-Zero thể hiện khả năng suy luận đáng kinh ngạc, các nhà nghiên cứu nhanh chóng phát hiện một vấn đề nghiêm trọng: quá trình suy luận của nó thường khó hiểu đối với con người.

Bài báo thẳng thắn chỉ ra rằng mô hình được huấn luyện thuần bằng học tăng cường này tồn tại vấn đề “poor readability” (khả năng đọc kém) và “language mixing” (trộn lẫn ngôn ngữ).

Hiện tượng này thực ra rất dễ hiểu: R1-Zero hoàn toàn tối ưu hành vi dựa trên tín hiệu phần thưởng, không có bất kỳ “đáp án chuẩn mực” nào của con người làm tham chiếu. Giống như một đứa trẻ thiên tài tự phát minh ra phương pháp giải đề, tuy luôn thành công nhưng khi giải thích cho người khác thì lại nói năng lộn xộn. Trong quá trình giải đề, nó có thể dùng nhiều ngôn ngữ cùng lúc, hoặc phát triển ra cách diễn đạt đặc biệt, khiến quá trình suy luận của nó khó theo dõi và hiểu được.

Chính để giải quyết vấn đề này, đội ngũ nghiên cứu đã phát triển phiên bản cải tiến DeepSeek-R1. Bằng cách đưa vào dữ liệu khởi tạo lạnh (cold-start data) truyền thống hơn và quy trình huấn luyện đa giai đoạn, R1 không chỉ giữ vững khả năng suy luận mạnh mẽ mà còn học được cách diễn đạt quá trình tư duy theo cách con người dễ hiểu. Điều này giống như gán cho đứa trẻ thiên tài một huấn luyện viên giao tiếp, dạy nó cách trình bày ý tưởng một cách rõ ràng.

Sau quá trình “đào tạo” này, DeepSeek-R1 thể hiện hiệu năng tương đương hoặc thậm chí vượt trội hơn OpenAI o1 ở một số khía cạnh. Trong bộ kiểm thử MATH, R1 đạt tỷ lệ chính xác 77,5%, gần bằng o1 với 77,3%; trong AIME 2024 khó hơn, R1 đạt 71,3% chính xác, vượt o1 (71,0%). Trong lĩnh vực mã hóa, R1 đạt 2441 điểm trên bảng xếp hạng Codeforces, cao hơn 96,3% người tham gia.

Tuy nhiên, tiềm năng của DeepSeek-R1 Zero dường như còn lớn hơn. Khi sử dụng cơ chế bỏ phiếu đa số trong bài kiểm tra AIME 2024, nó đạt độ chính xác 86,7% – thành tích này thậm chí vượt qua o1-0912 của OpenAI. Đặc điểm “càng thử nhiều lần càng chính xác hơn” này ám chỉ rằng R1-Zero có thể đã nắm bắt được một khung suy luận cơ bản, chứ không đơn thuần là ghi nhớ mẫu giải đề. Dữ liệu luận văn cho thấy, từ MATH-500 đến AIME, rồi đến GSM8K, mô hình thể hiện hiệu suất xuyên miền ổn định, đặc biệt trong các bài toán phức tạp đòi hỏi tư duy sáng tạo. Hiệu suất phổ rộng này gợi ý rằng R1-Zero có thể thực sự đã nuôi dưỡng một dạng năng lực suy luận cơ bản, trái ngược rõ rệt với các mô hình tối ưu theo nhiệm vụ cụ thể truyền thống.

Vì vậy, dù nói năng lộn xộn, nhưng có lẽ DeepSeek-R1 Zero mới chính là “thiên tài” thực sự hiểu được suy luận.

Học tăng cường thuần túy, có thể là lối tắt bất ngờ dẫn tới AGI

Lý do DeepSeek-R1 được ra mắt khiến cả cộng đồng đổ dồn sự chú ý vào phương pháp học tăng cường thuần túy là vì nó thực sự mở ra một con đường mới cho sự tiến hóa của AI.

R1-Zero – mô hình AI được huấn luyện hoàn toàn bằng học tăng cường – thể hiện khả năng suy luận tổng quát đáng kinh ngạc. Nó không chỉ đạt thành tích ấn tượng trong các kỳ thi toán học.

Quan trọng hơn, R1-Zero không chỉ đang bắt chước suy nghĩ, mà thực sự phát triển ra một dạng năng lực suy luận nào đó.

Phát hiện này có thể thay đổi cách chúng ta nhận thức về học máy: phương pháp huấn luyện AI truyền thống có thể đã mắc phải một sai lầm căn bản, đó là chúng ta quá chú trọng vào việc bắt AI bắt chước cách tư duy của con người. Ngành cần phải suy nghĩ lại vai trò của học có giám sát trong sự phát triển của AI. Thông qua học tăng cường thuần túy, các hệ thống AI dường như có thể phát triển khả năng giải quyết vấn đề gốc rễ hơn, thay vì bị giới hạn trong khuôn khổ giải pháp đã được thiết lập sẵn.

Dù R1-Zero có khuyết điểm rõ rệt về khả năng đọc hiểu đầu ra, nhưng chính “khuyết điểm” này có thể chính là minh chứng cho sự độc đáo trong cách tư duy của nó. Giống như một đứa trẻ thiên tài phát minh ra phương pháp giải đề riêng nhưng khó diễn đạt bằng ngôn ngữ thông thường. Điều này nhắc nhở chúng ta: trí tuệ nhân tạo tổng quát thực sự có thể cần một phương thức nhận thức hoàn toàn khác biệt với con người.

Đây mới chính là học tăng cường thực sự. Như lý thuyết của nhà giáo dục nổi tiếng Piaget: sự hiểu biết thực sự đến từ việc tự xây dựng chủ động, chứ không phải tiếp nhận thụ động.

Chào mừng tham gia cộng đồng chính thức TechFlow

Nhóm Telegram:https://t.me/TechFlowDaily

Tài khoản Twitter chính thức:https://x.com/TechFlowPost

Tài khoản Twitter tiếng Anh:https://x.com/BlockFlow_News