Tiên phong về các lĩnh vực tiềm năng: Thị trường điện toán phi tập trung (phần 1)

Tuyển chọn TechFlowTuyển chọn TechFlow

Tiên phong về các lĩnh vực tiềm năng: Thị trường điện toán phi tập trung (phần 1)

Sự thiếu hụt năng lực tính toán sẽ trở thành điều tất yếu, liệu thị trường năng lực tính toán phi tập trung có phải là một lĩnh vực kinh doanh tốt?

Tác giả: Zeke, YBB Capital

Lời mở đầu

Kể từ khi GPT-3 ra đời, trí tuệ nhân tạo tạo sinh (Generative AI) với hiệu suất ấn tượng và các trường hợp ứng dụng rộng rãi đã khiến lĩnh vực trí tuệ nhân tạo bước vào thời điểm bùng nổ. Các tập đoàn công nghệ bắt đầu đổ xô nhảy vào lĩnh vực AI. Tuy nhiên, vấn đề cũng phát sinh theo sau: việc vận hành mô hình ngôn ngữ lớn (LLM) trong huấn luyện và suy luận đòi hỏi khối lượng tính toán khổng lồ; cùng với việc nâng cấp mô hình, nhu cầu và chi phí về năng lực tính toán tăng theo cấp số mũ. Ví dụ như GPT-2 và GPT-3, số lượng tham số chênh lệch tới 1.166 lần (GPT-2 có 150 triệu tham số, GPT-3 có 175 tỷ tham số), chi phí huấn luyện một lần cho GPT-3 được ước tính lên tới 12 triệu USD dựa trên giá thuê GPU đám mây công cộng tại thời điểm đó, gấp 200 lần so với GPT-2. Trong quá trình sử dụng thực tế, mỗi truy vấn của người dùng đều cần thực hiện suy luận, ví dụ như với 13 triệu người dùng độc lập truy cập vào đầu năm nay thì nhu cầu về chip tương đương hơn 30.000 GPU A100. Như vậy chi phí đầu tư ban đầu sẽ đạt con số đáng kinh ngạc là 800 triệu USD, chi phí suy luận hàng ngày ước tính khoảng 700.000 USD.

Năng lực tính toán không đủ và chi phí quá cao đã trở thành khó khăn chung mà toàn ngành AI đang phải đối mặt. Tuy nhiên, dường như ngành blockchain cũng sắp phải đối mặt với những vấn đề tương tự. Một mặt, đợt giảm thưởng thứ tư của Bitcoin và khả năng thông qua ETF đang đến gần, cùng với việc giá cả tăng trong tương lai, nhu cầu của các thợ đào về phần cứng tính toán chắc chắn sẽ tăng mạnh. Mặt khác, công nghệ Chứng minh Không kiến thức ("Zero-Knowledge Proof", viết tắt là ZKP) đang phát triển mạnh mẽ, Vitalik từng nhiều lần nhấn mạnh rằng ảnh hưởng của ZK đối với lĩnh vực blockchain trong thập kỷ tới sẽ quan trọng ngang bằng chính bản thân blockchain. Mặc dù triển vọng công nghệ này được cả ngành blockchain kỳ vọng rất lớn, nhưng do quá trình tính toán phức tạp, ZK cũng giống như AI, cần tiêu tốn rất nhiều năng lực tính toán và thời gian để tạo ra chứng minh.

Trong tương lai gần, tình trạng thiếu hụt năng lực tính toán là điều tất yếu xảy ra, vậy thì thị trường tính toán phi tập trung có phải là một cơ hội kinh doanh tốt?

Định nghĩa thị trường tính toán phi tập trung

Thị trường tính toán phi tập trung về cơ bản tương đương với赛道 điện toán đám mây phi tập trung, tuy nhiên so với khái niệm "điện toán đám mây phi tập trung", cá nhân tôi cho rằng từ ngữ này mô tả chính xác hơn các dự án mới sẽ được đề cập dưới đây. Thị trường tính toán phi tập trung nên thuộc tập hợp con của DePIN (Mạng hạ tầng vật lý phi tập trung), mục tiêu nhằm xây dựng một thị trường tính toán mở, thông qua cơ chế phần thưởng bằng token để bất kỳ ai sở hữu tài nguyên tính toán nhàn rỗi đều có thể cung cấp tài nguyên của họ trên thị trường này, chủ yếu phục vụ nhóm khách hàng doanh nghiệp (B2B) và các nhà phát triển. Xét từ những dự án đã khá quen thuộc, ví dụ như mạng lưới giải pháp render dựa trên GPU phi tập trung Render Network và thị trường điểm-điểm phân tán dành cho điện toán đám mây Akash Network đều thuộc về lĩnh vực này.

Phần tiếp theo sẽ bắt đầu từ những khái niệm cơ bản, sau đó đi sâu thảo luận ba thị trường mới nổi trong lĩnh vực này: thị trường tính toán AGI, thị trường tính toán Bitcoin và thị trường tăng tốc phần cứng ZK. Phần về thị trường tính toán AGI sẽ được trình bày ở đây, hai thị trường còn lại sẽ được thảo luận trong bài viết “Tiềm năng赛道前瞻:Thị trường tính toán phi tập trung (Phần Hạ)”.

Tổng quan về năng lực tính toán

Khái niệm năng lực tính toán bắt nguồn từ thời điểm máy tính ra đời. Những máy tính đầu tiên hoàn thành nhiệm vụ tính toán bằng các thiết bị cơ học, và năng lực tính toán lúc đó chỉ đơn thuần là khả năng xử lý tính toán của thiết bị cơ học. Cùng với sự phát triển của công nghệ máy tính, khái niệm năng lực tính toán cũng tiến hóa theo, ngày nay thường đề cập đến khả năng phối hợp giữa phần cứng máy tính (CPU, GPU, FPGA...) và phần mềm (hệ điều hành, bộ biên dịch, ứng dụng...).

Định nghĩa

Năng lực tính toán (Computing Power) là lượng dữ liệu hoặc số lượng tác vụ tính toán mà một máy tính hoặc thiết bị tính toán khác có thể xử lý trong một khoảng thời gian nhất định. Năng lực tính toán thường được dùng để mô tả hiệu suất của máy tính hoặc thiết bị tính toán, là chỉ số quan trọng để đánh giá khả năng xử lý của một thiết bị tính toán.

Tiêu chuẩn đo lường

Năng lực tính toán có thể được đo lường bằng nhiều cách khác nhau, ví dụ như tốc độ tính toán, mức tiêu thụ năng lượng, độ chính xác tính toán, mức độ song song. Trong lĩnh vực máy tính, các chỉ số phổ biến bao gồm FLOPS (số phép tính dấu phẩy động mỗi giây), IPS (số lệnh mỗi giây), TPS (số giao dịch mỗi giây), v.v.

FLOPS (số phép tính dấu phẩy động mỗi giây) là khả năng xử lý các phép tính dấu phẩy động (toán học với các số có dấu phẩy, cần xem xét vấn đề độ chính xác và sai số làm tròn) của máy tính, đo lường số lần phép tính dấu phẩy động mà máy tính có thể hoàn thành mỗi giây. FLOPS là chỉ số đánh giá khả năng tính toán hiệu suất cao của máy tính, thường dùng để đo lường siêu máy tính, máy chủ tính toán hiệu suất cao và bộ xử lý đồ họa (GPU). Ví dụ, một hệ thống máy tính có FLOPS là 1 TFLOPS (1 nghìn tỷ phép tính dấu phẩy động mỗi giây), có nghĩa là nó có thể hoàn thành một nghìn tỷ phép tính dấu phẩy động mỗi giây.

IPS (số lệnh mỗi giây) là tốc độ xử lý lệnh của máy tính, đo lường số lượng lệnh mà máy tính có thể thực hiện mỗi giây. IPS là chỉ số đánh giá hiệu suất đơn lệnh, thường dùng để đánh giá hiệu suất của bộ xử lý trung tâm (CPU). Ví dụ, một CPU có IPS là 3 GHz (có thể thực hiện 300 triệu lệnh mỗi giây), có nghĩa là nó có thể thực hiện 300 triệu lệnh mỗi giây.

TPS (số giao dịch mỗi giây) là khả năng xử lý giao dịch của máy tính, đo lường số lượng giao dịch mà máy tính có thể hoàn thành mỗi giây. Thường dùng để đánh giá hiệu suất của máy chủ cơ sở dữ liệu. Ví dụ, một máy chủ cơ sở dữ liệu có TPS là 1000, có nghĩa là nó có thể xử lý 1000 giao dịch cơ sở dữ liệu mỗi giây.

Ngoài ra, còn có một số chỉ số năng lực tính toán dành riêng cho các trường hợp ứng dụng cụ thể, ví dụ như tốc độ suy luận, tốc độ xử lý hình ảnh, độ chính xác nhận dạng giọng nói.

Các loại năng lực tính toán

Năng lực tính toán GPU là khả năng tính toán của bộ xử lý đồ họa (Graphics Processing Unit). Khác với CPU (Central Processing Unit), GPU được thiết kế chuyên biệt để xử lý dữ liệu đồ họa như hình ảnh và video, sở hữu lượng lớn đơn vị xử lý và khả năng tính toán song song hiệu quả, có thể đồng thời thực hiện rất nhiều phép tính dấu phẩy động. Vì GPU ban đầu được dùng để xử lý đồ họa trò chơi, chúng thường có tần số đồng hồ cao hơn và băng thông bộ nhớ lớn hơn so với CPU để hỗ trợ các phép toán đồ họa phức tạp.

Sự khác biệt giữa CPU và GPU

-

Kiến trúc: Kiến trúc tính toán của CPU và GPU khác nhau. CPU thường sử dụng một hoặc vài nhân, mỗi nhân là một bộ xử lý tổng quát, có thể thực hiện nhiều loại thao tác khác nhau. Trong khi đó, GPU sở hữu lượng lớn các bộ xử lý luồng (Stream Processors) và shader, các bộ xử lý này chuyên dùng để thực hiện các phép toán liên quan đến xử lý hình ảnh;

-

Tính toán song song: GPU thường có khả năng tính toán song song cao hơn. Số lượng nhân của CPU có hạn, mỗi nhân chỉ có thể thực hiện một lệnh, trong khi GPU có thể sở hữu hàng ngàn bộ xử lý luồng, có thể đồng thời thực hiện nhiều lệnh và thao tác. Do đó, GPU thường phù hợp hơn để thực hiện các tác vụ tính toán song song, ví dụ như học máy và học sâu – những tác vụ cần rất nhiều tính toán song song;

-

Thiết kế chương trình: Thiết kế chương trình cho GPU phức tạp hơn so với CPU, cần sử dụng ngôn ngữ lập trình đặc thù (như CUDA hoặc OpenCL) và kỹ thuật lập trình đặc biệt để tận dụng khả năng tính toán song song của GPU. Trong khi đó, thiết kế chương trình cho CPU đơn giản hơn, có thể dùng ngôn ngữ lập trình phổ thông và công cụ lập trình thông thường.

Tầm quan trọng của năng lực tính toán

Trong thời đại Cách mạng Công nghiệp, dầu mỏ là huyết mạch của thế giới, len lỏi vào mọi ngành công nghiệp. Trong kỷ nguyên AI sắp tới, năng lực tính toán sẽ là "dầu mỏ kỹ thuật số" của toàn thế giới. Từ việc các doanh nghiệp lớn tranh mua chíp AI, cổ phiếu Nvidia vượt ngưỡng một nghìn tỷ đô la, cho đến việc Mỹ gần đây áp đặt lệnh cấm đối với chíp cao cấp của Trung Quốc, chi tiết đến mức độ tính toán, diện tích chíp, thậm chí lên kế hoạch cấm dùng dịch vụ GPU đám mây, tầm quan trọng của năng lực tính toán đã rõ ràng. Năng lực tính toán sẽ trở thành mặt hàng thương mại lớn trong thời đại tới.

Tổng quan về Trí tuệ nhân tạo tổng quát

Trí tuệ nhân tạo (Artificial Intelligence) là một ngành khoa học công nghệ mới nghiên cứu, phát triển các lý thuyết, phương pháp, kỹ thuật và hệ thống ứng dụng nhằm mô phỏng, mở rộng và phát triển trí tuệ con người. Nó khởi nguồn vào những năm 1950-1960, trải qua hơn nửa thế kỷ phát triển với ba làn sóng kết hợp lẫn nhau: chủ nghĩa biểu tượng, chủ nghĩa kết nối và chủ thể hành động. Đến nay, với tư cách là một công nghệ nền tảng mới, nó đang thúc đẩy những thay đổi to lớn trong đời sống xã hội và mọi ngành nghề. Các hệ thống AI tạo sinh phổ biến hiện nay được định nghĩa cụ thể hơn là: Trí tuệ nhân tạo tổng quát (Artificial General Intelligence, viết tắt là AGI), một hệ thống AI có khả năng hiểu biết rộng rãi, có thể thể hiện trí tuệ tương đương hoặc vượt con người trên nhiều nhiệm vụ và lĩnh vực khác nhau. AGI cơ bản cần ba yếu tố: học sâu (deep learning, viết tắt là DL), dữ liệu lớn và năng lực tính toán quy mô lớn.

Học sâu

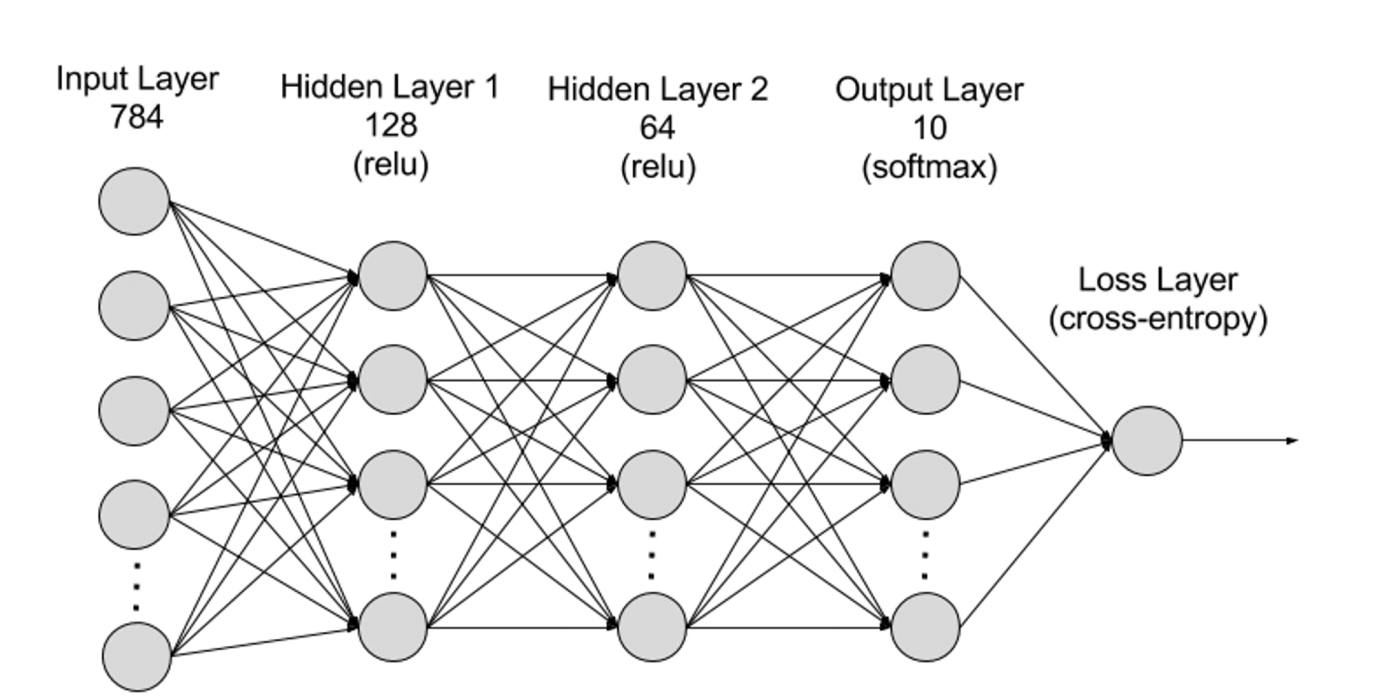

Học sâu là một lĩnh vực con của học máy (ML). Các thuật toán học sâu được mô phỏng theo mô hình mạng thần kinh của não người. Ví dụ, bộ não người chứa hàng triệu nơ-ron liên kết với nhau, phối hợp để học và xử lý thông tin. Tương tự, mạng thần kinh học sâu (hay mạng thần kinh nhân tạo) gồm nhiều lớp nơ-ron nhân tạo phối hợp bên trong máy tính. Các nơ-ron nhân tạo là các mô-đun phần mềm gọi là nút (node), sử dụng các phép tính toán học để xử lý dữ liệu. Mạng thần kinh nhân tạo là thuật toán học sâu sử dụng các nút này để giải quyết các vấn đề phức tạp.

Về mặt cấu trúc, mạng thần kinh có thể chia thành lớp đầu vào, lớp ẩn và lớp đầu ra, các lớp này được kết nối bởi các tham số.

-

Lớp đầu vào (Input Layer): Lớp đầu vào là lớp đầu tiên của mạng thần kinh, chịu trách nhiệm tiếp nhận dữ liệu đầu vào từ bên ngoài. Mỗi nơ-ron trong lớp đầu vào tương ứng với một đặc trưng của dữ liệu đầu vào. Ví dụ, khi xử lý dữ liệu hình ảnh, mỗi nơ-ron có thể tương ứng với giá trị một pixel;

-

Lớp ẩn (Hidden Layers): Lớp đầu vào xử lý dữ liệu và truyền sang các lớp sâu hơn trong mạng thần kinh. Các lớp ẩn này xử lý thông tin ở các cấp độ khác nhau, điều chỉnh hành vi khi tiếp nhận thông tin mới. Mạng học sâu có thể có hàng trăm lớp ẩn, cho phép phân tích vấn đề từ nhiều góc độ khác nhau. Ví dụ, bạn nhận được một bức ảnh động vật chưa biết và cần phân loại, bạn có thể so sánh nó với các loài động vật đã biết, như hình dạng tai, số chân, kích thước đồng tử để xác định loài. Các lớp ẩn trong mạng thần kinh sâu hoạt động tương tự. Nếu thuật toán học sâu cố gắng phân loại hình ảnh động vật, mỗi lớp ẩn sẽ xử lý các đặc trưng khác nhau của động vật để cố gắng phân loại chính xác;

-

Lớp đầu ra (Output Layer): Lớp đầu ra là lớp cuối cùng của mạng thần kinh, chịu trách nhiệm tạo ra kết quả đầu ra của mạng. Mỗi nơ-ron trong lớp đầu ra đại diện cho một hạng mục hoặc giá trị đầu ra có thể. Ví dụ, trong bài toán phân loại, mỗi nơ-ron lớp đầu ra có thể tương ứng với một hạng mục; trong bài toán hồi quy, lớp đầu ra có thể chỉ có một nơ-ron với giá trị đại diện cho kết quả dự đoán;

-

Tham số: Trong mạng thần kinh, các kết nối giữa các lớp được biểu diễn bằng các tham số trọng số (Weights) và độ lệch (Biases), các tham số này được tối ưu hóa trong quá trình huấn luyện để mạng có thể nhận diện chính xác các mẫu trong dữ liệu và đưa ra dự đoán. Việc tăng số lượng tham số có thể nâng cao dung lượng mô hình, tức là khả năng học và biểu diễn các mẫu phức tạp trong dữ liệu. Tuy nhiên, tương ứng với đó là nhu cầu về năng lực tính toán cũng tăng lên.

Dữ liệu lớn

Để huấn luyện hiệu quả, mạng thần kinh thường cần lượng lớn dữ liệu đa dạng, chất lượng cao và nhiều nguồn. Dữ liệu lớn là nền tảng để huấn luyện và xác thực mô hình học máy. Bằng cách phân tích dữ liệu lớn, mô hình học máy có thể học được các mẫu và mối quan hệ trong dữ liệu, từ đó đưa ra dự đoán hoặc phân loại.

Năng lực tính toán quy mô lớn

Cấu trúc phức tạp nhiều lớp của mạng thần kinh, số lượng tham số lớn, nhu cầu xử lý dữ liệu lớn, phương pháp huấn luyện lặp đi lặp lại (trong giai đoạn huấn luyện, mô hình cần lặp lại nhiều lần, quá trình huấn luyện cần tính toán lan truyền xuôi và lan truyền ngược cho từng lớp, bao gồm tính toán hàm kích hoạt, hàm mất mát, gradient và cập nhật trọng số), nhu cầu tính toán độ chính xác cao, khả năng tính toán song song, kỹ thuật tối ưu hóa và chuẩn hóa, cũng như quá trình đánh giá và xác thực mô hình — tất cả những yếu tố này dẫn đến nhu cầu rất lớn về năng lực tính toán. Cùng với sự phát triển của học sâu, yêu cầu về năng lực tính toán quy mô lớn cho AGI tăng khoảng 10 lần mỗi năm. Cho đến nay, mô hình mới nhất GPT-4 chứa 1,8 nghìn tỷ tham số, chi phí huấn luyện một lần vượt quá 60 triệu USD, nhu cầu tính toán là 2,15e25 FLOPS (21.500 nghìn tỷ phép tính dấu phẩy động). Nhu cầu tính toán cho việc huấn luyện các mô hình tiếp theo vẫn đang tiếp tục mở rộng, các mô hình mới cũng đang không ngừng ra đời.

Kinh tế học năng lực tính toán AI

Quy mô thị trường tương lai

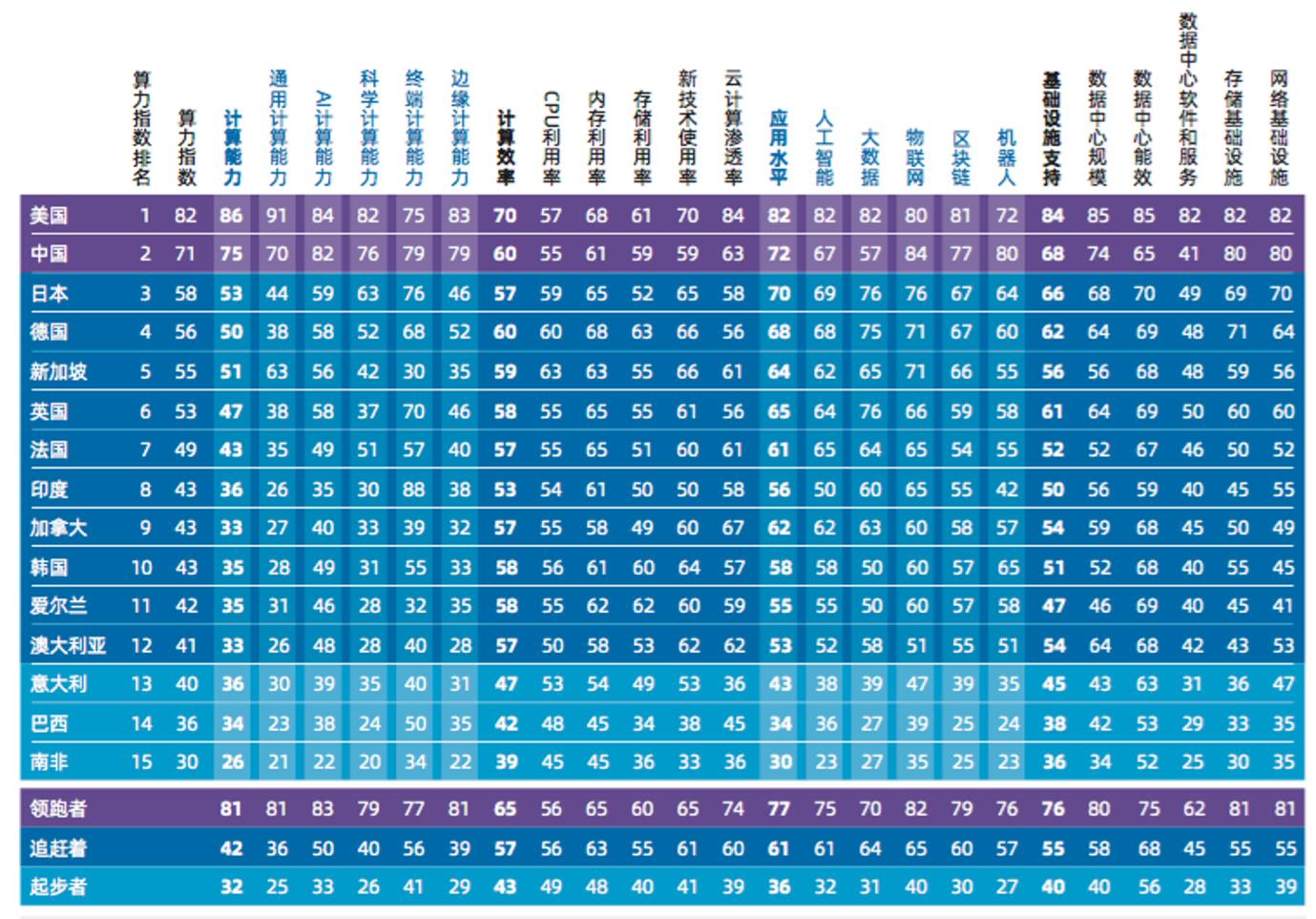

Theo ước tính uy tín nhất, báo cáo Đánh giá Chỉ số Năng lực Tính toán Toàn cầu 2022-2023 do International Data Corporation (IDC), Inspur Information và Viện Nghiên cứu Ngành Toàn cầu của Đại học Thanh Hoa phối hợp biên soạn cho thấy, quy mô thị trường điện toán AI toàn cầu sẽ tăng từ 19,5 tỷ USD năm 2022 lên 34,66 tỷ USD năm 2026, trong đó thị trường điện toán AI tạo sinh sẽ tăng từ 820 triệu USD năm 2022 lên 10,99 tỷ USD năm 2026. Tỷ lệ thị trường điện toán AI tạo sinh trong tổng thị trường điện toán AI sẽ tăng từ 4,2% lên 31,7%.

Độc quyền kinh tế tính toán

Việc sản xuất GPU cho AI đã bị NVIDIA độc quyền hoàn toàn, và còn cực kỳ đắt đỏ (mẫu H100 mới nhất, giá mỗi chiếc đã bị thổi lên tới 40.000 USD), hơn nữa GPU一经发售就被 các tập đoàn lớn tại Thung lũng Silicon mua sạch, một phần thiết bị này dùng để huấn luyện các mô hình mới của chính họ. Phần còn lại thì cho thuê thông qua nền tảng đám mây cho các nhà phát triển AI, ví dụ như các nền tảng điện toán đám mây của Google, Amazon và Microsoft nắm giữ lượng lớn tài nguyên máy chủ, GPU, TPU... Năng lực tính toán đã trở thành tài nguyên mới bị các tập đoàn lớn độc quyền, rất nhiều nhà phát triển liên quan đến AI thậm chí không thể mua được một chiếc GPU chuyên dụng nào mà không phải trả thêm tiền. Để sử dụng thiết bị mới nhất, các nhà phát triển buộc phải thuê máy chủ từ AWS hoặc Microsoft. Nhìn từ báo cáo tài chính, mảng kinh doanh này có lợi nhuận cực cao, dịch vụ đám mây AWS có biên lợi nhuận lên tới 61%, còn Microsoft còn cao hơn với 72%.

Vậy chúng ta có phải chấp nhận kiểu quyền lực và kiểm soát tập trung này, đồng thời trả 72% lợi nhuận cho tài nguyên tính toán? Liệu các gã khổng lồ độc quyền Web2 có tiếp tục độc quyền luôn cả thời đại tiếp theo?

Những thách thức của năng lực tính toán AGI phi tập trung

Khi nói đến chống độc quyền, phi tập trung thường là giải pháp tối ưu. Nhưng từ các dự án hiện có, liệu chúng ta có thể sử dụng các dự án lưu trữ DePIN kết hợp với các giao thức tận dụng GPU nhàn rỗi như RDNR để tạo ra năng lực tính toán quy mô lớn cần thiết cho AI? Câu trả lời là không. Con đường giết rồng không hề đơn giản. Các dự án sớm chưa được thiết kế chuyên biệt cho năng lực tính toán AGI, vì vậy không khả thi. Việc đưa năng lực tính toán lên chuỗi ít nhất phải đối mặt với năm thách thức sau:

1. Xác minh công việc: Để xây dựng một mạng tính toán thực sự không cần tin tưởng và cung cấp động lực kinh tế cho người tham gia, mạng phải có cách xác minh xem công việc tính toán học sâu đã thực sự được thực hiện hay chưa. Vấn đề cốt lõi nằm ở tính phụ thuộc trạng thái của mô hình học sâu; trong mô hình học sâu, đầu vào của mỗi lớp đều phụ thuộc vào đầu ra của lớp trước đó. Điều này có nghĩa là, không thể chỉ xác minh một lớp nào đó trong mô hình mà không xem xét tất cả các lớp phía trước. Mỗi lớp tính toán đều dựa trên kết quả của tất cả các lớp phía trước. Do đó, để xác minh công việc đã hoàn thành tại một điểm cụ thể (ví dụ như một lớp cụ thể), phải thực hiện toàn bộ công việc từ đầu mô hình đến điểm cụ thể đó;

2. Thị trường: Thị trường năng lực tính toán AI là một thị trường mới nổi, bị giới hạn bởi khó khăn cung-cầu, ví dụ như vấn đề khởi động lạnh, thanh khoản cung và cầu cần phải khớp nhau ngay từ đầu để thị trường có thể tăng trưởng thành công. Để thu hút nguồn cung tiềm năng, phải cung cấp phần thưởng rõ ràng cho người tham gia đổi lấy tài nguyên tính toán của họ. Thị trường cần một cơ chế để theo dõi công việc tính toán đã hoàn thành và thanh toán kịp thời cho người cung cấp. Trên thị trường truyền thống, trung gian chịu trách nhiệm xử lý các nhiệm vụ quản lý và tuyển dụng, đồng thời giảm chi phí vận hành bằng cách đặt mức thanh toán tối thiểu. Tuy nhiên, cách làm này chi phí cao khi mở rộng quy mô thị trường. Chỉ một phần nhỏ nguồn cung có thể được khai thác hiệu quả về mặt kinh tế, dẫn đến trạng thái cân bằng ngưỡng, tức là thị trường chỉ có thể thu hút và duy trì một lượng cung giới hạn, không thể phát triển thêm;

3. Vấn đề dừng máy (Halting Problem): Vấn đề dừng máy là một vấn đề cơ bản trong lý thuyết tính toán, liên quan đến việc xác định liệu một tác vụ tính toán nhất định có dừng trong thời gian hữu hạn hay sẽ chạy mãi mãi. Vấn đề này là không thể giải được, có nghĩa là không tồn tại một thuật toán tổng quát nào có thể dự đoán trước liệu tất cả các tác vụ tính toán có dừng trong thời gian hữu hạn hay không. Ví dụ như trên Ethereum, việc thực thi hợp đồng thông minh cũng đối mặt với vấn đề dừng máy tương tự, tức là không thể xác định trước một hợp đồng thông minh cần bao nhiêu tài nguyên tính toán để thực thi, hoặc liệu nó có hoàn thành trong thời gian hợp lý hay không;

(Trong bối cảnh học sâu, vấn đề này còn phức tạp hơn, vì mô hình và framework sẽ chuyển từ xây dựng đồ thị tĩnh sang xây dựng và thực thi động.)

4. Bảo mật: Thiết kế và phát triển chú trọng bảo mật là điều bắt buộc đối với các bên phát triển dự án. Mặc dù có thể thực hiện nhiều nghiên cứu học máy trên các bộ dữ liệu công khai, nhưng để cải thiện hiệu suất mô hình và thích nghi với các ứng dụng cụ thể, thường cần tinh chỉnh mô hình trên dữ liệu người dùng riêng. Quá trình tinh chỉnh này có thể liên quan đến việc xử lý dữ liệu cá nhân, do đó cần xem xét các yêu cầu bảo vệ quyền riêng tư;

5. Song song hóa: Đây là yếu tố then chốt khiến các dự án hiện tại không khả thi. Mô hình học sâu thường được huấn luyện song song trên các cụm phần cứng lớn có kiến trúc chuyên biệt và độ trễ cực thấp, trong khi các GPU trên mạng tính toán phân tán cần trao đổi dữ liệu thường xuyên sẽ gây ra độ trễ và bị giới hạn bởi GPU kém hiệu năng nhất. Trong điều kiện nguồn tính toán không đáng tin cậy và không ổn định, làm thế nào để song song hóa dị cấu là vấn đề phải giải quyết. Phương pháp khả thi hiện nay là thông qua mô hình Transformer để đạt được song song hóa, ví dụ như Switch Transformers, hiện đã có đặc tính song song hóa cao độ.

Giải pháp: Mặc dù các nỗ lực hiện tại đối với thị trường năng lực tính toán AGI phi tập trung vẫn còn ở giai đoạn sơ khai, nhưng恰好 có hai dự án ban đầu đã giải quyết được thiết kế đồng thuận cho mạng phi tập trung và quá trình triển khai mạng năng lực tính toán phi tập trung trong huấn luyện và suy luận mô hình. Phần tiếp theo sẽ phân tích cách thiết kế và các vấn đề tồn tại của thị trường năng lực tính toán AGI phi tập trung thông qua hai ví dụ Gensyn và Together.

Gensyn

Gensyn là một thị trường năng lực tính toán AGI vẫn đang trong giai đoạn xây dựng, nhằm giải quyết nhiều thách thức của tính toán học sâu phi tập trung, đồng thời giảm chi phí học sâu hiện tại. Về bản chất, Gensyn là một giao thức proof-of-stake lớp một trên mạng Polkadot, thông qua hợp đồng thông minh trực tiếp thưởng cho các Solvers (người giải) để đổi lấy thiết bị GPU nhàn rỗi của họ dùng vào tính toán và thực hiện các nhiệm vụ học máy.

Vậy quay lại vấn đề nêu ở trên, mấu chốt để xây dựng một mạng tính toán thực sự không cần tin tưởng là xác minh công việc học máy đã hoàn thành. Đây là một vấn đề cực kỳ phức tạp, cần tìm ra điểm cân bằng giữa lý thuyết phức tạp, lý thuyết trò chơi, mật mã học và tối ưu hóa.

Gensyn đề xuất một giải pháp đơn giản: Người giải nộp kết quả nhiệm vụ học máy đã hoàn thành. Để xác minh tính chính xác của các kết quả này, một Validator (người xác minh) độc lập khác sẽ thử thực hiện lại công việc tương tự. Phương pháp này được gọi là bản sao đơn (single replication), vì chỉ có một người xác minh thực hiện lại. Điều này có nghĩa là chỉ cần một lượng công việc bổ sung để xác minh tính chính xác của công việc ban đầu. Tuy nhiên, nếu người xác minh không phải là người yêu cầu công việc ban đầu, thì vẫn tồn tại vấn đề tin tưởng. Bởi vì bản thân người xác minh cũng có thể không trung thực, và công việc của họ cũng cần được xác minh. Điều này dẫn đến một vấn đề tiềm tàng: nếu người xác minh không phải là người yêu cầu công việc ban đầu, thì cần một người xác minh khác để xác minh công việc của họ. Nhưng người xác minh mới này cũng có thể không đáng tin cậy, do đó cần thêm một người xác minh khác, và cứ thế tiếp diễn vô hạn, tạo thành một chuỗi bản sao vô tận. Ở đây cần giới thiệu ba khái niệm then chốt và kết hợp chúng để xây dựng hệ thống bốn vai trò người tham gia nhằm giải quyết vấn đề chuỗi vô hạn.

Chứng minh học dựa trên xác suất (Probabilistic Proof of Learning): Sử dụng siêu dữ liệu từ quá trình tối ưu hóa dựa trên gradient để xây dựng chứng chỉ hoàn thành công việc. Thông qua việc sao chép một số giai đoạn nhất định, có thể nhanh chóng xác minh các chứng chỉ này, từ đó đảm bảo công việc đã được hoàn thành đúng như mong đợi.

Giao thức định vị chính xác dựa trên đồ thị (Graph-based Precise Pinpointing Protocol): Sử dụng giao thức định vị chính xác dựa trên đồ thị đa mức độ chi tiết và thực thi nhất quán của các bộ đánh giá chéo. Điều này cho phép chạy lại và so sánh công việc xác minh để đảm bảo tính nhất quán, và cuối cùng được xác nhận bởi chính chuỗi khối.

Trò chơi khuyến khích kiểu Truebit: Sử dụng cơ chế ký quỹ và phạt cắt (slashing) để xây dựng trò chơi khuyến khích, đảm bảo mọi người tham gia hợp lý về mặt kinh tế đều hành xử trung thực và thực hiện đúng nhiệm vụ được giao.

Hệ thống người tham gia gồm Người nộp đơn (Submitters), Người giải (Solvers), Người xác minh (Verifiers) và Người tố giác (Whistleblowers).

Người nộp đơn (Submitters):

Người nộp đơn là người dùng cuối của hệ thống, cung cấp nhiệm vụ sẽ được tính toán và thanh toán phí cho từng đơn vị công việc đã hoàn thành;

Người giải (Solvers):

Người giải là người thực hiện công việc chính trong hệ thống, thực hiện huấn luyện mô hình và tạo ra các chứng minh để người xác minh kiểm tra;

Người xác minh (Verifiers):

Người xác minh là chìa khóa nối quá trình huấn luyện phi xác định với tính toán tuyến tính xác định, sao chép một phần chứng minh của người giải và so sánh khoảng cách với ngưỡng dự kiến;

Người tố giác (Whistleblowers):

Người tố giác là hàng phòng ngự cuối cùng, kiểm tra công việc của người xác minh và đưa ra khiếu nại, hy vọng nhận được khoản thưởng hậu hĩnh.

Cơ chế hoạt động của hệ thống

Hệ thống trò chơi do giao thức thiết kế bao gồm tám giai đoạn, bao hàm bốn vai trò người tham gia chính, để hoàn thành toàn bộ quy trình từ nộp nhiệm vụ đến xác minh cuối cùng.

-

Nộp nhiệm vụ (Task Submission): Nhiệm vụ gồm ba thông tin cụ thể:

-

Dữ liệu siêu mô tả nhiệm vụ và siêu tham số;

-

Một tệp nhị phân mô hình (hoặc kiến trúc cơ bản);

-

Dữ liệu huấn luyện đã xử lý trước, có thể truy cập công khai.

-

-

Để nộp nhiệm vụ, người nộp đơn chỉ định chi tiết nhiệm vụ ở định dạng máy đọc được, và gửi kèm tệp nhị phân mô hình (hoặc kiến trúc máy đọc được) cùng vị trí có thể truy cập công khai của dữ liệu huấn luyện đã xử lý trước lên chuỗi. Dữ liệu công khai có thể được lưu trữ trên các hệ thống lưu trữ đối tượng đơn giản như S3 của AWS, hoặc trên các hệ thống lưu trữ phi tập trung như IPFS, Arweave hoặc Subspace.

-

Phân tích (Profiling): Quá trình phân tích xác định ngưỡng khoảng cách cơ sở cho chứng minh học để xác minh. Người xác minh sẽ định kỳ truy xuất các nhiệm vụ phân tích và tạo ra ngưỡng biến thiên để so sánh chứng minh học. Để tạo ngưỡng, người xác minh sẽ chạy và chạy lại một phần huấn luyện một cách xác định, sử dụng các hạt ngẫu nhiên khác nhau, tạo và kiểm tra chứng minh của riêng họ. Trong quá trình này, người xác minh sẽ thiết lập một ngưỡng khoảng cách tổng thể dự kiến cho công việc phi xác định có thể dùng để xác minh giải pháp.

-

Huấn luyện (Training): Sau khi phân tích, nhiệm vụ được đưa vào nhóm nhiệm vụ công cộng (tương tự như Mempool của Ethereum). Một Solver được chọn để thực hiện nhiệm vụ và nhiệm vụ bị xóa khỏi nhóm. Solver thực hiện nhiệm vụ dựa trên dữ liệu siêu mô tả, mô hình và dữ liệu huấn luyện do người nộp cung cấp. Khi thực hiện nhiệm vụ huấn luyện, Solver còn tạo ra chứng minh học bằng cách lưu định kỳ các điểm kiểm tra và lưu siêu dữ liệu (bao gồm tham số) trong quá trình huấn luyện, để người xác minh có thể tái tạo chính xác nhất các bước tối ưu hóa tiếp theo.

-

Tạo chứng minh (Proof generation): Solver định kỳ lưu trọng số mô hình hoặc cập nhật cùng chỉ số tương ứng với tập dữ liệu huấn luyện để xác định mẫu dùng để tạo cập nhật trọng số. Tần suất điểm kiểm tra có thể điều chỉnh để cung cấp đảm bảo mạnh hơn hoặc tiết kiệm dung lượng lưu trữ. Chứng minh có thể được "xếp chồng" (stacked), nghĩa là chứng minh có thể bắt đầu từ phân bố ngẫu nhiên dùng để khởi tạo trọng số, hoặc bắt đầu từ trọng số đã được tinh chỉnh trước có chứng minh riêng. Điều này cho phép giao thức xây dựng một bộ mô hình nền tảng đã được chứng minh và đã được huấn luyện trước, có thể được tinh chỉnh cho các nhiệm vụ cụ thể hơn.

-

Xác minh chứng minh (Verification of proof): Sau khi hoàn thành nhiệm vụ, Solver đăng ký hoàn thành nhiệm vụ lên chuỗi và hiển thị chứng minh học tại vị trí có thể truy cập công khai để người xác minh truy cập. Người xác minh trích xuất nhiệm vụ xác minh từ nhóm nhiệm vụ công cộng và thực hiện công việc tính toán để chạy lại một phần chứng minh và thực hiện tính toán khoảng cách. Sau đó, chuỗi (cùng với ngưỡng đã tính ở giai đoạn phân tích) sử dụng khoảng cách thu được để xác định liệu xác minh có khớp với chứng minh hay không.

-

Thử thách định vị chính xác dựa trên đồ thị (Graph-based pinpoint challenge): Sau khi xác minh chứng minh học, người tố giác có thể sao chép công việc của người xác minh để kiểm tra xem công việc xác minh có được thực hiện đúng hay không. Nếu người tố giác cho rằng việc xác minh đã bị thực hiện sai (dù cố ý hay vô ý), họ có thể khiếu nại với hợp đồng trọng tài để nhận thưởng. Phần thưởng này có thể đến từ khoản ký quỹ của người giải và người xác minh (trong trường hợp tích cực thực sự), hoặc từ quỹ thưởng xổ số (trong trường hợp dương tính giả), và hợp đồng sẽ thực hiện trọng tài.Người tố giác (trong ví dụ của họ là người xác minh) chỉ tham gia xác minh và khiếu nại khi kỳ vọng nhận được phần thưởng phù hợp. Trên thực tế, điều này có nghĩa là người tố giác dự kiến sẽ tham gia và rời khỏi mạng dựa trên số lượng người tố giác khác đang hoạt động (tức là có ký quỹ thực tế và khiếu nại). Do đó, chiến lược mặc định của bất kỳ người tố giác nào là tham gia mạng khi số lượng người tố giác khác ít, gửi ký quỹ, chọn ngẫu nhiên một nhiệm vụ đang hoạt động và bắt đầu quá trình xác minh. Sau khi hoàn thành nhiệm vụ đầu tiên, họ sẽ truy xuất một nhiệm vụ hoạt động ngẫu nhiên khác và lặp lại, cho đến khi số lượng người tố giác vượt quá ngưỡng thanh toán đã xác định, sau đó họ sẽ rời mạng (hoặc có khả năng cao hơn là chuyển sang đảm nhận vai trò khác trong mạng—người xác minh hoặc người giải—tùy theo khả năng phần cứng của họ), cho đến khi tình hình đảo ngược lại.

-

Trọng tài hợp đồng (Contract arbitration): Khi người xác minh bị người tố giác khiếu nại, họ sẽ cùng chuỗi thực hiện một quy trình để tìm ra vị trí thao tác hoặc đầu vào gây tranh cãi, cuối cùng chuỗi thực hiện thao tác cơ bản cuối cùng và xác định khiếu nại có hợp lý hay không. Để giữ cho người tố giác trung thực và vượt qua nghịch cảnh của người xác minh, ở đây giới thiệu lỗi bắt buộc định kỳ và phần thưởng giải đặc biệt.

-

Thanh toán (Settlement): Trong quá trình thanh toán, người tham gia được thanh toán dựa trên kết luận từ kiểm tra xác suất và xác định. Dựa trên kết quả xác minh và khiếu nại trước đó, các kịch bản khác nhau sẽ có cách thanh toán khác nhau. Nếu công việc được xác nhận là đã thực hiện đúng và mọi kiểm tra đều vượt qua, người cung cấp giải pháp và người xác minh sẽ được thưởng theo thao tác đã thực hiện.

Đánh giá ngắn gọn về dự án

Gensyn đã thiết kế một hệ thống trò chơi tuyệt vời ở tầng xác minh và tầng khuyến khích, có thể nhanh chóng xác định điểm sai sót bằng cách tìm ra sự khác biệt trong mạng. Tuy nhiên, hệ thống hiện tại vẫn thiếu nhiều chi tiết. Ví dụ như làm thế nào để thiết lập tham số đảm bảo phần thưởng và chế tài hợp lý mà không đặt ngưỡng quá cao? Các bước trong trò chơi đã xem xét các tình huống cực đoan và vấn đề về sự khác biệt năng lực tính toán của Solver chưa? Bản whitepaper hiện tại cũng chưa có giải thích chi tiết về việc chạy song song dị cấu. Nhìn chung, con đường hiện thực hóa Gensyn vẫn còn dài và gian nan.

Together.ai

Together là một công ty tập trung vào mô hình lớn mã nguồn mở, cam kết với giải pháp năng lực tính toán AI phi tập trung, mong muốn bất kỳ ai ở bất kỳ đâu đều có thể tiếp cận và sử dụng AI. Chính xác hơn, Together không phải là một dự án blockchain, nhưng dự án hiện đã sơ bộ giải quyết được vấn đề độ trễ trong mạng tính toán AGI phi tập trung. Do đó, phần tiếp theo chỉ phân tích giải pháp của Together mà không đánh giá dự án.

Trong điều kiện mạng phi tập trung chậm hơn trung tâm dữ liệu 100 lần, làm thế nào để thực hiện huấn luyện và suy luận mô hình lớn?

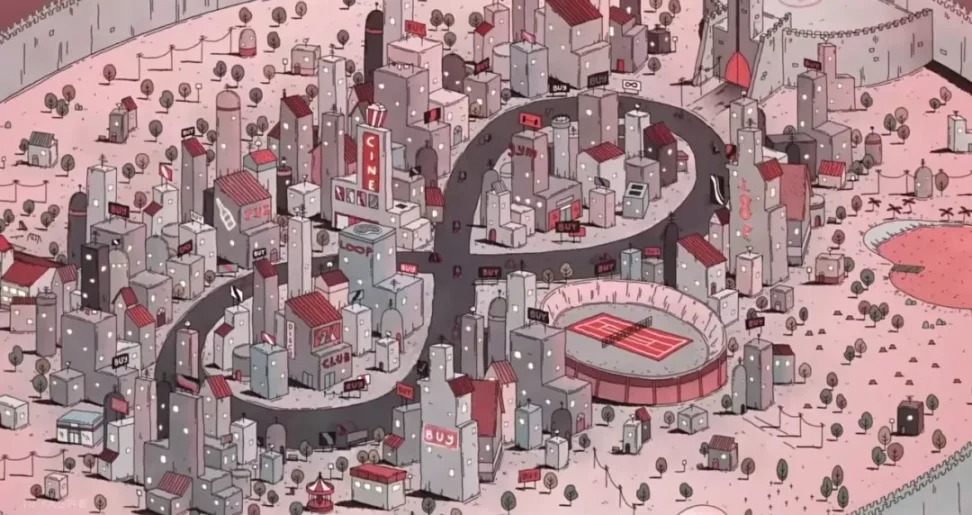

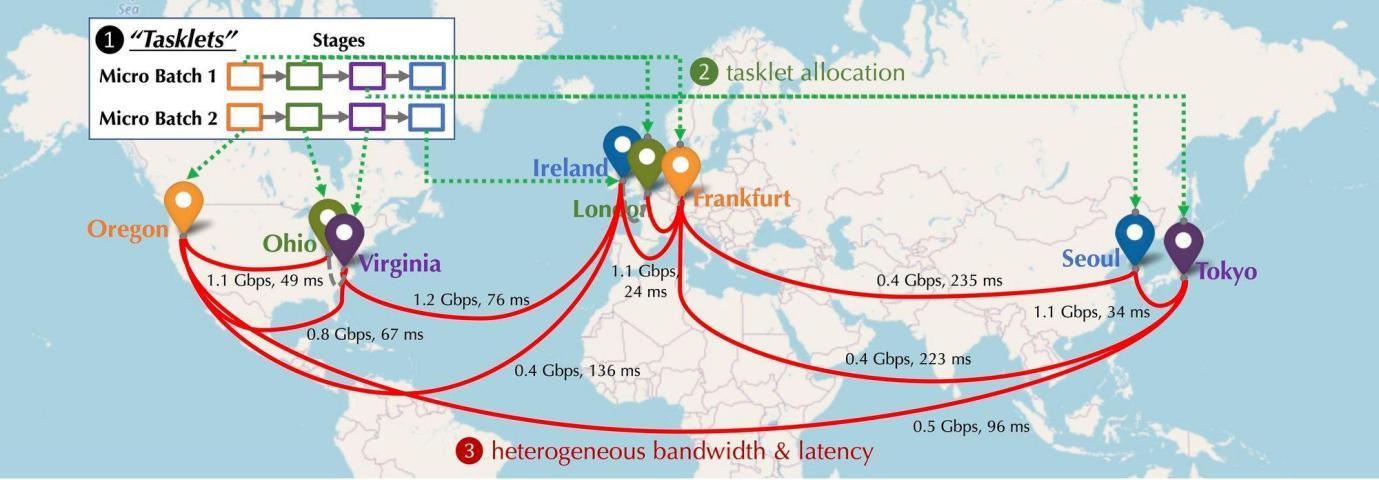

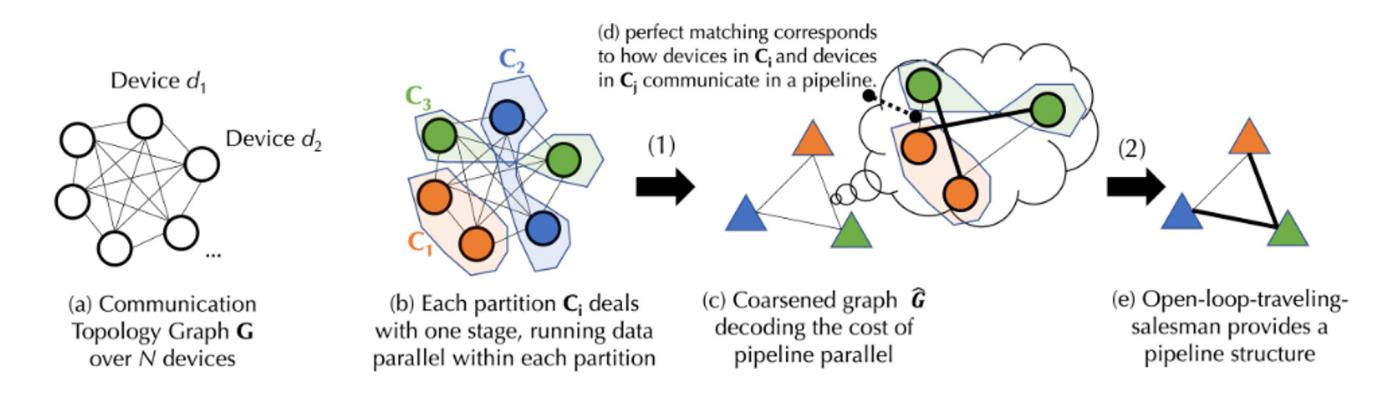

Hãy hình dung trong tình huống phi tập trung, thiết bị GPU tham gia mạng sẽ phân bố như thế nào? Những thiết bị này sẽ phân bố ở các châu lục, thành phố khác nhau, cần kết nối với nhau, trong khi độ trễ và băng thông kết nối lại khác nhau. Như hình dưới đây, mô phỏng một tình huống phân tán, thiết bị phân bố ở Bắc Mỹ, châu Âu và châu Á, độ trễ và băng thông giữa các thiết bị khác nhau. Vậy phải làm gì để nối chúng lại?

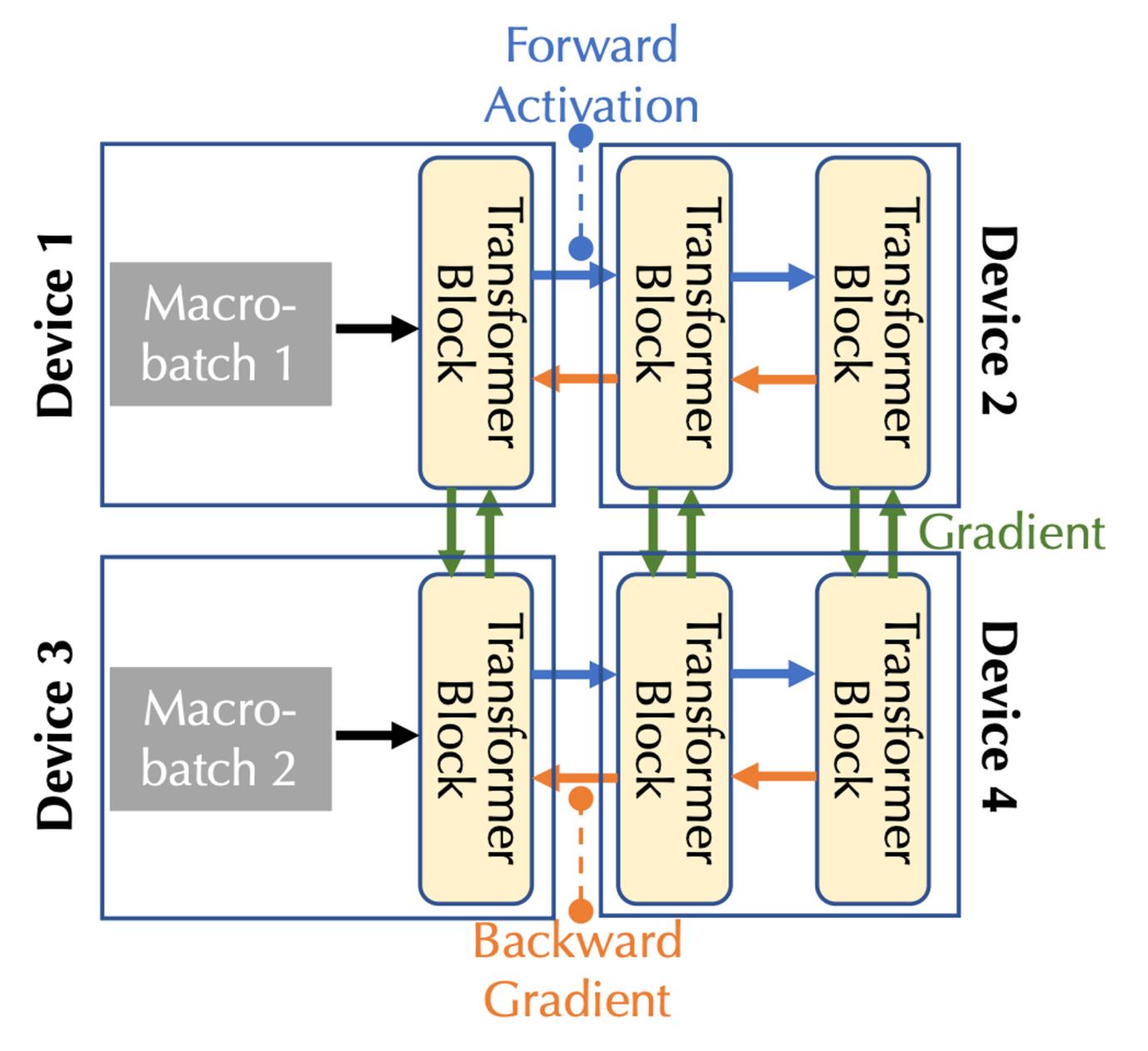

Mô hình hóa tính toán huấn luyện phân tán: Hình dưới đây mô tả việc huấn luyện mô hình cơ bản trên nhiều thiết bị, xét về loại hình truyền thông gồm ba loại: truyền kích hoạt xuôi (Forward Activation), gradient ngược (Backward Gradient) và truyền thông ngang hàng.

Kết hợp băng thông và độ trễ truyền thông, cần xem xét hai hình thức song song: song song ống dẫn (pipeline parallelism) và song song dữ liệu (data parallelism), tương ứng với ba loại truyền thông trong trường hợp nhiều thiết bị:

-

Trong song song ống dẫn, tất cả các lớp của mô hình được chia thành nhiều giai đoạn, mỗi thiết bị xử lý một giai đoạn, là một chuỗi các lớp liên tiếp, ví dụ như nhiều khối Transformer; trong quá trình truyền xuôi, các kích hoạt được truyền sang giai đoạn tiếp theo, trong khi truyền ngược, gradient của kích hoạt được truyền về giai đoạn trước.

-

Trong song song dữ liệu, các thiết bị độc lập tính toán gradient của các micro-batch khác nhau, nhưng cần truyền thông để đồng bộ gradient.

Tối ưu hóa lập lịch (Scheduling Optimization)

Trong môi trường phi tập trung, quá trình huấn luyện thường bị giới hạn bởi truyền thông. Thuật toán lập lịch thường giao nhiệm vụ cần nhiều truyền thông cho các thiết bị có tốc độ kết nối nhanh hơn. Xét đến sự phụ thuộc giữa các nhiệm vụ và tính dị cấu của mạng, trước tiên cần mô hình hóa chi phí cho chiến lược lập lịch cụ thể. Để nắm bắt chi phí truyền thông phức tạp khi huấn luyện mô hình cơ bản, Together đề xuất một công thức mới và sử dụng lý thuyết đồ thị để phân tách mô hình chi phí thành hai cấp độ:

-

Lý thuyết đồ thị là một nhánh của toán học, nghiên cứu chủ yếu về tính chất và cấu trúc của đồ thị (mạng). Đồ thị gồm các đỉnh (nút) và các cạnh (đường nối các nút). Mục đích chính của lý thuyết đồ thị là nghiên cứu các tính chất khác nhau của đồ thị, như tính liên thông, tô màu đồ thị, tính chất đường đi và chu trình trong đồ thị.

-

Cấp độ đầu tiên là bài toán phân hoạch đồ thị cân bằng (chia tập đỉnh của đồ thị thành một vài tập con có kích thước bằng nhau hoặc gần bằng nhau, đồng thời làm cho số cạnh giữa các tập con là nhỏ nhất. Trong phân hoạch này, mỗi tập con đại diện cho một phân vùng, và bằng cách giảm thiểu số cạnh giữa các phân vùng để giảm chi phí truyền thông), tương ứng với chi phí truyền thông của song song dữ liệu.

Cấp độ thứ hai là bài toán ghép cặp đồ thị kết hợp và người bán hàng du lịch (một bài toán tối ưu tổ hợp kết hợp các yếu tố của ghép cặp đồ thị và bài toán người bán hàng du lịch. Bài toán ghép cặp đồ thị là tìm một tập ghép cặp trong đồ thị sao cho tối thiểu hóa hoặc tối đa hóa một chi phí nào đó. Bài toán người bán hàng du lịch là tìm đường đi ngắn nhất thăm tất cả các đỉnh trong đồ thị), tương ứng với chi phí truyền thông của song song ống dẫn.

Hình trên là sơ đồ quy trình, do quá trình triển khai thực tế liên quan đến một số công thức tính toán phức tạp. Để dễ hiểu, phần tiếp theo sẽ mô tả quy trình trong hình một cách通俗 hơn, quá trình triển khai chi tiết có thể tự tra cứu tài liệu trên website Together.

Giả sử có một tập thiết bị D gồm N thiết bị, độ trễ (ma trận A) và băng thông (ma trận B) truyền thông giữa chúng là không chắc chắn. Dựa trên tập thiết bị D, trước tiên chúng ta tạo ra một phân hoạch đồ thị cân bằng. Số lượng thiết bị trong mỗi phân hoạch hoặc nhóm thiết bị gần bằng nhau, và tất cả đều xử lý cùng một giai đoạn ống dẫn. Điều này đảm bảo trong song song dữ liệu, các nhóm thiết bị thực hiện lượng công việc tương tự nhau. (Song song dữ liệu nghĩa là nhiều thiết bị thực hiện cùng một nhiệm vụ, trong khi giai đoạn ống dẫn nghĩa là thiết bị thực hiện các bước nhiệm vụ khác nhau theo thứ tự cụ thể). Dựa trên độ trễ và băng thông truyền thông, thông qua công thức có thể tính được "chi phí" truyền dữ liệu giữa các nhóm thiết bị. Mỗi nhóm thiết bị cân bằng được gộp lại, tạo thành một đồ thị liên kết đầy đủ thô, trong đó mỗi nút đại diện cho một giai đoạn ống dẫn, cạnh đại diện cho chi phí truyền thông giữa hai giai đoạn. Để tối thiểu hóa chi phí truyền thông, sử dụng thuật toán ghép cặp để xác định nhóm thiết bị nào nên làm việc cùng nhau.

Để tối ưu hơn nữa, bài toán này còn có thể được mô hình hóa thành bài toán người bán hàng du lịch vòng mở (vòng mở nghĩa là không cần quay về điểm xuất phát), từ đó tìm ra đường đi tối ưu để truyền dữ liệu giữa tất cả các thiết bị. Cuối cùng, Together sử dụng một thuật toán lập lịch sáng tạo của họ để tìm ra chiến lược phân bổ tối ưu cho mô hình chi phí đã cho, từ đó tối thiểu hóa chi phí truyền thông, tối đa hóa thông lượng huấn luyện. Theo thử nghiệm thực tế, dưới sự tối ưu hóa lập lịch này, ngay cả khi mạng chậm hơn 100 lần, thông lượng huấn luyện end-to-end chỉ chậm hơn khoảng 1,7 đến 2,3 lần.

Tối ưu hóa nén truyền thông

Đối với tối ưu hóa nén truyền thông, Together giới thiệu thuật toán AQ-SGD (quy trình tính toán chi tiết, có thể tham khảo bài báo Fine-tuning Language Models over Slow Networks using Activation Compression with Guarantees). AQ-SGD là một kỹ thuật nén hoạt động mới được thiết kế để giải quyết vấn đề hiệu quả truyền thông khi huấn luyện song song ống dẫn trên mạng tốc độ thấp. Khác với các phương pháp nén trực tiếp giá trị hoạt động trước đây, AQ-SGD tập trung vào nén sự thay đổi của giá trị hoạt động trên cùng một mẫu huấn luyện ở các thời điểm khác nhau. Phương pháp độc đáo này tạo ra một động lực "tự thực thi" thú vị, khi huấn luyện ổn định, hiệu suất của thuật toán dự kiến sẽ dần cải thiện. AQ-SGD đã được phân tích lý thuyết nghiêm ngặt, chứng minh có tốc độ hội tụ tốt dưới các điều kiện kỹ thuật nhất định và hàm lượng hóa có lỗi bị chặn. Thuật toán này không chỉ khả thi về mặt thực hiện mà còn không làm tăng chi phí thời gian chạy end-to-end, mặc dù cần sử dụng thêm bộ nhớ và SSD để lưu trữ giá trị hoạt động. Qua thử nghiệm rộng rãi trên các bộ dữ liệu phân loại chuỗi và mô hình ngôn ngữ, AQ-SGD có thể nén giá trị hoạt động xuống 2-4 bit mà không ảnh hưởng đến hiệu suất hội tụ. Ngoài ra, AQ-SGD còn có thể tích hợp với các thuật toán nén gradient tiên tiến nhất để đạt được "nén truyền thông end-to-end", nghĩa là tất cả dữ liệu trao đổi giữa các máy, bao gồm gradient mô hình, giá trị hoạt động xuôi và gradient ngược, đều được nén thành độ chính xác thấp, từ đó nâng cao đáng kể hiệu quả truyền thông trong huấn luyện phân tán. So với hiệu suất huấn luyện end-to-end trên mạng tính toán tập trung (ví dụ 10 Gbps) trong điều kiện không nén, hiện tại chỉ chậm hơn 31%. Kết hợp dữ liệu từ tối ưu hóa lập lịch, mặc dù vẫn còn khoảng cách nhất định so với mạng tính toán tập trung, nhưng hy vọng đuổi kịp trong tương lai là khá lớn.

Kết luận

Trong thời kỳ bùng nổ lợi ích mang lại bởi làn sóng AI, thị trường năng lực tính toán AGI rõ ràng là thị trường tiềm năng lớn nhất và có nhu cầu cao nhất trong số các thị trường tính toán. Tuy nhiên, độ khó phát triển, yêu cầu phần cứng và nhu cầu vốn cũng là cao nhất. Kết hợp phân tích hai dự án trên, chúng ta vẫn còn một khoảng thời gian nữa mới có thể hiện thực hóa thị trường năng lực tính toán AGI, mạng lưới phi tập trung thực sự cũng phức tạp hơn nhiều so với tưởng tượng, hiện tại rõ ràng vẫn chưa đủ sức cạnh tranh với các gã khổng lồ đám mây.

Khi viết bài này, tôi cũng nhận thấy một số dự án nhỏ, mới ở giai đoạn thai nghén (giai đoạn PPT) hiện đang tìm kiếm các điểm đột phá mới, ví dụ như tập trung vào giai đoạn suy luận dễ hơn hoặc huấn luyện mô hình nhỏ. Đây đều là những thử nghiệm tốt. Nhìn về lâu dài, ý nghĩa của việc phi tập trung và không cần cho phép là rất quan trọng, quyền truy cập và huấn luyện năng lực tính toán AGI không nên tập trung vào một vài gã khổng lồ tập trung. Loài người không cần một "giáo hội" mới, cũng không cần một "giáo hoàng" mới, càng không nên phải đóng hội phí đắt đỏ.

Chào mừng tham gia cộng đồng chính thức TechFlow

Nhóm Telegram:https://t.me/TechFlowDaily

Tài khoản Twitter chính thức:https://x.com/TechFlowPost

Tài khoản Twitter tiếng Anh:https://x.com/BlockFlow_News