IOSG|컴퓨팅 능력에서 지능까지: 강화 학습이 주도하는 탈중앙화 AI 투자 지도

저자: Jacob Zhao @IOSG

인공지능은 "패턴 적합" 중심의 통계적 학습에서 "구조적 추론"을 핵심으로 하는 능력 체계로 진화하고 있으며, 후속 훈련(Post-training)의 중요성이 급격히 부각되고 있다. DeepSeek-R1의 등장은 강화학습이 대규모 모델 시대에 이르러 패러다임 전환을 이뤘음을 상징하며 업계의 공감대가 형성되고 있다. 즉, 사전 훈련(Pre-training)은 모델의 일반적 능력을 위한 기반을 구축하는 반면, 강화학습은 더 이상 가치 조정 도구에 국한되지 않고 추론 체인의 질과 복잡한 의사결정 능력을 체계적으로 향상시킬 수 있음이 입증되었으며, 지능 수준을 지속적으로 높이는 기술 경로로 점차 발전하고 있다.

동시에 Web3는 탈중앙화된 컴퓨팅 네트워크와 암호화 인센티브 체계를 통해 AI의 생산 관계를 재편하고 있으며, rollout 샘플링, 보상 신호, 검증 가능한 훈련에 대한 강화학습의 구조적 요구사항은 블록체인의 컴퓨팅 협업, 인센티브 분배, 검증 가능한 실행과 자연스럽게 맞물린다. 본 리서치 리포트는 AI 훈련 패러다임과 강화학습 기술 원리를 체계적으로 분석하고, 강화학습 × Web3의 구조적 장점을 입증하며 Prime Intellect, Gensyn, Nous Research, Gradient, Grail, Fraction AI 등의 프로젝트를 심층적으로 검토한다.

AI 훈련의 세 단계: 사전 훈련, 명령어 미세조정 및 후속 훈련 정렬

현대 대규모 언어 모델(LLM)의 전체 훈련 생애주기는 일반적으로 세 가지 핵심 단계로 나뉜다: 사전 훈련(Pre-training), 감독형 미세조정(SFT), 후속 훈련(Post-training/RL). 이들 각각은 "세계 모델 구축 - 과제 수행 능력 주입 - 추론 및 가치관 형성"이라는 기능을 수행하며, 그들의 계산 구조, 데이터 요구사항, 검증 난이도는 탈중앙화와의 매칭 정도를 결정한다.

-

사전 훈련(Pre-training)은 대규모 자기지도 학습(Self-supervised Learning)을 통해 모델의 언어 통계 구조와 다중모달 세계 모델을 구성하며, LLM 능력의 근간이다. 이 단계는 트릴리온 단위 말뭉치에서 전역 동기화 방식으로 훈련되어야 하며, 수천~수만 개 H100 GPU로 구성된 동일한 클러스터에 의존하며 비용의 80–95%를 차지한다. 대역폭과 데이터 저작권에 매우 민감하므로 고도로 집중된 환경에서만 완료될 수 있다.

-

미세조정(Supervised Fine-tuning)은 과제 수행 능력과 명령어 형식을 주입하기 위해 사용되며, 데이터 양이 작고 비용은 약 5–15%를 차지한다. 미세조정은 전체 파라미터 훈련 또는 파라미터 효율적 미세조정(PEFT) 방법 중 LoRA, Q-LoRA, Adapter 등을 활용할 수 있다. 그러나 여전히 동기화된 그래디언트가 필요하여 탈중앙화 가능성은 제한적이다.

-

후속 훈련(Post-training)은 여러 반복적인 하위 단계로 구성되며, 모델의 추론 능력, 가치관, 안전 경계를 결정한다. 여기에는 강화학습 체계(RLHF, RLAIF, GRPO)뿐 아니라 RL이 없는 선호 최적화(DPO), 프로세스 보상 모델(PRM) 등도 포함된다. 이 단계의 데이터량과 비용은 낮으며(5–10%), 주로 Rollout과 전략 업데이트에 집중된다. 비동기 및 분산 실행이 가능하며 노드가 전체 가중치를 보유할 필요가 없고, 검증 가능한 컴퓨팅과 체인상 인센티브를 결합하면 개방형 탈중앙화 훈련 네트워크를 형성할 수 있어 Web3와 가장 잘 맞는 훈련 단계이다.

강화학습 기술 개요: 아키텍처, 프레임워크 및 응용

강화학습의 시스템 아키텍처와 핵심 요소

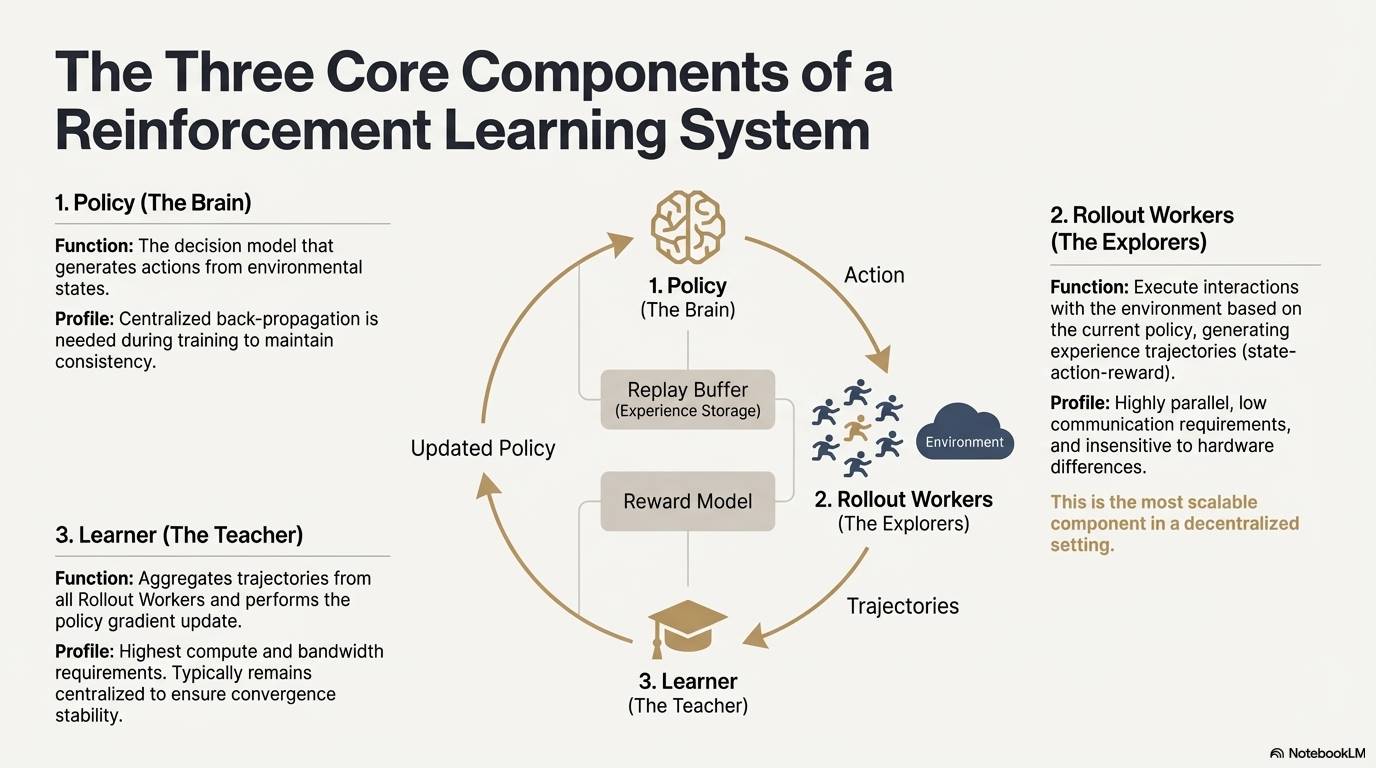

강화학습(Reinforcement Learning, RL)은 "환경 상호작용 - 보상 피드백 - 전략 업데이트"를 통해 모델이 스스로 의사결정 능력을 향상시키며, 핵심 구조는 상태, 행동, 보상, 전략으로 구성된 피드백 폐쇄루프로 볼 수 있다. 완전한 RL 시스템은 일반적으로 세 가지 구성 요소로 나뉜다: Policy(전략 네트워크), Rollout(경험 샘플링), Learner(전략 업데이터). 전략 네트워크는 환경과 상호작용하여 궤적을 생성하고, Learner는 보상 신호에 따라 전략을 업데이트함으로써 지속적으로 반복하고 최적화되는 학습 과정을 형성한다:

-

전략 네트워크(Policy): 환경 상태로부터 행동을 생성하며 시스템의 의사결정 핵심이다. 훈련 시 일관성을 유지하기 위해 집중형 역전파가 필요하며, 추론 시에는 다양한 노드에 분산하여 병렬 실행이 가능하다.

-

경험 샘플링(Rollout): 노드는 전략에 따라 환경과 상호작용하여 상태-행동-보상 등의 궤적을 생성한다. 이 과정은 고도로 병렬적이며 통신량이 극히 적고 하드웨어 차이에 덜 민감하여 탈중앙화 확장에 가장 적합한 단계이다.

-

학습기(Learner): 모든 Rollout 궤적을 집계하고 전략 그래디언트 업데이트를 수행하며, 연산력과 대역폭 요구가 가장 높은 유일한 모듈이므로 수렴 안정성을 보장하기 위해 일반적으로 중심화되거나 경량 중심화 배치를 유지한다.

강화학습 단계별 프레임워크 (RLHF → RLAIF → PRM → GRPO)

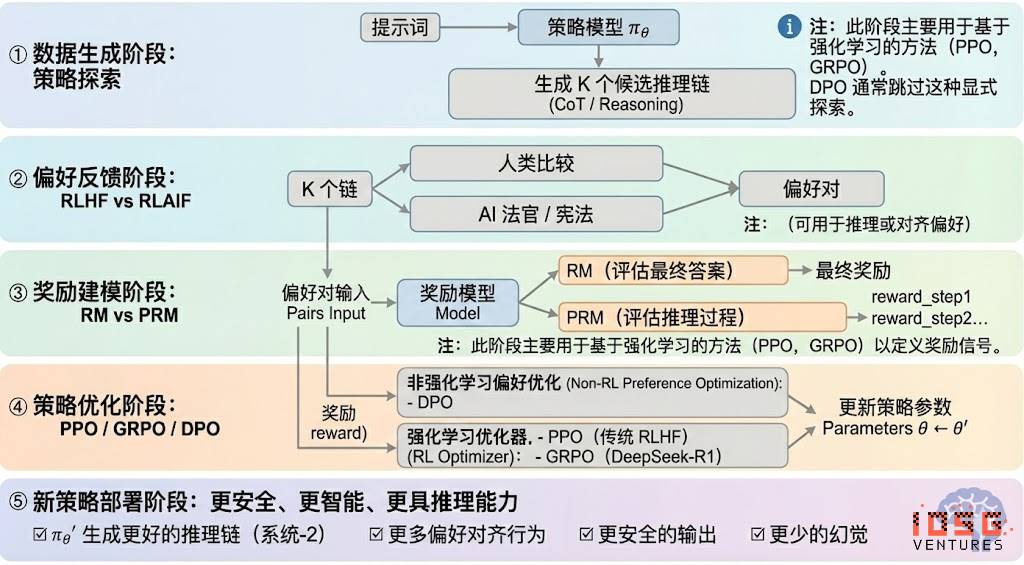

강화학습은 일반적으로 다섯 단계로 나뉘며, 전체 프로세스는 다음과 같다:

#데이터 생성 단계 (Policy Exploration)

주어진 입력 프롬프트 하에서 전략 모델 πθ가 여러 후보 추론 체인 또는 완전한 궤적을 생성하여 이후 선호 평가 및 보상 모델링에 필요한 샘플 기반을 제공하며, 전략 탐색의 범위를 결정한다.

#선호 피드백 단계 (RLHF / RLAIF)

-

RLHF(Reinforcement Learning from Human Feedback)는 다중 후보 답변, 인간 선호 라벨링, 보상 모델(RM) 훈련, PPO를 통한 전략 최적화를 통해 모델 출력이 인간 가치에 더 부합하도록 만든다. GPT-3.5 → GPT-4 전환의 핵심 요소였다.

-

RLAIF(Reinforcement Learning from AI Feedback)는 인간 라벨링을 AI 판사 또는 헌법적 규칙으로 대체하여 선호 데이터 획득 자동화를 실현하며, 비용을 크게 줄이고 확장성을 갖춘다. 현재 Anthropic, OpenAI, DeepSeek 등에서 주류 정렬 패러다임으로 자리 잡았다.

#보상 모델링 단계 (Reward Modeling)

선호 쌍을 입력하여 보상 모델에 학습시켜 출력을 보상으로 매핑한다. RM은 모델에게 "무엇이 올바른 답인지"를 가르치고, PRM은 "어떻게 올바르게 추론하는지"를 가르친다.

-

RM(Reward Model): 최종 답변의 우열을 평가하며 출력에만 점수를 부여한다.

-

과정 보상 모델PRM(Process Reward Model): 최종 답변만 평가하지 않고 각 추론 단계, 각 토큰, 각 논리 세그먼트에 점수를 부여하며, OpenAI o1 및 DeepSeek-R1의 핵심 기술로서 본질적으로 "모델에게 생각하는 법을 가르치는 것"이다.

#보상 검증 단계 (RLVR / Reward Verifiability)

보상 신호 생성 및 사용 과정에 "검증 가능한 제약"을 도입하여 보상이 가능한 한 재현 가능한 규칙, 사실 또는 합의에서 유래하도록 하며, reward hacking 및 편향 위험을 줄이고 개방 환경에서의 감사 가능성과 확장성을 향상시킨다.

#전략 최적화 단계 (Policy Optimization)

보상 모델이 제공하는 신호에 따라 전략 파라미터 θ를 업데이트하여 더 강력한 추론 능력, 더 높은 안전성, 더 안정적인 행동 패턴을 갖춘 전략 πθ′를 얻는다. 주류 최적화 방법은 다음과 같다:

-

PPO(Proximal Policy Optimization): RLHF의 전통적 최적화기로 안정성이 뛰어나지만 복잡한 추론 과제에서는 수렴 속도가 느리고 안정성이 부족한 한계가 있다.

-

GRPO(Group Relative Policy Optimization): DeepSeek-R1의 핵심 혁신으로, 후보 답변 그룹 내 우위 분포를 모델링하여 기대 가치를 추정하며 단순 순위 매기기를 넘는다. 이 방법은 보상 크기 정보를 보존하여 추론 체인 최적화에 더 적합하며 훈련 과정이 안정적이어서 PPO 이후 심층 추론 시나리오를 위한 중요한 강화학습 최적화 프레임워크로 간주된다.

-

DPO(Direct Preference Optimization): 강화학습이 아닌 후속 훈련 방법으로 궤적 생성이나 보상 모델 훈련 없이 선호 쌍에서 직접 최적화한다. 비용이 낮고 효과가 안정적이므로 Llama, Gemma 등 오픈소스 모델 정렬에 널리 사용되지만 추론 능력 향상은 불가능하다.

#신규 전략 배포 단계 (New Policy Deployment)

최적화된 모델은 더 강력한 추론 체인 생성 능력(System-2 Reasoning), 인간 또는 AI 선호에 더 부합하는 행동, 더 낮은 환각률, 더 높은 안전성을 나타낸다. 모델은 지속적인 반복을 통해 선호를 학습하고, 프로세스를 최적화하며, 의사결정 품질을 향상시키는 폐쇄 루프를 형성한다.

강화학습의 산업 응용 다섯 가지 분류

강화학습(Reinforcement Learning)은 초기 게임 지능에서부터 산업 전반의 자율 의사결정 핵심 프레임워크로 진화하였으며, 기술 성숙도와 산업 적용 정도에 따라 다섯 가지 카테고리로 정리할 수 있고 각 방향에서 핵심 돌파구를 마련했다.

-

게임 및 전략 시스템(Game & Strategy): RL이 최초로 검증된 분야로 AlphaGo, AlphaZero, AlphaStar, OpenAI Five 등 "완전 정보 + 명확한 보상" 환경에서 인간 전문가 수준을 넘어설 수 있는 의사결정 지능을 보여주었으며 현대 RL 알고리즘의 기반을 마련했다.

-

로봇 및 구현 지능(Embodied AI): RL은 연속 제어, 동역학 모델링, 환경 상호작용을 통해 로봇이 조작, 운동 제어, 다중모달 과제(RT-2, RT-X 등)를 학습하게 하며 빠르게 산업화되고 있으며 현실 세계 로봇 상용화의 핵심 기술 경로이다.

-

디지털 추론(Digital Reasoning / LLM System-2): RL + PRM은 대규모 모델을 "언어 모방"에서 "구조적 추론"으로 이끈다. 대표적 성과로 DeepSeek-R1, OpenAI o1/o3, Anthropic Claude, AlphaGeometry 등이 있으며 본질적으로 최종 답변 평가가 아닌 추론 체인 수준에서 보상 최적화를 수행한다.

-

자동 과학 발견 및 수학 최적화(Scientific Discovery): RL은 무라벨, 복잡한 보상, 거대한 탐색 공간에서 최적 구조 또는 전략을 찾는 데 사용되며 AlphaTensor, AlphaDev, Fusion RL 등 기초적 돌파구를 이루었고 인간 직관을 초월하는 탐색 능력을 보여주었다.

-

경제 의사결정 및 거래 시스템(Economic Decision-making & Trading): RL은 전략 최적화, 고차원 리스크 제어, 적응형 거래 시스템 생성에 사용되며 전통적 양적 모델보다 불확실한 환경에서도 지속적으로 학습할 수 있어 스마트 금융의 핵심 구성 요소이다.

강화학습과 Web3의 천연적 시너지

강화학습(RL)과 Web3의 높은 시너지는 본질적으로 둘 다 "인센티브 기반 시스템"이기 때문이다. RL은 보상 신호에 의존하여 전략을 최적화하고, 블록체인은 경제적 인센티브를 통해 참여자의 행동을 조정하므로 메커니즘 차원에서 천연적으로 일치한다. RL의 핵심 요구사항—대규모 이종 Rollout, 보상 분배, 진실성 검증—恰恰正是 Web3의 구조적 장점이다.

#추론과 훈련의 분리

강화학습의 훈련 과정은 두 단계로 명확히 분리된다:

-

Rollout (탐색 샘플링): 현재 전략에 기반해 모델이 대량의 데이터를 생성하며, 연산 집약적이지만 통신이 드문 작업이다. 노드 간 빈번한 통신이 필요하지 않아 전 세계 소비자급 GPU에서 병렬 생성이 가능하다.

-

Update (파라미터 업데이트): 수집된 데이터를 기반으로 모델 가중치를 업데이트하며, 고대역폭 중심화 노드가 필요하다.

"추론-훈련 분리"는 천연적으로 이종 컴퓨팅 구조의 탈중앙화와 부합한다: Rollout는 개방 네트워크에 아웃소싱되어 기여도에 따라 토큰 메커니즘으로 정산되며, 모델 업데이트는 안정성을 위해 중심화를 유지한다.

#검증 가능성 (Verifiability)

ZK 및 Proof-of-Learning은 노드가 실제로 추론을 수행했는지를 검증하는 수단을 제공하며 개방 네트워크의 정직성 문제를 해결한다. 코드, 수학 추론 등 결정론적 과제에서 검증자는 답변만 확인해도 작업량을 인증할 수 있어 탈중앙화 RL 시스템의 신뢰도를 크게 향상시킨다.

#인센티브 계층: 토큰 경제 기반 피드백 생산 메커니즘

Web3의 토큰 메커니즘은 RLHF/RLAIF의 선호 피드백 기여자에게 직접 보상을 제공하여 선호 데이터 생성에 투명하고 정산 가능하며 허가가 필요 없는 인센티브 구조를 부여한다. 스테이킹 및 슬래싱(Staking/Slashing)은 피드백 품질을 추가로 제한하여 전통적 아웃소싱보다 더 효율적이고 정렬된 피드백 시장을 형성한다.

#다중 에이전트 강화학습(MARL) 잠재력

블록체인은 본질적으로 공개적이고, 투명하며, 지속적으로 진화하는 다중 에이전트 환경이며, 계정, 계약, 에이전트는 인센티브에 의해 지속적으로 전략을 조정하므로 대규모 MARL 실험장 구축의 천연적 잠재력을 갖는다. 아직 초기 단계이지만 상태 공개, 실행 검증 가능성, 인센티브 프로그래밍 가능성 등 특성은 미래 MARL 발전에 원칙적 장점을 제공한다.

대표적인 Web3 + 강화학습 프로젝트 분석

위 이론적 프레임워크를 바탕으로 현재 생태계에서 가장 대표적인 프로젝트들을 간략히 분석한다:

Prime Intellect: 비동기 강화학습 패러다임 prime-rl

Prime Intellect은 전 세계 개방형 컴퓨팅 시장을 구축하여 훈련 장벽을 낮추고 협업 기반 탈중앙화 훈련을 촉진하며 완전한 오픈소스 슈퍼지능 기술 스택을 발전시키는 것을 목표로 한다. 이 시스템은 Prime Compute(통합 클라우드/분산 컴퓨팅 환경), INTELLECT 모델 패밀리(10B–100B+), 개방형 강화학습 환경 허브(Environments Hub), 대규모 합성 데이터 엔진(SYNTHETIC-1/2)을 포함한다.

Prime Intellect의 핵심 인프라 컴포넌트인 prime-rl 프레임워크는 비동기 분산 환경 및 강화학습에 고도로 관련되며, 대역폭 병목 현상을 극복하는 OpenDiLoCo 통신 프로토콜, 컴퓨팅 무결성을 보장하는 TopLoc 검증 메커니즘 등을 포함한다.

#Prime Intellect 핵심 인프라 구성 요소 개요

#기술 기반: prime-rl 비동기 강화학습 프레임워크

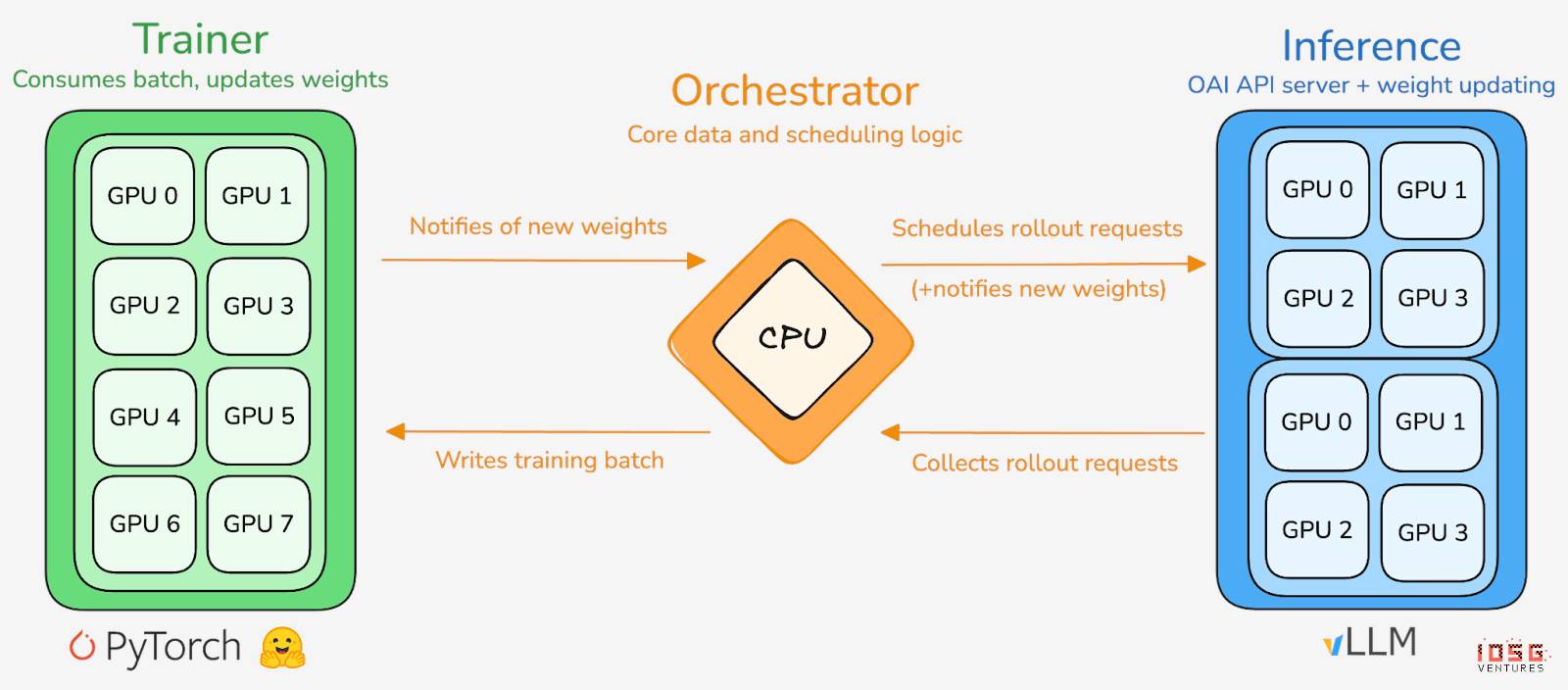

prime-rl은 Prime Intellect의 핵심 훈련 엔진으로 대규모 비동기 탈중앙화 환경을 위해 설계되었으며 Actor–Learner 완전 분리를 통해 고처리량 추론과 안정적인 업데이트를 달성한다. 실행자(Rollout Worker)와 학습자(Trainer)는 더 이상 동기화되지 않으며 노드는 언제든지 가입하거나 탈퇴할 수 있고 최신 전략을 지속적으로 가져와 생성된 데이터를 업로드하기만 하면 된다:

-

실행자 Actor (Rollout Workers): 모델 추론과 데이터 생성을 담당한다. Prime Intellect는 Actor 단에 vLLM 추론 엔진을 혁신적으로 통합하였다. vLLM의 PagedAttention 기술과 연속 배치 처리(Continuous Batching) 능력 덕분에 Actor는 매우 높은 처리량으로 추론 궤적을 생성할 수 있다.

-

학습자 Learner (Trainer): 전략 최적화를 담당한다. Learner는 공유 경험 리플레이 버퍼(Experience Buffer)에서 비동기적으로 데이터를 가져와 그래디언트 업데이트를 수행하며 모든 Actor가 현재 배치를 완료할 때까지 기다릴 필요가 없다.

-

조정기 (Orchestrator): 모델 가중치와 데이터 흐름을 조정한다.

#prime-rl의 핵심 혁신 포인트

-

완전 비동기(True Asynchrony): prime-rl은 전통적인 PPO의 동기화 패러다임을 버리고 느린 노드를 기다리지 않으며 배치 정렬이 필요 없어 임의의 수와 성능의 GPU가 언제든지 접속할 수 있도록 하여 탈중앙화 RL의 실현 가능성을 마련한다.

-

FSDP2 및 MoE 심층 통합: FSDP2 파라미터 슬라이싱과 MoE 희소 활성화를 통해 prime-rl은 백억 규모 모델을 분산 환경에서 효율적으로 훈련시킨다. Actor는 활성 전문가만 실행하여 메모리와 추론 비용을 크게 줄인다.

-

GRPO+(Group Relative Policy Optimization): GRPO는 Critic 네트워크를 제거하여 계산 및 메모리 오버헤드를 크게 줄이며 비동기 환경에 자연스럽게 적합하다. prime-rl의 GRPO+는 안정화 메커니즘을 통해 고지연 조건에서도 신뢰할 수 있는 수렴을 보장한다.

#INTELLECT 모델 패밀리: 탈중앙화 RL 기술 성숙도의 지표

-

INTELLECT-1(10B, 2024년 10월): OpenDiLoCo가 세 대륙에 걸친 이종 네트워크에서 효율적으로 훈련될 수 있음을 처음으로 입증(통신 비중 <2%, 컴퓨팅 이용률 98%), 지리적 훈련의 물리적 인식을 깼다.

-

INTELLECT-2(32B, 2025년 4월): 최초의 Permissionless RL 모델로서 prime-rl과 GRPO+가 다중 지연, 비동기 환경에서 안정적으로 수렴할 수 있음을 검증하여 전 세계 개방형 컴퓨팅 참여 기반의 탈중앙화 RL을 실현했다.

-

INTELLECT-3(106B MoE, 2025년 11월): 12B 파라미터만 활성화하는 희소 아키텍처를 채택하여 512×H200에서 훈련하고 플래그십 수준의 추론 성능(AIME 90.8%, GPQA 74.4%, MMLU-Pro 81.9% 등)을 달성하였으며, 전반적인 성능이 자신보다 훨씬 큰 규모의 중심화 폐쇄 모델에 육박하거나 초과하였다.

Prime Intellect은 또한 여러 지원 인프라를 구축하였다: OpenDiLoCo는 시간 희소 통신과 양자화된 가중치 차이를 통해 지리적 훈련의 통신량을 수백 배 줄여 INTELLECT-1이 세 대륙 네트워크에서도 98% 이용률을 유지하게 했다. TopLoc + Verifiers는 탈중앙화 신뢰 실행 계층을 형성하여 활성화 지문과 샌드박스 검증을 통해 추론 및 보상 데이터의 진실성을 보장한다. SYNTHETIC 데이터 엔진은 대규모 고품질 추론 체인을 생성하며 파이프라인 병렬화를 통해 671B 모델을 소비자급 GPU 클러스터에서 효율적으로 실행한다. 이러한 구성 요소들은 탈중앙화 RL의 데이터 생성, 검증, 추론 처리량에 핵심적인 엔지니어링 기반을 제공한다. INTELLECT 시리즈는 이 기술 스택이 성숙한 세계적 수준의 모델을 생산할 수 있음을 입증하며 탈중앙화 훈련 체계가 개념 단계에서 실용 단계로 진입했음을 의미한다.

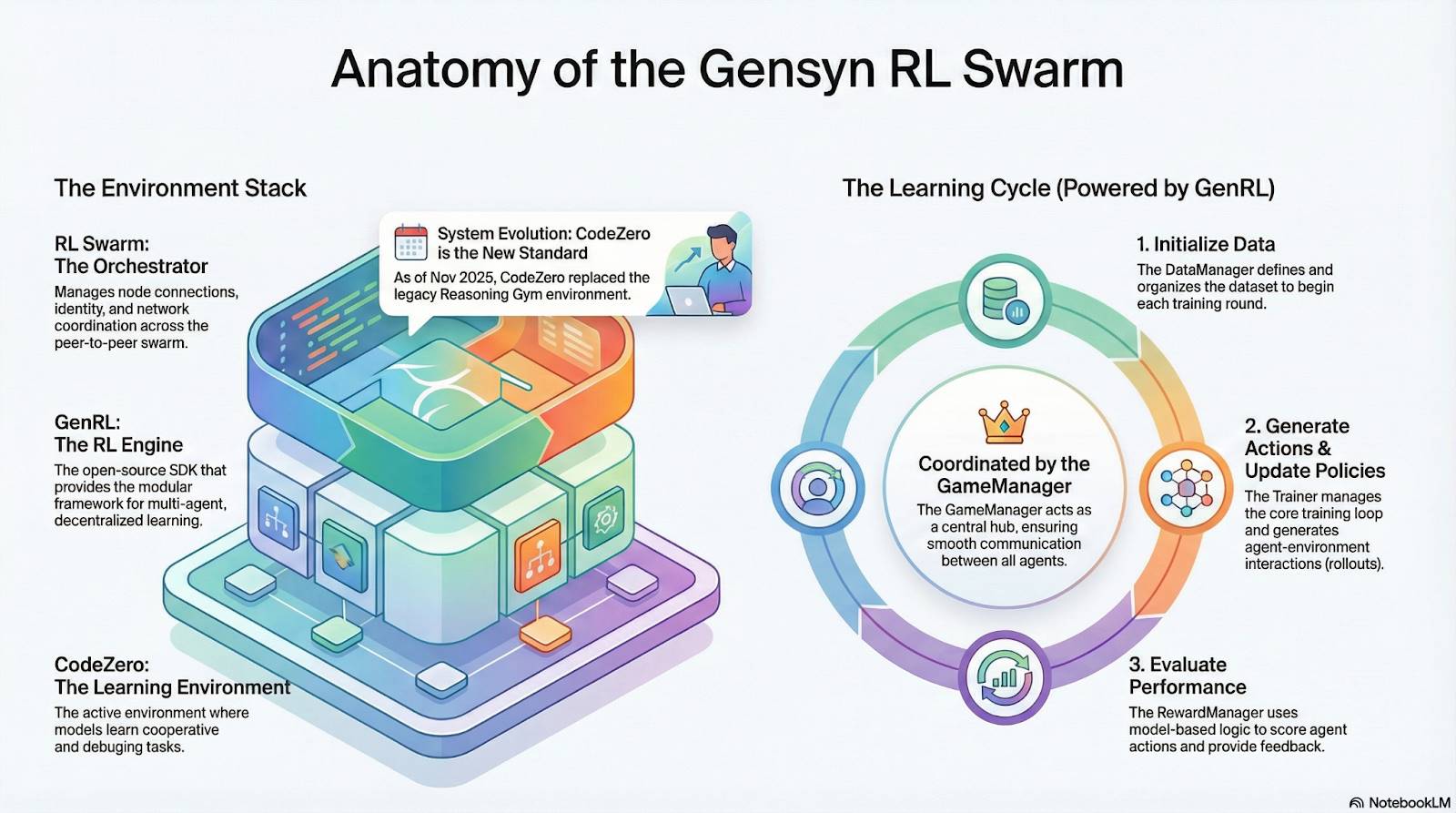

Gensyn: 강화학습 핵심 스택 RL Swarm과 SAPO

Gensyn의 목표는 전 세계 유휴 컴퓨팅을 하나의 개방적이고 신뢰 불필요하며 무제한 확장 가능한 AI 훈련 인프라로 통합하는 것이다. 핵심 요소로는 디바이스 간 표준화 실행 계층, P2P 조정 네트워크, 신뢰 불필요한 작업 검증 시스템이 있으며 스마트 계약을 통해 작업과 보상을 자동 분배한다. 강화학습의 특성에 따라 Gensyn은 RL Swarm, SAPO, SkipPipe 등의 핵심 메커니즘을 도입하여 생성, 평가, 업데이트 세 단계를 분리하고 전 세계 이종 GPU로 구성된 '군집'을 활용하여 집단 진화를 실현한다. 최종적으로 제공되는 것은 단순한 컴퓨팅이 아니라 검증 가능한 지능(Verifiable Intelligence)이다.

#Gensyn 스택의 강화학습 응용

#RL Swarm: 탈중앙화 협업 강화학습 엔진

RL Swarm은 새로운 형태의 협업 모델을 제시한다. 단순한 작업 분배가 아니라 인간 사회 학습을 모방한 탈중앙화된 "생성-평가-업데이트" 루프로서 협업 학습 과정을 무한 반복한다:

-

Solvers(실행자): 로컬 모델 추론과 Rollout 생성을 담당하며 노드 이질성은 문제가 되지 않는다. Gensyn은 CodeZero 등 고처리량 추론 엔진을 로컬에 통합하여 답변뿐만 아니라 전체 궤적을 출력할 수 있다.

-

Proposers(출제자): 동적으로 과제(수학 문제, 코드 문제 등)를 생성하며 과제 다양성과 커리큘럼 학습과 유사한 난이도 자가 조절을 지원한다.

-

Evaluators(평가자): 고정된 '판사 모델' 또는 규칙을 사용하여 로컬 Rollout을 평가하고 로컬 보상 신호를 생성한다. 평가 과정은 감사 가능하여 악의적 행위 공간을 줄인다.

이 세 가지 요소는 P2P RL 조직 구조를 공동 구성하며 중심화된 스케줄링 없이도 대규모 협업 학습을 완료할 수 있다.

#SAPO: 탈중앙화를 위해 재구성된 전략 최적화 알고리즘

SAPO(Swarm Sampling Policy Optimization)는 "그래디언트 신호가 없는 샘플을 필터링하여 롤아웃을 공유하고, 그래디언트를 공유하지 않는다"는 것을 핵심으로 대규모 탈중앙화된 Rollout 샘플링을 수행하며 수신한 Rollout을 로컬 생성물로 간주함으로써 중심화 조정 없이 노드 지연 차이가 큰 환경에서도 안정적인 수렴을 유지한다. Critic 네트워크에 의존하고 계산 비용이 높은 PPO나 그룹 내 우위 추정 기반 GRPO와 비교해 SAPO는 극히 낮은 대역폭으로 소비자급 GPU가 대규모 강화학습 최적화에 효과적으로 참여할 수 있게 한다.

RL Swarm과 SAPO를 통해 Gensyn은 강화학습(특히 후속 훈련 단계의 RLVR)이 탈중앙화 아키텍처에 천연적으로 적합함을 입증하였다. 이는 고빈도 파라미터 동기화보다 대규모, 다양한 탐색(Rollout)에 더 의존하기 때문이다. PoL과 Verde 검증 시스템을 결합하여 Gensyn은 단일 기술 거물에 의존하지 않는 트릴리언 파라미터 모델 훈련을 위한 대안 경로를 제시한다. 즉, 전 세계 수백만 이종 GPU로 구성된 자가 진화 슈퍼지능 네트워크이다.

Nous Research: 검증 가능한 강화학습 환경 Atropos

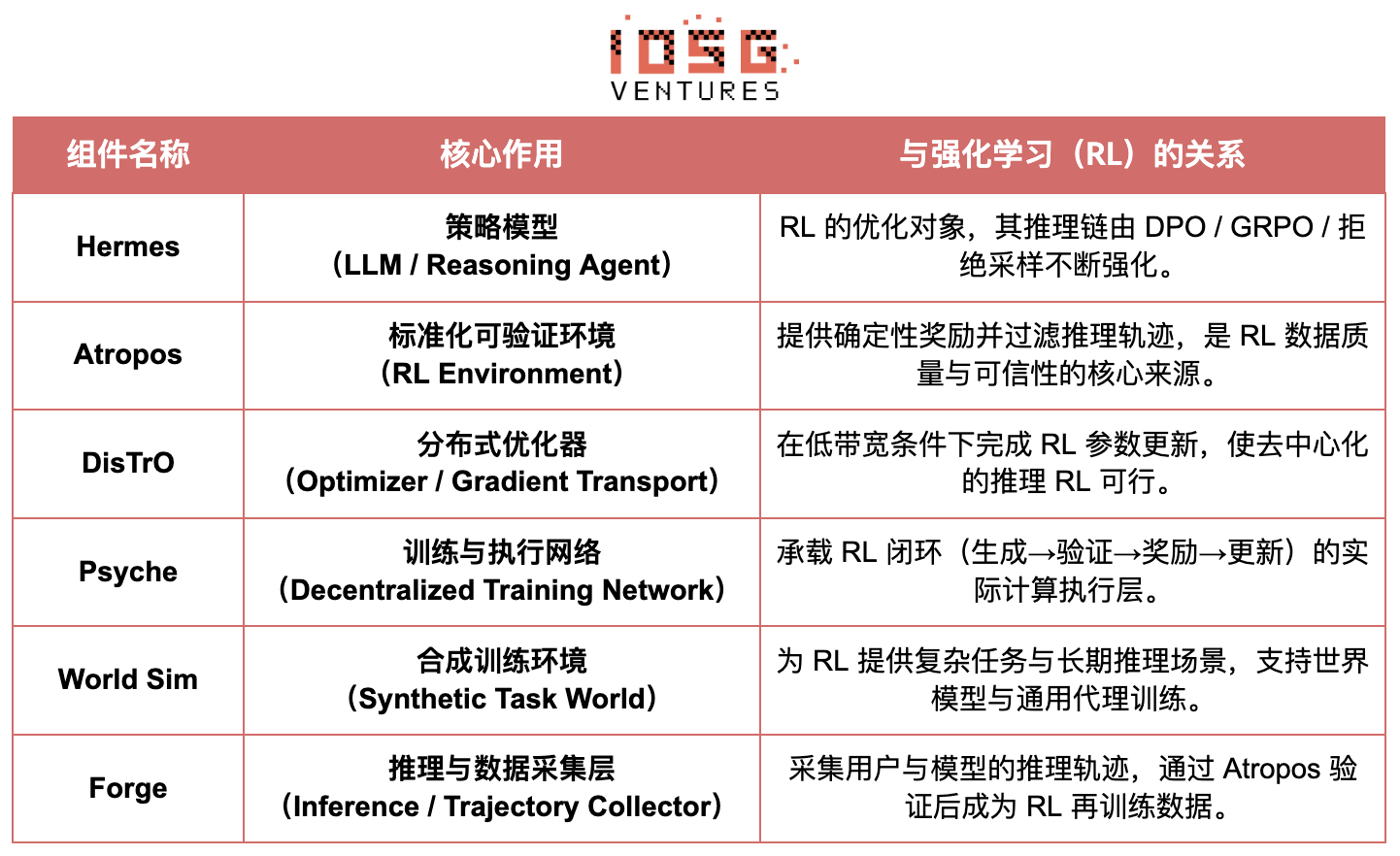

Nous Research는 탈중앙화되고 자가 진화 가능한 인지 인프라를 구축하고 있다. 핵심 구성 요소인 Hermes, Atropos, DisTrO, Psyche, World Sim은 지속적인 폐쇄 루프 지능 진화 시스템으로 조직된다. 전통적인 "사전 훈련-후속 훈련-추론" 선형 프로세스와 달리 Nous는 DPO, GRPO, 거부 샘플링 등의 강화학습 기술을 사용하여 데이터 생성, 검증, 학습, 추론을 연속적인 피드백 루프로 통합하여 지속적으로 자기 개선하는 폐쇄형 AI 생태계를 구축한다.

#Nous Research 구성 요소 개요

#모델 계층: Hermes와 추론 능력의 진화

Hermes 시리즈는 Nous Research가 사용자에게 제공하는 주요 모델 인터페이스이며, 그 진화는 업계가 전통적인 SFT/DPO 정렬에서 추론 중심 강화학습(Reasoning RL)으로 이동하는 경로를 명확히 보여준다:

-

Hermes 1–3: 명령어 정렬 및 초기 에이전트 능력: Hermes 1–3은 저비용 DPO로 견고한 명령어 정렬을 완료하며 Hermes 3에서는 합성 데이터와 최초 도입된 Atropos 검증 메커니즘을 활용한다.

-

Hermes 4 / DeepHermes: 사고의 연쇄를 통해 System-2 방식의 느린 사고를 가중치에 기록하고 Test-Time Scaling을 통해 수학 및 코드 성능을 향상시키며 "거부 샘플링 + Atropos 검증"을 통해 고순도 추론 데이터를 구축한다.

-

DeepHermes는 PPO보다 분산 배치가 어려운 GRPO를 채택하여 추론 RL이 Psyche 탈중앙화 GPU 네트워크에서 실행되도록 하였으며 오픈소스 추론 RL의 확장성에 공학적 기반을 마련하였다.

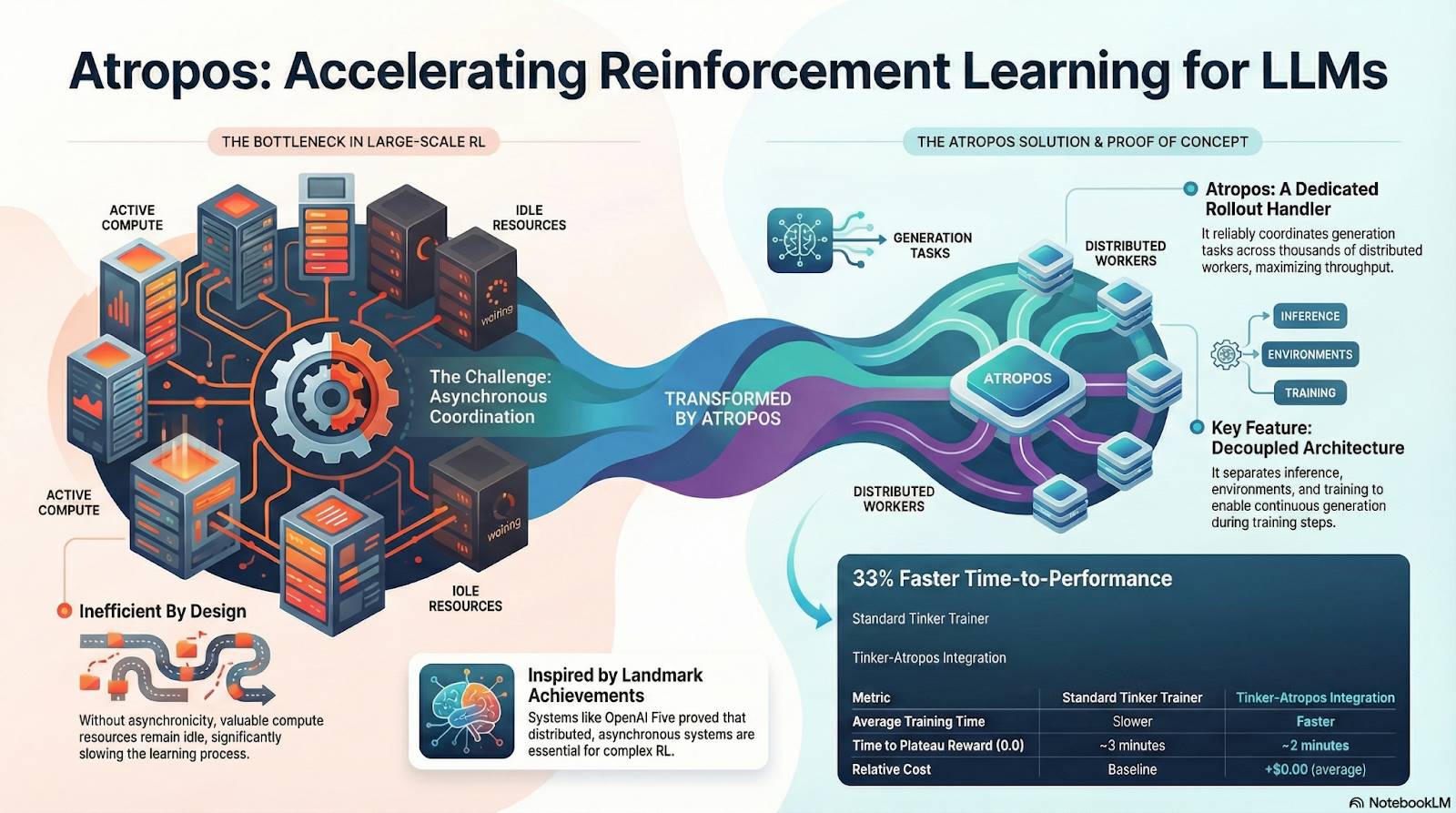

#Atropos: 검증 가능한 보상 기반 강화학습 환경

Atropos는 Nous RL 시스템의 진정한 핵심이다. 프롬프트, 도구 호출, 코드 실행, 다중 라운드 상호작용을 표준화된 RL 환경으로 패키징하여 출력이 올바른지 직접 검증할 수 있으므로 고비용이고 확장 불가능한 인간 라벨링을 대체하는 결정적 보상 신호를 제공한다. 더욱 중요한 것은, 탈중앙화 훈련 네트워크 Psyche에서 Atropos는 "심판" 역할을 하며 노드가 전략을 실제로 향상시켰는지 검증하고 감사 가능한 Proof-of-Learning을 지원하여 분산형 RL의 보상 신뢰성 문제를 근본적으로 해결한다.

#DisTrO와 Psyche: 탈중앙화 강화학습의 최적화 계층

전통적인 RLF(RLHF/RLAIF) 훈련은 중심화된 고대역폭 클러스터에 의존하는데, 이것이 오픈소스가 복제할 수 없는 핵심 장벽이다. DisTrO는 모멘텀 분리와 그래디언트 압축을 통해 RL의 통신 비용을 수 개 등급 낮추어 인터넷 대역폭에서 훈련이 가능하게 하고, Psyche는 이를 체인상 네트워크에 배치하여 노드가 로컬에서 추론, 검증, 보상 평가, 가중치 업데이트를 완료하고 완전한 RL 폐쇄 루프를 형성한다.

Nous의 시스템에서 Atropos는 사고의 연쇄를 검증하고, DisTrO는 훈련 통신을 압축하며, Psyche는 RL 루프를 실행하고, World Sim은 복잡한 환경을 제공하며, Forge는 실제 추론을 수집하고, Hermes는 모든 학습을 가중치에 기록한다. 강화학습은 단순한 훈련 단계가 아니라 데이터, 환경, 모델, 인프라를 연결하는 Nous 아키텍처의 핵심 프로토콜로서 Hermes를 오픈소스 컴퓨팅 네트워크에서 지속적으로 자기 개선하는 생명체 시스템으로 만든다.

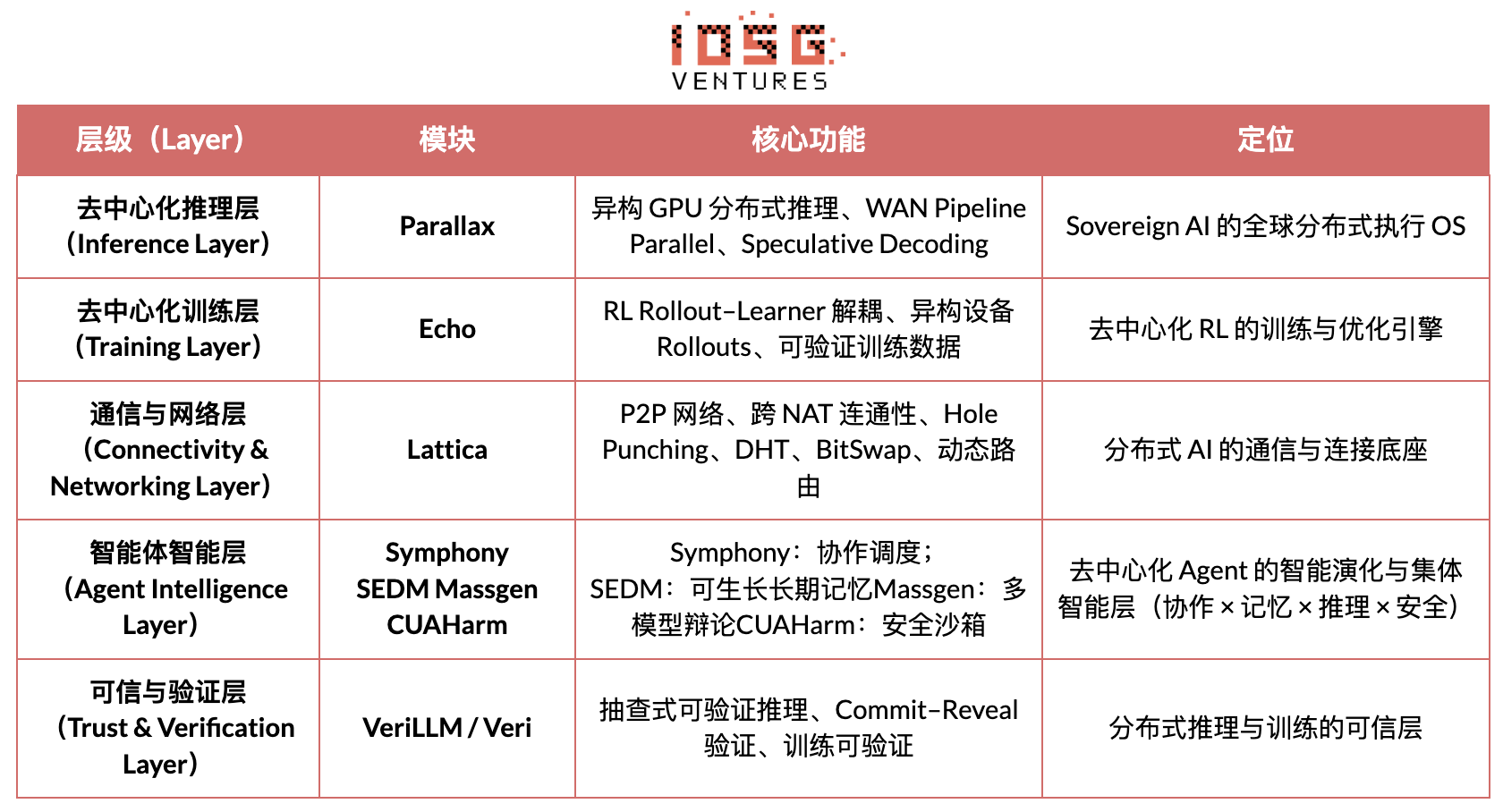

Gradient Network: 강화학습 아키텍처 Echo

Gradient Network의 핵심 비전은 "개방형 지능 프로토콜 스택"(Open Intelligence Stack)을 통해 AI 컴퓨팅 패러다임을 재구성하는 것이다. Gradient의 기술 스택은 독립적으로 진화하면서도 이종적으로 협업하는 일련의 핵심 프로토콜로 구성된다. 이 시스템은 하위 통신부터 상위 지능 협업까지 Parallax(분산 추론), Echo(탈중앙화 RL 훈련), Lattica(P2P 네트워크), SEDM/Massgen/Symphony/CUAHarm(메모리, 협업, 보안), VeriLLM(신뢰 검증), Mirage(고충실도 시뮬레이션)를 포함하여 지속적으로 진화하는 탈중앙화 지능 인프라를 구성한다.

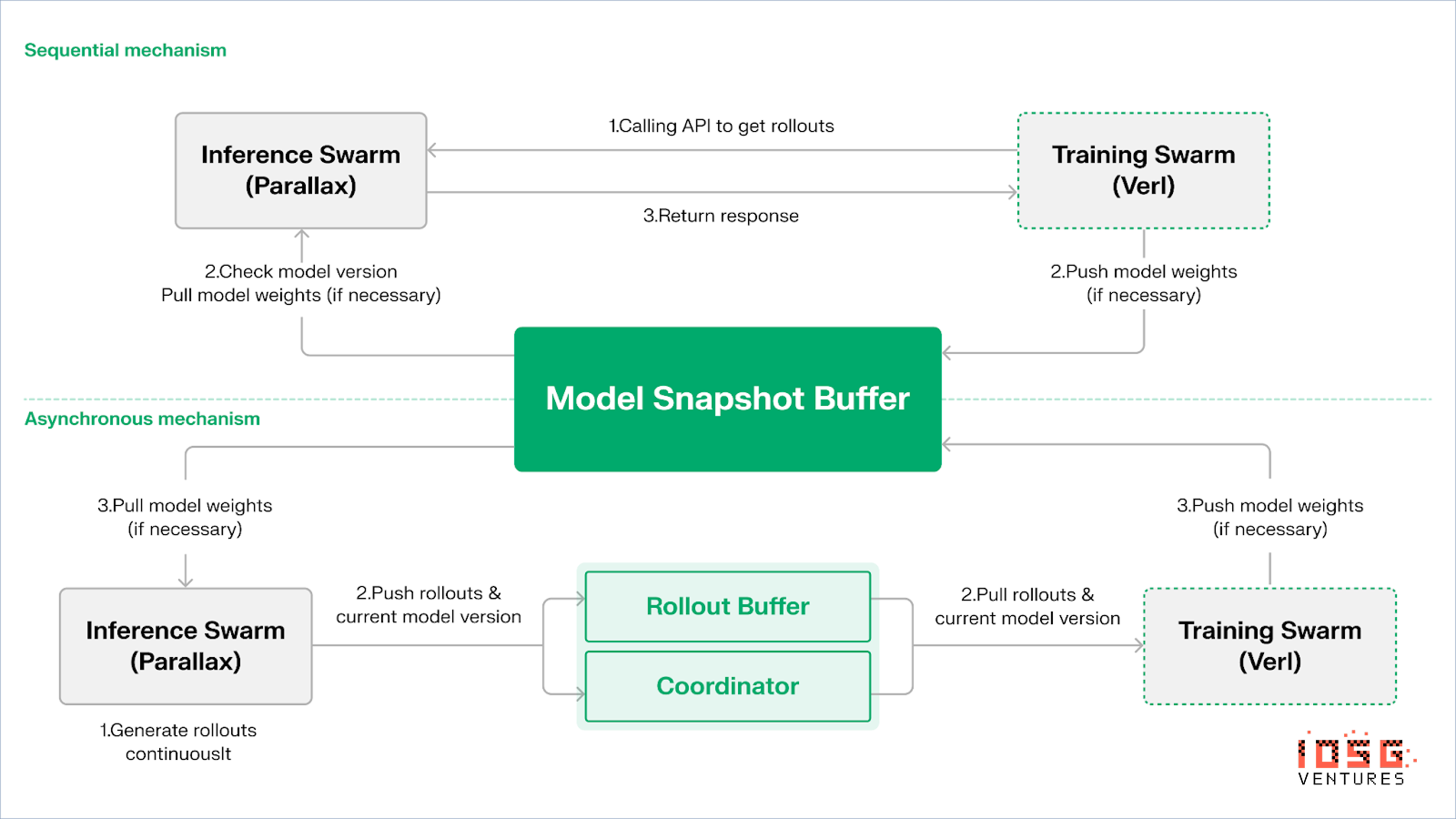

Echo — 강화학습 훈련 아키텍처

Echo는 Gradient의 강화학습 프레임워크로, 핵심 설계 철학은 강화학습에서 훈련, 추론, 데이터(보상) 경로를 분리하여 Rollout 생성, 전략 최적화, 보상 평가가 이종 환경에서 독립적으로 확장 및 스케줄링될 수 있도록 하는 것이다. 추론 측과 훈련 측 노드로 구성된 이종 네트워크에서 협업하여 광역 이종 환경에서 훈련 안정성을 유지하는 경량 동기화 메커니즘을 통해 전통적인 DeepSpeed RLHF/VERL에서 발생하는 SPMD 실패 및 GPU 이용률 병목 현상을 효과적으로 완화한다.

Echo는 "추론-훈련 이중 군집 아키텍처"를 채택하여 컴퓨팅 활용을 극대화하며, 두 군집은 서로 독립적으로 실행되어 상호 차단되지 않는다:

-

샘플링 처리량 극대화: 추론 군집 Inference Swarm은 소비자급 GPU 및 엣지 디바이스로 구성되며 Parallax를 통해 파이프라인-병렬 방식으로 고처리량 샘플러를 구축하고 궤적 생성에 집중한다.

-

그래디언트 컴퓨팅 극대화: 훈련 군집 Training Swarm은 중심화 클러스터 또는 전 세계 소비자급 GPU 네트워크에서 실행 가능하며 그래디언트 업데이트, 파라미터 동기화, LoRA 미세조정을 담당하고 학습 과정에 집중한다.

전략과 데이터의 일관성을 유지하기 위해 Echo는 순차적(Sequential) 및 비동기(Asynchronous) 두 가지 경량 동기화 프로토콜을 제공하여 전략 가중치와 궤적의 양방향 일관성 관리를 실현한다:

-

순차적 풀(Pull) 모드|정확도 우선: 훈련 측이 새 궤적을 가져오기 전에 추론 노드가 모델 버전을 새로 고치도록 강제하여 궤적의 최신성을 보장하며 전략 낙후에 매우 민감한 작업에 적합하다.

-

비동기 푸시-풀(Push–Pull) 모드|효율 우선: 추론 측은 지속적으로 버전 태그가 붙은 궤적을 생성하고 훈련 측은 자체 리듬에 따라 소비하며 조정기가 버전 편차를 모니터링하고 가중치 새로 고침을 트리거하여 장비 이용률을 극대화한다.

기반 기술적으로 Echo는 Parallax(저대역폭 환경의 이종 추론) 및 경량 분산 훈련 구성 요소(예: VERL) 위에 구축되며 LoRA를 통해 노드 간 동기화 비용을 낮춰 강화학습이 전 세계 이종 네트워크에서 안정적으로 실행될 수 있도록 한다.

Grail: Bittensor 생태계의 강화학습

Bittensor는 독특한 Yuma 합의 메커니즘을 통해 거대하고, 희소하며, 불안정한 보상 함수 네트워크를 구축한다.

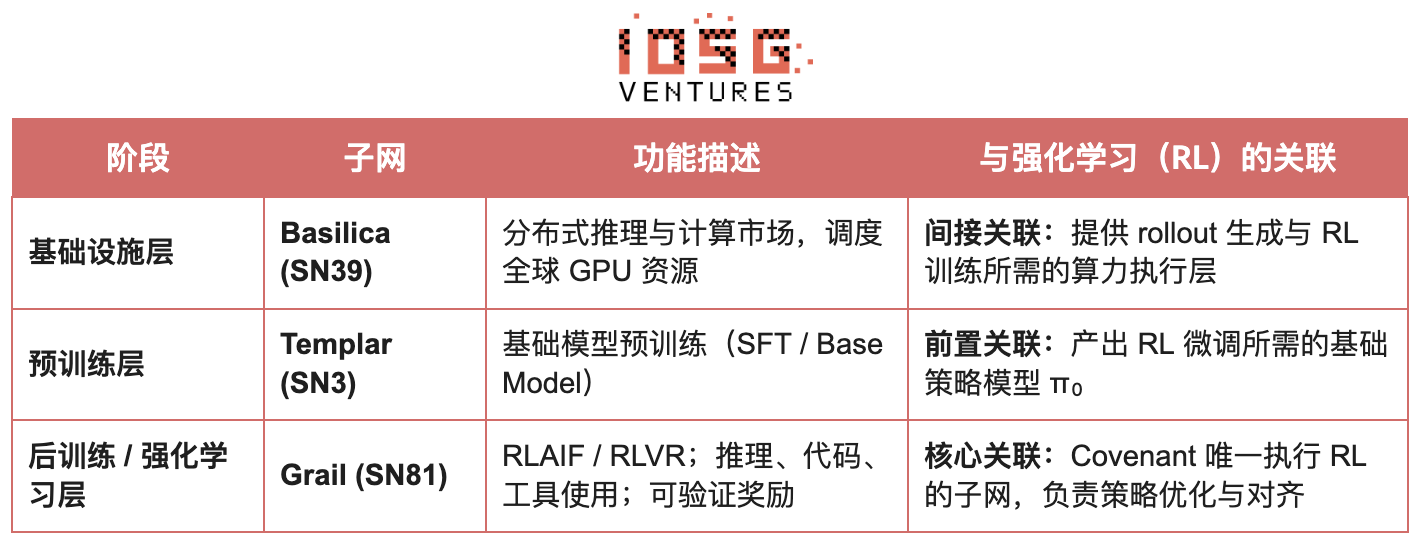

Bittensor 생태계의 Covenant AI는 SN3 Templar, SN39 Basilica, SN81 Grail을 통해 사전 훈련부터 RL 후속 훈련까지 수직 통합된 훈련 라인을 구축한다. 여기서 SN3 Templar는 기본 모델 사전 훈련을 담당하고, SN39 Basilica는 분산 컴퓨팅 시장을 제공하며, SN81 Grail은 RL 후속 훈련을 위한 "검증 가능한 추론 계층"으로 RLHF/RLAIF 핵심 프로세스를 수용하여 기본 모델에서 정렬 전략까지의 폐쇄 최적화를 완료한다.

GRAIL의 목표는 암호학적으로 각 강화학습 rollout의 진실성과 모델 신원 바인딩을 증명하여 신뢰 불필요한 환경에서도 RLHF가 안전하게 실행될 수 있도록 하는 것이다. 프로토콜은 세 가지 메커니즘을 통해 신뢰 체인을 구축한다:

-

결정론적 도전 과제 생성: drand 랜덤 비컨과 블록 해시를 활용하여 예측 불가능하지만 재현 가능한 도전 과제(SAT, GSM8K 등)를 생성하여 사전 계산 부정행위를 방지한다.

-

PRF 인덱스 샘플링과 sketch commitments를 통해 검증자가 매우 낮은 비용으로 token-level logprob과 추론 체인을 무작위로 검사하여 rollout이 선언된 모델에 의해 생성되었는지 확인한다.

-

모델 신원 바인딩: 추론 과정을 모델 가중치 지문 및 토큰 분포의 구조적 서명과 바인딩하여 모델 교체나 결과 재생이 즉시 식별되도록 한다. 이를 통해 RL의 추론 궤적(rollout)에 진실성 기반을 제공한다.

이 메커니즘을 기반으로 Grail 서브넷은 GRPO 스타일의 검증 가능한 후속 훈련 프로세스를 구현한다: 채굴자는 동일한 문제에 대해 다수의 추론 경로를 생성하고 검증자는 정확성, 추론 체인 품질, SAT 만족도에 따라 점수를 매기고 정규화된 결과를 TAO 가중치로 체인에 기록한다. 공개 실험 결과, 이 프레임워크는 Qwen2.5-1.5B의 MATH 정확도를 12.7%에서 47.6%로 향상시켜 부정행위를 방지하면서도 모델 능력을 크게 강화할 수 있음을 입증했다. Covenant AI의 훈련 스택에서 Grail은 탈중앙화 RLVR/RLAIF의 신뢰 및 실행 기반이며 현재 정식 메인넷 출시 전이다.

Fraction AI: 경쟁 기반 강화학습 RLFC

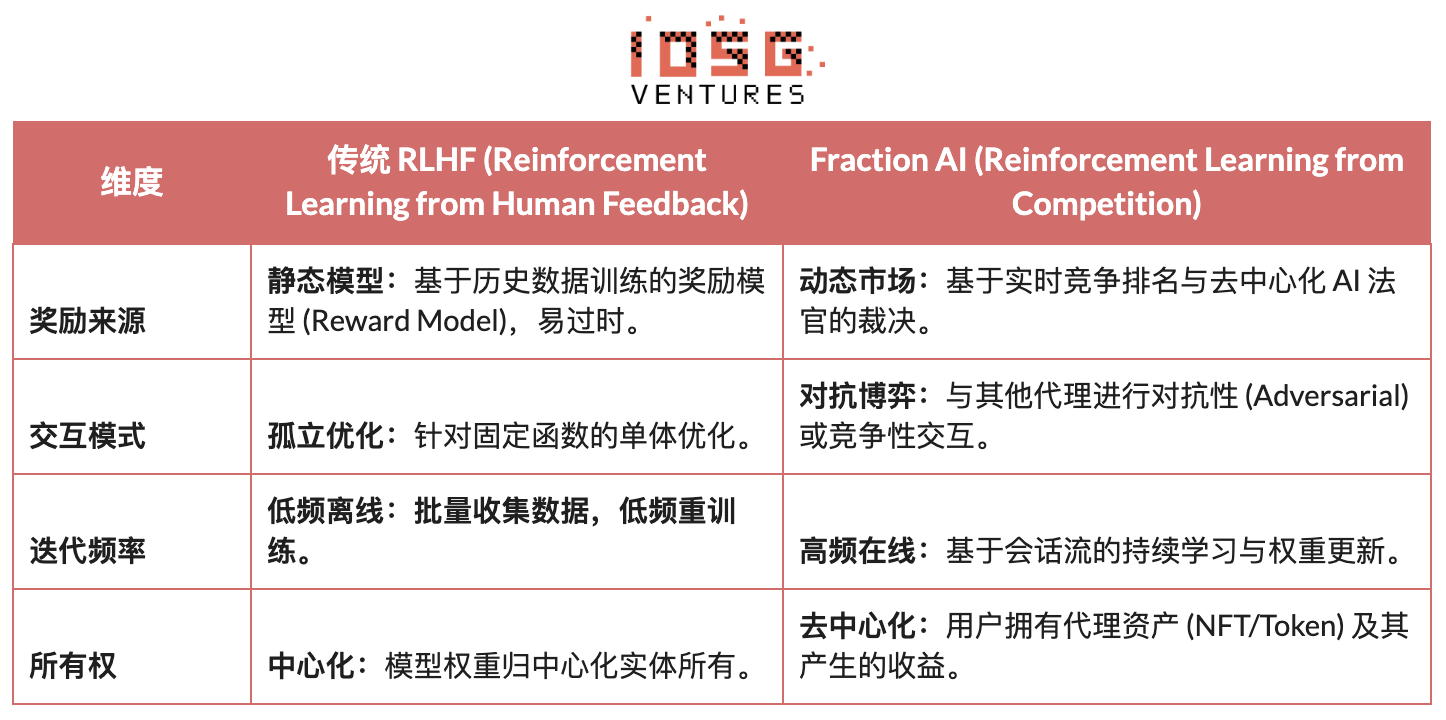

Fraction AI의 아키텍처는 경쟁 기반 강화학습(Reinforcement Learning from Competition, RLFC)과 게임화된 데이터 라벨링을 중심으로 명확하게 구성되며, 전통적인 RLHF의 정적 보상과 인공 라벨링을 개방적이고 동적인 경쟁 환경으로 대체한다. 에이전트는 서로 다른 Spaces에서 대결하며 상대적 순위와 AI 판사 점수가 실시간 보상을 구성하여 정렬 과정이 지속적인 온라인 다중 에이전트 게임 시스템으로 진화한다.

전통적 RLHF와 Fraction AI의 RLFC의 핵심 차이:

RLFC의 핵심 가치는 보상이 단일 모델에서 나오지 않고 지속적으로 진화하는 상대와 평가자에서 유래하여 보상 모델이 악용되는 것을 방지하고 전략 다양성을 통해 생태계가 지역 최적에 빠지는 것을 막는 것이다. Spaces의 구조는 게임 성격(영합 또는 정합)을 결정하며 대결과 협력을 통해 복잡한 행동의 출현을 촉진한다.

시스템 아키텍처 측면에서 Fraction AI는 훈련 과정을 네 가지 핵심 구성 요소로 분해한다:

-

Agents: 오픈소스 LLM 기반의 경량 전략 유닛으로 QLoRA를 통해 차등 가중치 확장을 하며 저비용으로 업데이트한다.

-

Spaces: 격리된 과제 영역 환경으로 에이전트가 요금을 지불하고 승패에 따라 보상을 받는다.

-

AI Judges: RLAIF 기반 실시간 보상 계층으로 확장 가능하고 탈중앙화된 평가를 제공한다.

-

Proof-of-Learning: 전략 업데이트를 특정 경쟁 결과와 연결하여 훈련 과정의 검증 가능성과 부정행위 방지를 보장한다.

Fraction AI의 본질은 "인간-기계 협업 진화 엔진"을 구축하는 것이다. 사용자는 전략 계층의 "메타 최적화자(Meta-optimizer)"로서 프롬프트 엔지니어링(Prompt Engineering)과 하이퍼파라미터 설정을 통해 탐색 방향을 유도하며, 에이전트는 미시적 경쟁에서 자동으로 대량의 고품질 선호 데이터 쌍(Preference Pairs)을 생성한다. 이 모델은 데이터 라벨링을 "신뢰 불필요한 미세조정(Trustless Fine-tuning)"을 통해 상업적 폐쇄 루프를 실현한다.

강화학습 Web3 프로젝트 아키텍처 비교

결론 및 전망: 강화학습 × Web3의 경로와 기회

위 선도 프로젝트들의 분석을 바탕으로 우리는 다음과 같은 점을 관찰한다: 각 팀의 접근점(알고리즘, 엔지니어링, 시장)이 다르더라도 강화학습(RL)과 Web3가 결합할 때, 그 하위 아키텍처 논리는 높은 수준의 일관성을 갖춘 "분리-검증-인센티브" 패러다임으로 수렴한다는 것이다. 이는 단순한 기술적 우연이 아니라 탈중앙화 네트워크가 강화학습의 독특한 속성에 적응하는 필연적 결과이다.

강화학습 일반 아키텍처 특징: 핵심 물리적 제약과 신뢰 문제 해결

-

추론-훈련 물리적 분리 (Decoupling of Rollouts & Learning) — 기본 계산 토폴로지

통신이 드물고 병렬화 가능한 Rollout은 전 세계 소비자급 GPU에 아웃소싱되고, 고대역폭 파라미터 업데이트는 소수의 훈련 노드에 집중된다. Prime Intellect의 비동기 Actor–Learner에서부터 Gradient Echo의 이중 군집 아키텍처까지 모두 이에 해당한다.

-

검증 기반 신뢰 계층 (Verification-Driven Trust) — 인프라화

허가 없는 네트워크에서 계산 진실성은 수학과 메커니즘 설계를 통해 강제 보장되어야 하며, 대표적 사례로 Gensyn의 PoL, Prime Intellect의 TOPLOC, Grail의 암호학적 검증이 있다.

-

토큰화된 인센티브 폐쇄 루프 (Tokenized Incentive Loop) — 시장 자가 조절

컴퓨팅 공급, 데이터 생성, 검증 순위, 보상 분배가 폐쇄 루프를 형성하며, 보상으로 참여를 유도하고 Slash로 부정행위를 억제하여 개방 환경에서도 네트워크가 안정적이고 지속적으로 진화할 수 있도록 한다.

차별화된 기술 경로: 일관된 아키텍처 아래의 서로 다른 "돌파 포인트"

아키텍처가 유사하더라도 각 프로젝트는 자체 유전자에 따라 다른 기술적 경쟁력을 선택한다:

-

알고리즘 돌파파(Nous Research): 분산 훈련의 근본적 모순(대역폭 병목)을 수학적 기반에서 해결하려 한다. DisTrO 최적화기는 그래디언트 통신량을 수천 배 압축하는 것을 목표로 하여 가정용 인터넷 대역폭에서도 대규모 모델 훈련이 가능하게 하며, 이는 물리적 제약에 대한 "차원 감소 공격"이다.

-

시스템 엔지니어링파(Prime Intellect, Gensyn, Gradient): 차세대 "AI 런타임 시스템" 구축에 집중한다. Prime Intellect의 ShardCast와 Gradient의 Parallax는 기존 네트워크 조건에서 극한의 엔지니어링 수단을 통해 최고의 이종 클러스터 효율을 끌어내는 것이다.

-

시장 게임파(Bittensor, Fraction AI): 보상 함수(Reward Function) 설계에 집중한다. 정교한 평가 메커니즘을 설계하여 채굴자가 자발적으로 최적 전략을 찾도록 유도하여 지능 출현을 가속화한다.

장점, 도전 과제 및 종국 전망

강화학습과 Web3의 결합 패러다임 하에서 시스템 수준의 장점은 먼저 비용 구조와 거버넌스 구조의 재편에서 나타난다.

-

비용 재구성: RL 후속 훈련(Post-training)은 샘플링(Rollout) 수요가 무한하며, Web3는 전 세계 장꼬리 컴퓨팅을 극히 낮은 비용으로 동원할 수 있어 중심화 클라우드 업체와 비교할 수 없는 비용 장점을 갖는다.

-

주권 정렬(Sovereign Alignment): 대기업이 AI 가치관(Alignment)을 독점하는 것을 깨고 커뮤니티가 토큰 투표를 통해 모델이 "좋은 답변이란 무엇인가"를 결정할 수 있어 AI 거버넌스의 민주화를 실현한다.

동시에 이 시스템은 두 가지 구조적 제약에도 직면한다.

-

대역폭 벽(Bandwidth Wall): DisTrO 등의 혁신이 있음에도 물리적 지연은 초대규모 모델(70B+)의 전체 훈련을 제한하며 현재 Web3 AI는 미세조정과 추론에 국한되는 경우가 많다.

-

구드해르트의 법칙(Goodhart's Law): 고도로 인센티브화된 네트워크에서 채굴자는 쉽게 "과적합"되어 보상 규칙(점수 획득)에 몰두할 수 있지만 실제 지능 향상은 이루어지지 않는다. 부정행위를 방지하는 견고한 보상 함수 설계는 영원한 게임이다.

-

악의적 비잔틴 노드 공격(BYZANTINE worker): 훈련 신호를 능동적으로 조작하거나 오염시켜 모델 수렴을 파괴하는 것. 핵심은 지속적으로 부정행위 방지 보상 함수를 설계하는 것이 아니라 대항적 견고성을 갖춘 메커니즘을 구축하는 것이다.

강화학습과 Web3의 결합은 본질적으로 "지능이 어떻게 생산되고, 정렬되며, 가치가 분배되는가"라는 메커니즘을 다시 쓰는 것이다. 그 진화 경로는 세

TechFlow 공식 커뮤니티에 오신 것을 환영합니다

Telegram 구독 그룹:https://t.me/TechFlowDaily

트위터 공식 계정:https://x.com/TechFlowPost

트위터 영어 계정:https://x.com/BlockFlow_News