騰訊 AI「상륙전」

저자: 연연

지난 1년간 AI 산업의 격렬한 진화 속에서 "대규모 모델(large model)"은 거의 모든 논의의 중심이 되었다. 파라미터 규모, 추론 속도부터 다중모달(multimodal) 능력에 이르기까지 기술 지표들은 끊임없이 갱신되고 있다. 하지만 냉정한 시각으로 돌아보면 대규모 모델의 진정한 경쟁은 이미 '누구의 모델이 더 크고 강한가'를 넘어서 있다. 2025년이라는 시점에서 승패를 결정하는 핵심은 가치 있는 모델 기능을 지속적으로 구축할 수 있는가, 복잡한 사용자 시나리오를 진정으로 이해할 수 있는가, 그리고 이러한 능력을 궁극적으로 '사용하기 좋은' 제품으로 전환할 수 있는가에 달려 있다.

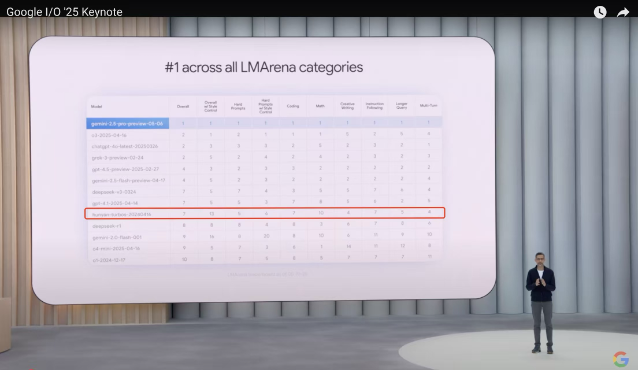

인터넷 업계에서 '제품 만들기'라고 하면 많은 사람들이 먼저 텐센트를 떠올린다. 그러나 이번 AI 대규모 모델 물결 속에서 텐센트는 오랫동안 매우 '조용한' 태도를 보였다. 심지어 많은 사람들은 구글 I/O 개발자 회의를 통해야만 텐센트 혼위안(Hunyuan)이 이미 글로벌 모델 1군에 들어섰다는 사실을 알게 되었다. 5월 열린 이번 회의에서 구글 CEO 순다르 피차이(Sundar Pichai)는 Chatbot Arena 순위표를 인용하며 우연히 텐센트의 혼위안 대규모 모델을 언급했다. 즉, 세계 7위, 중국 내 2위로 딥시크(DeepSeek)에 이어 뒤처진다는 것이다.

텐센트 AI의 놀라운 순간은 올해 초였다. 딥시크가 돌풍을 일으킨 후, 텐센트는 예외적으로 첫 번째로 공개적으로 신속하게 연결했으며, 자사의 AI 네이티브 애플리케이션 '위안바오(Yuanbao)'는 '매일 업데이트'라는 빈도로 고속 반복하면서 단 2~3개월 만에 일일 활성 사용자(DAU)가 국내 최상위 수준으로 급상승하였다. 이전의 '여유로운' 상태와는 전혀 다른 모습이었다. 텐센트 AI의 '빠름과 느림' 사이에는 도대체 어떤 판을 두고 있는 것일까?

5월 21일, 텐센트 클라우드 AI 산업 응용 정상회의에서 텐센트 그룹 고위 집행 부사장이자 클라우드 및 스마트 산업 사업부문 CEO 탕다오선(Tang Daosheng)은 텐센트의 AI 발전 방향을 한 문장으로 요약했다. "AI를 누구나 사용할 수 있게 하고, 가치를 쉽게 접할 수 있도록 한다." 이 문장 뒤에는 텐센트가 AI 분야에서 갖는 전체적인 마인드셋이 담겨 있다. 즉, '누가 최초로 AGI를 제안했는가'에 집착하지 않으며, '뜨거운 용어와 새로운 개념을 만들어내는 것'을 추구하지 않고, 구조가 완전하고 지속적으로 진화하며 체험이 탄탄한 AI 역량 체계를 구축하는 데 주력한다는 것이다.

이 체계의 핵심은 특정 지표에서의 '단독 경쟁'이 아니라 '모델과 제품의 공동 진화'에 있다. 텐센트는 모델의 중요성을 부정하지 않으며, 오히려 항상 모델이 전체 AI 역량의 기반이라고 강조한다. 올해 4월에도 텐센트는 공식적으로 '대규모 언어 모델 부서'와 '다중모달 모델 부서'를 설립하여 자체 개발 모델 역량을 더욱 체계적으로 강화했다. 이는 텐센트가 기초 기술 측면에서도 여전히 '작은 단계로 빠르게 달리며 빠르게 반복'하는 장기주의 논리를 따르고 있음을 보여준다.

텐센트의 장점은 모델 자체에만 국한되지 않고, 기술 역량을 어떻게 장기간 축적하여 궁극적으로 사용자가 실제로 사용할 수 있고 지속적으로 가치를 창출하는 도구로 실현하느냐에 있다. 이 배경에는 기술적인 인내심과 제품 관점에서 본 현실주의가 드러나 있다.

01 텐센트 AI 전략의 핵심: '최대'를 쫓지 않고 '사용하기 좋은' 것을 만든다

딥시크 R1이 등장하기 전, 국내 대형 기업들의 대규모 모델 포지셔닝 전략은 대규모 모델, 대규모 파라미터, 그리고 'AI 폐쇄순환(closed loop)'—즉 모델부터 도구, 응용 시나리오까지 전 과정을 자급자족하는 것이 주류 사고방식이었다.

이에 비해 텐센트의 전략은 더욱 실용적이다. 파라미터 규모 경쟁에 일방적으로 몰두하기보다는 대규모 모델 역량을 실제 접속 가능하고, 서비스 제공 가능하며, 지속 가능한 제품 형태로 전환하는 방법에 중점을 둔다. 올해 초 위안바오의 급속한 반등부터 최근 다시 '텐센트 각 사업이 전면적으로 AI를 수용한다'고 선언한 것까지 텐센트가 제품 개발에 매달리는 결심을 엿볼 수 있다. 이제 '사용하기 좋은' AI 제품을 만드는 것은 점차 전 산업의 공감대가 되고 있다.

탕다오선看来,这种转变来自 DeepSeek 给行业带来的「里程碑式」的改变,一种从「量」到「质」的变化——「用户在实际使用过程中,切实感受到了 AI 的『可用性』在进一步提升,AI 正在跨过产业化落地的门槛,站在普及应用的全新节点上。」

在最近的腾讯云 AI 产业应用峰会上,他又进一步指出,生成式 AI 接下来要从「可用」到「好用」。而这种「跃迁」,还需要在大模型、智能体、知识库与基础设施四个层面,完成新一轮的「加速」。

腾讯集团高级执行副总裁、云与智慧产业事业群 CEO 汤道生丨来自:腾讯云

具体来看,模型能力的持续优化,可以带来更强的性能、更好的交互体验;智能体能够基于模型,自主思考、决策和执行任务;知识库系统则有助于减少幻觉、增强上下文理解,使模型「更懂企业、更懂用户」;而底层基础设施的持续迭代,则显著降低了训练和推理成本,提升了系统响应速度。腾讯的这套结构,背后是其在产品化和服务化过程中对「可用性」理解的持续积累。

这种「以用促建」的思路,在腾讯自研大模型「混元」家族的演进中,也体现得尤为清晰。自 2023 年首次发布以来,混元不断迭代,技术能力不断提升:今年以来相继推出快思考模型 Turbo S 和深度思考模型 T1,均在公开基准测试中达到业界领先水平。

除语言模型外,腾讯也持续加码对多模态能力的投入,推进涵盖图像、视频和 3D 生成,以及图像理解、端到端语音模型等多类模型的研发,目的是为更广泛的商业场景,提供全面的 AI 支撑。这种能力体系的不断扩展,丰富了模型支持的交互方式,也帮助应用显著降低了用户的使用门槛。

除了自研体系的持续深化,腾讯也坚持以「好用」为目标,积极吸纳外部优质模型能力,以实现更优组合。这一策略最早可以在「腾讯元宝」这款通用 AI 助手中窥见端倪。元宝采用混元与 DeepSeek 的双引擎架构,是国内最早接入 DeepSeek 模型的大厂产品之一。这一架构是腾讯在性能对比、场景匹配和用户需求之间,所做出的策略性融合选择。

自上线以来,腾讯元宝保持高频迭代,陆续集成了微信文件、公众号内容、语音输入、文档处理等功能,并支持联网搜索、图像理解等能力。表面看是细节的打磨,实则构成了产品体验稳定性与可持续性的基础支点。腾讯在财报中披露,自 2 月 13 日以来,元宝的 DAU 在一个月内增长超过 20 倍。

这不是某个模型参数上的胜利,而是一种「以交付为目标」的系统能力体现。

腾讯也持续在多个自有场景中验证这一体系的有效性:腾讯会议的 AI 助手可基于实时与历史内容生成会议摘要和建议;腾讯云代码助手 CodeBuddy 已覆盖公司超过 85% 的开发员工,显著提升开发效率,整体编码时间缩短逾 40%;腾讯健康推出的 AI 健康助手,则能自动解读体检报告,生成个性化的复诊建议。

可以说,腾讯的 AI 战略从来不只是打造一个「最聪明的大脑」,而是始终致力于构建一个「真正能派上用场的助手」。

02 从「能用」到「好用」:打造一整套可交付的 AI 体系

实现从「能用」到「好用」,靠的不是某个环节的爆发,而是一整套技术栈背后的能力积累。

腾讯并没有试图用参数量来定义 AI 能力的边界,而是从底层架构到最终体验,系统性地搭建了一条「可交付」的路径。这背后,是一整套高度协同的技术能力体系:涵盖多模态交互、推理优化、知识增强(RAG)、多源数据支撑、高并发处理、云安全机制、敏捷开发方法、用户洞察机制,以及面向合作伙伴的开放生态。

高质量的内容和数据,是大模型可用的核心要素。在大模型能力趋同的状况下,也将是未来 AI 产品力竞争的核心领域,这也恰恰是腾讯最能发挥独特优势的地方。

腾讯有丰富的内容资源,例如图文方面的公众号、腾讯新闻、微信读书;视频领域的视频号和腾讯视频;还有专业领域的腾讯医典这样的权威医学科普。这些内容数据,可以作为模型调取的优质信源,帮助生成高质量的回答。腾讯元宝正是凭借微信公众号的内容源,加上强大的「联网搜索」能力,确保了检索和生成结果的质量和时效性。根据 SuperCLUE 报告测评,在 10 家接入 DeepSeek-R1 的平台中,元宝的联网搜索能力最强,在总分、基础检索能力和分析推理能力三项核心指标上,均排名第一。

优质内容生态,也对国内很多的模型厂商、内容和硬件厂商构成了巨大的吸引。比如 OPPO 手机、小米智能音响等,这些产品的音乐问答模块中,都在尝试接入结合了 QQ 音乐等资源的模型能力,满足用户的音乐需求。

多模态能力一度被视为通向 AGI 的必由之路,如今已成为产品化竞争的重要分水岭。也是腾讯厚积薄发,势必要拿下的关键战场。

腾讯从早年的优图、天籁实验室开始,就在图像、音视频等领域,积累了丰富的专利技术,今天大家用到的腾讯会议,就是腾讯多媒体技术的集大成者。AI 时代,腾讯则持续增强多模态能力优势。5 月 21 日,腾讯宣布了一系列的多模态模型上新,混元 Image 2.0,率先实现了商用级实时生图;视觉深度推理模型 T1-Vision,支持多图输入,具备原生长思维链,轻松实现「边看图边思考」;混元 3D 凭借业界首创的稀疏 3D 原生架构,实现了可控性与超高清生成能力的代际飞跃;端到端语音通话模型混元 Voice,实现低延迟语音通话,拟人性和情绪应用能力也有明显提升。

汤道生曾多次表达过对多模态的重视。他认为,现实世界是一个由多维信息构成的复杂系统。「未来,AI 要像人一样具备视觉和听觉,才能立体且完善地理解世界;在文字之外,还应该通过语气、动作,完整而真实地传递信息。」

从这个角度看,发展多模态模型不只是技术拓展,更是体验的重构。通过将图像、语音、视频、文本等形态的内容输入和输出纳入统一模型能力,用户可以用更简单的方式与 AI 交互,并得到更丰富的结果,从而显著降低使用门槛。这种交互方式使 AI 不再只是「极客的玩具」,而是真正向更广泛用户普及。

模型除了要低门槛、强交互,落地更重要的是要准确和靠谱。汤道生之前也说,「企业所需要的是,在实际场景中真正解决了某个问题,而不是在 100 个场景中,每个都只做到了 80%。」

在「让 AI 更靠谱」这一层面,RAG(检索增强生成)技术,被广泛认为是短期内提升模型准确性和上下文理解力的有效路径。而腾讯也是最早提出并拥抱「大模型+RAG」的云厂商之一。腾讯依托其文档解析、向量化等方面的长期积累,构建出一套结构化的知识增强能力,能够将企业的私有知识库与通用模型无缝融合,有效降低幻觉率,提高业务理解深度。这也为企业客户构建定制化 AI 助手提供了底层保障。

腾讯的这套 RAG 能力,同样源自过去多年的技术累积和海量应用实践。早在 2019 年,腾讯就将向量数据的检索处理能力,用在了腾讯视频、QQ 浏览器、QQ 音乐等 40 多个内部业务场景,每天处理超过 1600 亿次请求。在向量检索的帮助下,QQ 浏览器的检索成本降低了 37.9%,QQ 音乐人均听歌时长、腾讯视频有效曝光人均时长,都有了明显的提升。

为了支撑流畅的「前台体验」,背后的基础设施能力是决定规模化落地的隐性门槛。比如 AI 模型的训练与推理,对算力资源调度、数据流通效率与系统响应能力,提出了极高要求,腾讯通过构建包括腾讯云 TI 平台、高性能 HCC 集群、GooseFS 高速存储、星脉网络等在内的软硬一体化基础设施,大幅提升了训练效率与推理性能,显著降低响应延迟与成本。

而 AI 系统一旦进入真实业务场景,数据隐私、权限管控、可追溯性等问题将成为客户最关心的底层风险。腾讯也借助其服务亿级用户所积累的系统调度与安全能力,构建起涵盖身份认证、数据隔离、权限分级、加密传输等模块的完整安全体系。相比一些只专注算法性能的新兴玩家,这种「老业务带来的系统经验」成为腾讯 AI 能够深入复杂行业场景的底层壁垒。

所以说,腾讯 AI 能力体系的核心逻辑,并不只是追求模型本身的「最强」,更要让模型真正「能被交付」。从能用的技术能力,到可用的系统能力,再到好用的产品体验,推动前沿 AI 能力向普适工具转化。这也是为什么,当 DeepSeek 出现时,腾讯能成为第一批完成集成、快速上线、稳定运营的大型公司之一——不是因为它跑得最快,而是因为它一直在为「跑得更久」而准备。

03 从自用到共建:腾讯云如何推动 AI 在 B 端落地

腾讯在 AI 领域的打法,并不是「闭门造车」,而是始终坚持在自有场景中沉淀能力,在实际验证中拓展市场。真正支撑其走进 ToB 市场的关键,不是单点模型能力的突破,而是一整套「可交付」的体系构建:不仅能把 AI「做出来」,更能把 AI「做成服务」,并稳定、便捷地交付给客户。

这次腾讯云的 AI 应用峰会上,新升级的智能体开发平台,以及知识库产品,受到企业和开发者的关注。这些工具的出现,极大地降低了 AI 部署的门槛,提升了应用的覆盖面。

在全行业都很关注 AI 智能体的当下,腾讯云新升级的「智能体开发平台」,给企业提供了多种构建智能体的模式和配套工具,首次实现了零代码支持多 Agent 的转交协同方式,大幅降低了智能体搭建的门槛。同时,平台还构建了完备的 Agent 工具体系,支持 MCP 协议、兼容 OpenAI Agents SDK 的关键定义,帮助 Agent 更好地调用工具、拓展服务。

企业知识库的搭建,也是企业落地 AI 的「刚需」配置。腾讯乐享企业 AI 知识库,能够打破部门与层级壁垒,对知识的有效性、更新时间、权限进行管控,同时支持多人协作、知识共创,不仅加速了企业内部知识的流动,也让 AI 能够更好地管理和应用企业知识,生产出更高质量的内容。

除此之外,模型应用的普及,对算力的需求也从训练转向推理。规模化推理的成本优化,成为云厂商的核心竞争力。腾讯云也通过 IaaS 层与工具层协同优化,提升了模型在推理场景下的响应速度、延时和性价比。

汤道生在最近的演讲中,专门提到了他们帮助荣耀手机高效部署 DeepSeek 的成功用例。荣耀手机希望接入 DeepSeek-R1 服务,但随着手机里的 AI 功能越来越多,大模型调用频繁、并发量很高,模型回复的高延迟,会严重影响用户体验。腾讯云基于自身的加速能力,帮助荣耀部署了 DeepSeek-R1 满血版服务,使得模型推理吞吐最高提效 54%,大幅提升推理速度,也让模型运行更快更稳,系统调度更顺畅。

腾讯的 ToB 能力并不止于基础设施支撑,更体现在其对行业与场景的深度理解。

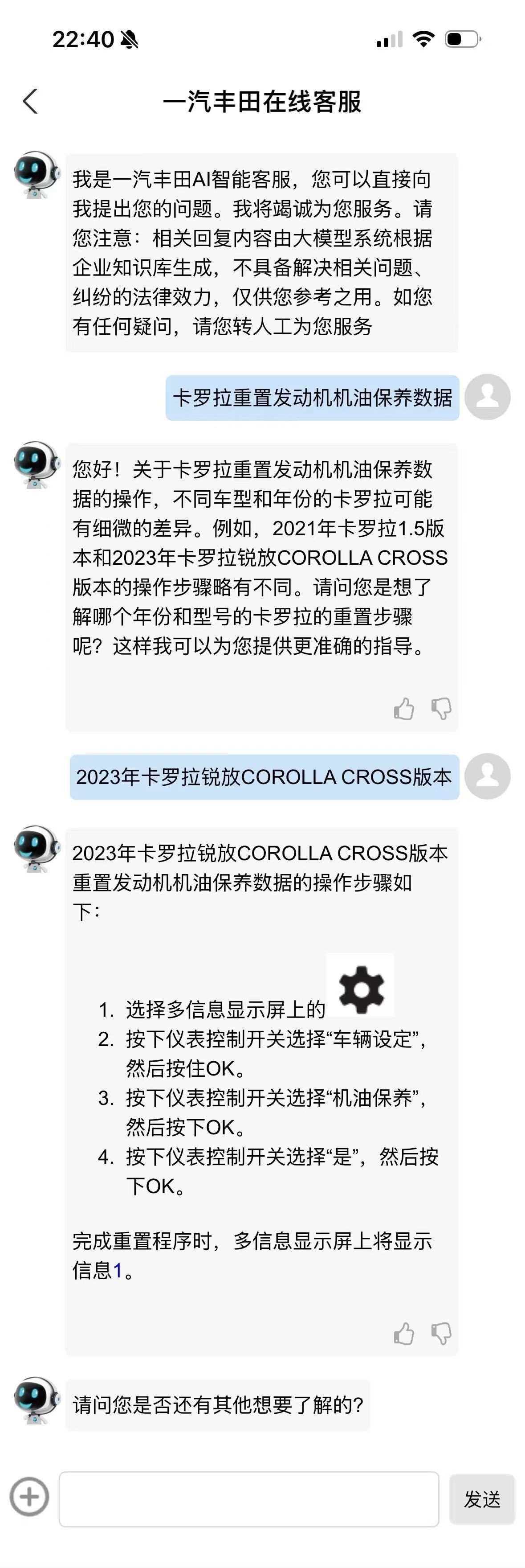

以汽车行业为例,一汽丰田在客服系统中引入腾讯云智能体开发平台,着手系统性解决传统智能客服「答不准、答不全、答不快」的行业共性难题。在此前,企业在部署大模型时常面临专属知识调取难、生成内容宽泛等技术瓶颈,导致 AI 难以真正落地。腾讯云以自研的大模型为基础,结合 RAG、自研长文本 Embedding 能력和 OCR、多模态等组件,帮助一汽丰田结合自身专属客服知识,构建起涵盖官网、App、小程序、公众号等全渠道的一体化智能客服体系。

一汽丰田智能在线客服机器人对话丨来自:腾讯云

今年 1 月该系统上线后,智能客服独立解决率从原本的 37% 提升至 84%,月均自动解答用户问题超过 1.7 万次,有效缓解人工客服压力,提升客户满意度。更重要的是,一汽丰田还借助腾讯云工具,从历史客服问答中提炼结构化知识,扩充企业专业知识库,为客服系统长期稳定运营打下基础。

作为一家年销量近百万、服务触点遍布全国的汽车企业,一汽丰田的这次升级不仅是一项技术改造,更标志着「AI 从实验走向生产」。它用切实可感的结果,验证了腾讯云 AI 的「可交付能力」——从模型融合、系统接入到知识调度与体验闭环,每一步都可衡量、可部署、可迭代,真正实现了技术价值与业务价值的统一。

这背后反映出的,不是 AI 在某个行业的「试验性应用」,而是腾讯正在通过工具平台화、知识 구조화、 상호작용 자연화의 경로를 통해 AI를 진정한 '제공 가능하고, 진화 가능하며, 협업 가능한' 새로운 생산력으로 전환하고 있다는 점이다.

AI 산업이 점차 '실용기'에 접어들면서, 일부 '기술 광환'으로 주목받던 플레이어들이 냉각기에 접어들고 있는 반면, 텐센트처럼 역량 축적과 시스템 서비스에 장기간 투자해온 기업은 점차 구조적 우위를 나타내고 있다.

텐센트가 딥시크의 기회를 신속하게 잡아 안정적으로 ToB 시장 확장을 추진할 수 있었던 것은 특정 모델 호황이나 우연한 전략 때문이 아니라, '모델을 잘 사용하고, 안정적으로 운영하며, 가치를 창출하는 방법'에 대한 체계적인 이해 덕분이다.

그들의 전략은 특정 '핵심 알고리즘'에 의존하지도, '전략 슬로건' 하나로 입지를 세우지도 않는다. 오늘날 텐센트 AI를 이끌고 있는 것은 사용자 요구에 대한 지속적인 이해, 시스템 역량에 대한 장기적인 다듬기, 그리고 시나리오 적용 로직에 대한 존중이다.

이것이 바로 텐센트가 AI 시대에 진정으로 구축한 장기적인 성역일 것이다.

TechFlow 공식 커뮤니티에 오신 것을 환영합니다

Telegram 구독 그룹:https://t.me/TechFlowDaily

트위터 공식 계정:https://x.com/TechFlowPost

트위터 영어 계정:https://x.com/BlockFlow_News