양직린과 양원펑, 논문이 겹쳤다

일

머스크가 20만 개의 카드로 훈련한 Grok3를 공개한 바로 그날, 기술 커뮤니티에는 머스크식 '힘으로 기적을 만든다'는 접근과 정반대 방향의 두 편의 논문이 발표되었다.

이 두 논문의 저자 명단 속에는 모두 익숙한 이름 하나씩이 자리하고 있었다:

량원펑, 양지린.

2월 18일, DeepSeek와 월之암면(月之暗面)은 거의 동시에 각각의 최신 논문을 발표하였으며, 주제가 정확히 충돌하였다—즉, 둘 다 트랜스포머 아키텍처의 핵심인 어텐션 메커니즘을 도전하며, 이를 통해 더 긴 문맥을 더욱 효율적으로 처리하려는 시도였다. 더욱 흥미로운 점은 두 회사의 기술 중심 창립자의 이름이 각각의 논문 및 기술 보고서에 등장했다는 것이다.

DeepSeek가 발표한 논문의 제목은 《Native Sparse Attention: Hardware-Aligned and Natively Trainable Sparse Attention》이다.

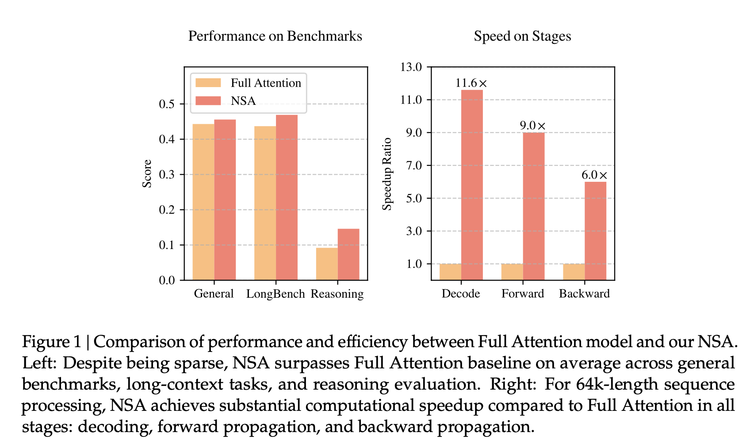

논문에 따르면, 이들이 제안한 새로운 아키텍처 NSA(네이티브 스파스 어텐션)는 벤치마크 테스트에서 전역 어텐션 메커니즘과 동등하거나 더 높은 정확도를 달성했으며, 64K 토큰 시퀀스 처리 시 최대 11.6배의 속도 향상을 보였고, 훈련 또한 더욱 효율적이며 계산 자원 소모가 적었다. 장문의 문맥 작업(예: 책 요약, 코드 생성, 추론 작업)에서도 뛰어난 성능을 보였다.

기존의 알고리즘적인 혁신보다 주목받았던 것들과 비교해볼 때, 이번 DeepSeek는 가장 핵심인 어텐션 메커니즘 자체의 개조에 손을 댔다.

오늘날 모든 대규모 모델 번영의 기반이 되는 것이 트랜스포머이지만, 그 핵심 알고리즘인 어텐션 메커니즘은 여전히 고질적인 문제가 있다. 독서에 비유하자면, 기존의 '전역 어텐션 메커니즘'은 이해 및 생성을 위해 텍스트 내 모든 단어를 읽고, 다른 모든 단어들과 비교한다. 이로 인해 처리하는 텍스트가 길어질수록 복잡도가 증가하여 기술적으로 한계에 부딪히거나 심지어 작동이 중단될 수 있다.

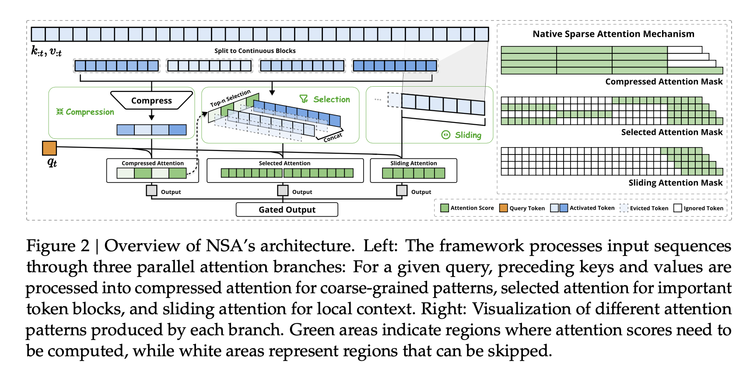

학계는 이러한 문제 해결을 위한 다양한 아이디어를 지속적으로 제시해 왔으며, NSA는 실제 환경에서의 엔지니어링 최적화와 실험을 통해 훈련 단계에서도 사용 가능한 세 가지 구성 요소로 이루어진 아키텍처를 제안하였다:

첫째, 의미 압축(Semantic Compression)—모든 단어를 일일이 보는 대신, 이를 '블록(block)'이라 불리는 그룹 단위로 나누어, 전체 의미를 유지하면서 시퀀스 길이를 1/k로 줄이며 위치 인코딩을 도입하여 정보 손실을 최소화함으로써 계산 복잡도를 O(n²)에서 O(n²/k)로 낮춘다.

둘째, 동적 선택(Dynamic Selection)—모델이 특정 스코어 기반 메커니즘을 이용해 텍스트 내 가장 주목해야 할 단어들을 선별하고, 이들에 대해 미세한 수준의 계산을 수행한다. 이 중요성 샘플링 전략은 계산량을 75% 감소시키면서도 미세 정보의 98%를 유지할 수 있다.

셋째, 슬라이딩 윈도우(Sliding Window)—앞의 두 과정이 요약과 하이라이트라면, 슬라이딩 윈도우는 최근 문맥 정보를 확인함으로써 연속성을 유지하며, 하드웨어 수준의 메모리 재사용 기술을 통해 메모리 접근 빈도를 40% 줄일 수 있다.

이러한 아이디어들은 각각 DeepSeek가 처음 고안한 것은 아니지만, ASML의 작업에 비유할 수 있다—이 기술 요소들은 이미 존재하여 여기저기에 흩어져 있었으나, 엔지니어링적으로 결합하여 규모화 가능한 솔루션으로 만들고, 새로운 알고리즘 아키텍처를 구현한 것은 전례가 없다. 이제 강력한 엔지니어링 능력을 가진 누군가가 산업 현장에서 모델을 훈련하는 데 쓸 수 있는 한 대의 '광각기(光刻机)'를 만들어낸 것이다.

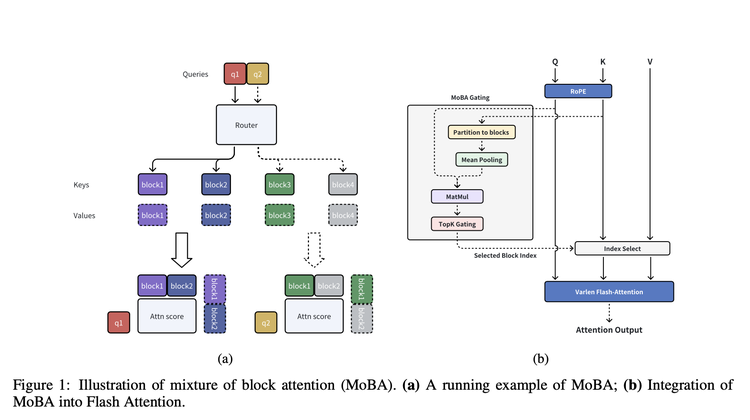

같은 날 월之암면이 발표한 논문은 핵심 사상 면에서 매우 유사한 아키텍처 MoBA(MoBA: MIXTURE OF BLOCK ATTENTION FOR LONG-CONTEXT LLMS)를 제안했다.

이름에서 알 수 있듯이, MoBA 역시 '단어'를 '블록' 단위로 묶는 방법을 사용한다. '블록화' 이후, MoBA에는 '지능형 필터' 역할을 하는 게이팅 네트워크가 있어, 각 블록과 가장 관련성이 높은 상위 K개의 블록만을 선별하여, 이들에 대해서만 어텐션 계산을 수행한다. 실제 구현 과정에서 MoBA는 어텐션 계산을 더욱 효율화하는 FlashAttention과 전문가 혼합 모델(MoE)의 최적화 기법도 함께 적용하였다.

NSA와 비교해 MoBA는 유연성을 더욱 강조하며, 현재 가장 주류인 전역 어텐션 메커니즘을 완전히 버리지 않고, 전역 어텐션과 스파스 어텐션 사이를 자유롭게 전환할 수 있는 방식을 설계하여 기존의 전역 어텐션 모델에 더 많은 호환성을 제공한다.

논문에 따르면, MoBA는 문맥 길이가 증가함에 따라 계산 복잡도 측면에서 뚜렷한 우위를 보인다. 1M 토큰 테스트에서 MoBA는 전역 어텐션보다 6.5배 빠르며, 10M 토큰에서는 무려 16배 빨라진다. 또한 이미 Kimi 제품에 적용되어 사용자들의 장문 문맥 처리 요구를 해결하고 있다.

양지린이 월之암면을 창업했을 당시 주목받은 중요한 이유 중 하나는 그의 논문 영향력과 인용 수였지만, K1.5 논문 이전 마지막 연구 논문은 2024년 1월까지 거슬러 올라간다. 반면 양원펑은 DeepSeek의 가장 중요한 모델 기술 보고서에 저자로 등재되기는 했지만, 이 보고서들의 저자 명단은 사실상 DeepSeek 직원 명단과 거의 동일하여 거의 모든 직원이 포함된다. 그러나 NSA 논문의 저자는 극소수에 불과하다. 이로부터 두 회사의 창립자에게 이 두 연구가 갖는 중요성과 두 회사의 기술 로드맵을 이해하는 데 가지는 의미를 짐작할 수 있다.

이러한 중요성을 뒷받침하는 또 다른 흥미로운 사실은, 일부 네티즌이 arXiv에서 NSA 논문의 제출 기록을 확인한 결과, 2월 16일 제출되었으며 제출자가 바로 양원펑本人이라는 점이었다.

이

이번이 월之암면과 DeepSeek가 처음으로 '충돌'한 것은 아니다. R1을 발표한 동시에, Kimi는 드물게 K1.5 기술 보고서를 공개했는데, 그동안 이 회사는 기술적 고민을 외부에 우선적으로 공유하는 것을 중점에 두지 않았다. 당시 두 논문 모두 RL 기반 추론 모델 개발을 목표로 삼았다. 실제로 두 기술 보고서를 꼼꼼히 읽어보면, K1.5 논문에서 월之암면은 추론 모델 훈련 방법에 대해 더 자세한 내용을 공유했으며, 정보량과 디테일 면에서 오히려 R1 논문보다 앞선다. 하지만 이후 DeepSeek의 열풍이 이 논문 자체에 대한 논의를 상당 부분 덮어버렸다.

이를 입증하는 예로, OpenAI가 최근 드물게 o시리즈 모델의 추론 능력에 관한 논문을 발표하며 DeepSeek R1과 Kimi k1.5를 동시에 언급했다. "DeepSeek-R1과 Kimi k1.5는 독자적인 연구를 통해 사고의 사슬(COT) 학습 방법을 활용하면 수학 문제 해결 및 프로그래밍 과제에서 모델의 종합적 성능을 크게 향상시킬 수 있음을 보여주었다." 즉, OpenAI가 스스로 비교 대상으로 삼은 두 추론 모델인 것이다.

"대규모 모델 아키텍처의 가장 신비로운 점은 마치 스스로 앞으로 나아갈 방향을 제시하는 것 같다는 느낌입니다. 서로 다른 사람들이 다양한 각도에서 비슷한 진보 방향에 도달하게 되죠."

MoBA 핵심 연구에 참여한 칭화대학 교수 장명성(章明星)이 저장소(知乎)에 글을 올렸다.

그는 또 흥미로운 비교를 제시했다.

"DeepSeek R1과 Kimi K1.5 모두 ORM 기반 RL을 지향하지만, R1은 제로에서 시작하여 더욱 '순수'하거나 'less structure'에 가까우며, 출시 시기도 더 빠르고 모델을 동시에 오픈소스로 공개했습니다.

Kimi MoBA와 DeepSeek NSA는 다시 한번 역전파가 가능한 learned sparse attention을 지향합니다. 이번엔 MoBA가 더욱 less structure에 가깝고, 출시 시기도 더 빠르며 코드를 동시에 오픈소스로 공개했습니다."

두 회사의 연이은 '충돌'은 강화학습 기술 발전과 더 효율적인 장문 텍스트 어텐션 메커니즘의 진화 방향을 비교하며 더 잘 이해하는 데 도움을 준다.

"R1과 K1.5를 함께 보면 추론 모델의 훈련 방법을 더 잘 배울 수 있듯이, MoBA와 NSA를 함께 보면 우리는 '어텐션 내 sparsity가 존재해야 하며, end-to-end 훈련을 통해 습득 가능하다'는 믿음에 대해 다양한 관점에서 더 깊이 이해할 수 있습니다." 장명성이 글을 남겼다.

삼

MoBA 발표 후 월之암면의 쉬신란(许欣然)은 소셜 미디어를 통해 이 작업이 1년 반간 진행된 것이며, 이제 개발자들이 즉시 사용할 수 있다고 밝혔다.

하지만 지금 이 시점에서 오픈소스를 선택하는 것은 어쩔 수 없이 DeepSeek의 '그림자' 속에서 논의될 수밖에 없다. 흥미로운 점은, 각 기업들이 적극적으로 DeepSeek에 접속하거나 자체 모델을 오픈소스로 공개하는 가운데, 외부에서는 항상 가장 먼저 월之암면을 떠올리며 Kimi의 접속 여부, 모델의 오픈소스 공개 여부에 대한 논의가 계속되고 있으며, 월之암면과 두바오(豆包)는 마치 남은 마지막 두 '이단아'처럼 여겨지고 있다.

현재로서는 DeepSeek가 다른 경쟁자들보다 월之암면에 미치는 영향이 더욱 지속적임을 알 수 있다. 이는 기술 로드맵부터 사용자 유치까지 전방위적인 도전을 의미한다. 첫째, 제품 경쟁 단계에 들어섰더라도 여전히 기본 모델 능력이 가장 중요함을 입증했다. 둘째, 점점 더 명확해지는 또 다른 연쇄 반응은 텐센트의 위챗 검색과 원바오(元宝) 조합이 DeepSeek R1의 기세를 타고 이전에 놓친 마케팅 전투를 보완하고 있다는 점이며, 궁극적으로는 Kimi와 두바오를 겨냥하고 있다.

이에 따른 월之암면의 대응 전략이 주목받고 있다. 그 중 오픈소스는 반드시 밟아야 할 한 걸음이다. 그리고 월之암면의 선택은 마치 DeepSeek의 오픈소스 전략에 진정으로 부합하려는 것처럼 보인다—현재 DeepSeek 이후 등장한 많은 오픈소스들은 대부분 반사적 행동처럼 보이며, 여전히 과거 Llama 시절의 오픈소스 패러다임을 따르고 있다. 사실 DeepSeek의 오픈소스는 이전과 다르다. 더 이상 Llama처럼 폐쇄형 경쟁자를 교란하기 위한 방어적 목적의 오픈소스가 아니라, 명확한 수익을 가져오는 경쟁 전략이 된 것이다.

최근 월之암면 내부에서 'SOTA(state-of-the-art) 결과를 목표로 한다'는 소식이 들려오는데, 이는 바로 그러한 새로운 오픈소스 모델에 가장 근접한 전략으로, 가장 강력한 모델과 가장 강력한 아키텍처 방법을 공개함으로써 오랫동안 갈망해온 애플리케이션 측 영향력을 얻을 수 있을 것이다.

두 회사의 논문에 따르면, MoBA는 이미 월之암면의 모델과 제품에 적용되었으며 NSA도 마찬가지다. NSA는 심지어 외부가 DeepSeek의 차세대 모델에 대해 더 명확한 기대를 갖도록 한다. 따라서 다음 관심사는 월之암면과 DeepSeek가 MoBA와 NSA를 각각 활용해 훈련한 차세대 모델이 또 한 번 충돌할지, 그리고 오픈소스 방식으로 할지 여부일 것이다—이것이 아마도 월之암면이 기다리고 있는 그 시점일 것이다.

TechFlow 공식 커뮤니티에 오신 것을 환영합니다

Telegram 구독 그룹:https://t.me/TechFlowDaily

트위터 공식 계정:https://x.com/TechFlowPost

트위터 영어 계정:https://x.com/BlockFlow_News