아직 공개되지 않았는데, 소라(Sora)가 어떻게 인터넷 업계를 놀라게 했을까?

글: 무무

아직 일반 대중에게 테스트를 개방하지도 않았는데, OpenAI가 텍스트로 영상을 생성하는 모델 Sora로 만든 예고편 하나로 테크 업계와 인터넷, 소셜 미디어 업계를 모두 충격에 빠뜨렸다.

OpenAI가 공식 발표한 영상에 따르면, Sora는 사용자가 제공한 텍스트 정보를 바탕으로 최대 1분 길이의 복잡한 장면을 담은 '초고화질 영상'을 생성할 수 있다. 화면 디테일이 매우 사실적인 것은 물론이고, 카메라 움직임까지 시뮬레이션한다.

현재 공개된 영상 결과만 봐도, 업계가 주목하는 것은 바로 Sora가 현실 세계를 이해하는 능력을 보여주고 있다는 점이다. 다른 텍스트-영상 생성 대규모 모델들과 비교했을 때, Sora는 의미 이해, 화면 표현, 시각적 일관성, 영상 길이 등 여러 면에서 우위를 보인다.

OpenAI는 이를 직접 '세계 시뮬레이터(world simulator)'라고 부르며, 물리 세계 속 사람, 동물, 환경의 특성을 시뮬레이션할 수 있다고 선언했다. 다만 회사는 현재 Sora가 완벽하지 않으며, 여전히 이해 부족과 잠재적인 보안 문제를 안고 있다고 인정하고 있다.

따라서 Sora는 극소수 인원에게만 제한적으로 테스트를 허용하고 있으며, 언제 일반 대중에게 공개될지에 대해서는 아직 알려진 바 없다. 하지만 그 충격은 이미 동종 기술을 개발 중인 기업들에게 명확한 격차를 각인시키기에 충분하다.

Sora '예고편'이 전 세계를 경악시켰다

OpenAI의 텍스트 기반 영상 생성 모델 Sora가 등장하자마자 국내에서도 다시금 '충격 보도'들이 쏟아져 나왔다.

자기매체(셀프미디어)들은 "현실이 사라졌다"며 탄성을 지르고, 인터넷 거물들도 Sora의 능력을 극찬했다. 360 창업자 저우훙이(周鸿祎)는 Sora의 등장으로 AGI(범용 인공지능) 실현이 기존 10년에서 약 2년 정도로 단축될 수 있다고 말했다. 단 이틀 만에 Sora의 구글 검색 지수는 급등해 ChatGPT에 버금가는 관심을 받았다.

Sora의 돌풍은 OpenAI가 공개한 48개의 영상에서 비롯됐다. 이 중 가장 긴 영상은 1분에 달한다. 이는 이전 문생영 모델 Gen2나 Runway의 영상 길이 한계를 뛰어넘는 것이며, 화질도 선명하고 심지어 카메라 언어까지 익혔다.

1분짜리 영상 속, 빨간 드레스를 입은 여성 한 명이 네온사인이 가득한 거리를 걷는다. 리얼한 스타일에 부드러운 화면 전환. 특히 여성의 얼굴 클로즈업 장면은 더욱 놀랍다. 피부의 모공, 반점, 여드름 자국까지 정교하게 재현했고, 메이크업이 들뜬 듯한 효과는 마치 라이브 방송에서 뷰티 필터를 끈 것 같다. 목에 있는 주름까지 나이를 정확히 드러내며 얼굴과 몸 상태를 완벽하게 통합해 보여준다.

인물뿐 아니라 동물과 환경 시뮬레이션도 가능하다. 빅토리아 왕관비둘기의 다각도 클로즈업 영상에서는 새의 머리부터 발끝까지 푸른 깃털을 초고화질로 보여줄 뿐 아니라, 붉은 눈동자의 미세한 움직임과 호흡 주기까지 세밀하게 묘사해, AI 생성인지 실제 촬영인지 분간하기 어렵다.

리얼하지 않은 창의적 애니메이션도 Sora의 생성 결과는 디즈니 애니메이션 영화 수준에 달해, 누리꾼들 사이에선 애니메이터들의 일자리가 위협받을 것이라는 우려도 나오고 있다.

Sora가 텍스트-영상 생성 모델에 가져온 진보는 영상 길이나 화면 효과에만 국한되지 않는다. 카메라 운용과 촬영 궤적, 게임의 1인칭 시점, 항공 촬영, 심지어 영화의 원 컷(one-take) 촬영까지 시뮬레이션할 수 있다.

OpenAI가 공개한 화려한 영상들을 본 후라면, 인터넷과 소셜 미디어 여론이 왜 Sora에 충격을 받았는지 쉽게 이해할 수 있을 것이다. 그런데 이것들조차 '예고편'일 뿐이다.

OpenAI, '비주얼 패치(visual patches)' 데이터셋 제시

그렇다면 Sora는 어떻게 이러한 시뮬레이션 능력을 실현한 것일까?

OpenAI가 발표한 Sora 기술 보고서에 따르면, 이 모델은 기존 이미지 생성 모델의 한계를 넘어서고 있다.

기존 텍스트 기반 시각 콘텐츠 생성 연구는 순환 신경망(RNN), 생성적 적대 신경망(GAN), 자기회귀 트랜스포머, 확산 모델 등을 다양한 방법으로 활용해 왔지만, 공통적으로 시각 데이터 범주가 제한적이거나, 짧은 영상, 혹은 고정 크기 영상에 집중돼 있었다.

Sora는 트랜스포머 기반의 확산 모델을 채택했으며, 이미지를 생성하는 과정을 양방향—즉 정방향(forward)과 역방향(backward) 두 단계로 나누어 시간축을 따라 앞뒤로 영상을 확장할 수 있는 능력을 갖췄다.

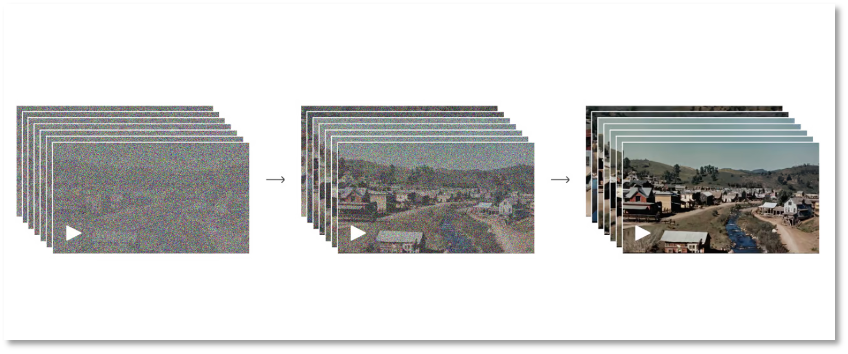

정방향 과정에서는 실제 이미지에서 완전한 노이즈(noise) 이미지로 확산되는 과정을 시뮬레이션한다. 구체적으로는, 모델이 이미지에 점진적으로 노이즈를 추가해 최종적으로 이미지를 완전한 노이즈로 만든다. 반면 역방향 과정은 이의 반대로, 노이즈 이미지에서 점차 원본 이미지를 복원해낸다. 이렇게 양방향으로 허상과 실체를 오가며 OpenAI는 기계가 시각 정보 형성 과정을 이해하도록 했다.

전혀 노이즈 상태에서 선명한 이미지로 변하는 과정

전혀 노이즈 상태에서 선명한 이미지로 변하는 과정

물론 이 과정은 반복적인 학습 훈련을 필요로 하며, 모델은 노이즈를 점차 제거하고 이미지의 디테일을 복원하는 방법을 학습하게 된다. 이러한 양단계 반복을 통해 Sora의 확산 모델은 고품질 이미지를 생성할 수 있다. 이 모델은 이미지 생성, 편집, 초고해상도화 등의 분야에서 뛰어난 성능을 보여왔다.

위 과정은 Sora가 고화질, 초고해상도를 구현할 수 있는 이유를 설명해 준다. 그러나 정적인 이미지에서 동적인 영상으로 나아가기 위해선 모델이 추가로 데이터를 축적하고 학습해야 한다.

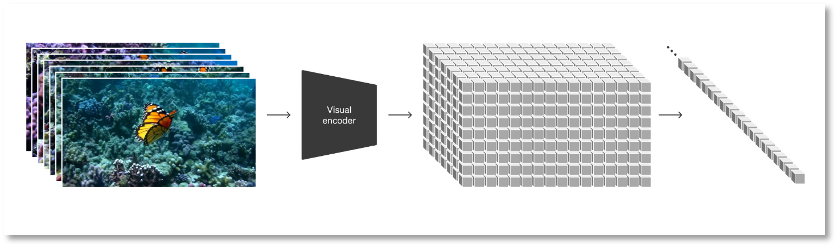

확산 모델을 기반으로 OpenAI는 영상과 이미지 등 모든 유형의 시각 데이터를 통합된 표현 형태로 변환해 Sora에 대한 대규모 생성 훈련을 수행했다. Sora가 사용하는 이 표현 방식을 OpenAI는 '비주얼 패치(patches)'라 명명했는데, 이는 GPT의 텍스트 토큰처럼 더 작은 데이터 단위의 집합체다.

연구진은 먼저 영상을 저차원 잠재 공간(latent space)으로 압축한 후, 이 표현을 시공간 패치(spatiotemporal patch)로 분해한다. 이는 확장성이 매우 높은 표현 방식으로, 영상에서 패치로의 변환이 용이하며 다양한 유형의 영상 및 이미지 생성 모델 훈련에 적합하다.

시각 데이터를 패치로 변환

시각 데이터를 패치로 변환

Sora를 보다 적은 정보와 계산량으로 훈련하기 위해 OpenAI는 영상 압축 네트워크를 개발했다. 먼저 영상을 픽셀 수준의 저차원 잠재 공간으로 차원 감소한 후, 압축된 영상 데이터를 이용해 패치를 생성함으로써 입력 정보를 줄여 계산 부담을 낮춘다. 동시에 OpenAI는 압축된 정보를 다시 픽셀 공간으로 매핑할 수 있는 디코더 모델도 함께 훈련시켰다.

'비주얼 패치'라는 표현 방식 덕분에 연구진은 다양한 해상도, 지속 시간, 종횡비를 가진 영상/이미지에 대해 Sora를 훈련시킬 수 있다. 추론 단계에서는 Sora가 적절한 크기의 그리드 안에 초기화된 패치들을 배열해 영상의 논리를 판단하고 생성 영상의 크기를 조절할 수 있다.

OpenAI는 대규모 훈련 과정에서 비디오 모델이 흥미로운 기능들을 나타냈다고 밝혔다. 예를 들어 Sora는 현실 세계의 사람, 동물, 환경을 사실적으로 시뮬레이션하고, 고도로 생생한 영상을 생성하며, 3D 일관성과 시간 일관성을 실현해 물리 세계를 사실적으로 모사할 수 있다.

알트먼, 사용자 요청 대신 '2차 전달자' 역할

결과에서부터 개발 과정까지 Sora는 강력한 능력을 보여주고 있지만, 일반 사용자는 여전히 체험할 수 없다. 현재로서는 프롬프트(입력 문구)를 작성한 후 X(트위터)에서 OpenAI 공동창업자 샘 알트먼(Sam Altman)을 @멘션하면, 그가 중간에서 '2차 전달자' 역할을 하여 Sora로 영상을 생성해 공개하는 방식밖에 없다.

이러다 보니 OpenAI가 공개한 것만큼 Sora가 정말 그렇게 뛰어난지에 대한 의문도 제기된다.

이에 대해 OpenAI는 현재 모델에 일부 문제가 있음을 솔직히 밝혔다. 초기 GPT와 마찬가지로, 지금의 Sora 역시 '환각(hallucination)' 현상이 존재한다. 이러한 오류는 시각 중심의 영상 결과물에서 더욱 구체적으로 드러난다.

예를 들어, 러닝머신 벨트와 사람의 움직임 간 관계, 유리잔이 깨지는 순간 안에 든 액체가 흘러나오는 시퀀스 로직 등 많은 기본 상호작용의 물리 과정을 정확히 시뮬레이션하지 못한다.

아래 '고고학자들이 모래 속에서 플라스틱 의자를 발굴한다'는 영상에서는, 플라스틱 의자가 모래 속에서 마치 떠오르듯 나온다.

또한 공중에서 갑자기 나타나는 새끼 늑대는 누리꾼들 사이에서 '늑대의 유사분열'이라 조롱당하고 있다.

때때로 전후좌우 구분도 잘 못한다.

이러한 동적 장면에서 발견되는 오류들은 모두 Sora가 물리 세계의 운동 로직을 보다 깊이 이해하고 훈련해야 함을 보여준다. 또한 ChatGPT보다 직관적인 시각 경험을 제공하는 Sora는 윤리적, 보안적 위험이 훨씬 더 크다.

이미 텍스트 기반 이미지 생성 모델인 미드저니(Midjourney)는 인간에게 '사진이 있어도 진실이 아닐 수 있다'는 교훈을 줬다. 인공지능이 생성한 사실처럼 보이는 이미지들이 이미 허위정보 요소로 등장하고 있다. 신원 확인 기업 iProov의 수석 과학자 뉴웰 박사는 "Sora는 악의적인 행위자가 고품질의 가짜 영상을 생성하기를 더욱 쉬워지게 할 것"이라고 경고했다.

상상해보라, Sora가 생성한 영상이 악용되어 사기, 명예훼손, 폭력·음란물 유포 등에 쓰인다면 그 파장은 어마어마할 것이다. 이것이 바로 Sora가 사람들에게 충격뿐 아니라 두려움까지 느끼게 하는 이유다.

OpenAI도 Sora가 초래할 수 있는 보안 문제를 고려했으며, 아마도 그래서 Sora를 초대제 기반으로 극소수에게만 테스트를 허용한 것으로 보인다. 대중에게 언제 공개될지에 대해서는 아직 아무런 일정도 밝히지 않았다. 하지만 공개된 영상들을 보면, 다른 기업들이 Sora 모델에 추격할 시간이 많지 않다는 것을 느낄 수 있다.

TechFlow 공식 커뮤니티에 오신 것을 환영합니다

Telegram 구독 그룹:https://t.me/TechFlowDaily

트위터 공식 계정:https://x.com/TechFlowPost

트위터 영어 계정:https://x.com/BlockFlow_News