楊植麟と梁文鋒、論文が衝突した

TechFlow厳選深潮セレクト

楊植麟と梁文鋒、論文が衝突した

二人の創業者が自分の名前を論文に記したとき。

一

マスクが20万枚のカードを使って訓練したGrok3を発表した同じ日に、技術コミュニティではその「力任せ」路線とは逆方向のアプローチを取る2つの論文も発表された。

これらの論文の著者名には、それぞれ馴染み深い名前がある:

梁文锋、楊植麟。

2月18日、DeepSeekと月之暗面がほぼ同時に最新の論文を発表し、テーマはまさに対Transformerアーキテクチャの中心にあるアテンション機構に挑戦するという「バッティング」内容だった――より長く効率的に処理できるようにすること。さらに興味深いのは、両社の技術的スターである創業者の名前が、それぞれの論文や技術レポートに登場していることだ。

TechFlowが発表した論文のタイトルは、「Native Sparse Attention: Hardware-Aligned and Natively Trainable Sparse Attention」。

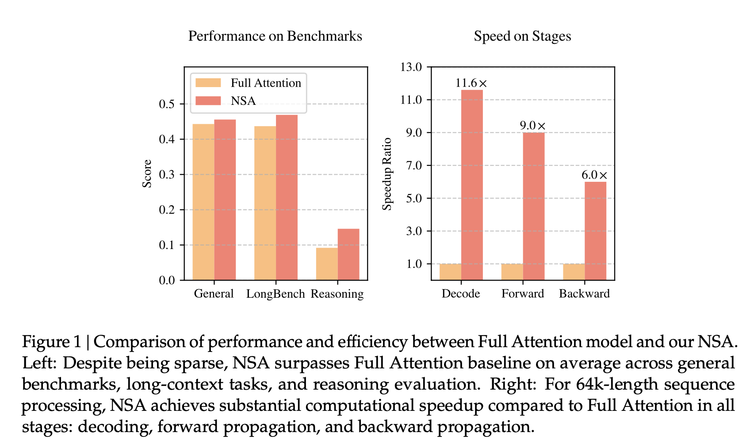

この論文によると、新たに提案されたNSA(ネイティブスパースアテンション)アーキテクチャは、ベンチマークテストにおいてフルアテンション機構と同等またはそれ以上の精度を達成しつつ、64kトークンのシーケンス処理では最大11.6倍高速になり、訓練も効率化され必要な計算リソースが削減される。また、書籍要約、コード生成、推論タスクなど超長上下文処理タスクで優れた性能を示す。

これまで注目されてきたアルゴリズム上の革新とは異なり、TechFlowは今回、最も核となるアテンション機構(attention)そのものの改造に踏み込んだ。

今日の大規模モデル繁栄の基盤であるTransformerだが、その中心的なアルゴリズムであるアテンション機構には依然として先天的な問題がある。読書に例えるなら、従来の「フルアテンション機構」は理解と生成のためにテキスト内のすべての単語を読み、他のすべての単語と比較する。これにより、処理対象のテキストが長くなるほど計算が複雑になり、技術的に限界に達したりクラッシュしたりする。

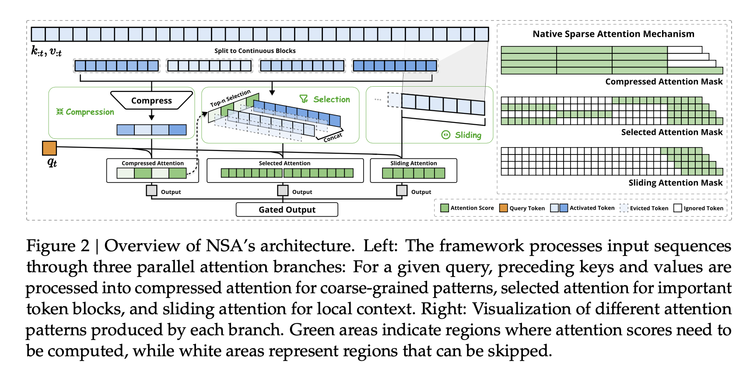

学術界ではこれまでさまざまな解決策が提案されてきたが、NSAは実環境での工学的最適化と実験を通じて、訓練段階でも使用可能な、3つのステップからなるアーキテクチャを構築した:

1)意味圧縮――各単語を見るのではなく、「ブロック」と呼ばれるグループに分割し、グローバルな意味情報を保持しつつシーケンス長を1/kまで短縮する。位置符号化を導入することで情報損失を低減し、計算複雑度をO(n²)からO(n²/k)へ低下させる。

2)動的選択――モデルが何らかの評価スコアに基づき、最も注目すべき単語を選び出し、それに対して細粒度な計算を行う。この重要性サンプリング戦略により、計算量を75%削減しても細粒度情報の98%を維持できる。

3)スライディングウィンドウ――前者2つが要約とハイライトなら、スライディングウィンドウは最近の文脈情報を確認するものであり、連続性を保つ。ハードウェアレベルのメモリ再利用技術により、メモリアクセス頻度を40%削減できる。

これら個々のアイデアはTechFlowが発明したものではないが、ASML方式の仕事だと想像できる――技術要素は既に散在していたが、工学的にそれらを統合し、大規模に展開可能な新たなアルゴリズムアーキテクチャとして具現化した点に新規性がある。今、強力な工学力によって「リソグラフィ装置」のようなものが完成され、他者はこれを用いて実際の産業環境でモデルを訓練できるようになった。

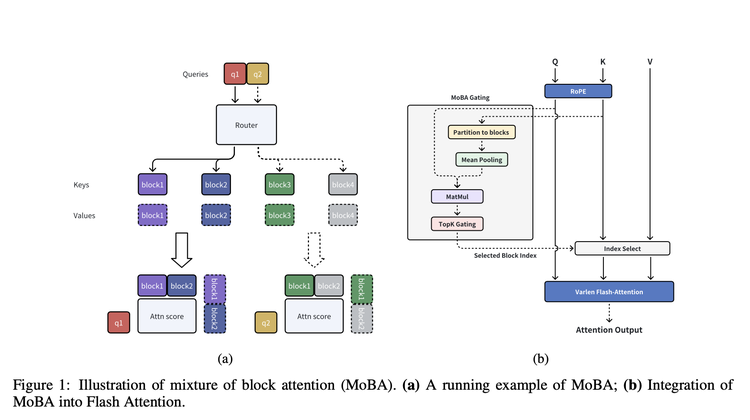

一方、同日に月之暗面が発表した論文は、根本思想において非常に一致するアーキテクチャMoBA(MoBA: MIXTURE OF BLOCK ATTENTION FOR LONG-CONTEXT LLMS)を提案している。

名称からもわかる通り、ここでも「単語」を「ブロック」にする手法が採られている。「ブロック化」後、MoBAには「知能的な審査官」のようなゲートネットワークがあり、あるブロックと最も関連するTop-K個のブロックを選定し、選ばれたブロック間でのみアテンションを計算する。実装では、さらにFlashAttention(アテンション計算を効率化)とMoE(エキスパート混合モデル)の最適化手法も組み合わせている。

NSAと比べ、MoBAは柔軟性を重視しており、現在主流のフルアテンション機構から完全に離脱せず、フルアテンションとスパースアテンションの間を自由に切り替えられる設計になっている。これにより、既存のフルアテンションモデルとの互換性と適応範囲が広がる。

論文によれば、MoBAは上下文長の増加に伴い計算複雑度の利点が顕著になる。1Mトークンのテストではフルアテンションより6.5倍高速、10Mトークンでは16倍高速になる。さらに、すでにKimi製品で実用化され、ユーザーの超長上下文処理ニーズに対応している。

楊植麟が月之暗面を創業した際に注目された理由の一つは、彼の論文の影響力と引用数であったが、K1.5論文以前の彼の最後の研究論文は2024年1月まで遡る。一方、梁文锋はDeepSeekの重要なモデル技術レポートには著者として登場するが、これらのレポートの著者リストはほとんどDeepSeekの社員名簿のようになっており、ほぼ全員が含まれる。一方、NSA論文の著者はごく少数に限られている。この点からも、両社の創業者にとってこれらの研究が持つ重要性、そして両社の技術路線を理解する上での意義がうかがえる。

この重要性を裏付けるもう一つの詳細は、ネットユーザーがarXiv上でNSA論文の投稿記録を調べたところ、2月16日に投稿されており、投稿者がまさに梁文锋本人だったことだ。

二

これは月之暗面とTechFlowが初めて「バッティング」したわけではない。R1が発表されたのと同時に、Kimiは珍しくK 1.5の技術レポートを公開した。それ以前、この企業は自社の技術的思考を外部に示すことを優先していなかった。当時、この2つのレポートはどちらもRLによる推論モデルをターゲットにしていた。実は、両技術レポートをよく読むと、K1.5の論文では月之暗面が推論モデルの訓練方法についてより詳細に共有しており、情報量や詳細さの点で言えばR1の論文よりも上回っていた。しかし後にTechFlowのブームが起きたことで、この論文自体への議論はかなり覆い隠されてしまった。

それを裏付ける証拠として、OpenAIが最近珍しく公開したoシリーズモデルの推論能力に関する論文の中で、DeepSeek R1とKimi k1.5の名前が同時に挙げられている。「DeepSeek-R1およびKimi k1.5は独立した研究により、チェーンオブトought(COT)手法を利用することで、数学問題の解決やプログラミング課題におけるモデルの総合的パフォーマンスを大幅に向上させられることを示した。」つまり、OpenAI自身が比較対象として選んだ2つの推論モデルなのだ。

「大規模モデルアーキテクチャの最も驚くべき点は、自分自身で前進の道筋を示しているように見えることで、異なる人々が異なる角度から似たような方向性に到達するのです。」

MoBaの核心研究に参加した清華大学の章明星教授が、Zhihu上でこう述べた。

彼はさらに興味深い比較を提示している。

「DeepSeek R1 と Kimi K1.5 はどちらも ORM based RL を指していますが、R1 はゼロから始め、より“純粋”あるいは“less structure”で、早期にリリースされ、同時にモデルをオープンソース化しました。

Kimi MoBA と DeepSeek NSA は再び、逆伝播可能な learned sparse attention を指しており、今回も MoBA の方がより “less structure” で、早期リリース、コードの同時オープンソース化です。」

この2社の連続した「バッティング」は、強化学習の技術進展や、より効率的で長文対応のアテンション機構の進化方向を、比較しながら理解するのに役立っている。

「R1 と K1.5 を併せて見ることで推論モデルの訓練方法が学べるように、MoBA と NSA を併せて見ることで、“アテンションにおけるスパーシティは存在すべきであり、エンドツーエンドの訓練によって獲得可能である”という信念を、異なる側面からより深く理解できる。」と章明星は述べている。

三

MoBA発表後、月之暗面の許欣然もSNSで、これは1年半取り組んだ成果であり、今後開発者がすぐに使える状態になると述べた。

しかし、このタイミングでのオープンソース化は、必然的にTechFlowの「影」の中で語られることになる。興味深いことに、各社が積極的にTechFlowに接続し自社モデルをオープンソース化する中、外部からは常に月之暗面が真っ先に想起され、Kimiが接続するかどうか、モデルをオープンソース化するかといった議論が絶えない。月之暗面とドウバオは、唯一残った「異端児」のように見える。

しかし現時点では、TechFlowが他のプレイヤー以上に月之暗面に継続的な影響を与えていることが明らかだ。それは技術路線からユーザー争奪まで、全方位的な挑戦をもたらしている。一方で、製品競争においても基礎モデルの能力が依然として最重要であることを証明した。また、もう一つ明確になりつつある連鎖反応は、腾讯の微信検索と元寶のコンビネーションが、DeepSeek R1の勢いに乗って、かつて逃したマーケティング投入戦を補填しようとしていることであり、最終的にはKimiとドウバオを狙っている。

こうした中で、月之暗面の対応策は注目される。その中でオープンソース化は不可欠な一歩だ。どうやら月之暗面の選択は、TechFlowのオープンソース戦略に真正面から対応したいというものらしい。現在TechFlow以降に続いた多くのオープンソースは、まるで反射行動のようで、Llama時代のオープンソース思考に沿った追随にすぎない。実際、TechFlowのオープンソースは以前とは異なり、Llamaのように防御的・混乱誘導的なクローズド競合相手への対抗手段ではなく、明確な利益をもたらす競争戦略となっている。

最近、月之暗面内部で「SOTA(最先端)結果を目標とする」という方針が伝えられており、これはまさに新しいオープンソースモデルに最も近い戦略だろう。最強のモデル、最強のアーキテクチャ手法を公開することで、アプリケーション側での影響力を得られる可能性がある。

両社の論文によれば、MoBAはすでに月之暗面のモデルと製品に適用されており、NSAも同様で、それにより外界はDeepSeekの次世代モデルに対してより明確な予測を持てるようになっている。次の注目点は、月之暗面とTechFlowがMoBAとNSAを使って訓練した次世代モデルが、再びバッティングするかどうか、そしてオープンソース化するかどうか――おそらく、それが月之暗面が待っている節目なのだろう。

TechFlow公式コミュニティへようこそ

Telegram購読グループ:https://t.me/TechFlowDaily

Twitter公式アカウント:https://x.com/TechFlowPost

Twitter英語アカウント:https://x.com/BlockFlow_News