Yang Zhilin et Liang Wenfeng ont publié des articles en collision

TechFlow SélectionTechFlow Sélection

Yang Zhilin et Liang Wenfeng ont publié des articles en collision

Quand les deux fondateurs inscrivent leurs noms dans l'article.

Un

Le jour où Musk a publié Grok3, entraîné avec 200 000 cartes, deux articles adoptant une approche « opposée » à la méthode de Musk basée sur la force brute ont également été publiés dans la communauté technologique.

Dans la liste des auteurs de ces deux articles figurent deux noms bien connus :

Liang Wenfeng, Yang Zhilin.

Le 18 février, DeepSeek et Moonshot ont presque simultanément publié leurs derniers articles scientifiques, abordant tous deux un sujet identique : remettre en cause le mécanisme d’attention central de l’architecture Transformer afin de traiter plus efficacement des contextes plus longs. Ce qui est encore plus intéressant, c’est que les fondateurs emblématiques de ces deux entreprises figurent personnellement parmi les auteurs des publications techniques respectives.

L'article publié par DeepSeek s'intitule : « Native Sparse Attention : Hardware-Aligned and Natively Trainable Sparse Attention ».

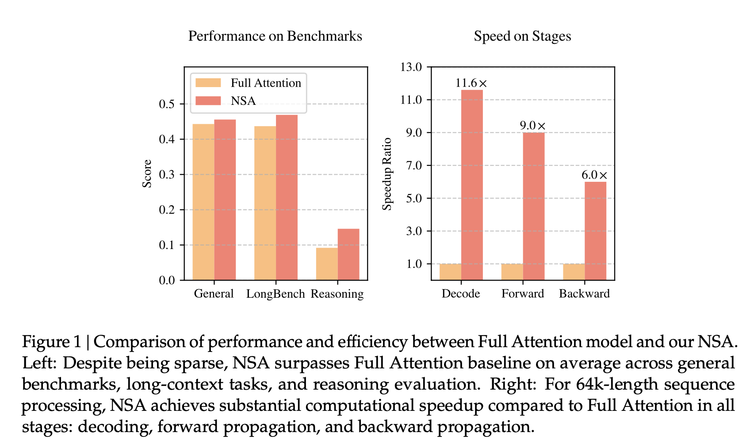

Selon cet article, la nouvelle architecture proposée NSA (attention clairsemée native) atteint, lors des tests de référence, une précision égale ou supérieure à celle du mécanisme d'attention complète ; elle permet d’accélérer jusqu’à 11,6 fois le traitement de séquences de 64k tokens, rend l'entraînement plus efficace et requiert moins de puissance de calcul ; elle excelle particulièrement dans les tâches à contexte très long, comme le résumé de livres, la génération de code ou les tâches de raisonnement.

Contrairement aux innovations algorithmiques précédemment mises en avant, DeepSeek intervient cette fois directement au cœur du mécanisme d’attention (attention).

Transformer constitue la base de toute la prospérité actuelle des grands modèles, mais son algorithme central, le mécanisme d’attention, présente toujours des défauts intrinsèques : par analogie avec la lecture, le mécanisme traditionnel d’« attention complète » lit chaque mot du texte pour comprendre et générer, puis compare chaque mot avec tous les autres. Cela rend le traitement exponentiellement complexe à mesure que le texte s’allonge, ralentissant fortement la technologie, voire provoquant des blocages.

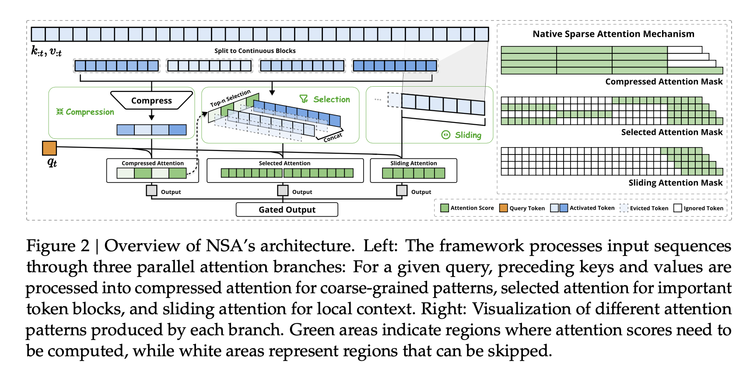

La communauté académique propose depuis longtemps diverses solutions. NSA assemble, grâce à des optimisations et expériences en environnement réel, un schéma architectural utilisable pendant l’entraînement, composé de trois étapes :

1) Compression sémantique — plutôt que d’examiner chaque mot individuellement, on regroupe les mots en « blocs ». En conservant la sémantique globale, cela réduit la longueur de la séquence à 1/k, tout en introduisant un encodage de position pour limiter la perte d’information, réduisant ainsi la complexité de calcul de O(n²) à O(n²/k).

2) Sélection dynamique — le modèle utilise un mécanisme de notation pour identifier les mots les plus pertinents, effectuant des calculs fins uniquement sur ceux-ci. Cette stratégie d’échantillonnage par importance préserve 98 % de l’information fine tout en réduisant de 75 % la charge de calcul.

3) Fenêtre glissante — si les deux premières étapes correspondent à un résumé et à la mise en évidence des points clés, la fenêtre glissante permet d'examiner les informations contextuelles les plus récentes, assurant ainsi la cohérence. Grâce à une technique matérielle de réutilisation de la mémoire, la fréquence d'accès à la mémoire est réduite de 40 %.

Aucune de ces idées n’a été inventée par DeepSeek, mais on peut y voir un travail à la manière d’ASML : les éléments technologiques existaient déjà, épars, mais l’ingénierie réussit à les combiner en une solution industrialisable. Un tel assemblage algorithmique n’avait jamais été réalisé auparavant. Aujourd’hui, quelqu’un dispose d’une capacité d’ingénierie suffisante pour construire une véritable « machine de lithographie », que d’autres peuvent utiliser pour entraîner des modèles dans des environnements industriels réels.

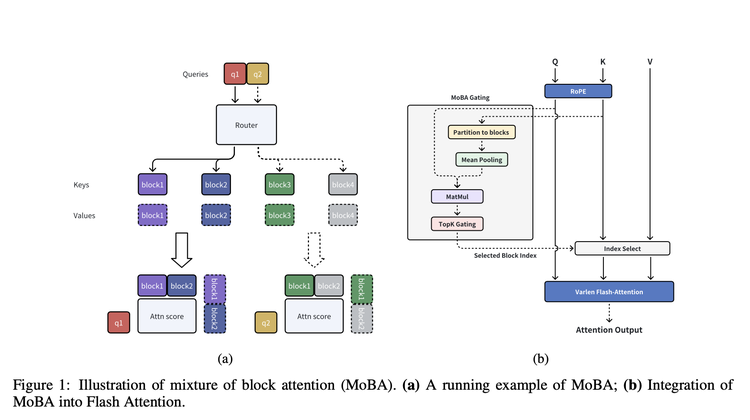

Le même jour, Moonshot publiait un article proposant une architecture dont l'idée fondamentale est très similaire : MoBA (MoBA : MIXTURE OF BLOCK ATTENTION FOR LONG-CONTEXT LLMS).

Comme son nom l'indique, MoBA utilise également une méthode consistant à transformer les « mots » en « blocs ». Après avoir segmenté le texte, MoBA intègre un réseau de contrôle agissant comme un « sélecteur intelligent », chargé de choisir les K blocs les plus pertinents pour un bloc donné, et de ne calculer l’attention que sur ces blocs sélectionnés. Dans sa mise en œuvre pratique, MoBA combine également FlashAttention (permettant un calcul d’attention plus efficace) et MoE (modèle mixte d’experts).

Comparé à NSA, MoBA met davantage l’accent sur la flexibilité. Il ne s’écarte pas complètement du mécanisme d’attention complète dominant aujourd’hui, mais conçoit un mode pouvant basculer librement, permettant aux modèles de passer entre attention complète et attention clairsemée, offrant ainsi plus d’espace d’adaptation aux modèles existants.

Selon l’article, l’avantage de MoBA en termes de complexité de calcul devient évident à mesure que la longueur du contexte augmente. Dans un test de 1 million de tokens, MoBA est 6,5 fois plus rapide que l’attention complète ; à 10 millions de tokens, il est 16 fois plus rapide. En outre, il est déjà utilisé dans le produit Kimi pour répondre aux besoins quotidiens des utilisateurs en traitement de contextes très longs.

Un des motifs importants ayant attiré l’attention sur la création initiale de Moonshot par Yang Zhilin était l’influence et le nombre de citations de ses articles, bien que sa dernière publication scientifique remonte à janvier 2024, avant le papier K1.5. Quant à Liang Wenfeng, bien qu’il apparaisse comme auteur dans les rapports techniques les plus importants de DeepSeek, ces rapports listent pratiquement tous les employés de DeepSeek, tandis que l’article NSA ne compte que quelques auteurs. Cela montre bien l’importance de ces travaux pour les fondateurs respectifs, ainsi que leur signification pour comprendre les orientations technologiques de ces deux entreprises.

Un autre détail illustrant cette importance est qu’un internaute a remarqué que l’historique de soumission de l’article NSA sur arXiv indique qu’il a été soumis le 16 février par Liang Wenfeng lui-même.

Deux

Ce n’est pas la première fois que Moonshot et DeepSeek se retrouvent en concurrence directe. Lors de la sortie de R1, Kimi a exceptionnellement publié le rapport technique de K 1.5, alors que cette entreprise n’avait jusque-là jamais fait de la diffusion de sa réflexion technique une priorité. À ce moment-là, ces deux articles visaient tous deux les modèles de raisonnement impulsés par l’apprentissage par renforcement (RL). En réalité, une lecture attentive de ces rapports techniques montre que dans l’article K1.5, Moonshot partage des détails beaucoup plus précis sur la façon d’entraîner un modèle de raisonnement, surpassant même l’article R1 en richesse d’informations et de précisions. Toutefois, l’effervescence suscitée par DeepSeek a largement occulté les discussions autour de ce papier.

Un indice confirmant cela est qu’OpenAI, dans un article récent rare où il explique les capacités de raisonnement de ses modèles o, mentionne explicitement à la fois DeepSeek R1 et Kimi k1.5. « DeepSeek-R1 et Kimi k1.5, par des recherches indépendantes, montrent que la méthode d’apprentissage par chaîne de pensée (COT) améliore significativement les performances globales des modèles dans la résolution de problèmes mathématiques et les défis de programmation. » Autrement dit, OpenAI choisit lui-même ces deux modèles comme points de comparaison en matière de raisonnement.

« Ce que j’admire le plus dans cette architecture de grands modèles, c’est qu’elle semble indiquer seule la direction à suivre, conduisant différentes personnes, depuis des angles différents, vers des orientations similaires. »

Ainsi s’exprime Zhang Mingxing, professeur à l’université Tsinghua, ayant participé à la recherche fondamentale sur MoBa, sur Zhihu.

Il propose aussi une comparaison très intéressante :

« DeepSeek R1 et Kimi K1.5 pointent tous deux vers un apprentissage par renforcement basé sur ORM, mais R1 part de zéro, étant plus “pur” ou “moins structuré”, lancé plus tôt, avec un modèle open source publié simultanément.

Kimi MoBA et DeepSeek NSA pointent à nouveau tous deux vers une attention clairsemée apprise pouvant être rétropropagée, et cette fois, MoBA est encore un peu plus “moins structuré”, lancé plus tôt, avec un code open source publié simultanément. »

Ces concurrences successives entre les deux entreprises aident à mieux comprendre, par comparaison, l’évolution de la technologie d’apprentissage par renforcement, ainsi que la trajectoire d’amélioration des mécanismes d’attention pour des textes plus longs et plus efficaces.

« Comme l’analyse conjointe de R1 et K1.5 permet de mieux comprendre comment entraîner un modèle de raisonnement, l’analyse combinée de MoBA et NSA permet de mieux saisir sous différents angles notre conviction selon laquelle la parcimonie dans l’attention doit exister et peut être acquise par un entraînement de bout en bout. » écrit Zhang Mingxing.

Trois

Après la publication de MoBA, Xu Xinran de Moonshot a déclaré sur les réseaux sociaux qu’il s’agissait d’un travail mené pendant une année et demie, désormais utilisable immédiatement par les développeurs.

Mais le choix d’ouvrir le code à ce moment sera inévitablement discuté à l’ombre de DeepSeek. Ce qui est intéressant, c’est que, alors que de nombreuses entreprises s’emparent activement de DeepSeek et ouvrent leurs propres modèles, l’opinion publique pense immédiatement à Moonshot, suscitant des débats constants sur l’intégration éventuelle de Kimi et sur l’ouverture de son modèle. Moonshot et DouBao semblent ainsi être devenus les deux derniers « anomalies ».

À présent, il apparaît que l’influence de DeepSeek sur Moonshot est plus durable que sur les autres acteurs, posant un défi global allant de la stratégie technologique à la conquête des utilisateurs : d’une part, cela prouve que même dans la compétition produit, la capacité fondamentale du modèle reste primordiale ; d’autre part, une réaction en chaîne de plus en plus nette se dessine : la combinaison de la recherche WeChat de Tencent et de Yuanbao profite de l’élan de DeepSeek R1 pour rattraper un combat marketing qu’elle avait manqué auparavant, visant finalement Kimi et DouBao.

La réponse de Moonshot devient donc particulièrement attendue. L’ouverture du code semble être une étape obligatoire. Et il semblerait que le choix de Moonshot soit de véritablement s’aligner sur la démarche d’open source de DeepSeek — contrairement à la plupart des initiatives d’open source post-DeepSeek, qui ressemblent à des réactions instinctives et suivent encore la logique d’ouverture de l’époque Llama. En réalité, l’open source de DeepSeek diffère désormais : ce n’est plus un open source défensif destiné à perturber les concurrents fermés, comme du temps de Llama, mais une stratégie compétitive générant des bénéfices clairs.

Récemment, on entend dire que Moonshot a fixé internement comme objectif d’atteindre SOTA (state-of-the-art). Cela semble être la stratégie la plus proche de ce nouveau modèle d’open source : ouvrir les modèles les plus performants, les architectures les plus avancées, afin d’acquérir enfin l’influence côté application qu’il recherche depuis longtemps.

D’après les articles des deux entreprises, MoBA est déjà intégré aux modèles et produits de Moonshot, tout comme NSA chez DeepSeek, ce qui permet même d’avoir des attentes plus claires concernant les prochains modèles de DeepSeek. Le prochain enjeu sera donc de savoir si Moonshot et DeepSeek, utilisant respectivement MoBA et NSA, vont former leurs prochains modèles et entrer à nouveau en collision, et ce, encore une fois par le biais de l’open source — ce qui pourrait bien être le moment que Moonshot attend patiemment.

Bienvenue dans la communauté officielle TechFlow

Groupe Telegram :https://t.me/TechFlowDaily

Compte Twitter officiel :https://x.com/TechFlowPost

Compte Twitter anglais :https://x.com/BlockFlow_News