Pourquoi sommes-nous toujours haussiers sur Bittensor ?

TechFlow SélectionTechFlow Sélection

Pourquoi sommes-nous toujours haussiers sur Bittensor ?

Grâce à sa forte inclusivité, son environnement concurrentiel intense et ses mécanismes d'incitation efficaces, l'écosystème Bittensor est capable de produire organiquement des produits d'intelligence artificielle de haute qualité.

Rédaction : 0xai

Traduction : TechFlow

Qu'est-ce que Bittensor ?

Bittensor n’est pas un produit d’intelligence artificielle (IA), ni ne produit ou fournit aucun service ou produit d’IA. Bittensor est un système économique qui agit comme un optimiseur de marché pour les produits d’IA en offrant aux producteurs un système d’incitations extrêmement compétitif. Dans l’écosystème Bittensor, les producteurs de haute qualité reçoivent davantage d’incitations, tandis que ceux dont la performance est plus faible sont progressivement éliminés.

Alors, comment Bittensor crée-t-il concrètement ce mécanisme incitatif afin d’encourager une concurrence efficace et favoriser la production organique de produits d’IA de haute qualité ?

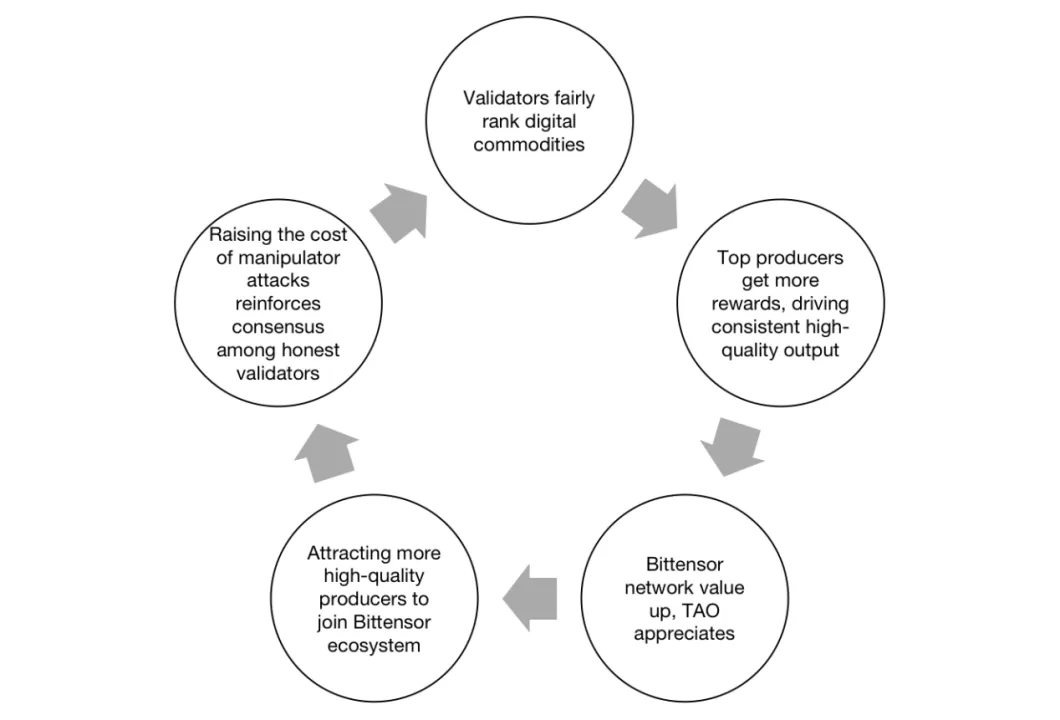

Modèle du cercle vertueux de Bittensor

Bittensor atteint cet objectif grâce à un modèle de cercle vertueux. Les validateurs évaluent la qualité des produits d’IA au sein de l’écosystème et attribuent des incitations proportionnellement à cette qualité, garantissant ainsi que les meilleurs producteurs soient mieux récompensés. Cela stimule une augmentation continue de la production de haute qualité, renforçant ainsi la valeur du réseau Bittensor et contribuant à l’appréciation du TAO. L’appréciation du TAO attire non seulement davantage de producteurs de qualité dans l’écosystème Bittensor, mais augmente également le coût d’attaque pour toute tentative de manipulation des résultats d’évaluation. Cela renforce davantage le consensus des validateurs honnêtes, améliore l’objectivité et l’équité des évaluations, et permet ainsi un mécanisme de concurrence et d’incitation plus efficace.

Garantir l’équité et l’objectivité des résultats d’évaluation est une étape clé pour activer ce cercle vertueux. C’est aussi la technologie fondamentale de Bittensor : un système de validation abstraite basé sur le consensus Yuma.

Alors, qu’est-ce que le consensus Yuma, et comment garantit-il que les résultats d’évaluation post-consensus soient justes et objectifs ?

Le consensus Yuma est un mécanisme de consensus conçu pour calculer un résultat final à partir des évaluations variées fournies par de nombreux validateurs. De manière similaire au consensus de tolérance aux pannes byzantines, tant que la majorité des validateurs du réseau sont honnêtes, une décision correcte peut être prise. En supposant que les validateurs honnêtes fournissent des évaluations objectives, les résultats après consensus seront également justes et objectifs.

Prenons l’évaluation de la qualité des sous-réseaux comme exemple : les validateurs du réseau racine évaluent et classent la qualité de la production de chaque sous-réseau. Les résultats provenant de 64 validateurs sont agrégés, puis un résultat final est obtenu via l’algorithme de consensus Yuma. Ces résultats finaux sont ensuite utilisés pour distribuer les nouveaux TAO frappés à chaque sous-réseau.

Actuellement, le consensus Yuma présente encore certaines limites :

-

Les validateurs du réseau racine peuvent ne pas représenter pleinement tous les détenteurs de TAO, et leurs évaluations ne reflètent pas nécessairement des points de vue largement partagés. En outre, les évaluations de certains principaux validateurs ne sont pas toujours objectives. Même si des biais sont détectés, il peut être difficile de les corriger immédiatement.

-

La présence des validateurs du réseau racine limite le nombre de sous-réseaux que Bittensor peut accueillir. Pour rivaliser avec les géants centralisés de l’IA, 32 sous-réseaux ne suffisent pas. Or, même avec seulement 32 sous-réseaux, les validateurs du réseau racine peuvent avoir du mal à surveiller efficacement chacun d’eux.

-

Les validateurs peuvent manquer d’incitations fortes pour migrer vers de nouveaux sous-réseaux. À court terme, un déplacement d’un ancien sous-réseau à forte émission vers un nouveau sous-réseau à faible émission entraîne une perte de récompenses. L’incertitude quant à la hausse future de l’émission, combinée à une perte immédiate de récompenses, diminue leur volonté de migration.

Bittensor prévoit toutefois des mises à niveau pour résoudre ces inconvénients :

-

Le TAO dynamique (dTAO) décentralisera le pouvoir d’évaluation de la qualité des sous-réseaux vers tous les détenteurs de TAO, plutôt que de le concentrer entre les mains d’un petit groupe de validateurs. Les détenteurs de TAO pourront indirectement déterminer la proportion d’allocation pour chaque sous-réseau via le staking.

-

Sans la limitation imposée par les validateurs du réseau racine, le nombre maximal de sous-réseaux actifs passera à 1024. Cela réduira considérablement la barrière d’entrée pour les nouvelles équipes souhaitant rejoindre l’écosystème Bittensor, intensifiant ainsi la concurrence entre sous-réseaux.

-

Les validateurs qui migreront tôt vers de nouveaux sous-réseaux pourraient recevoir des récompenses accrues. Une migration anticipée signifie acquérir le dTAO du sous-réseau à un prix inférieur, augmentant ainsi la possibilité d’obtenir davantage de TAO à l’avenir.

Une forte inclusivité constitue également l’un des principaux avantages du consensus Yuma. Ce dernier sert non seulement à déterminer l’émission de chaque sous-réseau, mais aussi à définir la proportion d’allocation pour chaque mineur et validateur au sein d’un même sous-réseau. En outre, quelle que soit la tâche du mineur, ses contributions — capacité de calcul, données, apport humain ou intellectuel — sont prises en compte de manière abstraite. Ainsi, toutes les étapes de la production de biens d’IA peuvent intégrer l’écosystème Bittensor, bénéficier d’incitations, et simultanément renforcer la valeur du réseau.

Passons maintenant à l’examen de quelques sous-réseaux leaders, afin d’observer comment Bittensor incite leurs productions.

Des sous-réseaux exemplaires

Sous-réseau 3 : Myshell TTS

Vous pouvez contribuer au développement du sous-réseau myshell ai/MyShell TTS en créant un compte sur GitHub.

Émission : 3,46 % (9 avril 2024)

Contexte : Myshell, l’équipe derrière Myshell TTS (text-to-speech), regroupe des membres clés issus d’institutions prestigieuses telles que le MIT, l’Université d’Oxford et Princeton. Myshell vise à créer une plateforme sans code permettant aux étudiants sans formation en programmation de concevoir facilement leurs propres robots. Spécialisée dans le domaine TTS, les livres audio et les assistants virtuels, Myshell a lancé en mars 2023 son premier chatbot vocal, Samantha. Avec l’expansion continue de sa gamme de produits, elle a déjà accumulé plus d’un million d’utilisateurs inscrits. La plateforme héberge divers types de robots, notamment destinés à l’apprentissage linguistique, à l’éducation ou à des usages pratiques.

Positionnement : Myshell a lancé ce sous-réseau afin de mobiliser la sagesse de toute la communauté open source pour construire le meilleur modèle TTS open source possible. Autrement dit, Myshell TTS n’exécute pas directement les modèles ni ne traite les requêtes finales des utilisateurs ; il s’agit plutôt d’un réseau dédié à l’entraînement de modèles TTS.

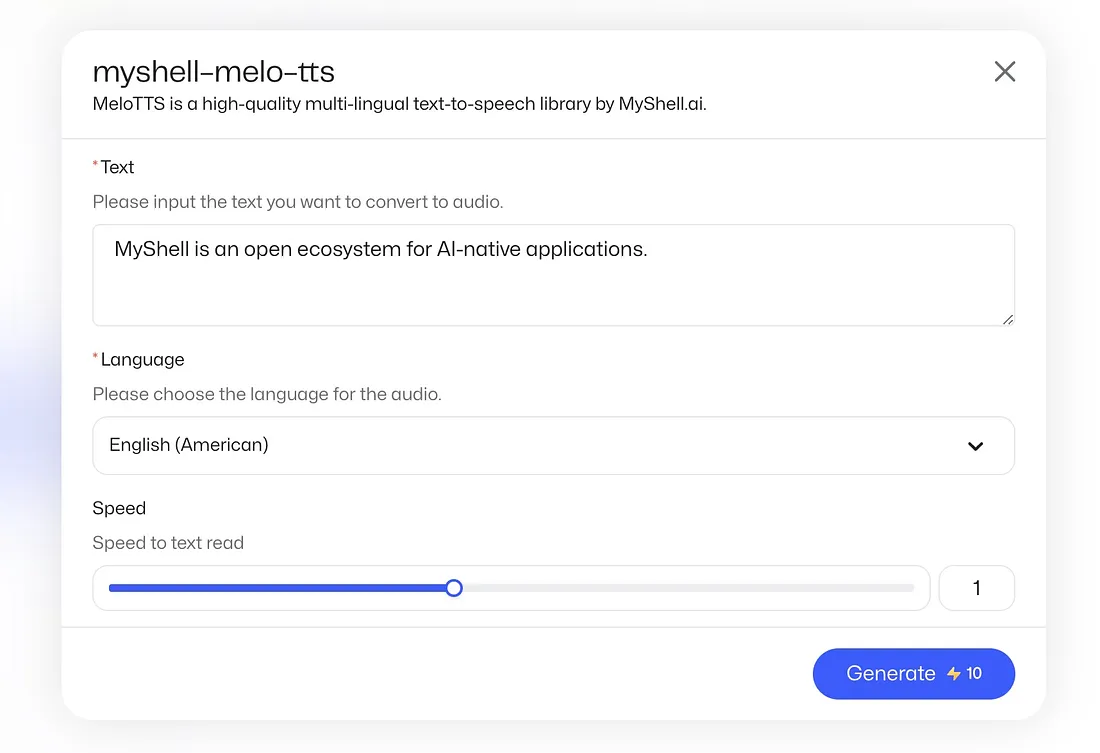

Architecture de Myshell TSS

Le fonctionnement de Myshell TTS suit le processus illustré ci-dessus. Les mineurs entraînent les modèles et téléchargent les modèles formés dans un pool (les métadonnées des modèles étant également stockées sur la blockchain Bittensor). Les validateurs génèrent des cas-tests, évaluent les performances des modèles et attribuent des notes en fonction des résultats. La blockchain Bittensor utilise ensuite le consensus Yuma pour agréger les poids et déterminer le poids final et la proportion d’allocation pour chaque mineur.

En résumé, les mineurs doivent continuellement soumettre des modèles de meilleure qualité pour maintenir leurs récompenses.

Actuellement, Myshell propose également une démonstration sur sa plateforme, permettant aux utilisateurs d’essayer les modèles issus de Myshell TTS.

Architecture Open Kaito

À l’avenir, lorsque les modèles entraînés par Myshell TTS deviendront plus fiables, davantage d’applications verront le jour. De plus, en tant que modèles open source, ils ne se limiteront pas à Myshell, mais pourront être déployés sur d’autres plateformes. N’est-ce pas là précisément l’objectif recherché dans l’intelligence artificielle décentralisée ?

Sous-réseau 5 : Open Kaito

Vous pouvez contribuer au développement d’Open Kaito en créant un compte sur GitHub.

Émission : 4,39 % (9 avril 2024)

Contexte : L’équipe derrière Kaito.ai forme l’équipe Open Kaito, dont les membres clés possèdent une riche expérience dans le domaine de l’IA, ayant auparavant travaillé chez des entreprises de premier plan telles qu’AWS, META et Citadel. Avant de rejoindre les sous-réseaux Bittensor, ils ont lancé leur produit phare, Kaito.ai — un moteur de recherche de données hors chaîne Web3, introduit au quatrième trimestre 2023. Grâce à des algorithmes d’IA, Kaito.ai a optimisé les composants essentiels du moteur de recherche, notamment la collecte de données, l’algorithme de classement et l’algorithme de récupération. Il est désormais reconnu comme un outil de collecte d’informations de premier plan dans la communauté cryptographique.

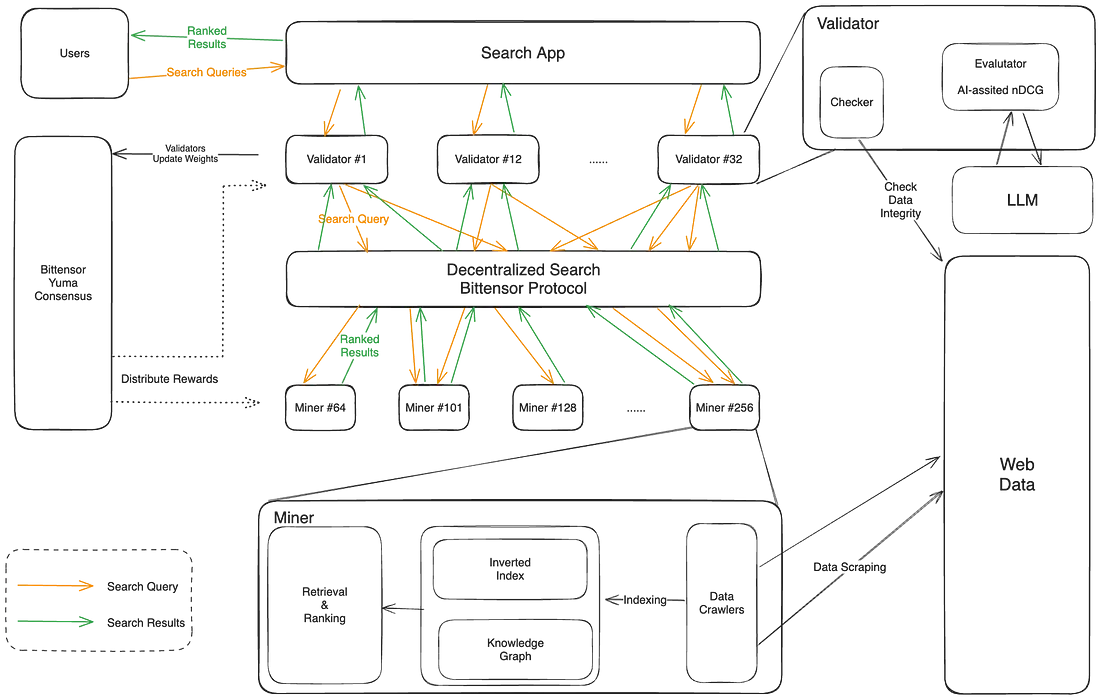

Positionnement : Open Kaito vise à construire une couche d’indexation décentralisée pour soutenir la recherche intelligente et l’analyse. Un moteur de recherche n’est pas simplement une base de données ou un algorithme de classement, mais un système complexe. En outre, un moteur de recherche efficace nécessite une faible latence, ce qui pose un défi supplémentaire pour sa version décentralisée. Heureusement, grâce au système d’incitation de Bittensor, ces défis pourraient être surmontés.

Le fonctionnement d’Open Kaito est illustré ci-dessus. Open Kaito décentralise non seulement chaque composant du moteur de recherche, mais définit aussi le problème d’indexation comme un problème mineur-validateur. Autrement dit, les mineurs sont chargés de répondre aux demandes d’indexation des utilisateurs, tandis que les validateurs distribuent les besoins et notent les réponses des mineurs.

Open Kaito ne restreint pas la manière dont les mineurs accomplissent la tâche d’indexation, mais se concentre uniquement sur le résultat final produit par les mineurs, encourageant ainsi des solutions innovantes. Cela favorise un environnement concurrentiel sain entre les mineurs. Face aux demandes d’indexation des utilisateurs, les mineurs s’efforcent d’améliorer leurs plans d’exécution afin d’obtenir des réponses de meilleure qualité avec moins de ressources.

Sous-réseau 6 : Nous Finetuning

Vous pouvez contribuer au développement du sous-réseau Nous Research/finetuning en créant un compte sur GitHub.

Émission : 6,26 % (9 avril 2024)

Contexte : L’équipe derrière Nous Finetuning provient de Nous Research, un groupe de recherche spécialisé dans les architectures de grands modèles linguistiques (LLM), la synthèse de données et l’inférence locale. Son cofondateur a été précédemment ingénieur en chef chez Eden Network.

Positionnement : Nous Finetuning est un sous-réseau spécialement dédié à l’ajustement fin (fine-tuning) des grands modèles linguistiques. En outre, les données utilisées pour cet ajustement proviennent elles aussi de l’écosystème Bittensor, plus précisément du sous-réseau 18.

Le fonctionnement de Nous Finetuning est similaire à celui de Myshell TSS. Les mineurs entraînent des modèles à partir des données du sous-réseau 18 et publient régulièrement ces modèles pour qu’ils soient hébergés sur Hugging Face. Les validateurs évaluent les modèles et attribuent des notes. De même, la blockchain Bittensor utilise le consensus Yuma pour agréger les poids et déterminer le poids final et la distribution pour chaque mineur.

Sous-réseau 18 : Cortex.t

Vous pouvez contribuer au développement de corcel-api/cortex.t en créant un compte sur GitHub.

Émission : 7,74 % (9 avril 2024)

Contexte : L’équipe derrière Cortex.t est Corcel.io, qui bénéficie du soutien de Mog, le deuxième plus grand validateur du réseau Bittensor. Corcel.io est une application destinée aux utilisateurs finaux, offrant une expérience similaire à ChatGPT en tirant parti des produits d’IA de l’écosystème Bittensor.

Positionnement : Cortex.t est positionné comme la dernière couche avant la fourniture des résultats aux utilisateurs finaux. Il est chargé de détecter et d’optimiser les sorties provenant de divers sous-réseaux afin de garantir des résultats précis et fiables, particulièrement lorsqu’une seule requête active plusieurs modèles. Cortex.t vise à éviter les sorties vides ou incohérentes, assurant ainsi une expérience utilisateur fluide.

Les mineurs de Cortex.t utilisent d’autres sous-réseaux de l’écosystème Bittensor pour traiter les demandes des utilisateurs finaux. Ils emploient également GPT-3.5 Turbo ou GPT-4 pour valider les résultats produits, garantissant ainsi leur fiabilité. Les validateurs évaluent les sorties des mineurs en les comparant aux résultats générés par OpenAI.

Sous-réseau 19 : Vision

Contribuez au développement de namoray/vision en créant un compte sur GitHub.

Émission : 9,47 % (9 avril 2024)

Contexte : L’équipe de développement derrière Vision provient également de Corcel.io.

Positionnement : Vision vise à maximiser la capacité de production du réseau Bittensor en exploitant un cadre d’optimisation appelé DSIS (Distributed Scale Inference Subnet). Ce cadre accélère la réponse des mineurs aux validateurs. Actuellement, Vision se concentre sur les scénarios de génération d’images.

Les validateurs reçoivent les demandes depuis l’interface de Corcel.io et les distribuent aux mineurs. Les mineurs peuvent librement choisir leur pile technologique (modèles non exclusifs) pour traiter les demandes et produire des réponses. Ensuite, les validateurs évaluent la performance des mineurs. Grâce à DSIS, Vision peut répondre à ces demandes plus rapidement et plus efficacement que les autres sous-réseaux.

Conclusion

Comme le montrent les exemples ci-dessus, Bittensor fait preuve d’une grande inclusivité. La production des mineurs et l’évaluation des validateurs ont lieu hors chaîne, tandis que le réseau Bittensor sert uniquement à distribuer les récompenses aux mineurs selon les évaluations des validateurs. Toute étape de production d’un produit d’IA compatible avec l’architecture mineur-validateur peut être transformée en un sous-réseau.

Théoriquement, la concurrence entre sous-réseaux devrait être intense. Pour continuer à recevoir des récompenses, tout sous-réseau doit produire constamment des résultats de haute qualité. Sinon, si les validateurs du réseau racine jugent sa production peu valorisable, son allocation pourrait être réduite, voire remplacée par un nouveau sous-réseau.

Cependant, dans la réalité, nous observons effectivement certains problèmes :

-

Redondance et duplication des ressources dues à des sous-réseaux ayant des positionnements similaires. Parmi les 32 sous-réseaux existants, plusieurs se concentrent sur des domaines populaires tels que texte-à-image, prompts textuels et prévision de prix.

-

Présence de sous-réseaux sans cas d’usage concret. Bien que les sous-réseaux de prévision de prix puissent théoriquement fournir une valeur en tant qu’oracle, les données de prévision actuelles sont loin d’atteindre un niveau exploitable par les utilisateurs finaux.

-

Phénomène de « chasse au bon grain » (« bad money drives out good »). Certains principaux validateurs peuvent ne pas vouloir migrer vers de nouveaux sous-réseaux, même si ces derniers affichent clairement une qualité supérieure. Faute de soutien financier, ces nouveaux sous-réseaux risquent de ne pas obtenir suffisamment d’émission à court terme. Comme ils ne bénéficient que d’une période de protection de 7 jours, s’ils ne parviennent pas rapidement à accumuler une émission suffisante, ils risquent d’être éliminés et désactivés.

Ces problèmes révèlent une concurrence insuffisante entre sous-réseaux, ainsi qu’un manque d’engagement de certains validateurs à encourager une concurrence efficace.

Le validateur Open Tensor Foundation (OTF) a mis en œuvre certaines mesures temporaires pour atténuer cette situation. En tant que plus grand validateur détenant 23 % du staking (y compris les délégations), l’OTF offre aux sous-réseaux une voie pour lutter afin d’obtenir davantage de TAO en staking : les propriétaires de sous-réseaux peuvent soumettre hebdomadairement une demande à l’OTF pour ajuster leur proportion de TAO en staking. Ces demandes doivent couvrir 10 aspects, notamment « l’objectif du sous-réseau et sa contribution à l’écosystème Bittensor », « le mécanisme de récompense », « la conception du protocole de communication », « les sources de données et la sécurité », « les exigences de calcul » et « la feuille de route », afin d’aider à la prise de décision finale de l’OTF.

Toutefois, pour résoudre fondamentalement ce problème, d’une part, il est urgent de lancer le dTAO (Dynamic TAO), visant à remédier radicalement aux anomalies mentionnées ci-dessus. D’autre part, on pourrait appeler les grands validateurs détenant une importante part de Stake TAO à considérer davantage le développement à long terme de l’écosystème Bittensor sous l’angle de « l’évolution de l’écosystème » plutôt que strictement sous celui du « retour financier ».

En somme, grâce à son fort caractère inclusif, son environnement concurrentiel intense et son mécanisme d’incitation efficace, nous sommes convaincus que l’écosystème Bittensor sera capable de produire organiquement des produits d’IA de haute qualité. Bien que toutes les réalisations actuelles des sous-réseaux ne soient pas encore comparables à celles des produits centralisés, rappelons-nous que l’architecture actuelle de Bittensor vient tout juste d’avoir un an (le sous-réseau 1 a été enregistré le 13 avril 2023). Pour une plateforme ayant le potentiel de rivaliser avec les géants centralisés de l’IA, peut-être devrions-nous nous concentrer davantage sur l’élaboration de plans d’amélioration concrets plutôt que de critiquer hâtivement ses défauts. Après tout, personne ne souhaite voir l’intelligence artificielle continuellement monopolisée par quelques rares géants.

Bienvenue dans la communauté officielle TechFlow

Groupe Telegram :https://t.me/TechFlowDaily

Compte Twitter officiel :https://x.com/TechFlowPost

Compte Twitter anglais :https://x.com/BlockFlow_News