Bài phát biểu mới nhất của Jensen Huang tại CES2026: Ba chủ đề then chốt, một "quái vật chip"

Tuyển chọn TechFlowTuyển chọn TechFlow

Bài phát biểu mới nhất của Jensen Huang tại CES2026: Ba chủ đề then chốt, một "quái vật chip"

Khi AI vật lý cần suy nghĩ liên tục, vận hành lâu dài và thực sự bước vào thế giới thực, vấn đề không còn chỉ là sức mạnh tính toán có đủ hay không, mà là ai có thể thực sự xây dựng được toàn bộ hệ thống.

Tác giả: Lý Hải Luân, Tô Dương

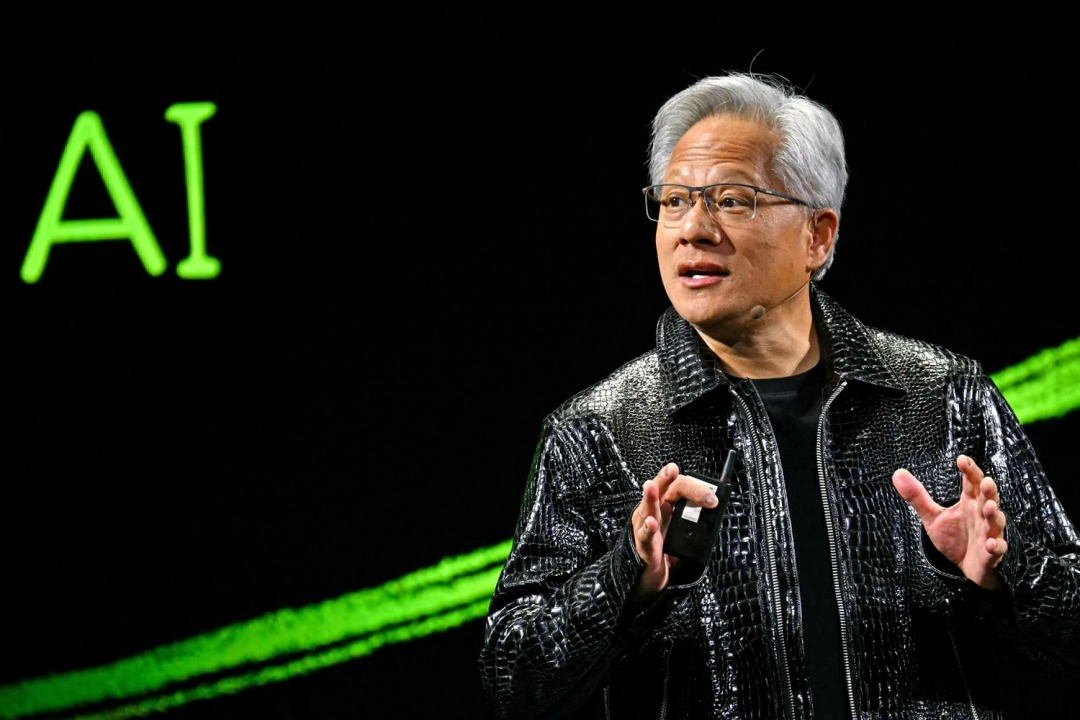

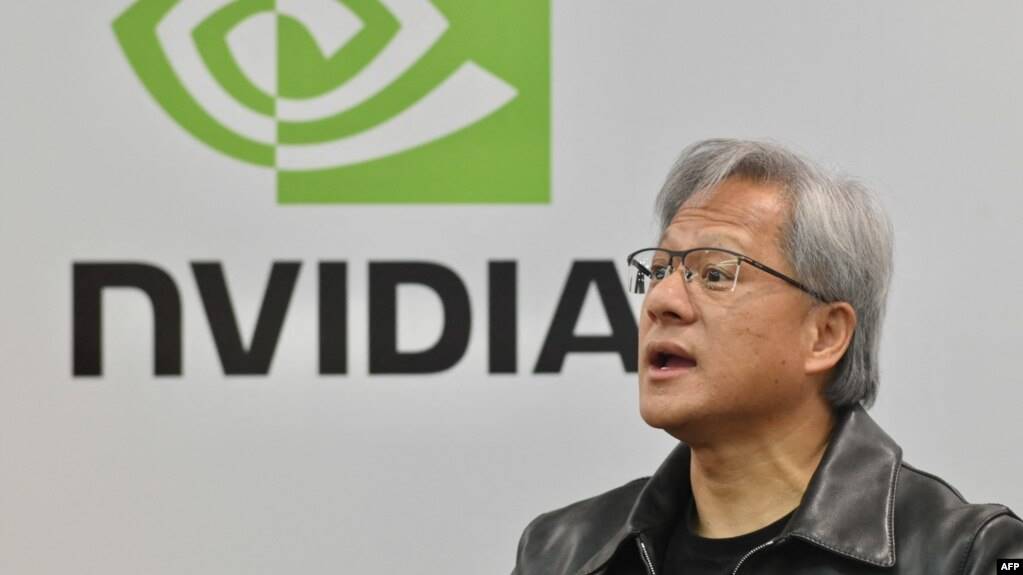

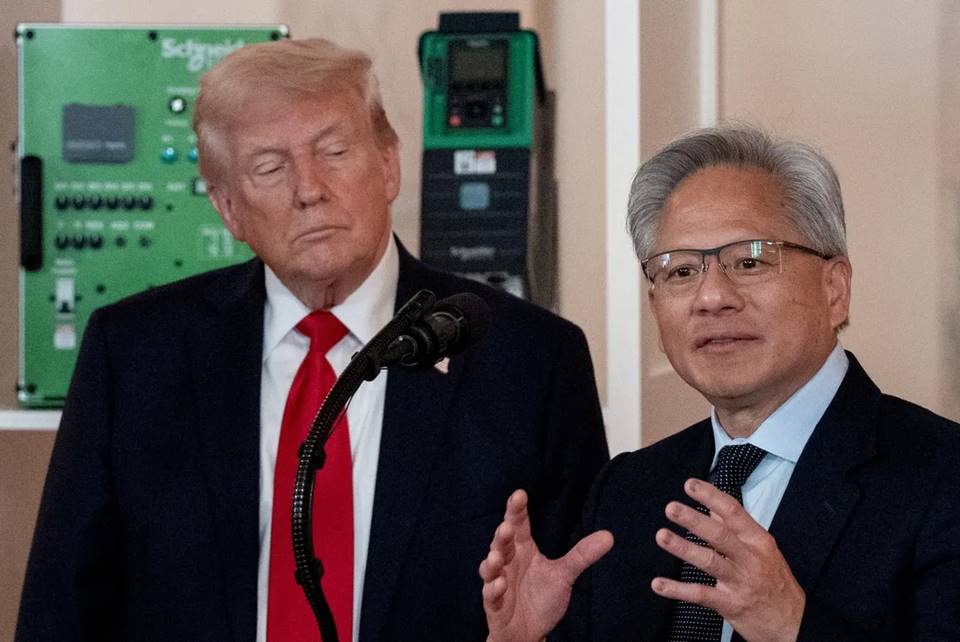

Vào ngày 6 tháng 1 theo giờ Bắc Kinh, CEO của NVIDIA, ông Jensen Huang, một lần nữa đứng trên sân khấu chính của CES 2026 trong chiếc áo da đặc trưng của mình.

Tại CES 2025, NVIDIA đã trình diễn chip Blackwell sản xuất hàng loạt và ngăn xếp công nghệ AI vật lý hoàn chỉnh. Tại sự kiện, ông Jensen Huang nhấn mạnh rằng một "kỷ nguyên AI vật lý" đang mở ra. Ông phác họa một tương lai đầy trí tưởng tượng: xe tự lái có khả năng suy luận, robot có thể hiểu và suy nghĩ, AI Agent (tác nhân thông minh) có thể xử lý các nhiệm vụ ngữ cảnh dài với hàng triệu token.

Chỉ trong nháy mắt một năm trôi qua, ngành công nghiệp AI đã trải qua những biến đổi và tiến hóa to lớn. Khi nhìn lại những thay đổi trong năm qua tại buổi ra mắt, ông Jensen Huang đã đặc biệt nhắc đến các mô hình mã nguồn mở.

Ông nói, các mô hình suy luận mã nguồn mở như DeepSeek R1 đã khiến toàn ngành nhận ra rằng: khi sự cởi mở và hợp tác toàn cầu thực sự được khởi động, tốc độ lan tỏa của AI sẽ cực kỳ nhanh. Mặc dù các mô hình mã nguồn mở vẫn chậm hơn khoảng nửa năm so với các mô hình tiên tiến nhất về tổng thể năng lực, nhưng cứ sau sáu tháng lại thu hẹp khoảng cách một lần, và lượng tải xuống cũng như sử dụng đã tăng trưởng bùng nổ.

So với việc trình diễn nhiều hơn về tầm nhìn và khả năng vào năm 2025, lần này NVIDIA bắt đầu có hệ thống trong việc giải quyết vấn đề "làm thế nào để thực hiện": xoay quanh AI suy luận, bổ sung cơ sở hạ tầng tính toán, mạng lưới và lưu trữ cần thiết cho vận hành dài hạn, giảm đáng kể chi phí suy luận, và nhúng trực tiếp những khả năng này vào các kịch bản thực tế như lái xe tự động và robot.

Bài phát biểu của ông Jensen Huang tại CES lần này xoay quanh ba chủ đề chính:

● Ở cấp độ hệ thống và cơ sở hạ tầng, NVIDIA đã tái cấu trúc kiến trúc tính toán, mạng lưới và lưu trữ xung quanh nhu cầu suy luận dài hạn. Với nền tảng Rubin, NVLink 6, Ethernet Spectrum-X và nền tảng lưu trữ bộ nhớ ngữ cảnh suy luận làm cốt lõi, những cập nhật này nhắm thẳng vào các điểm nghẽn như chi phí suy luận cao, ngữ cảnh khó duy trì và hạn chế về quy mô hóa, giải quyết vấn đề AI suy nghĩ lâu hơn một chút, tính toán được và chạy lâu dài.

● Ở cấp độ mô hình, NVIDIA đặt AI suy luận (Reasoning / Agentic AI) vào vị trí trung tâm. Thông qua các mô hình và công cụ như Alpamayo, Nemotron, Cosmos Reason, thúc đẩy AI chuyển từ "tạo ra nội dung" sang có thể suy nghĩ liên tục, từ "mô hình phản hồi một lần" sang "tác nhân thông minh có thể làm việc lâu dài".

● Ở cấp độ ứng dụng và triển khai thực tế, những khả năng này được đưa trực tiếp vào các kịch bản AI vật lý như lái xe tự động và robot. Dù là hệ thống lái xe tự động được cung cấp bởi Alpamayo, hay hệ sinh thái robot GR00T với Jetson, đều đang thúc đẩy triển khai quy mô thông qua hợp tác với các nhà cung cấp dịch vụ đám mây và nền tảng doanh nghiệp.

01 Từ lộ trình đến sản xuất hàng loạt: Rubin lần đầu tiên tiết lộ đầy đủ dữ liệu hiệu năng

Tại CES lần này, NVIDIA lần đầu tiên tiết lộ đầy đủ chi tiết kỹ thuật của kiến trúc Rubin.

Trong bài phát biểu, ông Jensen Huang bắt đầu với Test-time Scaling (mở rộng khi suy luận), khái niệm này có thể hiểu là, muốn AI trở nên thông minh hơn, không còn chỉ là khiến nó "đọc sách chăm chỉ hơn", mà dựa vào việc "suy nghĩ lâu hơn một chút khi gặp vấn đề".

Trước đây, việc nâng cao năng lực của AI chủ yếu dựa vào việc đổ thêm sức mạnh tính toán ở giai đoạn huấn luyện, làm cho mô hình ngày càng lớn hơn; còn bây giờ, sự thay đổi mới là dù mô hình không tiếp tục lớn thêm, chỉ cần mỗi lần sử dụng cho nó thêm một chút thời gian và sức mạnh tính toán để suy nghĩ, kết quả cũng có thể trở nên tốt hơn rõ rệt.

Làm thế nào để việc "AI suy nghĩ lâu hơn một chút" trở nên khả thi về kinh tế? Nền tảng tính toán AI thế hệ mới với kiến trúc Rubin chính là để giải quyết vấn đề này.

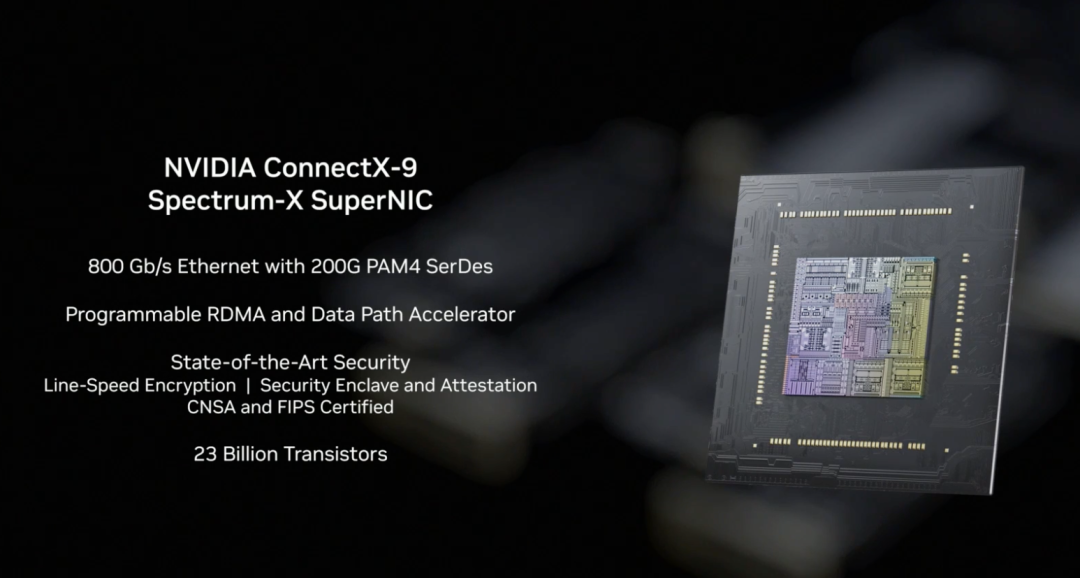

Ông Jensen Huang giới thiệu, đây là một hệ thống tính toán AI thế hệ tiếp theo hoàn chỉnh, thông qua thiết kế phối hợp của CPU Vera, GPU Rubin, NVLink 6, ConnectX-9, BlueField-4, Spectrum-6, nhằm đạt được sự sụt giảm mang tính cách mạng về chi phí suy luận.

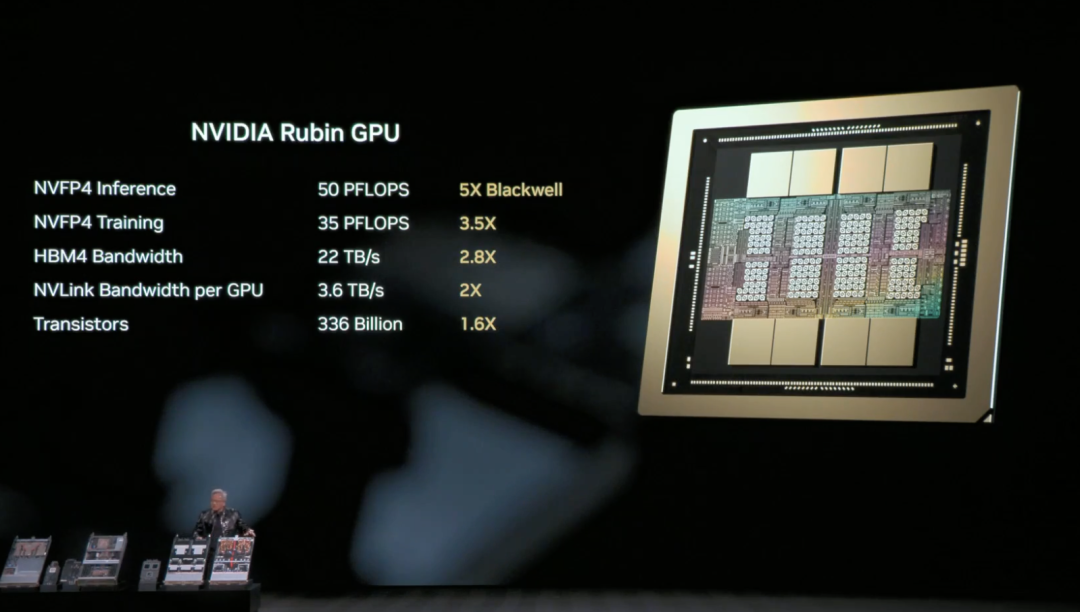

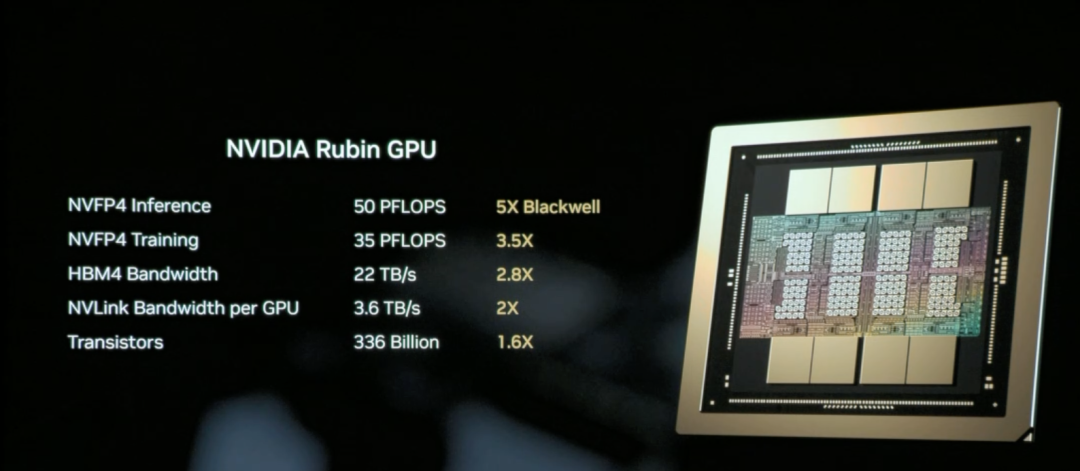

GPU Rubin của NVIDIA là chip lõi chịu trách nhiệm tính toán AI trong kiến trúc Rubin, mục tiêu là giảm đáng kể chi phí đơn vị cho suy luận và huấn luyện.

Nói một cách đơn giản, nhiệm vụ cốt lõi của GPU Rubin là "khiến AI sử dụng tiết kiệm hơn, thông minh hơn".

Năng lực cốt lõi của GPU Rubin nằm ở: cùng một GPU có thể làm được nhiều việc hơn. Nó có thể xử lý nhiều tác vụ suy luận hơn trong một lần, ghi nhớ ngữ cảnh dài hơn, và giao tiếp với các GPU khác cũng nhanh hơn, điều này có nghĩa là nhiều kịch bản trước đây phải dựa vào "xếp chồng nhiều card cứng", giờ đây có thể hoàn thành với ít GPU hơn.

Kết quả là, suy luận không chỉ nhanh hơn, mà còn rõ ràng rẻ hơn.

Ông Jensen Huang tại hiện trường đã ôn lại các thông số phần cứng NVL72 của kiến trúc Rubin: bao gồm 220 nghìn tỷ bóng bán dẫn, băng thông 260 TB/giây, là nền tảng đầu tiên trong ngành hỗ trợ tính toán bảo mật quy mô giá đỡ.

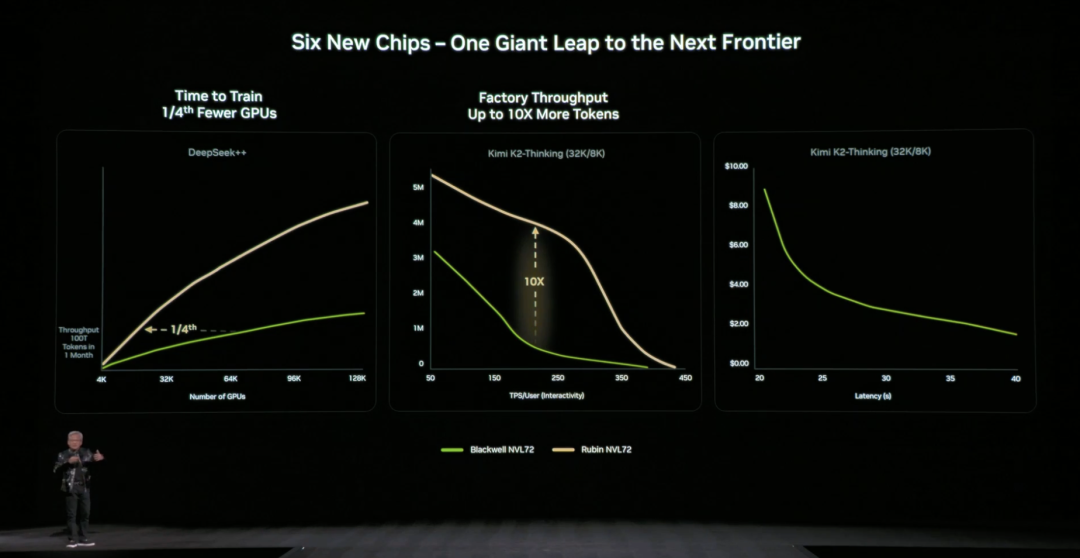

Nhìn tổng thể, so với Blackwell, GPU Rubin đạt được bước nhảy vọt liên thế hệ trên các chỉ số quan trọng: hiệu năng suy luận NVFP4 tăng lên 50 PFLOPS (gấp 5 lần), hiệu năng huấn luyện tăng lên 35 PFLOPS (gấp 3.5 lần), băng thông bộ nhớ HBM4 tăng lên 22 TB/s (gấp 2.8 lần), băng thông kết nối NVLink trên một GPU tăng gấp đôi lên 3.6 TB/s.

Những cải tiến này cùng tác động, khiến một GPU đơn lẻ có thể xử lý nhiều tác vụ suy luận hơn và ngữ cảnh dài hơn, từ căn bản giảm sự phụ thuộc vào số lượng GPU.

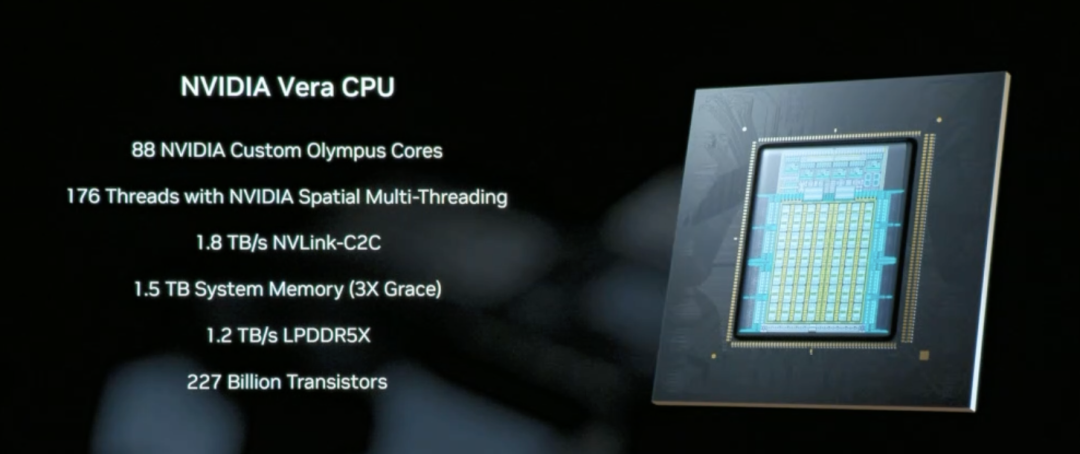

CPU Vera là thành phần lõi được thiết kế chuyên biệt cho việc di chuyển dữ liệu và xử lý Agentic, sử dụng 88 lõi Olympus tự nghiên cứu của NVIDIA, trang bị 1.5 TB bộ nhớ hệ thống (gấp 3 lần CPU Grace thế hệ trước), thông qua công nghệ NVLink-C2C 1.8 TB/s để đạt được truy cập bộ nhớ nhất quán giữa CPU và GPU.

Khác với CPU đa dụng truyền thống, Vera tập trung vào việc điều phối dữ liệu và xử lý logic suy luận nhiều bước trong kịch bản suy luận AI, về bản chất là người điều phối hệ thống giúp việc "AI suy nghĩ lâu hơn một chút" có thể vận hành hiệu quả.

NVLink 6 thông qua băng thông 3.6 TB/s và khả năng tính toán trong mạng, cho phép 72 GPU trong kiến trúc Rubin có thể làm việc phối hợp như một siêu GPU, đây là cơ sở hạ tầng then chốt để đạt được việc giảm chi phí suy luận.

Như vậy, dữ liệu và kết quả trung gian mà AI cần khi suy luận có thể lưu chuyển nhanh chóng giữa các GPU, không cần chờ đợi, sao chép hoặc tính toán lại nhiều lần.

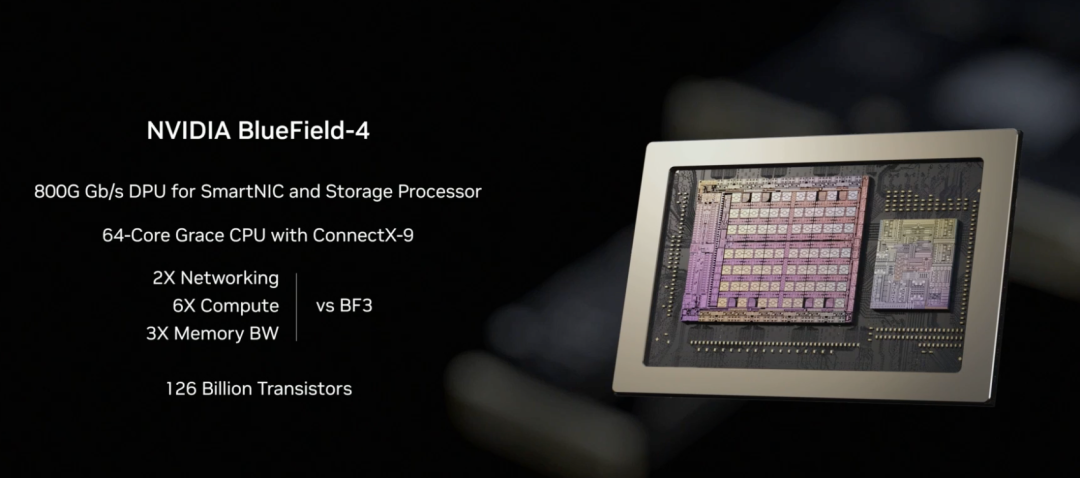

Trong kiến trúc Rubin, NVLink-6 chịu trách nhiệm tính toán phối hợp nội bộ GPU, BlueField-4 chịu trách nhiệm điều phối ngữ cảnh và dữ liệu, còn ConnectX-9 thì đảm nhận kết nối mạng tốc độ cao của hệ thống ra bên ngoài. Nó đảm bảo hệ thống Rubin có thể giao tiếp hiệu quả với các giá đỡ, trung tâm dữ liệu và nền tảng đám mây khác, là điều kiện tiên quyết để các tác vụ huấn luyện và suy luận quy mô lớn vận hành trơn tru.

So với kiến trúc thế hệ trước, NVIDIA cũng đưa ra dữ liệu cụ thể trực quan: so với nền tảng NVIDIA Blackwell, có thể giảm chi phí token ở giai đoạn suy luận tối đa 10 lần, và giảm số lượng GPU cần thiết để huấn luyện mô hình chuyên gia hỗn hợp (MoE) xuống còn 1/4 so với trước đây.

NVIDIA chính thức cho biết, hiện tại Microsoft đã cam kết triển khai hàng trăm nghìn chip Vera Rubin trong siêu nhà máy AI Fairwater thế hệ tiếp theo, các nhà cung cấp dịch vụ đám mây như CoreWeave sẽ cung cấp các instance Rubin vào nửa cuối năm 2026, cơ sở hạ tầng "khiến AI suy nghĩ lâu hơn một chút" này đang đi từ trình diễn kỹ thuật sang thương mại hóa quy mô.

02 "Điểm nghẽn lưu trữ" được giải quyết như thế nào?

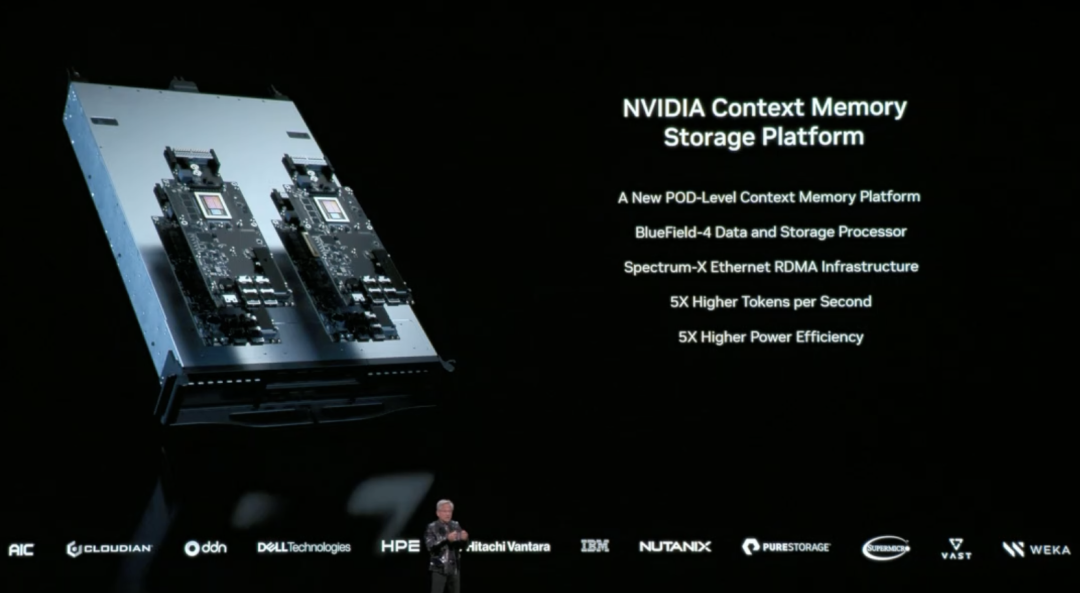

Việc khiến AI "suy nghĩ lâu hơn một chút" còn đối mặt với một thách thức kỹ thuật then chốt: dữ liệu ngữ cảnh nên được đặt ở đâu?

Khi AI xử lý các nhiệm vụ phức tạp cần đối thoại nhiều vòng, suy luận nhiều bước, sẽ tạo ra lượng lớn dữ liệu ngữ cảnh (KV Cache). Kiến trúc truyền thống hoặc là nhét chúng vào bộ nhớ GPU đắt đỏ và dung lượng hạn chế, hoặc là đưa vào lưu trữ thông thường (truy cập quá chậm). "Điểm nghẽn lưu trữ" này nếu không giải quyết, GPU mạnh đến đâu cũng sẽ bị kéo lùi.

Để giải quyết vấn đề này, tại CES lần này, NVIDIA lần đầu tiên tiết lộ đầy đủ nền tảng lưu trữ bộ nhớ ngữ cảnh suy luận (Inference Context Memory Storage Platform) được cung cấp bởi BlueField-4, mục tiêu cốt lõi là tạo ra một "lớp thứ ba" giữa bộ nhớ GPU và lưu trữ truyền thống. Vừa đủ nhanh, vừa có dung lượng dồi dào, lại có thể hỗ trợ AI vận hành lâu dài.

Xét về mặt thực hiện kỹ thuật, nền tảng này không phải là một thành phần đơn lẻ phát huy tác dụng, mà là kết quả của một bộ thiết kế phối hợp:

- BlueField-4 chịu trách nhiệm tăng tốc quản lý và truy cập dữ liệu ngữ cảnh ở cấp phần cứng, giảm việc di chuyển dữ liệu và chi phí hệ thống;

- Ethernet Spectrum-X cung cấp mạng lưới hiệu năng cao, hỗ trợ chia sẻ dữ liệu tốc độ cao dựa trên RDMA;

- Các thành phần phần mềm như DOCA, NIXL và Dynamo, thì chịu trách nhiệm tối ưu hóa điều phối, giảm độ trễ, nâng cao thông lượng tổng thể ở cấp hệ thống.

Chúng ta có thể hiểu rằng, cách làm của bộ nền tảng này là mở rộng dữ liệu ngữ cảnh vốn chỉ có thể đặt trong bộ nhớ GPU, sang một "lớp ký ức" độc lập, tốc độ cao, có thể chia sẻ. Một mặt giải phóng áp lực cho GPU, mặt khác lại có thể nhanh chóng chia sẻ thông tin ngữ cảnh này giữa nhiều node, nhiều tác nhân thông minh AI.

Về hiệu quả thực tế, dữ liệu mà NVIDIA chính thức đưa ra là: trong các kịch bản cụ thể, cách này có thể làm tăng số token xử lý mỗi giây lên tối đa 5 lần, và đạt được mức tối ưu hóa hiệu suất năng lượng tương đương.

Ông Jensen Huang trong buổi ra mắt đã nhiều lần nhấn mạnh, AI đang tiến hóa từ "chatbot đối thoại một lần", thành tác nhân hợp tác thông minh thực sự: chúng cần hiểu thế giới thực, suy luận liên tục, gọi công cụ để hoàn thành nhiệm vụ, và đồng thời lưu giữ trí nhớ ngắn hạn và dài hạn. Đây chính là đặc trưng cốt lõi của Agentic AI. Nền tảng lưu trữ bộ nhớ ngữ cảnh suy luận, được thiết kế chính cho hình thái AI vận hành lâu dài, suy nghĩ lặp lại này, thông qua việc mở rộng dung lượng ngữ cảnh, tăng tốc chia sẻ xuyên node, khiến đối thoại nhiều vòng và hợp tác đa tác nhân thông minh trở nên ổn định hơn, không còn "chạy càng lâu càng chậm".

03

DGX SuperPOD thế hệ mới: Khiến 576 GPU làm việc phối hợp

NVIDIA tại CES lần này đã công bố ra mắt DGX SuperPOD (siêu node) thế hệ mới dựa trên kiến trúc Rubin, mở rộng Rubin từ một giá đỡ đơn lẻ sang giải pháp hoàn chỉnh cho toàn bộ trung tâm dữ liệu.

DGX SuperPOD là gì?

Nếu nói Rubin NVL72 là một "siêu giá đỡ" chứa 72 GPU, thì DGX SuperPOD chính là kết nối nhiều giá đỡ như vậy lại với nhau, hình thành một cụm tính toán AI quy mô lớn hơn. Phiên bản được công bố lần này bao gồm 8 giá đỡ Vera Rubin NVL72, tương đương với 576 GPU làm việc phối hợp.

Khi quy mô nhiệm vụ AI tiếp tục mở rộng, 576 GPU của một giá đỡ đơn lẻ có thể vẫn chưa đủ. Ví dụ như huấn luyện mô hình siêu quy mô lớn, đồng thời phục vụ hàng nghìn tác nhân thông minh Agentic AI, hoặc xử lý các nhiệm vụ phức tạp cần ngữ cảnh hàng triệu token. Lúc này cần nhiều giá đỡ phối hợp làm việc, và DGX SuperPOD chính là giải pháp tiêu chuẩn hóa được thiết kế cho kịch bản này.

Đối với doanh nghiệp và nhà cung cấp dịch vụ đám mây, DGX SuperPOD cung cấp một giải pháp cơ sở hạ

Chào mừng tham gia cộng đồng chính thức TechFlow

Nhóm Telegram:https://t.me/TechFlowDaily

Tài khoản Twitter chính thức:https://x.com/TechFlowPost

Tài khoản Twitter tiếng Anh:https://x.com/BlockFlow_News