Ngoài việc kiếm tiền và xây dựng câu chuyện, Crypto còn có thể làm được gì cho AI?

Tuyển chọn TechFlowTuyển chọn TechFlow

Ngoài việc kiếm tiền và xây dựng câu chuyện, Crypto còn có thể làm được gì cho AI?

Trong lĩnh vực AI, có nhiều vấn đề cơ bản có thể được giải quyết thông qua công nghệ mã hóa.

Tác giả: Pavel Paramonov

Biên dịch: TechFlow

Người sáng lập Curve Finance @newmichwill gần đây đã tweet rằng mục đích chính của tiền mã hóa là DeFi (tài chính phi tập trung), và AI (trí tuệ nhân tạo) thực sự không cần đến tiền mã hóa. Dù tôi đồng ý rằng DeFi là một phần quan trọng trong lĩnh vực tiền mã hóa, tôi lại không đồng tình với quan điểm cho rằng AI không cần tiền mã hóa.

Cùng với sự nổi lên của các tác nhân AI (AI agents), nhiều tác nhân thường đi kèm một token, điều này khiến mọi người lầm tưởng rằng giao điểm giữa tiền mã hóa và AI chỉ đơn thuần là các tác nhân AI. Một chủ đề quan trọng khác bị bỏ qua là “AI phi tập trung”, có liên hệ mật thiết đến việc huấn luyện mô hình AI.

Tôi không hài lòng với một số câu chuyện kể vì đa số người dùng thường mù quáng cho rằng bất cứ thứ gì đang thịnh hành thì nhất định quan trọng và hữu ích, thậm chí tệ hơn, họ nghĩ mục tiêu duy nhất của những câu chuyện đó là tận dụng giá trị càng nhiều càng tốt (nói cách khác là kiếm tiền).

Khi thảo luận về AI phi tập trung, trước tiên chúng ta nên tự hỏi: Tại sao AI cần được phi tập trung? Và điều này sẽ dẫn đến hậu quả gì?

Thực tế cho thấy, khái niệm "đồng bộ hóa động lực" (incentive alignment) gần như luôn gắn liền với tư tưởng phi tập trung.

Trong lĩnh vực AI, có rất nhiều vấn đề cơ bản có thể được giải quyết bằng công nghệ mã hóa, thậm chí một số cơ chế không chỉ giải quyết các vấn đề hiện tại mà còn gia tăng độ tin cậy cho AI.

Vậy tại sao AI lại cần tiền mã hóa?

1. Chi phí tính toán cao hạn chế sự tham gia và đổi mới

Bất kể may mắn hay không, các mô hình AI lớn đòi hỏi lượng tài nguyên tính toán khổng lồ, điều này tự nhiên làm hạn chế sự tham gia của nhiều người dùng tiềm năng. Trong hầu hết trường hợp, mô hình AI cần dữ liệu quy mô lớn cùng khả năng tính toán thực tế – điều mà cá nhân riêng lẻ gần như không thể đảm đương.

Vấn đề này đặc biệt nổi bật trong phát triển mã nguồn mở. Người đóng góp không chỉ phải đầu tư thời gian để huấn luyện mô hình mà còn phải đầu tư tài nguyên tính toán, khiến hiệu suất phát triển mã nguồn mở trở nên thấp kém.

Thật vậy, cá nhân có thể đầu tư nhiều tài nguyên để vận hành mô hình AI, giống như người dùng có thể phân bổ tài nguyên tính toán để chạy nút blockchain riêng của họ.

Tuy nhiên, điều này không giải quyết được gốc rễ vấn đề, vì sức mạnh tính toán vẫn không đủ để hoàn thành nhiệm vụ.

Nhà phát triển hoặc nhà nghiên cứu độc lập không thể tham gia vào việc phát triển các mô hình AI lớn như LLaMA chỉ vì họ không đủ khả năng chi trả chi phí tính toán để huấn luyện mô hình: cần hàng chục ngàn GPU, trung tâm dữ liệu và hạ tầng bổ sung.

Dưới đây là một vài con số minh họa quy mô:

→ Elon Musk cho biết mô hình Grok 3 mới nhất được huấn luyện bằng 100.000 chip Nvidia H100.

→ Mỗi con chip trị giá khoảng 30.000 USD.

→ Tổng chi phí chip AI dùng để huấn luyện Grok 3 vào khoảng 3 tỷ USD.

Vấn đề này ở một mức độ nào đó tương tự quá trình xây dựng doanh nghiệp khởi nghiệp, khi cá nhân có thể sở hữu thời gian, năng lực kỹ thuật và kế hoạch thực thi, nhưng lại thiếu nguồn lực ban đầu để hiện thực hóa tầm nhìn.

Như @dbarabander đã chỉ ra, các dự án phần mềm mã nguồn mở truyền thống chỉ yêu cầu người đóng góp tặng thời gian, trong khi các dự án AI mã nguồn mở lại cần cả thời gian lẫn tài nguyên lớn như sức mạnh tính toán và dữ liệu.

Chỉ dựa vào thiện chí và nỗ lực tình nguyện là chưa đủ để khuyến khích đủ nhiều cá nhân hoặc nhóm cung cấp các tài nguyên đắt đỏ này. Cần có cơ chế khuyến khích bổ sung để thúc đẩy sự tham gia.

2. Công nghệ mã hóa là công cụ tốt nhất để đạt được sự đồng bộ hóa động lực

"Đồng bộ hóa động lực" nghĩa là thiết lập các quy tắc nhằm khuyến khích người tham gia vừa đóng góp cho hệ thống, vừa thu được lợi ích cá nhân.

Công nghệ mã hóa đã có vô số ví dụ thành công trong việc giúp các hệ thống khác đạt được sự đồng bộ hóa động lực, và một ví dụ nổi bật là ngành mạng cơ sở hạ tầng vật lý phi tập trung (DePIN), nơi khái niệm này được áp dụng hoàn hảo.

Ví dụ, các dự án như @helium và @rendernetwork đã trở thành biểu tượng nhờ thực hiện thành công việc đồng bộ hóa động lực thông qua mạng các nút phân tán và mạng GPU.

Vậy tại sao chúng ta không thể áp dụng mô hình này vào lĩnh vực AI để làm cho hệ sinh thái trở nên cởi mở và dễ tiếp cận hơn?

Thực tế là chúng ta hoàn toàn có thể.

Trọng tâm thúc đẩy Web3 và công nghệ mã hóa là khái niệm “quyền sở hữu”.

Bạn sở hữu dữ liệu của mình, bạn sở hữu động lực của mình, và thậm chí khi nắm giữ một số token nhất định, bạn cũng sở hữu một phần mạng lưới. Việc trao quyền sở hữu cho những người cung cấp tài nguyên sẽ khuyến khích họ đóng góp tài sản của mình cho dự án, với kỳ vọng nhận được phần thưởng từ thành công của mạng.

Để AI trở nên phổ cập hơn, công nghệ mã hóa là giải pháp tối ưu. Các nhà phát triển có thể tự do chia sẻ thiết kế mô hình giữa các dự án, trong khi những người cung cấp tính toán và dữ liệu có thể đổi tài nguyên lấy cổ phần sở hữu (động lực).

3. Đồng bộ hóa động lực gắn liền với khả năng xác minh

Nếu hình dung một hệ thống AI phi tập trung với cơ chế đồng bộ hóa động lực phù hợp, nó nên thừa hưởng một số đặc điểm từ cơ chế blockchain điển hình:

-

Hiệu ứng mạng (Network Effects).

-

Yêu cầu khởi đầu thấp, các nút có thể được hoàn vốn thông qua lợi nhuận trong tương lai.

-

Cơ chế phạt (Slashing Mechanisms), xử phạt những hành vi xấu.

Đặc biệt với cơ chế phạt, chúng ta cần khả năng xác minh. Nếu không thể xác minh ai là kẻ xấu, sẽ không thể xử phạt, khiến hệ thống dễ bị lợi dụng bởi những kẻ gian lận, đặc biệt trong bối cảnh cộng tác giữa các nhóm.

Trong hệ thống AI phi tập trung, khả năng xác minh cực kỳ quan trọng vì chúng ta không có điểm tin cậy tập trung. Thay vào đó, chúng ta theo đuổi một hệ thống không cần tin cậy nhưng có thể xác minh. Dưới đây là các thành phần có thể cần xác minh:

-

Giai đoạn đánh giá chuẩn hóa (Benchmark Phase): Hệ thống vượt trội hơn các hệ thống khác trên một số chỉ số (ví dụ x, y, z).

-

Giai đoạn suy luận (Inference Phase): Hệ thống hoạt động đúng, tức là giai đoạn "suy nghĩ" của AI.

-

Giai đoạn huấn luyện (Training Phase): Hệ thống có được huấn luyện hoặc tinh chỉnh đúng cách hay không.

-

Giai đoạn dữ liệu (Data Phase): Hệ thống có thu thập dữ liệu đúng cách hay không.

Hiện có hàng trăm đội ngũ đang xây dựng dự án trên @eigenlayer, nhưng tôi gần đây nhận thấy sự chú ý dành cho AI ngày càng cao, và tôi tự hỏi điều này có phù hợp với tầm nhìn ban đầu về tái đặt cược (restaking) hay không.

Mọi hệ thống AI muốn đạt được sự đồng bộ hóa động lực đều phải có khả năng xác minh.

Trong trường hợp này, cơ chế phạt tương đương với khả năng xác minh: nếu một hệ thống phi tập trung có thể xử phạt kẻ xấu, điều đó có nghĩa nó có thể nhận diện và xác minh hành vi xấu tồn tại.

Nếu hệ thống có thể xác minh, AI có thể sử dụng công nghệ mã hóa để truy cập tài nguyên tính toán và dữ liệu toàn cầu, từ đó xây dựng các mô hình lớn hơn, mạnh hơn. Bởi vì tài nguyên dồi dào hơn (tính toán + dữ liệu) thường mang lại mô hình tốt hơn (ít nhất là trong thế giới công nghệ hiện tại).

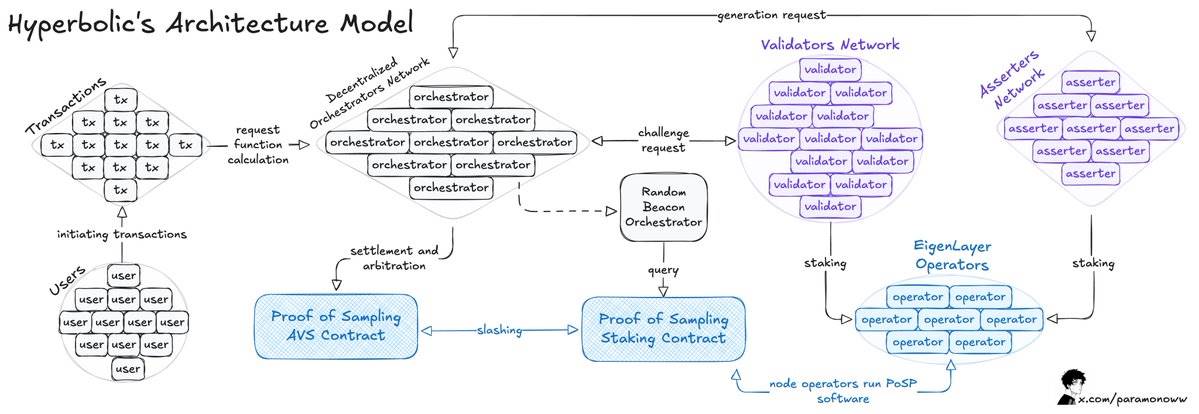

@hyperbolic_labs đã chứng minh tiềm năng của việc cộng tác tài nguyên tính toán. Bất kỳ người dùng nào cũng có thể thuê GPU để huấn luyện các mô hình AI phức tạp hơn so với khả năng vận hành tại nhà, với chi phí thấp hơn.

Làm thế nào để việc xác minh AI vừa hiệu quả vừa có thể xác minh?

Có người có thể nói rằng hiện nay đã có nhiều giải pháp điện toán đám mây cho thuê GPU, và vấn đề tài nguyên tính toán coi như đã được giải quyết.

Tuy nhiên, các giải pháp đám mây như AWS hay Google Cloud mang tính tập trung cao độ và áp dụng chiến lược "danh sách chờ" (Waitlist Strategy), cố tình tạo ra ảo giác về nhu cầu cao để đẩy giá lên. Hiện tượng này đặc biệt phổ biến trong cấu trúc độc quyền nhỏ trong lĩnh vực này.

Thực tế, có rất nhiều tài nguyên GPU đang nằm không tại các trung tâm dữ liệu, mỏ đào tiền mã hóa, thậm chí trong tay cá nhân, những tài nguyên này hoàn toàn có thể đóng góp cho việc tính toán huấn luyện mô hình AI nhưng lại đang bị lãng phí.

Bạn có thể đã nghe về @getgrass_io, nền tảng cho phép người dùng bán băng thông chưa sử dụng cho doanh nghiệp, tránh lãng phí tài nguyên và nhận phần thưởng tương ứng.

Tôi không nói rằng tài nguyên tính toán là vô hạn, nhưng mọi hệ thống đều có thể được tối ưu hóa để đạt được đôi bên cùng có lợi: một mặt, cung cấp thị trường mở hơn cho những người cần thêm tài nguyên để huấn luyện mô hình AI; mặt khác, giúp những người đóng góp tài nguyên nhận được phần thưởng xứng đáng.

Đội ngũ Hyperbolic đã phát triển một thị trường GPU mở. Tại đây, người dùng có thể thuê GPU để huấn luyện mô hình AI, tiết kiệm tới 75% chi phí, trong khi người cung cấp GPU có thể thương mại hóa tài nguyên nhàn rỗi và kiếm lợi nhuận.

Dưới đây là sơ đồ hoạt động của nó:

Hyperbolic tổ chức các GPU kết nối thành cụm và nút, cho phép khả năng tính toán mở rộng theo nhu cầu.

Hạt nhân kiến trúc mô hình là hệ thống “Bằng chứng lấy mẫu” (Proof of Sampling), nổi bật với việc xử lý giao dịch theo dạng lấy mẫu: bằng cách chọn và xác minh ngẫu nhiên các giao dịch, giảm tải khối lượng công việc và nhu cầu tính toán.

Vấn đề chính xuất hiện trong quá trình suy luận (Inference) của AI, khi mỗi lần suy luận chạy trên mạng đều cần được xác minh, và tốt nhất là tránh gây thêm chi phí tính toán đáng kể từ các cơ chế khác.

Như tôi đã nói trước đó, nếu một hành động có thể được xác minh, thì khi kết quả xác minh cho thấy hành vi vi phạm quy tắc, bắt buộc phải xử phạt (Slashing).

Khi Hyperbolic áp dụng mô hình AVS (Hệ thống Xác minh Thích ứng - Adaptive Verification System), họ tăng thêm tính xác minh cho hệ thống. Trong mô hình này, người xác minh được chọn ngẫu nhiên để kiểm tra kết quả đầu ra, từ đó đạt được sự đồng bộ hóa động lực – trong cơ chế này, hành vi gian dối là không sinh lời.

Để huấn luyện một mô hình AI và làm cho nó hoàn thiện hơn, chủ yếu cần hai tài nguyên: khả năng tính toán và dữ liệu. Thuê khả năng tính toán là một giải pháp, nhưng chúng ta vẫn cần tìm nguồn dữ liệu, và cần dữ liệu đa dạng để tránh định kiến trong mô hình.

Xác minh dữ liệu từ nhiều nguồn cho AI

Dữ liệu càng nhiều, mô hình càng tốt; nhưng vấn đề là, bạn thường cần dữ liệu đa dạng. Đây là một thách thức lớn đối với mô hình AI.

Các giao thức dữ liệu đã tồn tại hàng thập kỷ. Dù dữ liệu công khai hay riêng tư, các nhà môi giới dữ liệu luôn thu thập theo một cách nào đó, có thể trả phí hoặc không, rồi bán lại để thu lợi nhuận.

Chúng ta gặp các vấn đề khi thu thập dữ liệu phù hợp cho mô hình AI: điểm lỗi đơn lẻ (single point of failure), kiểm duyệt, và thiếu cách thức không cần tin cậy để cung cấp dữ liệu thật và đáng tin cậy để "nuôi" mô hình AI.

Vậy ai cần loại dữ liệu này?

Đầu tiên là các nhà nghiên cứu và nhà phát triển AI, họ muốn huấn luyện và suy luận mô hình của mình với đầu vào thực tế và phù hợp.

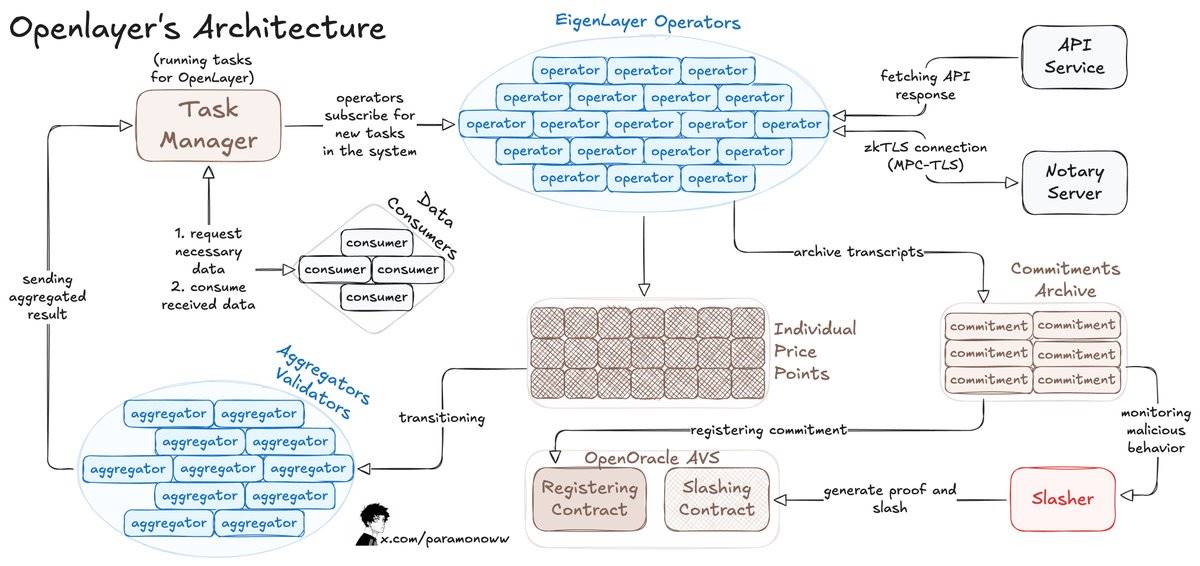

Ví dụ, OpenLayer cho phép bất kỳ ai thêm luồng dữ liệu vào hệ thống hoặc mô hình AI mà không cần cho phép trước, và hệ thống có thể ghi lại từng dòng dữ liệu sẵn có theo cách có thể xác minh.

OpenLayer còn sử dụng zkTLS (giao thức bảo mật lớp truyền tải không kiến thức), điều này tôi đã mô tả chi tiết trong bài viết trước. Giao thức này đảm bảo dữ liệu báo cáo bởi người vận hành thực sự là dữ liệu họ nhận được từ nguồn (khả năng xác minh).

Đây là cách OpenLayer hoạt động:

-

Người tiêu dùng dữ liệu gửi yêu cầu dữ liệu đến hợp đồng thông minh OpenLayer và truy xuất kết quả thông qua API tương tự oracle dữ liệu chính (trên chuỗi hoặc ngoài chuỗi).

-

Người vận hành đăng ký qua EigenLayer để đảm bảo tài sản đặt cược cho AVS OpenLayer và chạy phần mềm AVS.

-

Người vận hành đăng ký nhiệm vụ, xử lý và gửi dữ liệu đến OpenLayer, đồng thời lưu trữ phản hồi gốc và bằng chứng trong lưu trữ phi tập trung.

-

Đối với kết quả biến đổi, bộ tổng hợp (một loại người vận hành đặc biệt) sẽ chuẩn hóa đầu ra.

Các nhà phát triển có thể yêu cầu dữ liệu mới nhất từ bất kỳ trang web nào và đưa nó vào mạng. Nếu bạn đang phát triển dự án liên quan đến AI, bạn có thể nhận được dữ liệu thời gian thực đáng tin cậy.

Sau khi đã thảo luận về quá trình tính toán AI và cách lấy dữ liệu có thể xác minh, bước tiếp theo cần chú ý là hai thành phần cốt lõi của mô hình AI: bản thân việc tính toán và việc xác minh nó.

Việc tính toán AI phải được xác minh để đảm bảo tính đúng đắn

Trong trường hợp lý tưởng, các nút phải chứng minh được đóng góp tính toán của mình để đảm bảo hệ thống hoạt động bình thường.

Trong trường hợp tồi tệ nhất, các nút có thể tuyên bố sai rằng họ đã cung cấp khả năng tính toán, trong khi thực tế không làm bất kỳ công việc thực sự nào.

Yêu cầu các nút chứng minh đóng góp của họ có thể đảm bảo chỉ những người tham gia hợp lệ mới được công nhận, từ đó ngăn chặn hành vi xấu. Cơ chế này rất giống với Proof of Work (Bằng chứng công việc) truyền thống, chỉ khác ở loại công việc mà các nút thực hiện.

Ngay cả khi chúng ta đã tích hợp cơ chế đồng bộ hóa động lực phù hợp vào hệ thống, nếu các nút không thể chứng minh công việc đã hoàn thành một cách không cần cho phép, họ có thể nhận được phần thưởng không tương xứng với đóng góp thực tế, thậm chí có thể dẫn đến phân bổ phần thưởng không công bằng.

Nếu mạng không thể đánh giá được đóng góp tính toán, có thể khiến một số nút được giao nhiệm vụ vượt quá khả năng, trong khi các nút khác lại nằm không, cuối cùng dẫn đến hiệu suất thấp hoặc sự cố hệ thống.

Bằng cách chứng minh đóng góp tính toán, mạng có thể định lượng nỗ lực của từng nút bằng các chỉ số chuẩn hóa (ví dụ FLOPS – số phép tính dấu phẩy động mỗi giây). Cách này cho phép phân bổ phần thưởng dựa trên công việc thực tế hoàn thành, chứ không chỉ dựa trên việc nút có tồn tại trong mạng hay không.

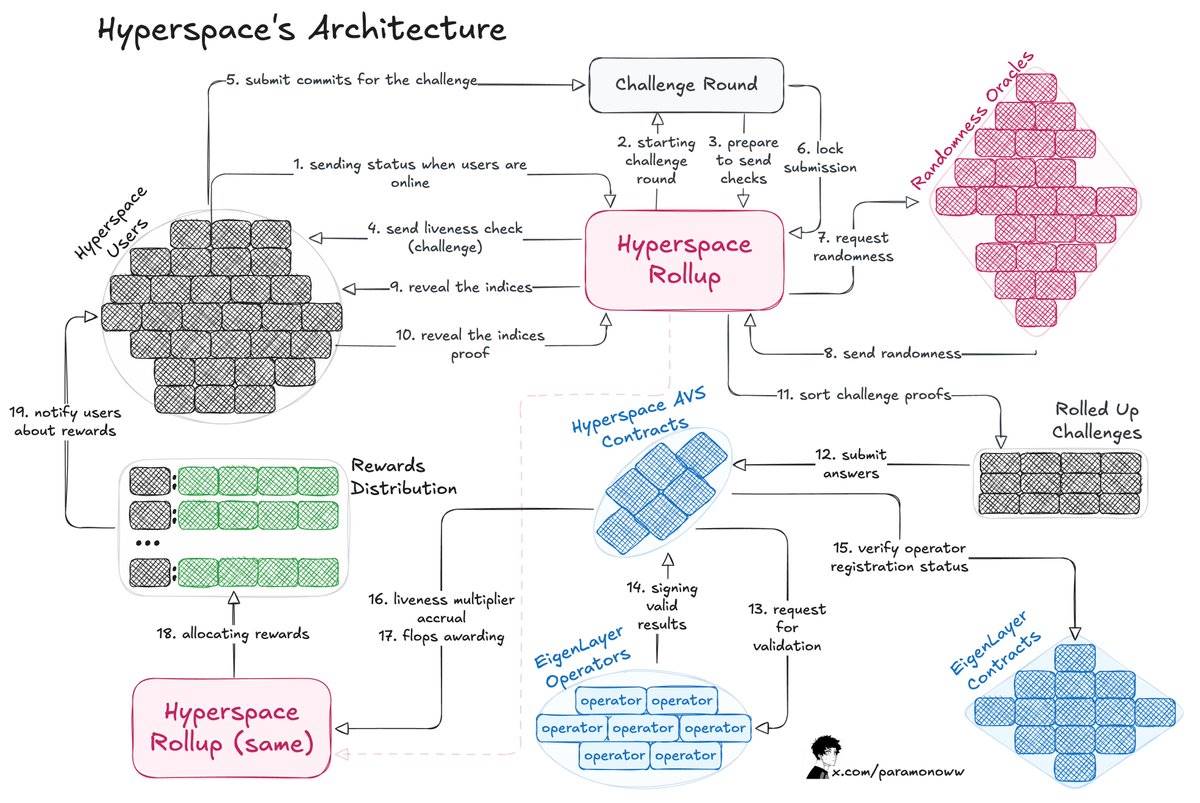

Đội ngũ từ @HyperspaceAI đã phát triển hệ thống “Proof-of-FLOPS” (Bằng chứng FLOPS), cho phép các nút cho thuê khả năng tính toán chưa sử dụng. Đổi lại, họ nhận được điểm “flops”, sẽ trở thành đơn vị tiền tệ chung của mạng.

Cơ chế hoạt động của kiến trúc này như sau:

-

Quy trình bắt đầu bằng việc gửi thử thách đến người dùng, người dùng phản hồi bằng cách nộp cam kết với thử thách.

-

Hyperspace Rollup quản lý quy trình, đảm bảo tính an toàn cho việc nộp và lấy số ngẫu nhiên từ oracle.

-

Người dùng công khai chỉ số, quy trình thử thách hoàn tất.

-

Người vận hành kiểm tra phản hồi và thông báo kết quả hợp lệ đến hợp đồng Hyperspace AVS, sau đó xác nhận kết quả qua hợp đồng EigenLayer.

-

Tính toán hệ số hoạt động (Liveness Multipliers) và cấp điểm flops cho người dùng.

Việc chứng minh đóng góp tính toán cung cấp bức tranh rõ ràng về năng lực từng nút, do đó hệ thống có thể phân bổ nhiệm vụ thông minh – giao các tác vụ tính toán AI phức tạp cho các nút hiệu suất cao, và các tác vụ nhẹ hơn cho các nút có năng lực thấp hơn.

Phần thú vị nhất là làm thế nào để hệ thống này có thể xác minh được, để bất kỳ ai cũng có thể chứng minh tính đúng đắn của công việc đã hoàn thành. Hệ thống AVS của Hyperspace liên tục gửi thử thách, yêu cầu số ngẫu nhiên và thực hiện quy trình xác minh đa tầng, như sơ đồ kiến trúc đã nêu trên.

Người vận hành có thể yên tâm tham gia hệ thống vì kết quả được xác minh và phần thưởng được phân bổ công bằng. Nếu kết quả không đúng, kẻ xấu chắc chắn sẽ bị xử phạt (Slashing).

Có nhiều lý do quan trọng để xác minh kết quả tính toán AI:

-

Khuyến khích các nút tham gia và đóng góp tài nguyên.

-

Phân bổ phần thưởng công bằng theo mức độ nỗ lực.

-

Đảm bảo đóng góp trực tiếp hỗ trợ cho mô hình AI cụ thể.

-

Phân bổ nhiệm vụ hiệu quả dựa trên khả năng xác minh của nút.

AI phi tập trung và khả năng xác minh

Như @yb_effect đã chỉ ra, “phi tập trung” (Decentralized) và “phân tán” (Distributed) là hai khái niệm hoàn toàn khác nhau. Phân tán chỉ nghĩa là phần cứng nằm rải rác ở nhiều vị trí khác nhau, nhưng vẫn có một điểm kết nối tập trung.

Trong khi đó, phi tập trung nghĩa là không có nút chính duy nhất, quá trình huấn luyện có thể xử lý sự cố, tương tự cách hoạt động của phần lớn blockchain hiện nay.

Nếu mạng AI muốn đạt được sự phi tập trung thực sự, cần áp dụng nhiều giải pháp, nhưng điều chắc chắn là, chúng ta cần xác minh gần như mọi thứ.

Nếu bạn muốn xây dựng một mô hình AI hoặc tác nhân AI, bạn cần đảm bảo mọi thành phần và mọi phụ thuộc đều được xác minh.

Suy luận, huấn luyện, dữ liệu, oracle – tất cả những thứ này đều có thể được xác minh, từ đó không chỉ đưa vào hệ thống AI phần thưởng mã hóa tương thích với động lực, mà còn làm cho hệ thống công bằng và hiệu quả hơn.

Chào mừng tham gia cộng đồng chính thức TechFlow

Nhóm Telegram:https://t.me/TechFlowDaily

Tài khoản Twitter chính thức:https://x.com/TechFlowPost

Tài khoản Twitter tiếng Anh:https://x.com/BlockFlow_News