Phỏng vấn mới nhất của David Luan, nhân viên cũ của OpenAI: DeepSeek không thay đổi câu chuyện về công nghệ AI

Tuyển chọn TechFlowTuyển chọn TechFlow

Phỏng vấn mới nhất của David Luan, nhân viên cũ của OpenAI: DeepSeek không thay đổi câu chuyện về công nghệ AI

Thực hiện nhiều trí tuệ hơn với chi phí thấp hơn không có nghĩa là bạn sẽ ngừng theo đuổi trí tuệ.

Tác giả: MD

Xuất bản bởi: Mingliang Company

Gần đây, trong podcast "Unsupervised Learning" của Redpoint Ventures, đối tác Jacob Effron của Redpoint đã phỏng vấn David Luan. Họ đã thảo luận từ góc độ công nghệ về những启示 mà DeepSeek mang lại cho lĩnh vực nghiên cứu và thực tiễn mô hình lớn, đồng thời chia sẻ suy nghĩ về các điểm nghẽn hiện tại của mô hình AI và các hướng đột phá tiềm năng.

David Luan là nhân viên đầu tiên của OpenAI. Sau khi tốt nghiệp Đại học Yale năm 2009, ông gia nhập iRobot làm việc về robot, sau đó từng làm việc tại nhiều công ty (bao gồm Microsoft), trước khi gia nhập OpenAI – lúc đó vẫn còn ở giai đoạn sơ khai – vào năm 2017, khi đội ngũ nghiên cứu chỉ có 35 người. Trong cuộc phỏng vấn này, ông cũng nói rằng lý do ông gia nhập một công ty trí tuệ nhân tạo xuất phát từ niềm đam mê với robot, và ông cho rằng "hạn chế lớn nhất của robot nằm ở mức độ thông minh của thuật toán nền tảng".

Năm 2020, David Luan rời OpenAI để gia nhập Google, nhưng không lâu sau đó, ông cùng hai đồng nghiệp quen biết tại Google đã đồng sáng lập Adept và đảm nhận vai trò CEO. Tháng 8 năm ngoái, ông gia nhập Amazon, trở thành người đứng đầu Phòng thí nghiệm AGI tại San Francisco.

Sau đây là nội dung phỏng vấn do 「Mingliang Company」biên dịch (có lược bỏ một phần nhỏ):

Giới hạn của mô hình lớn và giá trị của học tăng cường

Jacob: David Luan là người đứng đầu phòng thí nghiệm AGI của Amazon. Trước đó, ông là đồng sáng lập và CEO của công ty Adept, nơi đã huy động hơn 400 triệu USD để phát triển AI Agent. Ông từng giữ chức Phó Chủ tịch Kỹ thuật tại OpenAI và tham gia vào nhiều đột phá then chốt. Tôi là Jacob Effron.

Trong chương trình hôm nay, David và tôi đã thảo luận rất nhiều chủ đề thú vị, bao gồm quan điểm của ông về DeepSeek, dự đoán về sự tiến bộ của các mô hình trong tương lai, chúng tôi đã trao đổi về trạng thái hiện tại của Agent và cách làm cho chúng đáng tin cậy hơn, cũng như thời điểm chúng sẽ trở nên phổ biến khắp nơi. Ông ấy còn chia sẻ một số câu chuyện thú vị về giai đoạn đầu của OpenAI và văn hóa độc đáo nơi đây. Đây là một cuộc trò chuyện cực kỳ thú vị, vì David và tôi đã quen biết nhau hơn mười năm rồi. Tôi nghĩ khán giả sẽ rất thích. Cảm ơn bạn đã đến với podcast của chúng tôi, David.

David: Cảm ơn vì lời mời. Điều này sẽ rất thú vị, vì chúng ta đã quen biết nhau hơn mười năm rồi.

Jacob: Tôi nhớ lần đầu bạn gia nhập OpenAI, tôi thấy điều đó dường như rất thú vị, nhưng tôi không chắc liệu đây có phải lựa chọn nghề nghiệp sáng suốt hay không. Rõ ràng là, bạn luôn nhìn thấy cơ hội sớm hơn người khác.

David: Tôi thật sự may mắn vì tôi luôn yêu thích robot, mà (lúc đó) giới hạn lớn nhất của robot nằm ở mức độ thông minh của thuật toán nền tảng. Vì vậy, tôi bắt đầu làm việc trong lĩnh vực trí tuệ nhân tạo, được chứng kiến những tiến bộ công nghệ này trong đời mình thật sự rất tuyệt vời.

Jacob: Hôm nay tôi muốn thảo luận với bạn rất nhiều chủ đề. Tôi muốn bắt đầu bằng chủ đề nóng gần đây. Rõ ràng là, phản ứng với DeepSeek trong vài tuần qua rất mạnh mẽ. Mọi người bàn tán xôn xao, cổ phiếu sụt giảm. Có người nói điều này bất lợi cho OpenAI và Anthropic. Tôi cảm giác tâm lý mọi người hiện giờ đã dịu đi so với cơn hoảng loạn ban đầu. Nhưng tôi tò mò, trong các cuộc thảo luận rộng rãi hơn, quan điểm nào về tác động của sự kiện này là đúng, và đâu là sai?

David: Tôi vẫn nhớ buổi sáng hôm đó, mọi người đều đang theo dõi tin tức về DeepSeek. Tôi tỉnh dậy, nhìn vào điện thoại và thấy năm cuộc gọi nhỡ. Tôi tự hỏi chuyện gì xảy ra vậy? Lần cuối cùng tình huống tương tự diễn ra là khi SVB (Ngân hàng Thung lũng Silicon) sụp đổ, vì tất cả nhà đầu tư đều gọi điện bảo tôi rút tiền khỏi SVB và First Republic Bank. Nên tôi nghĩ chắc chắn đã xảy ra điều tồi tệ. Tôi kiểm tra tin tức và phát hiện cổ phiếu sụt giảm là do ra mắt DeepSeek R1. Tôi ngay lập tức nhận ra rằng mọi người hoàn toàn hiểu sai vấn đề. DeepSeek làm rất tốt, nhưng nó là một phần trong câu chuyện lớn hơn—đầu tiên chúng ta học cách làm cho mô hình lớn mới trở nên thông minh hơn, sau đó mới học cách làm cho chúng hiệu quả hơn.

Vì vậy, thực tế đây là một bước ngoặt. Điểm mọi người hiểu sai là, chỉ vì bạn có thể đạt được nhiều trí tuệ hơn với chi phí thấp hơn, không có nghĩa là bạn sẽ ngừng theo đuổi trí tuệ. Ngược lại, bạn sẽ sử dụng nhiều trí tuệ hơn. Vì vậy, khi thị trường nhận ra điều này, hiện giờ chúng ta đã trở lại trạng thái hợp lý.

Jacob: Xét rằng ít nhất các mô hình nền dường như đã được huấn luyện trên nền tảng OpenAI, bạn có thể khiến mô hình DeepSeek hoạt động giống ChatGPT theo nhiều cách khác nhau. Vậy thì, nhìn về tương lai, do nguyên nhân kiến thức phân tách (knowledge distillation), liệu OpenAI và Anthropic có dừng công bố công khai các mô hình này?

David: Tôi nghĩ điều sẽ xảy ra là, mọi người luôn muốn xây dựng những mô hình thông minh nhất, nhưng đôi khi những mô hình đó không phải lúc nào cũng hiệu quả về mặt suy luận. Vì vậy, tôi nghĩ chúng ta sẽ ngày càng thấy rõ hơn, mặc dù mọi người có thể không nói rõ điều này, nhưng họ sẽ huấn luyện những "mô hình thầy giáo" (teacher models) khổng lồ bên trong các phòng thí nghiệm, tận dụng mọi tài nguyên tính toán họ có được. Sau đó họ sẽ cố gắng nén chúng thành những mô hình hiệu quả phù hợp để khách hàng sử dụng.

Vấn đề lớn nhất tôi thấy hiện nay là, tôi hình dung các trường hợp sử dụng AI như những vòng tròn đồng tâm về mức độ phức tạp. Mức độ phức tạp đơn giản nhất có thể là trò chuyện đơn giản với mô hình ngôn ngữ nền tảng, điều mà chúng ta đã làm khá tốt kể từ GPT-2. Mỗi cấp độ trí tuệ bổ sung, ví dụ như có khả năng tính nhẩm, lập trình, hoặc sau này là Agent, thậm chí là phát hiện thuốc, đều cần những mô hình thông minh hơn. Nhưng mỗi cấp độ trí tuệ trước đó gần như trở nên rẻ đến mức có thể lượng tử hóa (quantize, chỉ việc giảm độ chính xác số học của mô hình nhằm giảm tiêu thụ tài nguyên).

Jacob: Điều này khiến tôi nghĩ đến xu hướng tính toán trong quá trình thử nghiệm (test-time compute). Dường như đây là một con đường tiến lên vô cùng hấp dẫn, đặc biệt trong các lĩnh vực dễ kiểm chứng như lập trình, toán học. Mô hình phạm vi này có thể đưa chúng ta đi xa đến đâu?

David: Có một loạt bài báo và podcast ghi lại những thảo luận của tôi trong nhiều năm về cách xây dựng AGI (trí tuệ nhân tạo tổng quát).

Jacob: Hãy thêm chút điều mới mẻ vào những thảo luận này.

David: Vì vậy, bây giờ chúng ta có thể chứng minh rằng chúng ta đã có cuộc trò chuyện này vào khoảnh khắc này. Nhưng ngay từ năm 2020, khi chúng ta bắt đầu thấy sự xuất hiện của GPT-2, có thể GPT-3 đã đang được phát triển hoặc đã hoàn thành. Chúng ta bắt đầu nghĩ về GPT-4, sống trong một thế giới mà mọi người không chắc liệu chỉ cần dự đoán token tiếp theo (next token prediction) có đủ để giải quyết mọi vấn đề AGI hay không.

Quan điểm của tôi, và một số người xung quanh tôi, thực tế là “không”. Lý do là, nếu một mô hình được huấn luyện để dự đoán token tiếp theo, thì về bản chất nó sẽ bị phạt khi phát hiện kiến thức mới, vì kiến thức mới đó không có trong tập dữ liệu huấn luyện. Vì vậy, điều chúng ta cần làm là hãy xem xét các khuôn mẫu học máy khác đã biết, những khuôn mẫu có thể thực sự khám phá ra kiến thức mới. Chúng ta biết học tăng cường (RL) có thể làm được điều này, RL có thể làm điều này trong tìm kiếm, đúng không? Vâng, hoặc như AlphaGo, có lẽ là lần đầu tiên công chúng nhận ra rằng chúng ta có thể dùng RL để khám phá kiến thức mới. Vấn đề luôn là, chúng ta sẽ kết hợp mô hình ngôn ngữ lớn (LLMs) với RL vào lúc nào để xây dựng hệ thống vừa có toàn bộ tri thức nhân loại, vừa có thể xây dựng thêm trên nền tảng đó.

Jacob: Vậy thì, đối với những lĩnh vực khó kiểm chứng, như chăm sóc sức khỏe hoặc pháp lý, mô hình tính toán trong quá trình thử nghiệm này có thể giúp chúng ta xây dựng các mô hình xử lý những vấn đề đó không? Hay chúng ta sẽ trở nên cực kỳ giỏi về lập trình và toán học, nhưng vẫn không thể kể một câu chuyện cười?

David: Đây là một chủ đề đáng tranh luận, tôi có một quan điểm rất rõ ràng.

Jacob: Câu trả lời của anh là gì?

David: Khả năng khái quát hóa của các mô hình này mạnh hơn bạn tưởng tượng. Mọi người đều nói, tôi dùng GPT-1, trông nó giỏi toán hơn, nhưng khi chờ nó suy nghĩ, có thể nó hơi kém hơn ChatGPT hay các mô hình khác. Tôi nghĩ đây chỉ là những khúc quanh nhỏ trên con đường tới sức mạnh lớn hơn. Ngày nay, chúng ta đã thấy một số dấu hiệu cho thấy, bằng cách kiểm chứng rõ ràng liệu mô hình có giải quyết đúng vấn đề hay không (như chúng ta thấy trong DeepSeek), thực sự có thể dẫn đến việc chuyển giao sang các vấn đề mơ hồ hơn một chút trong các lĩnh vực tương tự. Tôi nghĩ mọi người đều đang nỗ lực, nhóm của tôi và các nhóm khác đều đang cố gắng giải quyết vấn đề sở thích của con người trong các nhiệm vụ phức tạp hơn này, để đáp ứng những sở thích đó.

Jacob: Đúng vậy. Và bạn luôn cần có khả năng xây dựng một mô hình để kiểm chứng, ví dụ như “này, đầu ra này là lời khuyên pháp lý tốt” hoặc “đầu ra này là chẩn đoán y tế tốt”, điều này rõ ràng khó hơn nhiều so với việc kiểm chứng một chứng minh toán học hay mã code có chạy được hay không.

David: Tôi nghĩ điều chúng ta đang tận dụng là khoảng cách giữa cái tốt và cái xấu của các mô hình này — khả năng của cùng một bộ trọng số mạng thần kinh trong việc đánh giá bản thân đã hoàn thành công việc tốt hay chưa, so với khả năng sinh ra câu trả lời đúng. Chúng ta luôn thấy các mô hình này mạnh hơn trong việc đánh giá bản thân “đã hoàn thành tốt công việc” so với “sinh ra câu trả lời tốt”. Về cơ bản, chúng ta đang tận dụng điều này, thông qua một số công cụ RL (stuff), để giúp nó tự cảm nhận được liệu mình đã làm tốt một việc hay chưa.

Jacob: Để thực sự ra mắt các mô hình như vậy, cần giải quyết những vấn đề nghiên cứu nào?

David: Có quá nhiều vấn đề, tôi nghĩ tôi chỉ liệt kê ba vấn đề chính. Thứ nhất, tôi cho rằng vấn đề đầu tiên là, bạn cần thực sự biết cách xây dựng một tổ chức và quy trình để tạo ra mô hình một cách đáng tin cậy.

Tôi luôn nói với đội của mình và những người tôi cộng tác rằng, ngày nay, nếu bạn vận hành một phòng thí nghiệm AI hiện đại, công việc của bạn không phải là xây dựng mô hình, mà là xây dựng một nhà máy có thể tạo ra mô hình một cách đáng tin cậy. Khi bạn nghĩ theo cách đó, nó hoàn toàn thay đổi định hướng đầu tư của bạn. Trước khi đạt được khả năng tái tạo, tôi nghĩ ở một mức độ nào đó, chưa có nhiều tiến bộ. Chúng ta vừa trải qua quá trình từ luyện kim thuật sang công nghiệp hóa, cách thức xây dựng các mô hình đã thay đổi. Không có nền tảng này, các mô hình sẽ không hoạt động.

Tôi cho rằng phần tiếp theo là, bạn phải đi chậm để đi nhanh. Nhưng tôi nghĩ đây là phần đầu tiên. Tôi luôn tin rằng, mọi người luôn bị thu hút bởi các thuật toán, vì chúng trông thật ngầu, thật hấp dẫn. Nhưng nếu chúng ta nhìn vào điều gì thực sự thúc đẩy tất cả, đó là vấn đề kỹ thuật. Ví dụ, bạn làm thế nào để thực hiện tính toán quy mô lớn trên cụm máy, để đảm bảo chúng có thể chạy ổn định đủ lâu? Nếu một nút bị sập, bạn sẽ không mất quá nhiều thời gian vào nhiệm vụ của mình. Để thúc đẩy ranh giới quy mô, đây là một vấn đề thực sự.

Bây giờ, toàn bộ lĩnh vực học tăng cường (RL), chúng ta sẽ nhanh chóng bước vào một thế giới nơi có rất nhiều trung tâm dữ liệu, mỗi trung tâm sẽ thực hiện lượng lớn suy luận trên mô hình nền tảng, có thể còn thử nghiệm trong môi trường mới do khách hàng mang đến, để học cách cải thiện mô hình, và phản hồi kiến thức mới này về một vị trí trung tâm, để mô hình học cách trở nên thông minh hơn.

Jacob: Có những người như Yann LeCun gần đây liên tục chỉ trích giới hạn của mô hình ngôn ngữ lớn (LLMs). Tôi muốn bạn tóm tắt quan điểm chỉ trích này cho thính giả của chúng tôi, sau đó chia sẻ quan điểm của bạn về những người nói rằng các mô hình này sẽ không bao giờ có thể suy nghĩ thực sự sáng tạo.

David: Tôi nghĩ chúng ta đã có những phản ví dụ, AlphaGo là một dạng suy nghĩ sáng tạo. Nếu bạn quay lại giai đoạn đầu của OpenAI, chúng tôi sử dụng RL để chơi game Flash, nếu bạn thuộc độ tuổi đó, bạn có thể nhớ MiniClip và những thứ tương tự. Những trò này từng là thú vui thời trung học, nhưng thật thú vị khi thấy chúng trở thành nền tảng cho trí tuệ nhân tạo. Chúng tôi lúc đó đang nghiên cứu cách sử dụng thuật toán của mình để vượt qua các trò chơi này đồng thời, bạn nhanh chóng phát hiện ra chúng học được cách vượt qua nhanh chóng bằng cách khắc phục lỗi xuyên tường, những điều mà con người chưa từng làm.

Jacob: Về kiểm chứng, chủ yếu là tìm ra phương pháp thông minh để kiểm chứng cho các lĩnh vực khác nhau này.

David: Bạn chỉ cần dùng chính mô hình đó thôi.

Cách xây dựng các Agent đáng tin cậy

Jacob: Tôi muốn chuyển sang thế giới Agents. Anh mô tả trạng thái hiện tại của các mô hình này như thế nào?

David: Tôi vẫn cực kỳ phấn khích về các agent (Agent). Nó khiến tôi nhớ lại năm 2020, 2021, khi làn sóng đầu tiên của các mô hình thực sự mạnh mẽ như GPT4 ra đời. Khi bạn thử các mô hình này, bạn cảm nhận được tiềm năng khổng lồ—nó có thể sáng tác bài rap xuất sắc, bình luận hài hước, phép cộng ba chữ số cũng tạm ổn. Nhưng khi bạn bảo nó "giúp tôi đặt một chiếc pizza", nó chỉ biết bắt chước cuộc trò chuyện kiểu nhân viên chăm sóc khách hàng Domino's, hoàn toàn không thể hoàn thành nhiệm vụ thực tế. Điều này rõ ràng bộc lộ thiếu sót nghiêm trọng của các hệ thống này, đúng không?

Kể từ đó, tôi luôn tin chắc rằng phải giải quyết vấn đề về Agents. Khi tôi làm việc tại Google, chúng tôi đã bắt đầu nghiên cứu đề tài sau này được gọi là "sử dụng công cụ"—tức là làm thế nào để hiển thị giao diện thao tác cho mô hình ngôn ngữ lớn (LLM), để nó tự quyết định khi nào hành động. Mặc dù giới học thuật luôn gọi là "agent", nhưng lúc đó công chúng chưa hình thành nhận thức thống nhất. Do đó, chúng tôi đã cố gắng tạo ra thuật ngữ mới "mô hình hành động lớn" (Large Action Model) thay cho "mô hình ngôn ngữ lớn" (Large Language Model), khái niệm này từng gây ra một số tranh luận. Nhưng cuối cùng ngành công nghiệp vẫn chọn thuật ngữ "agent" (Agent), ngày nay thuật ngữ này đã bị lạm dụng đến mức mất đi ý nghĩa ban đầu, điều này thật đáng tiếc, nhưng thật ngầu khi là công ty châu Á hiện đại đầu tiên khám phá lĩnh vực này.

Khi chúng tôi sáng lập Adept, các mô hình LLM mã nguồn mở tốt nhất lúc đó đều hoạt động kém. Vì lúc đó cũng chưa tồn tại mô hình đa phương thức (LLM đa phương thức như LLM hỗ trợ hình ảnh, như GPT-4v sau này), chúng tôi buộc phải tự huấn luyện mô hình của riêng mình\chúng tôi buộc phải tự làm mọi thứ từ đầu, giống như việc thành lập công ty internet năm 2000 nhưng phải gọi điện cho TSMC để tự sản xuất chip, thật điên rồ quá.

Vì vậy, điều chúng tôi học được trên hành trình này là, mô hình ngôn ngữ lớn về cơ bản là các bộ sao chép hành vi (behavioral cloners) nếu không có công nghệ RL ngày nay, chúng sẽ làm những điều chúng thấy trong dữ liệu huấn luyện—điều đó có nghĩa là, một khi chúng bước vào tình huống chưa từng thấy, khả năng khái quát hóa của chúng sẽ rất kém, hành vi trở nên khó dự đoán. Vì vậy Adept luôn tập trung vào trí tuệ hữu ích (useful intelligence). Vậy thì tính hữu ích nghĩa là gì? Nó không phải là tung ra một bản demo ngầu khiến Twitter lan truyền. Mà là đưa công nghệ này vào tay mọi người, giúp họ không còn phải làm những công việc rườm rà mà hầu hết nhân viên tri thức phải chịu đựng, ví dụ như kéo thả file trên máy tính. Vì vậy những nhân viên tri thức này quan tâm đến độ tin cậy. Vì vậy, một trong những trường hợp sử dụng đầu tiên của chúng tôi là: Chúng tôi có thể xử lý hóa đơn giúp mọi người không?

Jacob: Ai cũng thích xử lý hóa đơn (cười). Với các mô hình tổng quát, đây dường như là một điểm khởi đầu tự nhiên.

David: Đây là một "Hello World" tuyệt vời. Vì vậy, lúc đó chưa ai thực sự làm điều này, chúng tôi chọn một ví dụ "Hello World" rõ ràng. Chúng tôi làm cả Excel và một số dự án khác. Nếu hệ thống này cứ bảy lần lại một lần xóa mất một phần ba mục trong QuickBooks của bạn, bạn sẽ không bao giờ dùng lại nó nữa. Độ tin cậy vẫn là vấn đề, ngay cả ngày nay, các hệ thống như Operator rất ấn tượng, dường như vượt trội hơn các agent máy tính đám mây khác. Nhưng nếu bạn nhìn vào hai hệ thống này, chúng đều tập trung vào thực hiện nhiệm vụ từ đầu đến cuối, ví dụ bạn nhập "Tôi muốn bạn giúp tôi tìm 55 địa điểm nghỉ dưỡng cuối tuần", nó sẽ cố hoàn thành nhiệm vụ đó. Nhưng độ tin cậy từ đầu đến cuối rất thấp, cần can thiệp thủ công rất nhiều. Chúng ta vẫn chưa đạt đến mức doanh nghiệp có thể thực sự tin tưởng các hệ thống này để 'làm một lần, xong mãi mãi'.

Jacob: Chúng ta phải giải quyết vấn đề này. Có thể giải thích cho thính giả của chúng ta, nếu bạn bắt đầu từ mô hình nền đa phương thức hiện có, để biến nó thành một mô hình hành động lớn, thực tế cần làm những gì?

David: Tôi có thể thảo luận vấn đề này ở mức độ cao hơn, nhưng cơ bản có hai việc cần làm. Việc đầu tiên là vấn đề kỹ thuật, tức là làm thế nào để hiển thị những việc có thể làm theo cách mô hình có thể hiểu. Ví dụ, đây là API có thể gọi, đây là các yếu tố giao diện người dùng bạn có thể gọi. Hãy dạy nó một chút về cách Expedia.com (chú thích: trang web dịch vụ du lịch) hoặc SAP hoạt động. Đây là một số nội dung kỹ thuật nghiên cứu. Đây là bước đầu tiên, tức là trao cho nó nhận thức về khả năng của bản thân, cũng như khả năng hành động cơ bản.

Phần thứ hai mới thực sự thú vị, là làm thế nào để dạy nó lên kế hoạch, suy luận, lên kế hoạch lại, và tuân theo chỉ dẫn của người dùng, thậm chí có thể suy luận ra người dùng thực sự muốn gì, và hoàn thành các nhiệm vụ đó. Đây là vấn đề nghiên cứu và phát triển khó khăn, nó rất khác biệt so với công việc mô hình ngôn ngữ thông thường, vì công việc mô hình ngôn ngữ thông thường là 'hãy sinh ra một đoạn văn bản', ngay cả công việc suy luận ngày nay, ví dụ như toán học, cũng có một câu trả lời cuối cùng.

Vì vậy, nó giống như một quá trình đơn bước, ngay cả khi nó liên quan đến suy nghĩ đa bước, nó chỉ cung cấp cho bạn câu trả lời. Đây là một quá trình ra quyết định đa bước hoàn toàn, liên quan đến việc quay ngược, liên quan đến việc cố gắng dự đoán hậu quả của hành động bạn thực hiện, và nhận ra rằng nút xóa có thể nguy hiểm, bạn phải hoàn thành tất cả những việc này trong thiết lập cơ bản.

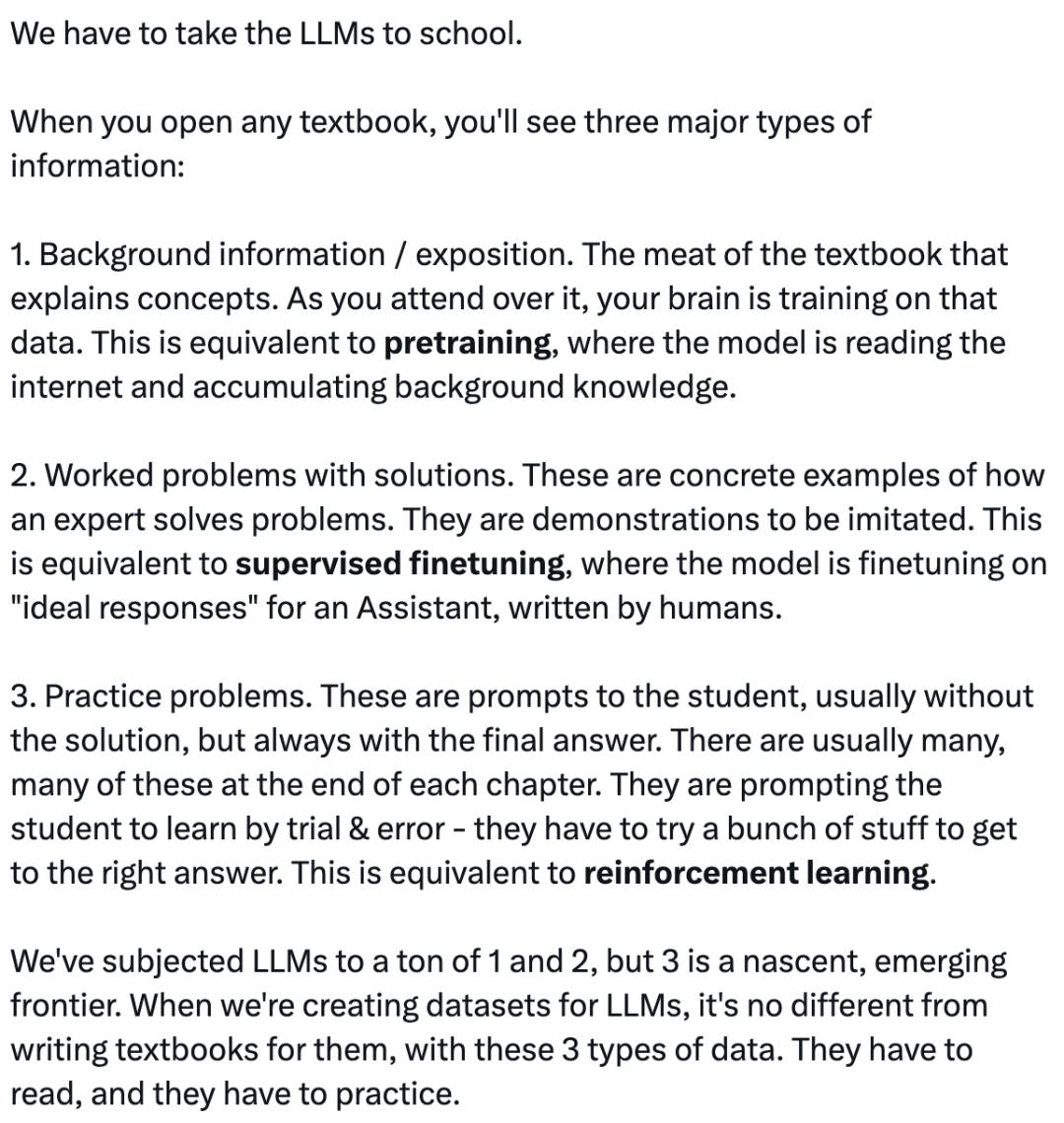

Sau đó bạn đặt nó vào môi trường sandbox, để nó học theo điều kiện của riêng mình. So sánh tốt nhất là Andrej Karpathy (chú thích: thành viên đội ngũ sáng lập OpenAI, năm 2024 thành lập Eureka Labs về AI+giáo dục) từng nói, việc huấn luyện AI hiện đại hơi giống cách tổ chức sách giáo khoa. Đầu tiên, bạn có toàn bộ giải thích về một quá trình vật lý, sau đó là một số câu hỏi ví dụ. Phần đầu là tiền huấn luyện, các câu hỏi ví dụ là tinh chỉnh giám sát, còn bước cuối là các câu hỏi mở, có thể phía sau sách giáo khoa có đáp án. Chúng ta chỉ đang tuân theo quy trình này.

Mô tả của Andrej Karpathy về mô hình lớn (Nguồn: X.com, Mingliang Company)

Jacob: Tôi nghĩ chắc bạn đã suy nghĩ rất nhiều về cách các agent thông minh này thực sự bước vào thế giới. Tôi muốn hỏi vài câu. Trước hết, bạn nói một phần vấn đề là khiến mô hình biết được nó có thể truy cập vào những gì. Về lâu dài, mô hình sẽ tương tác với trình duyệt và chương trình như thế nào? Liệu nó giống cách con người tương tác không? Hay chỉ thông qua mã code? Còn cách nào khác không?

David: Nếu tôi phải nhận xét về lĩnh vực này, tôi nghĩ vấn đề lớn nhất hiện nay là, con người thiếu sự sáng tạo trong cách tương tác với các mô hình lớn và agent ngày càng thông minh hơn. Bạn còn nhớ khi iPhone mới ra đời, App Store cũng ra đời, mọi người bắt đầu tạo ra các ứng dụng khác nhau, ví dụ như nhấn nút phát tiếng ợ, hoặc nghiêng điện thoại để đổ bia vào miệng. Giao diện của chúng ta hiện nay cũng giống như vậy, cảm giác rất tệ, vì trò chuyện là một cách tương tác siêu giới hạn, băng thông thấp, ít nhất là ở một số khía cạnh. Ví dụ, tôi không muốn mất bảy lượt đối thoại để quyết định các thành phần trên chiếc pizza của mình.

Tình trạng thiếu sáng tạo này khiến tôi rất thất vọng. Tôi nghĩ một phần là do những nhà thiết kế sản phẩm tuyệt vời có thể giúp chúng ta giải quyết các vấn đề này hiện chưa thực sự hiểu được giới hạn của các mô hình. Tình trạng này đang thay đổi nhanh chóng, nhưng ngược lại, cho đến nay, những người thúc đẩy tiến bộ công nghệ luôn coi đó là “tôi đang giao một hộp đen”, chứ không phải “tôi đang giao một trải nghiệm”.

Khi tình trạng này thay đổi, tôi mong chờ được thấy các hệ thống như vậy, khi bạn tương tác với agent, nó thực sự sẽ tổng hợp một giao diện người dùng đa phương thức để liệt kê những gì nó cần từ bạn, và tạo ra ngữ cảnh chung (Context) giữa con người và AI, thay vì mô hình hiện tại là bạn chỉ đang trò chuyện với nó. Nó giống như bạn và nó cùng làm một việc trên máy tính, nhìn vào màn hình, giống song song hơn là dọc.

Jacob: Tôi nghĩ bạn đã nói rằng Operator hiện nay tuy ấn tượng nhưng đôi khi chưa hoàn hảo. Vậy bạn nghĩ khi nào chúng ta mới có các agent thông minh đáng tin cậy?

David: Tôi nghĩ Operator rất tuyệt vời, chỉ là toàn bộ lĩnh vực hiện tại còn thiếu miếng ghép cuối cùng.

Jacob: Tôi nghĩ, xét theo lịch sử xe tự lái, có thể từ năm 1995, họ đã biểu diễn xe tự lái, chiếc xe có thể đi xuyên quốc gia, hoàn thành 99% hành trình.

David: Đúng vậy.

Jacob: Chúng ta có cần đợi thêm 30 năm nữa không?

David: Tôi không nghĩ vậy, vì tôi nghĩ thực tế chúng ta đã có các công cụ phù hợp.

Jacob: Bạn từng nói trước đó rằng AGI (trí tuệ nhân tạo tổng quát) thực ra không xa.

David: Mốc chính tôi đang tìm kiếm trong lĩnh vực Agents là tôi có thể giao bất kỳ nhiệm vụ nào cho agent này trong quá trình huấn luyện, vài ngày sau quay lại, nó đã hoàn thành 100%. Đúng vậy, giống như con người mang lại cho chúng ta 5% cải thiện độ tin cậy, nhưng agent này đã học được cách giải quyết vấn đề.

Jacob: Như bạn đã nói trước đó, khi bạn sáng lập Adept, chưa có mô hình mã nguồn mở thực sự, chứ đừng nói đến mô hình mã nguồn mở đa phương thức. Bạn nghĩ nếu có người bắt đầu một công ty như Adept ngày nay, một công ty khởi nghiệp có thể thành công ở đây không? Hay cuối cùng người thúc đẩy tiến trình sẽ là các công ty mô hình nền và nhà cung cấp dịch vụ đám mây siêu quy mô?

David: Tôi rất không chắc chắn về câu hỏi này. Nhưng quan điểm hiện tại của tôi là, cá nhân tôi nghĩ AGI thực ra không xa.

Jacob: Khi bạn nhắc đến AGI, bạn định nghĩa nó như thế nào?

David: Một mô hình có thể hoàn thành bất kỳ nhiệm vụ hữu ích nào mà con người làm trên máy tính, đó là một phần của định nghĩa. Định nghĩa khác tôi thích là, nó là một mô hình có thể học cách làm những việc này nhanh như con người. Tôi nghĩ những điều này không xa, nhưng tôi cũng không nghĩ chúng sẽ lan tỏa nhanh chóng trong xã hội. Như chúng ta biết, theo định luật Amdahl (Amdahl's Law), một khi bạn thực sự tăng tốc một việc, các việc khác sẽ trở thành điểm nghẽn, hiệu quả tăng tốc tổng thể bạn đạt được không lớn như bạn tưởng tượng.

Vì vậy, tôi nghĩ điều sẽ xảy ra là, chúng ta sẽ có công nghệ này, nhưng khả năng của con người để thực sự sử dụng hiệu quả các công nghệ này sẽ kéo dài trong một thời gian khá dài. Nhiều đồng nghiệp của tôi gọi đây là “thặng dư năng lực” (Capability overhang), một sự thặng dư năng lực khổng lồ.

Jacob: Bạn có từng suy nghĩ sơ bộ nào về các yếu tố tăng tốc có thể xảy ra khi chúng ta có những năng lực này không?

David: Tôi nghĩ điều đó phụ thuộc vào con người. Đó là về cách thiết kế tương tác với mô hình một cách đồng sáng tạo, và cách sử dụng các mô hình này. Sẽ là vấn đề chấp nhận xã hội. Ví dụ, tưởng tượng bạn có một mô hình ra đời ngày mai, nó nói: “Tôi phát minh ra một cách làm việc hoàn toàn mới, mọi người nên dùng nó.” Con người cần hòa giải với nó và quyết định liệu đây thực sự có phải là giải pháp tốt hơn hay không, điều này sẽ không diễn ra nhanh như chúng ta tưởng tượng.

Jacob: Như bạn nói, ngay cả khi phòng thí nghiệm là nơi đầu tiên phát triển các mô hình này, có thể vẫn có cơ hội để các công ty khởi nghiệp thực sự thu hẹp khoảng cách giữa năng lực mô hình và nhu cầu tương tác thực tế của người dùng cuối.

David: Tôi gần như chắc chắn đây là điều sẽ xảy ra. Vì cuối cùng, tôi vẫn tin chắc rằng, trong một thế giới có AGI, mối quan hệ giữa con người với con người thực sự rất quan trọng. Cuối cùng, việc hiểu và sở hữu khách hàng, và gắn bó với họ, hiểu nhu cầu của họ sâu sắc hơn, sẽ quan trọng hơn nhiều so với việc chỉ kiểm soát công cụ vốn được sở hữu bởi nhiều phòng thí nghiệm khác.

Jacob: Bạn nghĩ trong mười năm tới con người sẽ sử dụng máy tính như thế nào? Tất cả các mô hình này đều đạt đến định nghĩa AGI của bạn. Liệu tôi có còn ngồi trước máy tính không? Tầm nhìn của bạn về cách con người tương tác với các công nghệ này trong tương lai là gì?

David: Tôi nghĩ chúng ta sẽ có bộ công cụ mới để tương tác với máy tính. Ngày nay, vẫn có người dùng dòng lệnh, đúng không? Giống như mọi người vẫn dùng giao diện người dùng đồ họa (GUI). Trong tương lai, mọi người vẫn sẽ dùng giao diện giọng nói. Nhưng tôi nghĩ mọi người cũng sẽ dùng nhiều hơn tính toán môi trường (ambient computing). Và tôi nghĩ chỉ số chúng ta nên quan tâm là, đòn bẩy (leverage) mà con người thu được trên mỗi đơn vị năng lượng khi tương tác với máy tính. Tôi nghĩ, khi các hệ thống này phát triển, chỉ số này sẽ tiếp tục tăng lên.

Jacob: Có thể nói thêm một chút về thế giới mô hình tương lai, và liệu chúng ta cuối cùng có sở hữu bất kỳ mô hình chuyên biệt lĩnh vực nào không?

David: Hãy xem xét mô hình chuyên gia pháp lý giả thuyết. Bạn có thể muốn chuyên gia pháp lý giả thuyết này biết một số sự thật cơ bản về thế giới.

Jacob: Nhiều người học luật thường học một bằng đại cương trước.

David: Đúng vậy. Vì vậy tôi nghĩ sẽ có các mô hình chuyên biệt lĩnh vực, nhưng tôi không muốn che giấu trọng tâm, chỉ nói rằng sẽ có các mô hình chuyên biệt lĩnh vực. Tôi nghĩ sẽ có mô hình chuyên biệt lĩnh vực vì lý do kỹ thuật, nhưng cũng vì lý do chính sách.

Jacob: Điều này rất thú vị, ý bạn là gì?

David: Giống như một số công ty thực sự không muốn dữ liệu của họ bị trộn lẫn. Ví dụ, tưởng tượng bạn là một ngân hàng lớn, bạn có bộ phận bán hàng và giao dịch, bạn có bộ phận ngân hàng đầu tư, nhân viên AI hoặc LLMs hỗ trợ các bộ phận này, giống như ngày nay các nhân viên này không thể chia sẻ thông tin, các mô hình cũng không nên có khả năng chia sẻ thông tin qua trọng số của chúng.

Jacob: Bạn nghĩ còn những điều gì cần giải quyết? Về mô hình, dường như bạn rất tự tin rằng nếu chúng ta chỉ mở rộng năng lực tính toán hiện tại, chúng ta có thể rất gần với việc giải quyết các vấn đề cần giải quyết. Nhưng liệu còn thách thức công nghệ lớn nào khác cần vượt qua để tiếp tục mở rộng trí tuệ mô hình?

David: Thực tế, tôi không đồng ý với quan điểm rằng: chỉ cần di chuyển trực tiếp các công nghệ hiện tại sang cụm máy tính hai năm sau, mọi thứ sẽ kỳ diệu hoạt động. Mặc dù quy mô vẫn sẽ là yếu tố then chốt, nhưng niềm tin của tôi bắt nguồn từ việc đánh giá các vấn đề cốt lõi đang mở—chúng ta cần đánh giá độ khó của việc giải quyết các vấn đề này. Ví dụ, liệu có bài toán siêu khó nào buộc phải đột phá đổi mới mới có thể giải quyết? Ví dụ như hoàn toàn thay thế thuật toán giảm dần gradient (chú thích: gradient descent, thuật toán tối ưu tham số cốt lõi trong mô hình học sâu hiện đại, bằng cách lặp cập nhật tham số theo hướng âm gradient của hàm mất mát.), hay phải dựa vào máy tính lượng tử mới đạt được AGI. Nhưng tôi không nghĩ đây là con đường công nghệ tất yếu.

Jacob: Khi các mô hình mới ra đời, bạn đánh giá chúng như thế nào? Bạn có những câu hỏi cố định để kiểm tra không, hay bạn đánh giá chất lượng mô hình mới ra sao?

David: Phương pháp luận đánh giá của tôi dựa trên hai nguyên tắc cốt lõi: Tính đơn giản về phương pháp luận (Methodological Simplicity): Đây là đặc điểm hấp dẫn nhất trong lĩnh vực học sâu—khi một nghiên cứu kèm theo tài liệu phương pháp (điều này ngày nay ngày càng hiếm), bạn chỉ cần xem xét con đường thực hiện của nó, có thể phát hiện ra một giải pháp đơn giản hơn và hiệu quả hơn so với phương án truyền thống. Những đột phá như vậy thường được ghi vào kinh điển học sâu (deep learning canon), và mang lại khoảnh khắc "điều này thực sự thể hiện vẻ đẹp của thuật toán".

Sự sai lệch của các chuẩn đánh giá (Benchmark Misalignment): Sự thổi phồng (hype) trong lĩnh vực hiện nay khiến nhiều chuẩn đánh giá bị tách rời khỏi nhu cầu thực tế của mô hình, nhưng lại được đánh giá quá cao trong quy trình nghiên cứu và phát triển. Về bản chất, đây là một trò chơi. Sự phức tạp của việc đánh giá và đo lường bị đánh giá thấp nghiêm trọng—so với nhiều hướng nghiên cứu hiện nay, chúng đáng lẽ nên nhận được nhiều danh tiếng học thuật và nguồn lực hơn.

Thực tế tích lũy công nghệ khác biệt rất ít

Jacob: Dường như mọi người đều có chuẩn đánh giá nội bộ riêng, họ không công bố công khai, ví dụ như thứ họ tin tưởng hơn. Như bạn có thể thấy mô hình của OpenAI thể hiện tốt hơn trong nhiều chuẩn đánh giá lập trình, nhưng mọi người đều dùng mô hình của Anthropic, họ biết những mô hình này tốt hơn. Thật thú vị khi chứng kiến sự phát triển của lĩnh vực này. Tôi muốn nghe bạn nói về tình hình hiện tại của bạn tại Amazon, bạn nhìn nhận vai trò của Amazon trong hệ sinh thái rộng lớn hơn như thế nào?

David: Đúng vậy, Amazon là một nơi rất thú vị. Thực tế, tôi học được rất nhiều điều ở đó. Amazon rất nghiêm túc trong việc xây dựng hệ thống trí tuệ tổng quát, đặc biệt là agent trí tuệ tổng quát. Tôi nghĩ điều thực sự ngầu là, tôi nghĩ mọi người tại Amazon đều hiểu rằng bản thân tính toán đang chuyển đổi từ các yếu tố cơ bản chúng ta biết sang việc gọi các mô hình lớn hoặc agent lớn, điều này có thể là yếu tố cơ bản quan trọng nhất của tính toán trong tương lai. Vì vậy mọi người rất quan tâm đến điều này, thật tuyệt vời.

Tôi nghĩ điều thú vị là, tôi phụ trách mảng kinh doanh agent của Amazon, thật ngầu khi bạn thấy phạm vi mà agent chạm tới trong một công ty lớn như Amazon rộng đến đâu. Peter (âm) và tôi cùng nhau mở một phòng thí nghiệm nghiên cứu mới tại San Francisco cho Amazon, một phần lớn là vì rất nhiều lãnh đạo cấp cao của Amazon thực sự tin rằng chúng ta cần các đột phá nghiên cứu mới để giải quyết các vấn đề chính trọng tâm dẫn đến AGI mà chúng ta đã thảo luận trước đó.

Jacob: Bạn có theo dõi bất kỳ kiến trúc thay thế nào, hay các lĩnh vực nghiên cứu tiên phong hơn không?

David: Để tôi nghĩ xem. Tôi luôn chú ý đến những thứ có thể giúp chúng ta ánh xạ việc học mô hình sang tính toán hiệu quả hơn. Chúng ta có thể sử dụng tính toán nhiều hơn một cách hiệu quả hơn không? Điều này mang lại hệ số nhân khổng lồ cho những gì chúng ta có thể làm. Nhưng thực tế tôi dành nhiều thời gian hơn để theo dõi trung tâm dữ liệu và chip, vì tôi thấy điều này rất thú vị. Hiện nay có một số động thái thú vị đang diễn ra.

Jacob: Dường như một trong những yếu tố thúc đẩy sự phát triển của mô hình là gán nhãn dữ liệu, và rõ ràng, tất cả các phòng thí nghiệm đều chi rất nhiều tiền cho việc này. Trong mô hình tính toán trong quá trình thử nghiệm, điều này còn liên quan không? Bạn nhìn nhận vấn đề này như thế nào?

David: Điều đầu tiên tôi nghĩ đến là hai nhiệm vụ cần giải quyết trong gán nhãn dữ liệu, đầu tiên là dạy mô hình kiến thức cơ bản về cách hoàn thành một nhiệm vụ bằng cách sao chép hành vi con người. Nếu bạn có dữ liệu chất lượng cao, bạn có thể dùng nó để kích hoạt tốt hơn những gì mô hình đã thấy trong giai đoạn tiền huấn luyện. Sau đó tôi nghĩ nhiệm vụ thứ hai là dạy mô hình thế nào là tốt, thế nào là xấu, đối với các nhiệm vụ mơ hồ. Tôi nghĩ cả hai vẫn rất quan trọng.……

Jacob: Rõ ràng bạn luôn ở tuyến đầu lĩnh vực này trong thập kỷ qua. Có điều gì là bạn đã thay đổi quan điểm trong năm qua không?

David: Tôi luôn suy nghĩ về việc xây dựng văn hóa nhóm. Chúng tôi luôn biết điều đó, nhưng tôi càng tin chắc hơn rằng việc tuyển dụng những người thực sự thông minh, tràn đầy năng lượng, có động lực nội tại, đặc biệt là ở giai đoạn đầu sự nghiệp của họ, thực sự là một động cơ quan trọng cho thành công của chúng tôi. Trong lĩnh vực này, cứ vài năm, chiến lược tối ưu sẽ thay đổi. Vì vậy nếu mọi người quá thích nghi với chiến lược tối ưu trước đó, họ thực sự sẽ làm chậm bạn lại. Vì vậy tôi nghĩ, so với suy nghĩ trước đây của tôi, đặt cược vào người mới sẽ tốt hơn.

Một điều khác tôi đã thay đổi quan điểm là, tôi từng nghĩ xây dựng AI thực sự sẽ có sự khác biệt kỹ thuật dài hạn thực sự, bạn có thể tích lũy trên đó. Tôi từng nghĩ rằng, nếu bạn làm tốt trong mô hình hóa văn bản, nó nên giúp bạn tự nhiên trở thành người chiến thắng trong lĩnh vực đa phương thức. Nếu bạn làm tốt trong đa phương thức, bạn nên trở thành người chiến thắng trong lĩnh vực suy luận và agent... Những lợi thế này nên tích lũy liên tục. Nhưng trong thực tế, tôi thấy sự tích lũy rất ít. Tôi nghĩ mọi người đều đang thử những ý tưởng tương tự.

Jacob: Ý của bạn là, chỉ vì bạn đột phá A trước không có nghĩa là bạn sẽ chiếm ưu thế ở B. Ví dụ, OpenAI đột phá trong mô hình ngôn ngữ, nhưng điều đó không nhất thiết có nghĩa là họ sẽ đột phá trong suy luận.

David: Chúng có liên quan, nhưng không có nghĩa là bạn chắc chắn sẽ giành chiến thắng ở cơ hội tiếp theo.

Robot sẽ vào nhà khi nào

Jacob: Tôi muốn hỏi, bạn ban đầu bước vào trí tuệ nhân tạo thông qua lĩnh vực robot. Vậy, bạn đánh giá hiện trạng lĩnh vực robot trí tuệ nhân tạo ngày nay như thế nào?

David: Tương tự như quan điểm của tôi về Digital Agent, tôi nghĩ chúng ta đã có nhiều nguyên liệu thô. Và tôi nghĩ điều thú vị là, Digital Agent mang lại cho chúng ta cơ hội giải quyết một số vấn đề nan giải trước khi chuyển sang Physical Agent.

Jacob: Hãy triển khai thêm, độ tin cậy của Digital Agent được kế thừa như thế nào sang Physical Agent?

David: Lấy một ví dụ đơn giản, giả sử bạn có một kho hàng cần sắp xếp lại, bạn có một Physical Agent, bạn yêu cầu nó tính toán kế hoạch tốt nhất để sắp xếp lại kho hàng. Nếu bạn học trong thế giới thực, thậm chí trong môi trường mô phỏng robot, điều này sẽ rất khó. Nhưng nếu bạn đã làm điều này trong không gian số, và bạn đã có tất cả công thức huấn luyện và kiến thức điều chỉnh thuật toán để học từ dữ liệu mô phỏng, thì giống như bạn đã hoàn thành nhiệm vụ này trên bánh xe tập luyện.

Jacob: Điều này rất thú vị. Tôi nghĩ khi mọi người nghĩ đến robot, có hai thái cực. Một số người nghĩ rằng quy luật quy mô chúng ta phát hiện trong mô hình ngôn ngữ cũng sẽ được phát hiện trong lĩnh vực robot, chúng ta đang ở rìa của một thay đổi lớn. Bạn thường nghe Jensen (Jensen Huang, người sáng lập NVIDIA) nói về vấn đề này. Rồi lại có những người khác nghĩ rằng, điều này giống như xe tự lái năm 1995, một bản demo tuyệt vời, nhưng cần rất lâu để thực sự hoạt động. Bạn đứng ở đâu trong phổ này?

David: Tôi quay lại điều tôi đã nói trước đó, điều mang lại cho tôi nhiều niềm tin nhất là khả năng xây dựng công thức huấn luyện của chúng ta, giúp chúng ta hoàn thành nhiệm vụ 100%. Chúng ta có thể làm điều này trong không gian số. Dù có thách thức, nhưng cuối cùng cũng sẽ chuyển sang không gian vật lý.

Jacob: Khi nào chúng ta sẽ có robot trong nhà?

David: Tôi nghĩ điều này thực ra lại quay về vấn đề tôi đã nói trước đó. Tôi nghĩ điểm nghẽn của nhiều vấn đề không nằm ở việc xây dựng mô hình (modeling), mà nằm ở sự khuếch tán của mô hình (diffusion).

Jacob: Còn về mô hình video thì sao? Rõ ràng, hiện nay có rất nhiều người bước vào lĩnh vực này, dường như đây là một lĩnh vực tiên phong mới, liên quan đến việc hiểu mô hình thế giới và vật lý để đạt được khám phá mở rộng hơn. Có thể bạn nói thêm về những gì bạn thấy trong lĩnh vực này và quan điểm của bạn về lĩnh vực này?

David: Tôi rất hào hứng về điều này. Tôi nghĩ nó giải quyết một vấn đề chính mà chúng tôi đã đề cập trước đó, tức là trước đây chúng tôi đã thảo luận rằng ngày nay chúng tôi có thể khiến học tăng cường (RL) hoạt động trên các vấn đề có bộ xác minh (Verifier), ví dụ như chứng minh định lý.

Sau đó chúng tôi thảo luận về cách mở rộng sang lĩnh vực Digital Agents, nơi bạn không có bộ xác minh, nhưng có thể có một trình mô phỏng đáng tin cậy, vì tôi có thể khởi động môi trường staging của một ứng dụng, dạy agent cách sử dụng nó. Nhưng tôi nghĩ vấn đề chính còn lại là, khi không có bộ xác minh rõ ràng hay trình mô phỏng rõ ràng thì sao? Tôi nghĩ mô hình thế giới (World modeling) là cách chúng ta trả lời câu hỏi này.

Hành trình phát triển tổ chức của OpenAI

Jacob: Tuyệt vời. Tôi muốn chuyển chủ đề một chút, nói về OpenAI và khoảng thời gian của bạn ở đó. Rõ ràng, bạn đã tham gia vào giai đoạn rất đặc biệt của công ty và đóng vai trò tương tự trong nhiều bước tiến. Tôi nghĩ, trong tương lai chúng ta sẽ thấy nhiều phân tích về văn hóa OpenAI, về thời kỳ phát triển GPT-1 đến GPT-4 đặc biệt ở điểm nào. Bạn nghĩ những phân tích đó sẽ nói gì? Điều gì khiến tổ chức này thành công đến vậy?

David: Khi tôi gia nhập OpenAI, cộng đồng nghiên cứu còn rất nhỏ. Đó là năm 2017, OpenAI mới thành lập hơn một năm. Tôi biết đội ngũ sáng lập và một số nhân viên đầu tiên, họ đang tìm kiếm một người có thể xóa nhòa ranh giới giữa nghiên cứu và kỹ thuật, và tôi vừa vặn với nhu cầu đó.

Vì vậy, việc gia nhập OpenAI là một điều rất may mắn. Lúc đó đội ngũ chỉ có 35 người, nhưng đều là những nhân tài cực kỳ xuất sắc, họ đã làm rất nhiều việc trong siêu tính toán, và còn nhiều người khác, tôi có thể liệt kê từng người một. Họ đều là những người xuất sắc trong đội lúc đó.

Chào mừng tham gia cộng đồng chính thức TechFlow

Nhóm Telegram:https://t.me/TechFlowDaily

Tài khoản Twitter chính thức:https://x.com/TechFlowPost

Tài khoản Twitter tiếng Anh:https://x.com/BlockFlow_News