AI + DePIN + hệ sinh thái Solana: Phân tích sơ lược về IO.NET trước thềm phát hành token

Tuyển chọn TechFlowTuyển chọn TechFlow

AI + DePIN + hệ sinh thái Solana: Phân tích sơ lược về IO.NET trước thềm phát hành token

Trong bối cảnh thị trường AI có nhu cầu tính toán lớn hơn nguồn cung, yếu tố quan trọng nhất của mạng lưới tính toán AI phân tán là quy mô nguồn cung GPU.

Tác giả: Alex Xu, Mint Ventures

Giới thiệu

Trong bài viết trước của tôi, tôi đã đề cập rằng so với hai chu kỳ trước đó, chu kỳ thị trường tăng giá tiền mã hóa hiện tại thiếu những câu chuyện thương mại và tài sản mới đủ ảnh hưởng. AI là một trong số ít các câu chuyện mới trong lĩnh vực Web3 lần này; bài viết này sẽ kết hợp dự án AI nổi bật trong năm nay IO.NET để phân tích suy nghĩ về 2 vấn đề sau:

-

Tính cần thiết về mặt thương mại khi kết hợp AI + Web3

-

Tính cần thiết và thách thức của dịch vụ tính toán phân tán

Thứ hai, tôi sẽ tóm tắt thông tin chính về dự án tiêu biểu cho sức mạnh tính toán phân tán AI: dự án IO.NET, bao gồm logic sản phẩm, tình hình đối thủ cạnh tranh, bối cảnh dự án, đồng thời đưa ra đánh giá định giá cho dự án.

Một phần suy nghĩ về việc kết hợp AI và Web3 trong bài viết này chịu ảnh hưởng từ báo cáo "The Real Merge" do nhà nghiên cứu Michael Rinko của Delphi Digital viết. Một số quan điểm trong bài viết này có tham khảo và trích dẫn từ bài viết đó; độc giả được khuyến khích đọc nguyên bản.

Bài viết này phản ánh suy nghĩ giai đoạn hiện tại của tác giả tính đến thời điểm xuất bản, có thể thay đổi trong tương lai, và các quan điểm mang tính chủ quan rất cao, cũng có thể tồn tại sai sót về thực tế, dữ liệu hoặc logic lập luận. Vui lòng không sử dụng làm cơ sở đầu tư. Rất hoan nghênh sự chỉ trích và thảo luận từ cộng đồng chuyên môn.

Dưới đây là nội dung chính.

1. Logic kinh doanh: Điểm kết nối giữa AI và Web3

1.1 Năm 2023: "Năm kỳ diệu" mới do AI tạo nên

Nhìn lại lịch sử phát triển nhân loại, mỗi khi công nghệ đạt được bước tiến đột phá, từ đời sống cá nhân, cấu trúc ngành công nghiệp đến toàn bộ nền văn minh nhân loại đều trải qua những biến đổi to lớn.

Lịch sử nhân loại có hai năm quan trọng, đó là 1666 và 1905, ngày nay chúng được gọi là hai "năm kỳ diệu" trong lịch sử công nghệ.

Năm 1666 được coi là năm kỳ diệu vì thành quả khoa học của Newton tập trung bùng nổ vào năm đó. Trong năm này, ông đã mở ra ngành vật lý quang học, sáng lập ngành toán học giải tích, xây dựng công thức lực hấp dẫn – nền tảng cơ bản cho khoa học tự nhiên hiện đại. Mỗi đóng góp trên đều là nền tảng cho sự phát triển khoa học trong hàng trăm năm tới, thúc đẩy mạnh mẽ sự tiến bộ chung của khoa học.

Năm kỳ diệu thứ hai là 1905, khi Einstein mới 26 tuổi đã liên tiếp công bố 4 bài báo trên Tạp chí Vật lý học, lần lượt nói về hiệu ứng quang điện (đặt nền móng cho cơ học lượng tử), chuyển động Brown (trở thành tài liệu tham khảo quan trọng cho phân tích quá trình ngẫu nhiên), thuyết tương đối hẹp và phương trình khối lượng-năng lượng (chính là công thức nổi tiếng E=MC^2). Theo đánh giá hậu thế, mỗi bài báo này đều vượt mức trung bình của giải Nobel Vật lý (Einstein cũng nhận giải Nobel nhờ bài báo về hiệu ứng quang điện), tiến trình lịch sử nền văn minh nhân loại một lần nữa được đẩy nhanh đáng kể.

Và năm 2023 vừa qua, rất có thể sẽ được gọi là một "năm kỳ diệu" khác, nhờ ChatGPT.

Chúng ta xem năm 2023 là một "năm kỳ diệu" khác trong lịch sử công nghệ nhân loại không chỉ vì GPT đã đạt được bước tiến khổng lồ trong việc hiểu và tạo ngôn ngữ tự nhiên, mà còn vì con người đã nắm bắt được quy luật tăng trưởng năng lực của mô hình ngôn ngữ lớn thông qua tiến hóa của GPT – tức là mở rộng tham số mô hình và dữ liệu huấn luyện có thể nâng cao năng lực mô hình theo cấp số mũ – và quá trình này trong ngắn hạn dường như chưa thấy điểm tắc nghẽn (miễn là có đủ sức mạnh tính toán).

Khả năng này không chỉ giới hạn ở việc hiểu ngôn ngữ và tạo hội thoại, mà còn có thể được áp dụng rộng rãi trong nhiều lĩnh vực công nghệ. Lấy ví dụ ứng dụng mô hình ngôn ngữ lớn trong lĩnh vực sinh học:

-

Năm 2018, Francis Arnold – người đoạt giải Nobel Hóa học – trong buổi lễ trao giải đã nói: “Ngày nay, chúng ta có thể đọc, ghi và chỉnh sửa bất kỳ trình tự DNA nào trong ứng dụng thực tiễn, nhưng vẫn chưa thể 'sáng tạo' (compose it) từ nó.” Chỉ 5 năm sau lời phát biểu này, vào năm 2023, các nhà nghiên cứu từ Đại học Stanford và công ty khởi nghiệp AI Salesforce Research ở Thung lũng Silicon đã công bố một bài báo trên tạp chí Nature Biotechnology, trong đó họ sử dụng mô hình ngôn ngữ lớn điều chỉnh từ GPT-3 để tạo ra hoàn toàn mới 1 triệu loại protein, từ đó tìm ra 2 loại protein có cấu trúc hoàn toàn khác nhau nhưng đều có khả năng diệt khuẩn, hứa hẹn trở thành giải pháp đối phó vi khuẩn ngoài kháng sinh. Nghĩa là: dưới sự trợ giúp của AI, rào cản "sáng tạo" protein đã bị phá vỡ.

-

Trước đó, thuật toán AI AlphaFold trong vòng 18 tháng đã dự đoán cấu trúc gần như tất cả 214 triệu loại protein trên Trái đất, thành quả này gấp hàng trăm lần tổng thành quả của toàn bộ các nhà sinh học cấu trúc trong lịch sử loài người.

Với các mô hình dựa trên AI, từ công nghệ cao như sinh học, khoa học vật liệu, phát triển thuốc, đến các lĩnh vực nhân văn như luật pháp, nghệ thuật... chắc chắn sẽ chứng kiến những biến đổi to lớn, và năm 2023 chính là năm khai sinh cho tất cả.

Chúng ta đều biết rằng trong gần một thế kỷ qua, năng lực tạo ra của cải của con người tăng theo cấp số mũ, và sự trưởng thành nhanh chóng của công nghệ AI chắc chắn sẽ thúc đẩy mạnh mẽ hơn nữa quá trình này.

Biểu đồ tăng trưởng GDP toàn cầu, nguồn dữ liệu: Ngân hàng Thế giới

1.2 Sự kết hợp giữa AI và Crypto

Để hiểu sâu sắc tính cần thiết khi kết hợp AI và Crypto, chúng ta có thể bắt đầu từ đặc điểm bổ sung lẫn nhau của cả hai.

Sự bổ trợ đặc điểm giữa AI và Crypto

AI có ba thuộc tính:

-

Tính ngẫu nhiên: AI mang tính ngẫu nhiên, cơ chế sản xuất nội dung của nó nằm trong một hộp đen khó tái hiện và kiểm tra, do đó kết quả cũng mang tính ngẫu nhiên

-

Tập trung tài nguyên: AI là ngành công nghiệp tập trung tài nguyên, đòi hỏi lượng lớn năng lượng, chip và sức mạnh tính toán

-

Trí tuệ giống người: AI (sớm sẽ) vượt qua được bài kiểm tra Turing, sau đó khó phân biệt giữa người và máy*

※ Ngày 30 tháng 10 năm 2023, nhóm nghiên cứu của Đại học California, San Diego đã công bố kết quả bài kiểm tra Turing dành cho GPT-3.5 và GPT-4.0 (báo cáo thử nghiệm). Kết quả GPT-4.0 đạt 41%, cách điểm đậu 50% chỉ còn 9%, trong khi kết quả thử nghiệm của con người cùng bài là 63%. Ý nghĩa của bài kiểm tra Turing này là tỷ lệ phần trăm người cho rằng đối tượng đang trò chuyện với họ là người thật. Nếu vượt quá 50%, điều đó có nghĩa là hơn một nửa dân số cho rằng đối tượng trò chuyện là con người chứ không phải máy móc, tức là coi như đã vượt qua bài kiểm tra Turing.

Trong khi AI tạo ra năng suất vượt bậc cho con người, ba thuộc tính trên cũng đặt ra những thách thức lớn cho xã hội, cụ thể là:

-

Làm thế nào để xác minh và kiểm soát tính ngẫu nhiên của AI, biến tính ngẫu nhiên thành lợi thế thay vì khuyết điểm

-

Làm thế nào để đáp ứng khoảng trống khổng lồ về năng lượng và sức mạnh tính toán mà AI cần

-

Làm thế nào để phân biệt giữa người và máy

Trong khi đó, đặc điểm của nền kinh tế mã hóa và blockchain có lẽ chính là liều thuốc tốt để giải quyết những thách thức do AI gây ra. Kinh tế mã hóa có ba đặc trưng sau:

-

Tính xác định: hoạt động dựa trên blockchain, mã code và hợp đồng thông minh, quy tắc và ranh giới rõ ràng, đầu vào nào thì đầu ra ấy, mang tính xác định cao

-

Phân bổ tài nguyên hiệu quả: kinh tế mã hóa xây dựng một thị trường tự do toàn cầu rộng lớn, định giá, huy động và luân chuyển tài nguyên diễn ra rất nhanh chóng, đồng thời nhờ token có thể tăng tốc độ khớp cung-cầu thông qua cơ chế khuyến khích, nhanh chóng đạt đến điểm tới hạn

-

Không cần tin tưởng (trustless): sổ cái công khai, mã nguồn mở, mọi người có thể dễ dàng xác minh, tạo ra hệ thống "không cần tin tưởng", trong khi công nghệ ZK giúp tránh lộ thông tin riêng tư khi xác minh

Tiếp theo, hãy dùng 3 ví dụ để minh họa sự bổ trợ giữa AI và kinh tế mã hóa.

Ví dụ A: Giải quyết tính ngẫu nhiên, Agent AI dựa trên kinh tế mã hóa

Agent AI là chương trình trí tuệ nhân tạo chịu trách nhiệm thực hiện công việc thay con người dựa trên ý chí con người (dự án tiêu biểu là Fetch.AI). Giả sử chúng ta muốn yêu cầu Agent AI của mình xử lý một giao dịch tài chính, chẳng hạn như "mua 1000 USD BTC". Agent AI có thể gặp hai tình huống:

Tình huống một, nó phải kết nối với các tổ chức tài chính truyền thống (ví dụ như BlackRock) để mua ETF BTC, điều này đặt ra nhiều vấn đề tương thích giữa Agent AI và tổ chức tập trung như KYC, kiểm tra hồ sơ, đăng nhập, xác thực danh tính... Hiện tại, điều này vẫn còn rất phiền phức.

Tình huống hai, nó vận hành dựa trên nền kinh tế mã hóa gốc, tình hình sẽ đơn giản hơn nhiều: nó sẽ trực tiếp ký giao dịch và đặt lệnh bằng tài khoản của bạn thông qua Uniswap hoặc một sàn giao dịch tổng hợp nào đó, nhận WBTC (hoặc các dạng BTC được bao bọc khác), toàn bộ quá trình nhanh chóng và đơn giản. Thực tế, đây chính là những gì các Trading BOT đang làm, chúng thực tế đã đảm nhận vai trò của một Agent AI sơ cấp, chỉ là công việc tập trung vào giao dịch. Trong tương lai, khi các Trading BOT tích hợp và phát triển thêm AI, chúng chắc chắn sẽ thực hiện được nhiều mục đích giao dịch phức tạp hơn. Ví dụ: theo dõi 100 địa chỉ "tiền thông minh" trên chuỗi, phân tích chiến lược giao dịch và tỷ lệ thành công của họ, dùng 10% vốn trong địa chỉ của tôi để thực hiện các giao dịch tương tự trong một tuần, dừng lại nếu hiệu quả kém và tổng hợp các nguyên nhân thất bại có thể xảy ra.

AI vận hành trong hệ thống blockchain sẽ tốt hơn, về bản chất là do tính rõ ràng của quy tắc kinh tế mã hóa và quyền truy cập hệ thống không cần cho phép. Việc thực hiện nhiệm vụ trong một quy tắc giới hạn sẽ làm giảm rủi ro tiềm ẩn do tính ngẫu nhiên của AI. Ví dụ, hiệu suất của AI trong các cuộc thi cờ bạc, trò chơi điện tử đã áp đảo con người, bởi vì cờ bạc và trò chơi là một hộp cát đóng kín với quy tắc rõ ràng. Trong khi đó, tiến độ của AI trong lái xe tự hành chậm hơn, vì môi trường bên ngoài mở rộng thách thức lớn hơn, và chúng ta cũng khó chấp nhận tính ngẫu nhiên khi AI xử lý vấn đề.

Ví dụ B: Định hình tài nguyên, tập hợp tài nguyên thông qua phần thưởng token

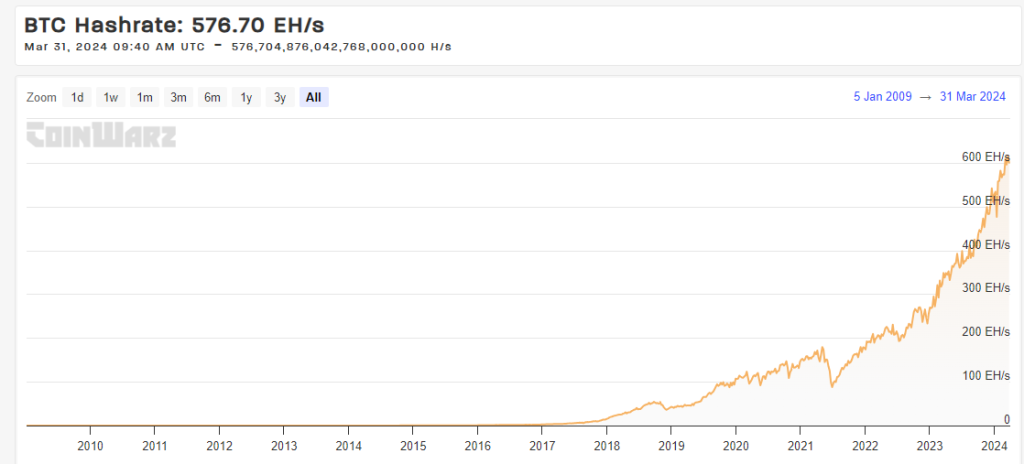

Mạng lưới sức mạnh tính toán toàn cầu phía sau BTC hiện tại có tổng sức mạnh tính toán (Hashrate: 576,70 EH/s) vượt quá tổng sức mạnh tính toán của siêu máy tính bất kỳ quốc gia nào. Động lực phát triển của nó đến từ phần thưởng mạng lưới đơn giản và công bằng.

Đồ thị xu hướng sức mạnh tính toán mạng BTC, nguồn: https://www.coinwarz.com/

Ngoài ra, các dự án DePIN bao gồm cả Mobile, cũng đang cố gắng định hình thị trường hai chiều cung-cầu thông qua phần thưởng token, nhằm tạo ra hiệu ứng mạng. Dự án IO.NET, trọng tâm phân tích trong bài viết này, là một nền tảng được thiết kế để tập hợp sức mạnh tính toán AI, hy vọng thông qua mô hình token kích hoạt tiềm năng sức mạnh tính toán AI lớn hơn.

Ví dụ C: Mã nguồn mở, tích hợp ZK, phân biệt người-máy trong điều kiện bảo vệ riêng tư

Worldcoin, một dự án Web3 mà Sam Altman – người đồng sáng lập OpenAI – tham gia, sử dụng thiết bị phần cứng Orb, dựa trên đặc điểm sinh trắc học mống mắt của con người, tạo ra giá trị băm riêng biệt và ẩn danh thông qua công nghệ ZK để xác minh danh tính, phân biệt người thật và máy. Đầu tháng 3 năm nay, dự án nghệ thuật Web3 Drip đã bắt đầu sử dụng ID Worldcoin để xác minh người dùng thật và phát phần thưởng.

Hơn nữa, Worldcoin gần đây đã công bố mã nguồn chương trình của thiết bị phần cứng mống mắt Orb, nhằm đảm bảo an toàn và riêng tư đặc điểm sinh trắc học người dùng.

Tổng thể, do tính xác định, không cần cho phép của mã code và mật mã học, lợi thế trong luân chuyển và huy động tài nguyên nhờ cơ chế token, cùng thuộc tính không cần tin tưởng nhờ mã nguồn mở và sổ cái công khai, kinh tế mã hóa đã trở thành một giải pháp tiềm năng quan trọng cho xã hội loài người đối mặt với thách thức từ AI.

Trong đó, thách thức cấp bách nhất và nhu cầu thương mại mạnh mẽ nhất chính là sự khao khát cực độ của sản phẩm AI đối với tài nguyên tính toán, xoay quanh nhu cầu khổng lồ về chip và sức mạnh tính toán.

Cũng chính vì vậy mà trong chu kỳ thị trường tăng giá lần này, các dự án tính toán phân tán dẫn đầu về đà tăng trưởng trong toàn bộ lĩnh vực AI.

Tính cần thiết về mặt thương mại của tính toán phân tán (Decentralized Compute)

AI cần lượng lớn tài nguyên tính toán, dù là để huấn luyện mô hình hay thực hiện suy luận.

Trong thực tiễn huấn luyện mô hình ngôn ngữ lớn, một thực tế đã được khẳng định: miễn là quy mô dữ liệu và tham số đủ lớn, mô hình ngôn ngữ lớn sẽ bộc lộ một số khả năng chưa từng có trước đó. Mỗi thế hệ GPT đều có bước nhảy cấp số nhân so với thế hệ trước, đằng sau đó là sự gia tăng cấp số nhân về lượng tính toán dùng để huấn luyện mô hình.

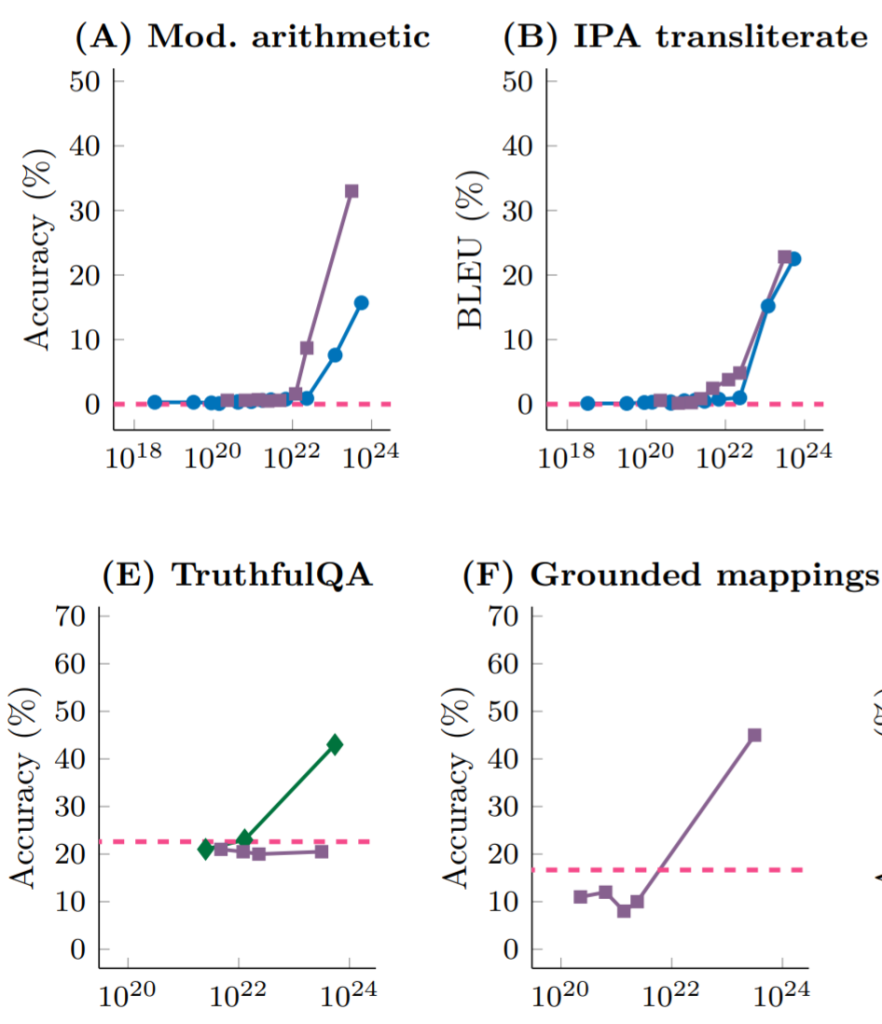

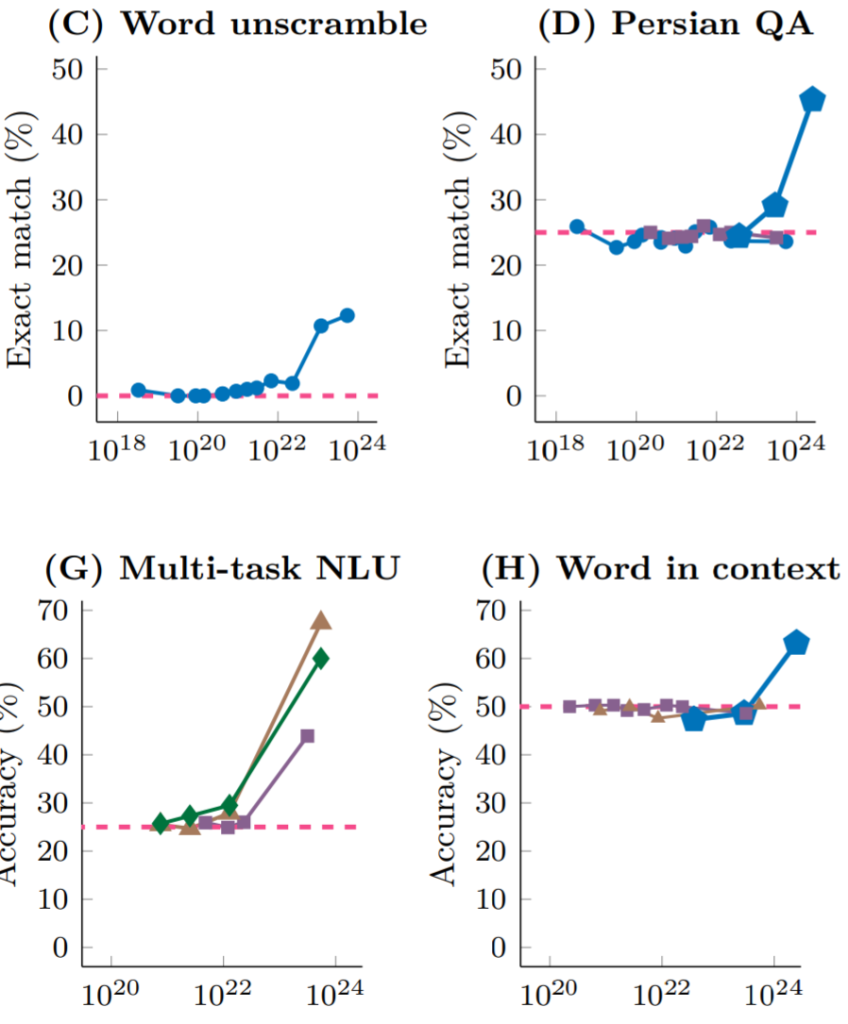

Nghiên cứu của DeepMind và Đại học Stanford cho thấy, các mô hình ngôn ngữ lớn khác nhau, khi đối mặt với các nhiệm vụ khác nhau (toán học, trả lời tiếng Ba Tư, hiểu ngôn ngữ tự nhiên...), chỉ cần mở rộng quy mô tham số mô hình trong quá trình huấn luyện (tương ứng, lượng tính toán huấn luyện cũng tăng lên), trước khi lượng tính toán đạt đến ngưỡng 10^22 FLOPs (FLOPs chỉ số phép toán dấu phẩy động mỗi giây, dùng để đo hiệu năng tính toán), hiệu suất ở mọi nhiệm vụ đều gần như ngẫu nhiên; nhưng một khi quy mô tham số vượt qua ngưỡng tới hạn đó, hiệu suất nhiệm vụ tăng vọt, bất kể là mô hình ngôn ngữ nào.

Nguồn: Emergent Abilities of Large Language Models

Nguồn: Emergent Abilities of Large Language Models

Chính là do quy luật và thực tiễn "dùng sức mạnh để tạo kỳ tích" trong sức mạnh tính toán đã khiến Sam Altman, người đồng sáng lập OpenAI, đề xuất huy động 7 nghìn tỷ USD để xây dựng một nhà máy chip tiên tiến có quy mô lớn gấp 10 lần TSMC hiện tại (dự kiến chi phí phần này là 1,5 nghìn tỷ), và dùng phần còn lại để sản xuất chip và huấn luyện mô hình.

Ngoài việc huấn luyện mô hình AI cần sức mạnh tính toán, quá trình suy luận mô hình cũng cần lượng lớn sức mạnh tính toán (mặc dù thấp hơn so với huấn luyện), do đó sự khao khát chip và sức mạnh tính toán đã trở thành trạng thái bình thường của các bên tham gia lĩnh vực AI.

So với các nhà cung cấp sức mạnh tính toán AI tập trung như Amazon Web Services, Google Cloud Platform, Azure của Microsoft, các đề xuất giá trị chính của tính toán AI phân tán bao gồm:

-

Khả năng truy cập: việc truy cập tài nguyên chip thông qua dịch vụ đám mây như AWS, GCP hoặc Azure thường mất vài tuần, và các mẫu GPU phổ biến thường hết hàng. Ngoài ra, để có được sức mạnh tính toán, người tiêu dùng thường phải ký hợp đồng dài hạn, thiếu linh hoạt với các công ty lớn này. Trong khi đó, nền tảng tính toán phân tán có thể cung cấp lựa chọn phần cứng linh hoạt hơn, khả năng truy cập cao hơn.

-

Giá thấp: do tận dụng chip nhàn rỗi, cộng với trợ cấp token từ giao thức mạng cho bên cung cấp chip và sức mạnh tính toán, mạng lưới tính toán phân tán có thể cung cấp sức mạnh tính toán rẻ hơn.

-

Chống kiểm duyệt: hiện tại chip tính toán đỉnh cao và nguồn cung bị các công ty công nghệ lớn độc quyền, cộng với chính phủ Mỹ và các nước khác đang tăng cường kiểm soát dịch vụ sức mạnh tính toán AI, việc có thể tiếp cận sức mạnh tính toán AI một cách phân tán, linh hoạt và tự do đang dần trở thành nhu cầu rõ rệt, đây cũng là đề xuất giá trị cốt lõi của nền tảng dịch vụ sức mạnh tính toán dựa trên web3.

Nếu nói năng lượng hóa thạch là máu của thời đại công nghiệp, thì sức mạnh tính toán có thể sẽ là máu của thời đại kỹ thuật số mới do AI mở ra, và nguồn cung sức mạnh tính toán sẽ trở thành cơ sở hạ tầng của thời đại AI. Cũng như stablecoin trở thành một nhánh phát triển mạnh mẽ của tiền pháp định trong thời đại Web3, liệu thị trường sức mạnh tính toán phân tán có trở thành một nhánh phát triển nhanh của thị trường sức mạnh tính toán AI?

Do đây vẫn còn là một thị trường khá sớm, mọi thứ còn cần được quan sát. Nhưng một số yếu tố sau đây có thể thúc đẩy câu chuyện hoặc việc áp dụng thị trường tính toán phân tán:

-

Tình trạng căng thẳng cung-cầu GPU kéo dài. Việc cung GPU liên tục căng thẳng có thể thúc đẩy một số nhà phát triển chuyển sang thử các nền tảng tính toán phân tán.

-

Mở rộng quản lý. Để nhận được dịch vụ sức mạnh tính toán AI từ các nền tảng tính toán đám mây lớn, bắt buộc phải trải qua KYC và nhiều lớp kiểm tra. Điều này ngược lại có thể thúc đẩy việc áp dụng nền tảng tính toán phân tán, đặc biệt là ở những khu vực bị hạn chế và trừng phạt.

-

Kích thích từ giá token. Giá token tăng trong chu kỳ thị trường tăng giá sẽ làm tăng giá trị trợ cấp của nền tảng đối với bên cung cấp GPU, từ đó thu hút thêm nhà cung cấp tham gia thị trường, mở rộng quy mô thị trường, giảm giá mua thực tế cho người tiêu dùng.

Tuy nhiên, thách thức đối với nền tảng tính toán phân tán cũng rất rõ ràng:

-

Khó khăn kỹ thuật và kỹ sư

-

Vấn đề xác minh công việc: tính toán mô hình học sâu, do cấu trúc phân tầng, đầu ra mỗi tầng đều là đầu vào cho tầng tiếp theo, do đó để xác minh tính hợp lệ của tính toán cần thực hiện lại toàn bộ công việc trước đó, không thể xác minh đơn giản và hiệu quả. Để giải quyết vấn đề này, nền tảng tính toán phân tán cần phát triển các thuật toán mới hoặc sử dụng kỹ thuật xác minh gần đúng, các kỹ thuật này có thể cung cấp đảm bảo xác suất về tính đúng đắn của kết quả, thay vì đảm bảo tuyệt đối.

-

Khó khăn về song song hóa: nền tảng tính toán phân tán tập hợp nguồn cung chip đuôi dài, điều này đồng nghĩa với việc sức mạnh tính toán mà mỗi thiết bị cung cấp là khá hạn chế, gần như không thể hoàn thành nhiệm vụ huấn luyện hoặc suy luận mô hình AI một cách độc lập trong thời gian ngắn, do đó phải sử dụng phương pháp song song hóa để phân tách và phân phối nhiệm vụ, rút ngắn tổng thời gian hoàn thành. Nhưng song song hóa lại phải đối mặt với hàng loạt vấn đề như cách phân chia nhiệm vụ (đặc biệt là các nhiệm vụ học sâu phức tạp), phụ thuộc dữ liệu, chi phí truyền thông bổ sung giữa các thiết bị...

-

Vấn đề bảo vệ riêng tư: làm sao đảm bảo dữ liệu và mô hình của bên mua không bị tiết lộ cho bên nhận nhiệm vụ?

-

-

Khó khăn về tuân thủ quản lý

-

Do tính chất không cần cho phép ở cả hai phía cung và cầu của nền tảng tính toán phân tán, một mặt có thể là điểm bán hàng thu hút một số khách hàng. Mặt khác, khi các quy định quản lý AI ngày càng hoàn thiện, nó có thể trở thành mục tiêu chỉnh đốn của chính phủ. Hơn nữa, một số nhà cung cấp GPU cũng lo lắng liệu tài nguyên tính toán họ cho thuê có bị cung cấp cho các doanh nghiệp hoặc cá nhân bị trừng phạt hay không.

-

Tổng thể, người tiêu dùng nền tảng tính toán phân tán chủ yếu là các nhà phát triển chuyên nghiệp hoặc các tổ chức quy mô nhỏ và vừa, khác với các nhà đầu tư mã hóa mua tiền mã hóa và NFT, những người dùng này đòi hỏi cao hơn về tính ổn định và liên tục của dịch vụ mà giao thức cung cấp, giá cả chưa hẳn là động lực quyết định chính của họ. Hiện tại, các nền tảng tính toán phân tán vẫn còn một chặng đường dài để giành được sự công nhận từ những người dùng này.

Tiếp theo, chúng ta sẽ phân tích và tóm tắt thông tin dự án IO.NET – một dự án tính toán phân tán mới trong chu kỳ này, đồng thời dựa trên các dự án AI và tính toán phân tán cùng lĩnh vực trên thị trường hiện tại để ước tính mức định giá có thể có sau khi niêm yết.

2. Nền tảng tính toán AI phân tán: IO.NET

2.1 Định vị dự án

IO.NET là một mạng lưới tính toán phi tập trung, xây dựng một thị trường hai chiều xung quanh chip, phía cung là sức mạnh tính toán từ các chip (chủ yếu là GPU, cũng có CPU và iGPU của Apple) phân bố khắp toàn cầu, phía cầu là các kỹ sư AI muốn hoàn thành nhiệm vụ huấn luyện hoặc suy luận mô hình AI.

Trên trang web chính thức của IO.NET, họ viết:

Nhiệm vụ của chúng tôi

Tập hợp một triệu GPU vào một DePIN – mạng lưới cơ sở hạ tầng vật lý phi tập trung.

Nhiệm vụ của họ là tích hợp hàng triệu GPU vào mạng DePIN của họ.

So với các nhà cung cấp dịch vụ sức mạnh tính toán AI đám mây hiện tại, điểm bán hàng chính mà họ nhấn mạnh là:

-

Tổ hợp linh hoạt: kỹ sư AI có thể tự do lựa chọn, kết hợp các chip cần thiết để tạo thành "cụm (cluster)", hoàn thành nhiệm vụ tính toán của mình

-

Triển khai nhanh chóng: không cần phê duyệt và chờ đợi vài tuần (tình trạng hiện tại của các nhà cung cấp tập trung như AWS), có thể triển khai và bắt đầu nhiệm vụ trong vài chục giây

-

Dịch vụ giá thấp: chi phí dịch vụ thấp hơn 90% so với các nhà cung cấp chính

Ngoài ra, IO.NET trong tương lai còn có kế hoạch ra mắt các dịch vụ như cửa hàng mô hình AI.

2.2 Cơ chế sản phẩm và dữ liệu kinh doanh

Cơ chế sản phẩm và trải nghiệm triển khai

Giống như Amazon Cloud, Google Cloud, Alibaba Cloud, dịch vụ tính toán mà IO.NET cung cấp được gọi là IO Cloud. IO Cloud là một mạng lưới chip phân tán, phi tập trung, có thể thực hiện mã học máy dựa trên Python, chạy các chương trình AI và học máy.

Mô-đun cơ bản của dịch vụ IO Cloud được gọi là cụm (Clusters), Clusters là một nhóm GPU có thể tự điều phối để hoàn thành nhiệm vụ tính toán, kỹ sư AI có thể tùy chỉnh cụm mong muốn theo nhu cầu của mình.

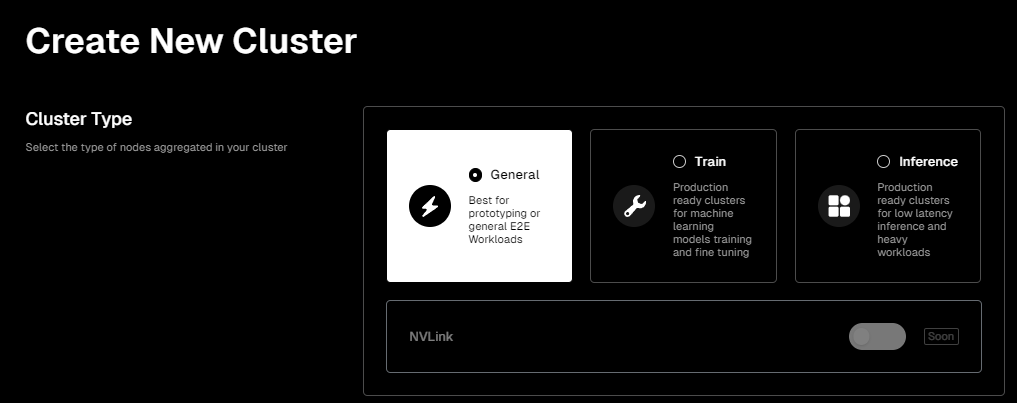

Giao diện sản phẩm của IO.NET rất thân thiện với người dùng. Nếu bạn muốn triển khai cụm chip riêng để hoàn thành nhiệm vụ tính toán AI, sau khi vào trang sản phẩm Clusters (cụm) của họ, bạn có thể bắt đầu cấu hình cụm chip theo nhu cầu.

Thông tin trang: https://cloud.io.net/cloud/clusters/create-cluster, tương tự bên dưới

Đầu tiên bạn cần chọn kịch bản nhiệm vụ của mình, hiện tại có ba loại:

-

Tổng quát (General): cung cấp một môi trường khá chung chung, phù hợp với giai đoạn dự án ban đầu khi chưa xác định rõ nhu cầu tài nguyên cụ thể.

-

Huấn luyện (Train): cụm được thiết kế riêng cho việc huấn luyện và tinh chỉnh mô hình học máy. Tùy chọn này có thể cung cấp nhiều tài nguyên GPU hơn, dung lượng bộ nhớ cao hơn và/hoặc kết nối mạng nhanh hơn để xử lý các nhiệm vụ tính toán cường độ cao này.

-

Suy luận (Inference): cụm được thiết kế riêng cho suy luận độ trễ thấp và công việc tải nặng. Trong ngữ cảnh học máy, suy luận là việc sử dụng mô hình đã được huấn luyện để dự đoán hoặc phân tích dữ liệu mới và cung cấp phản hồi. Do đó, tùy chọn này sẽ tập trung tối ưu hóa độ trễ và thông lượng để hỗ trợ nhu cầu xử lý dữ liệu thời gian thực hoặc gần thời gian thực.

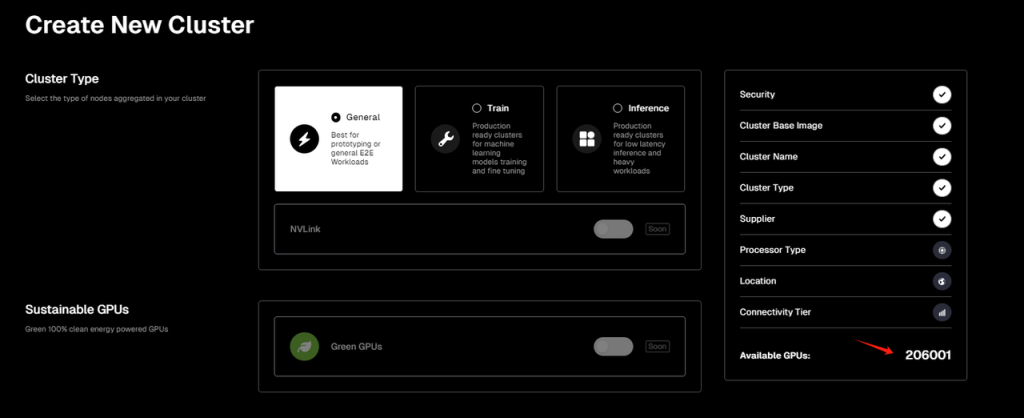

Tiếp theo, bạn cần chọn nhà cung cấp cụm chip. Hiện tại IO.NET đã hợp tác với Render Network và mạng lưới thợ đào Filecoin, do đó người dùng có thể chọn chip từ IO.NET hoặc hai mạng khác làm nhà cung cấp cụm tính toán của mình, tương đương với việc IO.NET đóng vai trò aggregator (tổng hợp). Tuy nhiên, tính đến thời điểm tác giả viết bài, dịch vụ Filecoin tạm thời ngừng hoạt động. Đáng chú ý, theo hiển thị trên trang, hiện tại số lượng GPU khả dụng trực tuyến của IO.NET là hơn 200.000, trong khi số lượng GPU khả dụng của Render Network là hơn 3.700.

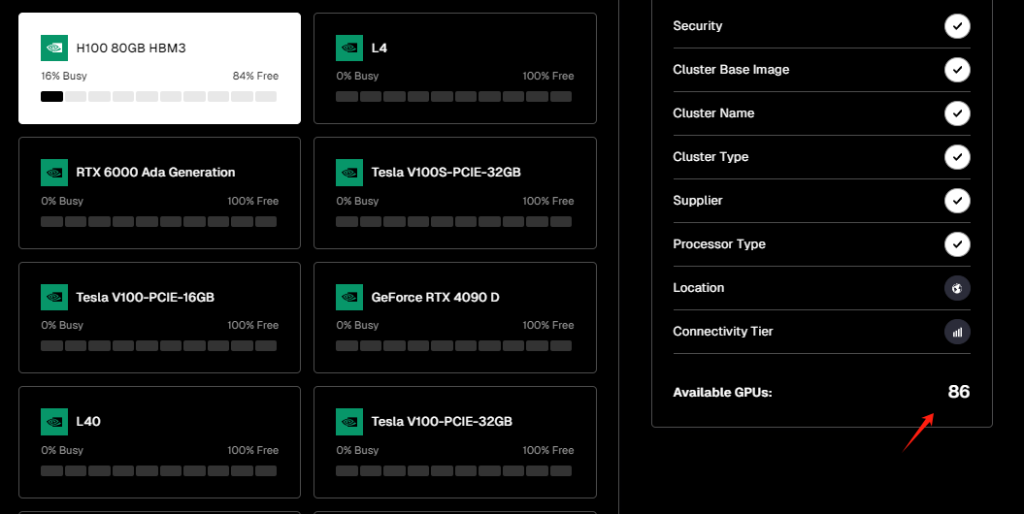

Sau đó là bước lựa chọn phần cứng cụm chip, hiện tại IO.NET chỉ liệt kê GPU là lựa chọn, không bao gồm CPU hoặc iGPU của Apple (M1, M2...), và GPU chủ yếu là sản phẩm của Nvidia.

Trong các lựa chọn phần cứng GPU được liệt kê và khả dụng trên trang chính thức, theo dữ liệu thử nghiệm của tác giả trong ngày, tổng số lượng GPU khả dụng trực tuyến của mạng IO.NET là 206.001 chiếc. Trong đó, dòng GeForce RTX 4090 là nhiều nhất (45.250 chiếc), tiếp theo là GeForce RTX 3090 Ti (30.779 chiếc).

Ngoài ra, chip A100-SXM4-80GB (giá thị trường trên 15.000$), hiệu quả cao hơn trong xử lý nhiệm vụ tính toán AI như học máy, học sâu, tính toán khoa học, có 7.965 chiếc đang trực tuyến.

Trong khi đó, card đồ họa H100 80GB HBM3 của Nvidia, được thiết kế phần cứng riêng cho AI ngay từ đầu (giá thị trường trên 40.000$), hiệu suất huấn luyện gấp 3,3 lần A100, hiệu suất suy luận gấp 4,5 lần A100, số lượng thực tế trực tuyến là 86 chiếc.

Sau khi chọn loại phần cứng cụm, người dùng còn phải chọn các tham số như khu vực cụm, tốc độ truyền thông, số lượng và thời gian thuê GPU.

Cuối cùng, IO.NET sẽ cung cấp hóa đơn dựa trên các lựa chọn tổng hợp. Ví dụ cấu hình cụm của tác giả:

-

Kịch bản nhiệm vụ Tổng quát (General)

-

16 chip A100-SXM4-80GB

-

Tốc độ kết nối cao nhất (Ultra High Speed)

-

Vị trí địa lý tại Mỹ

-

Thời gian thuê 1 tuần

Tổng hóa đơn này là 3.311,6$, giá thuê theo giờ cho mỗi card là 1,232$

Trong khi đó, giá thuê theo giờ mỗi card A100-SXM4-80GB trên Amazon Cloud, Google Cloud và Microsoft Azure lần lượt là 5,12$, 5,07$ và 3,67$ (nguồn dữ liệu: https://cloud-gpus.com/, giá thực tế có thể thay đổi tùy theo điều khoản hợp đồng).

Do đó, xét riêng về giá cả, sức mạnh tính toán chip của IO.NET thực sự rẻ hơn đáng kể so với các nhà cung cấp chính, đồng thời sự kết hợp và mua sắm tài nguyên cũng rất linh hoạt, thao tác dễ sử dụng.

Tình hình kinh doanh

Tình hình phía cung

Tính đến ngày 4 tháng 4 năm nay, theo dữ liệu chính thức, tổng nguồn cung GPU phía cung của IO.NET là 371.027 chiếc, CPU là 42.321 chiếc. Ngoài ra, Render Network với tư cách là đối tác, còn có 9.997 GPU và 776 CPU kết nối vào nguồn cung mạng lưới.

Nguồn dữ liệu: https://cloud.io.net/explorer/home, tương tự bên dưới

Tại thời điểm tác giả viết bài, tổng số 214.387 GPU được kết nối vào IO.NET đang ở trạng thái trực tuyến, tỷ lệ trực tuyến đạt 57,8%. Tỷ lệ trực tuyến của GPU từ Render Network là 45,1%.

Dữ liệu phía cung trên có ý nghĩa gì?

Để so sánh, chúng ta sẽ đưa vào một dự án tính toán phân tán lâu đời hơn là Akash Network.

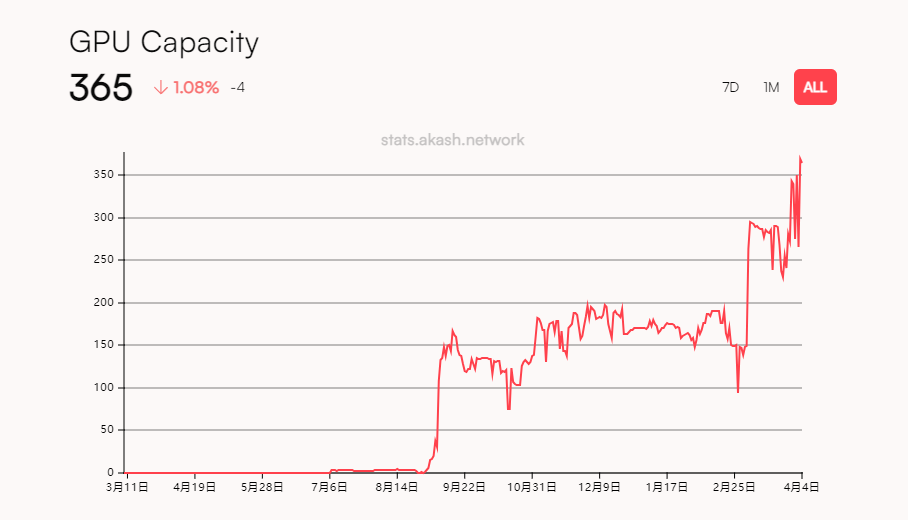

Akash Network đã ra mắt mainnet từ năm 2020, ban đầu tập trung chủ yếu vào dịch vụ phân tán CPU và lưu trữ. Tháng 6 năm 2023, họ ra mắt mạng thử nghiệm dịch vụ GPU, và ra mắt mainnet tính toán phân tán GPU vào tháng 9 cùng năm.

Nguồn dữ liệu: https://stats.akash.network/provider-graph/graphics-gpu

Theo dữ liệu chính thức của Akash, kể từ khi ra mắt mạng GPU, mặc dù nguồn cung phía cung tiếp tục tăng, nhưng đến nay tổng số GPU kết nối chỉ đạt 365 chiếc.

Xét về số lượng GPU cung cấp, IO.NET vượt xa Akash Network về vài cấp độ, hiện là mạng cung cấp lớn nhất trong lĩnh vực tính toán GPU phân tán.

Tình hình phía cầu

Tuy nhiên, xét về phía cầu, IO.NET vẫn đang ở giai đoạn đầu nuôi dưỡng thị trường, hiện tại tổng lượng sử dụng thực tế để thực hiện nhiệm vụ tính toán còn ít. Phần lớn tải trọng nhiệm vụ của GPU trực tuyến là 0%, chỉ có bốn loại chip A100 PCIe 80GB K8S, RTX A6000 K8S, RTX A4000 K8S, H100 80GB HBM3 đang xử lý nhiệm vụ. Và ngoại trừ A100 PCIe 80GB K8S, tải trọng của ba loại chip còn lại đều dưới 20%.

Hơn nữa, giá trị áp lực mạng được tiết lộ trong ngày là 0%, nghĩa là phần lớn nguồn cung chip đang ở trạng thái chờ trực tuyến.

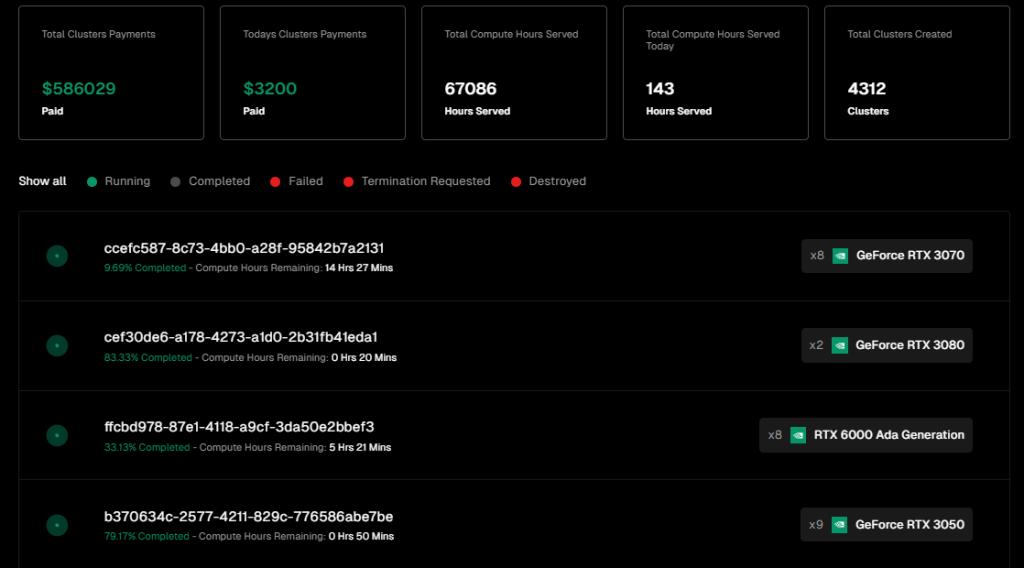

Về quy mô phí mạng, IO.NET đã tạo ra 586.029$ phí dịch vụ, phí trong ngày gần nhất là 3.200$.

Nguồn dữ liệu: https://cloud.io.net/explorer/clusters

Quy mô phí thanh toán mạng trên, dù xét tổng thể hay giao dịch hàng ngày, đều ở cùng cấp độ với Akash, tuy nhiên phần lớn thu nhập mạng của Akash đến từ phần CPU, với nguồn cung CPU của Akash lên tới hơn 20.000 chiếc.

Nguồn dữ liệu: https://stats.akash.network/

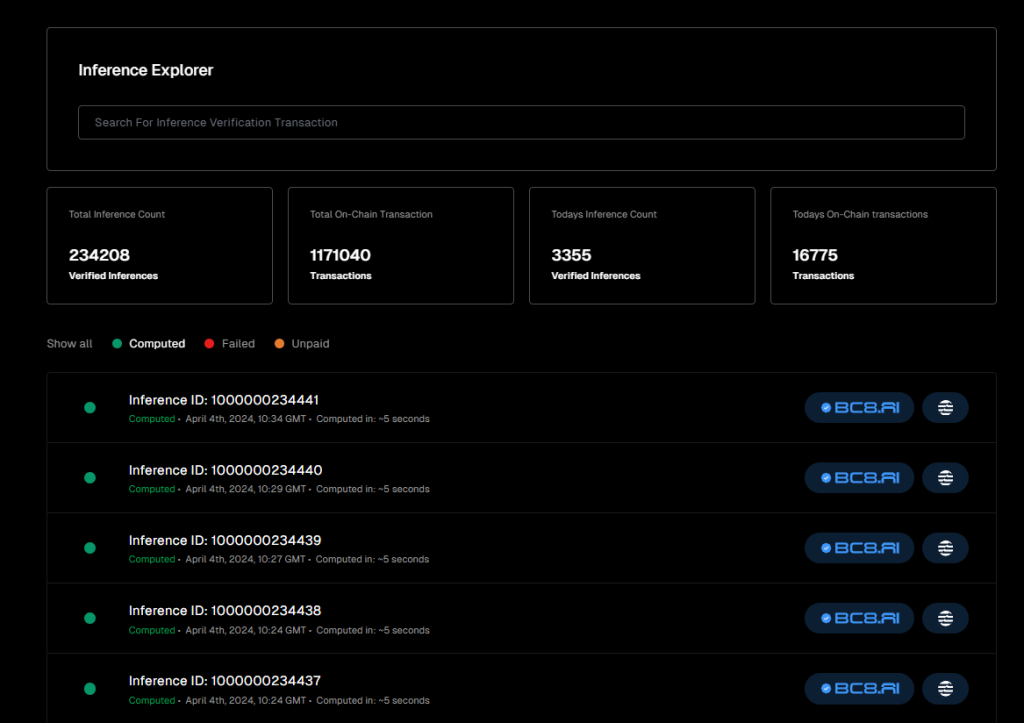

Ngoài ra, IO.NET còn tiết lộ dữ liệu kinh doanh nhiệm vụ suy luận AI mà mạng đã xử lý, tính đến nay đã xử lý và xác minh hơn 230.000 nhiệm vụ suy luận, tuy nhiên phần lớn khối lượng công việc này đến từ dự án BC8.AI do IO.NET tài trợ.

Nguồn dữ liệu: https://cloud.io.net/explorer/inferences

Xét theo dữ liệu kinh doanh hiện tại, phía cung của IO.NET mở rộng thuận lợi, dưới tác động của kỳ vọng airdrop và hoạt động cộng đồng mang tên "Ignition", đã nhanh chóng tập hợp lượng lớn sức mạnh tính toán chip AI. Trong khi đó, việc mở rộng phía cầu vẫn ở giai đoạn đầu, nhu cầu tự nhiên hiện tại còn chưa đủ. Việc thiếu hụt phía cầu hiện tại là do việc mở rộng người tiêu dùng chưa bắt đầu, hay do trải nghiệm dịch vụ hiện tại chưa ổn định nên chưa được áp dụng rộng rãi, điều này vẫn cần được đánh giá.

Tuy nhiên, xem xét rằng khoảng cách sức mạnh tính toán AI trong ngắn hạn khó có thể lấp đầy, có rất nhiều kỹ sư AI và dự án đang tìm kiếm giải pháp thay thế, có thể quan tâm đến nhà cung cấp phi tập trung, cộng với IO.NET hiện chưa triển khai kích thích kinh tế và hoạt động cho phía cầu, cùng với trải nghiệm sản phẩm ngày càng cải thiện, việc dần cân bằng cung-cầu trong tương lai vẫn đáng kỳ vọng.

2.3 Bối cảnh đội ngũ và tình hình gọi vốn

Tình hình đội ngũ

Đội ngũ cốt lõi của IO.NET ban đầu hoạt động trong lĩnh vực giao dịch định lượng, trước tháng 6 năm 2022, họ luôn tập trung phát triển hệ thống giao dịch định lượng cấp tổ chức cho cổ phiếu và tài sản mã hóa. Do nhu cầu về sức mạnh tính toán ở backend hệ thống, đội ngũ bắt đầu khám phá khả năng tính toán phi tập trung, và cuối cùng tập trung vào vấn đề cụ thể là giảm chi phí dịch vụ sức mạnh tính toán GPU.

Người sáng lập & CEO: Ahmad Shadid

Ahmad Shadid trước khi gia nhập IO.NET luôn làm việc trong lĩnh vực định lượng và kỹ thuật tài chính, đồng thời là tình nguyện viên của Quỹ Ethereum.

CMO & Giám đốc Chiến lược: Garrison Yang

Garrison Yang chính thức gia nhập IO.NET vào tháng 3 năm nay, trước đó là Phó Chủ tịch Chiến lược và Tăng trưởng tại Avalanche, tốt nghiệp Đại học California, Santa Barbara.

COO: Tory Green

Tory Green là COO của io.net, trước đó là COO của Hum Capital, Giám đốc Phát triển Doanh nghiệp và Chiến lược tại Fox Mobile Group, tốt nghiệp Đại học Stanford.

Theo thông tin LinkedIn của IO.NET, trụ sở đội ngũ tại New York, Mỹ, có chi nhánh tại San Francisco, hiện quy mô đội ngũ trên 50 người.

Tình hình gọi vốn

IO.NET đến nay chỉ công bố một vòng gọi vốn, đó là vòng Series A hoàn thành vào tháng 3 năm nay với định giá 1 tỷ USD, huy động tổng cộng 30 triệu USD, do Hack VC dẫn dắt, các nhà đầu tư khác bao gồm Multicoin Capital, Delphi Digital, Foresight Ventures, Animoca Brands, Continue Capital, Solana Ventures, Aptos, LongHash Ventures, OKX Ventures, Amber Group, SevenX Ventures và ArkStream Capital.

Chào mừng tham gia cộng đồng chính thức TechFlow

Nhóm Telegram:https://t.me/TechFlowDaily

Tài khoản Twitter chính thức:https://x.com/TechFlowPost

Tài khoản Twitter tiếng Anh:https://x.com/BlockFlow_News