Huang Renxun đối thoại cùng bảy tác giả chính của bài báo Transformer, thảo luận về tương lai của các mô hình lớn

Tuyển chọn TechFlowTuyển chọn TechFlow

Huang Renxun đối thoại cùng bảy tác giả chính của bài báo Transformer, thảo luận về tương lai của các mô hình lớn

Thế giới này cần thứ gì đó tốt hơn Transformer, và tôi nghĩ tất cả chúng ta ở đây đều mong muốn nó sẽ được thay thế bằng một cái gì đó mới, đưa chúng ta đến một đỉnh cao hiệu suất hoàn toàn mới.

Tác giả: Quách Hiểu Tĩnh

Nguồn: Tin tức Tencent

Năm 2017, một bài báo mang tính bước ngoặt – “Attention is All You Need” xuất hiện, lần đầu tiên giới thiệu mô hình Transformer dựa trên cơ chế tự chú ý. Kiến trúc đổi mới này thoát khỏi sự ràng buộc của RNN và CNN truyền thống, vượt qua khó khăn về phụ thuộc dài hạn thông qua cơ chế chú ý xử lý song song, đồng thời cải thiện đáng kể tốc độ xử lý dữ liệu chuỗi. Cấu trúc mã hóa-giải mã và cơ chế chú ý đa đầu của Transformer đã tạo nên làn sóng trong lĩnh vực trí tuệ nhân tạo, và ChatGPT nổi tiếng hiện nay cũng được xây dựng dựa trên kiến trúc này.

Hãy tưởng tượng, mô hình Transformer giống như bộ não của bạn khi đang trò chuyện với bạn bè, có thể đồng thời chú ý đến từng từ mà đối phương nói và hiểu mối liên hệ giữa các từ đó. Nó trao cho máy tính khả năng hiểu ngôn ngữ tương tự con người. Trước đó, RNN là phương pháp chủ đạo để xử lý ngôn ngữ, nhưng tốc độ xử lý thông tin chậm chạp, giống như chiếc máy phát băng cổ điển, phải phát từng chữ một. Trong khi đó, mô hình Transformer giống như một DJ hiệu quả, có thể điều khiển nhiều bản nhạc cùng lúc, nhanh chóng nắm bắt thông tin then chốt.

Sự ra đời của mô hình Transformer đã nâng cao mạnh mẽ khả năng xử lý ngôn ngữ của máy tính, giúp các nhiệm vụ như dịch máy, nhận dạng giọng nói và tóm tắt văn bản trở nên hiệu quả và chính xác hơn, đây là một bước tiến khổng lồ đối với toàn ngành.

Thành quả đổi mới này đến từ nỗ lực chung của tám nhà khoa học AI từng làm việc tại Google. Mục tiêu ban đầu của họ rất đơn giản: cải thiện dịch vụ dịch máy của Google. Họ mong muốn máy móc có thể hiểu toàn bộ câu một cách hoàn chỉnh, thay vì dịch từng từ một cách rời rạc. Tư tưởng này trở thành điểm khởi đầu cho kiến trúc "Transformer" – cơ chế "tự chú ý". Trên cơ sở đó, tám tác giả phát huy chuyên môn riêng, công bố bài báo “Attention Is All You Need” vào tháng 12 năm 2017, miêu tả chi tiết kiến trúc Transformer, mở ra chương mới cho trí tuệ nhân tạo sinh tạo.

Trong thế giới trí tuệ nhân tạo sinh tạo, định luật quy mô (Scaling Law) là nguyên tắc cốt lõi. Nói một cách đơn giản, khi mô hình Transformer mở rộng quy mô, hiệu suất của nó cũng tăng lên, tuy nhiên điều này cũng đồng nghĩa với việc cần tài nguyên tính toán mạnh mẽ hơn để hỗ trợ các mô hình lớn hơn và mạng sâu hơn, và NVIDIA – nhà cung cấp dịch vụ tính toán hiệu suất cao – cũng trở thành vai trò then chốt trong đợt sóng AI này.

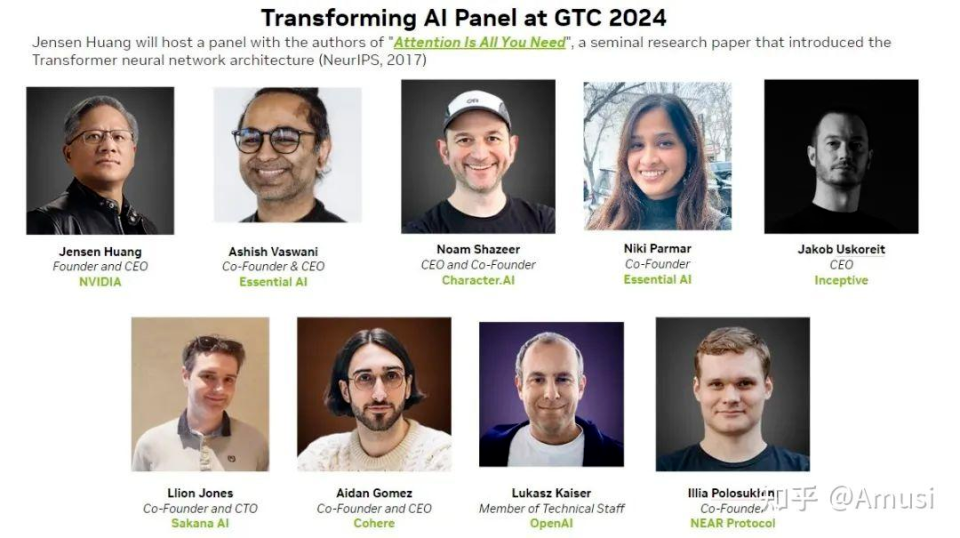

Tại hội nghị GTC năm nay, Huang Renxun của NVIDIA đã mời bảy trong số tám tác giả của Transformer (Niki Parmar vắng mặt do bận việc) tham gia diễn đàn bàn tròn theo cách thức đầy tính nghi lễ. Đây là lần đầu tiên tám tác giả xuất hiện tập thể trước công chúng.

Họ cũng bày tỏ một số quan điểm ấn tượng trong cuộc đối thoại:

-

Thế giới này cần thứ gì đó tốt hơn Transformer. Tôi nghĩ tất cả những người ngồi đây đều hy vọng nó sẽ bị thay thế bởi một cái gì đó, đưa chúng ta lên một tầm cao hiệu suất mới.

-

Chúng tôi không thực sự thành công với mục tiêu ban đầu. Chúng tôi bắt đầu với Transformer nhằm mô phỏng quá trình tiến hóa của token. Nó không chỉ đơn thuần là quá trình tạo tuyến tính, mà là sự tiến hóa dần dần của văn bản hoặc mã.

-

Với những vấn đề đơn giản như 2+2, mô hình lớn vẫn có thể sử dụng hàng nghìn tỷ tham số. Tôi cho rằng tính toán thích ứng là điều cần thiết tiếp theo, chúng ta cần biết nên dành bao nhiêu tài nguyên tính toán cho từng vấn đề cụ thể.

-

Tôi nghĩ các mô hình hiện tại quá rẻ tiền, quy mô vẫn còn nhỏ, giá khoảng 1 USD cho một triệu token, rẻ hơn 100 lần so với việc mua một cuốn sách bìa mềm bên ngoài.

Dưới đây là nội dung ghi lại:

Huang Renxun: Trong sáu mươi năm qua, dường như công nghệ máy tính chưa trải qua biến đổi căn bản nào, ít nhất là kể từ khi tôi chào đời. Hệ thống máy tính mà chúng ta đang dùng ngày nay – xử lý đa nhiệm, sự tách biệt giữa phần cứng và phần mềm, tính tương thích phần mềm, khả năng sao lưu dữ liệu, hay kỹ năng lập trình của các kỹ sư phần mềm – về cơ bản đều dựa trên nguyên tắc thiết kế của IBM System360: CPU trung tâm, hệ thống Bio, xử lý đa nhiệm, phần cứng-phần mềm, tính tương thích hệ thống phần mềm, v.v.

Tôi cho rằng, kể từ năm 1964, điện toán hiện đại chưa từng có thay đổi căn bản nào. Dù trong những năm 80 và 90 của thế kỷ 20, máy tính đã trải qua một chuyển đổi lớn, hình thành nên hình thái mà chúng ta quen thuộc ngày nay. Nhưng theo thời gian, chi phí biên của máy tính liên tục giảm, mỗi thập kỷ giảm mười lần, mười lăm năm giảm một nghìn lần, hai mươi năm giảm một vạn lần. Trong cuộc cách mạng máy tính này, mức độ giảm chi phí lớn đến mức, trong vòng hai mươi năm, chi phí máy tính gần như giảm một vạn lần, sự thay đổi này đã mang lại động lực khổng lồ cho xã hội.

Hãy thử hình dung, nếu mọi vật đắt đỏ trong cuộc sống bạn đều giảm xuống còn một phần vạn, ví dụ chiếc xe hơi bạn mua cách đây hai mươi năm với giá 200.000 USD, giờ chỉ còn 1 USD, bạn có thể hình dung sự thay đổi này không? Tuy nhiên, sự giảm chi phí máy tính không xảy ra ngay lập tức, mà dần dần đạt đến một điểm tới hạn, sau đó xu hướng giảm chi phí đột ngột dừng lại, nó vẫn cải thiện từng chút mỗi năm, nhưng tỷ lệ thay đổi đã đình trệ.

Chúng tôi bắt đầu khám phá điện toán tăng tốc, nhưng việc sử dụng điện toán tăng tốc không dễ dàng, bạn cần thiết kế từ đầu từng chút một. Trước đây, chúng ta có thể giải quyết vấn đề theo từng bước cố định, nhưng bây giờ, chúng ta cần thiết kế lại các bước này, đây là một lĩnh vực khoa học hoàn toàn mới, diễn đạt lại các quy tắc trước đây dưới dạng thuật toán song song.

Chúng tôi nhận ra điều này và tin rằng, nếu có thể tăng tốc dù chỉ 1% mã lệnh, tiết kiệm 99% thời gian chạy, thì chắc chắn sẽ có ứng dụng hưởng lợi. Mục tiêu của chúng tôi là biến điều không thể thành có thể, hoặc biến điều có thể thành không thể, hoặc làm cho điều đã có thể trở nên hiệu quả hơn – đó chính là ý nghĩa của điện toán tăng tốc.

Nhìn lại lịch sử công ty, chúng tôi thấy mình có khả năng tăng tốc mọi ứng dụng. Ban đầu, chúng tôi đạt được hiệu quả tăng tốc rõ rệt trong lĩnh vực game, tốt đến mức mọi người nhầm tưởng chúng tôi là một công ty game. Nhưng thực tế, mục tiêu của chúng tôi còn xa hơn thế, bởi thị trường này đủ lớn để thúc đẩy tiến bộ công nghệ đáng kinh ngạc. Điều này không phổ biến, nhưng chúng tôi đã tìm thấy một ngoại lệ đặc biệt như vậy.

Tóm gọn lại, năm 2012, AlexNet đã châm ngòi cho tia lửa nhỏ, đánh dấu lần va chạm đầu tiên giữa trí tuệ nhân tạo và GPU của NVIDIA. Điều này đánh dấu sự khởi đầu cho hành trình kỳ diệu của chúng tôi trong lĩnh vực này. Vài năm sau, chúng tôi tìm thấy một ứng dụng hoàn hảo, đặt nền móng cho sự phát triển ngày nay.

Tóm lại, những thành tựu này đã đặt nền tảng cho sự phát triển của trí tuệ nhân tạo sinh tạo. AI sinh tạo không chỉ có thể nhận diện hình ảnh, mà còn biến văn bản thành hình ảnh, thậm chí tạo ra nội dung hoàn toàn mới. Bây giờ, chúng ta đã có đủ năng lực kỹ thuật để hiểu pixel, nhận diện chúng và hiểu ý nghĩa đằng sau chúng. Thông qua ý nghĩa đằng sau đó, chúng ta có thể tạo ra nội dung mới. Khả năng mà AI hiểu được ý nghĩa đằng sau dữ liệu thông qua học từ dữ liệu là một biến đổi lớn.

Chúng tôi có lý do để tin rằng, đây là khởi đầu của một cuộc cách mạng công nghiệp hoàn toàn mới. Trong cuộc cách mạng này, chúng tôi đang tạo ra những điều chưa từng có. Ví dụ, trong các cuộc cách mạng công nghiệp trước, nước là nguồn năng lượng, nước đi vào thiết bị do chúng ta tạo ra, máy phát điện bắt đầu hoạt động, nước vào – điện ra, như một phép màu.

AI sinh tạo là một loại "phần mềm" hoàn toàn mới, nó có thể tạo ra phần mềm, và nó phụ thuộc vào nỗ lực chung của nhiều nhà khoa học. Hãy tưởng tượng, bạn cung cấp nguyên liệu – dữ liệu – cho AI, chúng đi vào một "tòa nhà" – chúng ta gọi là máy GPU, và nó sẽ đưa ra kết quả thần kỳ. Nó đang định hình lại mọi thứ, chúng ta đang chứng kiến sự ra đời của "nhà máy AI".

Sự biến đổi này có thể được gọi là một cuộc cách mạng công nghiệp hoàn toàn mới. Trước đây, chúng ta chưa từng trải nghiệm biến đổi như vậy, nhưng giờ đây, nó đang từ từ hiện ra trước mắt chúng ta. Đừng bỏ lỡ thập kỷ tiếp theo, bởi trong thập kỷ này, chúng ta sẽ tạo ra năng suất khổng lồ. Kim đồng hồ thời gian đã khởi động, các nhà nghiên cứu của chúng ta đã bắt đầu hành động.

Hôm nay, chúng tôi mời các nhà sáng tạo Transformer đến để cùng thảo luận về việc AI sinh tạo trong tương lai sẽ dẫn dắt chúng ta đi đâu.

Họ là:

Ashish Vaswani: Gia nhập đội ngũ Google Brain năm 2016. Tháng 4 năm 2022, cùng Niki Parmar sáng lập Adept AI, rời công ty này vào tháng 12 cùng năm và đồng sáng lập một công ty khởi nghiệp AI khác là Essential AI.

Niki Parmar: Làm việc tại Google Brain trong bốn năm, sau đó cùng Ashish Vaswani sáng lập Adept AI và Essential AI.

Jakob Uszkoreit: Làm việc tại Google từ năm 2008 đến 2021. Năm 2021 rời Google và cùng người khác sáng lập Inceptive, công ty chuyên về khoa học sự sống AI, sử dụng mạng thần kinh và thí nghiệm quy mô lớn để thiết kế phân tử RNA thế hệ tiếp theo.

Illia Polosukhin: Gia nhập Google năm 2014, là một trong những người sớm rời nhóm tám người, cùng người khác sáng lập công ty blockchain NEAR Protocol vào năm 2017.

Noam Shazeer: Từng làm việc tại Google trong giai đoạn 2000-2009 và 2012-2021. Năm 2021, Shazeer rời Google và cùng kỹ sư cũ Daniel De Freitas sáng lập Character.AI.

Llion Jones: Từng làm việc tại Delcam, YouTube. Năm 2012 gia nhập Google làm kỹ sư phần mềm. Sau đó rời Google, sáng lập công ty khởi nghiệp AI sakana.ai.

Lukasz Kaiser: Từng là nhà nghiên cứu tại Trung tâm Khoa học Quốc gia Pháp. Năm 2013 gia nhập Google. Năm 2021, ông rời Google và trở thành nhà nghiên cứu tại OpenAI.

Aidan Gomez: Tốt nghiệp Đại học Toronto, Canada. Khi bài báo về Transformer được công bố, anh vẫn là thực tập sinh trong đội Google Brain. Là người thứ hai trong nhóm tám người rời Google. Năm 2019, anh cùng người khác sáng lập Cohere.

Huang Renxun: Hôm nay mời mọi người đến đây, hãy tích cực tranh giành cơ hội phát biểu, ở đây không có chủ đề nào là không thể bàn. Các bạn thậm chí có thể nhảy khỏi ghế để thảo luận. Hãy bắt đầu từ câu hỏi cơ bản nhất: các bạn gặp phải vấn đề gì, điều gì đã truyền cảm hứng để các bạn làm nên Transformer?

Illia Polosukhin: Nếu bạn muốn phát hành mô hình thực sự đọc được kết quả tìm kiếm, ví dụ xử lý đống tài liệu, bạn cần một mô hình có thể xử lý thông tin nhanh chóng. Mạng nơ-ron đệ quy (RNN) lúc đó không đáp ứng được nhu cầu này.

Thật vậy, lúc đó mặc dù đã có mạng nơ-ron đệ quy (RNN) và một số cơ chế chú ý sơ khai (Arnens) thu hút sự chú ý, nhưng chúng vẫn phải đọc từng từ một, hiệu quả không cao.

Jakob Uszkoreit: Tốc độ tạo dữ liệu huấn luyện của chúng tôi nhanh hơn nhiều so với khả năng huấn luyện kiến trúc tiên tiến nhất. Thực tế, chúng tôi sử dụng kiến trúc đơn giản hơn, ví dụ mạng phản hồi với đặc trưng đầu vào là n-gram. Những kiến trúc này ít nhất trong quy mô dữ liệu huấn luyện khổng lồ của Google, nhờ tốc độ huấn luyện nhanh hơn, thường vượt qua các mô hình phức tạp và tiên tiến hơn.

Lúc đó, RNN mạnh mẽ, đặc biệt là mạng LSTM (Long Short-Term Memory), đã tồn tại.

Noam Shazeer: Có vẻ đây là một vấn đề cấp bách cần giải quyết. Khoảng năm 2015, chúng tôi đã bắt đầu nhận ra các định luật Scaling, bạn có thể thấy khi quy mô mô hình tăng lên, mức độ thông minh của nó cũng tăng theo. Đây giống như vấn đề tuyệt vời nhất trong lịch sử thế giới, rất đơn giản: bạn chỉ cần dự đoán token tiếp theo, nó sẽ trở nên thông minh đến mức có thể làm trăm ngàn việc khác nhau, bạn chỉ cần mở rộng quy mô và làm cho nó tốt hơn.

Một thất vọng lớn là RNN xử lý quá rắc rối. Sau đó tôi vô tình nghe mấy người này thảo luận, này, hãy dùng卷积 hoặc cơ chế chú ý để thay thế nó. Tôi nghĩ, tuyệt vời, cứ làm vậy. Tôi thích so sánh Transformer như bước nhảy từ động cơ hơi nước sang động cơ đốt trong. Chúng ta có thể hoàn thành cuộc cách mạng công nghiệp bằng động cơ hơi nước, nhưng sẽ rất đau khổ, còn động cơ đốt trong khiến mọi thứ tốt hơn hẳn.

Ashish Vaswani: Tôi bắt đầu nhận ra những bài học cay đắng từ thời研究生, đặc biệt khi làm việc về dịch máy. Tôi nhận ra, này, tôi sẽ không học những quy tắc ngôn ngữ phức tạp đó. Tôi nghĩ gradient descent (giảm dần theo gradient) – phương pháp huấn luyện mô hình của chúng ta – là giáo viên giỏi hơn tôi. Vì vậy tôi sẽ không học những quy tắc đó, tôi chỉ để gradient descent làm mọi việc thay tôi, đó là bài học thứ hai của tôi.

Bài học tôi rút ra từ những trải nghiệm cay đắng đó là, những kiến trúc tổng quát có thể mở rộng cuối cùng sẽ chiến thắng về lâu dài. Hôm nay có thể là token, ngày mai có thể là hành động trên máy tính của chúng ta, chúng sẽ bắt đầu mô phỏng hoạt động của chúng ta và có thể tự động hóa nhiều công việc chúng ta đang làm. Như chúng ta đã thảo luận, Transformer, đặc biệt là cơ chế tự chú ý, có phạm vi áp dụng rất rộng, nó cũng khiến gradient descent tốt hơn. Ngoài ra là vật lý, vì tôi học được từ Noam rằng phép nhân ma trận là một ý tưởng hay.

Noam Shazeer: Mô hình này luôn lặp lại. Mỗi khi bạn thêm một loạt quy tắc, gradient descent cuối cùng sẽ giỏi hơn bạn trong việc học những quy tắc đó. Chính xác như vậy. Giống như chúng ta đang làm học sâu, chúng ta đang xây dựng một mô hình AI có hình dạng như GPU. Và bây giờ, chúng ta đang xây dựng một mô hình AI có hình dạng như siêu máy tính. Đúng vậy, siêu máy tính giờ đây chính là mô hình. Đúng, đúng vậy. Siêu máy tính chỉ để các bạn biết, chúng ta đang xây dựng siêu máy tính để nó có hình dạng của mô hình.

Huang Renxun: Vậy các bạn muốn giải quyết vấn đề gì?

Lukasz Kaiser: Dịch máy. Nhớ lại năm năm trước, quá trình này dường như rất khó khăn, bạn phải thu thập dữ liệu, có thể dịch, nhưng kết quả có thể chỉ vừa đúng. Trình độ lúc đó còn sơ khai. Nhưng hiện nay, những mô hình này có thể học dịch mà không cần dữ liệu. Bạn chỉ cần cung cấp một ngôn ngữ và một ngôn ngữ khác, mô hình tự học cách dịch, khả năng này như xuất hiện một cách tự nhiên, và hiệu quả rất hài lòng.

Llion Jones: Nhưng, trực giác của "Attention" chính là điều bạn cần. Vì vậy tôi nghĩ ra tiêu đề này, điều xảy ra cơ bản là trong lúc chúng tôi đang tìm tiêu đề.

Chúng tôi chỉ đang làm thí nghiệm loại trừ, bắt đầu vứt bỏ một số mảnh của mô hình, chỉ để xem nó có tệ hơn không. Điều đáng ngạc nhiên là, nó bắt đầu tốt hơn. Bao gồm việc vứt bỏ tất cả卷积 hiệu quả tốt hơn nhiều. Vì vậy mà có tiêu đề đó.

Ashish Vaswani: Cơ bản thú vị là, chúng tôi thực sự bắt đầu từ một khung cơ bản nhất, sau đó thêm thứ vào, chúng tôi thêm卷积, tôi đoán sau đó lại bỏ chúng đi. Và còn nhiều thứ quan trọng khác như chú ý đa đầu.

Huang Renxun: Ai nghĩ ra tên Transformer? Tại sao lại gọi là Transformer?

Jakob Uszkoreit: Chúng tôi thích cái tên này, chúng tôi chỉ đặt đại một cái tên, cảm thấy nó rất sáng tạo, thay đổi mô hình sản xuất dữ liệu của chúng tôi, sử dụng một logic như vậy. Tất cả học máy đều là Transformer, đều là kẻ phá cách.

Noam Shazeer: Chúng tôi chưa từng nghĩ đến cái tên này, tôi thấy nó đặc biệt đơn giản, nhiều người cảm thấy tên này đặc biệt hay. Tôi từng nghĩ đến nhiều tên, như Yaakov, cuối cùng chọn "Transformer", nó mô tả nguyên lý của mô hình, thực tế nó chuyển đổi toàn bộ tín hiệu, theo logic này, gần như tất cả học máy sẽ bị chuyển đổi.

Llion Jones: Transformer trở thành cái tên quen thuộc không chỉ vì nội dung dịch thuật, mà vì chúng tôi muốn mô tả sự thay đổi này theo cách khái quát hơn. Tôi không cảm thấy chúng tôi làm được điều gì đặc biệt, nhưng với tư cách là người thay đổi, là động cơ và động lực, nó hợp lý. Mọi người có thể hiểu được mô hình ngôn ngữ lớn, động cơ và logic này, xét về kiến trúc, đây là thời điểm bắt đầu khá sớm.

Nhưng chúng tôi thực sự nhận ra, chúng tôi đang cố gắng tạo ra thứ gì đó rất, rất tổng quát, nó thực sự có thể biến bất cứ thứ gì thành bất cứ thứ gì. Và tôi không nghĩ chúng tôi dự đoán được khi Transformer được dùng cho hình ảnh, thực tế nó lại tốt đến thế, điều này hơi ngạc nhiên. Với các bạn có thể hợp lý, nhưng thực tế, bạn có thể chia hình ảnh thành các khối và đánh dấu từng điểm nhỏ, đúng không. Tôi nghĩ điều này đã tồn tại từ sớm về mặt kiến trúc.

Vì vậy, khi chúng tôi xây dựng thư viện tensor sang tensor, điều chúng tôi thực sự quan tâm là mở rộng quy mô huấn luyện tự hồi quy. Không chỉ là ngôn ngữ, mà còn là thành phần hình ảnh, âm thanh.

Vì vậy Lukasz nói anh ấy đang làm dịch thuật. Tôi nghĩ anh ấy đã đánh giá thấp bản thân, tất cả những ý tưởng này, bây giờ chúng tôi bắt đầu thấy các mẫu kết hợp lại, chúng đều được đưa vào mô hình.

Nhưng thực tế, mọi thứ đều đã tồn tại từ sớm, những ý tưởng này đang lan toả, cần một thời gian. Mục tiêu của Lukasz là chúng ta có tất cả các tập dữ liệu học thuật này, từ hình ảnh sang văn bản, từ văn bản sang hình ảnh, từ âm thanh sang văn bản, từ văn bản sang văn bản. Chúng ta nên huấn luyện mọi thứ.

Ý tưởng này thực sự thúc đẩy công việc mở rộng, cuối cùng thành công, nó thú vị đến mức, chúng ta có thể dịch hình ảnh sang văn bản, văn bản sang hình ảnh, dịch văn bản sang văn bản.

Bạn đang dùng nó để nghiên cứu sinh học, hoặc phần mềm sinh học, nó có thể giống như phần mềm máy tính, bắt đầu dưới dạng chương trình, sau đó bạn biên dịch nó thành thứ có thể chạy trên GPU.

Sự sống của phần mềm sinh học bắt đầu từ một số quy tắc hành vi. Ví dụ, bạn muốn in một protein, giống như protein cụ thể trong tế bào. Sau đó bạn học cách dùng học sâu để chuyển đổi nó thành phân tử RNA, nhưng thực tế khi vào tế bào của bạn, nó thể hiện những hành vi đó. Vì vậy ý tưởng này thực sự không chỉ đơn thuần là dịch sang tiếng Anh.

Huang Renxun: Các bạn có tạo một phòng thí nghiệm lớn để sản xuất tất cả những thứ này không?

Aidan Gomez: Có sẵn số lượng lớn, thực tế vẫn công khai, vì dữ liệu này thường vẫn chủ yếu do tài trợ công cộng. Nhưng thực tế, bạn vẫn cần dữ liệu để làm rõ hiện tượng bạn đang cố gắng.

Cố gắng mô hình hóa trong sản phẩm nhất định, ví dụ biểu hiện protein và vaccine mRNA, hoặc đúng vậy, ở Palo Alto, chúng tôi có một đống robot và những người mặc áo phòng thí nghiệm, cả nhà nghiên cứu học hỏi lẫn những người từng là nhà sinh học.

Hiện nay, chúng tôi coi mình là người tiên phong trong điều mới mẻ, tận tụy tạo ra dữ liệu này và xác thực các mô hình thiết kế phân tử. Nhưng ý tưởng ban đầu là dịch thuật.

Huang Renxun: Ý tưởng ban đầu là dịch máy, tôi muốn hỏi, trong việc củng cố và đột phá kiến trúc, các nút then chốt là gì? Và chúng ảnh hưởng thế nào đến thiết kế Transformer?

Aidan Gomez: Trong suốt hành trình, các bạn đều thấy, bạn có nghĩ rằng trên thiết kế Transformer cơ bản thực sự có đóng góp bổ sung lớn không? Tôi nghĩ đã có rất nhiều công việc để tăng tốc các mô hình này trong suy luận, làm chúng hiệu quả hơn.

Tôi vẫn cảm thấy hơi bất an vì hình thức gốc của chúng ta giống nhau đến thế nào. Tôi nghĩ thế giới này cần thứ gì đó tốt hơn Transformer. Tôi nghĩ tất cả những người ngồi đây đều hy vọng nó sẽ bị thay thế bởi một cái gì đó, đưa chúng ta lên một tầm cao hiệu suất mới.

Tôi muốn hỏi mỗi người ở đây một câu hỏi. Bạn nghĩ điều gì sẽ xảy ra tiếp theo? Bởi vì tôi nghĩ nó quá giống với thứ 6-7 năm trước, đúng không?

Llion Jones: Đúng vậy, tôi nghĩ mọi người sẽ ngạc nhiên về mức độ giống nhau mà bạn nói, đúng không? Mọi người thực sự thích hỏi tôi điều gì sẽ xảy ra tiếp theo, vì tôi là tác giả bài báo. Như một phép màu, bạn vẫy cây đũa thần, bước tiếp theo sẽ là gì? Tôi muốn chỉ ra cách nguyên lý cụ thể này được thiết kế. Chúng ta không chỉ cần tốt hơn, chúng ta cần tốt hơn rõ rệt.

Bởi vì nếu nó chỉ tốt hơn một chút, thì điều đó chưa đủ để đưa toàn ngành AI đến điều mới mẻ. Vì vậy, chúng ta bị mắc kẹt với mô hình gốc, dù về mặt kỹ thuật, nó có thể không phải thứ mạnh nhất mà chúng ta có hiện nay.

Nhưng ai cũng biết công cụ cá nhân mình muốn là gì, bạn muốn cửa sổ ngữ cảnh tốt hơn, bạn muốn khả năng tạo token nhanh hơn. Được rồi, tôi không chắc bạn có thích câu trả lời này không, nhưng hiện nay họ đang sử dụng quá nhiều tài nguyên tính toán. Tôi nghĩ mọi người đang lãng phí rất nhiều tính toán. Chúng tôi đang nỗ lực cải thiện hiệu quả, cảm ơn.

Huang Renxun: Tôi nghĩ chúng ta đang làm mọi thứ hiệu quả hơn, cảm ơn!

Jakob Uszkoreit: Nhưng tôi nghĩ chủ yếu là về cách phân bổ tài nguyên, chứ không phải tổng lượng tiêu thụ. Ví dụ, chúng tôi không muốn chi quá nhiều tiền cho vấn đề dễ, hoặc chi quá ít cho vấn đề quá khó và cuối cùng không có giải pháp.

Illia Polosukhin: Ví dụ như 2+2, nếu bạn đưa chính xác vào mô hình này, nó sẽ sử dụng một nghìn tỷ tham số. Vì vậy tôi nghĩ tính toán thích ứng là điều cần thiết tiếp theo, chúng ta cần biết nên dành bao nhiêu tài nguyên tính toán cho từng vấn đề cụ thể.

Aidan Gomez: Chúng tôi biết hiện tại khả năng tạo của máy tính là bao nhiêu, tôi nghĩ đây là vấn đề cần tập trung tiếp theo, tôi nghĩ đây là người thay đổi cấp vũ trụ, cũng là xu hướng phát triển trong tương lai.

Lukasz Kaiser: Khái niệm này đã tồn tại trước Transformer, và được tích hợp vào mô hình Transformer. Thực tế, tôi không chắc các bạn ở đây có rõ không, chúng tôi không thành công với mục tiêu ban đầu, chúng tôi bắt đầu dự án này với mong muốn mô phỏng quá trình tiến hóa của token. Nó không chỉ là quá trình tạo tuyến tính, mà là sự tiến hóa dần dần của văn bản hoặc mã. Chúng tôi lặp lại, chúng tôi chỉnh sửa, điều này cho phép chúng tôi không chỉ mô phỏng cách con người phát triển văn bản, mà còn đưa họ vào quá trình này. Bởi vì nếu bạn có thể tạo nội dung một cách tự nhiên như con người, họ thực tế có thể cung cấp phản hồi, phải không?

Tất cả chúng tôi đều đã đọc luận văn của Shannon, ý tưởng ban đầu của chúng tôi là chỉ tập trung vào mô hình ngôn ngữ và perplexity, nhưng thực tế điều đó chưa đạt được. Tôi nghĩ đây cũng là nơi chúng ta có thể phát triển thêm. Điều này cũng liên quan đến cách chúng ta tổ chức thông minh tài nguyên tính toán hiện nay, cách tổ chức này hiện nay cũng áp dụng cho xử lý hình ảnh. Ý tôi là, mô hình khuếch tán có đặc tính thú vị, chúng có thể liên tục tinh chỉnh và nâng cao chất lượng qua lặp lại. Còn hiện tại chúng ta chưa có khả năng đó.

Ý tôi là, vấn đề căn bản này: kiến thức nào nên được tích hợp bên trong mô hình, kiến thức nào nên nằm ngoài mô hình? Có dùng mô hình truy xuất không? Mô hình RAG (Retrieval-Augmented Generation) là một ví dụ. Tương tự, nó cũng liên quan đến vấn đề suy luận, nhiệm vụ suy luận nào nên được thực hiện qua hệ thống ký hiệu bên ngoài, nhiệm vụ nào nên được thực hiện trực tiếp bên trong mô hình. Về cơ bản đây là một cuộc thảo luận về hiệu quả. Tôi thực sự tin rằng, mô hình lớn cuối cùng sẽ học được cách tính 2+2, nhưng nếu bạn tính 2+2 bằng cách cộng dồn số, thì rõ ràng là kém hiệu quả.

Huang Renxun: Nếu AI chỉ cần tính 2+2, thì nó nên dùng trực tiếp máy tính, dùng ít năng lượng nhất để hoàn thành nhiệm vụ, bởi vì chúng ta biết máy tính là công cụ hiệu quả nhất để tính 2+2. Tuy nhiên, nếu ai đó hỏi AI, bạn đã đưa ra quyết định 2+2 như thế nào? Bạn có biết 2+2 là câu trả lời đúng không? Điều này sẽ tiêu tốn rất nhiều tài nguyên?

Noam Shazeer: Đúng vậy. Bạn vừa nhắc đến một ví dụ, nhưng tôi cũng tin chắc rằng các hệ thống AI do các bạn ở đây phát triển đủ thông minh để chủ động dùng máy tính.

Hiện nay, sản phẩm công cộng toàn cầu (GPP) đang làm điều đó. Tôi nghĩ các mô hình hiện tại quá rẻ tiền, quy mô vẫn còn nhỏ. Nó rẻ bởi vì công nghệ như NV, cảm ơn vì đã tạo ra nó.

Chi phí tính toán cho mỗi thao tác khoảng 10 đến 18 đô la Mỹ. Hoặc nói cách khác, ở mức độ này. Cảm ơn bạn đã tạo ra nhiều tài nguyên tính toán như vậy. Nhưng nếu bạn quan sát một mô hình có năm trăm tỷ tham số, và mỗi token thực hiện một nghìn tỷ phép tính, khoảng một đô la cho một triệu token, rẻ hơn 100 lần so với việc ra ngoài mua và đọc một cuốn sách bìa mềm. Các ứng dụng của chúng ta về giá trị cao hơn hàng triệu lần hoặc nhiều hơn so với tính toán hiệu quả trên mạng thần kinh khổng lồ. Ý tôi là, chúng chắc chắn có giá trị hơn nhiều so với việc chữa ung thư, nhưng không chỉ vậy.

Ashish Vaswani: Tôi nghĩ làm cho thế giới thông minh hơn là cách nhận được phản hồi từ thế giới, chúng ta có thể đạt được đa nhiệm, đa tuyến song song không. Nếu bạn thực sự muốn xây dựng một mô hình như vậy, giúp chúng ta thiết kế mô hình như vậy, đó là một cách rất tốt.

Huang Renxun: Có thể chia sẻ nhanh lý do các bạn sáng lập công ty không?

Ashish Vaswani: Trong công ty chúng tôi, mục tiêu là xây dựng mô hình và giải quyết nhiệm vụ mới. Công việc của chúng tôi là hiểu mục tiêu và nội dung nhiệm vụ, và đáp ứng nhu cầu khách hàng khi nội dung thay đổi. Thực tế, từ năm 2021, tôi nhận ra vấn đề lớn nhất của mô hình là, bạn không thể chỉ làm mô hình thông minh hơn, bạn còn cần tìm được nhân tài phù hợp để diễn giải mô hình. Chúng tôi muốn thế giới hòa quyện với mô hình, làm cho mô hình trở nên lớn hơn và xuất sắc hơn. Cần có tiến bộ nhất định trong quá trình học, điều này ban đầu không thể hoàn thành trong môi trường chân không phòng thí nghiệm.

Noam Shazeer: Năm 2021, chúng tôi cùng nhau sáng lập công ty này. Chúng tôi có công nghệ tuyệt vời như vậy, nhưng công nghệ này chưa mang lại lợi ích cho nhiều người. Hãy tưởng tượng, nếu tôi là bệnh nhân, nghe bạn nói như vậy, tôi sẽ nghĩ có hàng trăm tỷ người cần hoàn thành nhiệm vụ khác nhau. Đó chính là ý nghĩa của học sâu, chúng tôi nâng cao công nghệ thông qua so sánh. Thực tế, nhờ sự phát triển công nghệ không ngừng, nhờ sự thúc đẩy của Huang Renxun, mục tiêu cuối cùng của chúng tôi là giúp mọi người trên thế giới. Các bạn phải thử nghiệm, hiện nay chúng tôi cần phát triển giải pháp nhanh hơn, để hàng trăm người có thể ứng dụng các ứng dụng này. Ví dụ ban đầu, không phải ai cũng dùng các ứng dụng này, nhiều người dùng chúng chỉ để giải trí, nhưng chúng thực sự hiệu quả, thực sự hoạt động.

Jakob Uszkoreit: Cảm ơn. Tôi muốn nói về hệ sinh thái phần mềm mà chúng tôi sáng lập. Năm 2021, tôi tham gia sáng lập công ty này, mục tiêu là giải quyết một số vấn đề thực sự có ảnh hưởng khoa học. Trước đây, nội dung chúng tôi xử lý khá phức tạp. Nhưng khi tôi có đứa con đầu tiên, cách nhìn thế giới của tôi thay đổi. Chúng tôi muốn làm cho cuộc sống con người thuận tiện hơn, cũng muốn đóng góp cho nghiên cứu protein. Đặc biệt sau khi có con, tôi càng muốn thay đổi kiến trúc y tế hiện tại, và hy vọng sự phát triển khoa học công nghệ có ảnh hưởng tích cực đến sự tồn tại và phát triển của con người. Ví dụ, cấu trúc và phân giải protein đã chịu ảnh hưởng nhất định, nhưng hiện nay chúng tôi thiếu dữ liệu. Chúng tôi phải nỗ lực dựa trên dữ liệu, đây không chỉ là trách nhiệm, mà còn là trách nhiệm của một người cha.

Huang Renxun: Tôi thích quan điểm của bạn, tôi luôn say mê thiết kế dược phẩm mới, và để máy tính học quá trình phát triển và tạo thuốc mới. Nếu có thể học và thiết kế thuốc mới, và có phòng thí nghiệm thử nghiệm, thì có thể xác định mô hình như vậy có khả thi hay không.

Llion Jones: Đúng vậy, tôi là người chia sẻ cuối cùng. Công ty chúng tôi đồng sáng lập có tên Sakana AI, nghĩa là "cá". Chúng tôi đặt tên công ty bằng từ "cá" trong tiếng Nhật vì chúng tôi như đàn cá, cảm hứng tự nhiên đã truyền cảm hứng cho chúng tôi tìm kiếm trí tuệ. Nếu chúng ta có thể kết hợp nhiều yếu tố kiểm tra, sẽ tạo ra những điều phức tạp và tuyệt vời. Nhiều người có thể không hiểu chi tiết cụ thể của quá trình và nội dung, nhưng triết lý cốt lõi bên trong của chúng tôi là "học tập luôn chiến thắng".

Dù bạn muốn giải quyết vấn đề hay học bất cứ nội dung gì, học tập luôn giúp bạn chiến thắng. Trong quá trình AI sinh tạo, học nội dung cũng giúp chúng ta chiến thắng. Với tư cách là nhà nghiên cứu ở đây, tôi muốn nhắc nhở mọi người, chúng tôi trao cho mô hình AI của máy tính ý nghĩa thực sự, để chúng thực sự giúp chúng ta hiểu bí ẩn vũ trụ. Thực tế, tôi cũng muốn nói với mọi người, chúng tôi sắp công bố một tiến triển mới nhất, chúng tôi rất phấn khích. Dù hiện nay chúng tôi có một loạt thành quả nghiên cứu làm nền tảng, nhưng chúng tôi đang trải qua sự phát triển mang tính chuyển đổi, quản lý mô hình hiện nay có tổ chức, khiến mọi người thực sự tham gia. Chúng tôi làm cho các mô hình khả thi hơn, sử dụng các mô hình lớn và mô hình mang tính chuyển đổi này, thay đổi cách con người nhận thức thế giới và vũ trụ. Đó là mục tiêu của chúng tôi.

Aidan Gomez: Lý do tôi sáng lập công ty tương tự Noam Shazeer. Tôi nghĩ máy tính đang bước vào một mô hình mới, đang thay đổi sản phẩm hiện tại và cách chúng ta làm việc. Mọi thứ đều dựa trên máy tính, và đã có sự thay đổi nhất định bên trong công nghệ. Vai trò của chúng ta là gì? Thực tế tôi đang thu hẹp khoảng cách, lấp đầy khoảng trống. Chúng ta có thể thấy các doanh nghiệp khác nhau tạo ra nền tảng như vậy, để mỗi doanh nghiệp thích nghi và tích hợp sản phẩm, đây là cách tiếp cận trực tiếp người dùng. Đây là cách chúng tôi thúc đẩy công nghệ, chúng tôi có thể làm cho công nghệ kinh tế hơn, phổ biến hơn.

Huang Renxun: Tôi đặc biệt ngưỡng mộ, khi Noam Shazeer dường như rất bình tĩnh, bạn lại rất hào hứng. Sự khác biệt tính cách của hai bạn thật rõ rệt. Bây giờ, mời Lukasz Kaiser phát biểu.

Lukasz Kaiser: Trải nghiệm của tôi tại OpenAI rất mang tính đảo ngược. Công ty tràn đầy niềm vui, chúng tôi xử lý lượng lớn dữ liệu tính toán, nhưng rốt cuộc, vai trò của tôi vẫn là người xử lý dữ liệu.

Illia Polosukhin: Tôi là người đầu tiên rời đi. Tôi tin chắc chúng tôi sẽ đạt được tiến bộ lớn, phần mềm sẽ thay đổi toàn thế giới. Cách trực tiếp nhất là dạy máy viết mã, làm cho lập trình khả thi với mọi người.

Chào mừng tham gia cộng đồng chính thức TechFlow

Nhóm Telegram:https://t.me/TechFlowDaily

Tài khoản Twitter chính thức:https://x.com/TechFlowPost

Tài khoản Twitter tiếng Anh:https://x.com/BlockFlow_News