Báo cáo FMG: Ba vấn đề của AI và lời giải từ DePIN

Tuyển chọn TechFlowTuyển chọn TechFlow

Báo cáo FMG: Ba vấn đề của AI và lời giải từ DePIN

Vấn đề then chốt không nằm ở lượng sức mạnh tính toán, mà ở cách thức trao quyền cho sản phẩm AI.

Tác giả: FMGResearch

TL; DR

Cạnh tranh sản phẩm trong thời đại AI không thể tách rời khỏi nguồn lực (năng lực tính toán, dữ liệu,...), đặc biệt là sự hỗ trợ từ nguồn lực ổn định.

Việc huấn luyện/mô hình AI cũng cần một lượng lớn người dùng (IP) để cung cấp dữ liệu, giúp hiệu quả mô hình đạt được bước nhảy vọt về chất.

Sự kết hợp với Web3 có thể giúp các đội khởi nghiệp AI vừa và nhỏ vượt mặt các gã khổng lồ AI truyền thống.

Đối với hệ sinh thái DePIN, nguồn lực như năng lực tính toán, băng thông quyết định mức độ sàn (việc tích hợp đơn thuần năng lực tính toán không tạo nên hào moat); ứng dụng và tối ưu sâu mô hình AI (giống BitTensor), chuyên môn hóa (Render, Hivemaper), cùng khả năng khai thác dữ liệu hiệu quả sẽ quyết định mức độ trần của dự án.

Trong bối cảnh AI+DePIN, suy luận & tinh chỉnh mô hình AI, cũng như thị trường mô hình AI trên thiết bị di động sẽ ngày càng được chú trọng.

Phân tích thị trường AI & Ba vấn đề

Theo số liệu thống kê, từ tháng 9 năm 2022 – thời điểm trước khi ChatGPT ra đời đến tháng 8 năm 2023, 50 sản phẩm AI hàng đầu thế giới đã ghi nhận hơn 24 tỷ lượt truy cập, trung bình mỗi tháng tăng 236,3 triệu lượt.

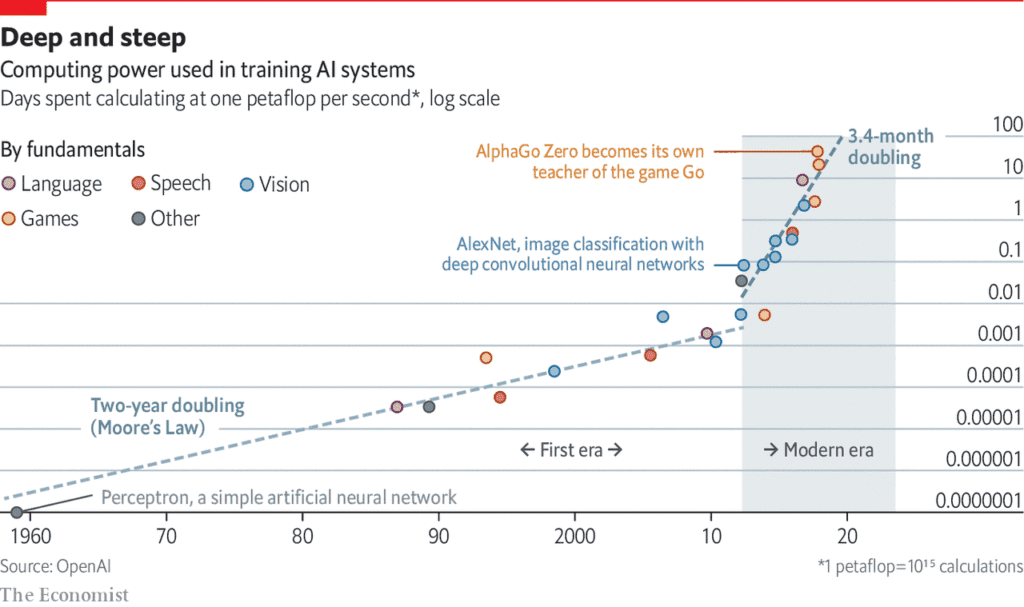

Sự phát triển mạnh mẽ của các sản phẩm AI đằng sau là sự phụ thuộc ngày càng sâu vào năng lực tính toán.

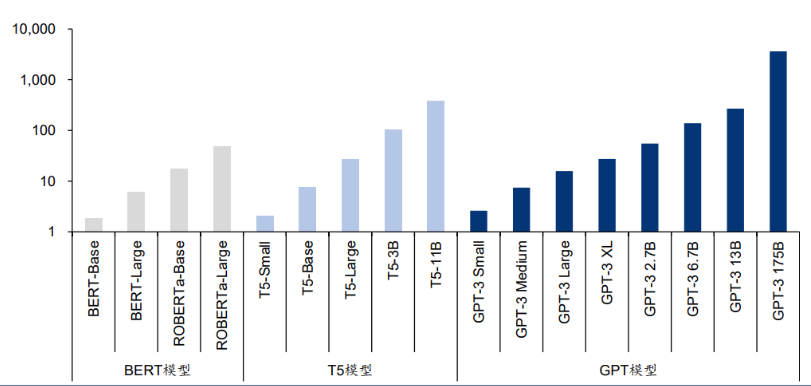

Nguồn: Language Models are Few-Shot Learners

Một nghiên cứu từ Đại học Massachusetts Amherst chỉ ra rằng "Huấn luyện một mô hình trí tuệ nhân tạo thải ra lượng carbon tương đương với khí thải từ năm chiếc ô tô cả đời". Tuy nhiên, phân tích này chỉ xét đến một lần huấn luyện. Khi mô hình được cải thiện qua nhiều lần huấn luyện lặp lại, lượng tiêu thụ năng lượng sẽ tăng lên đáng kể.

Các mô hình ngôn ngữ mới nhất chứa hàng tỷ thậm chí hàng nghìn tỷ trọng số. Một mô hình phổ biến là GPT-3 sở hữu tới 175 tỷ tham số học máy. Nếu sử dụng GPU A100 thì cần 1024 GPU, 34 ngày và 4,6 triệu USD để huấn luyện mô hình này.

Cuộc cạnh tranh sản phẩm thời hậu AI hiện nay đang dần chuyển thành cuộc chiến về nguồn lực, chủ yếu là năng lực tính toán.

Nguồn:AI đang hủy hoại hành tinh chúng ta: giải quyết chi phí năng lượng khổng lồ của AI

Điều này dẫn đến ba vấn đề: Thứ nhất, một sản phẩm AI có đủ nguồn lực (năng lực tính toán, băng thông...) hay không, đặc biệt là nguồn lực ổn định. Sự tin cậy này đòi hỏi năng lực tính toán phải phi tập trung đầy đủ. Trong lĩnh vực truyền thống, do nhu cầu về chip thiếu hụt, cộng thêm bức tường thế giới được xây dựng dựa trên chính sách, ý thức hệ, khiến nhà sản xuất chip tự nhiên ở vị thế ưu thế và có thể đẩy giá mạnh. Ví dụ, chip NVIDIA H100 đã tăng từ 36.000 USD lên 50.000 USD vào tháng 4 năm 2023, làm gia tăng đáng kể chi phí cho các đội huấn luyện mô hình AI.

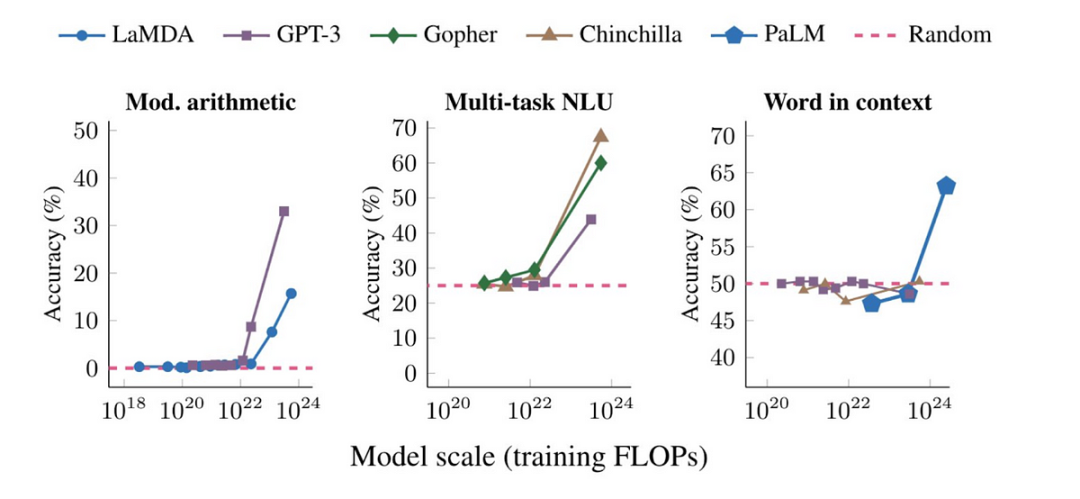

Vấn đề thứ hai, điều kiện nguồn lực giúp dự án AI giải quyết nhu cầu phần cứng, nhưng việc huấn luyện/mô hình AI vẫn cần lượng lớn người dùng (IP) để cung cấp dữ liệu. Khi quy mô mô hình vượt ngưỡng nhất định, hiệu suất của nó trên các tác vụ khác nhau đều thể hiện sự bứt phá.

Vấn đề thứ ba là các đội khởi nghiệp AI vừa và nhỏ khó thực hiện vượt mặt đối thủ. Sự độc quyền về năng lực tính toán trong thị trường tài chính truyền thống cũng dẫn đến sự độc quyền trong các giải pháp mô hình AI, các hãng lớn như OpenAI, Google Deepmind đang tiếp tục xây dựng hào moat riêng. Các đội AI vừa và nhỏ cần tìm kiếm cách cạnh tranh khác biệt hơn.

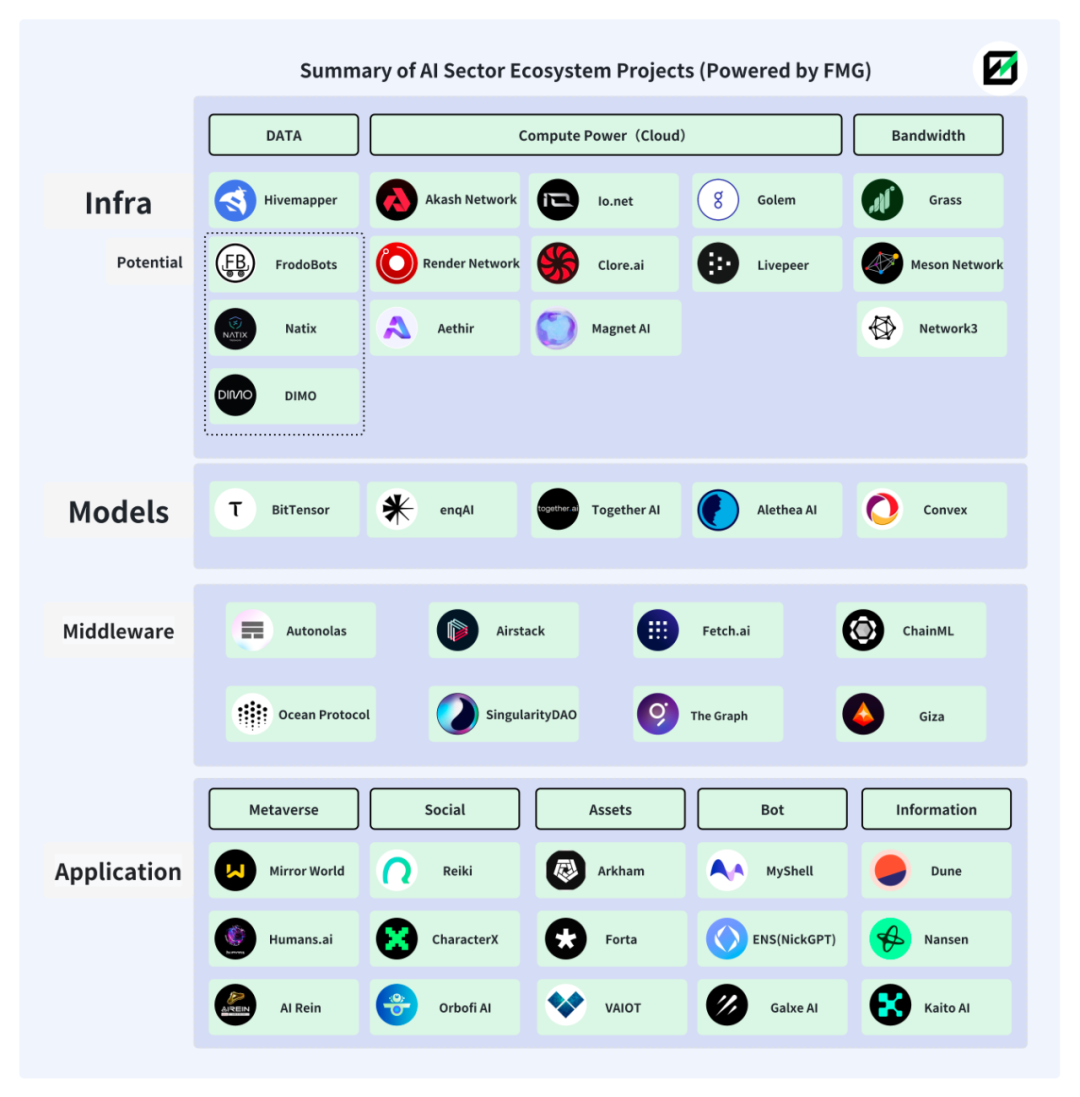

Ba vấn đề trên đều có thể tìm thấy câu trả lời từ Web3. Thực tế, sự kết hợp giữa AI và Web3 đã diễn ra từ lâu và hệ sinh thái khá sôi động.

Hình dưới đây là bản đồ một phần hệ sinh thái AI+Web3 do Future Money Group tổng hợp.

AI+DePIN

1. Giải pháp từ DePIN

DePIN là viết tắt của mạng cơ sở hạ tầng vật lý phi tập trung, đồng thời là tập hợp mối quan hệ sản xuất giữa con người và thiết bị, thông qua kinh tế học token kết hợp với thiết bị phần cứng (như máy tính, camera xe hơi...) để tích hợp người dùng và thiết bị, đồng thời đảm bảo vận hành trơn tru mô hình kinh tế.

So với định nghĩa rộng hơn của Web3, do DePIN vốn dĩ liên hệ sâu sắc hơn với thiết bị phần cứng và doanh nghiệp truyền thống, nên DePIN có lợi thế tự nhiên trong việc thu hút các đội AI bên ngoài và các nguồn vốn liên quan.

Hệ sinh thái DePIN theo đuổi năng lực tính toán phân tán và khuyến khích người đóng góp, vừa vặn giải quyết nhu cầu về năng lực tính toán và IP của sản phẩm AI.

-

DePIN thúc đẩy việc tích hợp năng lực tính toán toàn cầu (trung tâm tính toán & năng lực tính toán cá nhân rảnh rỗi) bằng kinh tế học token, giảm rủi ro tập trung hóa, đồng thời hạ chi phí gọi dùng năng lực tính toán cho các đội AI.

-

Cơ cấu IP đa dạng, phong phú trong hệ sinh thái DePIN giúp mô hình AI đạt được sự đa dạng và khách quan trong kênh thu thập dữ liệu, lượng lớn người cung cấp dữ liệu cũng đảm bảo nâng cao hiệu suất mô hình AI.

-

Sự trùng lặp trong chân dung người dùng giữa hệ sinh thái DePIN và người dùng Web3 có thể giúp các dự án AI tham gia phát triển thêm nhiều mô hình AI mang đặc trưng Web3, tạo ra sự cạnh tranh khác biệt – điều mà thị trường AI truyền thống không có.

Trong lĩnh vực Web2, dữ liệu mô hình AI thường được thu thập từ bộ dữ liệu công khai hoặc do chính nhóm phát triển mô hình tự thu thập, điều này dễ bị giới hạn bởi bối cảnh văn hóa và khu vực, khiến nội dung do mô hình AI tạo ra mang tính "méo mó" chủ quan. Cách thu thập dữ liệu truyền thống lại bị giới hạn về hiệu quả và chi phí, khó đạt được quy mô mô hình lớn hơn (số lượng tham số, thời gian huấn luyện và chất lượng dữ liệu). Với mô hình AI, quy mô càng lớn thì hiệu suất mô hình càng dễ đạt bước nhảy vọt về chất.

Nguồn:Khả năng nổi bật của các mô hình ngôn ngữ lớn: chúng giải quyết những vấn đề chưa từng được huấn luyện như thế nào?

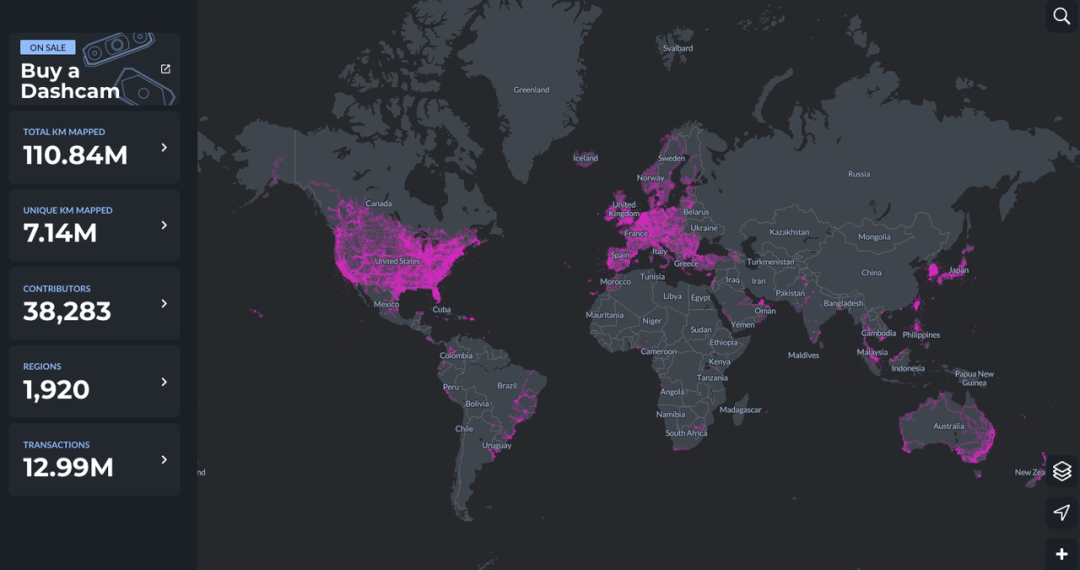

DePIN có lợi thế tự nhiên trong lĩnh vực này. Lấy ví dụ Hivemapper, với gần 40.000 người đóng góp tại 1.920 khu vực trên toàn cầu đang cung cấp dữ liệu cho MAP AI (mô hình AI bản đồ).

Sự kết hợp giữa AI và DePIN còn đánh dấu một bước tiến mới trong sự hội tụ giữa AI và Web3. Hiện tại, các dự án AI trong Web3 nở rộ chủ yếu ở lớp ứng dụng, và hầu như chưa thoát ly hoàn toàn sự phụ thuộc trực tiếp vào cơ sở hạ tầng Web2, tức là đưa các mô hình AI sẵn có trên nền tảng tính toán truyền thống vào các dự án Web3, rất ít khi tham gia vào việc tạo ra mô hình AI.

Yếu tố Web3 luôn ở vị trí chuỗi thức ăn thấp, không thể thu được lợi nhuận siêu ngạch thực sự. Đối với nền tảng năng lực tính toán phân tán cũng vậy, chỉ đơn thuần kết hợp AI + năng lực tính toán sẽ không khai thác được tiềm năng thực sự của cả hai bên. Trong mối quan hệ này, bên cung cấp năng lực tính toán không thể thu được lợi nhuận siêu ngạch cao hơn, cấu trúc hệ sinh thái quá đơn giản, do đó không thể thúc đẩy vòng xoáy tăng trưởng thông qua kinh tế học token.

Nhưng khái niệm AI+DePIN đang phá vỡ mối quan hệ cố hữu này, đồng thời chuyển sự chú ý của Web3 sang lĩnh vực mô hình AI rộng lớn hơn.

2. Tổng hợp các dự án AI+DePIN

Bản thân DePIN đã sở hữu sẵn thiết bị (năng lực tính toán, băng thông, thuật toán, dữ liệu), người dùng (người cung cấp dữ liệu huấn luyện mô hình) và cơ chế khuyến khích nội bộ (kinh tế học token) – những yếu tố AI rất cần.

Chúng ta có thể mạnh dạn đưa ra định nghĩa: Những dự án cung cấp đầy đủ điều kiện khách quan cho AI (năng lực tính toán/băng thông/dữ liệu/IP), cung cấp các kịch bản (huấn luyện/suy luận/tinh chỉnh) cho mô hình AI, và được trang bị kinh tế học token, có thể được định nghĩa là AI+DePIN.

Future Money Group sẽ liệt kê và phân tích các mô hình điển hình của AI+DePIN dưới đây.

Chúng tôi chia theo loại tài nguyên cung cấp thành bốn nhóm: năng lực tính toán, băng thông, dữ liệu và các nhóm khác, để cố gắng phân tích các dự án trong từng nhóm.

2.1 Năng lực tính toán

Phía năng lực tính toán là thành phần chính trong mảng AI+DePIN, đồng thời là nhóm có số lượng dự án nhiều nhất hiện nay. Cấu thành chính của năng lực tính toán là GPU (bộ xử lý đồ họa), CPU (bộ xử lý trung tâm) và TPU (chip học máy chuyên dụng). Trong đó, TPU do khó sản xuất nên chủ yếu do Google phát triển, chỉ cung cấp dịch vụ thuê năng lực tính toán đám mây, do đó quy mô thị trường nhỏ. GPU là thành phần phần cứng chuyên biệt hơn so với CPU, có thể xử lý hiệu quả các phép toán toán học phức tạp chạy song song. Ban đầu GPU chỉ dùng để xử lý nhiệm vụ render đồ họa trong game và hoạt hình, nhưng hiện nay phạm vi sử dụng đã mở rộng hơn nhiều. Do đó, GPU hiện là nguồn lực tính toán chính trên thị trường.

Vì vậy, chúng ta thấy nhiều dự án AI+DePIN về năng lực tính toán chuyên về render đồ họa và video, hoặc liên quan đến game – điều này bắt nguồn từ đặc tính của GPU.

Nhìn tổng thể, bên cung cấp năng lực tính toán trong các sản phẩm AI+DePIN gồm ba nhóm: nhà cung cấp dịch vụ đám mây truyền thống; năng lực tính toán cá nhân rảnh rỗi; năng lực tính toán tự có. Trong đó, nhà cung cấp dịch vụ đám mây chiếm tỷ lệ lớn, tiếp theo là năng lực tính toán cá nhân rảnh rỗi. Điều này có nghĩa các sản phẩm này thường đóng vai trò trung gian năng lực tính toán. Bên có nhu cầu là các đội phát triển mô hình AI.

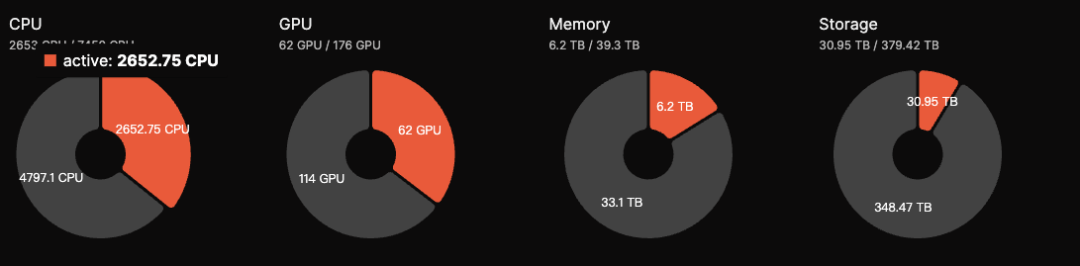

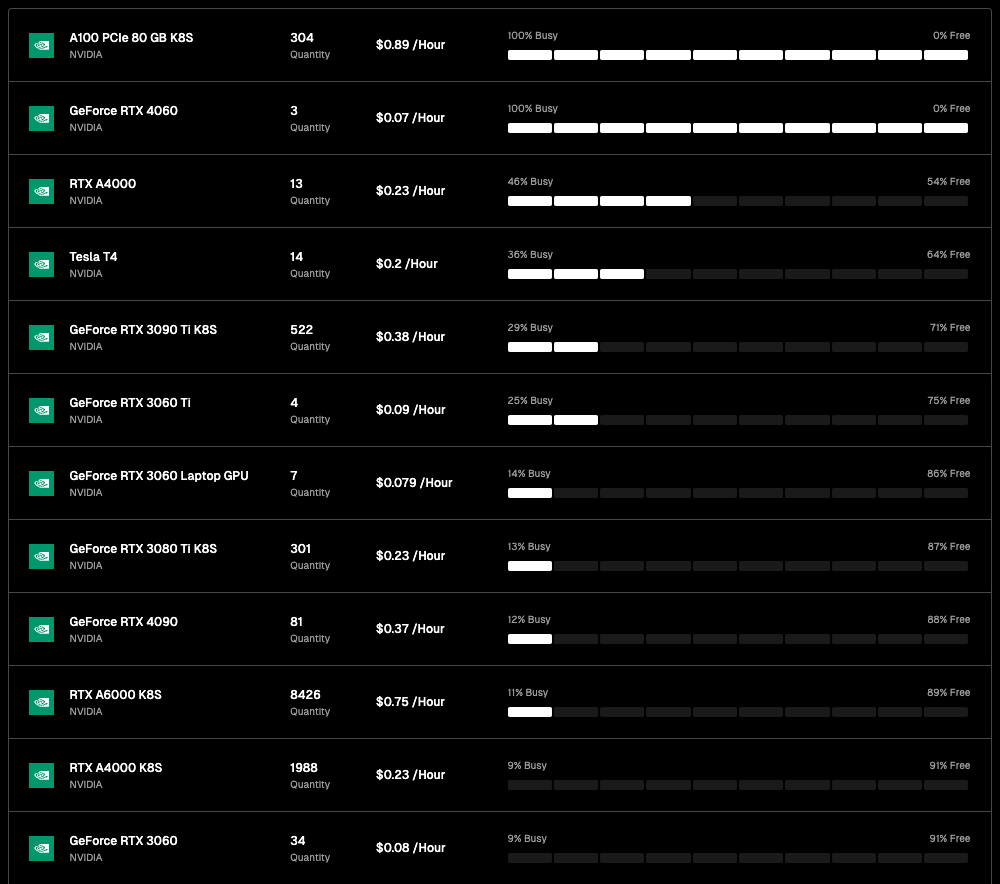

Hiện tại, trong nhóm này, năng lực tính toán gần như không được sử dụng 100%, phần lớn thời gian ở trạng thái rảnh rỗi. Ví dụ Akash Network hiện chỉ sử dụng khoảng 35% năng lực tính toán, phần còn lại đang rảnh. io.net cũng tương tự.

Điều này có thể do nhu cầu huấn luyện mô hình AI hiện tại còn ít, đồng thời cũng là lý do AI+DePIN có thể cung cấp chi phí năng lực tính toán rẻ. Về sau khi thị trường AI mở rộng, tình trạng này sẽ được cải thiện.

Akash Network: Thị trường dịch vụ đám mây ngang hàng phi tập trung

Akash Network là một thị trường dịch vụ đám mây ngang hàng phi tập trung, thường được gọi là Airbnb của dịch vụ đám mây. Akash Network cho phép người dùng và công ty ở mọi quy mô sử dụng dịch vụ một cách nhanh chóng, ổn định và tiết kiệm.

Giống Render, Akash cũng cung cấp cho người dùng dịch vụ triển khai, thuê GPU và huấn luyện mô hình AI.

Tháng 8 năm 2023, Akash ra mắt Supercloud, cho phép các nhà phát triển đặt giá họ sẵn sàng trả để triển khai mô hình AI của mình, trong khi các nhà cung cấp có năng lực tính toán dư thừa sẽ lưu trữ mô hình của người dùng. Chức năng này rất giống Airbnb, cho phép nhà cung cấp cho thuê dung lượng chưa sử dụng.

Thông qua hình thức đấu giá công khai, khuyến khích các bên cung cấp mở tài nguyên tính toán rảnh rỗi trong mạng lưới của họ, Akash Network đạt được việc sử dụng tài nguyên hiệu quả hơn, từ đó cung cấp giá cả cạnh tranh hơn cho bên có nhu cầu.

Hiện tại, tổng số GPU trong hệ sinh thái Akash là 176 chiếc, nhưng số lượng hoạt động là 62, tỷ lệ hoạt động 35%, thấp hơn mức 50% vào tháng 9 năm 2023. Doanh thu ước tính mỗi ngày khoảng 5.000 USD. Token AKT có chức năng đặt cược, người dùng thông qua việc đặt cược token để tham gia duy trì an ninh mạng, nhận được lợi nhuận hàng năm khoảng 13,15%.

Hiện tại, dữ liệu của Akash trong mảng AI+DePIN khá tốt, và FDV 700 triệu USD so với Render và BitTensor còn nhiều dư địa tăng trưởng.

Akash còn tham gia Subnet của BitTensor để mở rộng không gian phát triển. Nhìn chung, Akash là một trong những dự án chất lượng trong赛道 AI+DePIN, cơ bản rất vững chắc.

io.net: Dự án AI+DePIN có số lượng GPU kết nối nhiều nhất

io.net là một mạng lưới tính toán phi tập trung, hỗ trợ phát triển, thực thi và mở rộng các ứng dụng ML (học máy) trên blockchain Solana, tận dụng cụm GPU lớn nhất thế giới, cho phép các kỹ sư học máy thuê và truy cập năng lực tính toán đám mây phân tán với chi phí chỉ bằng một phần nhỏ so với dịch vụ tập trung.

Theo số liệu chính thức, io.net có hơn 1 triệu GPU đang chờ sẵn. Ngoài ra, sự hợp tác giữa io.net và Render cũng mở rộng tài nguyên GPU có thể triển khai.

Hệ sinh thái io.net có nhiều GPU, nhưng phần lớn đến từ hợp tác với các nhà cung cấp dịch vụ điện toán đám mây và sự tham gia của các nút cá nhân, tỷ lệ rảnh khá cao. Lấy RTX A6000 – mẫu GPU nhiều nhất làm ví dụ, trong 8.426 GPU, chỉ có 11% (927) đang được sử dụng, còn nhiều mẫu GPU khác gần như không ai dùng. Nhưng hiện tại, một lợi thế lớn của sản phẩm io.net là giá rẻ, so với chi phí gọi dùng GPU 1,5 USD/giờ của Akash, chi phí trên io.net có thể thấp tới 0,1-1 USD.

Sau này io.net còn xem xét cho phép các nhà cung cấp GPU trong hệ sinh thái IO tăng cơ hội được sử dụng bằng cách thế chấp tài sản gốc. Càng thế chấp nhiều, cơ hội được chọn càng lớn. Đồng thời, các kỹ sư AI thế chấp tài sản gốc cũng có thể sử dụng GPU hiệu suất cao.

Về quy mô kết nối GPU, io.net là lớn nhất trong số 10 dự án được liệt kê trong bài viết này. Bỏ qua tỷ lệ rảnh, số lượng GPU đang sử dụng cũng đứng đầu. Về kinh tế học token, token gốc io.net và token giao thức IO sẽ ra mắt vào Quý I năm 2024, tổng cung tối đa 22.300.000 token. Khi người dùng sử dụng mạng sẽ bị thu 5% phí, khoản phí này dùng để đốt token IO hoặc thưởng cho người dùng mới hai bên cung-cầu. Mô hình token có đặc điểm rõ ràng là tăng giá, do đó mặc dù chưa phát hành token, io.net vẫn rất được quan tâm trên thị trường.

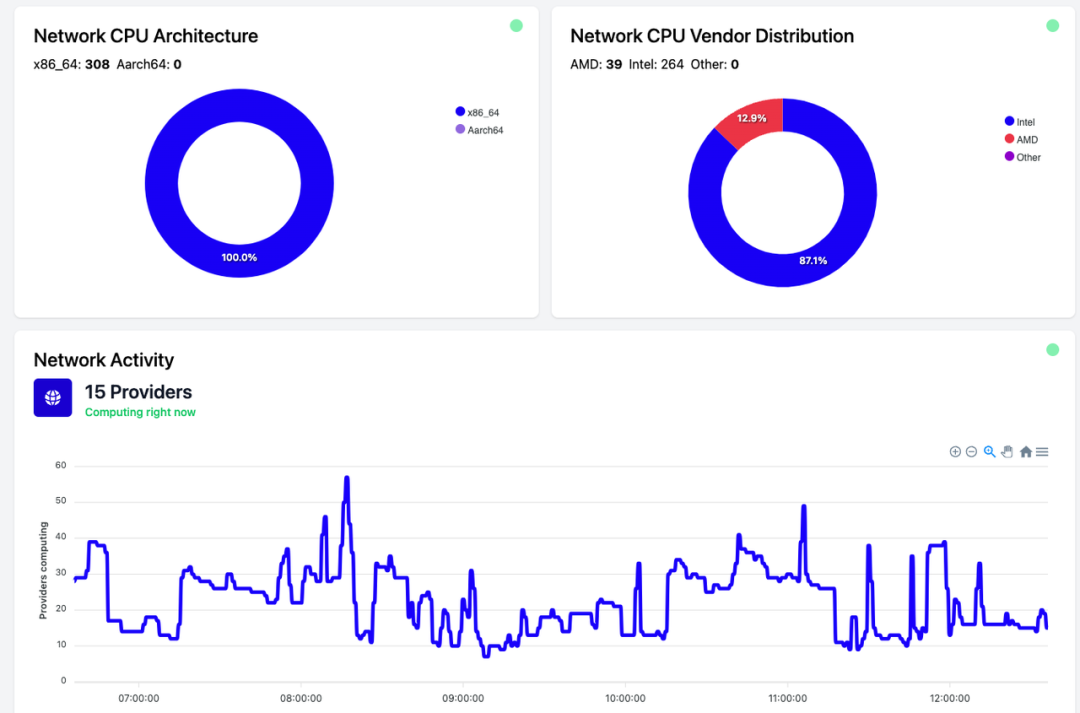

Golem: Thị trường năng lực tính toán chủ yếu dùng CPU

Golem là một thị trường năng lực tính toán phi tập trung, hỗ trợ bất kỳ ai cũng có thể chia sẻ và tập hợp tài nguyên tính toán bằng cách tạo mạng chia sẻ tài nguyên. Golem cung cấp bối cảnh thuê năng lực tính toán cho người dùng.

Thị trường Golem gồm ba bên: nhà cung cấp năng lực tính toán, nhà có nhu cầu năng lực tính toán và nhà phát triển phần mềm. Bên có nhu cầu gửi nhiệm vụ tính toán, mạng Golem phân bổ nhiệm vụ cho nhà cung cấp phù hợp (cung cấp RAM, dung lượng ổ cứng và số nhân CPU...), sau khi hoàn thành nhiệm vụ, hai bên thanh toán qua token.

Golem chủ yếu dùng CPU để tích hợp năng lực tính toán, mặc dù chi phí rẻ hơn GPU (CPU Intel i9 14900k giá khoảng 700 USD, trong khi GPU A100 giá từ 12.000-25.000 USD), nhưng CPU không thể xử lý song song hiệu quả và tiêu thụ năng lượng cao hơn. Vì vậy, việc thuê năng lực tính toán bằng CPU có thể kém hấp dẫn hơn các dự án dùng GPU.

Magnet AI: Tài sản hóa mô hình AI

Magnet AI thông qua việc tích hợp các nhà cung cấp năng lực tính toán GPU, cung cấp dịch vụ huấn luyện mô hình cho các nhà phát triển mô hình AI khác nhau. Khác với các sản phẩm AI+DePIN khác, Magnet AI cho phép các đội AI khác nhau phát hành token ERC-20 dựa trên mô hình của họ, người dùng tham gia tương tác với các mô hình khác nhau sẽ nhận được airdrop token mô hình và phần thưởng bổ sung.

Quý II năm 2024, Magnet AI sẽ ra mắt trên Polygon zkEVM & Arbrium.

Tương tự io.net, đều chủ yếu tích hợp GPU và cung cấp dịch vụ huấn luyện mô hình cho các đội AI.

Điểm khác là io.net tập trung hơn vào tích hợp tài nguyên GPU, khuyến khích các cụm GPU, doanh nghiệp và cá nhân đóng góp GPU và nhận phần thưởng, là mô hình lấy năng lực tính toán làm trung tâm.

Magnet AI dường như tập trung hơn vào mô hình AI, do sự tồn tại của token mô hình AI, có thể thu hút và giữ chân người dùng thông qua token, airdrop, và thúc đẩy sự tham gia của các nhà phát triển AI bằng cách tài sản hóa mô hình AI.

Tóm tắt đơn giản: Magnet giống như dùng GPU xây một chợ, bất kỳ nhà phát triển AI, người triển khai mô hình nào cũng có thể phát token ERC-20 trên đó, người dùng có thể nhận các token khác nhau, hoặc chủ động nắm giữ các token khác nhau.

Render: Chuyên gia chuyên về mô hình AI kiểu render đồ họa

Render Network là nhà cung cấp giải pháp render dựa trên GPU phi tập trung, nhằm kết nối người sáng tạo và tài nguyên GPU rảnh rỗi thông qua công nghệ blockchain, loại bỏ giới hạn phần cứng, giảm thời gian và chi phí, đồng thời cung cấp quản lý bản quyền số, thúc đẩy thêm sự phát triển của metaverse.

Theo nội dung whitepaper của Render, dựa trên Render, nghệ sĩ, kỹ sư và nhà phát triển có thể tạo ra loạt ứng dụng AI như tạo nội dung 3D hỗ trợ AI, render toàn cảnh tăng tốc bằng AI, và huấn luyện mô hình AI liên quan dựa trên dữ liệu sơ đồ cảnh 3D của Render.

Render cung cấp SDK Render Network cho các nhà phát triển AI, họ sẽ có thể sử dụng GPU phân tán của Render để thực hiện các nhiệm vụ tính toán AI từ quá trình render NeRF (trường phản xạ thần kinh) và LightField đến các nhiệm vụ AI tạo sinh.

Theo báo cáo của Global Market Insights, quy mô thị trường render 3D toàn cầu dự kiến đạt 6 tỷ USD. Trong khi đó, Render với FDV 2,2 tỷ USD vẫn còn dư địa phát triển.

Hiện tại không tra được dữ liệu cụ thể về GPU của Render, nhưng do背 OTOY phía sau Render nhiều lần thể hiện mối liên hệ với Apple; cộng thêm hoạt động rộng rãi, bộ render nổi tiếng OctaneRender của OTOY hỗ trợ tất cả bộ công cụ 3D hàng đầu trong các lĩnh vực VFX, game, thiết kế hiệu ứng, hình ảnh kiến trúc và mô phỏng, bao gồm hỗ trợ gốc cho Unity3D và Unreal Engine.

Cùng với Google và Microsoft tham gia mạng RNDR. Render từng xử lý gần 250.000 yêu cầu render vào năm 2021, các nghệ sĩ trong hệ sinh thái tạo ra doanh số khoảng 5 tỷ USD thông qua NFT.

Do đó, định giá tham chiếu cho Render nên căn cứ vào tiềm năng thị trường render nói chung (khoảng 30 tỷ USD). Cộng thêm mô hình kinh tế BME (đốt và鑄 cân bằng), dù xét về giá token thuần túy hay FDV, Render vẫn còn dư địa tăng trưởng.

Clore.ai: Render video

Clore.ai là một nền tảng cung cấp dịch vụ thuê năng lực tính toán GPU xây dựng trên PoW. Người dùng có thể cho thuê GPU của mình để thực hiện các nhiệm vụ như đào tạo AI, render video và đào tiền mã hóa, người khác có thể tiếp cận năng lực này với giá rẻ.

Phạm vi hoạt động bao gồm: đào tạo trí tuệ nhân tạo, render phim, VPN, đào tiền mã hóa... Khi có nhu cầu dịch vụ năng lực tính toán cụ thể, thực hiện nhiệm vụ phân bổ mạng; khi không có nhu cầu, mạng sẽ tìm tiền mã hóa có tỷ suất đào cao nhất lúc đó để tham gia đào.

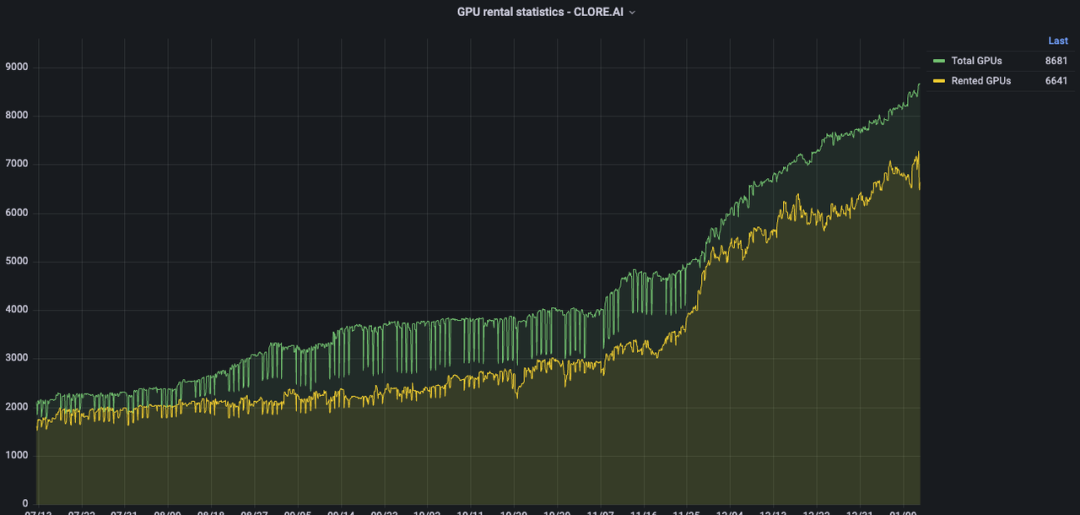

Trong nửa năm qua, số lượng GPU của Clore.ai tăng từ 2.000 lên khoảng 9.000, xét về số lượng tích hợp GPU, Clore.ai vượt Akash. Nhưng FDV thị trường thứ cấp chỉ khoảng 20% so với Akash.

Về mô hình token, CLORE áp dụng mô hình đào POW, không pre-mine hay ICO, 50% mỗi khối phân cho thợ đào, 40% cho bên cho thuê, 10% cho đội ngũ.

Tổng cung 1,3 tỷ token, bắt đầu đào từ tháng 6 năm 2022, đến năm 2042 cơ bản lưu thông hết, hiện tại lượng lưu thông khoảng 220 triệu. Cuối năm 2023 lưu thông khoảng 250 triệu, chiếm 20% tổng cung. Do đó FDV thực tế hiện tại là 31 triệu USD, về lý thuyết Clore.ai đang bị định giá thấp nghiêm trọng, nhưng do kinh tế học token, tỷ lệ phân phối cho thợ đào 50%, tỷ lệ đào-bán-rút cao, nên giá token gặp khó khăn lớn trong việc tăng giá.

Livepeer: Render video, suy luận

Livepeer là giao thức video phi tập trung dựa trên Ethereum, thưởng cho các bên xử lý nội dung video một cách an toàn với giá hợp lý.

Theo tuyên bố chính thức, Livepeer mỗi tuần có hàng ngàn tài nguyên GPU thực hiện hàng triệu phút chuyển mã video.

Livepeer có thể sẽ áp dụng cách "mainnet" + "subnet", cho phép các nhà vận hành nút tạo subnet, thực hiện các nhiệm vụ này bằng cách兑现 thanh toán trên mainnet Livepeer. Ví dụ, giới thiệu subnet video AI chuyên dùng để huấn luyện mô hình AI trong lĩnh vực render video.

Sau này Livepeer sẽ mở rộng phần liên quan đến AI từ huấn luyện mô hình đơn thuần sang suy luận & tinh chỉnh.

Aethir: Tập trung vào game đám mây và AI

Aethir là một nền tảng game đám mây, xây dựng cơ sở hạ tầng đám mây phi tập trung (DCI) dành riêng cho các công ty game và trí tuệ nhân tạo. Nó giúp thay thế người chơi gánh vác tải trọng tính toán GPU nặng nề, đảm bảo trải nghiệm độ trễ cực thấp cho game thủ ở bất kỳ đâu, trên bất kỳ thiết bị nào.

Đồng thời, Aethir cung cấp dịch vụ triển khai bao gồm GPU, CPU, ổ đĩa... Ngày 27 tháng 9 năm 2023, Aethir chính thức cung cấp dịch vụ thương mại game đám mây và năng lực tính toán AI cho khách hàng toàn cầu, thông qua tích hợp năng lực tính toán phi tập trung để hỗ trợ năng lực tính toán cho game và mô hình AI trên nền tảng của chính nó.

Game đám mây chuyển nhu cầu năng lực tính toán render sang đám mây, loại bỏ giới hạn phần cứng và hệ điều hành của thiết bị đầu cuối, mở rộng đáng kể quy mô cơ sở người chơi tiềm năng.

2.2 Băng thông

Băng thông là một trong những tài nguyên DePIN cung cấp cho AI. Quy mô thị trường băng thông toàn cầu năm 2021 vượt 50 tỷ USD, dự đoán sẽ vượt 100 tỷ vào năm 2027.

Do số lượng mô hình AI ngày càng nhiều và phức tạp hơn, việc huấn luyện mô hình thường áp dụng nhiều chiến lược tính toán song song, chẳng hạn như song song dữ liệu, song song đường ống và song song tenxơ. Trong các mô hình tính toán song song này, tầm quan trọng của các thao tác truyền thông tập thể giữa nhiều thiết bị tính toán ngày càng nổi bật. Do đó, khi xây dựng cụm huấn luyện quy mô lớn cho mô hình AI lớn, vai trò của băng thông mạng trở nên nổi bật.

Quan trọng hơn, một tài nguyên băng thông ổn định và đáng tin cậy có thể đảm bảo các nút khác nhau phản hồi đồng thời, về mặt kỹ thuật tránh được sự kiểm soát điểm đơn (ví dụ Falcon sử dụng mô hình mạng trung gian độ trễ thấp + băng thông cao để tìm kiếm sự cân bằng giữa nhu cầu độ trễ và băng thông), cuối cùng đảm bảo tính tin cậy và kháng kiểm duyệt của toàn bộ mạng.

Grass: Sản phẩm đào băng thông tương thích thiết bị di động

Grass là sản phẩm chủ lực của Wynd Network, Wynd chuyên về dữ liệu mạng mở, đã gây quỹ 1 triệu USD vào năm 2023. Grass cho phép người dùng bán tài nguyên mạng chưa sử dụng để nhận thu nhập thụ động thông qua kết nối internet.

Người dùng có thể bán băng thông internet trên Grass, cung cấp dịch vụ băng thông cho các đội phát triển AI có nhu cầu, giúp huấn luyện mô hình AI, từ đó nhận được phần thưởng token.

Hiện tại, Grass sắp ra mắt phiên bản thiết bị di động, do thiết bị di động và PC có địa chỉ IP khác nhau, điều này có nghĩa người dùng Grass sẽ cung cấp thêm nhiều địa chỉ IP cho nền tảng, Grass sẽ thu thập được nhiều IP hơn để cung cấp hiệu quả dữ liệu tốt hơn cho việc huấn luyện mô hình AI.

Hiện tại Grass có hai cách cung cấp địa chỉ IP: tải tiện ích mở rộng trên PC, và tải ứng dụng trên thiết bị di động. (PC và thiết bị di động cần ở mạng khác nhau)

Tính đến ngày 29 tháng 11 năm 2023, nền tảng Grass đã có 103.000 lượt tải và 1.450.000 địa chỉ IP duy nhất.

Thiết bị di động và PC có nhu cầu AI khác nhau, do đó loại mô hình AI được huấn luyện cũng khác nhau.

Ví dụ, thiết bị di động có lượng lớn dữ liệu trong các lĩnh vực như tối ưu hóa hình ảnh, nhận diện khuôn mặt, dịch thuật thời gian thực, trợ lý giọng nói, tối ưu hóa hiệu suất thiết bị. Đây là những điều PC khó cung cấp.

Hiện tại Grass đang ở vị trí đi đầu trong việc huấn luyện mô hình AI trên thiết bị di động. Xét đến tiềm năng to lớn của thị trường thiết bị di động toàn cầu, triển vọng của Grass rất đáng chú ý.

Nhưng hiện tại Grass chưa cung cấp thông tin hiệu quả hơn về mô hình AI, phỏng đoán ban đầu có thể chỉ đơn thuần vận hành theo hướng tiền đào.

Meson Network: Layer 2 tương thích thiết bị di động

Meson Network là mạng tăng tốc lưu trữ thế hệ tiếp theo dựa trên blockchain Layer 2, thông qua hình thức đào để tập hợp các máy chủ rảnh rỗi, điều phối tài nguyên băng thông và phục vụ thị trường tăng tốc file cũng như stream media, bao gồm website truyền thống, video, livestream và giải pháp lưu trữ blockchain.

Chúng ta có thể hiểu Meson Network như một hồ tài nguyên băng thông, hai bên hồ có thể coi là bên cung và bên cầu. Bên trước đóng góp băng thông, bên sau sử dụng băng thông.

Trong cấu trúc sản phẩm cụ thể của Meson, có 2 sản phẩm (GatewayX, GaGaNode) chịu trách nhiệm tiếp nhận băng thông từ các nút toàn cầu khác nhau, 1 sản phẩm (IPCola) chịu trách nhiệm biến tài nguyên băng thông tập hợp này thành doanh thu.

GatewayX: Chủ yếu tích hợp băng thông rảnh thương mại, tập trung vào trung tâm IDC.

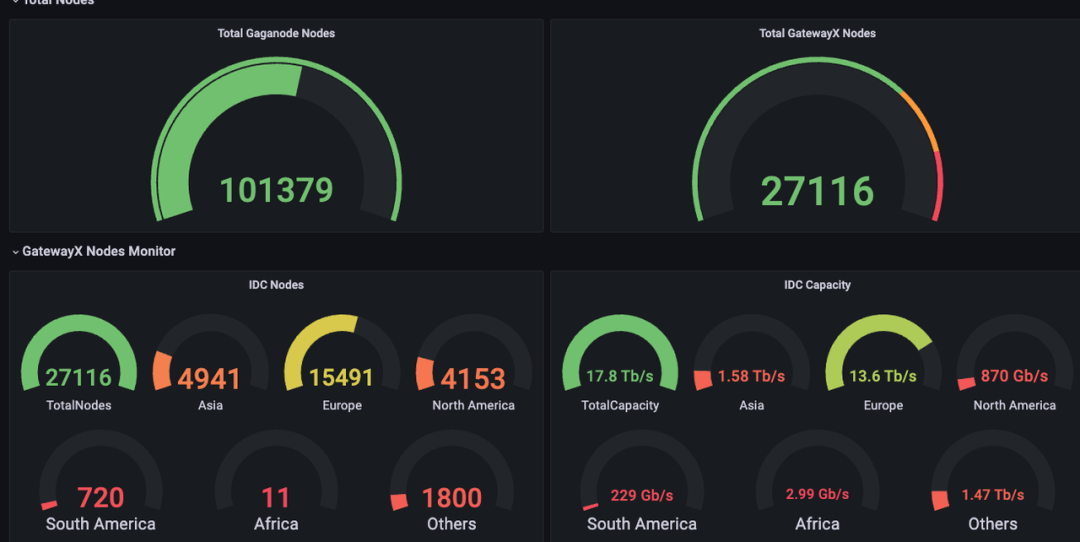

Từ bảng điều khiển dữ liệu Meson có thể thấy, hiện tại có hơn 20.000 nút IDC trên toàn thế giới tham gia, tạo thành khả năng truyền dữ liệu 12,5Tib/s.

GaGaNode: Chủ yếu tích hợp băng thông rảnh từ thiết bị cá nhân và hộ gia đình, cung cấp hỗ trợ điện toán biên.

IPCola: Kênh biến doanh thu của Meson, thực hiện phân bổ IP và băng thông.

Hiện tại Meson tiết lộ, doanh thu nửa năm trên một triệu USD. Theo thống kê trang web, Meson có 27.116 nút IDC, dung lượng IDC 17,7TB/s.

Hiện tại Meson dự kiến phát hành token vào tháng 3-4 năm 2024, nhưng đã công bố kinh tế học token.

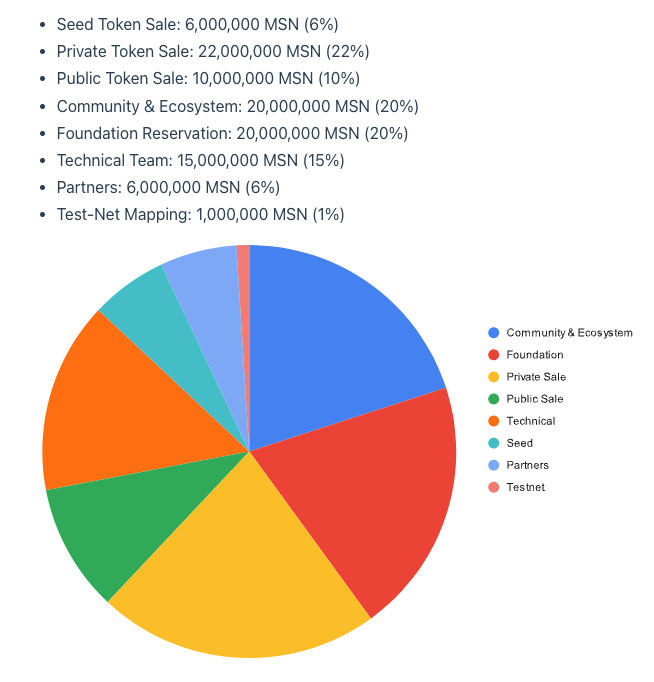

Tên token: MSN, cung ban đầu 100 triệu token, tỷ lệ lạm phát đào năm đầu 5%, giảm 0,5% mỗi năm.

Network 3: Tích hợp với mạng Sei

Chào mừng tham gia cộng đồng chính thức TechFlow

Nhóm Telegram:https://t.me/TechFlowDaily

Tài khoản Twitter chính thức:https://x.com/TechFlowPost

Tài khoản Twitter tiếng Anh:https://x.com/BlockFlow_News