黄仁勲、Transformer論文の7大著者と対話し、大規模モデルの将来について議論

TechFlow厳選深潮セレクト

黄仁勲、Transformer論文の7大著者と対話し、大規模モデルの将来について議論

この世界はTransformerよりも優れたものが必要であり、ここでお目にかかっている全員が、それが何か別のものに取って代わられ、私たちを新しい性能の高原へと導いてくれることを願っていると思います。

執筆:郭暁静

出典:騰訊ニュース

2017年、画期的な論文『Attention is All You Need』が登場した。この論文は、自己注意(セルフアテンション)機構に基づくTransformerモデルを初めて導入したもので、従来のRNNやCNNの枠組みから脱却し、並列処理によるアテンション機構を通じて長距離依存関係の問題を効果的に克服するとともに、系列データ処理の速度を大幅に向上させた。Transformerのエンコーダー・デコーダー構造とマルチヘッドアテンション機構は人工知能分野に大きな衝撃を与え、現在話題のChatGPTもまさにこのアーキテクチャを基盤としている。

Transformerモデルを、友人と会話している自分の脳が相手の言葉のすべての単語に同時に注目し、それらのつながりを理解できるように想像してみてほしい。これはコンピュータに人間のような言語理解能力を与えるものだ。これ以前、言語処理の主流はRNNだったが、その情報処理速度は遅く、古いタイプのテーププレーヤーのように一字一句順番に再生しなければならなかった。一方、Transformerモデルは効率的なDJのように複数の音軌を同時に操作し、重要な情報を素早く捉えることができる。

Transformerモデルの登場により、コンピュータの言語処理能力は飛躍的に向上し、機械翻訳、音声認識、テキスト要約などのタスクがより高速かつ正確に行えるようになった。これは業界全体にとって大きな進歩であった。

この革新的な成果は、かつてグーグルに在籍していた8人のAI科学者たちの協力によって生まれた。当初の目的は非常にシンプルで、グーグルの機械翻訳サービスを改善することだった。単語ごとに孤立して翻訳するのではなく、文全体を理解して通読できるようにしたいという思いが、「Transformer」アーキテクチャの出発点――「自己注意」機構――となった。こうした理念のもと、8人はそれぞれの専門性を活かし、2017年12月に『Attention Is All You Need』という論文を発表し、Transformerアーキテクチャの詳細を明らかにすることで、生成AIの新たな時代の幕を開けたのである。

生成AIの世界では、「スケーリング則(Scaling Law)」が中心的な原則である。簡単に言えば、Transformerモデルの規模が大きくなるほどその性能も向上するということだが、これはより大規模なモデルと深層ネットワークを支えるために、より強力な計算リソースが必要になることも意味している。高性能計算サービスを提供するNVIDIAは、このAIブームの中で極めて重要な役割を果たすことになった。

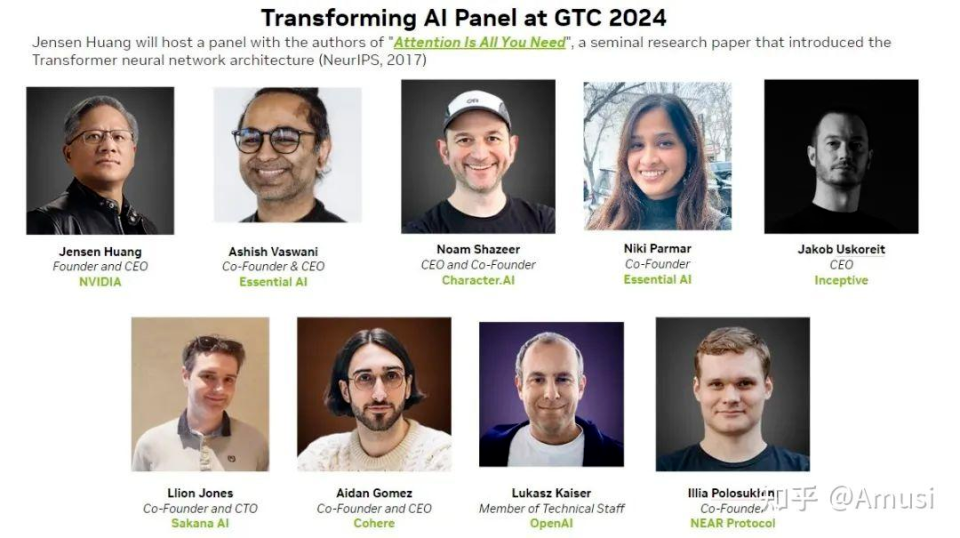

今年のGTCカンファレンスで、NVIDIAの黄仁勲(ジェンスン・ファン)氏は儀式的な形で、Transformerの7人の著者(Niki Parmar氏は都合により欠席)を円卓フォーラムに招いた。これは7人が公の場で一堂に会する初めての出来事であった。

彼らの対話からは、印象深いいくつかの見解が示された:

-

世界にはTransformerよりも優れた何かが必要だ。ここにいる全員が、それが何らかの新しい技術に取って代わられ、新たな性能の高原に到達することを望んでいると思う。

-

我々の当初の目標は達成できていない。当初の狙いはトークンの進化過程を模倣することだった。それは線形的な生成プロセスではなく、テキストやコードが段階的に進化していくプロセスだ。

-

2+2のような簡単な問題でも、大規模モデルの兆単位のパラメータを使ってしまうかもしれない。私は、適応的計算が次に必要とされるべきことだと思う。特定の問題に対してどれだけの計算リソースを使うべきかを知るべきだ。

-

今のモデルはあまりにも経済的で、まだ規模も小さい。トークン百万個あたり1ドル程度の価格は、ペーパーバックを買うよりも100倍安い。

以下は対談内容の実録:

黄仁勲:過去60年間、コンピュータ技術は根本的な変革を遂げてこなかったように思われる。少なくとも私が生まれた当時から変わっていない。現在私たちが使っているコンピュータシステムは、マルチタスク処理、ハードウェアとソフトウェアの分離、ソフトウェアの互換性、データのバックアップ能力、そしてソフトウェアエンジニアのプログラミング技術など、すべてIBM System/360の設計思想――中央処理装置、I/Oサブシステム、マルチタスク処理、ハードウェアとソフトウェアの分離、ソフトウェアの互換性など――に基づいている。

1964年以降、現代コンピューティングは根本的に変わっていないと考えている。確かに1980年代から1990年代にかけて、コンピュータは大きく変容し、今日私たちが知る形になった。しかし時間とともに、コンピュータの限界コストは継続的に下がり、10年で10分の1、15年で千分の1、20年で一万分の1になった。このコンピュータ革命において、コスト低下の度合いは非常に大きく、20年の間にほぼ一万分の一まで下がった。この変化が社会に与えた影響は計り知れない。

もし生活の中の高価なものがすべて一万分の一の価格になったとしたら、どうなるだろうか? 例えば20年前に20万ドルで買った車が今では1ドルで買える。そんな変化を想像できるだろうか? しかしコンピュータのコスト低下は突然の現象ではなく、ある臨界点に達した後、急激に変化したわけではない。毎年少しずつ改良はされているが、変化率自体は頭打ちになっている。

そこで我々はアクセラレーテッド・コンピューティングを探求し始めた。しかしアクセラレーションは容易ではない。ゼロから設計し直す必要がある。かつては既定のステップに従って問題を解決できたが、今はそれらのステップを再設計しなければならない。これはまったく新しい科学領域であり、従来のルールを並列アルゴリズムとして再定式化する作業なのだ。

我々は気づいた。たとえコードの1%しか高速化できなくても、99%の実行時間を節約できれば、それを活用できるアプリケーションが必ず存在すると信じている。不可能を可能にする、あるいは可能だったことをさらに効率化する――それがアクセラレーテッド・コンピューティングの意義である。

会社の歴史を振り返ると、さまざまなアプリケーションを加速できる能力を持っていることがわかる。当初、ゲーム分野で顕著な加速効果を上げたため、人々は誤って我々をゲーム企業だと考えた。しかし実際の目標はそれ以上にある。この市場は非常に巨大であり、信じられないほどの技術進歩を推進できるほど膨大な需要がある。このような例はめったにないが、我々はその稀有なケースを見つけたのだ。

端的に言えば、2012年にAlexNetが小さな火種に火をつけた。これがAIとNVIDIAのGPUとの最初の出会いだった。この瞬間が、我々の旅の始まりを告げた。数年後、我々は今日の発展の基礎となる完璧な応用シナリオを発見した。

要するに、これらの成果が生成AIの発展の土台を築いた。生成AIは画像を識別するだけでなく、テキストから画像を生成したり、まったく新しいコンテンツを作り出したりできる。今や我々は十分な技術力を備えており、ピクセルを理解し、それらを認識し、その背後にある意味を理解できるようになった。その意味を基に、新しいコンテンツを創造できるのだ。データからその意味を理解するAIの能力――これは巨大な変革である。

我々には、これがまったく新しい産業革命の始まりであると信じる理由がある。この革命の中で、我々はかつてないものを生み出している。例えば過去の産業革命では、水がエネルギー源であり、水が我々の作った装置に入り、発電機が動き出す。水が入り、電気が出てくる。まるで魔法のようだ。

生成AIはまったく新しい「ソフトウェア」であり、それ自体がソフトウェアを生み出す。それは多くの科学者の共同努力に依存している。原材料であるデータを与え、それを「建物」――GPUマシンと呼ぶ――に入れると、魔法のような結果が出力される。すべてが再形成されつつある。我々は「AI工場」の誕生を目撃しているのだ。

この変革はまったく新しい産業革命と呼べる。過去、我々はこのような変革を真に経験したことはないが、今まさにそれがゆっくりと姿を現している。次の10年を見逃してはならない。この10年で、我々は巨大な生産性を生み出すだろう。時の針はすでに動き始め、研究者たちはすでに行動を開始している。

今日はTransformerの創造者たちをお招きし、未来の生成AIが我々をどこへ導くのかについて話し合いたい。

彼らは以下の通り:

Ashish Vaswani:2016年にGoogle Brainチームに加入。2022年4月にNiki Parmarと共にAdept AIを設立。同年12月に同社を退社し、別のAIスタートアップEssential AIを共同設立。

Niki Parmar:Google Brainで4年間勤務後、Ashish Vaswaniと共にAdept AIおよびEssential AIを設立。

Jakob Uszkoreit:2008年から2021年までグーグルに勤務。2021年に退社し、他者と共にInceptiveを共同設立。同社はAIバイオサイエンスを主業務とし、ニューラルネットワークとハイスループット実験を用いて次世代RNA分子の設計を目指している。

Illia Polosukhin:2014年にグーグルに入社。8人チームの中で最も早く退社した一人であり、2017年に他者と共にブロックチェーン企業NEAR Protocolを共同設立。

Noam Shazeer:2000年から2009年、および2012年から2021年までグーグルに勤務。2021年にグーグルを退社し、元グーグルエンジニアのDaniel De Freitasと共にCharacter.AIを共同設立。

Llion Jones:Delcam、YouTubeに勤務。2012年にグーグルに入社し、ソフトウェアエンジニアとして勤務。後にグーグルを退社し、AIスタートアップsakana.aiを設立。

Lukasz Kaiser:フランス国立科学研究センター(CNRS)の研究員を務めた後、2013年にグーグルに入社。2021年にグーグルを退社し、OpenAIの研究員となった。

Aidan Gomez:カナダのトロント大学卒業。Transformer論文発表時はグーグルブラインチームのインターン。8人チームで2番目にグーグルを退社。2019年に他者と共にCohereを設立。

黄仁勲:今日はここに集まっていただき、積極的に発言を争ってください。ここではどんな話題でも自由に語れます。椅子から飛び上がって議論しても構いません。基本的なところから始めましょう。当時、あなた方は何に直面していましたか? なぜTransformerを作ろうと思ったのですか?

Illia Polosukhin:検索結果を実際に読み取れるモデルを公開したい場合、例えば大量のドキュメントを処理する必要があるとき、情報を迅速に処理できるモデルが必要でした。当時の再帰型ニューラルネットワーク(RNN)はその要求を満たせませんでした。

確かに当時、RNNや初期のアテンション機構(Arnens)が注目を集めていましたが、それでも単語ごとに順番に読む必要があり、効率は低かったのです。

Jakob Uszkoreit:訓練データの生成スピードは、最先端アーキテクチャを訓練する能力をはるかに上回っていた。実際にはよりシンプルなアーキテクチャ、例えばn-gramを入力特徴とするフィードフォワードネットワークを使っていました。これらのアーキテクチャは、グーグル規模の大量の訓練データにおいて、訓練が速いため、しばしばより複雑で高度なモデルを上回っていました。

当時、強力なRNN、特にLSTM(長短期記憶)ネットワークはすでに存在していました。

Noam Shazeer:これは明らかに解決すべき問題でした。2015年頃から、スケーリング則(Scaling law)の存在に気づき始めました。モデルが大きくなるにつれて、知能レベルも上がることがわかりました。これは人類史上最高の問題です。とてもシンプルで、ただ次のトークンを予測しているだけで、それがこんなに賢くなり、100万の異なることをこなせるのです。ただ規模を拡大して、より良くすればいい。

しかし大きな挫折は、RNNの扱いが非常に面倒だったことです。そんなとき、他の人たちが「畳み込みやアテンション機構で置き換えよう」と話し合っているのを耳にしました。「よし、それでいこう」と思ったのです。私はTransformerを蒸気機関から内燃機関への飛躍に例えています。産業革命は蒸気機関でも可能でしたが、それは非常に苦痛なものだったでしょう。内燃機関はすべてをより良くしたのです。

Ashish Vaswani:大学院時代、特に機械翻訳に取り組んでいたときに、いくつかの苦い教訓を得ました。「複雑な言語ルールを学んでも無駄だ」と気づいたのです。勾配降下法(Gradient Descent)――つまりモデルの訓練方法――は私よりも優れた教師だと。だから私はルールを学ばず、勾配降下法にすべてを任せることにした。それが私の二つ目の教訓です。

こうした苦い教訓から学んだのは、「スケーラブルな汎用アーキテクチャが長期的には勝ち残る」ということです。今日のトークンがそうであるように、明日はコンピュータ上で行われる行動になり、それらが私たちの活動を模倣し始め、多くの作業を自動化できるようになるでしょう。議論したように、Transformer、特にその自己注意機構は非常に広範に適用可能であり、勾配降下法をより効果的にします。あと物理学ですね。Noamから学んだのは、「行列乗算は良いアイデアだ」ということです。

Noam Shazeer:このパターンは繰り返されます。ルールをいくら追加しても、結局勾配降下法の方がそれらを学ぶのが上手くなるのです。まさに私たちがやってきたディープラーニングのように、GPUのような形のAIモデルを構築しています。今や、スーパーコンピュータのような形のAIモデルを構築しているのです。はい、スーパーコンピュータそのものがモデルなのです。本当です。スーパーコンピュータはモデルの形をしているということを知っておいてください。我々はスーパーコンピュータをモデルの形にしているのです。

黄仁勲:では、あなた方が解決しようとした問題は何ですか?

Lukasz Kaiser:機械翻訳です。5年前を振り返ると、このプロセスは非常に難しく、データを集め、翻訳を試みても、せいぜい正しくなる程度でした。当時のレベルはまだ初歩的でした。しかし今や、データがなくても翻訳を学習できるモデルがあります。ある言語と別の言語を提示するだけで、モデル自身が翻訳を学びます。この能力は自然発生的に現れ、結果も満足できるものです。

Llion Jones:しかし、「Attention」こそが本質的な直感だと感じました。そのため、タイトルを考えていたときに、そのアイデアが浮かびました。

私たちはアブレーション実験をしていて、モデルの一部を取り除いてみて、悪くなるかどうか確かめていました。驚いたことに、むしろ良くなったのです。畳み込みをすべて取り除いた場合も、はるかに良い結果が出ました。それがタイトルの由来です。

Ashish Vaswani:興味深いのは、基本的に最も基本的なフレームワークから始めたことです。その後、何かを追加しました。畳み込みを追加したと思いますが、後に取り除きました。マルチヘッドアテンションなど、その他多くの非常に重要な要素もあります。

黄仁勲:誰が「Transformer」という名前を思いついたのですか? なぜ「Transformer」なのでしょうか?

Jakob Uszkoreit:この名前が気に入りました。ただ思いつきで名付けたのですが、創造的だと感じました。データ生産方式を変え、このような論理を使いました。すべての機械学習はトランスフォーマーであり、破壊的革新者なのです。

Noam Shazeer:当初はこの名前を考えておらず、とてもシンプルで、多くの人に好評だと感じました。以前はYaakovなどいろいろな名前を考えましたが、最終的に「Transformer」に決定しました。これはモデルの原理を説明しており、信号を実際に変換するものです。この論理に従えば、ほぼすべての機械学習が変換されることになります。

Llion Jones:Transformerがよく知られる名前になったのは、翻訳の内容だけでなく、このような変革をより包括的に表現したいという意図があったからです。私たちが特別優れているとは思いませんが、変革者として、原動力として、エンジンとして、それは理にかなっています。人々がこのような大規模言語モデル、エンジン、論理を理解できるようになりました。アーキテクチャの観点からは、かなり早い段階での取り組みでした。

しかし我々は実際に、非常に普遍的な何かを創造しようとしていたことに気づきました。それは本当に何でも他の何にも変換できるものです。また、Transformerが画像に使われたときにどれほどうまくいくかは予測していませんでした。少し驚きました。あなた方にとっては論理的かもしれませんが、画像をチャンクに分け、各ポイントにトークンを付けることができるのです。これはアーキテクチャ的に早くから存在していました。

したがって、テンソルからテンソルへのライブラリを構築する際、真剣に取り組んでいたのは自己回帰訓練のスケーリングでした。それは言語だけでなく、画像、音声の要素も含まれます。

だからルカシュ(Lukasz)が翻訳をしていると言ったのですが、彼は自分を過小評価していると思います。これらすべてのアイデアが、今や統合され始め、モデルの中に取り込まれています。

しかし実際、すべては昔から存在していました。これらのアイデアが浸透するには時間がかかりました。ルカシュ(Lukasz)の目標は、画像からテキスト、テキストから画像、音声からテキスト、テキストからテキストといったあらゆる学術データセットを持つことでした。すべてのものに対して訓練すべきだと。

このアイデアは拡張作業を推進し、最終的に成功しました。それは非常に面白く、画像をテキストに、テキストを画像に、テキストをテキストに翻訳できるようになったのです。

あなたはそれを生物学やバイオソフトウェアの研究に使っています。それはコンピュータソフトウェアに似ており、プログラムの形で始まり、GPU上で実行可能な形にコンパイルされます。

バイオソフトウェアの生命は、ある行動仕様から始まります。例えば、細胞内の特定のタンパク質のように、あるタンパク質を印刷したいとします。その後、ディープラーニングを使ってそれをRNA分子に変換する方法を学びますが、実際には細胞内に入ったときに、その行動を示します。だからこのアイデアは英語への翻訳にとどまらないのです。

黄仁勲:皆さんはこれらすべてを生産するための大規模な研究所を作ったのですか?

Aidan Gomez:大量に利用可能で、実際には依然として公開されています。なぜなら、これらのデータは通常、公共資金によって支援されているからです。しかし実際に、あなたが試みている現象を明確に示すデータは必要です。

特定の製品、例えばタンパク質発現やmRNAワクチンなどをモデリングしようとすると、パロアルトにはたくさんのロボットと白衣を着た人たちがいます。学習研究者もいれば、元生物学者もいます。

今や我々は新事物の先駆者だと考えており、実際にこれらのデータを作成し、分子設計モデルを検証することに尽力しています。しかし最初のアイデアは翻訳でした。

黄仁勲:最初のアイデアは機械翻訳でしたが、アーキテクチャの強化と突破の中で、鍵となる節目は何でしたか? そしてそれらはTransformerの設計にどのような影響を与えましたか?

Aidan Gomez:道のりを振り返ると、皆さんが見てきた通り、基本的なTransformer設計の上に本当に大きな追加貢献があると思いますか? 推論の面では、これらのモデルを高速化し、より効率的にするための大量の仕事がすでに行われています。

それでも、私たちのオリジナル形式がいかに似ているかにまだ不安を感じます。世界にはTransformerよりも良いものが必要だと思います。ここにいる全員が、それが何かに取って代わり、新たな性能の高原に連れて行ってくれることを願っていると思います。

ここで在席の皆さんに一つ質問したいと思います。次に何が起こるとお考えですか? これは6〜7年前のものとあまりにも似ているので、エキサイティングな一歩だと思いますが。

Llion Jones:はい、あなたが言う類似度に人々は驚くと思います。確かに、次に何が起こるかと私に尋ねる人は多いです。私は論文の著者だからです。まるで魔法のように、魔法の杖を振ったら次は何が現れるか? 私が指摘したいのは、この特定の原理がどのように設計されたかということです。私たちはより良くなるだけでなく、明らかにより良くなる必要があります。

なぜなら、わずかに良くなるだけでは、人工知能業界全体を新しい何かに押し進めることはできないからです。そのため、私たちは原始的なモデルに閉じ込められています。技術的には、今私たちが持っている最強のものではないかもしれませんが。

しかし、皆さんは自分がどんな個人用ツールを欲しいか知っています。より良いコンテキストウィンドウが欲しい、トークン生成をより速くしたい。まあ、この答えが好きかどうかはわかりませんが、彼らは今、あまりにも多くの計算リソースを使っています。多くの無駄な計算が行われています。効率を高める努力をしています。ありがとう。

黄仁勲:我々はそれをより効率的にしているのだと思います。ありがとうございます!

Jakob Uszkoreit:しかし、主に問題はどれだけのリソースを使うかではなく、どのようにリソースを分配するかだと思います。例えば、簡単な問題に多額のお金をかけるべきではなく、難しい問題に少なすぎるリソースを割いて解決できないまま終わるべきでもありません。

Illia Polosukhin:2+2のような例で言えば、それを正しくモデルに入力すれば、一兆のパラメータを使ってしまうかもしれません。ですから、適応的計算は次に必ず現れるべきものの一つだと思います。特定の問題にどれだけの計算リソースを使うべきかを知るべきです。

Aidan Gomez:現在のコンピュータの生成能力がどれほどあるかを知っています。これが次に集中すべき課題だと思います。これは宇宙規模の変革者であり、将来のトレンドでもあります。

Lukasz Kaiser:この概念はTransformer以前から存在し、Transformerモデルに統合されました。実は、在席の皆さんが気づいているかどうかわかりませんが、当初の目標には成功していません。このプロジェクトを始めた初衷は、トークンの進化過程を模倣することでした。それは線形的な生成プロセスではなく、テキストやコードが段階的に進化していくプロセスです。反復し、編集を行うことで、人間がテキストを発展させる過程だけでなく、人間自身をそのプロセスの一部にすることが可能になります。なぜなら、人間のように自然にコンテンツを生成できれば、実際にはフィードバックを提供できるからです。そうでしょう?

私たちは全員シャノンの論文を精読しました。当初の考えは、言語モデリングとパープレキシティに集中することでしたが、実際にはそれが実現できていません。これもさらに発展できる分野だと思います。また、現在どのように計算リソースを知的に組織しているかにも関係しています。この組織方法は現在画像処理にも適用されています。つまり、拡散モデルには面白い特性があり、反復的に品質を洗練・向上させることができます。しかし、今の我々にはその能力がありません。

つまり、根本的な問題は、どの知識をモデル内部に組み込むべきか、どの知識を外部に置くべきかということです。検索モデルを使うのか? RAG(Retrieval-Augmented Generation)モデルがその一例です。同様に、推論の問題もあり、どの推論タスクを外部の記号システムで行い、どの推論タスクをモデル内で直接行うかという点です。これは大きく効率に関する議論です。大規模モデルは最終的に2+2のような計算を学習すると信じていますが、数字を累積して2+2を計算するのは明らかに非効率です。

黄仁勲:AIが2+2を計算するだけなら、最小限のエネルギーでタスクを完了するために計算機を使うべきです。なぜなら、計算機は2+2を計算するのに最も効率的なツールだとわかっているからです。しかし、誰かがAIに『2+2の答えをどう出したのですか? 2+2が正しい答えだと知っているのですか?』と尋ねたら、それは莫大なリソースを消費するでしょうか?

Noam Shazeer:確かにそうです。あなたが挙げた例と同じですが、在席の皆さんが開発しているAIシステムは十分にスマートで、自発的に計算機を使うことができると私も確信しています。

現在、グローバル・パブリック・プロダクト(GPP)はまさにそれをやっています。今のモデルはあまりにも安価で、規模もまだ小さい。安く抑えられているのは、NVのような技術のおかげで、その生産性に感謝しています。

1回の演算の計算コストはおよそ10~18ドル。あるいは、その程度の数量級です。これほど多くの計算リソースを創出したことに感謝します。しかし、5000億パラメータのモデルを観察し、各トークンに対して1兆回の計算を行うと、トークン百万個あたり約1ドルです。これはペーパーバックを買って読むコストの100倍安い。私たちのアプリケーションの価値は、巨大なニューラルネット上の効率的な計算よりも百万倍、あるいはそれ以上高い。つまり、がんの治療などよりも明らかに価値が高いだけでなく、それ以上の価値があります。

Ashish Vaswani:世界をより賢くするとは、世界からのフィードバックを得る方法を指すと思います。多タスク、マルチラインの並列処理が可能かどうか。本当にそんなモデルを構築したいなら、そのモデルの設計を助けるのは非常に良い方法です。

黄仁勲:それぞれの会社を設立した理由を簡単に教えていただけますか?

Ashish Vaswani:私たちの会社では、モデルを構築し、新しいタスクを解決することを目指しています。私たちの仕事は、タスクの目的と内容を理解し、それらの変化に応じて顧客のニーズに応えることです。実際に2021年から、モデルの最大の問題は、モデルをより賢くするだけでなく、これらのモデルを解釈できる適切な人材を見つける必要があることに気づきました。世界とモデルが相互に融合し、モデルがさらに巨大で卓越したものになるようにしたいのです。学習プロセスには一定の進展が必要で、最初は研究所の真空状態ではこれらの仕事は完成できません。

Noam Shazeer:2021年、私たちは共同でこの会社を設立しました。これほど優れた技術を持っていますが、まだ多くの人々に恩恵を届けていません。もし私が患者だったら、数百億人が異なるタスクを完了する必要があると聞いたら、ディープラーニングの意義を感じるでしょう。私たちは比較を通じて技術を向上させます。技術の継続的な発展により、黄仁勲氏の推進のおかげで、究極の目標は世界中の人々を助けることです。テストを行う必要があります。今すぐ、より高速なソリューションを開発し、何百人もの人々がこれらのアプリケーションを使えるようにする必要があります。当初、誰もがこれらのアプリケーションを使っていたわけではなく、多くの人が娯楽目的で使っていましたが、確かに機能しており、働いていました。

Jakob Uszkoreit:ありがとうございます。私たちが構築したエコシステムソフトウェアについて話したいと思います。2021年、私はこの会社の設立に関わりました。私たちの目標は、本当に科学的影響力のある問題を解決することです。過去、私たちが扱ってきた内容は非常に複雑でした。しかし、最初の子供が生まれたとき、世界の見方が変わりました。人類の生活をより便利にしたいし、タンパク質研究にも貢献したい。特に子供ができたことで、現在の医療体制を変えることができれば、そして科学技術の発展が人類の生存と発展にプラスの影響を与えることができればと願っています。例えば、タンパク質の構造と分解はすでに一定の影響を受けていますが、現在データが不足しています。データに基づいて努力しなければなりません。それは責任であり、父親としての義務でもあります。

黄仁勲:あなたの考え方が好きです。私は常に新薬設計に興味を持っており、コンピュータに新薬開発と生成のプロセスを学ばせることに魅力を感じます。学習し、新薬を設計でき、実験室でテストできれば、そのモデルの実現可能性が確認できます。

Llion Jones:はい、最後の発言者です。私たちが共同設立した会社はSakana AIで、「魚」という意味です。会社名に日本の「魚」を使ったのは、魚群のように自然からインスピレーションを得て知能を探求するからです。多くの検証要素を組み合わせることができれば、複雑で美しいものが生まれます。多くの人がこのプロセスや内容の詳細を理解していないかもしれませんが、私たちの内部の核心哲学は「学習は常に勝利する」です。

問題を解決しようとしても、何かを学ぼうとしても、学習は常にあなたを勝利に導きます。生成AIのプロセスにおいても、学習は私たちを勝利に導きます。現場の研究者として、皆さんに伝えたいのは、コンピュータに与えるAIモデルに真の意味を持たせ、それが本当に宇宙の謎を理解する手助けをすることです。実際に皆さんにお伝えしたいのは、最新の進展を発表しようとしていることで、それに非常にわくわくしています。現在、一連の研究成果を基盤としていますが、変革的な発展を経験しています。現在のモデル管理は体系的で、人々が真に参加できるようになっています。これらのモデルをより実現可能にし、大規模モデルと変革的なパターンを使って、人々の世界や宇宙に対する認知の仕方を変えていくことが目標です。

Aidan Gomez:私の会社設立の動機はNoam Shazeerと似ています。コンピュータが新しいモードに入り、既存の製品や私たちの働き方を変えつつあると感じました。すべてがコンピュータに基づいており、技術内部で一定の変化が起きています。私たちの役割は何でしょうか? 実際にはギャップを埋め、溝を越えようとしています。さまざまな企業がこのようなプラットフォームを構築し、各企業が製品に適応・融合できるようにしています。これはユーザーに直接向けたアプローチです。これが私たちが技術を推進する方法で、技術をより経済的かつ普及させることができるのです。

黄仁勲:Noam Shazeerが特に落ち着いているときに、あなたは非常に興奮しているのが印象的です。二人の性格の違いは鮮明ですね。では、Lukasz Kaiserさん、お願いします。

Lukasz Kaiser:OpenAIでの経験は非常に破壊的でした。会社には楽しさがあり、大量のデータを計算処理していますが、結局のところ、私の役割はデータ処理者です。

Illia Polosukhin:私は最初に退社した人です。大きな進展を達成すると信じており、ソフトウェアが世界を変えると確信しています。最も直接的な方法は、機械にコードを書くことを教え、プログラミングを誰にでもアクセス可能にすることです。

NEARでは進展は限定的ですが、人類の知性を統合し、関連データを取得することに努めています。例えば人々にさらなるインスピレーションを与え、基礎的な方法論が必要だと気づかせることです。このパターンは基礎的な進展であり、大規模モデルは世界的に広く使用されており、航空宇宙など多くの分野で応用されています。それは各分野の交流と相互作用に関わり、実際には私たちに能力を提供しています。使用が深まるにつれ、より多くのモデルが生まれ、現在、著作権に関する論争はあまり多くありません。

私たちは今、まったく新しい生成時代にいます。これはイノベーションとイノベーターを称える時代です。積極的に参加し、変化を歓迎したいと考えており、非常にクールなモデルを構築するための異なる方法を模索しています。

黄仁勲:このような積極的なフィードバックシステムは、全体の経済にとって非常に有益です。今や経済をよりよく設計できます。質問があります。GPTモデルが数十億トークン規模のデータベースを訓練しているこの時代、次は何でしょうか? 新しいモデル技術とは何ですか? 何を探求したいですか? データの出所はどこですか?

Illia Polosukhin:私たちの出発点はベクトルと変位です。本当に経済的価値のあるモデルが必要で、人々がそれを評価でき、最終的にあなたの技術とツールを実践に応用することで、モデル全体をより良くすることができます。

黄仁勲:どのようにしてモデルをドメイン特化訓練するのですか? 最初のインタラクションや相互作用のパターンは何ですか? モデル同士のコミュニケーションや相互作用ですか? それとも生成モデルや技術がありますか?

Illia Polosukhin:私たちのチームでは、各自が独自の技術的専門性を持っています。

Jakob Uszkoreit:次は推論です。推論の重要性を誰もが認識していますが、多くの作業はまだエンジニアが手作業で行っています。我々は彼らにインタラクティブなQ&A方式で答えることを教えています。なぜ一緒に、共に強力な推論パターンを提供できるのかを理解してほしいのです。モデルが私たちが望む内容を生成できるようにしたい。このような生成方法が私たちの追求するものです。ビデオ、テキスト、3D情報など、すべて統合されるべきです。

TechFlow公式コミュニティへようこそ

Telegram購読グループ:https://t.me/TechFlowDaily

Twitter公式アカウント:https://x.com/TechFlowPost

Twitter英語アカウント:https://x.com/BlockFlow_News