FMGレポート:AIの3つの課題とDePINによる解決策

TechFlow厳選深潮セレクト

FMGレポート:AIの3つの課題とDePINによる解決策

問題の鍵は計算能力の多寡ではなく、いかにAI製品に付加価値を与えるかにある。

執筆:FMGResearch

TL; DR

AI時代の製品競争は、リソース面(計算力、データなど)なしには成り立たず、特に安定したリソースのバックアップが不可欠である。

モデルのトレーニングや反復改善には、膨大なユーザー数(IP)によるデータ供給が必要であり、これがモデル効率の質的飛躍をもたらす。

Web3との統合により、中小規模のAIスタートアップチームは従来のAI大手企業を逆転することが可能になる。

DePINエコシステムにおいて、計算力や帯域などのリソース面は下限を決定する(単なる計算力の集約には持続的な優位性がない)。一方で、AIモデルの応用・最適化(BitTensorのような例)、専門化(Render、Hivemapperなど)、およびデータの有効活用といった要素がプロジェクトの上限を決める。

AI+DePINという文脈では、モデル推論・ファインチューニングおよびモバイル端末向けAIモデル市場が注目される。

AI市場分析と3つの課題

統計によると、2022年9月(ChatGPT登場直前)から2023年8月までの間に、世界トップ50のAI製品は累計240億回以上のアクセスを記録し、月平均で約2.363億回の増加があった。

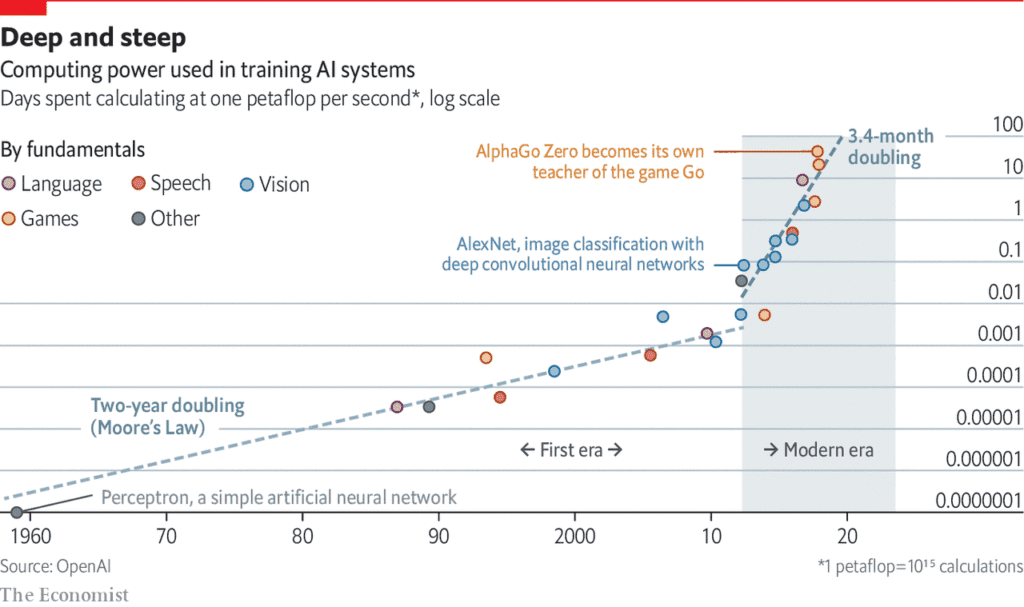

AI製品の繁栄の裏側では、計算力への依存度がますます高まっている。

出典: Language Models are Few-Shot Learners

マサチューセッツ大学アマースト校の研究論文では、「AIモデル1回分の学習に伴う生涯排出炭素量は、5台の自動車の排出量に相当する」と指摘している。しかし、これは1回の学習プロセスに限定した分析であり、モデルが繰り返し再学習されることでエネルギー消費はさらに大幅に増加する。

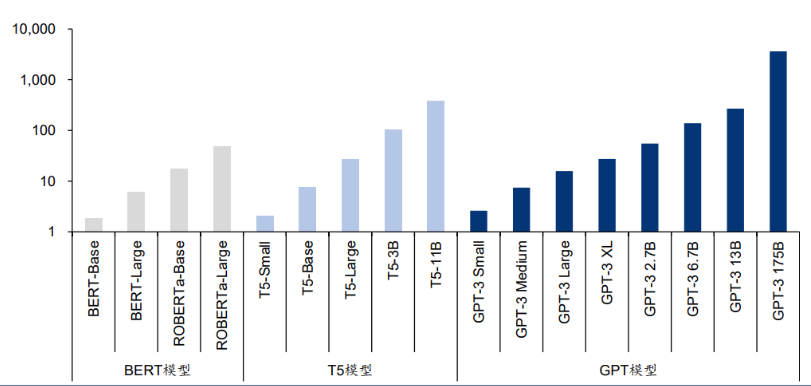

最新の言語モデルは数十億から数兆もの重みパラメータを持つ。有名なGPT-3モデルは1750億の機械学習パラメータを持ち、A100チップを使用して訓練するには1024個のGPU、34日間、そして460万ドルの費用がかかる。

AI後期における製品競争は、実質的に計算力を中心とするリソース争奪戦へと移行しつつある。

出典:AI is harming our planet: addressing AI’s staggering energy cost

ここから次の3つの問題が浮上する。第一に、AI製品が十分なリソース(計算力、帯域など)—とりわけ安定したリソース—を確保できるか。 この信頼性は、計算力の非中央集権化によって支えられるべきだが、現状では半導体需要のギャップに加え、政策やイデオロギーに基づく「技術壁」の存在により、チップメーカーが価格を大きく引き上げる優位性を持っている。例えばNVIDIAのH100チップは、2023年4月の3.6万ドルから5万ドルまで値上がりしており、AIモデル開発チームのコスト負担を一層加重させている。

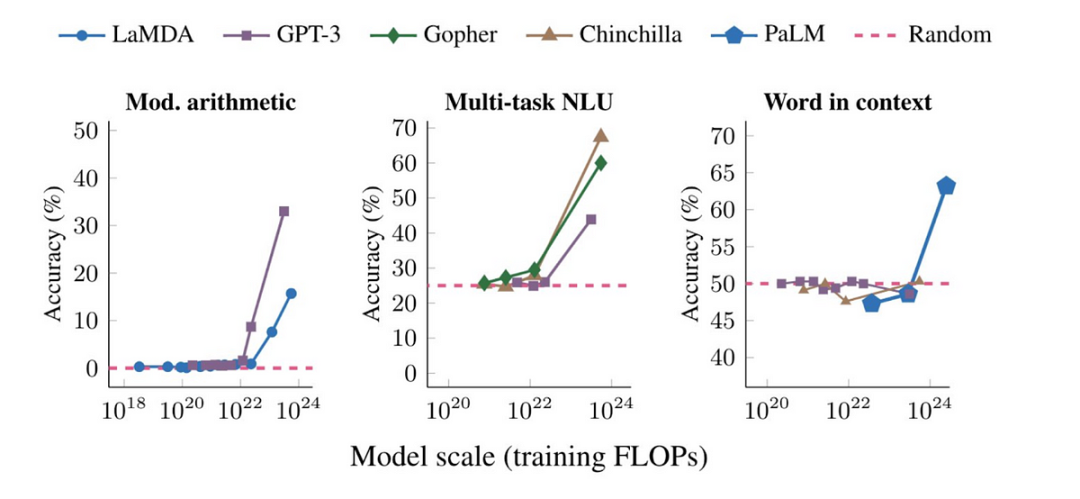

第二の問題は、ハードウェア需要の充足だけでは不十分であり、モデルのトレーニング/反復改善には膨大なユーザー(IP)によるデータ供給が必要である。 モデル規模がある閾値を超えると、さまざまなタスクでの性能が飛躍的に向上する。

第三の問題は、中小規模のAIスタートアップが既存の大手に対抗して急成長するのが難しい点にある。 従来の金融市場における計算力の独占は、AIモデルの提案段階でも独占構造を生み出し、OpenAIやGoogle DeepMindなどの大手AIモデル企業がますます強固な防衛ラインを築いている。中小AIチームは差別化された競争戦略を模索せざるを得ない。

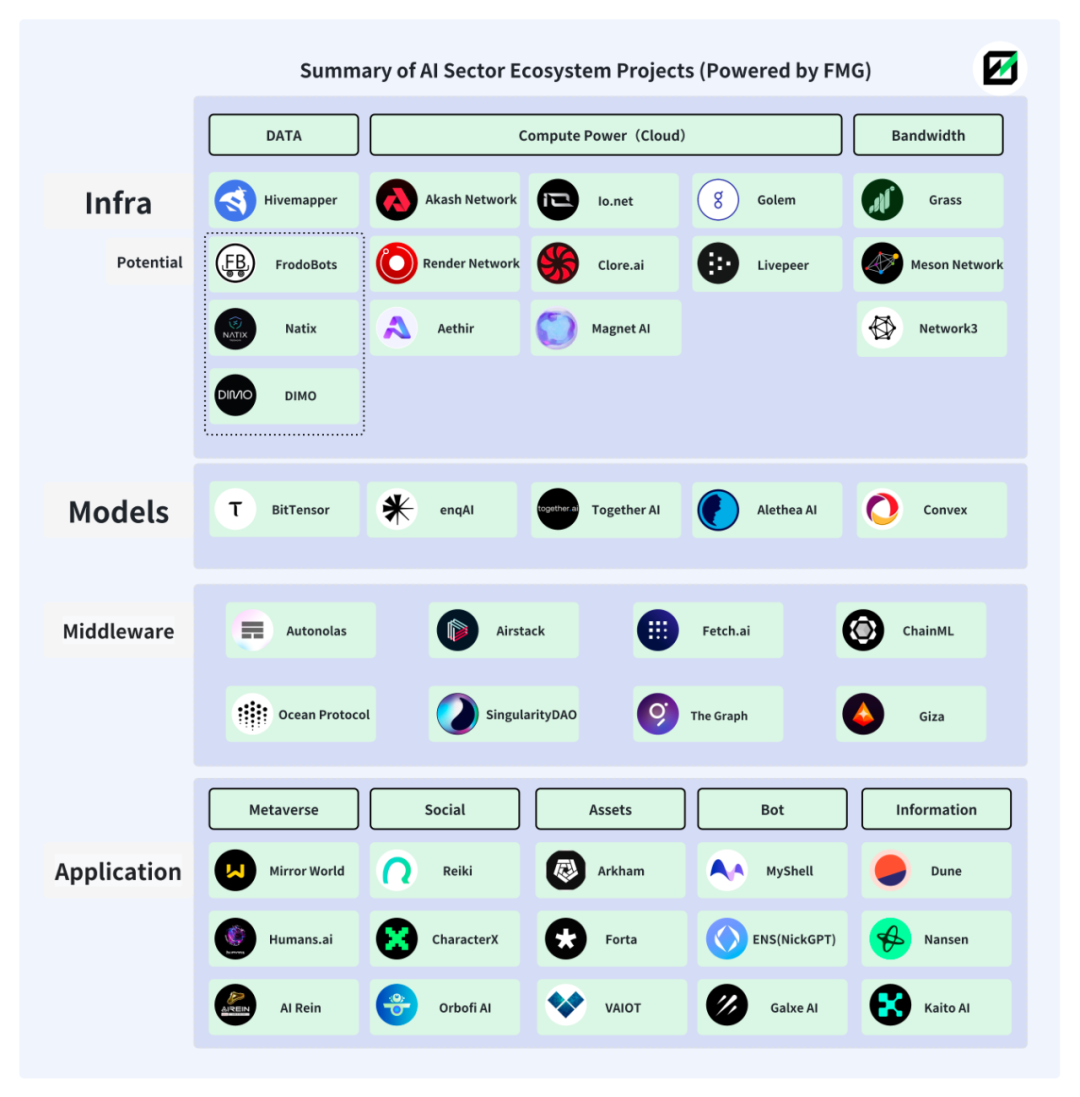

これらの3つの課題に対して、Web3の中に解決策が見いだせる。実際、AIとWeb3の融合は以前から存在しており、すでに比較的成熟したエコシステムが形成されている。

以下の図はFuture Money Groupが作成したAI+Web3エコシステムの一部カテゴリーとプロジェクトの概観である。

AI+DePIN

1. DePINのソリューション

DePINとは「Decentralized Physical Infrastructure Networks(分散型物理インフラネットワーク)」の略であり、人間とハードウェア機器の生産関係の集合体である。トークン経済学とコンピュータや車載カメラなどのハードウェアを組み合わせることで、ユーザーと機器を一体化し、経済モデルの円滑な運営を実現する。

より広義のWeb3と比べて、DePINはハードウェア機器および伝統的企業との関連が深いため、外部のAIチームおよび関連資金を惹きつける天然の優位性を持つ。

DePINエコシステムが分散型計算力の追求と貢献者へのインセンティブ設計を通じて、AI製品の計算力およびIPニーズを的確に満たしている。

-

DePINはトークン経済を通じて世界中の計算力(データセンターおよび個人の空き計算力)を呼び込み、計算力の中央集権リスクを低減するとともに、AIチームの計算力利用コストを下げている。

-

DePINエコシステム内の多様で大量のIPは、AIモデルのデータ取得チャネルを多様化・客観化し、多数のデータ提供者がモデル性能の向上を保証する。

-

DePINユーザーとWeb3ユーザーの人物像が重なるため、参画するAIプロジェクトはWeb3特有のAIモデルを開発でき、差別化競争を実現できる。これは従来のAI市場にはない利点である。

Web2領域では、AIモデルのデータ収集は主に公開データセットまたは自社収集に依存しており、文化的背景や地域制限により生成コンテンツに主観的な「歪み」が生じやすい。また、従来のデータ収集方法は効率とコストの制約から、より大きなモデル規模(パラメータ数、トレーニング時間、データ品質)の達成が困難である。AIモデルにとって、規模が大きくなるほど性能の質的変化が起こりやすくなる。

出典:Large Language Models’ emergent abilities: how they solve problems they were not trained to address?

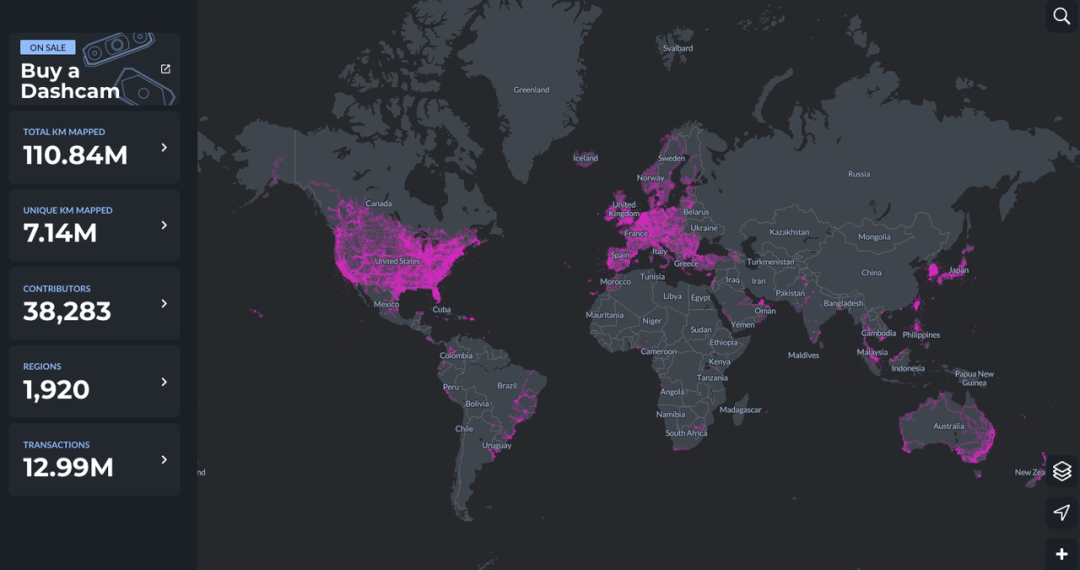

この点において、DePINは天然の優位性を持つ。Hivemapperを例に挙げると、世界1920地域にわたる約4万名の貢献者がMAP AI(地図AIモデル)のデータ提供を行っている。

AIとDePINの統合は、AIとWeb3の融合を新たな高みへと押し上げている。現在のWeb3内AIプロジェクトは主にアプリケーション層に集中しており、ほとんどがWeb2インフラに直接依存している。つまり、既存の伝統的計算プラットフォーム上のAIモデルをWeb3プロジェクトに埋め込む形にとどまり、AIモデルの独自創出にはほとんど踏み込んでいない。

Web3要素は食物連鎖の下流に位置し、真の超過利潤を得られていない。分散型計算プラットフォームも同様で、単なるAI+計算力では双方の潜在能力を十分に引き出せず、計算力提供者は追加の利益を得られず、エコシステム構造も単一的であるため、トークン経済を通じた好循環(フライホイール)の発生が難しい。

しかし、AI+DePINという概念はこうした固定関係を打破し、Web3の注目をより広範なAIモデル開発へとシフトさせつつある。

2. AI+DePINプロジェクト一覧

DePIN内部には、AIに必要なハードウェア(計算力、帯域、アルゴリズム、データ)、ユーザー(モデルトレーニングデータ提供者)、およびエコシステム内インセンティブ(トークン経済)が自然に備わっている。

大胆に定義しよう。AIに必要な客観的条件(計算力/帯域/データ/IP)を整備し、AIモデル(トレーニング/推論/ファインチューニング)の利用シーンを提供し、トークン経済が付与されたプロジェクトを、「AI+DePIN」と呼ぶことができる。

以下、Future Money GroupがAI+DePINの代表的パターンを整理する。

提供されるリソースの種類ごとに、計算力、帯域、データ、その他という4つのカテゴリに分け、それぞれのプロジェクトを整理する。

2.1 計算力

計算力はAI+DePINの主要構成部分であり、現在最も多くのプロジェクトが集中する分野である。計算力の主成分はGPU(グラフィックスプロセッサ)、CPU(中央処理装置)、TPU(専用機械学習チップ)である。TPUは製造難度が高く、Googleが主に開発しておりクラウド計算力のレンタルサービスのみ提供しているため、市場規模は小さい。一方、GPUはCPUに似た専門的ハードウェアであり、並列処理による複雑な数学演算をより効率的に処理できる。当初はゲームやアニメーションのグラフィックレンダリング専用だったが、現在ではその用途はそれを遥かに超えている。そのため、現在の計算力市場の主力はGPUである。

そのため、AI+DePINの計算力系プロジェクトの多くは、グラフィック・ビデオレンダリングや関連ゲーム分野に特化しているのは、GPUの特性によるものである。

全体として見ると、計算力系AI+DePIN製品の提供元は三つに分けられる:伝統的クラウド計算サービスプロバイダー、個人の空き計算力、自社保有計算力。うちクラウドプロバイダーが最大、次いで個人の空き計算力である。つまり、こうした製品は多くの場合、計算力仲介者の役割を果たしている。需要側は多様なAIモデル開発チームである。

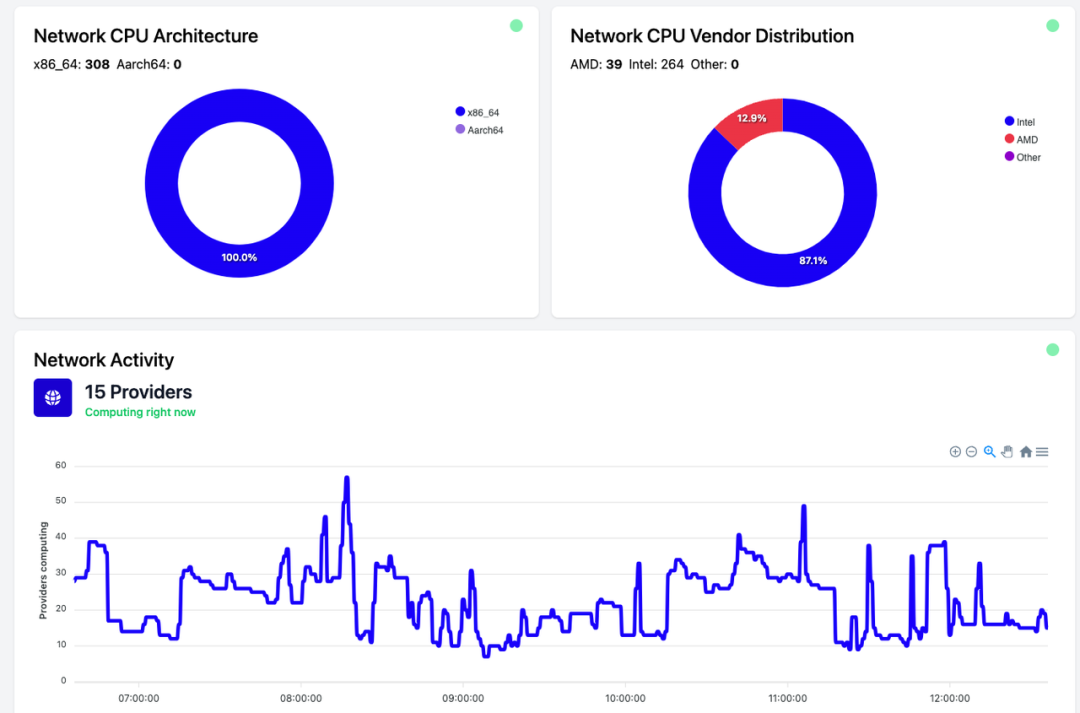

現時点では、計算力はほぼ100%活用されておらず、大部分がアイドル状態にある。例えばAkash Networkの場合、使用中の計算力は約35%で、残りは未使用である。io.netも同様の状況である。

これはおそらく、現時点でのAIモデルトレーニング需要がまだ少ないことに起因し、同時にAI+DePINが安価な計算コストを提供できる理由でもある。今後AI市場が拡大すれば、この状況は改善されると予想される。

Akash Network:分散型P2Pクラウドサービスマーケット

Akashネットワークは、分散型P2Pクラウドサービスマーケットであり、しばしば「クラウドサービスのAirbnb」と呼ばれる。Akashネットワークは、大小さまざまなユーザーおよび企業が迅速かつ安定、かつ経済的にサービスを利用できるようにする。

Renderと同様に、AkashもユーザーにGPUの展開・レンタル、AIモデルトレーニングなどのサービスを提供している。

2023年8月、AkashはSupercloudをリリース。開発者が自身のAIモデルを展開する際に支払いたい価格を設定でき、余剰計算能力を持つプロバイダーがそのモデルをホストする仕組みである。この機能はAirbnbに酷似しており、プロバイダーが未使用の容量を貸し出すことを可能にする。

公開入札方式により、ネットワーク内の空き計算資源を開放するインセンティブを提供し、Akash Networkはリソースのより効率的な利用を実現し、需要側に競争力のある価格を提供している。

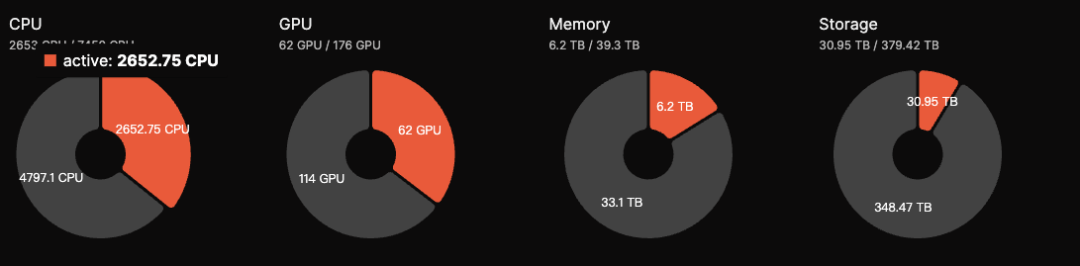

現在、Akashエコシステム内のGPU総数は176枚だが、アクティブ数は62枚で、稼働率は35%。2023年9月の50%から低下している。推定日収は約5000米ドル。AKTトークンはステーキング機能を備え、ユーザーはトークンをステークすることでネットワークの安全性維持に参加し、年率約13.15%のリターンを得られる。

Akashは現在のAI+DePIN分野で比較的優れたデータを示しており、7億ドルのFDVはRenderやBitTensorと比べて大きな上昇余地がある。

また、AkashはBitTensorのSubnetにも接続し、自らの発展空間を拡大している。全体として、AkashはAI+DePIN分野の優良プロジェクトの一つであり、基本的財務状況も良好である。

io.net:接続GPU数最多のAI+DePIN

io.netは分散型計算ネットワークであり、Solanaブロックチェーン上でML(機械学習)アプリケーションの開発・実行・拡張を支援する。世界最大級のGPUクラスタを活用し、機械学習エンジニアが中央集権型サービスコストのごく一部で、分散型クラウド計算リソースをレンタル・アクセスできるようにする。

公式データによると、io.netは100万以上の待機状態GPUを保有している。また、Renderとの協業により、展開可能なGPUリソースも拡大している。

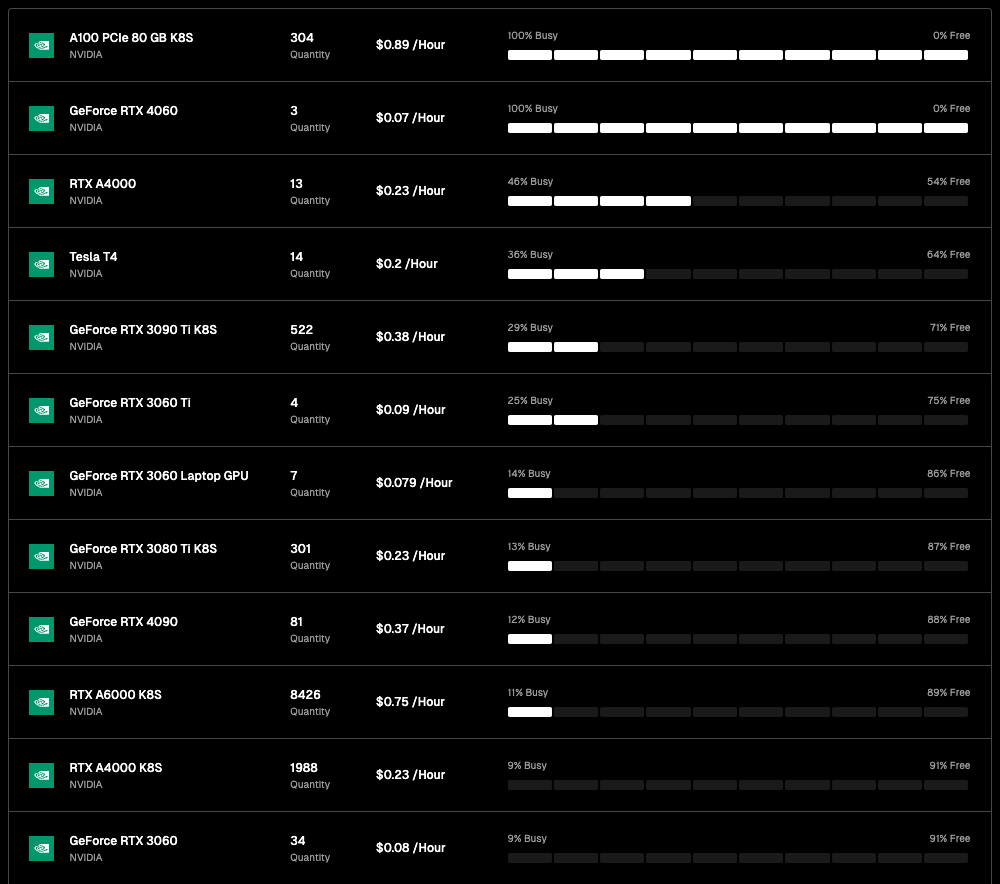

io.netエコシステムのGPU数は多いが、ほとんどが各クラウドベンダーとの提携および個人ノードからの接続によるものであり、稼働率は低い。最も多くのRTX A6000(8426枚)でも、使用中は11%(927枚)にとどまる。他の多くのGPUモデルはほとんど使われていない。ただし、現在のio.netの大きな利点は価格の安さにある。AkashのGPU利用コストが1時間1.5ドルであるのに対し、io.netでは0.1~1ドルの範囲で提供できる。

今後、io.netはIOエコシステム内のGPUプロバイダーがネイティブ資産をステークすることで利用機会を高める方針も検討している。投入資産が多いほど選ばれやすくなり、ステークしたAIエンジニアも高性能GPUを利用可能となる。

GPU接続規模において、io.netは本稿で紹介する10プロジェクト中最大である。稼働率を除けば、実際に使用中のGPU数も最多である。トークン経済面では、io.netネイティブトークンおよびプロトコルトークンIOは2024年第1四半期に上場予定。最大供給量は22,300,000枚。ネットワーク利用時に5%の手数料が発生し、この手数料はIOトークンのバーンまたは新規ユーザーへのインセンティブに充てられる。トークンモデルは明確な価格上昇特性を持っており、未発行ながらも市場の注目度は非常に高い。

Golem:CPU中心の計算力マーケット

Golemは分散型計算力マーケットであり、誰でも共有リソースのネットワークを構築することで、計算リソースの共有・集積が可能になる。Golemはユーザーに計算力レンタルの場を提供する。

Golemマーケットは三者から構成される:計算力供給者、計算力需要者、ソフトウェア開発者。需要者が計算タスクを提出すると、GolemネットワークがRAM、ディスク容量、CPUコア数などを提供する適切な供給者にタスクを分配。タスク完了後、両者はトークンで決済を行う。

Golemは主にCPUで計算力を積み上げており、費用面ではGPUよりも安価である(Intel i9 14900kは約700ドル、A100 GPUは12,000〜25,000ドル)。しかし、CPUは高並列処理が不可能で、エネルギー効率も悪い。そのため、CPUベースの計算力レンタルは、GPUプロジェクトと比べて物語(ナラティブ)としてはやや弱い可能性がある。

Magnet AI:AIモデルの資産化

Magnet AIはGPU計算力プロバイダーを統合し、さまざまなAIモデル開発者にモデルトレーニングサービスを提供する。他のAI+DePIN製品と異なる点は、Magnet AIが各AIチームが自らのモデルに基づいてERC-20トークンを発行できる点にある。ユーザーはモデルとのインタラクションを通じて、対応するモデルトークンのエアドロップや追加報酬を得られる。

2024年第2四半期に、Magnet AIはPolygon zkEVMおよびArbitrumに上線予定。

io.netと類似しており、どちらもGPU計算力を統合し、AIチームにモデルトレーニングサービスを提供している。

違いは、io.netがGPUリソースの統合に重点を置き、さまざまなGPUクラスタ、企業、個人がGPUを貢献してリターンを得ることを奨励する、つまり計算力主導であるのに対し、

Magnet AIはAIモデルそのものに重点を置いている。AIモデルトークンの存在により、トークンやエアドロップを通じたユーザー獲得・維持が可能になり、AIモデルの資産化を通じてAI開発者の参画を促進できる。

簡単に言えば、MagnetはGPUを使ってマーケットプレイスを構築し、あらゆるAI開発者やモデル展開者がERC-20トークンを発行でき、ユーザーは異なるトークンを取得したり、意図的に保有したりできる。

Render:グラフィックレンダリングAIモデルの専門家

Render Networkは、分散型GPUに基づくレンダリングソリューションプロバイダーであり、ブロックチェーン技術を通じてクリエイターと空きGPUリソースを結びつけ、ハードウェア制限を排除し、時間とコストを削減するとともに、デジタル著作権管理を提供し、メタバースの発展をさらに推進することを目指している。

Renderのホワイトペーパーによれば、Renderを活用することで、アーティスト、エンジニア、開発者はAI補助3Dコンテンツ生成、AI加速フルレンダリング、Renderの3Dシーングラフデータを使った関連AIモデルトレーニングなど、一連のAIアプリケーションを開発できる。

RenderはAI開発者にRender Network SDKを提供しており、開発者はRenderの分散型GPUを利用して、NeRF(ニューラル反射場)やLightFieldレンダリングプロセスから生成AIタスクまで、幅広いAI計算タスクを実行できる。

Global Market Insightsのレポートによると、世界の3Dレンダリング市場規模は60億ドルに達すると予測されている。一方、FDV22億ドルのRenderは依然として成長余地がある。

現在、RenderのGPUに関する具体的なデータは公表されていないが、Renderの背後にいるOTOY社が何度もApple社との関連を示唆していること、また業務範囲が広く、OTOYの旗艦レンダラーOctaneRenderはVFX、ゲーム、モーショングラフィックス、建築可視化、シミュレーション分野のすべての主要3Dツールをサポートしており、Unity3DやUnrealエンジンへのネイティブ対応も含まれている。

また、GoogleとMicrosoftもRNDRネットワークに参加している。Renderは2021年に約25万件のレンダリングリクエストを処理し、エコシステム内のアーティストはNFTを通じて約50億ドルの売上をあげた。

したがって、Renderの参考評価額は汎用レンダリング市場の潜在力(約300億ドル)と照らし合わせるべきである。BME(燃焼と鋳造のバランス)経済モデルも加味すれば、単純なトークン価格やFDVのいずれから見ても、Renderにはまだ上昇余地がある。

Clore.ai:ビデオレンダリング

Clore.aiはPoW基盤のGPU計算力レンタルサービスプラットフォームである。ユーザーは自分のGPUをAIトレーニング、ビデオレンダリング、暗号通貨マイニングなどに貸し出し、他者は低価格でその能力を利用できる。

業務範囲には、人工知能トレーニング、映画レンダリング、VPN、暗号通貨マイニングなどが含まれる。計算力サービスの需要があるときは、ネットワークが割り当てたタスクを実行。需要がないときは、ネットワークがその時点でマイニング収益率が最も高い暗号通貨を見つけ、マイニングに参加する。

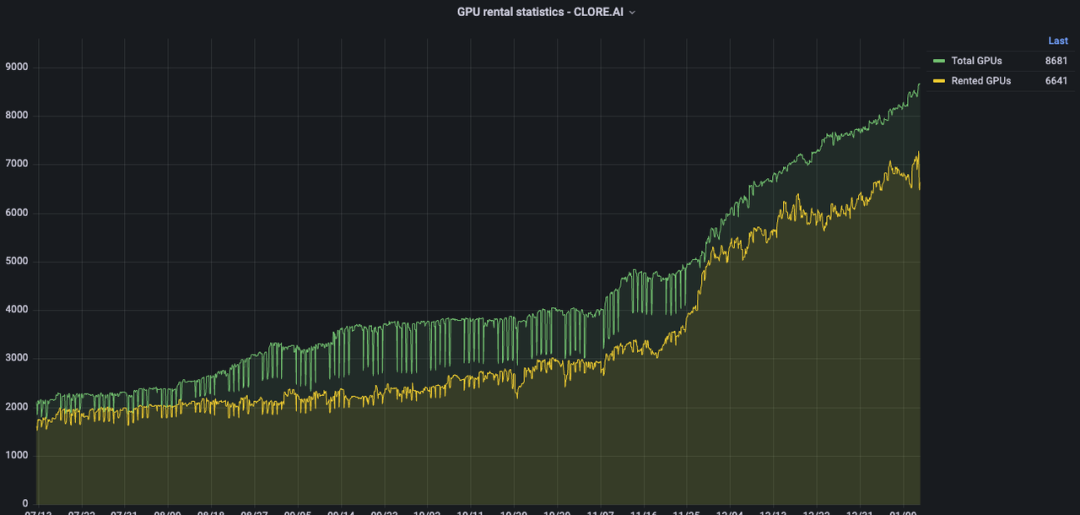

Clore.aiは過去半年間でGPU数を2000から約9000に増やし、GPU統合数ではAkashを上回った。しかし、二次市場のFDVはAkashの約20%しかない。

トークンモデルでは、CLOREはPOWマイニング方式を採用しており、プリマインやICOはなく、各ブロックの50%をマイナーに、40%をレンタル者に、10%をチームに分配する。

トークン総量は13億枚。2022年6月からマイニングを開始し、2042年までにほぼ全流通となる。現在の流通量は約2.2億枚。2023年末には約2.5億枚で、総供給量の20%。したがって、現在の実際のFDVは3100万ドル。理論的には、Clore.aiは深刻に過小評価されている状態にある。しかし、トークン経済上、マイナー配分比率が50%と高く、「掘って売る」圧力が大きいため、価格上昇には大きな抵抗がある。

Livepeer:ビデオレンダリング、推論

Livepeerはイーサリアム基盤の分散型ビデオプロトコルであり、適正価格で安全にビデオコンテンツを処理する当事者に報酬を与える。

公式によれば、Livepeerは毎週数千のGPUリソースで数百万分のビデオトランスコードを行っている。

Livepeerは将来的に「メインネット」+「サブネット」方式を採用し、各ノードオペレーターがサブネットを生成し、Livepeerメインネット上で支払いを確定することでタスクを実行する可能性がある。例えば、AIビデオサブネットを導入して、ビデオレンダリング分野のAIモデルトレーニングに特化する。

その後、LivepeerはAI関連部分を単なるモデルトレーニングから、推論およびファインチューニングへと拡大していく予定である。

Aethir:クラウドゲーミングとAIに特化

Aethirはクラウドゲーミングプラットフォームであり、ゲームおよび人工知能企業向けに構築された分散型クラウドインフラ(DCI)である。プレイヤーに代わって重いGPU計算負荷を処理することで、どこにいてもどんなデバイスでも超低遅延の体験を保証する。

同時に、AethirはGPU、CPU、ディスクなどの要素を含む展開サービスを提供している。2023年9月27日、Aethirは正式にグローバル顧客にクラウドゲーミングおよびAI計算力の商用サービスを提供開始。分散型計算力を統合することで、自社プラットフォームのゲームおよびAIモデルに計算力を提供している。

クラウドゲーミングは計算レンダリングの負荷をクラウドに移すことにより、端末デバイスのハードウェアおよびOSの制限を解消し、潜在的なプレイヤー層を大幅に拡大する。

2.2 帯域

帯域はDePINがAIに提供するリソースの一種であり、2021年の世界帯域市場規模は500億ドルを超え、2027年には千億ドル突破が予測されている。

AIモデルがますます増加し、より複雑化するにつれ、モデルトレーニングでは通常、データ並列、パイプライン並列、テンソル並列などの複数の並列計算戦略が採用される。このような並列計算モードでは、複数の計算デバイス間の集団通信操作の重要性が高まる。したがって、大規模AIモデルのトレーニングクラスタを構築する際、ネットワーク帯域の役割が際立ってくる。

さらに重要なのは、安定かつ十分な帯域

TechFlow公式コミュニティへようこそ

Telegram購読グループ:https://t.me/TechFlowDaily

Twitter公式アカウント:https://x.com/TechFlowPost

Twitter英語アカウント:https://x.com/BlockFlow_News