Pas étonnant que Buffett ait finalement misé sur Google

TechFlow SélectionTechFlow Sélection

Pas étonnant que Buffett ait finalement misé sur Google

Google contrôle toute la chaîne de bout en bout. Elle ne dépend pas de Nvidia et possède une souveraineté informatique efficace et à faible coût.

Auteur : Ma Leilei

Source : Wuxiaobo Channel CHANNELWU

Warren Buffett a un jour déclaré : « Ne jamais investir dans une entreprise que vous ne comprenez pas ». Pourtant, alors que l'ère du « gourou boursier » touche à sa fin, Buffett a pris une décision allant à l’encontre de cette règle familiale : acheter des actions Google, et ce avec une forte prime d’environ 40 fois les flux de trésorerie libres.

Oui, Buffett a pour la première fois investi dans une valeur liée à l’IA, mais ni dans OpenAI ni dans Nvidia. Tous les investisseurs se posent la même question : pourquoi Google ?

Revenons à la fin 2022. À cette époque, ChatGPT faisait son apparition, déclenchant une « alerte rouge » parmi les dirigeants de Google. Ils ont tenu de nombreuses réunions et ont même rappelé d’urgence leurs deux fondateurs. Mais Google semblait alors être un dinosaure lent et enlisé dans le bureaucratisme.

L’entreprise a précipitamment lancé le chatbot Bard, mais s’est rendue coupable d’erreurs factuelles lors de sa démonstration, provoquant une chute importante de son cours boursier et une perte de plus de mille milliards de dollars américains de capitalisation en un seul jour. Ensuite, elle a regroupé ses équipes IA pour lancer Gemini 1.5, un modèle multimodal.

Ce produit, considéré comme une arme fatale, n’a suscité qu’un bref engouement dans la sphère technologique avant d’être immédiatement éclipsé par Sora, le modèle de génération vidéo d’OpenAI, et rapidement tombé dans l’oubli.

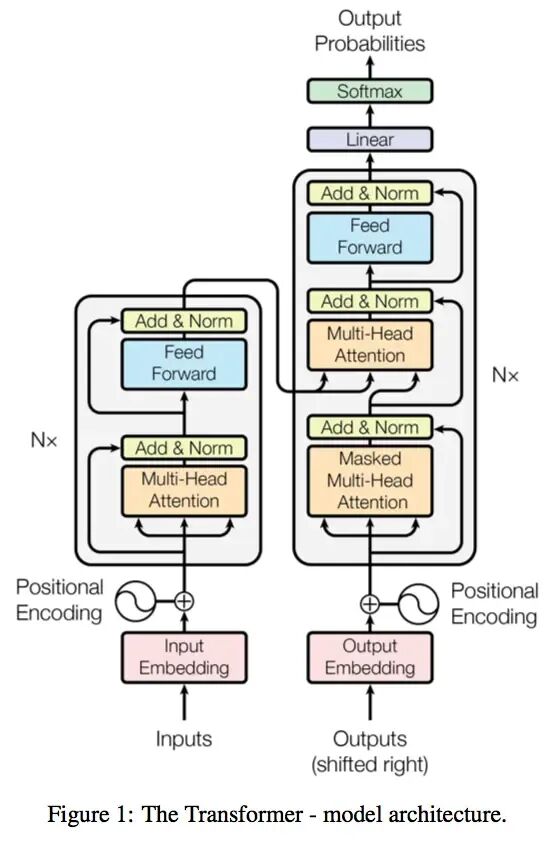

Ironiquement, ce sont justement les chercheurs de Google qui, en 2017, ont publié un article académique fondateur ayant jeté les bases théoriques solides de cette révolution de l’IA.

Article « Attention Is All You Need »

Modèle Transformer proposé

Ses rivaux moquent Google. Sam Altman, PDG d’OpenAI, critique ouvertement le goût de Google : « Je ne peux m’empêcher de penser aux différences esthétiques entre OpenAI et Google. »

L’ancien PDG de Google critique également la paresse de l’entreprise : « Google a toujours pensé que l’équilibre entre vie professionnelle et vie privée était plus important que de remporter la compétition. »

Cette série d’embarras a alimenté le doute sur le fait que Google aurait décroché dans la course à l’IA.

Mais le changement est arrivé. En novembre, Google a lancé Gemini 3, surpassant ses concurrents, y compris OpenAI, sur la plupart des indicateurs de référence. Plus crucial encore, Gemini 3 a été entièrement entraîné sur des puces TPU conçues en interne par Google, désormais positionnées comme une alternative économique aux GPU de Nvidia, et officiellement vendues à grande échelle à des clients extérieurs.

Google montre ses crocs sur deux fronts : avec la série Gemini 3 face à OpenAI sur le front logiciel, et avec ses puces TPU contre la domination historique de Nvidia sur le front matériel.

Pieds contre OpenAI, poings contre Nvidia.

Altman ressentait déjà la pression dès le mois dernier, affirmant dans un courrier interne que Google « pourrait nous apporter quelques vents économiques contraires temporaires ». Cette semaine, après avoir appris que de grands groupes achetaient des puces TPU, Nvidia a vu son action chuter de 7 % en séance, obligeant l’entreprise à publier un message rassurant pour calmer les marchés.

Le PDG de Google, Sundar Pichai, a déclaré dans un récent podcast que ses employés devraient rattraper leur sommeil. « D’un point de vue extérieur, nous avons peut-être paru silencieux ou en retard pendant un temps, mais en réalité, nous consolidions toutes nos briques fondamentales et avancions à plein régime. »

La situation s’est maintenant inversée. Pichai affirme : « Nous sommes arrivés à un point de bascule. »

C’est précisément trois ans après le lancement de ChatGPT. Ces trois années ont vu l’IA déclencher un festin de capitaux à Silicon Valley, marqué par alliances stratégiques et rivalités ; mais sous ce festin, les inquiétudes quant aux bulles spéculatives grandissent : l’industrie a-t-elle atteint un point de bascule ?

Inversion de tendance

Le 19 novembre, Google a publié son dernier modèle d’intelligence artificielle, Gemini 3.

Les données d’un test indiquent que Gemini 3 obtient des résultats nettement supérieurs à ceux des derniers modèles d’autres entreprises, y compris ChatGPT, dans presque tous les domaines testés — connaissances expertes, raisonnement logique, mathématiques et reconnaissance d’images. Il arrive seulement deuxième dans un seul test, celui des capacités de programmation.

Le Wall Street Journal écrit : « On pourrait l’appeler le prochain modèle phare américain. » Bloomberg affirme que Google s’est enfin réveillé. Musk et Altman l’ont tous deux salué. Certains internautes plaisantent en disant que c’est le GPT-5 dont Altman rêvait.

Le PDG de Box, plateforme de gestion de contenu cloud, après un accès anticipé à Gemini 3, a déclaré que l’amélioration des performances était si spectaculaire qu’ils ont douté de la validité de leur propre méthode d’évaluation. Mais après plusieurs tests répétés, le modèle a remporté tous les tests internes avec un avantage à deux chiffres.

Le PDG de Salesforce, utilisateur de ChatGPT depuis trois ans, affirme que Gemini 3 a bouleversé sa perception en seulement deux heures : « Putain… impossible de revenir en arrière. C’est un saut qualitatif total — inférence, vitesse, traitement texte-image-vidéo… tout est plus tranchant, plus rapide. On a l’impression que le monde bascule à nouveau. »

Gemini 3

Pourquoi Gemini 3 se distingue-t-il ainsi ? Que s’est-il passé chez Google ?

Le responsable du projet Gemini a posté : « Simple : amélioration de la préformation et de la post-formation. » Selon certaines analyses, la préformation du modèle suit toujours la logique de la loi d’échelle (Scaling Law) — en optimisant la préformation (données plus volumineuses, méthodes d’entraînement plus efficaces, plus de paramètres, etc.), les capacités du modèle progressent.

Celui qui veut le plus percer le secret de Gemini 3 est sans doute Altman.

Le mois dernier, avant la sortie de Gemini 3, il avait envoyé un message interne à ses employés pour les préparer : « Sur tous les plans, les travaux récents de Google sont excellents », surtout en préformation, les progrès réalisés pourraient « nous apporter quelques vents économiques contraires temporaires », et « l’ambiance extérieure sera difficile dans les mois à venir ».

Bien que ChatGPT conserve un avantage significatif sur Gemini en termes de volume d’utilisateurs, l’écart se réduit.

Au cours de ces trois années, le nombre d’utilisateurs de ChatGPT a augmenté rapidement. En février, son nombre hebdomadaire d’utilisateurs actifs était de 400 millions ; ce mois-ci, il atteint 800 millions. Pour Gemini, les chiffres publiés sont mensuels : en juillet, il comptait 450 millions d’utilisateurs mensuels actifs, et ce mois-ci, 650 millions.

Grâce à sa part d’environ 90 % du marché mondial de la recherche en ligne, Google dispose naturellement d’un canal clé pour promouvoir ses modèles d’IA, lui permettant d’atteindre directement une masse énorme d’utilisateurs.

OpenAI est actuellement valorisée à 5000 milliards de dollars, devenant ainsi la start-up la plus valorisée au monde. C’est aussi l’une des entreprises à croissance la plus rapide de l’histoire, passant d’un chiffre d’affaires quasi nul en 2022 à une estimation de 13 milliards de dollars cette année. Toutefois, elle prévoit de brûler plus de 100 milliards de dollars au cours des prochaines années pour atteindre l’intelligence artificielle générale, en plus de dépenser des centaines de milliards pour louer des serveurs. Autrement dit, elle devra continuer à lever des fonds.

Google possède un avantage non négligeable : des réserves financières plus importantes.

Le dernier rapport trimestriel de Google révèle un chiffre d’affaires dépassant pour la première fois les 100 milliards de dollars, atteignant 102,3 milliards, en hausse de 16 %, avec un bénéfice de 35 milliards, en progression de 33 %. Son flux de trésorerie libre s’élève à 73 milliards de dollars, et ses dépenses en capital liées à l’IA atteindront 90 milliards de dollars cette année.

Il n’a pas non plus à craindre pour le moment que son activité de recherche soit érodée par l’IA : recherche et publicité affichent encore une croissance à deux chiffres. Son activité cloud progresse bien, au point qu’OpenAI loue ses serveurs.

En plus de ses flux de trésorerie générés en interne, Google détient des atouts inaccessibles à OpenAI, notamment des données massives prêtes à l’emploi pour entraîner et optimiser ses modèles, ainsi qu’une infrastructure informatique autonome.

Le 14 novembre, Google annonce un investissement de 40 milliards de dollars dans de nouveaux centres de données

OpenAI, habile dans ses partenariats, a signé des accords de calcul à hauteur de plus de mille milliards de dollars. Ainsi, alors que Google approche rapidement avec Gemini, les investisseurs s’interrogent davantage : le gâteau de croissance promis par OpenAI suffira-t-il à combler le déficit ?

Fissures

Il y a un mois, la capitalisation boursière de Nvidia franchissait les 5000 milliards de dollars. L’enthousiasme du marché pour l’intelligence artificielle a propulsé ce « fournisseur d’armes de l’IA » vers de nouveaux sommets. Pourtant, les puces TPU utilisées par Google Gemini 3 ont ouvert une fissure dans la forteresse bien établie de Nvidia.

D’après des données citées par The Economist provenant de la société de recherche Bernstein, les GPU de Nvidia représentent plus des deux tiers du coût total d’un rack typique de serveurs IA. En comparaison, les puces TPU de Google coûtent entre 10 % et 50 % du prix de puces Nvidia de performance équivalente. Ces économies cumulées sont considérables. La banque d’investissement Jefferies estime que Google produira environ 3 millions de ces puces l’année prochaine, soit près de la moitié de la production de Nvidia.

Le mois dernier, la célèbre startup IA Anthropic a prévu d’adopter massivement les puces TPU de Google, avec un accord potentiellement évalué à des centaines de milliards de dollars. Un rapport du 25 novembre indique que le géant technologique Meta est également en discussions pour intégrer les puces TPU dans ses centres de données d’ici 2027, dans un accord pouvant atteindre plusieurs dizaines de milliards de dollars.

Le PDG de Google, Sundar Pichai, présente la puce TPU

Les grands groupes internet de la Silicon Valley misent tous sur les puces, soit en développant les leurs, soit en collaborant avec des fabricants. Mais aucune autre entreprise n’a fait autant de progrès que Google.

L’histoire des TPU remonte à plus de dix ans. À l’époque, Google cherchait à améliorer l’efficacité de ses services de recherche, cartographie et traduction, et a commencé à concevoir une puce accélérateur spécialisée pour un usage interne. Depuis 2018, elle vend ses TPU aux clients du cloud.

Par la suite, les TPU ont également servi à soutenir le développement interne de l’IA chez Google. Pendant la conception de modèles comme Gemini, les équipes IA et celles des puces ont collaboré étroitement : les premières fournissaient besoins concrets et retours d’expérience, tandis que les secondes adaptaient et optimisaient les TPU en conséquence, renforçant ainsi l’efficacité du développement IA.

Actuellement, Nvidia domine plus de 90 % du marché des puces IA. Ses GPU, initialement conçus pour rendre les images de jeux vidéo de manière réaliste, exploitent des milliers de cœurs de calcul capables de traiter des tâches en parallèle, une architecture qui les place largement en tête dans le domaine de l’IA.

À l’inverse, les TPU de Google sont des circuits intégrés spécifiques (ASIC), des « spécialistes », conçus exclusivement pour des tâches de calcul particulières. En sacrifiant une certaine flexibilité et polyvalence, ils offrent une meilleure efficacité énergétique. Les GPU de Nvidia sont plutôt des « généralistes », très flexibles et programmables, mais au prix d’un coût élevé.

Toutefois, à ce stade, aucune entreprise, y compris Google, ne peut remplacer complètement Nvidia. Bien que les TPU soient à leur septième génération, Google reste un grand client de Nvidia. Une raison évidente : son activité cloud doit servir des dizaines de milliers de clients mondiaux, et utiliser la puissance de calcul des GPU garantit l’attractivité auprès de ces clients.

Même les entreprises achetant des TPU doivent embrasser Nvidia. Peu après avoir annoncé sa collaboration avec les TPU de Google, Anthropic a conclu un nouvel accord majeur avec Nvidia.

Le Wall Street Journal affirme : « Investisseurs, analystes et opérateurs de centres de données déclarent que les TPU de Google constituent l’une des menaces les plus sérieuses contre la domination de Nvidia sur le marché du calcul IA. Mais pour contester Nvidia, Google doit commencer à vendre ces puces plus largement à des clients externes. »

Les puces IA de Google deviennent l’une des rares alternatives aux puces Nvidia, ce qui a directement fait baisser le cours de l’action de Nvidia. Ce dernier a dû publier un message pour calmer la panique suscitée par les TPU. Il se dit « heureux des succès de Google », mais insiste sur son avance d’une génération sur l’industrie, soulignant que son matériel est plus universel que les TPU et autres puces spécialisées.

La pression supplémentaire sur Nvidia vient des craintes de bulle spéculative : les investisseurs redoutent un décalage entre les investissements massifs et les perspectives de profit. L’humeur des marchés oscille constamment : tantôt on craint que les activités de Nvidia soient concurrencées, tantôt on s’inquiète que les puces IA ne se vendent pas.

Michael Burry, célèbre « short-seller » américain, affirme avoir parié plus d’un milliard de dollars à la baisse sur Nvidia et d’autres entreprises technologiques. Connu pour avoir anticipé la crise immobilière américaine en 2008, son histoire a inspiré le film à succès The Big Short. Il compare l’engouement actuel pour l’IA à la bulle Internet du début des années 2000.

Michael Burry

Nvidia a distribué aux analystes un document de sept pages réfutant les critiques de Burry et autres. Ce document n’a toutefois pas calmé la controverse.

Modèle

Google traverse une période heureuse, son cours de bourse grimpant à contre-courant de la bulle IA. La société de Buffett a acheté ses actions au troisième trimestre, Gemini 3 reçoit un accueil favorable, et les puces TPU enthousiasment les investisseurs, tout cela portant Google vers des sommets.

Au cours du dernier mois, les valeurs technologiques liées à l’IA comme Nvidia et Microsoft ont perdu plus de 10 %, tandis que le cours de Google a grimpé d’environ 16 %. Avec une capitalisation boursière de 3,86 billions de dollars, il se classe désormais troisième mondial, juste derrière Nvidia et Apple.

Les analystes qualifient le modèle d’intelligence artificielle de Google d’intégration verticale.

Joueur rare dans la tech à maîtriser toute la chaîne en interne, Google contrôle chaque maillon : ses puces TPU maison sont déployées sur Google Cloud pour entraîner ses propres grands modèles d’IA, qui s’intègrent ensuite sans friction dans des services clés comme la recherche et YouTube. L’avantage de ce modèle est évident : pas de dépendance à Nvidia, souveraineté en matière de calcul efficace et à faible coût.

L’autre modèle, plus courant, est celui de l’alliance lâche. Chaque géant joue son rôle : Nvidia fournit les GPU, OpenAI et Anthropic développent les modèles d’IA, les géants du cloud comme Microsoft achètent les GPU des fabricants pour héberger les modèles de ces laboratoires IA. Dans ce réseau, il n’y a ni allié ni ennemi absolu : coopération quand c’est utile, confrontation quand nécessaire.

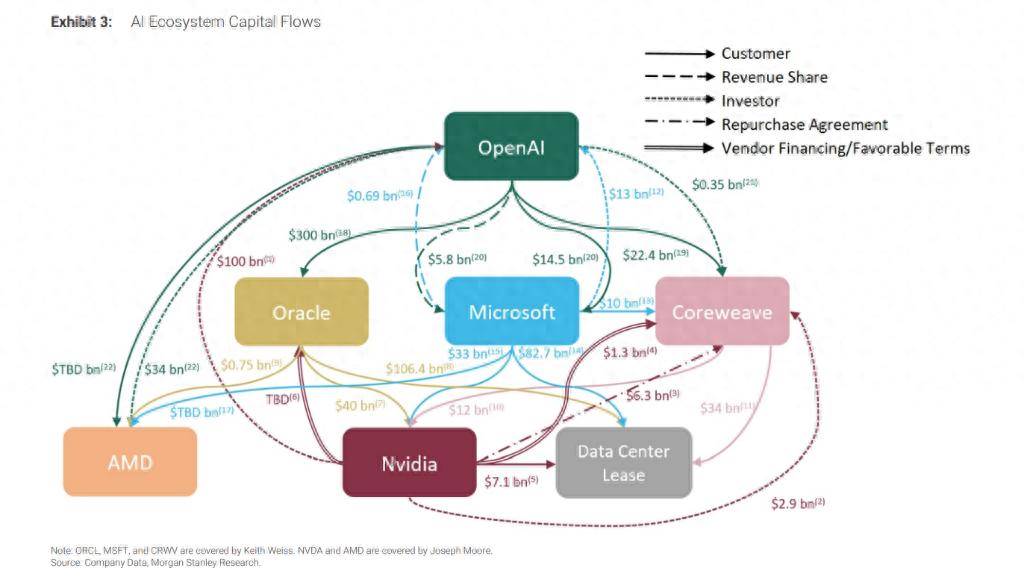

Les acteurs ont créé une « structure circulaire », où les capitaux circulent en boucle fermée entre quelques grandes entreprises technologiques.

Généralement, le mécanisme fonctionne ainsi : une entreprise A verse une somme à une entreprise B (investissement, prêt ou location), puis B utilise cet argent pour acheter des produits ou services à A. Sans cette « mise de départ », B ne pourrait probablement pas effectuer l’achat.

Par exemple, OpenAI engage 300 milliards de dollars auprès d’Oracle pour du pouvoir de calcul, Oracle utilise cet argent pour acheter des puces Nvidia afin de construire des centres de données, et Nvidia réinvestit jusqu’à 100 milliards de dollars dans OpenAI — à condition que celle-ci continue à utiliser ses puces. (OpenAI paie 300 milliards à Oracle → Oracle utilise cet argent pour acheter des puces Nvidia → Nvidia utilise les profits pour réinvestir dans OpenAI.)

Ces cas ont donné naissance à des cartographies financières labyrinthiques. Dans un rapport du 8 octobre, un analyste de Morgan Stanley a publié une image illustrant les flux de capitaux dans l’écosystème IA de la Silicon Valley. Il met en garde : le manque de transparence rend difficile pour les investisseurs d’évaluer les risques et rendements réels.

Le Wall Street Journal commente cette image : « Les flèches qui les relient ressemblent à un plat de spaghettis emmêlés. »

Sous l’impulsion du capital, la silhouette de la bête immense attend de prendre forme, personne ne connaît encore son vrai visage. Certains paniquent, d’autres s’émerveillent.

Bienvenue dans la communauté officielle TechFlow

Groupe Telegram :https://t.me/TechFlowDaily

Compte Twitter officiel :https://x.com/TechFlowPost

Compte Twitter anglais :https://x.com/BlockFlow_News