IOSG | Réflexion sur l'industrie de la robotique : convergence et évolution de l'automatisation, de l'intelligence artificielle et de Web3

TechFlow SélectionTechFlow Sélection

IOSG | Réflexion sur l'industrie de la robotique : convergence et évolution de l'automatisation, de l'intelligence artificielle et de Web3

Le point de convergence entre robots, IA et Web3 représente toujours l'origine du prochain système économique intelligent.

Auteur : Jacob Zhao @IOSG

Panorama des robots : de l'automatisation industrielle à l'intelligence humanoïde

La chaîne industrielle traditionnelle des robots s'est structurée selon une hiérarchie ascendante complète, comprenant quatre grands segments : composants clés – systèmes de contrôle intermédiaires – fabrication intégrale – intégration d'applications. Les composants clés (contrôleurs, servomoteurs, réducteurs, capteurs, batteries, etc.) présentent les barrières technologiques les plus élevées et déterminent la performance minimale et le coût des machines finales ; les systèmes de contrôle constituent le « cerveau et petit cerveau » du robot, chargés de la prise de décision, de la planification et du contrôle moteur ; la fabrication intégrale reflète la capacité d'intégration de la chaîne logistique. L'intégration système et les applications, qui déterminent la profondeur de la commercialisation, deviennent progressivement un nouveau centre de valeur.

Selon les scénarios et formes d’application, les robots mondiaux évoluent selon un chemin allant de « l’automatisation industrielle → l’intelligence par scénario → l’intelligence générale », se divisant en cinq catégories principales : robots industriels, robots mobiles, robots de service, robots spéciaux et robots humanoïdes.

#Robots industriels (Industrial Robots)

C’est actuellement le seul domaine pleinement mature, largement utilisé dans les processus de fabrication tels que le soudage, l’assemblage, la peinture et le transport. L’industrie a mis en place un système d’approvisionnement standardisé, avec des marges stables et un ROI bien défini. Parmi ceux-ci, les robots collaboratifs (Cobots) mettent l’accent sur la collaboration homme-machine, sont légers et faciles à déployer, et connaissent la croissance la plus rapide.

Entreprises représentatives : ABB, Fanuc, Yaskawa, KUKA, Universal Robots, Jaka, Aubo.

#Robots mobiles (Mobile Robots)

Incluent les AGV (véhicules guidés automatiques) et AMR (robots mobiles autonomes), massivement déployés dans la logistique, l’entreposage, la livraison e-commerce et le transport industriel. Ils sont devenus la catégorie la plus mature pour les clients B.

Entreprises représentatives : Amazon Robotics, Geek+, Quicktron, Locus Robotics.

#Robots de service (Service Robots)

Destinés aux secteurs de nettoyage, restauration, hôtellerie et éducation, ils constituent le domaine à la croissance la plus rapide côté consommateur. Les produits de nettoyage suivent désormais la logique des produits électroniques grand public, tandis que les applications médicales et les livraisons commerciales accélèrent leur commercialisation. Par ailleurs, une nouvelle vague de robots manipulateurs plus généralistes émerge (comme le système à deux bras de Dyna) — plus flexibles que les produits spécialisés, mais encore loin de l’universalité des robots humanoïdes.

Entreprises représentatives : Ecovacs, Roborock, PuduTech, Enway, iRobot, Dyna, etc.

#Robots spéciaux (Special Robots)

Principalement destinés aux domaines médicaux, militaires, de construction, marins et spatiaux. Le marché est limité mais présente des marges élevées et de fortes barrières technologiques. Dépendant principalement de commandes gouvernementales ou d’entreprises, ces robots se développent dans des niches verticales. Des projets emblématiques incluent Intuitive Surgical, Boston Dynamics, ANYbotics, NASA Valkyrie, etc.

#Robots humanoïdes (Humanoid Robots)

Considérés comme la future « plateforme de main-d’œuvre universelle ».

Entreprises représentatives : Tesla (Optimus), Figure AI (Figure 01), Sanctuary AI (Phoenix), Agility Robotics (Digit), Apptronik (Apollo), 1X Robotics, Neura Robotics, Unitree, UBTECH, Zhiyuan Robotics, etc.

Les robots humanoïdes sont actuellement la direction la plus surveillée en matière de technologies avancées. Leur valeur centrale réside dans leur forme humaine, compatible avec les espaces sociaux existants, ce qui en fait la forme clé vers une « plateforme de main-d’œuvre universelle ». Contrairement aux robots industriels axés sur l’efficacité maximale, les robots humanoïdes privilégient l’adaptabilité générale et la capacité de transfert de tâches, pouvant pénétrer usines, foyers et espaces publics sans nécessiter de modification de l’environnement.

Actuellement, la plupart des robots humanoïdes restent au stade de démonstration technique, validant principalement leurs capacités d’équilibre dynamique, de marche et de manipulation. Bien que certains projets aient commencé un déploiement à petite échelle dans des environnements très contrôlés (ex : Figure × BMW, Agility Digit), et que davantage de fabricants (comme 1X) devraient entrer en phase de distribution précoce à partir de 2026, ces applications restent limitées à des « scénarios étroits, tâches uniques », loin d’une véritable mise en œuvre comme main-d’œuvre universelle. Globalement, plusieurs années seront encore nécessaires avant une commercialisation à grande échelle. Les principaux obstacles incluent : les difficultés de coordination à multiples degrés de liberté et d’équilibre dynamique en temps réel ; les problèmes d’autonomie et de consommation liés à la densité énergétique des batteries et à l’efficacité des actionneurs ; les chaînes perception–décision instables et peu généralisables dans des environnements ouverts ; un manque significatif de données (insuffisantes pour entraîner des stratégies générales) ; le transfert inter-corporel non résolu ; ainsi que des contraintes persistantes dans la chaîne logistique matérielle et la courbe des coûts (en particulier en dehors de Chine), rendant encore plus difficile un déploiement à grande échelle et faible coût.

Le parcours commercial futur devrait passer par trois phases : à court terme, dominé par le modèle Demo-as-a-Service, dépendant de pilotes et subventions ; à moyen terme, évoluant vers Robotics-as-a-Service (RaaS), construisant un écosystème de tâches et de compétences ; à long terme, centré sur le cloud de main-d’œuvre et les services intelligents par abonnement, déplaçant la valeur principale de la fabrication matérielle vers les logiciels et les réseaux de services. Dans l’ensemble, les robots humanoïdes traversent une période de transition cruciale, passant de la démonstration à l’apprentissage autonome. Leur capacité à franchir les seuils du contrôle, du coût et des algorithmes déterminera s’ils peuvent vraiment réaliser l’intelligence incarnée.

IA × Robots : l’aube de l’ère de l’intelligence incarnée

L’automatisation traditionnelle repose principalement sur des programmes prédéfinis et un contrôle en chaîne (comme l’architecture DSOP perception-planification-contrôle), ne fonctionnant de manière fiable que dans des environnements structurés. Or, le monde réel est beaucoup plus complexe et changeant. La nouvelle génération d’intelligence incarnée (Embodied AI) suit une autre approche : grâce aux grands modèles et à l’apprentissage par représentation unifiée, les robots acquièrent une capacité de « compréhension–prédiction–action » transversale aux scénarios. L’intelligence incarnée insiste sur le couplage dynamique entre le corps (matériel), le cerveau (modèle) et l’environnement (interaction). Le robot n’est qu’un support ; l’intelligence est au cœur.

L’intelligence générative (Generative AI) appartient à l’intelligence du monde du langage, excellente pour comprendre les symboles et la sémantique ; l’intelligence incarnée (Embodied AI) appartient à l’intelligence du monde réel, maîtrisant la perception et l’action. Elles correspondent respectivement au « cerveau » et au « corps », représentant deux grandes lignes parallèles de l’évolution de l’IA. Sur le plan hiérarchique, l’intelligence incarnée est plus avancée que l’intelligence générative, mais son niveau de maturité reste nettement inférieur. Les LLM s’appuient sur d’immenses corpus linguistiques issus d’Internet, formant une boucle claire « données → puissance de calcul → déploiement » ; en revanche, l’intelligence robotique nécessite des données multivues, multimodales, étroitement liées aux actions — telles que les trajectoires de téléopération, vidéos en première personne, cartes spatiales, séquences d’opérations, etc. Ces données n’existent pas naturellement et doivent être générées par interaction réelle ou simulation haute fidélité, ce qui les rend plus rares et coûteuses. Bien que les données simulées ou synthétiques soient utiles, elles ne peuvent remplacer l’expérience sensorielle et motrice réelle, expliquant pourquoi Tesla, Figure, etc., doivent construire leurs propres usines de données de téléopération, et pourquoi des ateliers tiers de labellisation apparaissent en Asie du Sud-Est. En résumé : les LLM apprennent à partir de données existantes, tandis que les robots doivent « créer » des données en interagissant avec le monde physique. D’ici les 5 à 10 prochaines années, les deux convergeront profondément autour des modèles Vision–Langue–Action et des architectures d’Agent Incarné — les LLM géreront la cognition de haut niveau et la planification, les robots exécuteront dans le monde réel, formant une boucle bidirectionnelle entre données et actions, poussant ensemble l’IA du « langage intelligent » vers une intelligence générale réelle (AGI).

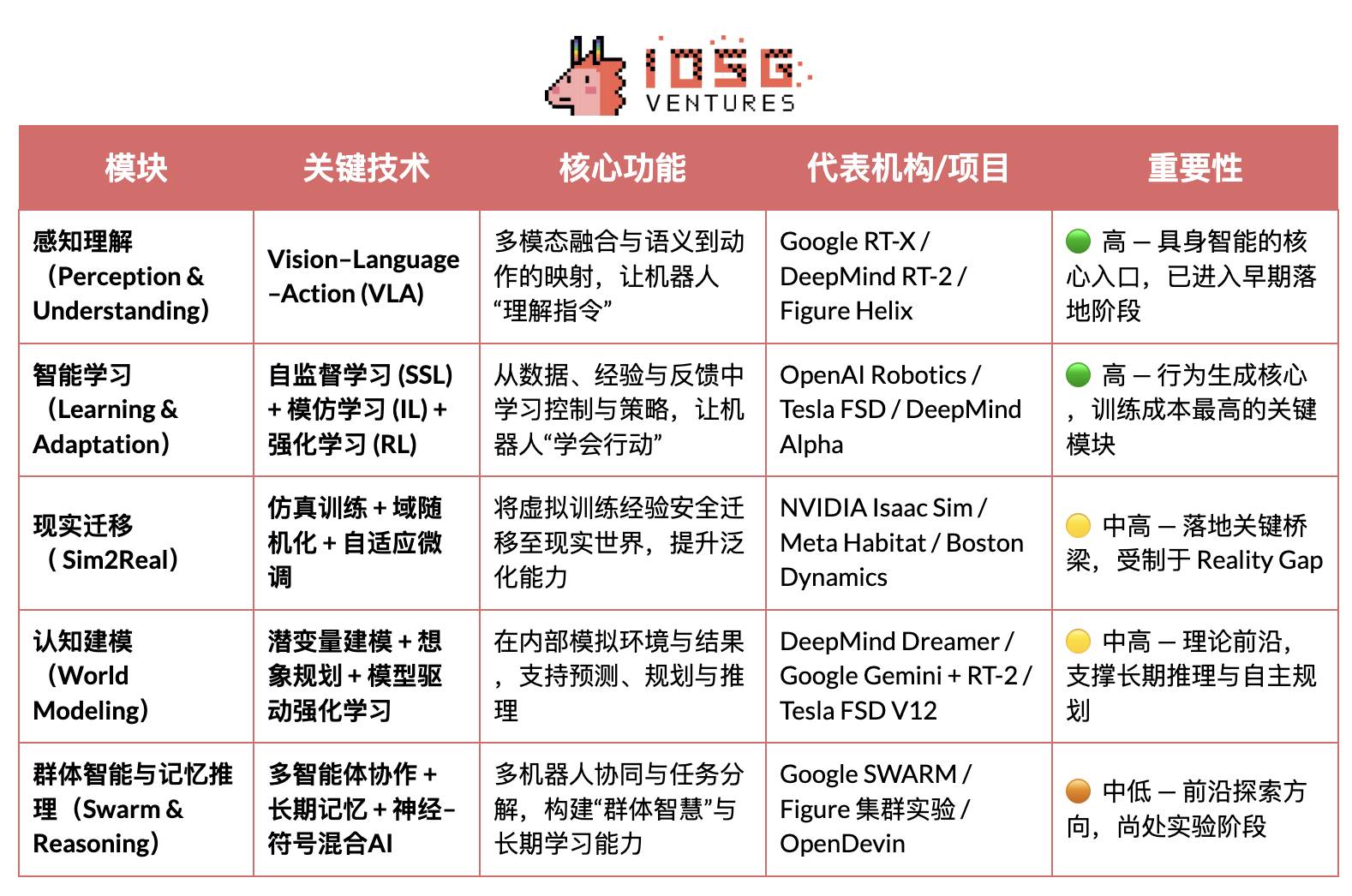

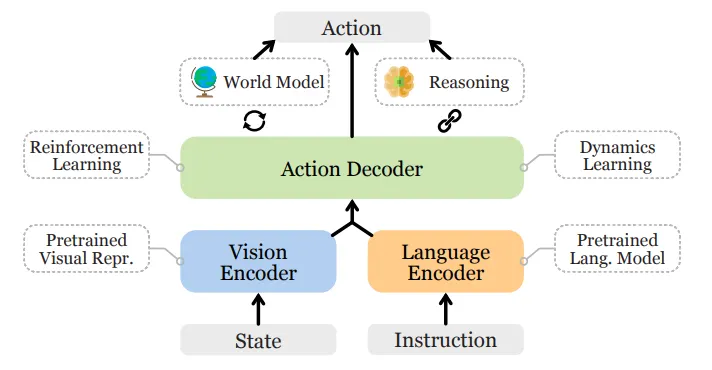

Le système technologique central de l’intelligence incarnée peut être vu comme une pile intelligente ascendante : VLA (fusion sensorielle), RL/IL/SSL (apprentissage intelligent), Sim2Real (transfert vers le réel), World Model (modélisation cognitive), et collaboration multi-agents avec mémoire et raisonnement (Swarm & Reasoning). Parmi eux, VLA et RL/IL/SSL sont les « moteurs » de l’intelligence incarnée, déterminant sa mise en œuvre et sa commercialisation ; Sim2Real et World Model sont les technologies clés reliant l’entraînement virtuel à l’exécution réelle ; la collaboration multi-agents et le raisonnement mémoire représentent une évolution cognitive de groupe et métacognitive plus avancée.

Perception et compréhension : modèles Vision–Langue–Action

Les modèles VLA intègrent trois canaux — vision, langage et action — permettant aux robots de comprendre l’intention humaine exprimée par le langage et de la traduire en actions concrètes. Leur flux d’exécution inclut l’analyse sémantique, l’identification des objectifs (localisation des objets visuels) et la planification du chemin avec exécution, réalisant ainsi une boucle fermée de « compréhension sémantique → perception du monde → accomplissement de tâche », constituant l’une des percées clés de l’intelligence incarnée. Les projets actuels incluent Google RT-X, Meta Ego-Exo et Figure Helix, illustrant des directions avancées telles que la compréhension multimodale, la perception immersive et le contrôle piloté par le langage.

Actuellement, VLA en est encore au stade précoce, confronté à quatre types de limitations fondamentales :

-

Ambiguïté sémantique et faible généralisation des tâches : les modèles ont du mal à comprendre des instructions floues ou ouvertes ;

-

Décalage instable entre vision et action : les erreurs de perception s’amplifient lors de la planification et de l’exécution ;

-

Données multimodales rares et normes non uniformes : coûts élevés de collecte et d’annotation, impossibilité de former une boucle de données à grande échelle ;

-

Défis temporels et spatiaux pour les tâches longues : une durée excessive affaiblit la planification et la mémoire, tandis qu’une grande portée spatiale exige du modèle qu’il raisonne sur des éléments « hors champ », or les VLA actuels manquent de modèles mondiaux stables et de capacités de raisonnement spatial croisé.

Ensemble, ces problèmes limitent la capacité de généralisation transversale et le déploiement à grande échelle des VLA.

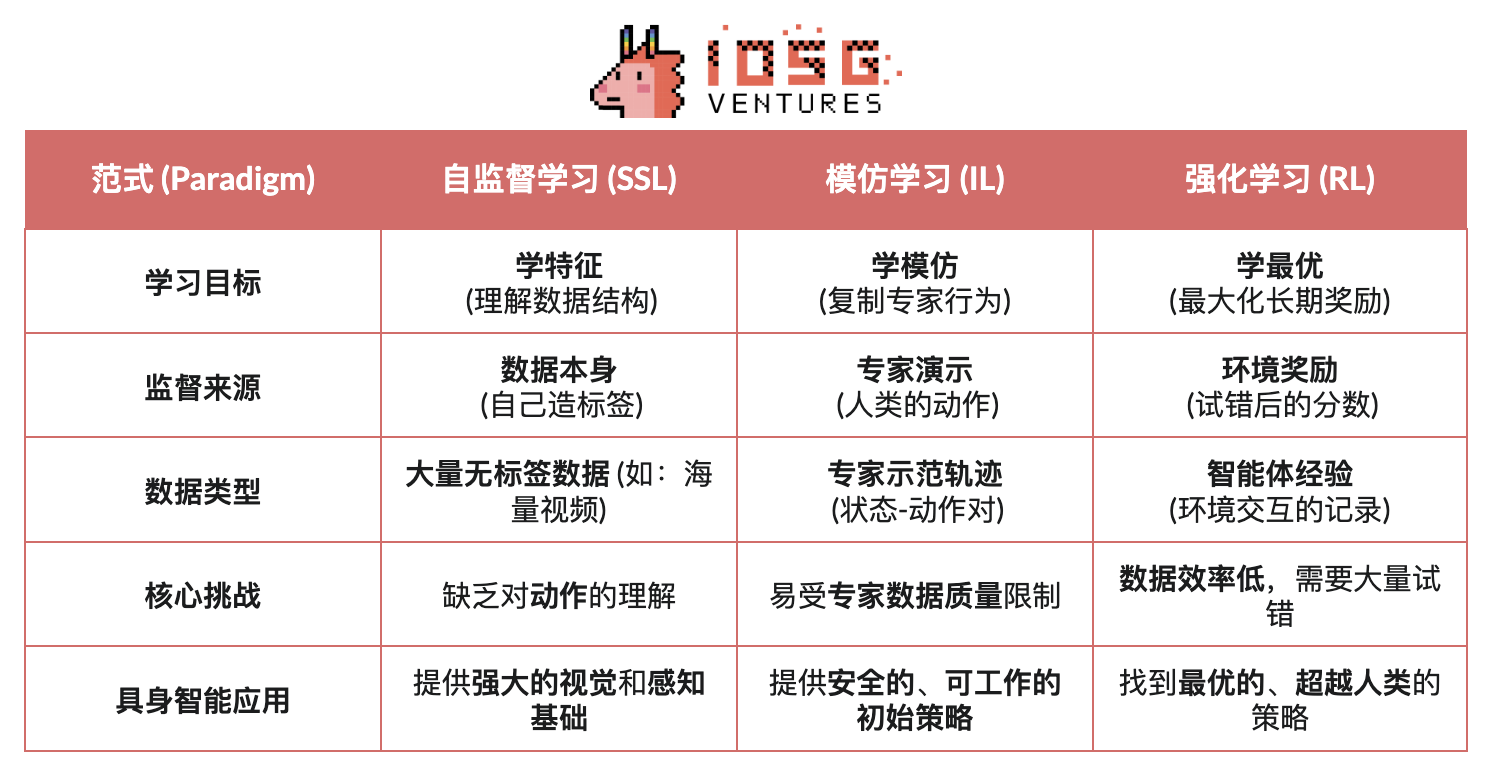

Apprentissage intelligent : apprentissage auto-supervisé (SSL), apprentissage par imitation (IL) et apprentissage par renforcement (RL)

-

Apprentissage auto-supervisé (Self-Supervised Learning) : extrait automatiquement des caractéristiques sémantiques à partir des données sensorielles, permettant au robot de « comprendre le monde ». Équivaut à enseigner à la machine à observer et représenter.

-

Apprentissage par imitation (Imitation Learning) : acquiert rapidement des compétences de base en imitant des démonstrations humaines ou des exemples d’experts. Équivaut à apprendre à la machine à agir comme un humain.

-

Apprentissage par renforcement (Reinforcement Learning) : optimise les stratégies d’action par mécanisme de « récompense-punition », via essais et erreurs continus. Équivaut à apprendre à la machine à progresser par essais.

Dans l’IA incarnée (Embodied AI), l’apprentissage auto-supervisé (SSL) vise à faire comprendre aux robots les changements d’état et les lois physiques à partir des données sensorielles, afin de saisir la structure causale du monde ; l’apprentissage par renforcement (RL) est le moteur central de formation de l’intelligence, conduisant les robots à maîtriser des comportements complexes (marcher, saisir, éviter les obstacles) par interaction avec l’environnement et optimisation basée sur des signaux de récompense ; l’apprentissage par imitation (IL) accélère ce processus en fournissant des démonstrations humaines, donnant rapidement des a priori d’action au robot. La tendance actuelle combine les trois pour créer un cadre d’apprentissage hiérarchique : SSL fournit la base de représentation, IL apporte les a priori humains, RL conduit l’optimisation des politiques, équilibrant efficacité et stabilité, formant ensemble le mécanisme central de passage de la compréhension à l’action.

Transfert vers le réel : Sim2Real — franchir le fossé entre simulation et réalité

Sim2Real (Simulation to Reality) permet d’entraîner les robots dans des environnements virtuels puis de transférer ces compétences dans le monde réel. Grâce à des environnements de simulation haute fidélité (comme NVIDIA Isaac Sim & Omniverse, DeepMind MuJoCo), il génère d’immenses volumes de données interactives, réduisant considérablement les coûts d’entraînement et l’usure matérielle. Son cœur réside dans la réduction du « fossé simulation-réalité », par des méthodes telles que :

-

Randomisation de domaine (Domain Randomization) : ajustement aléatoire de paramètres comme lumière, friction, bruit dans la simulation, améliorant la généralisation du modèle ;

-

Calibration de cohérence physique : utilisation de données réelles de capteurs pour corriger le moteur de simulation, augmentant le réalisme physique ;

-

Ajustement fin adaptatif (Adaptive Fine-tuning) : réentraînement rapide dans l’environnement réel pour assurer un transfert stable.

Sim2Real est l’élément central du déploiement de l’intelligence incarnée, permettant aux modèles IA d’apprendre la boucle fermée « perception–décision–contrôle » dans un monde virtuel sûr et peu coûteux. Bien que Sim2Real soit mature pour l’entraînement en simulation (ex : NVIDIA Isaac Sim, MuJoCo), le transfert vers le réel reste limité par le fossé de réalité, la forte demande en puissance de calcul, les coûts d’annotation, et une généralisation et sécurité insuffisantes en environnement ouvert. Malgré cela, Simulation-as-a-Service (SimaaS) devient une infrastructure stratégique essentielle, bien que légère, dans l’ère de l’intelligence incarnée, avec des modèles économiques incluant l’abonnement (PaaS), la génération de données (DaaS) et la validation de sécurité (VaaS).

Modélisation cognitive : World Model — le « monde intérieur » du robot

Le modèle du monde (World Model) est le « cerveau interne » de l’intelligence incarnée, permettant au robot de simuler l’environnement et les conséquences de ses actions, réalisant ainsi prédiction et raisonnement. En apprenant les lois dynamiques de l’environnement, il construit une représentation interne prédictive, transformant l’agent passif en décideur actif capable de « répéter mentalement » avant d’agir. Des projets notables incluent DeepMind Dreamer, Google Gemini + RT-2, Tesla FSD V12, NVIDIA WorldSim, etc. Les voies technologiques typiques incluent :

-

Modélisation de dynamique latente (Latent Dynamics Modeling) : compression des perceptions hautes dimensions vers un espace d’état latent ;

-

Entraînement par imagination prédictive (Imagination-based Planning) : essais virtuels et prévisions de trajectoire dans le modèle ;

-

Apprentissage par renforcement piloté par modèle (Model-based RL) : remplacement de l’environnement réel par le modèle du monde, réduisant les coûts d’entraînement.

Le World Model se situe à la pointe théorique de l’intelligence incarnée, étant la voie clé pour passer d’une intelligence « réactive » à une intelligence « prédictive », mais reste freiné par la complexité de modélisation, l’instabilité des prédictions long terme et l’absence de standards unifiés.

Intelligence collective et raisonnement : du geste individuel à la cognition collaborative

La collaboration multi-agents (Multi-Agent Systems) et le raisonnement avec mémoire (Memory & Reasoning) représentent deux directions importantes de l’évolution de l’intelligence incarnée, passant de « l’intelligence individuelle » à « l’intelligence collective » et « l’intelligence cognitive ». Ensemble, ils soutiennent les capacités d’apprentissage collaboratif et d’adaptation à long terme des systèmes intelligents.

#Collaboration multi-agents (Swarm / Cooperative RL) :

Désigne plusieurs agents intelligents coopérant dans un environnement partagé via un apprentissage par renforcement distribué ou collaboratif, prenant des décisions conjointes et répartissant les tâches. Cette direction repose sur des bases solides de recherche, comme l’expérience OpenAI Hide-and-Seek qui montre l’émergence spontanée de coopération et de stratégies, ou les algorithmes DeepMind QMIX et MADDPG qui offrent un cadre d’entraînement centralisé et d’exécution décentralisée. Ces méthodes ont déjà été validées dans des cas comme la gestion de robots d’entrepôt, les inspections et le contrôle de groupes.

#Mémoire et raisonnement (Memory & Reasoning)

Se concentre sur doter les agents de capacités de mémoire à long terme, de compréhension contextuelle et de raisonnement causal, clés pour le transfert de tâches et l’auto-planification. Des recherches notables incluent DeepMind Gato (agent multitâche unifiant perception-langage-contrôle), la série DeepMind Dreamer (planification imaginative basée sur un modèle du monde), et Voyager, un agent incarné ouvert qui apprend continuellement via mémoire externe et auto-évolution. Ces systèmes posent les bases pour que les robots « se souviennent du passé, anticipent l’avenir ».

Paysage industriel mondial de l’intelligence incarnée : coopération et concurrence

L’industrie robotique mondiale traverse une période de « coopération dominante, concurrence approfondie ». L’efficacité de la chaîne logistique chinoise, les capacités d’IA américaines, la précision des composants japonais et les standards industriels européens façonnent ensemble le paysage à long terme de cette industrie.

-

Les États-Unis conservent une avance dans les modèles IA et logiciels de pointe (DeepMind, OpenAI, NVIDIA), mais cet avantage ne s’étend pas au matériel robotique. Les fabricants chinois surpassent en rapidité d’itération et performance réelle. Les États-Unis cherchent à recentraliser l’industrie via le CHIPS Act et l’Inflation Reduction Act (IRA).

-

La Chine, grâce à la production massive, à l’intégration verticale et aux politiques incitatives, domine dans les composants, l’automatisation industrielle et les robots humanoïdes, avec une force matérielle et logistique remarquable. Unitree et UBTECH produisent déjà à grande échelle et étendent vers la couche décisionnelle intelligente. Toutefois, elle accuse un retard significatif face aux États-Unis en algorithmes et entraînement par simulation.

-

Le Japon monopolise depuis longtemps les composants haute précision et les technologies de contrôle moteur. Son industrie est robuste, mais l’intégration des modèles IA en est encore à ses balbutiements, avec un rythme d’innovation prudent.

-

La Corée excelle dans la diffusion des robots grand public, menée par LG et NAVER Labs, et possède un écosystème mature de robots de service.

-

L’Europe dispose d’un système d’ingénierie et de normes de sécurité abouti. Des entreprises comme 1X Robotics restent actives en R&D, mais certaines productions ont été délocalisées, recentrant l’innovation sur la collaboration et la standardisation.

Robots × IA × Web3 : vision narrative et chemin réel

En 2025, le secteur Web3 adopte une nouvelle narration fusionnant robots et IA. Bien que Web3 soit perçu comme le protocole sous-jacent d’une économie machine décentralisée, sa valeur combinée et sa faisabilité varient fortement selon les couches :

-

La fabrication matérielle et la couche de service, intensives en capital et faibles en boucles de données, limitent actuellement Web3 à des rôles secondaires comme le financement logistique ou la location d’équipements ;

-

La compatibilité est plus élevée au niveau des simulations et écosystèmes logiciels : les données de simulation et tâches d’entraînement peuvent être certifiées sur chaîne, les agents et modules de compétences pouvant être tokenisés via NFT ou Agent Token ;

-

Au niveau plateforme, les réseaux décentralisés de main-d’œuvre et de collaboration montrent le plus grand potentiel — Web3 peut, via des mécanismes unifiés d’identité, d’incitation et de gouvernance, bâtir progressivement un « marché de main-d’œuvre machine » fiable, jetant les bases institutionnelles d’une future économie machine.

À long terme, les couches de collaboration et plateforme sont les plus valorisables dans la convergence Web3-robots-IA. À mesure que les robots acquièrent perception, langage et apprentissage, ils deviennent des individus intelligents capables de décisions autonomes, de coopération et de création de valeur économique. Pour que ces « travailleurs intelligents » participent pleinement à l’économie, quatre seuils doivent être franchis : identité, confiance, incitation et gouvernance.

-

Au niveau identité, chaque machine doit avoir une identité numérique vérifiable et traçable. Via Machine DID, chaque robot, capteur ou drone peut générer sur chaîne un « permis de conduire » unique et vérifiable, lié à sa propriété, historique d’actions et droits, permettant des interactions sécurisées et une attribution des responsabilités.

-

Au niveau confiance, il faut rendre le « travail machine » vérifiable, mesurable et tarifable. Grâce aux contrats intelligents, oracles et audits, combinés au Proof of Physical Work (PoPW), aux environnements d’exécution fiables (TEE) et aux preuves à divulgation nulle (ZKP), on garantit l’authenticité et la traçabilité des tâches, conférant une valeur comptable aux actions des machines.

-

Au niveau incitation, Web3 permet, via des systèmes tokenisés, l’abstraction de compte et les canaux d’état, des règlements automatiques et transferts de valeur entre machines. Les robots peuvent effectuer des micro-paiements pour louer de la puissance de calcul ou partager des données, et assurer l’exécution via des mécanismes de mise en jeu et sanction ; avec contrats intelligents et oracles, on peut créer un « marché de collaboration machine » décentralisé sans supervision humaine.

-

Au niveau gouvernance, lorsque les machines auront une autonomie durable, Web3 offre un cadre transparent et programmable : via DAO pour décider collectivement des paramètres système, signatures multiples et mécanismes de réputation pour assurer sécurité et ordre. À long terme, cela mènera vers une phase de « gouvernance algorithmique » — les humains fixent buts et limites, les machines s’ajustent via contrats.

La vision ultime de la convergence Web3-robots : un réseau d’évaluation en environnement réel — un « moteur de raisonnement du monde réel » constitué de robots distribués testant continuellement les capacités des modèles dans des scénarios physiques variés et complexes ; et un marché de main-d’œuvre robotique — où les robots exécutent globalement des tâches vérifiables, perçoivent des revenus via règlement sur chaîne, et réinvestissent dans du calcul ou du matériel.

Sur le plan réel, la convergence intelligence incarnée-Web3 en est encore à l’exploration précoce. L’économie décentralisée d’intelligence machine reste surtout narrative et communautaire. Les pistes réalistes actuelles concernent principalement trois aspects :

(1) Crowdsourcing et certification des données — Web3 encourage, via des incitations et traçabilité sur chaîne, la contribution de données réelles ; (2) Participation mondiale de niche — les paiements transfrontaliers et micro-incitations réduisent les coûts de collecte et distribution ; (3) Financiarisation et innovation collaborative — le modèle DAO permet la tokenisation des robots, la titrisation des revenus et les règlements inter-machines.

En résumé, à court terme, l’accent sera sur la collecte de données et l’incitation ; à moyen terme, des percées sont attendues dans « paiement en stablecoin + agrégation de données de niche » et la tokenisation-RaaS ; à long terme, si les robots humanoïdes se diffusent massivement, Web3 pourrait devenir la base institutionnelle de la propriété, redistribution et gouvernance des machines, impulsant une véritable économie machine décentralisée.

Cartographie de l’écosystème Web3-robots et cas sélectionnés

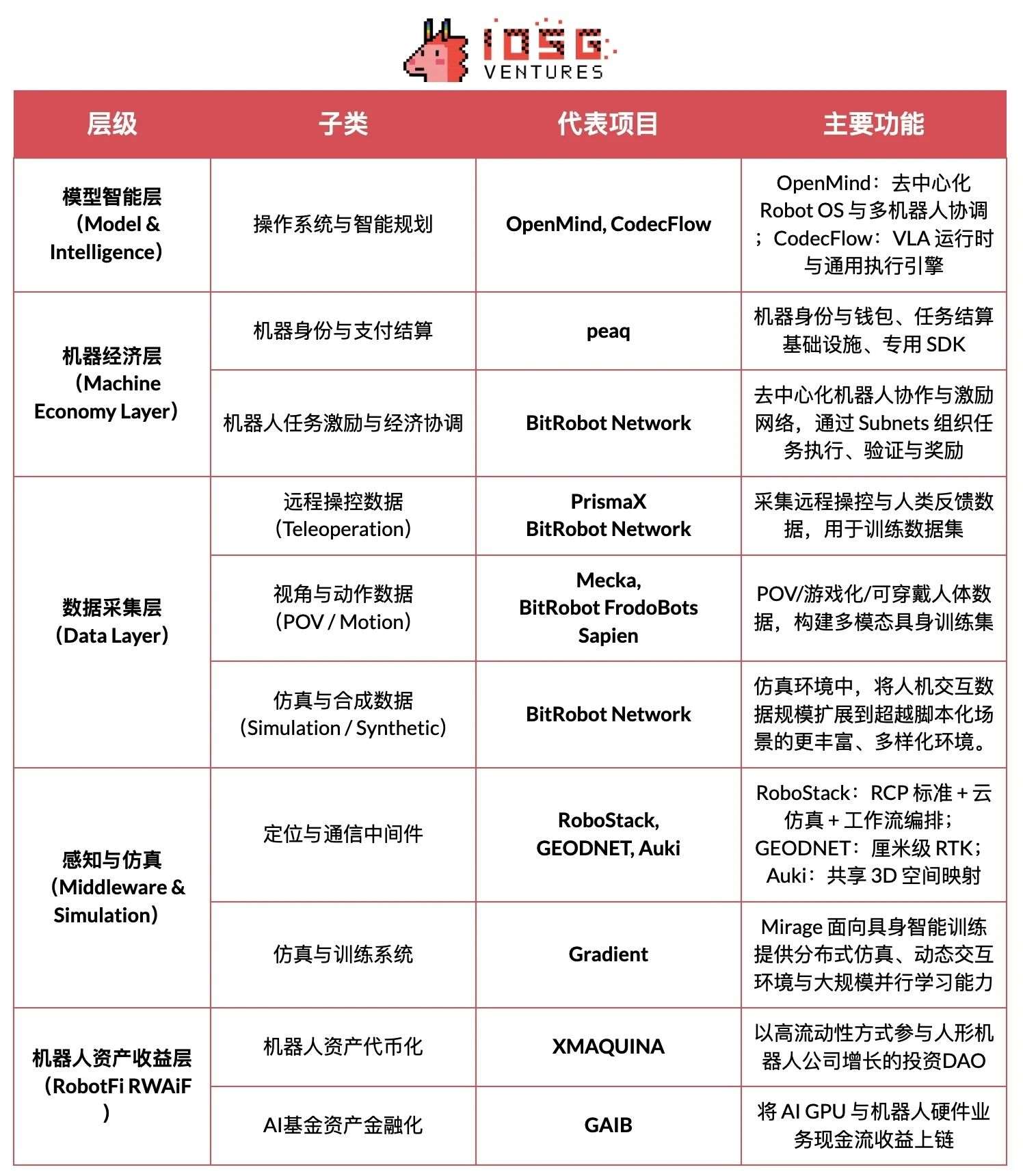

Basé sur trois critères — progrès vérifiables, transparence technique, pertinence industrielle — nous recensons les projets représentatifs de Web3 × Robotics, classés selon cinq couches : couche intelligence/modèle, couche économie machine, couche collecte de données, couche perception/simulation, couche收益机器人资产. Pour rester objectif, les projets clairement opportunistes ou manquant d’informations ont été exclus ; toute omission est bienvenue.

Couche intelligence/modèle (Model & Intelligence)

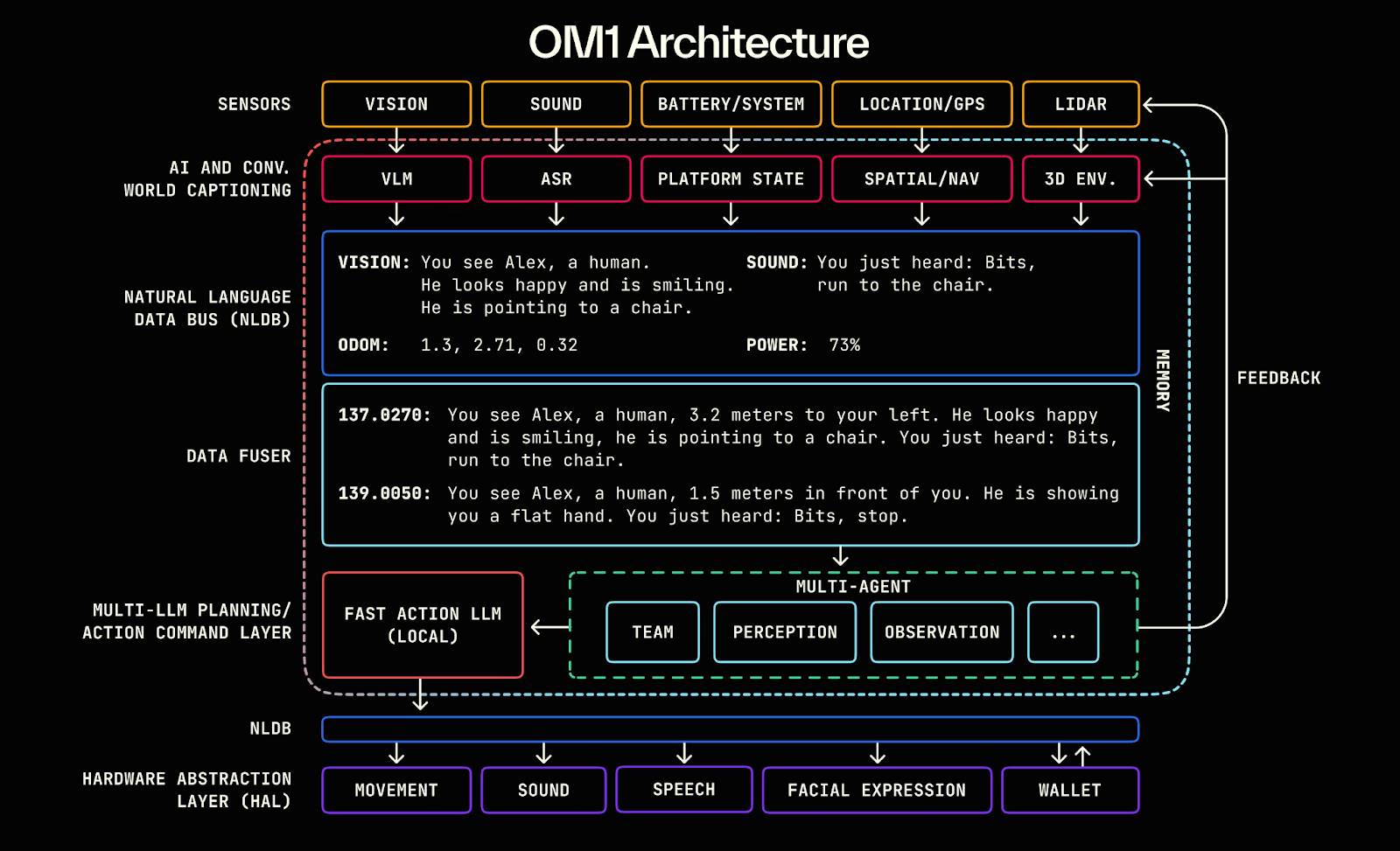

#Openmind - Building Android for Robots (https://openmind.org/)

OpenMind est un système d’exploitation open source (Robot OS) destiné à l’intelligence incarnée (Embodied AI) et au contrôle robotique, visant à construire le premier environnement d’exécution robotique décentralisé et plateforme de développement au monde. Le projet comporte deux composants principaux :

-

OM1 : runtime open source modulaire AI (couche AI Runtime Layer) basé sur ROS2, orchestrant les pipelines perception, planification et action, servant les robots numériques et physiques ;

-

FABRIC : couche de coordination distribuée (Fabric Coordination Layer), reliant puissance de calcul, modèles et robots réels, permettant aux développeurs de contrôler et entraîner des robots dans un environnement unifié.

Le cœur d’OpenMind est d’agir comme couche intermédiaire intelligente entre les LLM (grands modèles linguistiques) et le monde robotique, transformant réellement l’intelligence linguistique en intelligence incarnée (Embodied Intelligence), construisant un squelette intelligent allant de la compréhension (Language → Action) à l’alignement (Blockchain → Rules).

Le système multicouche d’OpenMind réalise une boucle de collaboration complète : les humains fournissent feedback et annotations via l’appli OpenMind (données RLHF), Fabric Network gère authentification, attribution des tâches et coordination des règlements, les robots OM1 exécutent les tâches et respectent la « constitution robotique » sur blockchain pour audit comportemental et paiement, créant ainsi un réseau décentralisé de collaboration machine reliant feedback humain → collaboration → règlement sur chaîne.

Progrès du projet et évaluation réelle

OpenMind est à un stade précoce « techniquement opérationnel, commercialement non déployé ». Le système central OM1 Runtime est déjà open source sur GitHub, fonctionne sur plusieurs plateformes, prend en charge les entrées multimodales, utilise un bus de données linguistiques naturelles (NLDB) pour comprendre les tâches, présente une forte originalité mais reste expérimental ; le réseau Fabric et le règlement sur chaîne n’en sont qu’à la conception d’interface.

Sur le plan écosystème, le projet collabore avec des matériels libres (Unitree, Ubtech, TurtleBot) et des universités (Stanford, Oxford, Seoul Robotics), principalement pour l’éducation et la validation académique, sans application industrielle. L’appli est en version bêta, mais les fonctions d’incitation et de tâches sont encore embryonnaires.

Sur le plan économique, OpenMind construit un écosystème à trois niveaux : OM1 (système open source) + Fabric (protocole de règlement) + Skill Marketplace (couche d’incitation). Aucun revenu pour l’instant, financé par environ 20 millions USD (Pantera, Coinbase Ventures, DCG). Globalement, technologie en avance mais commercialisation et écosystème au tout début ; si Fabric réussit, il pourrait devenir « l’Android de l’ère de l’intelligence incarnée », mais avec un cycle long, des risques élevés et une forte dépendance au matériel.

#CodecFlow - The Execution Engine for Robotics (https://codecflow.ai)

CodecFlow est un protocole de couche d’exécution décentralisé basé sur Solana (Fabric), visant à fournir un environnement d’exécution à la demande pour les agents IA et systèmes robotiques, donnant à chaque agent un « ordinateur instantané (Instant Machine) ». Le projet repose sur trois modules :

-

Fabric : couche d’agrégation de puissance de calcul cross-cloud (Weaver + Shuttle + Gauge), générant en quelques secondes des machines virtuelles, conteneurs GPU ou nœuds de contrôle robotiques sécurisés pour les tâches IA ;

-

SDK optr : framework d’exécution d’agents (interface Python), permettant de créer des « Opérateurs » capables d’interagir avec bureau, simulation ou robots réels ;

-

Incitation par token : couche d’incitation et de paiement sur chaîne, reliant fournisseurs de calcul, développeurs d’agents et utilisateurs de tâches automatisées, formant un marché décentralisé de puissance de calcul et de tâches.

L’objectif central de CodecFlow est de créer une « base d’exécution décentralisée pour opérateurs IA et robots », permettant à tout agent de s’exécuter en sécurité dans n’importe quel environnement (Windows/Linux/ROS/MuJoCo/contrôleurs robotiques), réalisant une architecture d’exécution universelle allant de l’allocation de ressources (Fabric) → environnement système (System Layer) → perception-action (VLA Operator).

Progrès du projet et évaluation réelle

Une version préliminaire du framework Fabric (Go) et du SDK optr (Python) a été publiée, permettant de lancer des instances de puissance isolée via navigateur ou ligne de commande. Le marché des Operators devrait sortir fin 2025, positionné comme couche d’exécution décentralisée pour l’IA, ciblant développeurs IA, équipes de recherche robotique et sociétés d’automatisation.

Couche économie machine (Machine Economy Layer)

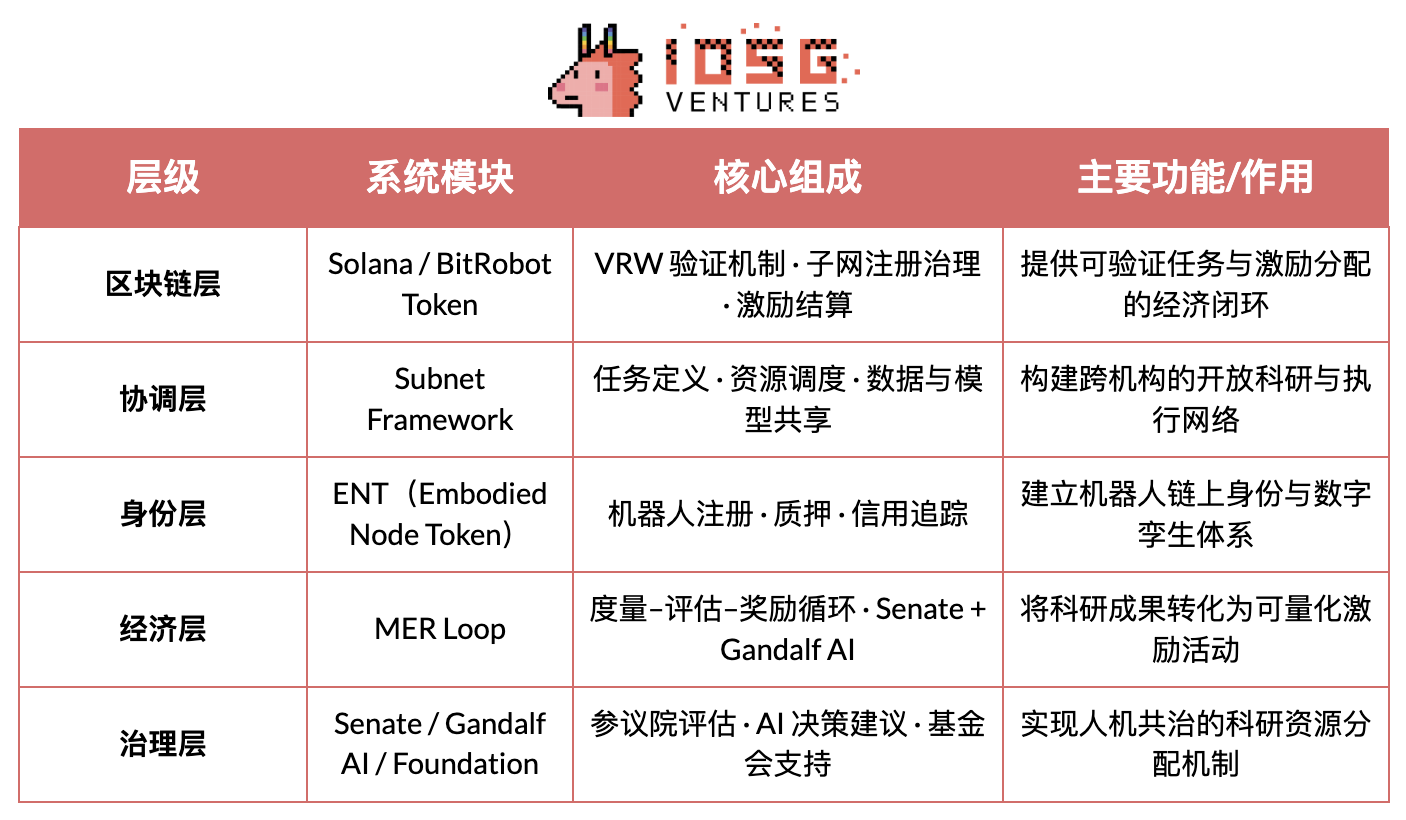

#BitRobot - The World’s Open Robotics Lab (https://bitrobot.ai)

BitRobot est un réseau de recherche et collaboration décentralisé dédié à l’intelligence incarnée (Embodied AI) et au développement robotique (Open Robotics Lab), lancé conjointement par FrodoBots Labs et Protocol Labs. Sa vision centrale est : via une architecture ouverte « sous-réseaux (Subnets) + mécanismes d’incitation + travail robotique vérifiable (VRW) », ses fonctions clés incluent :

-

Définir et valider via VRW (Verifiable Robotic Work) la contribution réelle de chaque tâche robotique ;

-

Attribuer via ENT (Embodied Node Token) une identité sur chaîne et une responsabilité économique aux robots ;

-

Organiser via Subnets la collaboration transfrontalière en recherche, puissance de calcul, équipements et opérateurs ;

-

Réaliser une gouvernance « homme-machine » via Senate + Gandalf AI pour décisions incitatives et gestion scientifique.

Depuis la publication du livre blanc en 2025, BitRobot a lancé plusieurs sous-réseaux (ex : SN/01 ET Fugi, SN/05 SeeSaw by Virtuals Protocol), réalisant la téléopération décentralisée et la collecte de données en scénarios réels, et a lancé un fonds Grand Challenges de 5M$ pour stimuler des compétitions mondiales de développement de modèles.

#peaq – The Economy of Things (https://www.peaq.network)

peaq est une blockchain Layer-1 dédiée à l’économie des machines, fournissant aux millions de robots et appareils des capacités fondamentales : identité machine, portefeuille sur chaîne, contrôle d’accès et synchronisation temporelle nanoseconde (Universal Machine Time). Son SDK Robotics permet aux développeurs de rendre leurs robots « prêts pour l’économie machine » avec très peu de code, assurant l’interopérabilité et l’interaction entre fabricants et systèmes.

Actuellement, peaq a lancé la première ferme de robots tokenisée au monde, soutenant plus de 60 applications réelles. Son cadre de tokenisation aide les entreprises robotiques à lever des fonds pour des matériels intensifs en capital, élargissant la participation du B2B/B2C traditionnel à une communauté plus large. Grâce à un bassin d’incitation au niveau protocole alimenté par les frais réseau, peaq peut subventionner l’adoption de nouveaux dispositifs et aider les développeurs, créant ainsi une boucle économique propulsant l’expansion accélérée des projets robotiques et IA physique.

Couche collecte de données (Data Layer)

Visant à résoudre le manque et le coût élevé des données réelles de haute qualité pour l’entraînement de l’intelligence incarnée. Plusieurs voies sont utilisées pour collecter et générer des données homme-machine, incluant la téléopération (PrismaX, BitRobot Network), la capture en première personne et mouvements (Mecka, BitRobot Network, Sapien, Vader, NRN), et les données simulées ou synthétiques (BitRobot Network), fournissant une base d’entraînement extensible et généralisable pour les modèles robotiques.

Il faut souligner que Web3 n’est pas bon pour « produire des données » — en termes de matériel, algorithmes et efficacité de collecte, les géants Web2 surpassent largement tous les projets DePIN. Sa véritable valeur réside dans la refonte des mécanismes de distribution et d’incitation des données. Basé sur un « réseau de paiement en stablecoin + modèle de crowdsourcing », via un système d’incitation sans permission et un mécanisme de certification sur chaîne, il permet des règlements micropaiements à faible coût, la traçabilité des contributions et le partage automatique des bénéfices. Mais le crowdsourcing ouvert rencontre toujours des problèmes de qualité et de boucle de demande — la qualité des données est inégale, sans validation efficace ni acheteur stable.

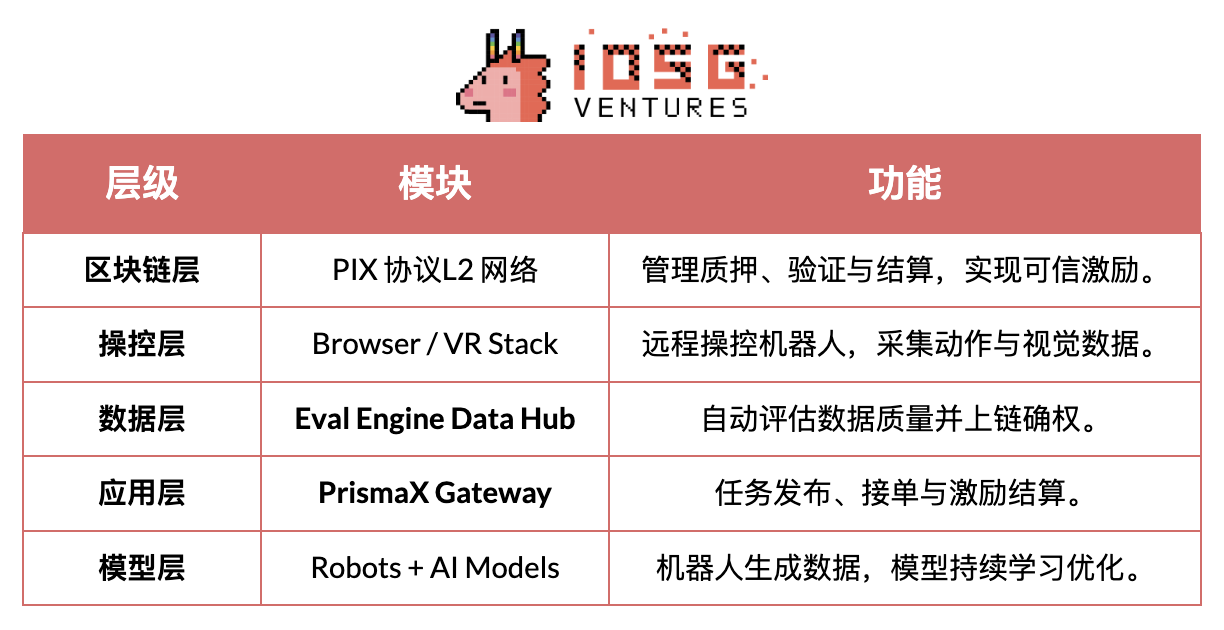

#PrismaX (https://gateway.prismax.ai)

PrismaX est un réseau économique décentralisé de téléopération et de données pour l’intelligence incarnée (Embodied AI), visant à construire un « marché mondial de main-d’œuvre robotique », permettant aux opérateurs humains, aux robots et aux modèles IA d’évoluer ensemble via un système d’incitation sur chaîne. Le projet comporte deux composants clés :

-

Téléopération Stack — système de téléopération (interface navigateur/VR + SDK), connectant des bras robotiques et robots de service mondiaux, permettant le contrôle humain en temps réel et la collecte de données ;

-

Moteur Eval — moteur d’évaluation et validation des données (CLIP + DINOv2 + notation sémantique par flux optique), générant une note de qualité pour chaque trajectoire d’opération et réglant sur chaîne.

PrismaX, via un mécanisme d’incitation décentralisé, transforme les actions humaines en données d’apprentissage machine, créant une boucle complète de « téléopération → collecte de données → entraînement de modèles → règlement sur chaîne », réalisant une économie circulaire où « le travail humain devient actif de données ».

Progrès du projet et évaluation réelle

PrismaX a lancé une version bêta en août 2025 (gateway.prismax.ai), permettant aux utilisateurs de contrôler à distance un bras robotique pour des expériences de préhension et générer des données d’entraînement. Le moteur Eval fonctionne internement. Globalement, PrismaX a un haut niveau de réalisation technique, une position claire, et est une couche intermédiaire clé reliant « opération humaine × modèle IA × règlement blockchain ». Son potentiel à long terme pourrait en faire le « protocole décentralisé de travail et de données de l’ère de l’intelligence incarnée », mais il fait face à des défis de scalabilité à court terme.

#BitRobot Network (https://bitrobot.ai/)

BitRobot Network collect

Bienvenue dans la communauté officielle TechFlow

Groupe Telegram :https://t.me/TechFlowDaily

Compte Twitter officiel :https://x.com/TechFlowPost

Compte Twitter anglais :https://x.com/BlockFlow_News