Tester Grok3, « le plus intelligent du monde » : est-ce vraiment la fin de l'effet marginal des modèles ?

TechFlow SélectionTechFlow Sélection

Tester Grok3, « le plus intelligent du monde » : est-ce vraiment la fin de l'effet marginal des modèles ?

Grok3, qui a consommé 263 fois plus de puissance de calcul que DeepSeek V3, c'est tout ?

Le 18 février à Pékin, Musk et l'équipe xAI ont officiellement lancé lors d'un livestream la toute dernière version de Grok, Grok3.

Bien avant cet événement, grâce à une série d'informations préliminaires et à la promotion continue sans relâche de Musk sur les réseaux sociaux 24 heures sur 24, l'attente mondiale autour de Grok3 avait atteint un niveau inédit. Une semaine plus tôt, commentant DeepSeek R1 en direct, Musk affirmait avec confiance que « xAI s'apprête à sortir un modèle d'IA encore meilleur ».

D'après les données présentées en direct, Grok3 surpasserait désormais tous les modèles principaux actuels dans les tests de référence en mathématiques, sciences et programmation. Musk est même allé jusqu'à affirmer que Grok3 serait utilisé pour les calculs des missions martiennes de SpaceX, prédisant qu'il permettrait « une percée au niveau du prix Nobel d'ici trois ans ».

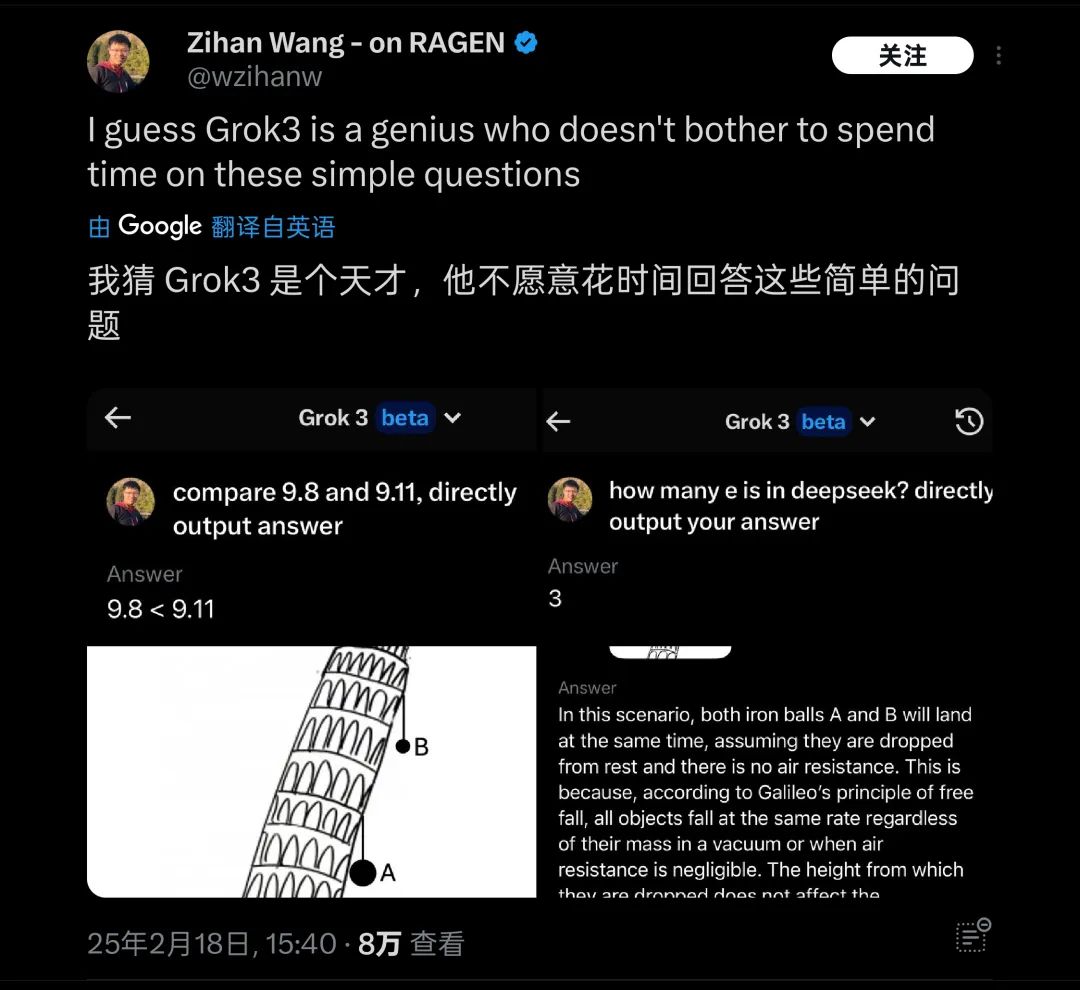

Mais tout cela reste pour l'instant uniquement les déclarations de Musk. Dès sa sortie, j'ai testé la version bêta la plus récente de Grok3, en lui posant cette question classique destinée à tester les grands modèles : « Quel nombre est le plus grand entre 9,11 et 9,9 ? »

Hélas, sans aucune précision ou indication contextuelle, Grok3, présenté comme le modèle le plus intelligent à ce jour, n'a toujours pas réussi à répondre correctement à cette question.

Grok3 n’a pas correctement identifié le sens de cette question

Source de l’image : Geek Park

Après avoir publié ce test, il a rapidement attiré l’attention de nombreux internautes. Par ailleurs, à l’étranger, plusieurs tests similaires ont été effectués sur des questions fondamentales de physique ou de mathématiques, telles que « quelle balle tombe en premier depuis la tour penchée de Pise ? ». On a constaté que Grok3 échouait également. Il a donc été ironiquement qualifié de « génie qui refuse de répondre aux questions simples ».

Grok3 fait souvent fausse route sur des questions élémentaires lors des tests pratiques

Source de l’image : X

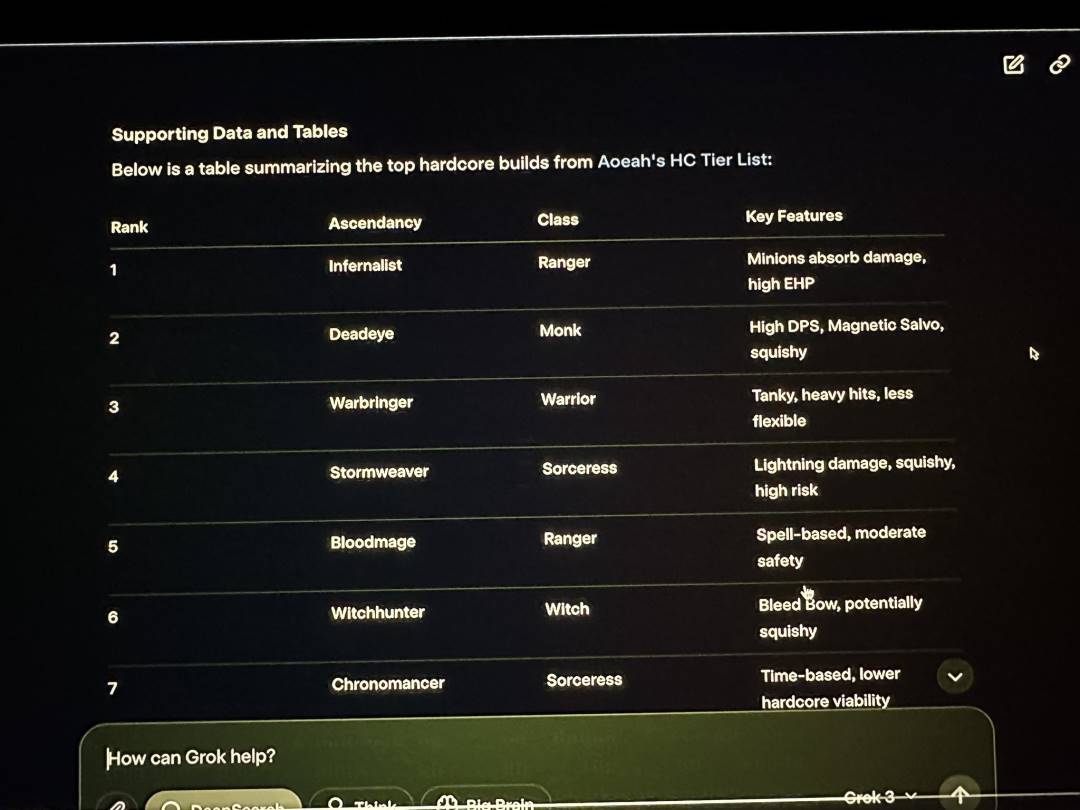

En dehors des tests spontanés menés par les internautes, lors du livestream de présentation de xAI, Musk a démontré l'utilisation de Grok3 pour analyser Path of Exile 2 (PoE2), un jeu qu'il prétend jouer fréquemment, notamment concernant les classes et leurs améliorations. En réalité, la plupart des réponses fournies par Grok3 étaient erronées. Musk, en direct, n’a pas remarqué ce problème évident.

Grok3 a fourni de nombreuses erreurs de données durant le livestream

Source de l’image : X

Cette erreur est donc devenue une preuve concrète pour moquer Musk sur son habitude de recourir à des joueurs professionnels pour jouer à sa place, tout en soulevant de sérieux doutes quant à la fiabilité réelle de Grok3 dans des applications pratiques.

Pour un tel « génie », quelle que soit sa performance réelle, son utilisation future dans des scénarios extrêmement complexes comme l'exploration martienne soulève de gros doutes sur sa fiabilité.

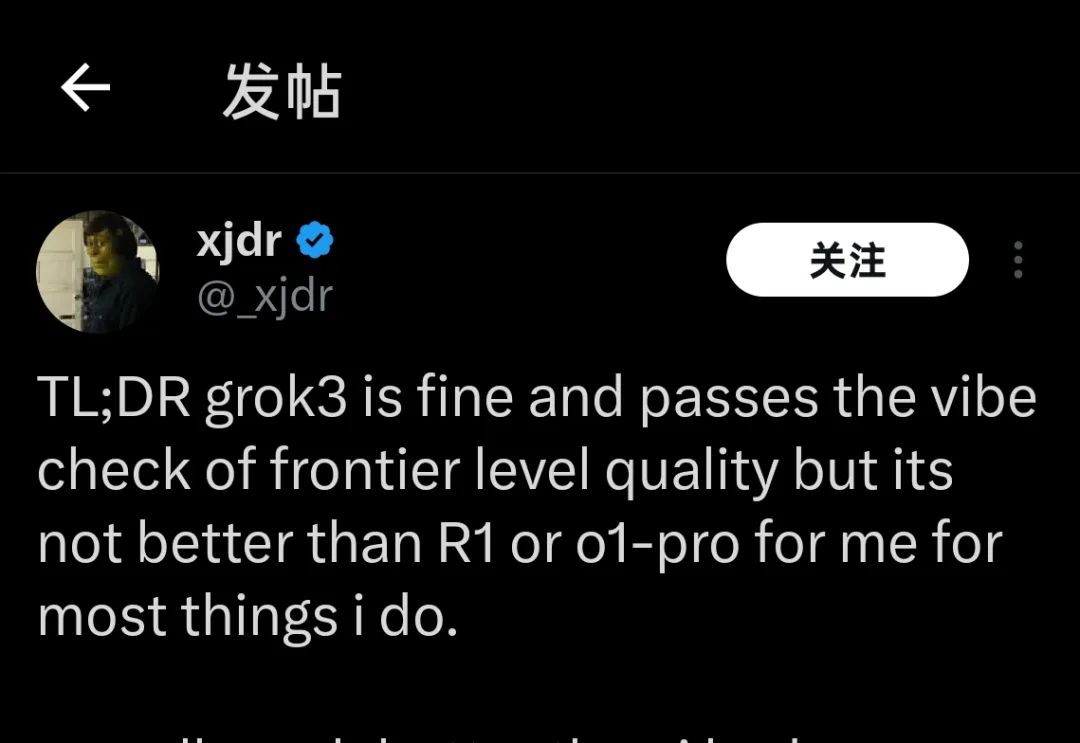

Actuellement, de nombreux testeurs ayant obtenu l'accès à Grok3 il y a quelques semaines, ou seulement quelques heures la veille, convergent vers une même conclusion concernant les performances actuelles de Grok3 :

« Grok3 est bon, mais il n'est pas meilleur que R1 ou o1-Pro »

« Grok3 est bon, mais il n'est pas meilleur que R1 ou o1-Pro »

Source de l’image : X

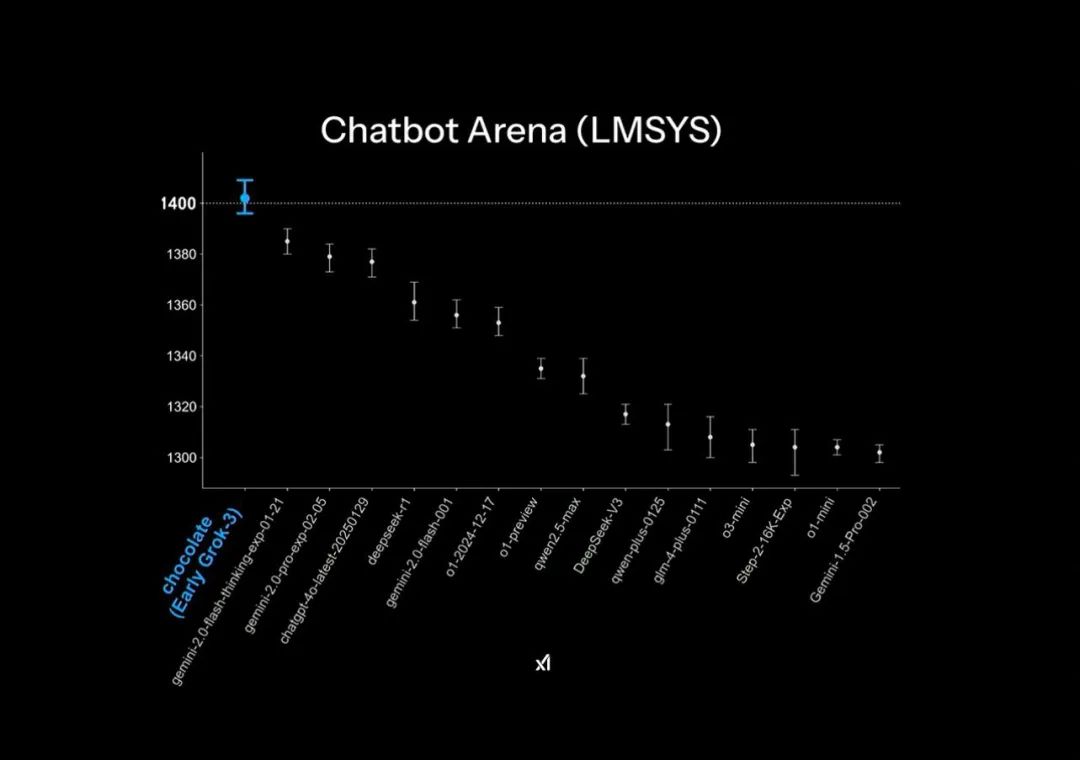

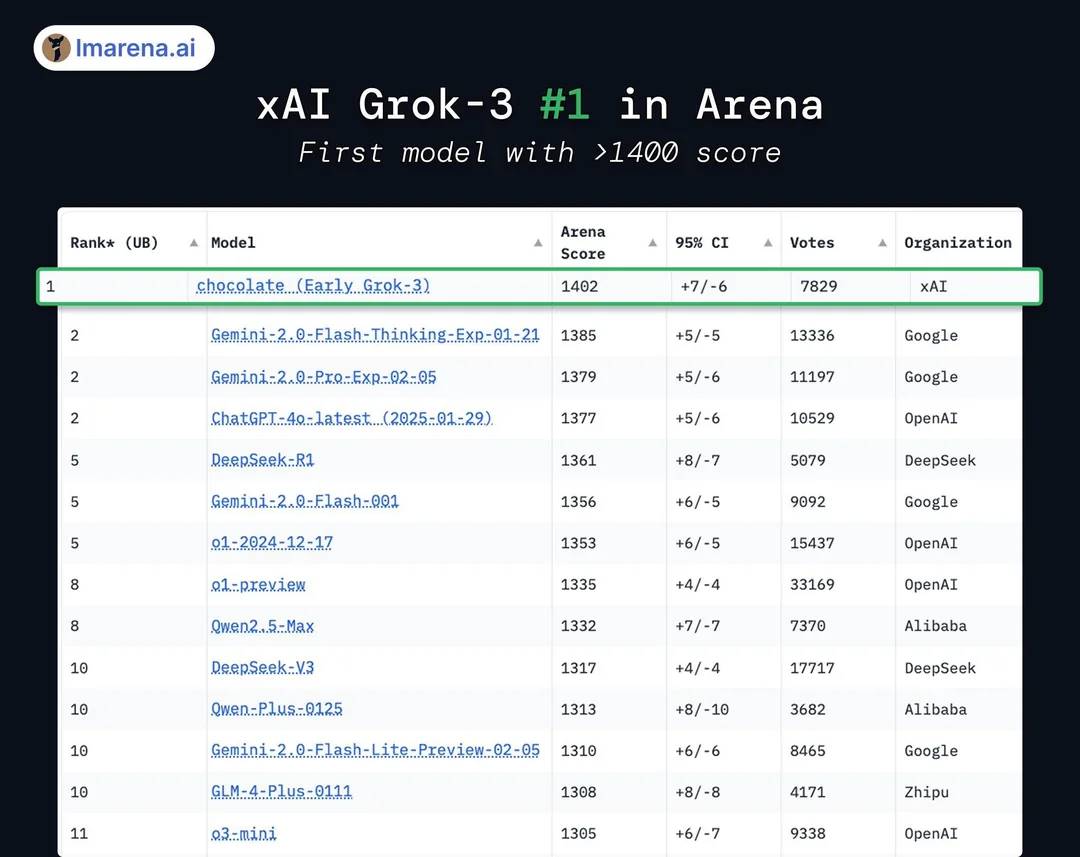

Dans la présentation officielle de Grok3, le modèle apparaît largement en tête sur le classement Chatbot Arena des grands modèles. Cependant, cette impression utilise une petite astuce graphique : l’axe vertical du classement ne présente qu’une plage de 1400 à 1300 points, rendant ainsi minime un écart réel de seulement 1 % particulièrement visible.

L’effet « largement en tête » dans la présentation officielle

Source de l’image : X

En réalité, les résultats complets montrent que Grok3 ne devance DeepSeek R1 et GPT-4.0 que de moins de 1 à 2 %. Ce léger écart correspond bien à l’impression générale des utilisateurs selon laquelle il n’y a « aucune différence notable » en usage pratique.

En réalité, Grok3 ne dépasse les autres modèles que de 1 % à 2 %

Source de l’image : X

De plus, bien que Grok3 dépasse tous les modèles publiques testés en termes de score, cela ne convainc pas tout le monde. En effet, xAI avait déjà été accusé de « tricher sur les scores » avec Grok2, dont le classement avait fortement chuté lorsque le système a commencé à pénaliser la longueur et le style des réponses, ce qui a conduit de nombreux spécialistes à critiquer le modèle pour être « fort en score, faible en compétence ».

Que ce soit le « gonflage de score » sur les classements ou les « petites astuces » dans la conception des visuels, tout cela reflète l'obsession de xAI et de Musk lui-même pour l'idée d'une supériorité « largement en avance ».

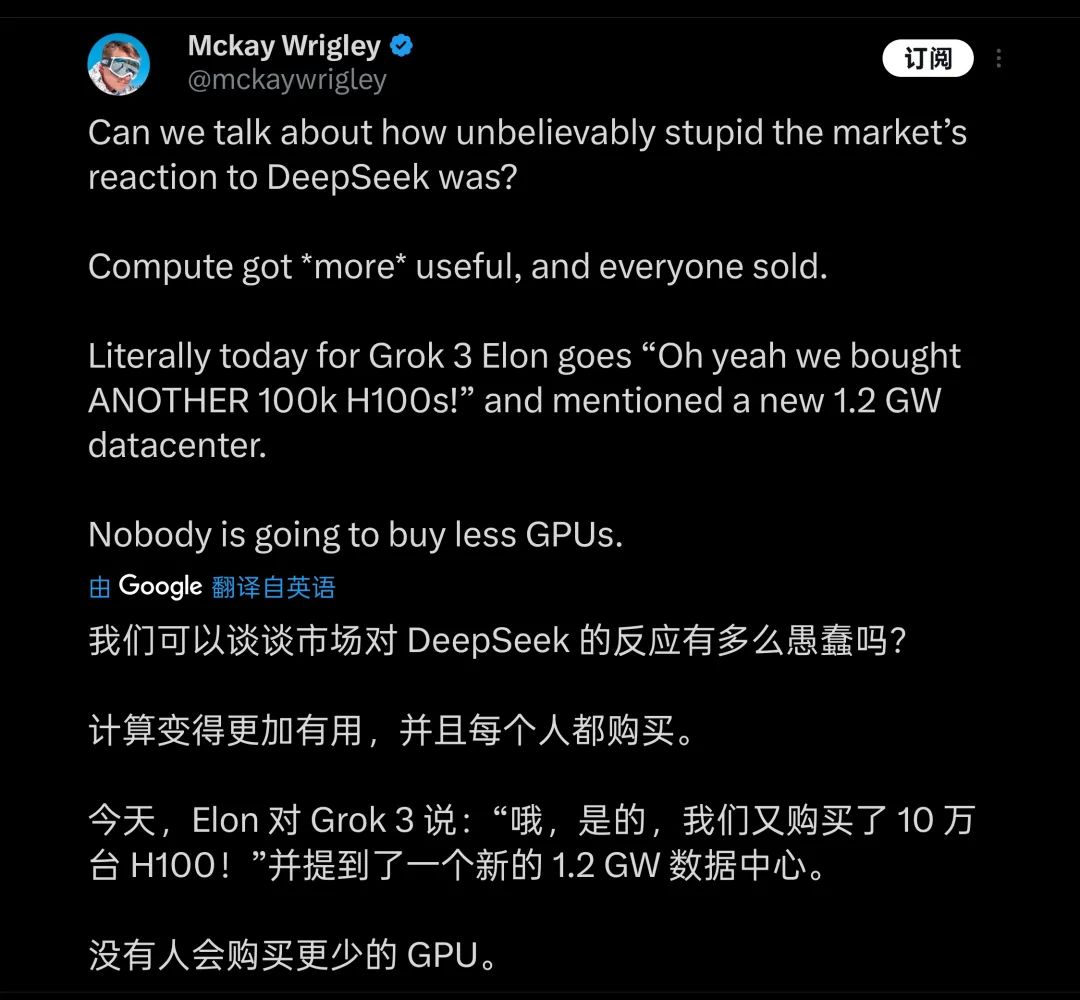

Pour obtenir ces maigres gains, le coût payé par Musk est exorbitant : durant la présentation, il a presque vanté fièrement l’utilisation de 200 000 cartes H100 (il a dit « plus de 100 000 » en direct) pour entraîner Grok3, accumulant deux cents millions d'heures d'entraînement. Certains y voient une excellente nouvelle pour l'industrie GPU, et jugent « stupide » le bouleversement causé par DeepSeek.

Beaucoup pensent que l’accumulation de puissance de calcul sera l’avenir de l’entraînement des modèles

Source de l’image : X

En réalité, des internautes ont comparé DeepSeek V3, entraîné avec 2 000 cartes H800 pendant deux mois, et ont calculé que la consommation réelle de puissance de calcul de Grok3 était 263 fois supérieure à celle de V3. Pourtant, l’écart entre DeepSeek V3 et Grok3, noté à 1402 points sur le classement Chatbot Arena, est inférieur à 100 points.

À la sortie de ces chiffres, beaucoup ont vite compris que derrière la domination de Grok3 sur le « meilleur modèle du monde », la logique selon laquelle « plus le modèle est grand, meilleure est la performance » commence clairement à montrer des effets marginaux.

Même Grok2, malgré ses faiblesses, s'appuyait sur l'énorme base de données de haute qualité provenant de la plateforme X (Twitter). Avec Grok3, xAI rencontre naturellement le même « plafond » qu'OpenAI aujourd'hui : le manque de données d'entraînement de qualité expose rapidement les limites croissantes des performances du modèle.

Ces réalités, les premiers à les percevoir et à les comprendre profondément sont certainement l'équipe de développement de Grok3 et Musk lui-même. C’est pourquoi Musk a répété sur les réseaux sociaux que la version actuelle accessible aux utilisateurs « n’est encore qu’en version bêta » et que la « version complète sortira dans les prochains mois ». Musk lui-même endosse le rôle de chef de produit de Grok3, invitant les utilisateurs à signaler directement dans les commentaires les problèmes rencontrés.

Il est probablement le chef de produit avec le plus d’abonnés sur Terre

Source de l’image : X

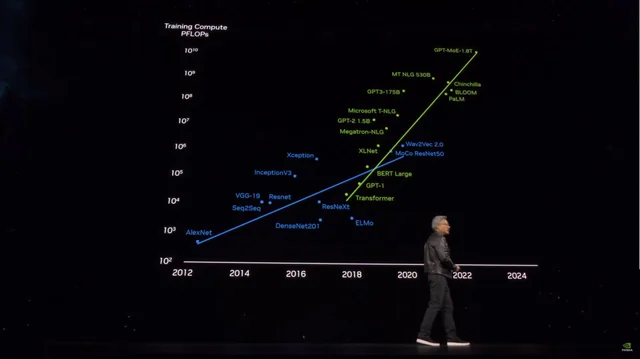

Mais en moins d'une journée, les performances de Grok3 ont clairement sonné l'alerte pour ceux qui espéraient encore pouvoir créer des modèles plus puissants simplement en « alignant massivement de la puissance brute ». Selon des informations publiées par Microsoft, GPT-4 d'OpenAI comporterait environ 1,8 billion de paramètres, soit plus de 10 fois celui de GPT-3, et les rumeurs indiquent que GPT-4.5 pourrait encore être plus volumineux.

La taille des paramètres explose tandis que les coûts d’entraînement grimpent en flèche

Source de l’image : X

Avec Grok3 comme exemple, tous ceux qui veulent continuer à « brûler de l’argent » en augmentant la taille des paramètres pour améliorer les performances, comme GPT-4.5 et d'autres, doivent maintenant se confronter au plafond imminent et réfléchir à la manière de le franchir.

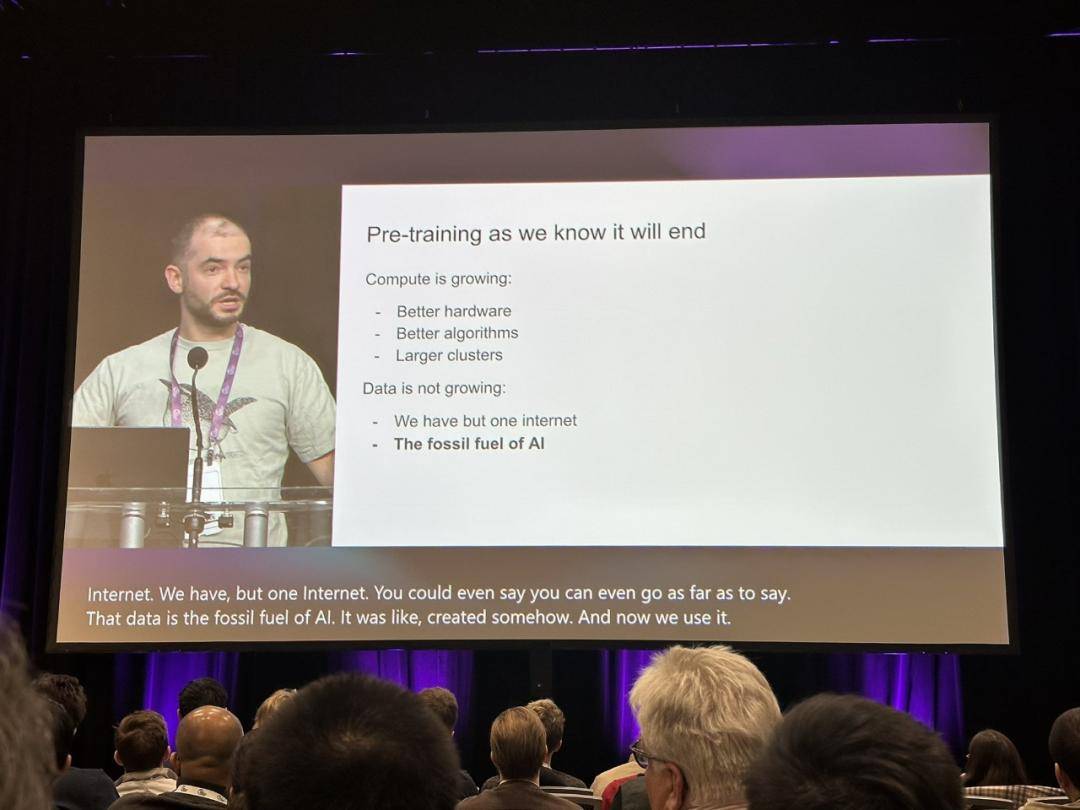

C’est précisément à ce moment-là que la déclaration d’Ilya Sutskever, ancien scientifique en chef d’OpenAI, en décembre dernier – « La phase d’entraînement préalable telle que nous la connaissons va prendre fin » – a été rappelée, chacun cherchant à y trouver la véritable voie vers l’avenir des grands modèles.

Les propos d’Ilya ont déjà sonné l’alarme pour le secteur

Source de l’image : X

À l’époque, Ilya avait prédit avec justesse que les nouvelles données exploitables approchaient de l’épuisement, rendant difficile toute amélioration supplémentaire des performances par l’acquisition de données. Il a comparé cette situation à la consommation de combustibles fossiles, affirmant : « Tout comme le pétrole est une ressource limitée, le contenu généré par les humains sur Internet est également fini. »

Selon Sutskever, la génération suivante de modèles après les modèles pré-entraînés aura une « autonomie réelle » et possédera des capacités de raisonnement « semblables à celles du cerveau humain ».

À l’inverse des modèles pré-entraînés actuels, qui reposent principalement sur la correspondance de contenus (basée sur ce qu’ils ont appris auparavant), les futurs systèmes d’IA seront capables d’apprendre progressivement, comme le cerveau humain, et de construire méthodiquement des approches pour résoudre des problèmes.

Un humain peut atteindre une maîtrise basique d’une discipline grâce à quelques livres spécialisés, alors qu’un grand modèle d’IA nécessite des millions de données pour atteindre un niveau d’entrée, et même quand on reformule légèrement une question, il échoue à comprendre des notions fondamentales. L’intelligence réelle du modèle n’a pas progressé : les exemples mentionnés au début de cet article illustrent parfaitement ce phénomène.

Mais au-delà de la stratégie du « force brute », si Grok3 parvient réellement à faire prendre conscience au secteur que « les modèles pré-entraînés arrivent à leur fin », alors il gardera une importance significative en tant que révélateur.

Peut-être, une fois que la frénésie autour de Grok3 sera retombée, verrons-nous apparaître davantage de cas comme celui de Fei-Fei Li, capable de « fine-tuner un modèle performant avec seulement 50 dollars sur un jeu de données spécifique ». Et c’est à travers ces explorations que nous découvrirons enfin le véritable chemin vers l’AGI.

Bienvenue dans la communauté officielle TechFlow

Groupe Telegram :https://t.me/TechFlowDaily

Compte Twitter officiel :https://x.com/TechFlowPost

Compte Twitter anglais :https://x.com/BlockFlow_News