Huang Renxun en dialogue avec les sept auteurs du document Transformer sur l'avenir des grands modèles

TechFlow SélectionTechFlow Sélection

Huang Renxun en dialogue avec les sept auteurs du document Transformer sur l'avenir des grands modèles

Le monde a besoin de quelque chose de meilleur que le Transformer, et je pense que nous espérons tous ici qu'il sera remplacé par une autre technologie capable de nous propulser vers un nouveau plateau de performance.

Rédaction : Guo Xiaojing

Source : Tencent News

En 2017, un article fondateur intitulé « Attention Is All You Need » a fait son apparition. Il introduisait pour la première fois l'architecture Transformer basée sur le mécanisme d'auto-attention, une innovation qui s'affranchissait des modèles traditionnels RNN et CNN. Grâce à un traitement parallèle via le mécanisme d'attention, cette architecture permettait de résoudre efficacement le problème des dépendances à longue distance tout en accélérant considérablement le traitement des séquences. La structure encodeur-décodeur du Transformer et son mécanisme d'attention multi-têtes ont provoqué une véritable révolution dans le domaine de l'intelligence artificielle, posant les bases du très populaire ChatGPT.

Imaginez que le modèle Transformer fonctionne comme votre cerveau lors d'une conversation avec un ami : il peut simultanément prêter attention à chaque mot prononcé et comprendre les liens entre eux. Ce modèle confère aux ordinateurs une capacité de compréhension du langage proche de celle des humains. Avant cela, les RNN dominaient le traitement du langage, mais leur vitesse de traitement était lente, comparable à un ancien magnétophone qui doit lire mot après mot. Le modèle Transformer, lui, ressemble à un DJ performant capable de manipuler plusieurs pistes musicales en même temps, identifiant rapidement les informations clés.

L'avènement du modèle Transformer a grandement amélioré la capacité des ordinateurs à traiter le langage, rendant plus efficaces et précis des tâches telles que la traduction automatique, la reconnaissance vocale ou encore le résumé de texte. C'est un bond énorme pour toute l'industrie.

Cette percée est le fruit du travail conjoint de huit scientifiques en IA ayant travaillé chez Google. Leur objectif initial était simple : améliorer le service de traduction automatique de Google. Ils souhaitaient que les machines comprennent intégralement une phrase au lieu de traduire mot à mot de façon isolée. Cette vision a donné naissance à l'architecture « Transformer », centrée sur le mécanisme d'« auto-attention ». Chacun y a apporté sa spécialité, publiant ensemble en décembre 2017 l'article « Attention Is All You Need », décrivant en détail cette nouvelle architecture et ouvrant ainsi une nouvelle ère pour l’IA générative.

Dans le monde de l'IA générative, la loi d'échelle (Scaling Law) constitue un principe fondamental. En termes simples, plus le modèle Transformer augmente en taille, plus ses performances s'améliorent. Toutefois, cela implique également un besoin accru de ressources informatiques pour supporter des modèles plus volumineux et des réseaux plus profonds. NVIDIA, fournisseur de services de calcul haute performance, est ainsi devenu un acteur central dans cette vague d'innovation en IA.

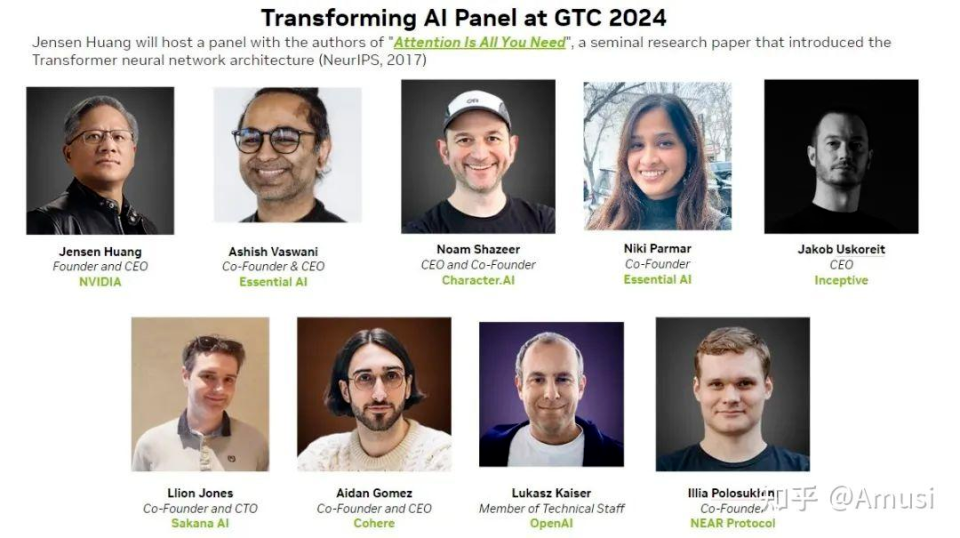

Lors de la conférence GTC de cette année, Jensen Huang, PDG de NVIDIA, a invité de manière solennelle sept des huit auteurs du modèle Transformer (Niki Parmar n'ayant pu être présente) à participer à un forum-débat. C'était la première fois que ces sept chercheurs apparaissaient ensemble en public.

Ils ont exprimé lors de cet échange plusieurs points de vue marquants :

-

Ce monde a besoin de quelque chose de meilleur que le Transformer. Je pense que nous espérons tous ici qu’il sera remplacé par autre chose, nous menant vers un nouveau plateau de performance.

-

Nous n’avons pas réussi notre objectif initial. Nous avons conçu le Transformer dans l'idée de simuler l’évolution des tokens. Ce n’est pas seulement un processus linéaire de génération, mais bien une évolution progressive du texte ou du code.

-

Pour une question aussi simple que 2+2, un grand modèle peut mobiliser un trillion de paramètres. Je pense que le calcul adaptatif devra être l’une des prochaines étapes : savoir combien de ressources allouer à un problème donné.

-

Je pense que les modèles actuels sont encore trop économiques, et trop petits. À environ 1 dollar le million de tokens, c’est 100 fois moins cher que d’acheter un livre broché.

Voici le compte rendu intégral de l’événement :

Jensen Huang : Au cours des soixante dernières années, la technologie informatique n’a pas connu de transformation fondamentale, du moins depuis ma naissance. Les systèmes informatiques actuels – multitâche, séparation logicielle/matérielle, compatibilité logicielle, sauvegarde des données, compétences des programmeurs – reposent tous sur les principes de conception du IBM System360 : processeur central, sous-système BIOS, multitâche, séparation matériel/logiciel, compatibilité des systèmes logiciels, etc.

Je crois que l’informatique moderne n’a pas changé fondamentalement depuis 1964. Certes, dans les années 80 et 90, l’ordinateur a subi une grande transformation, prenant la forme que nous connaissons aujourd’hui. Mais au fil du temps, le coût marginal de l’ordinateur a continué de baisser : divisé par dix tous les dix ans, par mille tous les quinze ans, par dix mille tous les vingt ans. Dans cette révolution informatique, la baisse des coûts a été si radicale qu’en vingt ans, le prix d’un ordinateur a été divisé par presque dix mille. Un tel changement a fourni une impulsion gigantesque à la société.

Imaginez que tous les objets coûteux de votre vie passent à un dix-millième de leur prix initial. Par exemple, une voiture achetée 200 000 dollars il y a vingt ans ne coûterait plus qu’un dollar. Pouvez-vous imaginer un tel bouleversement ? Pourtant, cette chute des coûts informatiques ne s’est pas faite en un jour ; elle a progressivement atteint un seuil critique, puis la tendance à la baisse s’est brusquement arrêtée. Elle continue certes à s’améliorer légèrement chaque année, mais le taux de progression est désormais stabilisé.

Nous avons commencé à explorer le calcul accéléré, mais ce n’est pas facile à mettre en œuvre : il faut repenser entièrement la conception. Avant, nous pouvions suivre des étapes définies, mais désormais, nous devons redessiner ces étapes. C’est un nouveau champ scientifique, consistant à reformuler les anciennes règles en algorithmes parallèles.

Nous avons compris que si nous pouvions accélérer même 1 % du code, économisant ainsi 99 % du temps d’exécution, certaines applications en tireraient un bénéfice énorme. Notre objectif est de rendre possible l’impossible, ou de transformer le possible en impossible, ou encore de rendre plus efficace ce qui l’était déjà. Telle est la signification du calcul accéléré.

En regardant en arrière, nous réalisons que nous avons la capacité d’accélérer diverses applications. Initialement, nous avons obtenu des résultats spectaculaires dans le jeu vidéo, au point que beaucoup pensaient que nous étions une entreprise de jeux. Mais notre ambition va bien au-delà, car ce marché est immense, assez vaste pour entraîner des progrès technologiques incroyables. C’est rare, mais nous avons trouvé ce cas particulier.

Pour faire court, en 2012, AlexNet a mis le feu aux poudres – la première rencontre entre l’intelligence artificielle et les GPU de NVIDIA. Cela a marqué le début de notre parcours magique dans ce domaine. Quelques années plus tard, nous avons découvert un cas d’usage parfait, jetant les bases de notre développement actuel.

En résumé, ces réalisations ont posé les bases du développement de l’IA générative. Celle-ci ne se contente plus de reconnaître des images, mais transforme aussi le texte en image, voire crée du contenu inédit. Désormais, nous disposons de suffisamment de capacités techniques pour comprendre les pixels, les identifier et saisir leur signification profonde. À partir de cette signification, nous pouvons créer du nouveau contenu. La capacité de l’IA à comprendre le sens caché derrière les données constitue une révolution majeure.

Nous avons toutes les raisons de croire que nous assistons au début d’une nouvelle révolution industrielle. Lors des précédentes révolutions industrielles, l’eau était la source d’énergie : elle entrait dans nos machines, faisait tourner les générateurs, et produisait de l’électricité – un peu comme par magie.

L’IA générative est une « application » entièrement nouvelle, capable de créer d’autres applications, grâce aux efforts combinés de nombreux scientifiques. Imaginez que vous donniez à l’IA des matières premières – des données – qui entrent dans un « bâtiment » – ces machines appelées GPU – et qui en sortent des résultats miraculeux. Tout est en train d’être remodelé. Nous assistons à la naissance des « usines d’IA ».

Ce changement peut être qualifié de nouvelle révolution industrielle. Jamais auparavant n’avons-nous connu une telle transformation, mais aujourd’hui, elle commence lentement à se déployer devant nos yeux. Ne manquez pas les dix prochaines années, car elles seront celles où nous créerons une productivité colossale. L’aiguille du temps a commencé à bouger, et nos chercheurs sont déjà en action.

Aujourd’hui, nous avons invité les créateurs du Transformer pour discuter de l’avenir de l’IA générative et de la direction qu’elle va prendre.

Ils sont :

Ashish Vaswani : Rejoint l’équipe Google Brain en 2016. En avril 2022, cofonde Adept AI avec Niki Parmar. En décembre de la même année, quitte l’entreprise et fonde une autre startup d’intelligence artificielle, Essential AI.

Niki Parmar : A travaillé quatre ans au sein de Google Brain, puis a cofondé Adept AI et Essential AI avec Ashish Vaswani.

Jakob Uszkoreit : Travaille chez Google de 2008 à 2021. Quitte Google en 2021 et cofonde Inceptive, une entreprise spécialisée dans les sciences de la vie par intelligence artificielle, utilisant réseaux neuronaux et expérimentations haut débit pour concevoir les molécules d’ARN de nouvelle génération.

Illia Polosukhin : Rejoint Google en 2014. Il est l’un des premiers à quitter l’équipe des huit auteurs, cofondant en 2017 la société blockchain NEAR Protocol.

Noam Shazeer : Travailla chez Google de 2000 à 2009, puis de 2012 à 2021. Quitte Google en 2021 et cofonde Character.AI avec l’ancien ingénieur Google Daniel De Freitas.

Llion Jones : Anciennement employé chez Delcam, puis YouTube. Rejoint Google en 2012 en tant qu’ingénieur logiciel. Quitte ensuite Google pour fonder la startup d’intelligence artificielle sakana.ai.

Lukasz Kaiser : Ancien chercheur au CNRS français. Rejoint Google en 2013. Quitte Google en 2021 pour devenir chercheur chez OpenAI.

Aidan Gomez : Diplômé de l’Université de Toronto au Canada. Lors de la publication du papier sur le Transformer, il était stagiaire au sein de Google Brain. Il est le deuxième membre du groupe à quitter Google. En 2019, il cofonde Cohere.

Jensen Huang : Venez, installez-vous, n’hésitez pas à vous emparer du micro, tout sujet est abordable ici, vous pouvez même sauter de vos chaises ! Commençons par la base : quel problème avez-vous rencontré ? Qu’est-ce qui vous a poussés à créer le Transformer ?

Illia Polosukhin : Si vous voulez publier un modèle capable de lire réellement les résultats de recherche, par exemple traiter des piles de documents, vous avez besoin d’un modèle capable de traiter rapidement ces informations. À l’époque, les réseaux neuronaux récurrents (RNN) ne répondaient pas à ce besoin.

Certes, les RNN et certains mécanismes d’attention préliminaires (Arnens) commençaient à attirer l’attention, mais ils devaient toujours lire mot après mot, ce qui restait inefficace.

Jakob Uszkoreit : Nous générions des données d’entraînement plus vite que nous ne pouvions entraîner les architectures avancées. En réalité, nous utilisions des architectures plus simples, comme des réseaux feedforward dont les caractéristiques d’entrée étaient des n-grammes. Ces architectures, du fait de leur rapidité d’entraînement, surpassaient souvent les modèles plus complexes et avancés, même à l’échelle massive de Google.

Les puissants RNN de l’époque, notamment les LSTM (Long Short-Term Memory), existaient déjà.

Noam Shazeer : C’était clairement un problème urgent. Vers 2015, nous avons commencé à observer ces lois d’échelle (Scaling laws). On voyait que plus le modèle grossissait, plus il devenait intelligent. C’était un problème extraordinaire dans l’histoire du monde : très simple, on prédisait juste le token suivant, et pourtant le système devenait si intelligent qu’il pouvait accomplir un million de choses différentes. Il suffisait de l’agrandir pour qu’il s’améliore.

Mais le grand découragement venait du fait que les RNN étaient extrêmement pénibles à gérer. Puis j’ai entendu ces collègues discuter : « Et si on remplaçait ça par des convolutions ou le mécanisme d’attention ? » J’ai pensé : génial, faisons-le ! J’aime comparer le Transformer à la transition de la machine à vapeur au moteur à combustion interne. On aurait pu accomplir la révolution industrielle avec la machine à vapeur, mais ç’aurait été terriblement difficile. Le moteur à combustion a tout rendu bien meilleur.

Ashish Vaswani : Durant mes études, j’ai appris quelques leçons difficiles, surtout quand je travaillais sur la traduction automatique. J’ai réalisé : « Je ne vais pas apprendre ces règles linguistiques complexes. » Je me suis dit que la descente de gradient (Gradient Descent) – notre méthode d’entraînement des modèles – était un bien meilleur enseignant que moi. Donc, plutôt que d’apprendre les règles, je laisse la descente de gradient faire tout le travail à ma place. Voilà ma deuxième leçon.

De ces leçons difficiles, j’ai compris qu’à long terme, les architectures généralistes extensibles finissent par l’emporter. Aujourd’hui, c’est le token ; demain, ce pourraient être les actions que nous effectuons sur un ordinateur. Elles commenceront à imiter nos activités et automatiser beaucoup de nos tâches. Comme nous l’avons dit, le Transformer, et en particulier son mécanisme d’auto-attention, possède une applicabilité très large. Il améliore aussi la descente de gradient. Et puis il y a la physique : j’ai appris de Noam que la multiplication matricielle est une excellente idée.

Noam Shazeer : Ce schéma se répète constamment. Chaque fois que vous ajoutez plein de règles, la descente de gradient finit par apprendre ces règles mieux que vous. C’est tout. Exactement comme dans le deep learning : nous construisons un modèle d’IA en forme de GPU. Et maintenant, nous construisons un modèle d’IA en forme d’ordinateur quantique. Oui, l’ordinateur quantique est désormais le modèle. C’est vrai. Oui. L’ordinateur quantique, juste pour que vous sachiez, nous construisons des ordinateurs quantiques en leur donnant la forme d’un modèle.

Jensen Huang : Alors, quel était le problème que vous cherchiez à résoudre ?

Lukasz Kaiser : La traduction automatique. Cinq ans en arrière, ce processus semblait extrêmement difficile : vous collectiez des données, tentiez une traduction, mais le résultat était à peine correct. Le niveau était encore rudimentaire. Aujourd’hui, ces modèles apprennent la traduction même sans données. Vous leur donnez une langue et une autre, et ils apprennent spontanément à traduire. Cette capacité émerge naturellement, avec des résultats satisfaisants.

Llion Jones : Mais l’intuition derrière « Attention » était tout simplement ce dont nous avions besoin. J’ai donc eu l’idée du titre. En réalité, tout s’est joué quand nous cherchions un nom.

Nous faisions des analyses d’ablation, retirant des morceaux du modèle pour voir s’il empirait. À notre surprise, il s’améliorait. Enlever toutes les convolutions donnait de meilleurs résultats. Voilà d’où vient le titre.

Ashish Vaswani : Ce qui est intéressant, c’est que nous sommes partis d’un cadre minimal, puis avons ajouté des éléments : des convolutions, que nous avons ensuite retirées, ainsi que d’autres composants essentiels comme l’attention multi-têtes.

Jensen Huang : Qui a trouvé le nom « Transformer » ? Pourquoi ce nom ?

Jakob Uszkoreit : Nous aimions ce nom, nous l’avons choisi un peu au hasard, trouvant qu’il avait de la créativité. Il changeait notre mode de production de données, utilisait une telle logique. Tout apprentissage automatique est un transformateur, un perturbateur.

Noam Shazeer : Nous n’y avions pas pensé initialement. Ce nom est particulièrement simple, et beaucoup le trouvent excellent. J’avais envisagé d’autres noms, comme Yaakov, mais nous avons finalement retenu « Transformer ». Il décrit bien le principe du modèle : il transforme effectivement tout le signal. Selon cette logique, presque tout l’apprentissage automatique serait transformé.

Llion Jones : Le nom « Transformer » est devenu familier non seulement pour la traduction, mais parce que nous souhaitions décrire cette transformation de manière plus globale. Je ne pense pas que nous ayons fait preuve d’un talent exceptionnel, mais en tant que perturbateur, moteur et moteur logique, cela avait du sens. Les gens ont pu comprendre ce grand modèle, ce moteur, cette logique. Sur le plan architectural, c’était une période précoce.

Mais nous avons vraiment réalisé que nous essayions de créer quelque chose d’extrêmement universel, capable de transformer n’importe quoi en n’importe quoi. Et je ne pense pas que nous ayons anticipé à quel point le Transformer fonctionnerait bien sur les images. C’était un peu surprenant. Pour vous, cela semble logique, mais en réalité, vous pouvez découper une image en morceaux et étiqueter chaque petit point, n’est-ce pas ? Je pense que cette idée existait déjà architecturalement.

Ainsi, lorsque nous avons construit la bibliothèque tenseur-à-tenseur, notre objectif principal était d’agrandir l’échelle de l’entraînement autorégressif. Ce n’était pas seulement pour le langage, mais aussi pour les composants d’image et d’audio.

Donc Lukasz disait qu’il faisait de la traduction. Je pense qu’il se sous-estimait. Toutes ces idées, nous commençons maintenant à voir ces motifs s’unifier, ils rejoignent tous le modèle.

Mais en réalité, tout était déjà là, ces idées se diffusaient, cela a pris du temps. L’objectif de Lukasz était que nous disposions de toutes ces bases de données académiques, passant de l’image au texte, du texte à l’image, de l’audio au texte, du texte au texte. Nous devrions tout entraîner ensemble.

Cette idée a réellement propulsé le travail d’extension, qui a finalement réussi. C’est si fascinant que nous puissions traduire des images en texte, du texte en images, du texte en texte.

Vous l’utilisez pour la biologie, ou les logiciels biologiques, qui ressemblent peut-être à des logiciels informatiques : ils commencent sous forme de programme, puis sont compilés pour s’exécuter sur GPU.

La vie d’un logiciel biologique commence par une spécification de comportement. Par exemple, vous voulez imprimer une protéine spécifique, comme celles présentes dans les cellules. Ensuite, vous apprenez à utiliser le deep learning pour la convertir en molécule d’ARN, qui, une fois entrée dans la cellule, produit ce comportement. Donc cette idée va bien au-delà de la simple traduction en anglais.

Jensen Huang : Avez-vous créé un grand laboratoire pour produire tout cela ?

Aidan Gomez : Beaucoup est disponible, encore ouvert, car ces données sont souvent financées par des fonds publics. Mais en pratique, vous avez toujours besoin de données pour bien illustrer le phénomène étudié.

Par exemple, modéliser un produit comme l’expression protéique ou les vaccins à ARNm. À Palo Alto, nous avons une grande équipe de robots et de personnes en blouse blanche, des chercheurs en apprentissage automatique mais aussi d’anciens biologistes.

Nous nous considérons comme des pionniers de nouvelles approches, créant activement ces données et validant les modèles de conception moléculaire. Mais l’idée initiale était la traduction.

Jensen Huang : L’idée initiale était la traduction automatique. Je voudrais savoir : quels ont été les nœuds clés dans le renforcement et la rupture de l’architecture ? Et comment ont-ils influencé la conception du Transformer ?

Aidan Gomez : Au fil du chemin, avez-vous vu de véritables contributions supplémentaires majeures au-dessus du design de base du Transformer ? Je pense qu’il y a eu beaucoup de travaux sur l’inférence pour accélérer ces modèles et les rendre plus efficaces.

Cela me met encore un peu mal à l’aise, car notre forme originale reste si similaire. Je pense que ce monde a besoin de quelque chose de meilleur que le Transformer. Je crois que nous espérons tous ici qu’il sera remplacé par autre chose, nous menant vers un nouveau plateau de performance.

Je voudrais poser une question à chacun d’entre vous : que pensez-vous qui viendra ensuite ? Car c’est excitant, mais trop similaire à ce qu’on faisait il y a 6-7 ans, non ?

Llion Jones : Oui, les gens seront surpris par le degré de similarité, n’est-ce pas ? On me demande souvent ce qui viendra ensuite, parce que je suis coauteur de cet article. Comme par magie, tu agites ta baguette, et que va-t-il apparaître ? Je veux souligner comment ce principe précis a été conçu. Nous ne devons pas seulement devenir meilleurs, nous devons devenir nettement meilleurs.

Car si c’est seulement un peu mieux, cela ne suffira pas à pousser toute l’industrie de l’IA vers du nouveau. Nous sommes donc coincés sur le modèle original, même s’il n’est techniquement pas la chose la plus puissante dont nous disposons actuellement.

Mais chacun sait quel outil personnel il veut : une meilleure fenêtre contextuelle, une génération plus rapide de tokens. Bon, je ne sais pas si vous apprécierez cette réponse, mais ils utilisent actuellement trop de ressources de calcul. Beaucoup de calculs sont gaspillés. Nous travaillons à améliorer l’efficacité. Merci.

Jensen Huang : Je pense que nous rendons tout cela plus efficace. Merci !

Jakob Uszkoreit : Mais je pense que c’est surtout une question d’allocation des ressources, pas du total consommé. Par exemple, nous ne voulons pas dépenser trop pour un problème facile, ni trop peu sur un problème difficile au risque de ne jamais trouver de solution.

Illia Polosukhin : Prenons l’exemple de 2+2 : si vous l’entrez correctement dans le modèle, il utilisera un billion de paramètres. Je pense donc que le calcul adaptatif sera l’une des prochaines étapes obligatoires : savoir combien de ressources allouer à un problème donné.

Aidan Gomez : Nous savons combien de capacité de génération possèdent actuellement les ordinateurs. Je pense que c’est là-dessus qu’il faut concentrer les efforts. C’est un changement cosmique, la tendance de l’avenir.

Lukasz Kaiser : Ce concept existait avant le Transformer et a été intégré au modèle. En réalité, je ne suis pas sûr que vous sachiez que nous n’avons pas réussi notre objectif initial. Nous avons commencé ce projet pour simuler l’évolution des tokens. Ce n’est pas seulement un processus linéaire de génération, mais une évolution progressive du texte ou du code. Nous itérons, nous éditons, ce qui permet non seulement d’imiter la façon dont les humains développent un texte, mais aussi d’en faire partie intégrante. Car si vous générez naturellement comme un humain, ils peuvent réellement donner un retour, n’est-ce pas ?

Nous avons tous lu les articles de Shannon. Notre idée initiale était de se concentrer uniquement sur la modélisation du langage et la perplexité, mais cela n’a pas abouti. Je pense que c’est là que nous pouvons aller plus loin. Cela concerne aussi la façon dont nous organisons intelligemment les ressources de calcul aujourd’hui, organisation qui s’applique maintenant au traitement d’images. Par exemple, les modèles de diffusion ont une propriété intéressante : ils peuvent affiner et améliorer continuellement la qualité par itération. Nous n’avons pas encore cette capacité.

Je veux dire, cette question fondamentale : quelles connaissances doivent être intégrées au modèle, et lesquelles doivent rester à l’extérieur ? Utilise-t-on un modèle de récupération ? Le modèle RAG (Retrieval-Augmented Generation) en est un exemple. De même, concernant le raisonnement : quelles tâches doivent être exécutées par un système symbolique externe, et lesquelles directement dans le modèle ? C’est largement une discussion sur l’efficacité. Je crois que les grands modèles finiront par apprendre à faire 2+2, mais si vous calculez 2+2 en additionnant les chiffres un par un, c’est clairement inefficace.

Jensen Huang : Si l’IA doit simplement calculer 2+2, elle devrait utiliser directement une calculatrice, avec le minimum d’énergie, car nous savons que c’est l’outil le plus efficace. Mais si quelqu’un demande à l’IA : comment as-tu pris la décision que 2+2=4 ? Sais-tu que c’est la bonne réponse ? Cela pourrait consommer énormément de ressources ?

Noam Shazeer : Absolument. Vous avez mentionné un exemple, mais je suis convaincu que les systèmes d’IA développés par chacun ici sont suffisamment intelligents pour utiliser activement une calculatrice.

Actuellement, le produit global public (GPP) fait exactement cela. Je pense que les modèles actuels sont encore trop économiques, et trop petits. Ils sont bon marché grâce à des technologies comme celles de NV, merci pour leur production.

Le coût de calcul par opération est d’environ 10 à 18 dollars. Ou à peu près ce niveau. Merci d’avoir rendu disponibles autant de ressources de calcul. Mais si vous observez un modèle de cinq cents milliards de paramètres, effectuant mille milliards d’opérations par token, cela revient à environ un dollar le million de tokens, soit 100 fois moins cher que d’acheter un livre broché et de le lire. La valeur de nos applications excède d’un million de fois ou plus celle du calcul efficace sur de grands réseaux neuronaux. Je veux dire, elles sont sans aucun doute plus précieuses que des choses comme guérir le cancer, mais pas seulement.

Ashish Vaswani : Je pense que rendre le monde plus intelligent, c’est aussi obtenir un retour du monde. Pouvons-nous réaliser un traitement parallèle multi-tâche, multi-lignes ? Si vous voulez vraiment construire un tel modèle, c’est une excellente manière d’y parvenir.

Jensen Huang : Pouvez-vous brièvement expliquer pourquoi vous avez fondé vos entreprises ?

Ashish Vaswani : Dans notre entreprise, notre objectif est de construire des modèles et de résoudre de nouvelles tâches. Notre travail consiste à comprendre les objectifs et contenus des tâches, et à répondre aux besoins des clients à mesure que ces contenus évoluent. En réalité, dès 2021, j’ai constaté que le plus gros problème des modèles n’était pas seulement de les rendre plus intelligents, mais aussi de trouver les bons talents pour les interpréter. Nous voulons que le monde et les modèles fusionnent, rendant les modèles plus vastes et plus excellents. Certains progrès sont nécessaires durant l’apprentissage, ce qui ne peut

Bienvenue dans la communauté officielle TechFlow

Groupe Telegram :https://t.me/TechFlowDaily

Compte Twitter officiel :https://x.com/TechFlowPost

Compte Twitter anglais :https://x.com/BlockFlow_News