Entretien avec le directeur des opérations d'io.net : « Nous voulons concurrencer AWS en offrant des GPU décentralisés plus accessibles » (avec tutoriel de distribution gratuite)

TechFlow SélectionTechFlow Sélection

Entretien avec le directeur des opérations d'io.net : « Nous voulons concurrencer AWS en offrant des GPU décentralisés plus accessibles » (avec tutoriel de distribution gratuite)

Nous souhaitons incarner l'esprit de Web3 tout en battant AWS et GCP.

Rédaction : AYLO

Traduction : TechFlow

Généré par BC8.AI, une plateforme soutenue par io.net

Aujourd’hui, je vous propose un entretien avec un autre projet que j’apprécie particulièrement.

Ce projet touche à plusieurs domaines verticaux actuellement très porteurs : IA + DePin + Solana.

io.net Cloud est un réseau informatique décentralisé de pointe qui permet aux ingénieurs en apprentissage automatique d’accéder à des grappes de cloud distribuées à un coût bien inférieur à celui des services centralisés.

J’ai discuté avec le directeur des opérations, Tory Green, pour en savoir plus.

Le jeton IO sera bientôt lancé sur Solana, et je vous recommande vivement de lire cet article. J’inclurai également des informations sur la façon de participer au airdrop (à la fin de l’article).

Je suis investisseur privé dans io.net et je crois fermement en leur plateforme, car leur solution de regroupement de GPU est vraiment unique.

Présentation de io.net

-

Un AWS décentralisé pour l'entraînement ML (machine learning) sur GPU

-

Accès instantané et sans autorisation à un réseau mondial de GPU et CPU, déjà disponible

-

Ils disposent de 25 000 nœuds

-

Technologie révolutionnaire permettant de regrouper des clusters de GPU dans le cloud

-

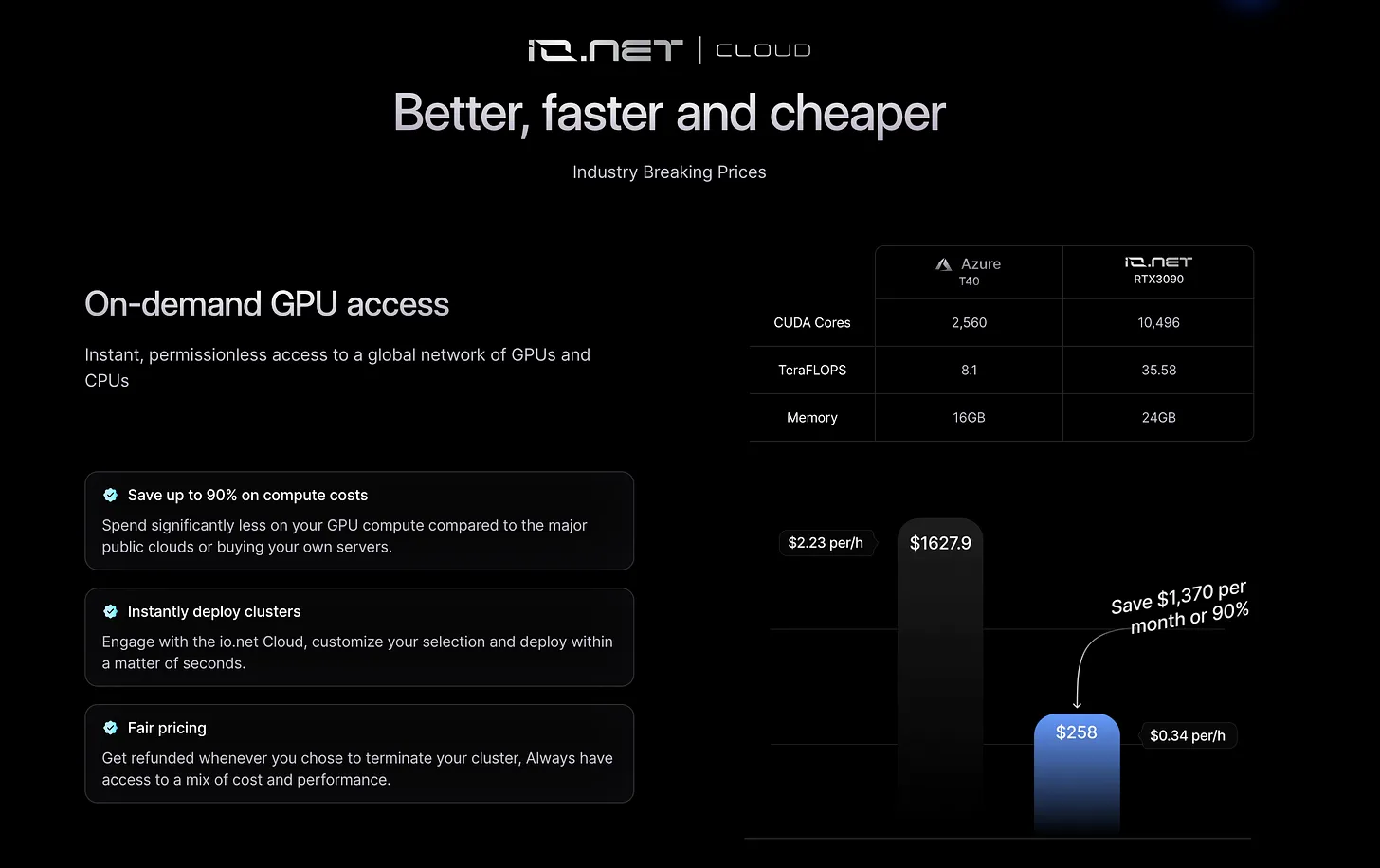

Peut faire économiser jusqu'à 90 % des coûts de calcul aux grandes startups d'IA

-

Intègre Render et Filecoin

-

Basé sur Solana

Ils viennent d'annoncer un financement de 30 millions de dollars, attirant les plus grands soutiens du secteur.

Pourquoi devrait-on s'intéresser à io.net ?

Nous ne concurrençons pas seulement d'autres projets cryptographiques, mais aussi le cloud computing. L'un des principaux avantages que nous offrons à nos clients est un prix nettement inférieur, pouvant aller jusqu'à 90 % moins cher. Ce que nous proposons réellement, c'est un choix pour les consommateurs, ce qui est véritablement intéressant. Oui, sur notre plateforme, vous pouvez obtenir des GPU à 90 % moins cher, et je vous encourage vivement à l'essayer. Vous avez accès à des GPU grand public entièrement décentralisés à bas prix avec une remise substantielle. Cependant, si vous avez besoin de performances élevées, vous pouvez recréer une expérience similaire à AWS en utilisant du matériel haut de gamme comme l'A100, peut-être 30 % moins cher, mais toujours moins coûteux qu'AWS. Dans certains cas, nous offrons même de meilleures performances qu'AWS, ce qui peut être crucial pour des industries spécifiques telles que les hedge funds.

Pour l'un de nos principaux clients, nous proposons un service 70 % moins cher qu'AWS et 40 % moins cher que ce qu'il obtient ailleurs. Notre plateforme est conviviale et sans autorisation, contrairement à AWS, qui peut exiger des détails tels qu’un plan commercial. N’importe qui peut s’inscrire et lancer immédiatement un cluster, alors qu’avec AWS cela peut prendre plusieurs jours ou semaines.

Comparé aux concurrents décentralisés, si vous essayez d'obtenir un cluster sur des plateformes comme Akash, vous constaterez que ce n'est pas instantané. Elles ressemblent davantage à des agences de voyage, appelant leurs centres de données pour trouver des GPU disponibles, ce qui peut prendre plusieurs semaines. Chez nous, c’est instantané, moins cher et sans autorisation. Nous voulons incarner l’esprit Web3 tout en battant AWS et GCP.

Quel est le plan stratégique pour 2024 ?

Il se divise en deux axes : commercial et technique. Du point de vue commercial, le TGE approche. Nous prévoyons d’organiser un sommet cette année où nous annoncerons de nombreuses nouveautés liées au produit. Nous restons concentrés sur le développement du réseau, car malgré l’excitation autour du TGE, nous nous considérons comme une entreprise légitime et un véritable concurrent d'AWS.

Nous continuerons à renforcer fortement notre équipe commerciale. Nous souhaitons imiter des entreprises comme Chainlink et Polygon, en recrutant des cadres commerciaux expérimentés provenant d'entreprises comme Amazon et Google, afin de constituer une équipe commerciale de niveau mondial. Cela nous aidera à attirer des clients IA et à établir des partenariats avec des entités telles que Hugging Face et Prettybase.

Notre clientèle initiale comprend de grandes startups d’IA confrontées à des coûts élevés de calcul IA. Je fais partie d’une équipe de direction financière technologique dans la Silicon Valley, et l’un des principaux problèmes est justement le coût élevé du calcul IA. Une startup SaaS en série A dépense 700 000 dollars par mois en calcul IA, ce qui n’est pas durable. Notre objectif est de réduire significativement les coûts pour des entreprises comme celle-ci.

Une fois que nous aurons prouvé l’efficacité de notre solution auprès de ces premiers clients, nous explorerons les marchés adjacents. Nous disposons sur notre réseau de deux GPU conformes SOC, ce qui nous permet de cibler de grandes entreprises technologiques ou des sociétés comme JPMorgan Chase ou Procter & Gamble, qui possèdent certainement leurs propres départements internes d’intelligence artificielle. Notre technologie prend en charge des clusters allant jusqu’à 500 000 GPU, ce qui pourrait nous permettre de dépasser AWS ou GCP en termes de capacité, car ils ne peuvent pas déployer physiquement autant de GPU sur un seul site. Cela pourrait attirer des projets IA majeurs comme OpenAI pour les futures versions de GPT. Toutefois, construire un marché nécessite d’équilibrer offre et demande ; nous avons actuellement 25 000 GPU sur le réseau, contre une liste d’attente de 200 000. Avec le temps, notre objectif est d’étendre le réseau pour répondre à la demande croissante. Voilà pour la feuille de route commerciale.

Sur le plan technique, il y a évidemment beaucoup de travail à accomplir. Actuellement, nous prenons en charge Ray, ainsi que Kubernetes, que nous développons activement. Mais comme mentionné précédemment, nous envisageons d’étendre notre produit. En considérant la manière dont fonctionne l’IA, par exemple lorsque vous utilisez ChatGPT, cela correspond à une application, tandis que ChatGPT repose sur un modèle, lui-même basé sur GPT-3, qui exécute toutes ses inférences sur des GPU. Nous pouvons donc commencer par les GPU et construire progressivement toute la pile.

Nous collaborons également avec Filecoin, et de nombreux centres de données partenaires disposent déjà de grandes quantités de CPU et de stockage, ce qui nous permet également de stocker des modèles. Cela nous permettrait d’offrir du calcul, du stockage de modèles et des SDK destinés à créer des applications, créant ainsi un écosystème d’intelligence artificielle entièrement décentralisé, presque comme un App Store décentralisé.

Quel rôle joue le jeton dans le réseau ?

À un niveau élevé, il s’agit d’un jeton utilitaire utilisé pour payer le calcul sur le réseau. C’est l’explication la plus simple. Je vous recommande également de consulter le site bc8.ai.

C’est une preuve de concept que nous avons développée, un clone de Stable Diffusion, que je crois être actuellement la seule application IA entièrement sur chaîne. Les utilisateurs peuvent effectuer de petites transactions via Solana pour générer des images en payant par cryptomonnaie. Chaque transaction rémunère quatre parties prenantes clés impliquées dans la création de l'image : le créateur de l'application, le créateur du modèle, nous-mêmes et le GPU utilisé. Pour l'instant, nous permettons aux gens de l'utiliser gratuitement, car nous sommes à la fois propriétaires de l'application et du modèle, mais ceci reste surtout une démonstration de concept plutôt qu'une activité commerciale réelle.

Nous prévoyons d'étendre le réseau afin que d'autres puissent héberger des modèles et créer des applications d'IA entièrement décentralisées. Le jeton IO alimentera non seulement nos modèles, mais aussi tous les modèles créés par d'autres. L'économie du jeton est encore en cours de finalisation et pourrait être annoncée vers avril.

Pourquoi avoir choisi Solana ?

Je pense qu’il y a deux raisons. Premièrement, nous apprécions sincèrement cette communauté. Deuxièmement, franchement, c’est la seule blockchain capable de nous supporter. Si vous examinez notre analyse des coûts, chaque fois qu’une inférence est effectuée, environ cinq transactions sont générées. Vous avez l’inférence elle-même, puis les paiements aux différentes parties prenantes. Donc, lorsqu’on fait une analyse des coûts avec 60 000, 70 000, voire 100 000 transactions, chacune doit coûter un centième ou un dixième de cent. Compte tenu de notre volume de transactions, Solana est pratiquement notre seule option. En outre, ils ont été très coopératifs en tant que partenaires, et la communauté est extrêmement forte. Ce fut presque un choix évident.

Quelle est selon vous la taille de votre marché ?

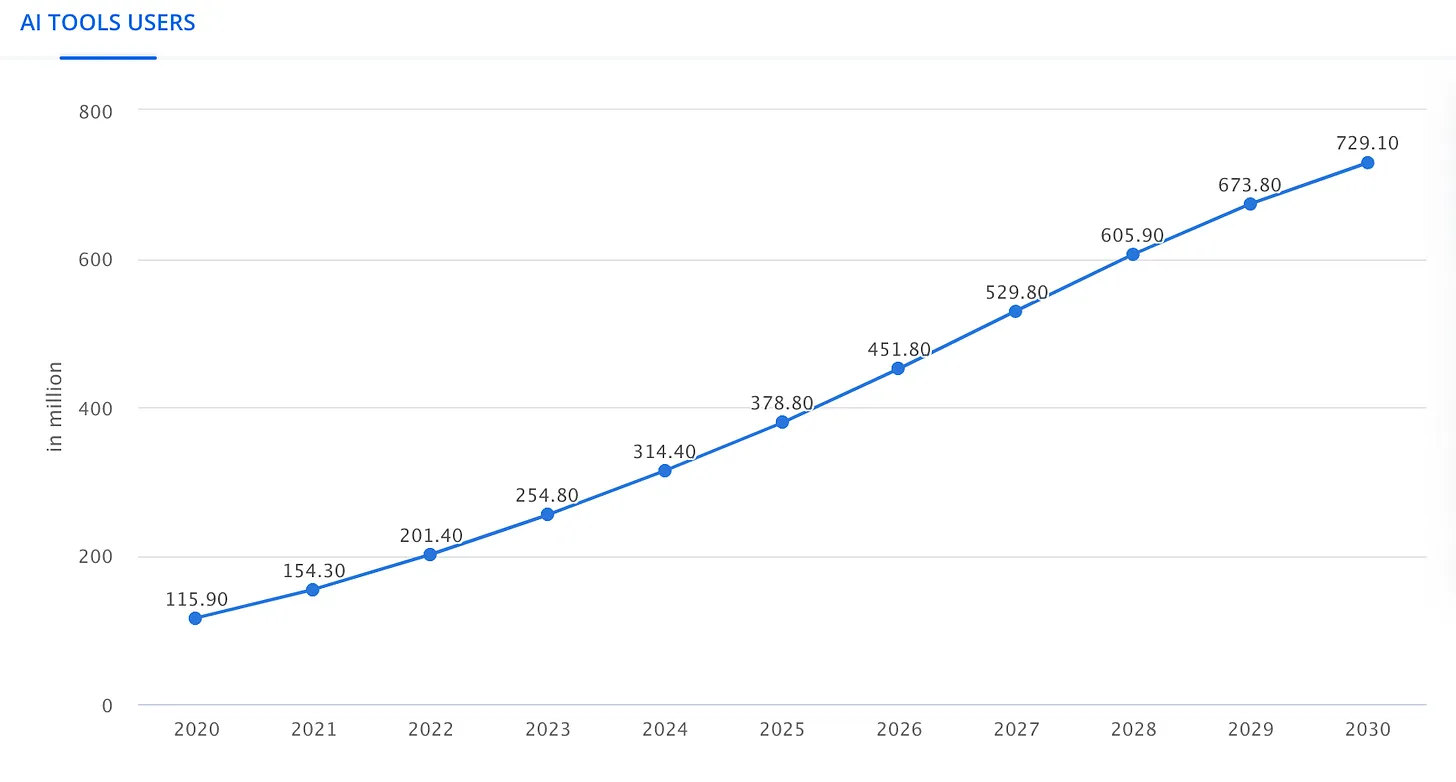

Je pense que c’est impossible à prédire, vous savez. Nous parlons de chiffres comme un millier de milliards, mais même ainsi, il est difficile de saisir pleinement l’étendue totale. Par exemple, les prévisions de sociétés comme Gartner indiquent qu’en 2030, l’entraînement des modèles pourrait représenter 1 % du PIB, soit environ 300 milliards de dollars. Cette statistique est relativement facile à trouver. Cependant, lorsque le PDG de Nvidia mentionne que le marché de l’IA n’utilise que 10 % pour l’entraînement, notre perspective change. Si l’inférence et l’entraînement combinés représentent un marché de 300 milliards de dollars, alors tout le marché des GPU pour l’IA, rien que pour les services de calcul, pourrait atteindre 3 000 milliards de dollars. Ensuite, Kathy Wood prévoit que le marché global de l’IA pourrait atteindre 80 000 milliards de dollars. Cela montre que l’ampleur potentielle du marché dépasse presque notre compréhension.

Quel est selon vous le principal obstacle au développement de io.net ?

Construire un marché est difficile, et bien que cela puisse être plus aisé dans le domaine de la crypto, cela comporte toujours des défis. Par exemple, la plupart de nos clients demandent des A100, un GPU haut de gamme et professionnel dont chaque unité coûte environ 30 000 dollars, et dont l’approvisionnement est limité. Actuellement, ils sont très difficiles à trouver. Notre équipe commerciale s’efforce de localiser ces GPU, ce qui constitue un défi majeur, car ils sont à la fois rares et coûteux.

Nous disposons de nombreux GPU 3090, qui sont davantage orientés grand public et suscitent moins de demande. Cela signifie que nous devons adapter notre stratégie et identifier des clients spécifiquement intéressés par ce type de GPU. Toutefois, ce genre de situation se retrouve dans tout marché, et nous la gérons en recrutant les bonnes personnes et en mettant en œuvre des stratégies marketing efficaces.

Stratégiquement parlant, comme je l'ai mentionné, notre force réside dans le fait que nous sommes actuellement la seule plateforme capable de construire des clusters décentralisés à travers différents emplacements géographiques. C’est aujourd’hui notre fossé protecteur. À court terme, nous bénéficions d’un avantage concurrentiel significatif, que je pense étendre à moyen terme. Pour des partenaires comme Render, s’ils peuvent utiliser notre réseau et conserver 95 % de la valeur, il n’y a aucun intérêt à copier notre modèle.

L’équipe a mis environ deux ans pour développer cette fonctionnalité. Ce n’est donc pas chose aisée. Bien sûr, à l’avenir, quelqu’un d’autre pourrait trouver une solution similaire. D’ici là, nous espérons avoir suffisamment creusé notre fossé. Nous sommes déjà le plus grand réseau de GPU décentralisé en termes d’ordre de grandeur, avec 25 000 GPU, contre 300 chez Akash et quelques milliers chez Render.

Notre objectif est d’atteindre 100 000 GPU et 500 clients, créant ainsi un effet de réseau similaire à Facebook. La question devient alors « Où d’autre pourriez-vous aller ? ». Notre but est de devenir la plateforme incontournable pour toute personne ayant besoin de calcul GPU, tout comme Uber domine le covoiturage et Airbnb l’hébergement. L’essentiel est d’agir rapidement pour assurer notre position sur le marché et devenir synonyme de calcul GPU décentralisé.

Comment obtenir le airdrop IO ?

Deux méthodes principales permettent d’être éligible au airdrop IO :

-

Ils organisent une campagne Galxe intitulée « Ignition ». Vous devez simplement accomplir certaines tâches. Il vous sera demandé de prouver que vous êtes humain en frappant un passeport Galxe, ce qui est excellent car cela ne peut pas être falsifié.

-

Fournissez votre GPU/CPU à io.net. Il suffit de suivre les instructions indiquées dans la documentation. Même si vous n’êtes pas technique, cela prend environ 10 à 15 minutes et est assez simple.

Bienvenue dans la communauté officielle TechFlow

Groupe Telegram :https://t.me/TechFlowDaily

Compte Twitter officiel :https://x.com/TechFlowPost

Compte Twitter anglais :https://x.com/BlockFlow_News