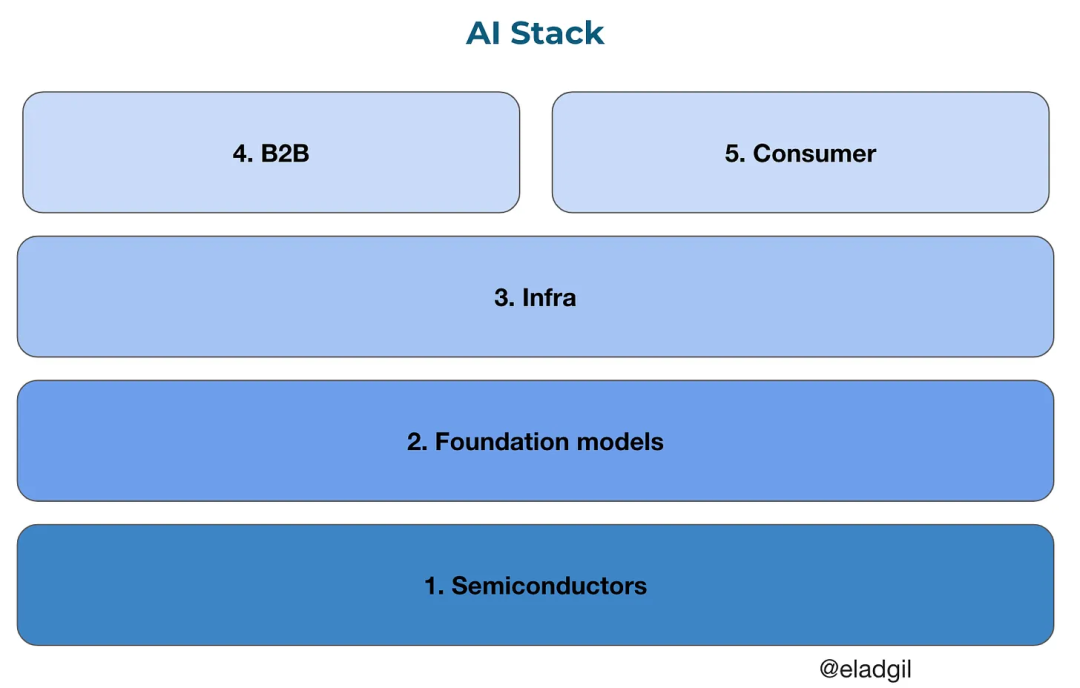

Problèmes fondamentaux non encore résolus concernant les modèles, l'infrastructure et les applications

TechFlow SélectionTechFlow Sélection

Problèmes fondamentaux non encore résolus concernant les modèles, l'infrastructure et les applications

Existe-t-il un « plafond du capital », c'est-à-dire une limite au-delà de laquelle seules les grandes entreprises peuvent supporter le coût élevé des modèles de pointe ?

Rédaction : Elad

Dans la plupart des domaines, le passage du temps nous permet d'acquérir une vision plus claire des choses. Mais dans le domaine de l'intelligence artificielle générative, il se pourrait que ce soit exactement l'inverse. Nous pensons que ce domaine en est encore à un stade très précoce, extrêmement complexe en raison des nouveaux paramètres, modalités et changements systémiques. Dans cette phase exploratoire initiale, trier parmi la masse d'informations, avancer dans l'incertitude, identifier des voies possibles et approfondir notre réflexion sont des efforts constants auxquels nous nous livrons.

Elad est un entrepreneur en série, ainsi qu’un investisseur précoce auprès de sociétés renommées telles qu’Airbnb, Coinbase, Figma, Notion ou Pinterest. Cet article présente les questions non résolues qu’il a récemment identifiées concernant les LLMs, la couche infrastructurelle et celle des applications IA. Il s’agit d’un contenu riche et profond – n’hésitez pas à en discuter et à partager vos retours.

Les grandes entreprises technologiques ont façonné le paysage du marché des LLMs grâce à des investissements massifs, soulevant ainsi une question cruciale : dans un tel environnement, comment les jeunes pousses et développeurs indépendants peuvent-ils trouver leur place ? Existe-t-il un « plafond financier », au-delà duquel seules les grandes entreprises seraient capables d’assumer le coût élevé des modèles de pointe ?

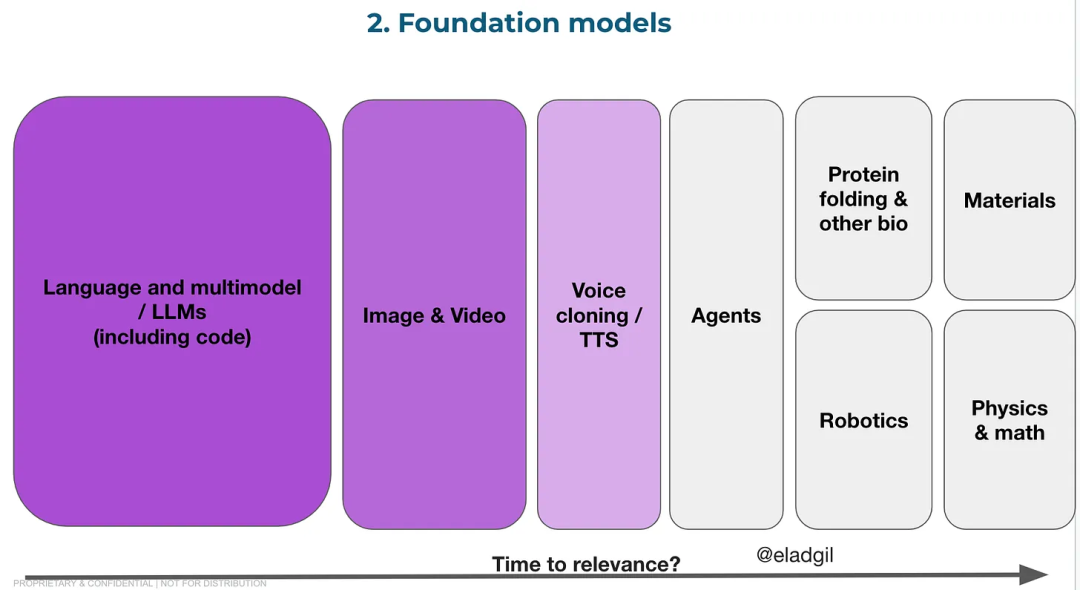

Les modèles open source comme Llama et Mistral jouent également un rôle important dans l’écosystème des LLMs. Ils constituent un contrepoids aux modèles propriétaires, favorisant la diffusion technologique et l’innovation. Toutefois, les restrictions liées à leur utilisation commerciale et leur viabilité à long terme restent des défis majeurs pour ces grands modèles open source.

01. Questions autour des LLM

D’un certain point de vue, il existe deux types de LLM : ceux à la pointe technologique (comme GPT-4), et tous les autres. En 2021, Elad avait prédit que, en raison des besoins colossaux en capital, le marché des modèles de pointe évoluerait progressivement vers une oligarchie dominée par quelques rares entreprises. Parallèlement, les modèles non leaders seraient davantage pilotés par le prix, tandis que l’influence des modèles open source s’accroîtrait.

La situation actuelle semble suivre cette trajectoire. Le marché des LLM de pointe risque fort de devenir oligopolistique, avec des concurrents tels qu’OpenAI, Google ou Anthropic (modèles fermés), ainsi que Llama (Meta) et Mistral (open source). Bien que cette liste puisse évoluer légèrement dans les un ou deux prochaines années, le coût croissant de l’entraînement des modèles leaders contraste fortement avec la baisse annuelle du coût des autres modèles généraux, dont les performances continuent pourtant de progresser. Aujourd’hui, le coût d’entraînement d’un modèle équivalent à GPT-3.5 pourrait être cinq fois moindre qu’il y a deux ans.

À mesure que les modèles gagnent en taille, les financements proviennent de plus en plus des fournisseurs de cloud et des géants technologiques. Microsoft a investi plus de 10 milliards de dollars dans OpenAI, tandis qu’Anthropic a levé 7 milliards de dollars auprès d’Amazon et de Google. NVIDIA est également un investisseur majeur dans ce secteur. Comparés à ces montants, les fonds issus du capital-risque semblent dérisoires. Avec la hausse exponentielle du coût d’entraînement des modèles leaders, les nouveaux bailleurs de fonds proviennent principalement des grandes entreprises technologiques ou des gouvernements nationaux désireux de soutenir leurs champions locaux, comme les Émirats arabes unis. Cette tendance façonne déjà le marché et pourrait préciser prématurément qui seront les futurs gagnants.

Ces investissements des fournisseurs de cloud ne représentent toutefois qu’une infime partie de leurs revenus. Par exemple, Azure génère 25 milliards de dollars de revenus par trimestre ; les 10 milliards de dollars investis dans OpenAI correspondent à peine à six semaines de chiffre d’affaires d’Azure. Pourtant, l’IA a un impact considérable sur les revenus d’Azure : sa croissance récente a été boostée de 6 points par l’IA, ce qui représente entre 5 et 6 milliards de dollars supplémentaires par an. Même si ces revenus ne se traduisent pas directement en bénéfices nets, cela reste impressionnant et montre que ces grands fournisseurs de cloud ont tout intérêt à financer davantage de grands modèles. De son côté, Meta ne doit pas être sous-estimée : elle a récemment annoncé un budget de 20 milliards de dollars pour financer l’entraînement de grands modèles.

Quelques questions fondamentales autour des LLMs

Les fournisseurs de cloud utilisent-ils leur puissance de calcul et leurs capitaux pour créer un petit nombre de joueurs dominants, verrouillant ainsi un marché oligopolistique ? Que se passera-t-il lorsque ces fournisseurs cesseront de financer de nouvelles startups LLM pour concentrer leurs ressources sur les acteurs existants ? Les fournisseurs de cloud sont désormais les principaux financeurs des modèles de base, bien plus que le capital-risque. Compte tenu de leurs limitations en matière de fusions-acquisitions et du fait que l’utilisation de leurs services cloud génère des revenus, cette stratégie est logique. Mais cela pourrait introduire certaines distorsions dans la dynamique du marché. Quelles en seront les conséquences à long terme sur l’économie et la structure du marché des LLM ? Cela signifie-t-il que nous verrons bientôt disparaître de nombreuses nouvelles startups LLM faute de capitaux suffisants ou de talents disponibles ?

Les modèles open source (OSS) vont-ils transformer l’économie de l’IA, en recentrant la valeur depuis les modèles de base vers le cloud computing ? Meta continuera-t-elle à financer ses modèles open source ? Si oui, Llama-N réussira-t-il à rattraper les modèles les plus avancés ? Un modèle open source performant à la pointe de l’IA pourrait bouleverser l’architecture de l’infrastructure IA, en déplaçant la valeur du LLM vers les fournisseurs de cloud et de services d’inférence, réduisant ainsi les revenus des entreprises basées sur des modèles LLM propriétaires.

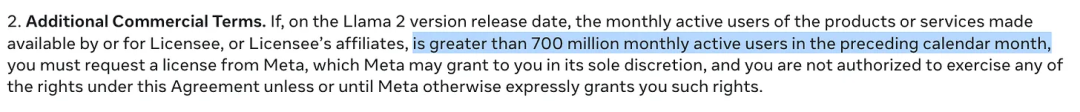

La licence de Llama2 inclut une clause selon laquelle toute utilisation commerciale est autorisée tant que l’utilisateur final compte moins de 700 millions d’utilisateurs. Cela empêche certains grands concurrents d’utiliser ce modèle. Un grand fournisseur de cloud devrait ainsi payer des frais de licence à Meta pour utiliser Llama. Cela crée pour Meta un mécanisme durable de contrôle et de monétisation de Llama.

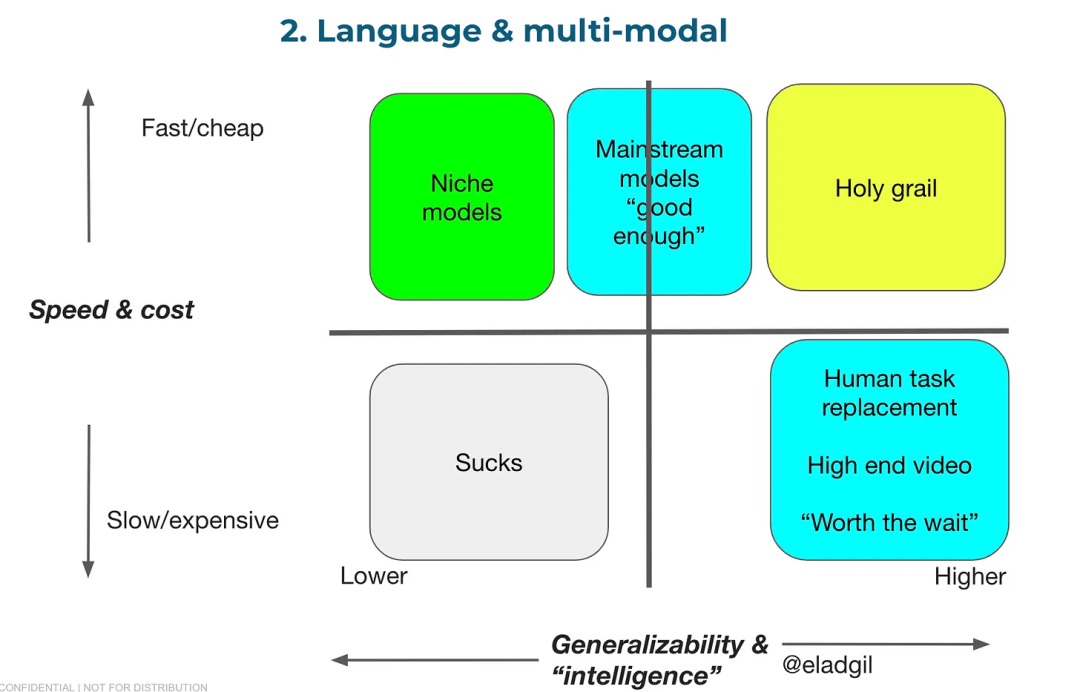

Comment analyser la relation entre prix et performance des modèles ? Comparé à la vitesse d’un humain moyen pour accomplir une tâche, un modèle lent mais très performant peut avoir une grande valeur. Le dernier modèle Gemini semble aller dans cette direction, avec une fenêtre contextuelle dépassant le million de tokens. L’augmentation de la longueur du contexte et la profondeur de compréhension peuvent transformer la manière dont les utilisateurs perçoivent les usages de l’IA. À l’autre extrémité du spectre, Mistral illustre la valeur des modèles compacts, rapides, peu coûteux et performants en inférence. Le tableau ci-dessous détaille cette problématique.

Comment l’architecture des modèles de base va-t-elle évoluer ? Des modèles agents dotés d’architectures différentes remplaceront-ils partiellement le potentiel futur des LLM ? Quand intégrera-t-on d’autres formes de mémoire et de raisonnement ?

Les gouvernements orientent-ils leurs achats ou subventions vers les entreprises locales leaders en IA ? Souhaitent-ils promouvoir des modèles reflétant leurs valeurs locales, leurs langues et besoins culturels spécifiques ? Outre les fournisseurs de cloud et les géants technologiques mondiaux, les États constituent une autre source potentielle de financement. Actuellement, d’excellentes entreprises de grands modèles existent en Europe, au Japon, en Inde, aux Émirats arabes unis, en Chine et ailleurs. Rien qu’avec les budgets publics, plusieurs entreprises locales de modèles IA valorisées plusieurs milliards de dollars pourraient émerger.

02. Questions sur l’infrastructure

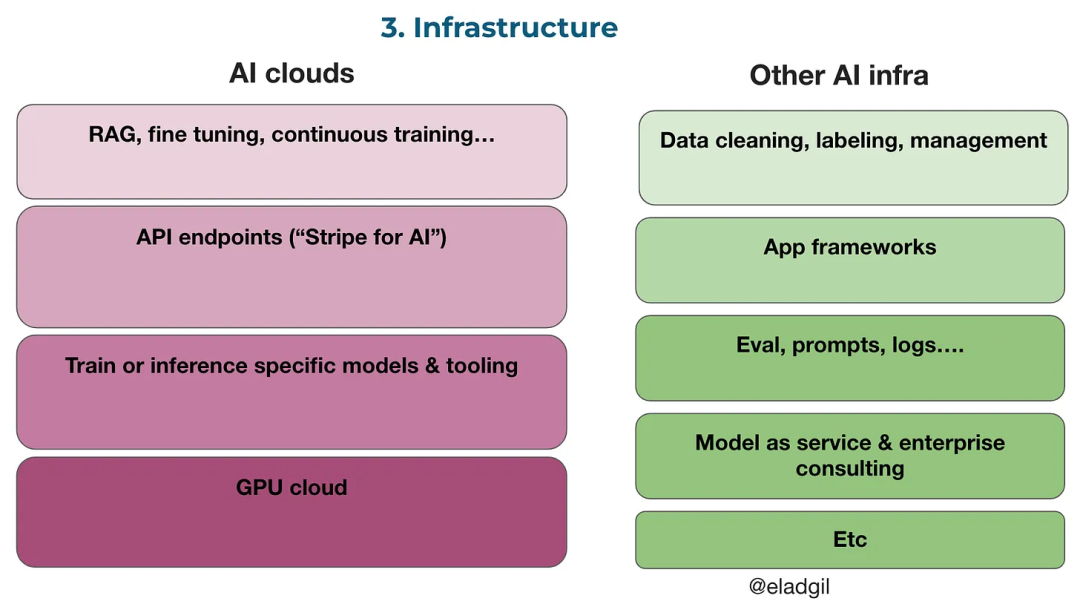

Différents types d’entreprises d’infrastructure coexistent, chacune ayant des usages variés. Braintrust, par exemple, propose des outils d’évaluation, de gestion des prompts, de journalisation et d’agents, aidant les entreprises à passer d’une analyse « intuitive » de l’IA à une approche pilotée par les données. Scale.ai et d'autres acteurs jouent un rôle clé dans l'annotation de données, l'ajustement fin (fine-tuning) et d'autres domaines.

L'une des principales incertitudes dans l'infrastructure IA concerne l'évolution de la pile cloud dédiée à l'IA. Les besoins des startups et des grandes entreprises diffèrent fortement. Pour les startups, de nouveaux fournisseurs et outils cloud (comme Anyscale, Baseten, Modal, Replicate ou Together) sont sur une bonne trajectoire, attirant clients et revenus.

Pour les grandes entreprises disposant de besoins spécifiques, plusieurs questions restent sans réponse. Par exemple : les entreprises cloud IA doivent-elles proposer une version locale / BYOC / VPN de leurs produits destinée aux grands groupes ? Ces derniers pourraient optimiser :

(a) L'utilisation de crédits cloud existants déjà budgétisés via les places de marché (ex. AWS Marketplace) ;

(b) La latence et les performances : envisageront-ils des allers-retours complets depuis l'hébergement de leurs applications/données (AWS, Azure, GCP) ?

(c) La sécurité et la conformité (FedRAMP, HIPAA, etc.).

Le marché initial des startups IA dans le cloud pourrait donc différer sensiblement des besoins à long terme des grandes entreprises.

Dans quelle mesure l'adoption des services cloud IA est-elle due à la pénurie de GPU / à l'arbitrage GPU ? En l'absence de GPU sur les principaux clouds, les entreprises se battent pour obtenir suffisamment de ressources, accélérant ainsi l'adoption des startups cloud possédant leurs propres GPU. NVIDIA pourrait adopter une stratégie consistant à prioriser l'attribution de GPU à ces nouveaux fournisseurs afin de limiter le pouvoir de négociation des hyperscalers, fragmenter le marché et stimuler l'innovation via les startups. Quand la pénurie de GPU prendra-t-elle fin, et quel impact cela aura-t-il sur les nouveaux fournisseurs de cloud IA ? La fin de la pénurie sur les plateformes majeures pourrait nuire aux entreprises dont le seul produit est le cloud GPU, tandis que celles offrant davantage d'outils et services devraient mieux traverser cette transition.

Quels autres services sont en cours d'intégration dans les offres cloud IA ? Proposent-ils des ventes croisées combinant modèles embarqués et agents génératifs réutilisables (RAG) ? Offrent-ils des mises à jour continues, des ajustements fins ou d'autres services ? Quel impact cela a-t-il sur les entreprises spécialisées dans l'annotation de données ou proposant des services similaires ? Quels services sont intégrés directement par les fournisseurs de modèles, et lesquels passent par les fournisseurs cloud ?

Dans le marché du cloud IA, quelles stratégies commerciales les différentes entreprises vont-elles adopter ?

Le monde du cloud IA comporte clairement deux segments : les startups et les entreprises moyennes/grandes. Le modèle économique « uniquement GPU » convient par défaut au segment startup, qui a moins besoin de services cloud complexes. Pour les grandes entreprises, les contraintes liées aux GPU sur les plateformes principales sont souvent plus limitantes. Ainsi, les entreprises fournissant des outils développeurs, des API, du matériel spécialisé ou d'autres services évolueront-elles vers deux modèles distincts : (a) un modèle « Snowflake/Databricks pour l’IA », ou (b) un modèle « Cloudflare pour l’IA » ? Si oui, quelles entreprises adoptent quel modèle ?

Quelle est la taille potentielle du marché émergent du cloud IA ? Peut-il atteindre l’échelle de Heroku, Digital Ocean, Snowflake ou AWS ?

Comment la pile technologique IA évolue-t-elle avec des modèles dotés de fenêtres contextuelles très longues ? Comment faut-il penser l’interaction entre la taille du contexte, l’ingénierie des prompts, l’ajustement fin, la récupération améliorée (RAG) et le coût de l’inférence ?

Comment les politiques réglementaires contre les fusions-acquisitions influencent-elles ce marché ? Une douzaine d’entreprises au moins développent actuellement des produits et services liés au cloud IA. Sous un régime gouvernemental hostile aux acquisitions dans la tech, comment les fondateurs doivent-ils repenser leurs stratégies de sortie ? Le cloud IA doit-il connaître une consolidation pour agrandir le marché et optimiser les services offerts ?

03. Questions sur les applications IA

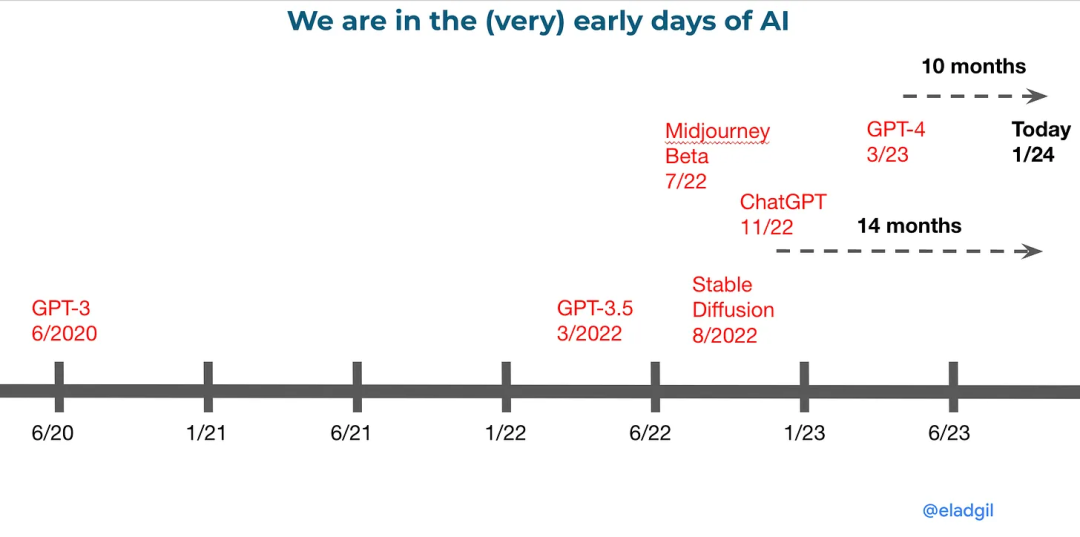

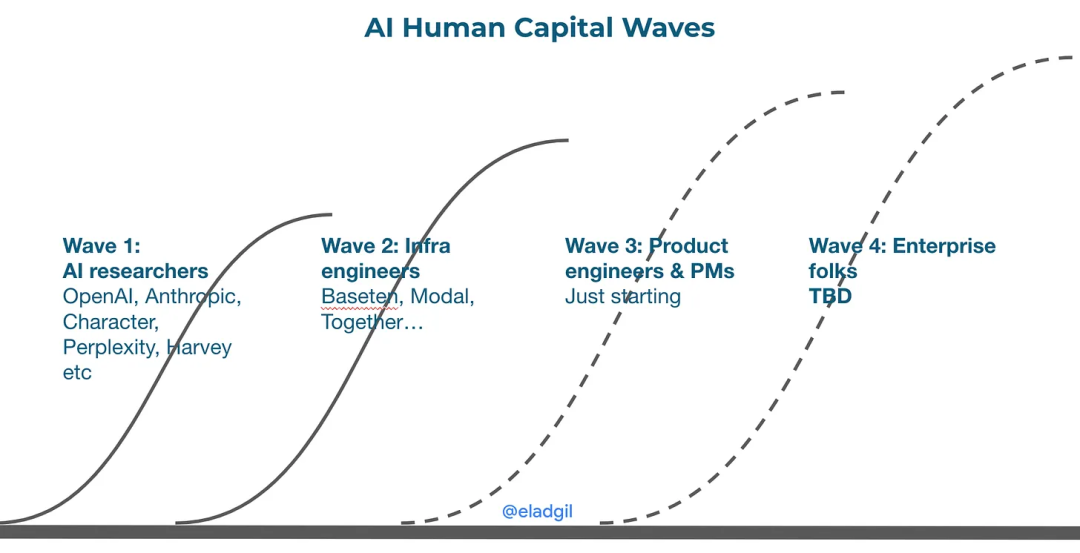

ChatGPT est le point de départ de nombreux fondateurs IA. Avant ChatGPT, et même avant Midjourney et Stable Diffusion, peu de personnes suivaient de près la révolution en cours autour des modèles Transformer et Diffusion. Ce sont les chercheurs en IA et ingénieurs infrastructure, les plus proches des modèles et technologies, qui ont été les premiers à lancer des entreprises basées sur ces avancées. Les développeurs, designers et chefs de produit éloignés de ces technologies n’ont pris conscience de l’importance de l’IA que très récemment.

ChatGPT a été lancé il y a environ 15 mois. S’il faut 9 à 12 mois pour décider de quitter son emploi, quelques mois supplémentaires pour brainstormer avec un cofondateur, puis plusieurs mois pour construire un prototype, alors selon ce calendrier, une nouvelle vague d’applications IA devrait bientôt inonder le marché.

Applications B2B : Parmi cette nouvelle vague d’applications B2B, quelles seront les entreprises et marchés importants ? Dans quels domaines les entreprises existantes créeront-elles de la valeur, et où les startups prendront-elles l’avantage ?

Grand public : Les premiers produits IA étaient des « produits pour consommateurs professionnels », utilisables à la fois dans un cadre personnel et professionnel. Des applications comme ChatGPT, Midjourney, Perplexity ou Pika en sont des exemples. Pourquoi y a-t-il si peu de produits IA conçus spécifiquement pour le grand public ? Les utilisateurs des produits sociaux de 2007-2012 semblent aujourd’hui déconnectés de l’écosystème IA. Construire des produits IA exige de nouveaux profils, des utilisateurs plus intelligents et innovants, capables de façonner ensemble la prochaine grande vague d’applications IA grand public.

Agents : Les agents IA peuvent accomplir de nombreuses tâches. Quels seront les domaines porteurs pour des produits focalisés, et quelles startups cherchent encore leurs cas d’usage ?

Voici donc une liste complète de questions essentielles à méditer dans le domaine de l’IA. Le développement de l’IA générative constitue un moment passionnant de révolution technologique que nous vivons tous. De nombreuses créations intéressantes et prometteuses nous attendent. Réfléchir à ces questions peut aider les entrepreneurs à mieux répondre aux besoins du marché et à faire progresser ce domaine.

Bienvenue dans la communauté officielle TechFlow

Groupe Telegram :https://t.me/TechFlowDaily

Compte Twitter officiel :https://x.com/TechFlowPost

Compte Twitter anglais :https://x.com/BlockFlow_News