FMG : Les trois problèmes de l'IA et la solution DePIN

TechFlow SélectionTechFlow Sélection

FMG : Les trois problèmes de l'IA et la solution DePIN

La question clé ne réside pas dans la puissance de calcul, mais dans la manière d'habiliter les produits d'intelligence artificielle.

Rédaction : FMGResearch

TL ; DR

La concurrence entre produits à l'ère de l'IA ne peut se passer des ressources (puissance de calcul, données, etc.), en particulier un soutien stable côté ressources.

L'entraînement et l'itération des modèles nécessitent également un vaste ensemble d'utilisateurs (IP) pour alimenter les données, permettant ainsi une transformation qualitative de l'efficacité du modèle.

L'intégration avec Web3 pourrait permettre aux petites et moyennes startups IA de dépasser les géants traditionnels de l'IA.

Pour l'écosystème DePIN, les ressources comme la puissance de calcul ou la bande passante fixent le niveau minimal (l'intégration pure de puissance de calcul n'offre pas de moat compétitif) ; tandis que l'application des modèles IA, leur optimisation poussée (comme BitTensor), leur spécialisation (Render, Hivemapper) et l'utilisation efficace des données déterminent le potentiel maximal du projet.

Dans le contexte de l'IA + DePIN, l'inférence et l'ajustement fin des modèles, ainsi que le marché des modèles IA sur mobile, gagneront en importance.

Analyse du marché de l’IA & trois problèmes clés

Selon certaines statistiques, entre septembre 2022, juste avant la sortie de ChatGPT, et août 2023, les 50 principaux produits d’intelligence artificielle dans le monde ont cumulé plus de 24 milliards de visites, avec une croissance mensuelle moyenne de 236,3 millions.

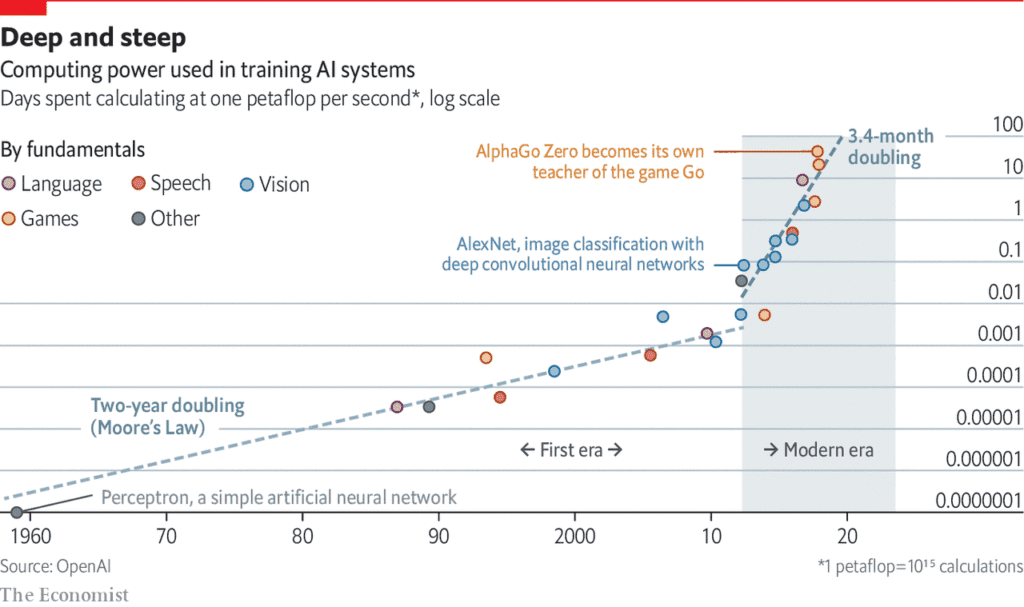

Derrière cette floraison des produits d’IA se cache une dépendance accrue à la puissance de calcul.

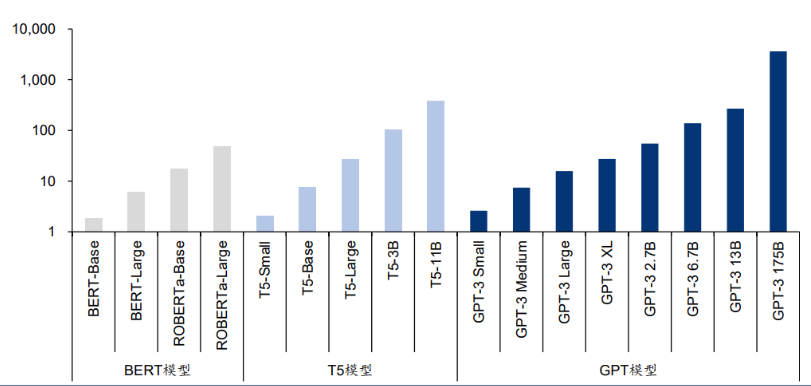

Source : Language Models are Few-Shot Learners

Un article de l'Université du Massachusetts à Amherst indique que « l'entraînement d'un modèle d'intelligence artificielle émet autant de carbone au cours de sa vie qu'une voiture pendant cinq ans ». Cette analyse ne considère toutefois qu'un seul entraînement. Lorsque les modèles sont améliorés par des entraînements répétés, la consommation d'énergie augmente considérablement.

Les derniers modèles linguistiques contiennent des milliards, voire des trillions de poids. Le modèle populaire GPT-3 possède 175 milliards de paramètres d'apprentissage automatique. En utilisant des GPU A100, il faut 1024 unités, 34 jours et 4,6 millions de dollars pour entraîner ce modèle.

La concurrence entre produits à l’ère post-IA s’est progressivement transformée en guerre des ressources, centrée principalement sur la puissance de calcul.

Source : AI is harming our planet: addressing AI’s staggering energy cost

Cela soulève trois questions : premièrement, un produit IA dispose-t-il de suffisamment de ressources (calcul, bande passante, etc.), notamment de ressources stables ? Cette fiabilité exige une décentralisation suffisante de la puissance de calcul. Dans le secteur traditionnel, en raison du déficit côté demande de puces et des barrières mondiales fondées sur des politiques et des idéologies, les fabricants de puces occupent une position dominante leur permettant d'augmenter fortement les prix. Par exemple, le prix du GPU NVIDIA H100 est passé de 36 000 $ en avril 2023 à 50 000 $, augmentant encore le coût pour les équipes d'entraînement des modèles IA.

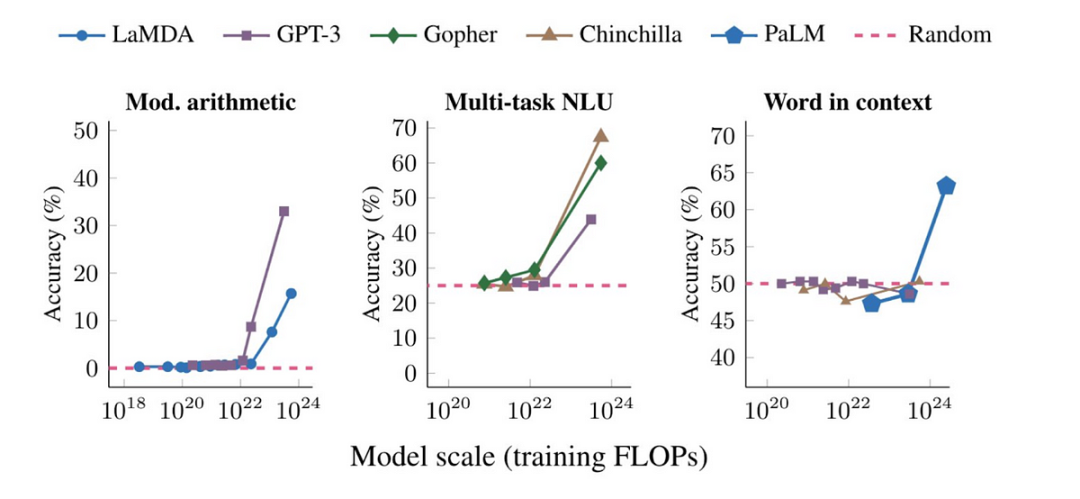

Deuxièmement, même si les conditions matérielles sont satisfaites, l'entraînement et l'itération du modèle nécessitent toujours un grand nombre d'utilisateurs (IP) pour alimenter les données. Une fois que l'échelle du modèle dépasse un certain seuil, ses performances sur différentes tâches montrent une croissance exponentielle.

Troisièmement, les petites et moyennes startups IA ont du mal à réaliser un dépassement stratégique. Le monopole de la puissance de calcul dans les marchés financiers traditionnels entraîne également un monopole des solutions de modèles IA. Des grands acteurs comme OpenAI et Google DeepMind renforcent continuellement leurs propres positions dominantes. Les petites équipes IA doivent donc chercher davantage de différenciation concurrentielle.

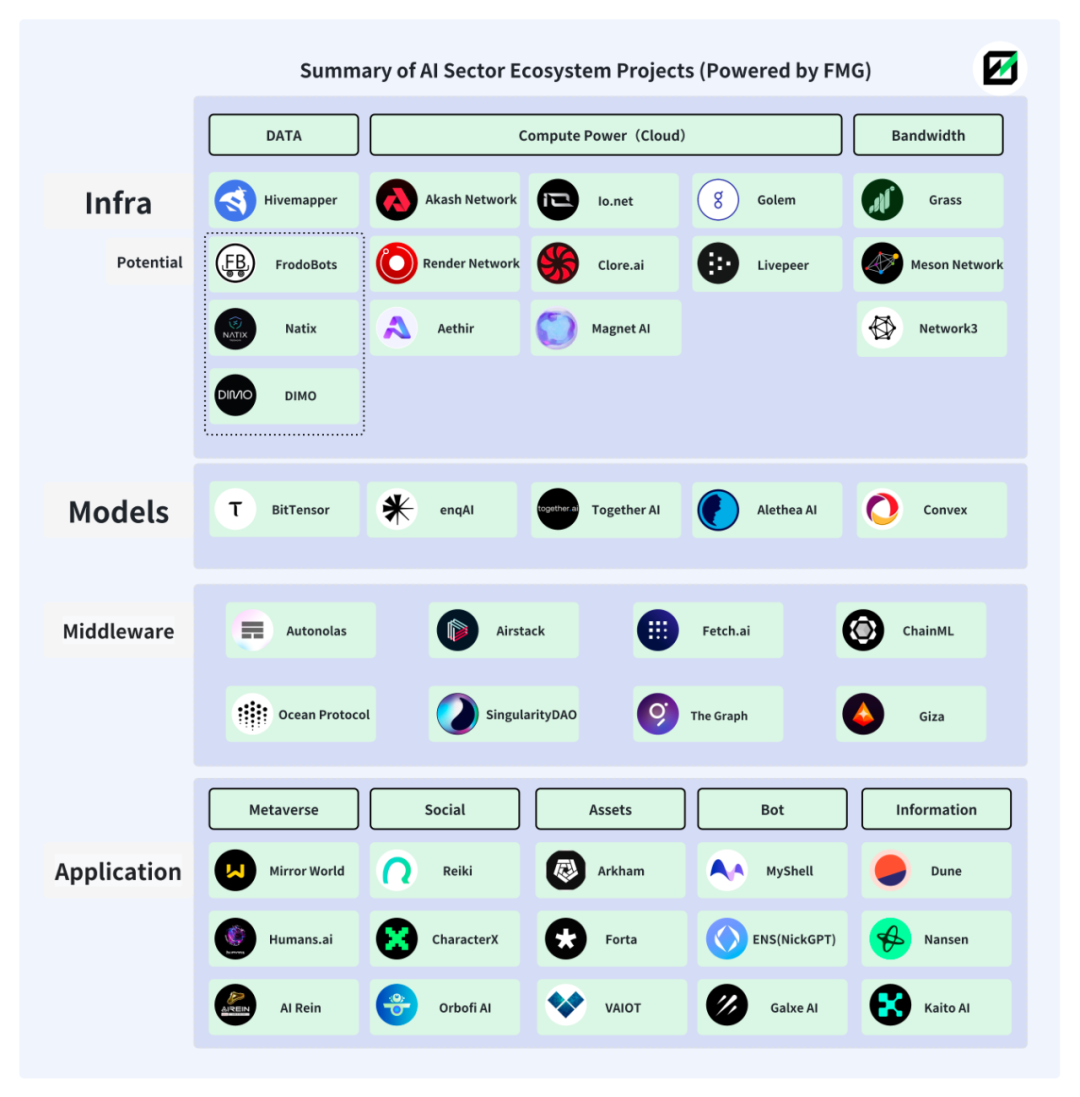

Ces trois problèmes peuvent tous trouver des réponses dans Web3. En réalité, l'alliance entre IA et Web3 existe depuis longtemps et l'écosystème est déjà bien développé.

L'image ci-dessous présente une partie des catégories et projets de l'écosystème IA+Web3 réalisée par Future Money Group.

IA + DePIN

1. La solution DePIN

DePIN signifie « Decentralized Physical Infrastructure Networks » (réseaux d'infrastructures physiques décentralisés). Il s'agit aussi d'un ensemble de relations de production entre humains et appareils, combinant économie tokenisée et matériel (ordinateurs, caméras embarquées, etc.) pour intégrer étroitement utilisateurs et équipements, tout en assurant un fonctionnement ordonné du modèle économique.

Comparé à la définition plus large de Web3, DePIN entretient naturellement des liens plus profonds avec le matériel et les entreprises traditionnelles, lui conférant un avantage inhérent pour attirer des équipes IA extérieures et leurs financements.

L'écosystème DePIN, grâce à sa recherche de puissance de calcul distribuée et à son incitation des contributeurs, répond précisément aux besoins des produits IA en matière de puissance de calcul et d’adresses IP.

-

DePIN utilise l’économie tokenisée pour intégrer la puissance de calcul mondiale (data centers et puissance inutilisée personnelle), réduisant ainsi les risques de centralisation et le coût d’utilisation de la puissance pour les équipes IA.

-

La diversité et le grand nombre d’adresses IP dans l’écosystème DePIN offrent aux modèles IA des sources de données variées et objectives. Un grand nombre de fournisseurs garantit l’amélioration continue des performances du modèle.

-

Le chevauchement entre les utilisateurs DePIN et ceux de Web3 permet aux projets IA intégrés de développer des modèles dotés de spécificités Web3, créant ainsi une concurrence différenciée, absente sur les marchés IA traditionnels.

Dans l’univers Web2, les données des modèles IA proviennent généralement de jeux de données publics ou collectées directement par les concepteurs du modèle. Cela entraîne des limitations culturelles et géographiques, rendant les résultats des modèles IA subjectifs et biaisés. De plus, les méthodes traditionnelles de collecte souffrent d’une faible efficacité et d’un coût élevé, limitant l’échelle des modèles (nombre de paramètres, durée d’entraînement, qualité des données). Pour un modèle IA, plus l’échelle est grande, plus les performances tendent vers une transformation qualitative.

Source : Large Language Models’ emergent abilities: how they solve problems they were not trained to address?

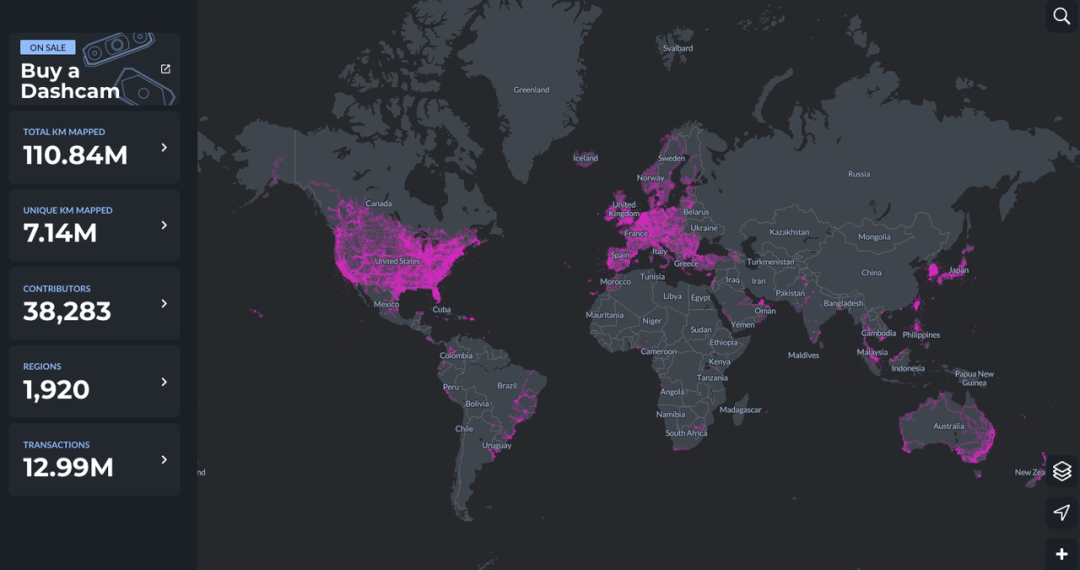

DePIN présente ici un avantage naturel. Prenons Hivemapper comme exemple : près de 40 000 contributeurs répartis dans 1 920 régions du monde alimentent le modèle MAP AI (modèle cartographique).

L’alliance entre IA et DePIN marque une nouvelle étape dans l’intégration de l’IA et de Web3. Actuellement, les projets IA dans Web3 se concentrent majoritairement sur les applications et restent largement dépendants des infrastructures Web2, en intégrant simplement des modèles IA préexistants basés sur des plateformes de calcul centralisées, sans souvent créer eux-mêmes de nouveaux modèles IA.

Les composants Web3 restent en aval de la chaîne alimentaire et n’obtiennent pas de retours excédentaires. Même pour les plateformes de calcul distribué, une simple combinaison IA + puissance de calcul ne permet pas d’exploiter pleinement leur potentiel. Dans cette relation, les fournisseurs de puissance ne tirent pas de profit supplémentaire, et l’architecture écologique trop simpliste empêche la mise en œuvre d’un effet de levier via l’économie tokenisée.

Mais le concept d’IA+DePIN brise cette relation figée et redirige l’attention de Web3 vers le vaste domaine des modèles IA.

2. Synthèse des projets IA+DePIN

L’écosystème DePIN dispose naturellement des équipements (puissance de calcul, bande passante, algorithmes, données), des utilisateurs (fournisseurs de données d’entraînement) et d’un mécanisme d’incitation interne (économie tokenisée) dont l’IA a désespérément besoin.

Nous pouvons formuler une définition audacieuse : tout projet qui fournit des conditions objectives complètes (puissance de calcul / bande passante / données / IP) pour l’IA, propose des scénarios d’application (entraînement / inférence / ajustement fin) et intègre une économie tokenisée peut être qualifié de IA+DePIN.

Future Money Group présentera ci-dessous une synthèse des paradigmes classiques de IA+DePIN.

En fonction des types de ressources fournies, nous divisons les projets en quatre catégories : puissance de calcul, bande passante, données et autres.

2.1 Puissance de calcul

La puissance de calcul constitue la majeure partie du segment IA+DePIN et rassemble actuellement le plus grand nombre de projets. Elle repose principalement sur les GPU (processeurs graphiques), CPU (unités centrales) et TPU (puces spécialisées pour l’apprentissage machine). Du fait de leur complexité de fabrication, les TPU sont principalement produits par Google, qui n’en propose que sous forme de services cloud, limitant ainsi leur part de marché. Les GPU, similaires aux CPU mais plus spécialisés, traitent efficacement les opérations mathématiques complexes en parallèle. Initialement conçus pour le rendu graphique dans les jeux et animations, ils sont désormais utilisés bien au-delà de ces domaines. Les GPU constituent donc aujourd’hui la principale source de puissance de calcul.

Par conséquent, de nombreux projets IA+DePIN axés sur la puissance de calcul se spécialisent dans le rendu graphique ou vidéo, ou dans des applications liées aux jeux, en raison des caractéristiques des GPU.

À l’échelle globale, les fournisseurs de puissance de calcul dans ces projets se divisent en trois catégories : les fournisseurs traditionnels de cloud computing, les particuliers mettant à disposition leur puissance inutilisée, et les détenteurs de matériel propre. Les fournisseurs cloud représentent la plus grande part, suivis par les particuliers. Ces projets jouent donc surtout un rôle d’intermédiaire. Les demandeurs sont principalement des équipes de développement de modèles IA.

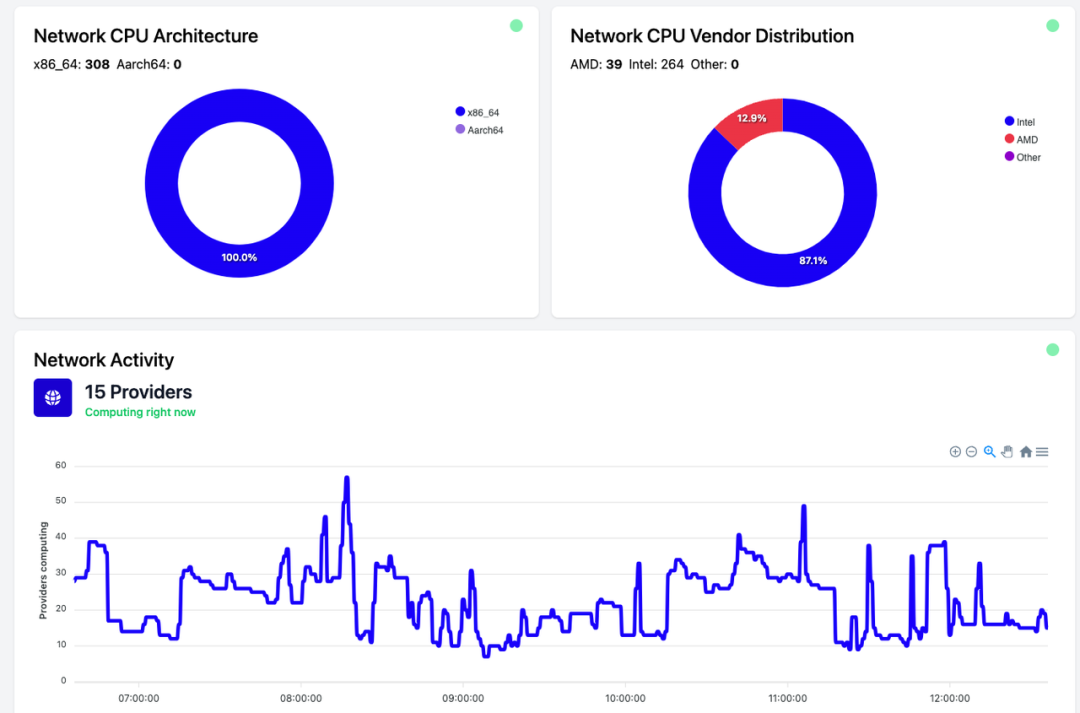

Actuellement, la puissance de calcul n'est presque jamais utilisée à 100 %, beaucoup reste inutilisée. Par exemple, chez Akash Network, environ 35 % de la puissance est utilisée, le reste étant inactif. Io.net connaît une situation similaire.

Cela peut être dû au faible volume actuel des besoins en entraînement de modèles IA, mais explique aussi pourquoi l’IA+DePIN peut proposer des coûts de calcul abordables. À mesure que le marché IA s’élargira, cette situation devrait s’améliorer.

Akash Network : marché décentralisé de services cloud pair-à-pair

Akash Network est un marché décentralisé de services cloud peer-to-peer, souvent comparé à Airbnb pour le cloud. Il permet aux utilisateurs et entreprises de toutes tailles d’accéder rapidement, de façon fiable et économique à ses services.

Comme Render, Akash propose des services de déploiement et de location de GPU, ainsi que l’entraînement de modèles IA.

En août 2023, Akash a lancé Supercloud, permettant aux développeurs de définir le prix qu’ils sont prêts à payer pour déployer leurs modèles IA, tandis que les fournisseurs disposant de capacité de calcul excédentaire hébergent ces modèles. Cette fonctionnalité, semblable à Airbnb, permet aux fournisseurs de louer leur capacité inutilisée.

Grâce à un système d’enchères publiques, Akash Network incite les fournisseurs à mettre à disposition leurs ressources informatiques inutilisées, optimisant ainsi l’utilisation des ressources et offrant des prix plus compétitifs aux demandeurs.

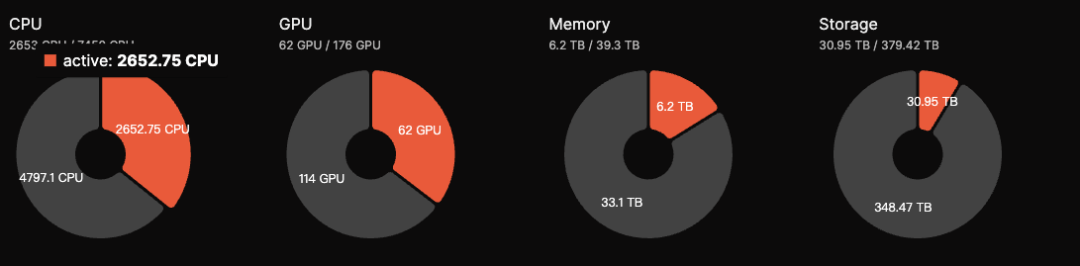

Actuellement, l’écosystème Akash compte 176 GPU au total, dont 62 actifs, soit un taux d’activité de 35 %, en baisse par rapport aux 50 % d’octobre 2023. Le revenu journalier estimé est d’environ 5 000 $. Le jeton AKT offre une fonction de mise en gage : les utilisateurs participent à la sécurité du réseau en bloquant leurs jetons, obtenant ainsi un rendement annuel d’environ 13,15 %.

Akash affiche actuellement de bonnes performances dans le secteur IA+DePIN, et sa FDV de 700 millions de dollars laisse entrevoir un fort potentiel de croissance par rapport à Render et BitTensor.

Akash est également intégré au Subnet de BitTensor pour élargir ses perspectives. Globalement, Akash figure parmi les meilleurs projets du secteur IA+DePIN, avec des fondamentaux solides.

io.net : IA+DePIN avec le plus grand nombre de GPU connectés

io.net est un réseau de calcul décentralisé qui prend en charge le développement, l’exécution et l’expansion d’applications ML (machine learning) sur la blockchain Solana. Il exploite l’un des plus grands clusters GPU au monde, permettant aux ingénieurs en apprentissage machine de louer et d’accéder à des services de cloud distribué à une fraction du coût des services centralisés.

Selon les données officielles, io.net dispose de plus d’un million de GPU en attente. De plus, son partenariat avec Render étend davantage les ressources GPU disponibles.

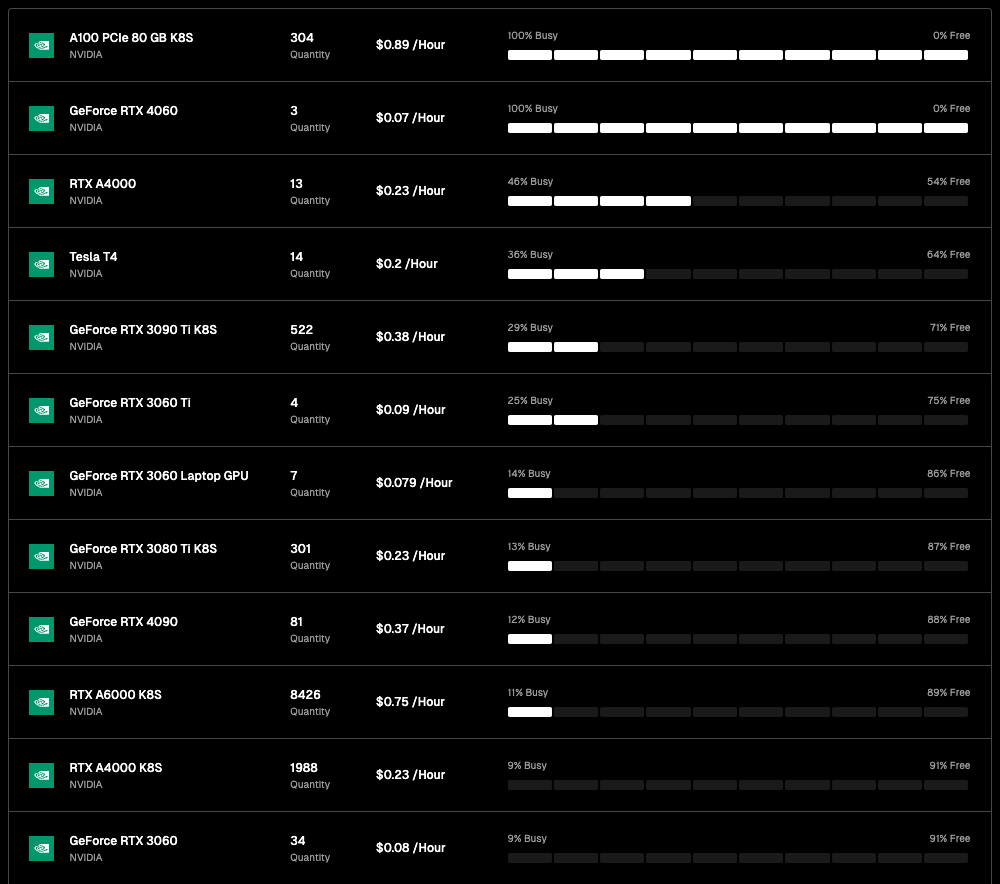

Bien que io.net dispose d’un grand nombre de GPU, ceux-ci proviennent presque exclusivement de partenariats avec des fournisseurs de cloud ou de connexions de nœuds individuels, et le taux d’inactivité est élevé. Par exemple, parmi les 8 426 RTX A6000, seulement 11 % (927) sont utilisés, et de nombreux autres modèles sont quasi inutilisés. Toutefois, l’un des principaux atouts d’io.net réside dans ses prix très compétitifs : alors qu’Akash facture environ 1,5 $ par heure d’utilisation d’un GPU, io.net propose des tarifs allant de 0,1 à 1 $.

À l’avenir, io.net envisage de permettre aux fournisseurs de GPU de l’écosystème IO d’augmenter leurs chances d’être sélectionnés en misant des actifs natifs : plus la mise est élevée, plus la probabilité d’être choisi augmente. Les ingénieurs IA qui misent des actifs natifs pourront également accéder à des GPU haute performance.

En termes d’échelle de connexion GPU, io.net est le plus grand parmi les dix projets présentés ici. Même après déduction du taux d’inactivité, le nombre de GPU actifs reste le plus élevé. Sur le plan économique tokenisée, le jeton natif d’io.net sera lancé au premier trimestre 2024, avec une offre maximale de 22 300 000 unités. Une commission de 5 % sera perçue lors de l’utilisation du réseau, utilisée soit pour brûler les jetons IO, soit pour inciter les nouveaux utilisateurs. Ce modèle présente des caractéristiques haussières marquées, ce qui explique l’importante attention médiatique suscitée par io.net, malgré l’absence encore de jeton.

Golem : marché de puissance de calcul basé sur CPU

Golem est un marché décentralisé de puissance de calcul permettant à chacun de partager et regrouper des ressources informatiques via un réseau collaboratif. Golem propose des scénarios de location de puissance de calcul.

Le marché Golem comprend trois parties : les fournisseurs de puissance, les demandeurs et les développeurs logiciels. Les demandeurs soumettent des tâches de calcul, que Golem attribue à des fournisseurs adaptés (RAM, espace disque, cœurs CPU), puis paient via des tokens après exécution.

Golem utilise principalement des CPU pour accumuler la puissance de calcul. Bien que cela réduise les coûts (un CPU Intel i9 14900k coûte environ 700 $ contre 12 000-25 000 $ pour un GPU A100), les CPU ne supportent pas bien le calcul parallèle intensif et consomment plus d’énergie. Ainsi, les projets basés sur CPU peinent à rivaliser narrativement avec ceux basés sur GPU.

Magnet AI : titrisation des modèles IA

Magnet AI agrège des fournisseurs de puissance GPU pour offrir des services d’entraînement de modèles à différents développeurs IA. Contrairement aux autres projets IA+DePIN, Magnet AI permet à chaque équipe IA de publier son propre jeton ERC-20 basé sur son modèle. Les utilisateurs interagissant avec ces modèles reçoivent des airdrops et des récompenses supplémentaires.

Au deuxième trimestre 2024, Magnet AI sera lancé sur Polygon zkEVM et Arbitrum.

Similaire à io.net, Magnet AI se concentre sur l’intégration de puissance GPU et propose des services d’entraînement de modèles IA.

La différence réside dans l’accent mis par io.net sur l’intégration des ressources GPU, encourageant les clusters, entreprises et particuliers à contribuer et être rémunérés — une approche orientée puissance de calcul.

Magnet AI semble davantage centré sur les modèles IA. Grâce aux jetons associés aux modèles, il cherche à attirer et fidéliser les utilisateurs via des airdrops, et à inciter les développeurs IA à rejoindre la plateforme en titrisant les modèles.

En résumé : Magnet construit un marché avec des GPU, où tout développeur IA peut émettre un jeton ERC-20, et où les utilisateurs peuvent acquérir ou détenir différents jetons.

Render : spécialiste des modèles IA dédiés au rendu graphique

Render Network est un fournisseur de solutions de rendu basé sur des GPU décentralisés. Il vise à connecter créateurs et ressources GPU inutilisées via la technologie blockchain, supprimant les limites matérielles, réduisant temps et coûts, tout en offrant une gestion des droits numériques, stimulant ainsi le développement du métavers.

D’après le livre blanc de Render, artistes, ingénieurs et développeurs peuvent créer diverses applications IA, telles que la génération assistée par IA de contenu 3D, l’accélération par IA du rendu global, ou encore l’entraînement de modèles IA à partir des données de scènes 3D de Render.

Render fournit un SDK à destination des développeurs, leur permettant d’utiliser les GPU distribués de Render pour des tâches allant du rendu NeRF (champs radiants neuronaux) et LightField jusqu’à des tâches génératives d’IA.

Selon un rapport de Global Market Insights, le marché mondial du rendu 3D devrait atteindre 6 milliards de dollars. Avec une FDV de 2,2 milliards, Render dispose encore de marges de progression.

Aucune donnée précise sur les GPU de Render n’est disponible, mais OTOY, société mère, a plusieurs fois manifesté des liens avec Apple. Très diversifiée, OTOY possède OctaneRender, un moteur de rendu vedette supportant nativement Unity3D et Unreal Engine, ainsi que tous les outils 3D leaders dans les domaines VFX, jeux, design motion, visualisation architecturale et simulation.

Google et Microsoft ont rejoint le réseau RNDR. En 2021, Render a traité près de 250 000 demandes de rendu, et les artistes de l’écosystème ont généré environ 5 milliards de dollars de ventes via des NFT.

Par conséquent, l’évaluation de Render devrait s’appuyer sur le potentiel global du marché du rendu (environ 30 milliards de dollars). Combiné à son modèle économique BME (Burn and Mint Equilibrium), Render conserve un potentiel de hausse significatif, tant en prix de jeton qu’en FDV.

Clore.ai : rendu vidéo

Clore.ai est une plateforme basée sur PoW offrant des services de location de puissance GPU. Les utilisateurs peuvent louer leurs GPU pour des tâches telles que l’entraînement IA, le rendu vidéo ou le minage de cryptomonnaies, accessibles à moindre coût par d’autres.

Les activités comprennent : formation IA, rendu cinématographique, VPN, minage de cryptomonnaies, etc. Quand il y a une demande de puissance, le réseau attribue des tâches. Sinon, il choisit automatiquement la cryptomonnaie offrant le meilleur rendement et participe au minage.

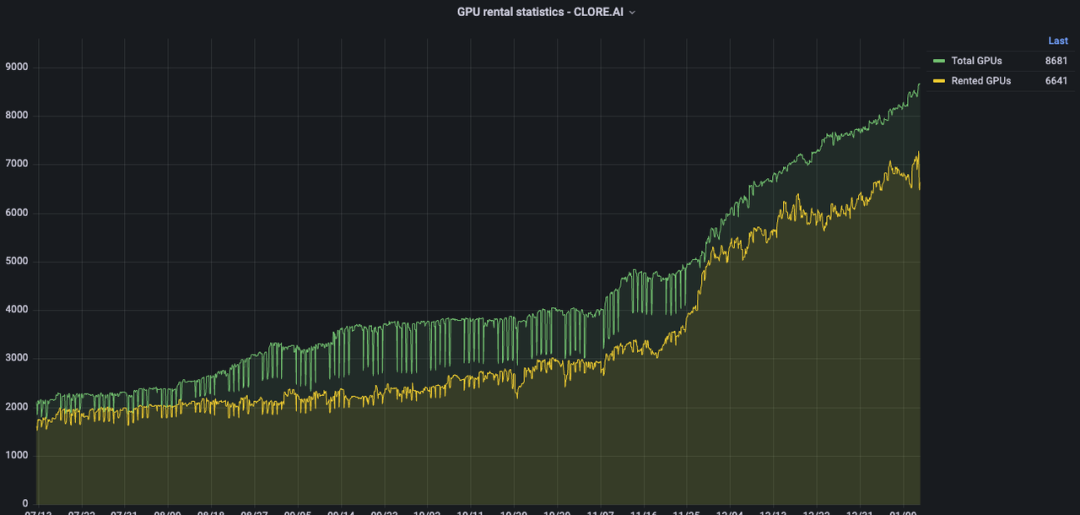

Au cours des six derniers mois, le nombre de GPU sur Clore.ai est passé de 2 000 à environ 9 000. En volume de GPU intégrés, Clore.ai dépasse Akash. Pourtant, sa FDV sur le marché secondaire n’atteint que 20 % environ de celle d’Akash.

Sur le plan économique, CLORE suit un modèle PoW sans pré-minage ni ICO : 50 % des blocs vont aux mineurs, 40 % aux loueurs, 10 % à l’équipe.

Offre totale : 1,3 milliard de jetons, extraction commencée en juin 2022, circulation quasi totale prévue en 2042. Offre actuelle : environ 220 millions, 250 millions fin 2023 (20 % du total). La FDV réelle est donc de 31 millions de dollars. Théoriquement, Clore.ai est fortement sous-évalué, mais la forte proportion de distribution aux mineurs (50 %) et le ratio « miner-vendre-retirer » élevé freinent toute hausse du prix du jeton.

Livepeer : rendu et inférence vidéo

Livepeer est un protocole vidéo décentralisé basé sur Ethereum, récompensant les parties qui traitent du contenu vidéo à prix raisonnable et en toute sécurité.

Selon l’officiel, Livepeer mobilise chaque semaine des milliers de GPU pour des millions de minutes de transcodage vidéo.

Livepeer pourrait adopter une structure « mainnet + subnet », permettant à différents opérateurs de nœuds de créer des sous-réseaux et d’exécuter des tâches payées via la mainnet. Par exemple, un sous-réseau IA vidéo pourrait être dédié à l’entraînement de modèles IA spécialisés dans le rendu vidéo.

Bienvenue dans la communauté officielle TechFlow Groupe Telegram :https://t.me/TechFlowDaily Compte Twitter officiel :https://x.com/TechFlowPost Compte Twitter anglais :https://x.com/BlockFlow_News