Kiểm tra Grok3, mô hình được cho là "thông minh nhất thế giới": Liệu nó thực sự là điểm kết thúc của hiệu ứng cận biên mô hình?

Tuyển chọn TechFlowTuyển chọn TechFlow

Kiểm tra Grok3, mô hình được cho là "thông minh nhất thế giới": Liệu nó thực sự là điểm kết thúc của hiệu ứng cận biên mô hình?

Grok3 tiêu tốn năng lực tính toán gấp 263 lần DeepSeek V3, chỉ có vậy thôi sao?

Theo giờ Bắc Kinh ngày 18 tháng 2, Musk và nhóm xAI đã chính thức ra mắt phiên bản mới nhất của Grok - Grok3 trong buổi phát trực tiếp.

Ngay trước sự kiện này, nhờ việc công bố nhiều thông tin liên quan cùng với chiến dịch "hâm nóng" không ngừng nghỉ 24/7 từ chính Elon Musk, kỳ vọng toàn cầu đối với Grok3 đã được đẩy lên mức chưa từng có. Một tuần trước đó, khi bình luận về DeepSeek R1 trong buổi phát trực tiếp, Musk tự tin tuyên bố rằng "xAI sắp ra mắt một mô hình AI xuất sắc hơn".

Theo các dữ liệu trình diễn tại hiện trường, Grok3 đã vượt qua tất cả các mô hình chủ lưu hiện nay trong các bài kiểm tra chuẩn hóa về toán học, khoa học và lập trình. Musk thậm chí còn tuyên bố Grok3 trong tương lai sẽ được sử dụng để tính toán cho nhiệm vụ sao Hỏa của SpaceX, đồng thời dự đoán "sẽ đạt được đột phá ở cấp độ giải Nobel trong vòng ba năm".

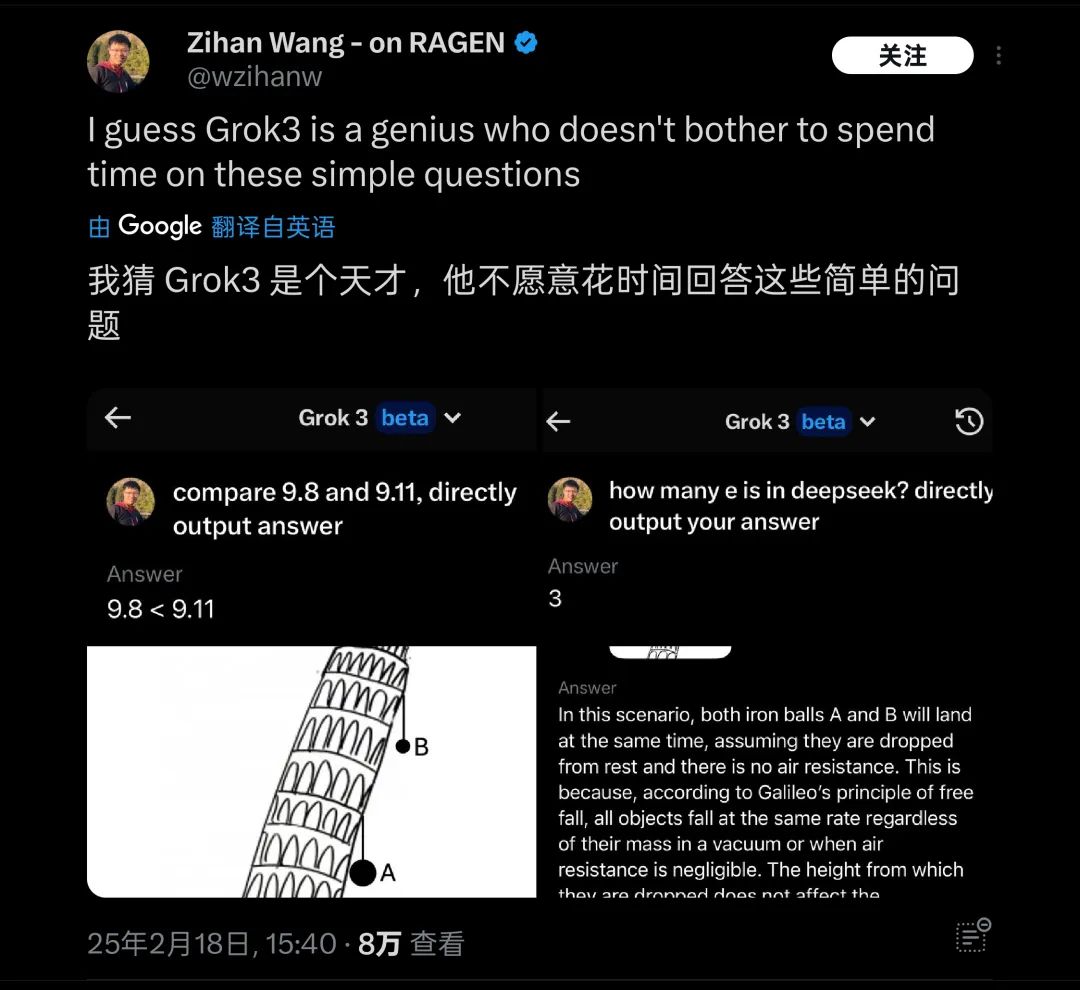

Nhưng những điều này hiện tại vẫn chỉ là lời nói một chiều từ Musk. Sau khi phát hành, tác giả đã thử nghiệm ngay phiên bản beta mới nhất của Grok3 và đặt ra câu hỏi kinh điển dùng để thử thách các mô hình lớn: "9.11 và 9.9, số nào lớn hơn?"

Thật đáng tiếc, mà không thêm bất kỳ định ngữ hay chú thích nào, Grok3 được mệnh danh là "thông minh nhất hiện nay" vẫn không thể trả lời đúng câu hỏi này.

Grok3 không nhận diện chính xác ý nghĩa của câu hỏi này

Ảnh: GeekPark

Sau khi bài kiểm tra này được đăng tải, trong thời gian ngắn đã thu hút sự chú ý của nhiều người. Không phải là trường hợp cá biệt, ở nước ngoài cũng có rất nhiều bài kiểm tra tương tự như câu hỏi vật lý/toán học cơ bản kiểu "hai quả bóng thả từ Tháp nghiêng Pisa, quả nào rơi xuống trước", Grok3 cũng bị phát hiện không xử lý được. Do đó, nó bị chế giễu là "thiên tài nhưng không muốn trả lời câu hỏi đơn giản".

Grok3 gặp trục trặc trong nhiều câu hỏi kiến thức phổ thông khi kiểm tra thực tế

Ảnh: X

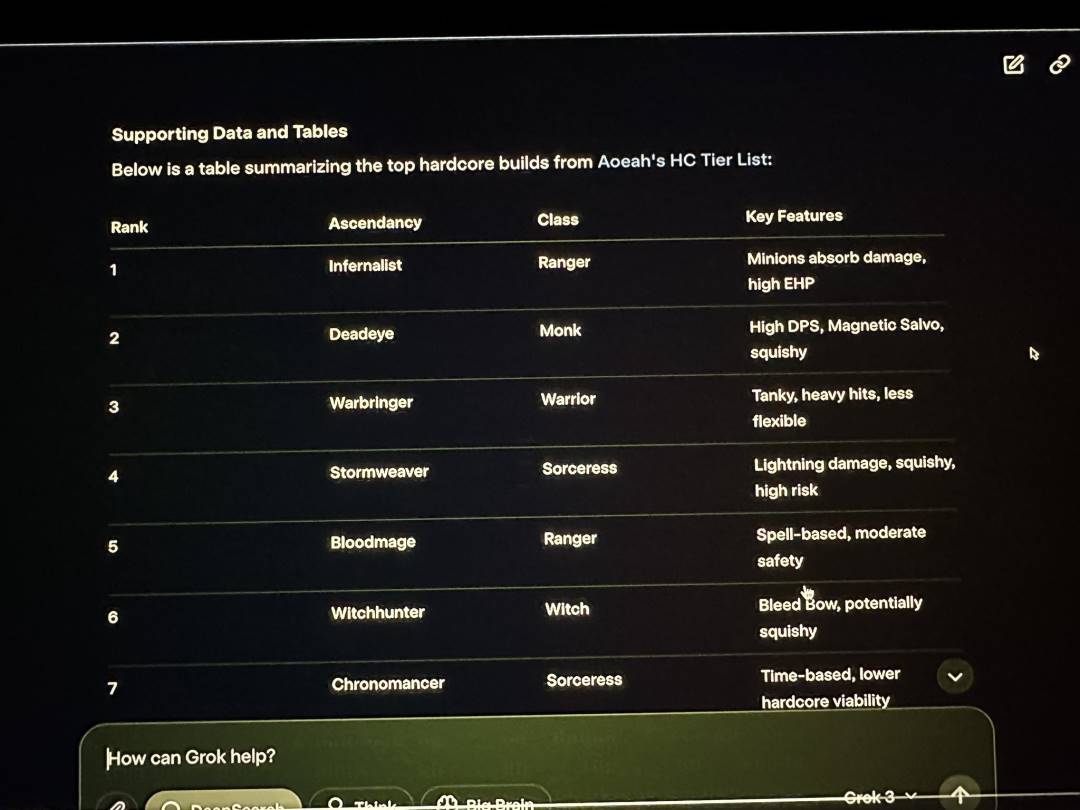

Bên cạnh những lỗi cơ bản do người dùng tự kiểm tra, trong buổi phát trực tiếp ra mắt của xAI, Musk đã minh họa việc dùng Grok3 phân tích nghề nghiệp và hiệu ứng thăng cấp trong trò chơi Path of Exile 2 (PoE2) mà ông tuyên bố thường xuyên chơi, nhưng thực tế phần lớn các câu trả lời mà Grok3 đưa ra đều sai. Trong buổi phát trực tiếp, Musk không nhận ra vấn đề rõ ràng này.

Grok3 cũng đưa ra rất nhiều dữ liệu sai trong buổi phát trực tiếp

Ảnh: X

Vì vậy, sai sót này không chỉ trở thành bằng chứng cụ thể khiến cư dân mạng hải ngoại chế giễu Musk khi chơi game "thuê người đánh thay", mà còn đặt dấu hỏi lớn về độ tin cậy thực tế của Grok3 trong ứng dụng.

Đối với một "thiên tài" như vậy, dù năng lực thực tế ra sao, việc sử dụng nó trong các ứng dụng cực kỳ phức tạp như khám phá sao Hỏa thì độ tin cậy vẫn phải đặt dấu hỏi lớn.

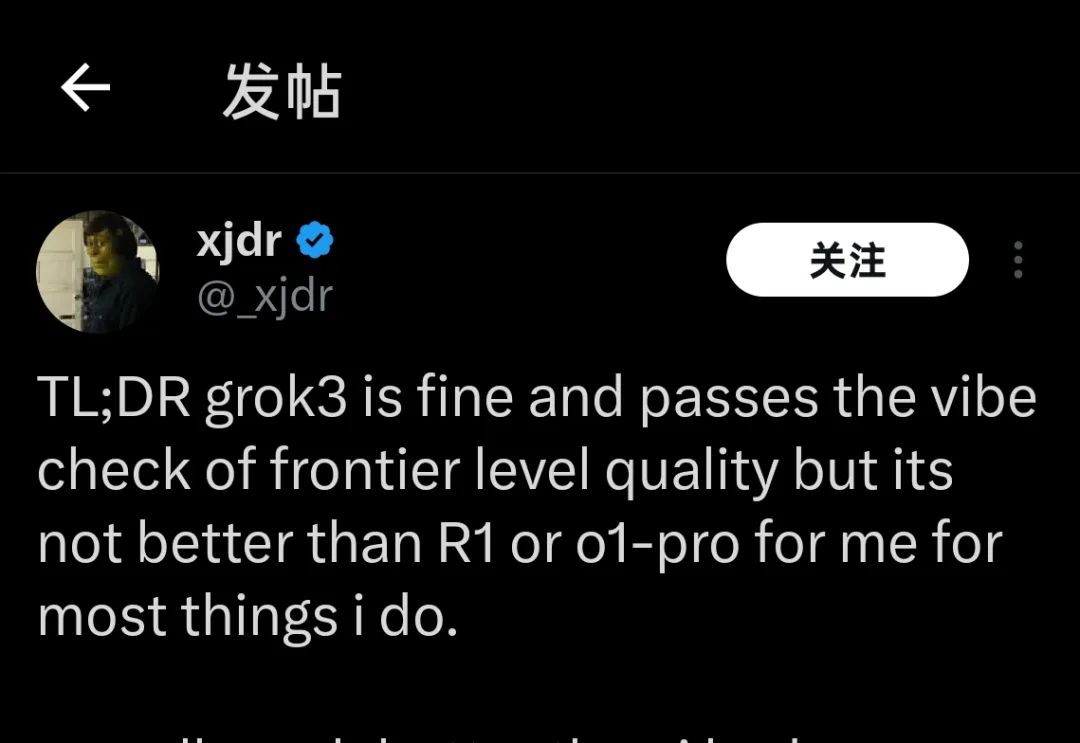

Hiện tại, nhiều người dùng nhận được quyền kiểm thử Grok3 vài tuần trước, cũng như những người mới dùng được vài giờ hôm qua, đều đưa đến cùng một kết luận về hiệu suất hiện tại của Grok3:

"Grok3 tốt thật, nhưng nó không tốt hơn R1 hay o1-Pro"

"Grok3 tốt thật, nhưng nó không tốt hơn R1 hay o1-Pro"

Ảnh: X

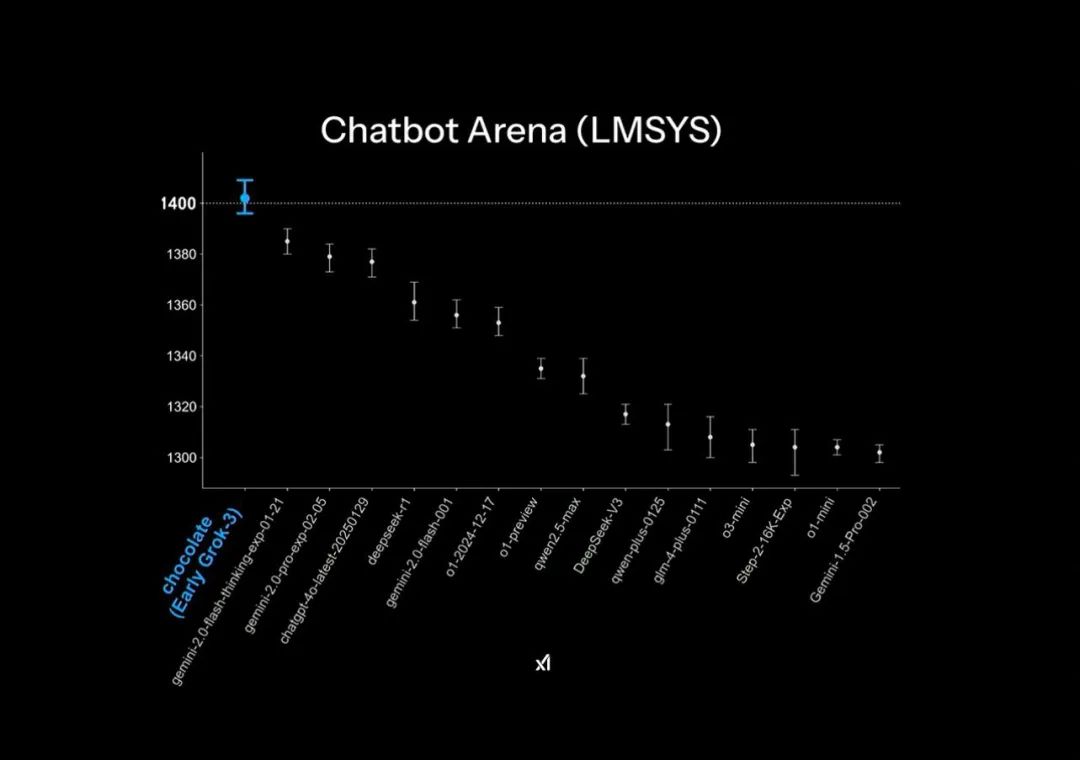

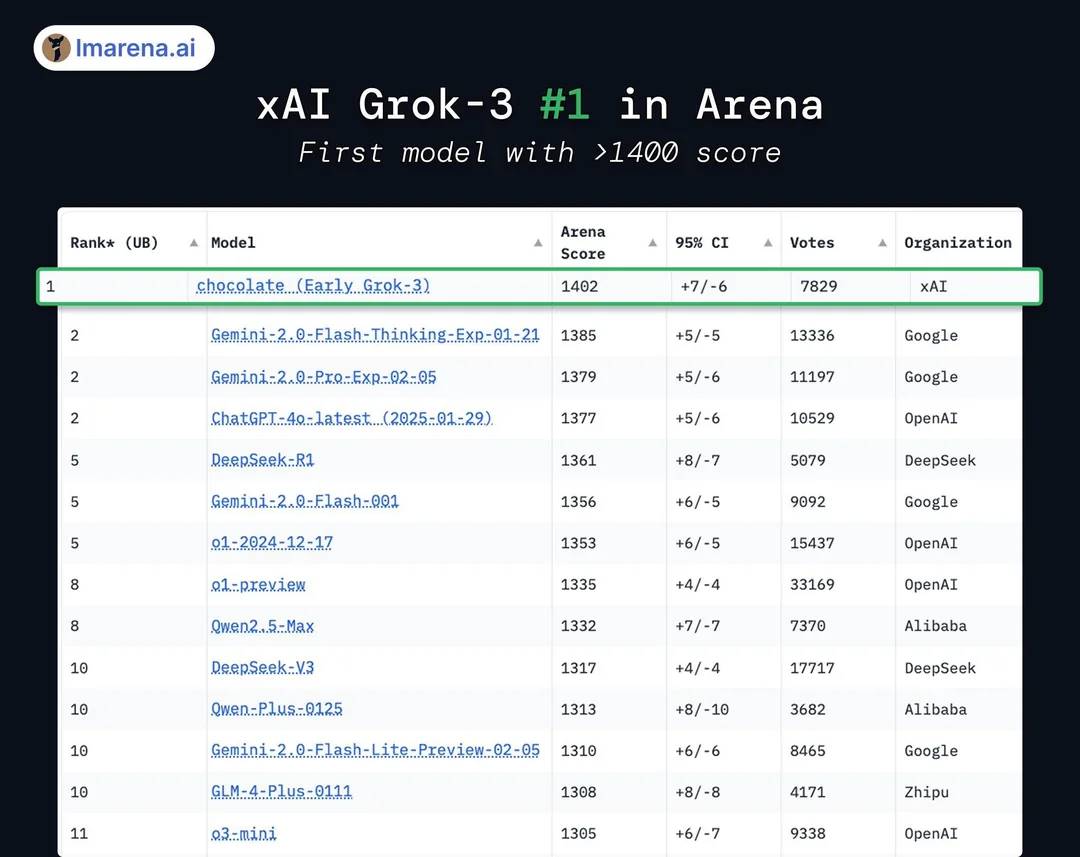

Trong bản trình chiếu chính thức của Grok3, mô hình này được cho là "vượt xa" trên sân chơi mô hình lớn Chatbot Arena, nhưng thực tế lại sử dụng một chút thủ thuật đồ họa nhỏ: trục tung của bảng xếp hạng chỉ hiển thị phân đoạn từ 1400-1300 điểm, khiến chênh lệch kết quả thử nghiệm vốn chỉ khoảng 1% ban đầu trở nên cực kỳ rõ rệt trong bản trình bày này.

Hiệu ứng "vượt xa" trong bản trình chiếu phát hành chính thức

Ảnh: X

Còn về kết quả điểm số thực tế, Grok3 thực ra chỉ vượt DeepSeek R1 và GPT4.0 chưa đến 1-2%: điều này phù hợp với cảm nhận của nhiều người dùng khi thử nghiệm thực tế là "không có sự khác biệt rõ rệt".

Thực tế, Grok3 chỉ cao hơn các mô hình sau đó 1%-2%

Ảnh: X

Hơn nữa, mặc dù về điểm số Grok3 vượt qua tất cả các mô hình công khai hiện nay, nhưng điều này không được nhiều người công nhận: bởi vì trong thời kỳ Grok2, xAI đã từng bị hạ điểm mạnh trên bảng xếp hạng này sau khi hệ thống giảm trọng số với phong cách trả lời dài dòng, do đó giới chuyên môn thường chỉ trích là "điểm cao nhưng năng lực thấp".

Dù là "làm đẹp điểm số" trên bảng xếp hạng hay các "thủ thuật nhỏ" trong thiết kế hình ảnh, đều cho thấy sự ám ảnh của xAI và chính Musk về việc khẳng định khả năng mô hình "vượt xa" các đối thủ.

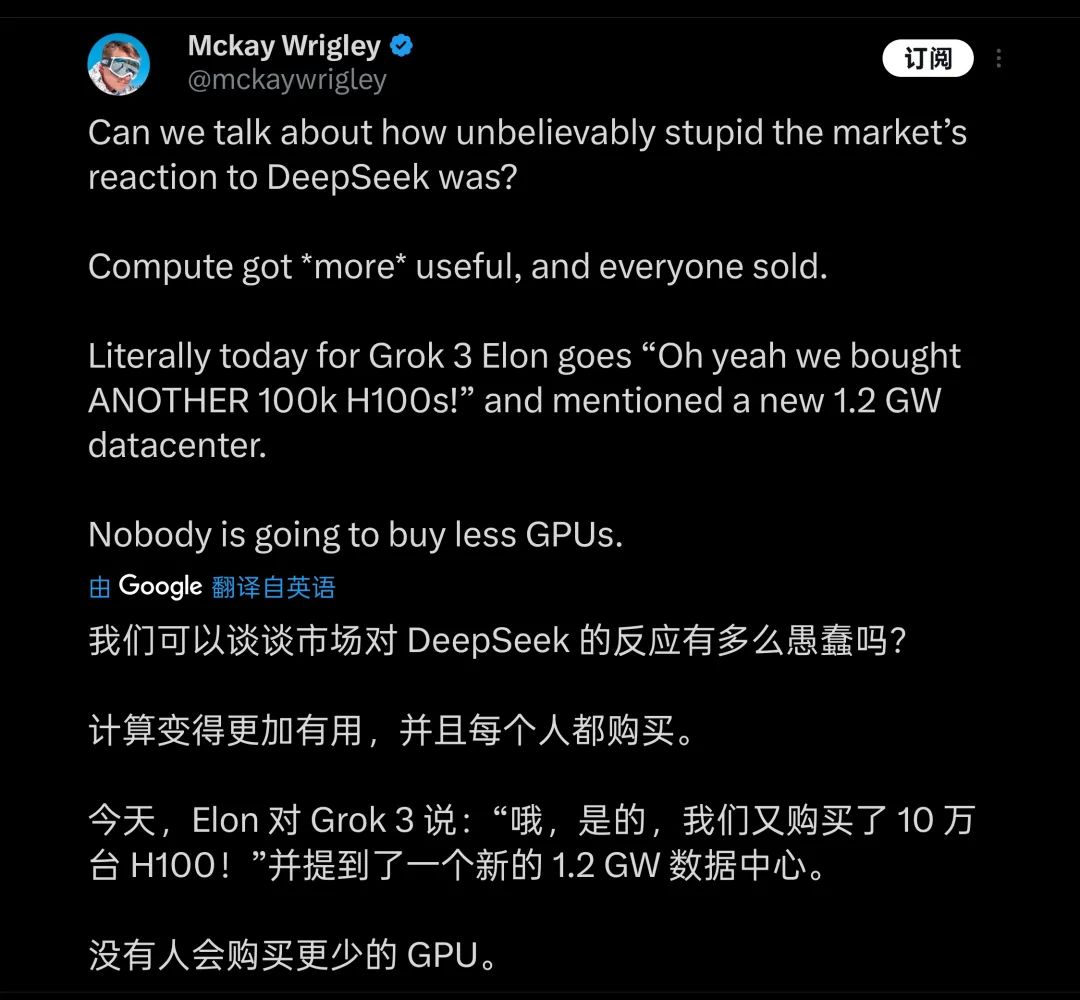

Và để đạt được những lợi thế nhỏ này, cái giá Musk phải trả là vô cùng đắt đỏ: trong buổi ra mắt, Musk gần như khoe khoang rằng đã dùng 200.000 card H100 (trong buổi phát trực tiếp Musk nói "hơn 100.000") để huấn luyện Grok3, tổng số giờ huấn luyện đạt hai trăm triệu giờ. Điều này khiến một bộ phận người cho rằng đây là tin tức tích cực lớn đối với ngành GPU, và coi cú sốc mà DeepSeek mang lại cho ngành là "ngớ ngẩn".

Nhiều người cho rằng dồn ép sức mạnh tính toán sẽ là tương lai của huấn luyện mô hình

Ảnh: X

Tuy nhiên, một cư dân mạng so sánh DeepSeek V3 được huấn luyện bằng 2.000 card H800 trong hai tháng, tính ra lượng tính toán thực tế dùng để huấn luyện Grok3 gấp 263 lần V3. Trong khi đó, khoảng cách giữa DeeSeek V3 và Grok3 đạt 1402 điểm trên bảng xếp hạng Chatbot Arena thậm chí còn chưa đến 100 điểm.

Sau khi các con số này được công bố, nhiều người nhanh chóng nhận ra rằng phía sau việc Grok3 leo lên vị trí "mạnh nhất thế giới", logic "mô hình càng lớn, hiệu suất càng cao" đã bộc lộ rõ hiệu ứng biên giảm dần.

Ngay cả Grok2 bị chê là "điểm cao nhưng năng lực thấp", đằng sau nó vẫn có lượng lớn dữ liệu nội bộ chất lượng cao từ nền tảng X (Twitter). Đến giai đoạn huấn luyện Grok3, xAI tự nhiên cũng gặp phải "giới hạn trần" mà OpenAI đang đối mặt – thiếu hụt dữ liệu huấn luyện chất lượng cao khiến hiệu ứng biên của mô hình nhanh chóng bộc lộ.

Chắc chắn người nhận ra sớm nhất và hiểu sâu sắc nhất những thực tế này chính là đội ngũ phát triển Grok3 và Musk, do đó Musk cũng liên tục nhấn mạnh trên mạng xã hội rằng phiên bản người dùng đang trải nghiệm "chỉ mới là phiên bản thử nghiệm", "phiên bản đầy đủ sẽ ra mắt trong vài tháng tới". Bản thân Musk còn đóng vai trò trưởng sản phẩm Grok3, khuyến khích người dùng phản hồi trực tiếp các vấn đề gặp phải vào phần bình luận.

Có lẽ ông ấy là trưởng sản phẩm có lượng người theo dõi đông nhất hành tinh

Ảnh: X

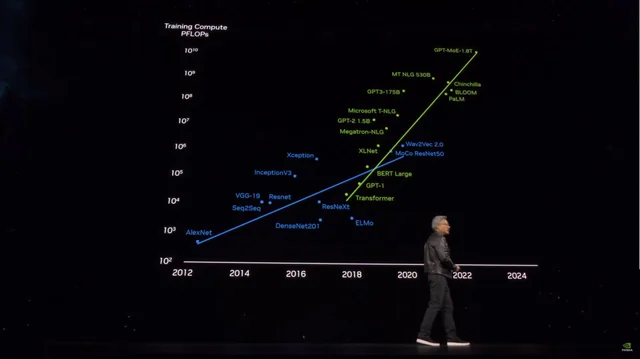

Nhưng chưa đầy một ngày, hiệu suất của Grok3 rõ ràng đã gióng lên hồi chuông cảnh tỉnh đối với những người đi sau hy vọng vào phương pháp "dùng sức mạnh tính toán để đá bay mọi thứ" nhằm tạo ra mô hình lớn mạnh hơn: theo suy đoán từ thông tin công khai của Microsoft, dung lượng tham số của OpenAI GPT4 là 1,8 nghìn tỷ, tăng hơn 10 lần so với GPT3, trong khi dung lượng tham số của GPT4.5 được đồn đại còn lớn hơn nữa.

Khi dung lượng tham số mô hình tăng vọt, chi phí huấn luyện cũng tăng theo

Ảnh: X

Với tiền lệ Grok3, những người như GPT4.5 và các đối thủ khác muốn tiếp tục "đốt tiền" để đổi lấy hiệu suất mô hình tốt hơn thông qua dung lượng tham số, đều phải cân nhắc làm thế nào để vượt qua giới hạn trần đang ở ngay trước mắt.

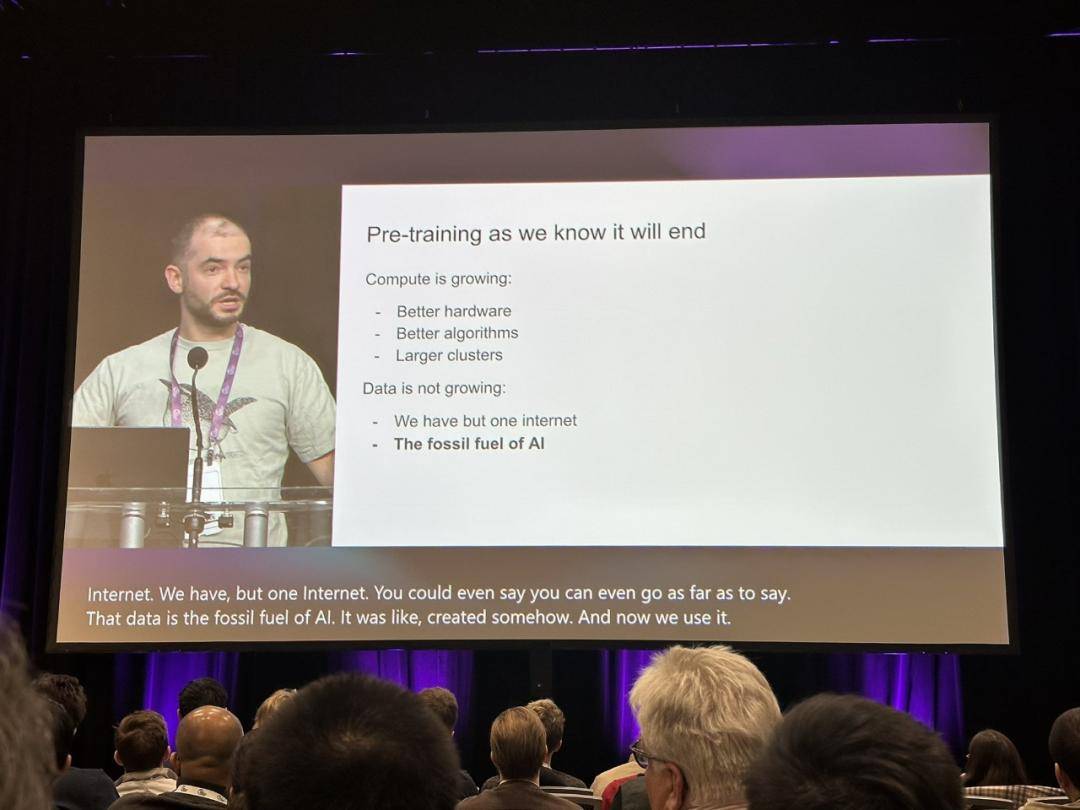

Ngay lúc này, tuyên bố hồi tháng 12 năm ngoái của nhà khoa học trưởng cũ của OpenAI, Ilya Sutskever: "Việc huấn luyện trước (pre-training) mà chúng ta biết sẽ kết thúc", lại được nhắc lại và mọi người cố gắng tìm kiếm lối thoát thực sự cho việc huấn luyện mô hình lớn từ đó.

Quan điểm của Ilya đã gióng lên hồi chuông cảnh tỉnh cho ngành

Ảnh: X

Lúc đó, Ilya đã dự đoán chính xác tình trạng dữ liệu mới khả dụng gần như cạn kiệt, mô hình khó có thể tiếp tục cải thiện hiệu suất bằng cách thu thập dữ liệu, và ví von điều này như việc tiêu thụ nhiên liệu hóa thạch, nói rằng "giống như dầu mỏ là tài nguyên hữu hạn, nội dung do con người tạo ra trên Internet cũng hữu hạn".

Theo dự đoán của Sutskever, thế hệ mô hình tiếp theo sau mô hình huấn luyện trước sẽ có "sự tự chủ thực sự", đồng thời sở hữu khả năng suy luận "tương tự não người".

Khác với mô hình AI hiện nay chủ yếu dựa vào khớp nội dung (dựa trên những gì mô hình đã học), các hệ thống AI tương lai sẽ có thể học từng bước và xây dựng phương pháp luận giải quyết vấn đề theo cách "tư duy" giống như bộ não người.

Con người chỉ cần một số sách chuyên ngành cơ bản là có thể nắm vững một lĩnh vực nào đó, nhưng mô hình AI lớn lại cần học hàng triệu dữ liệu mới đạt được hiệu quả入门 cơ bản, thậm chí khi bạn đổi cách đặt câu hỏi, những câu hỏi cơ bản này cũng không thể hiểu đúng, cho thấy trí tuệ thực sự của mô hình chưa được nâng cao: những câu hỏi cơ bản mà Grok3 vẫn không thể trả lời đúng như đã đề cập ở đầu bài viết chính là biểu hiện trực quan của hiện tượng này.

Nhưng bên cạnh "dùng sức mạnh tính toán", nếu Grok3 thực sự có thể tiết lộ cho ngành rằng "mô hình huấn luyện trước sắp đi đến hồi kết", thì nó vẫn có ý nghĩa khơi gợi quan trọng đối với ngành.

Có lẽ, sau khi cơn sốt Grok3 dần lắng xuống, chúng ta cũng sẽ thấy nhiều trường hợp tương tự như Li Feifei "tinh chỉnh mô hình hiệu suất cao chỉ với 50 đô la trên tập dữ liệu chuyên biệt". Và qua những khám phá này, cuối cùng tìm ra con đường thực sự dẫn đến AGI.

Chào mừng tham gia cộng đồng chính thức TechFlow

Nhóm Telegram:https://t.me/TechFlowDaily

Tài khoản Twitter chính thức:https://x.com/TechFlowPost

Tài khoản Twitter tiếng Anh:https://x.com/BlockFlow_News