Quelle est exactement la deuxième bombe open source lancée par DeepSeek ?

TechFlow SélectionTechFlow Sélection

Quelle est exactement la deuxième bombe open source lancée par DeepSeek ?

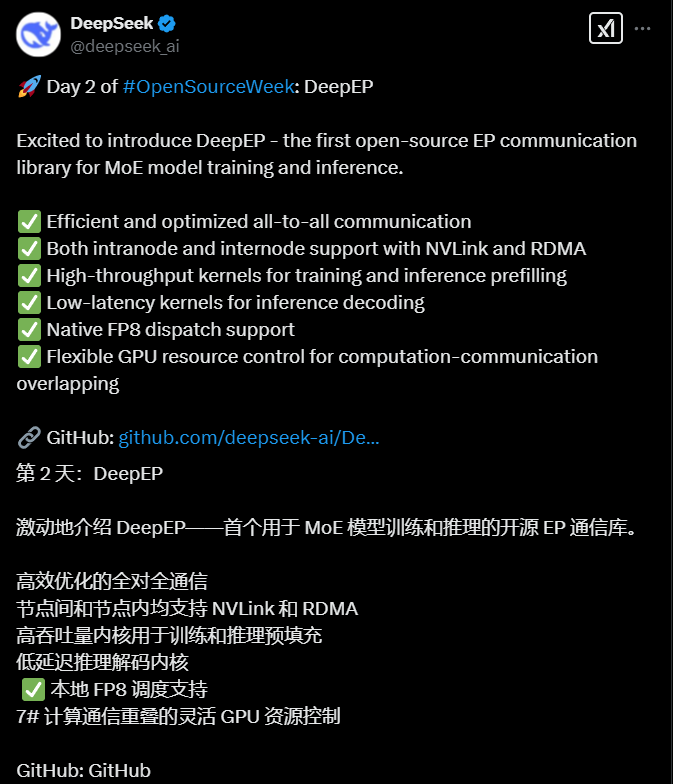

La bibliothèque de communication open source DeepEP, récemment publiée par DeepSeek, améliore considérablement l'efficacité de la transmission des informations entre GPU, atténuant ainsi fortement l'anxiété liée à la puissance de calcul ressentie par les professionnels du secteur.

Auteur : Liang Siqi

Image : générée par Wujie AI

Le 25 février, DeepSeek, connu pour ses contributions open source, a sorti un atout majeur : DeepEP, la première bibliothèque de communication full stack au monde destinée aux modèles MoE. En résolvant directement l'anxiété liée à la puissance de calcul en IA, elle a atteint 1500 étoiles sur GitHub (nombre de favoris) en un rien de temps, provoquant une onde de choc dans la communauté, ce qui témoigne de son importance.

Que signifie DeepEP ? Imaginez un centre logistique pendant le Singles Day : 2048 livreurs (GPU) transportent frénétiquement des colis (données d'IA) entre 200 entrepôts (serveurs). Le système traditionnel revient à faire livrer les colis à vélo cargo, alors que DeepEP équipe chaque employé d’un ensemble « train à lévitation magnétique + téléportation quantique » pour transmettre les informations de manière stable et efficace.

Caractéristique 1 : Changer directement les règles du transport

Lors de la conférence téléphonique de NVIDIA le 29 août 2024, Jensen Huang avait souligné l'importance de NVLink (technologie développée par NVIDIA permettant aux GPU de se connecter directement, avec une vitesse bidirectionnelle pouvant atteindre 1,8 To/s) pour les grands modèles linguistiques, notamment grâce à sa faible latence et son haut débit, la considérant comme l'une des technologies clés du développement des grands modèles.

Pourtant, cette technologie NVLink, tant vantée, vient d’être repensée à un niveau inédit par une équipe chinoise. L’astuce de DeepEP réside justement dans l’optimisation de NVLink : entre livreurs d’un même entrepôt, les marchandises circulent sur des rails à lévitation magnétique à une vitesse atteignant 158 conteneurs par seconde (Go/s), ce qui revient à réduire le trajet Pékin-Shanghai à la durée d’une gorgée d’eau.

La deuxième technologie révolutionnaire est un noyau RDMA à très faible latence. Imaginez maintenant que, entre entrepôts situés dans différentes villes, les marchandises soient « téléportées quantiquement », chaque avion (carte réseau) pouvant transporter jusqu’à 47 conteneurs par seconde, tout en chargeant les marchandises en vol, superposant calcul et communication, éliminant complètement les attentes d’arrêt.

Caractéristique 2 : Tri intelligent high-tech : le « cerveau ultra-puissant » version IA

Lorsque les colis doivent être distribués à différents experts (sous-réseaux dans un modèle MoE), les trieurs traditionnels doivent ouvrir chaque boîte individuellement. Le système « planification-combinaison » de DeepEP agit comme s’il avait le pouvoir de prémonition : en mode pré-remplissage d’entraînement, 4096 paquets empruntent simultanément un tapis roulant intelligent qui identifie automatiquement les livraisons intra-villes ou inter-villes ; en mode pré-remplissage d’inférence, 128 colis urgents passent par une voie VIP, livrés en 163 microsecondes — cinq fois plus vite qu’un clignement d’œil humain. Grâce à une technologie de changement dynamique de trajectoire, le système commute instantanément de mode en cas de pic de trafic, s’adaptant parfaitement aux divers scénarios.

Caractéristique 3 : La « technique de réduction de taille » FP8

Les marchandises standards sont transportées dans des caisses classiques (formats FP32/FP16), mais DeepEP compresse les objets en capsules miniatures (format FP8), permettant à un camion de transporter trois fois plus de marchandises. Plus impressionnant encore : ces capsules se reconstituent automatiquement à destination, économisant à la fois les frais d’expédition et le temps.

Ce système a déjà été testé avec succès dans les propres entrepôts de DeepSeek (grappe de GPU H800) : la vitesse de transport en ville triple, la latence inter-ville tombe à un niveau imperceptible pour l’humain, et le plus révolutionnaire est qu’il réalise une transmission véritablement « transparente » — comme si le livreur glissait des colis dans les casiers tout en roulant, sans aucune interruption.

Aujourd’hui, DeepSeek rend cette carte maîtresse open source, ce qui revient à publier les plans du système automatisé de tri de SF Express. Une tâche lourde nécessitant auparavant 2000 GPU peut désormais être facilement réalisée avec quelques centaines seulement.

Précédemment, DeepSeek avait publié le premier fruit de sa « semaine open source » : le code de FlashMLA (mécanisme rapide d’attention multiple implicite), une autre technologie clé pour réduire les coûts durant l’entraînement des grands modèles. Pour apaiser les tensions liées aux coûts dans toute la chaîne d’approvisionnement, DeepSeek partage généreusement ses connaissances.

Plus tôt, You Yang, fondateur de Langchen Technology, écrivait sur les réseaux sociaux : « À court terme, le modèle MaaS chinois pourrait être le pire modèle économique ». Il a fait une estimation simple : si 100 milliards de tokens sont produits quotidiennement, le coût mensuel des machines pour un service basé sur DeepSeek s’élèverait à 450 millions de yuans, soit une perte de 400 millions ; avec des puces AMD, le revenu mensuel serait de 45 millions, pour un coût machine de 270 millions, entraînant une perte supérieure à 200 millions de yuans.

Bienvenue dans la communauté officielle TechFlow

Groupe Telegram :https://t.me/TechFlowDaily

Compte Twitter officiel :https://x.com/TechFlowPost

Compte Twitter anglais :https://x.com/BlockFlow_News