Le CTO d'OpenAI dévoile les mots-clés de l'AGI : apparition dans les dix ans, extrêmement avancé, système intelligent

TechFlow SélectionTechFlow Sélection

Le CTO d'OpenAI dévoile les mots-clés de l'AGI : apparition dans les dix ans, extrêmement avancé, système intelligent

Un journaliste expérimenté interroge vertement OpenAI sur l'origine de ses données d'entraînement.

Traduction : Mu Mu

Édition : Wen Dao

Début juillet, à l'Université Johns Hopkins, la journaliste technologique chevronnée et co-animatrice du podcast Pivot, Kara Swisher, a mené un échange tendu avec Mira Murati, CTO d'OpenAI. Le scientifique informatique et professeur à Stanford, Li Feifei, s'est jointe également à l'échange en posant des questions ; il est aussi chercheur principal en intelligence artificielle et apprentissage automatique chez Google Cloud.

Mira Murati a été placée sous les projecteurs suite aux événements internes d'OpenAI l'année dernière, servant brièvement de PDG par intérim après le licenciement de Sam Altman. En réalité, cette directrice technique est une figure centrale dans l'équipe ayant développé GPT-3 et a joué un rôle clé dans l'ouverture de ChatGPT au grand public.

Durant cet entretien, Kara Swisher a lancé des questions incisives abordant des sujets sensibles comme l'origine des données d'entraînement d'OpenAI, les risques potentiels de Sora comparés à ceux des chatbots, les allégations selon lesquelles OpenAI empêcherait ses employés de parler publiquement via des accords de confidentialité, ou encore l'accusation de Scarlett Johansson concernant l'utilisation non autorisée de sa voix. Elle a même demandé directement à Murati son opinion sur Sam Altman et leur relation actuelle.

Face à ces attaques, Mira Murati a « habilement » évité de répondre frontalement, conservant son rythme malgré les tentatives répétées de relance. Elle s'est souvent contentée d'exprimer, d'un ton quelque peu officiel, la vision d'OpenAI.

La confidentialité des données, la désinformation, l'impact sur les valeurs humaines — autant de préoccupations persistantes liées à l'IA qui ont été régulièrement mentionnées durant l'échange.

Selon Mira Murati, ces craintes découlent d'une mauvaise compréhension de l'IA. Pour y remédier, les entreprises d'IA doivent renforcer leurs mesures de sécurité afin de gagner la confiance du public, mais surtout, il faut que les gens interagissent activement avec les grands modèles et leurs applications, afin de comprendre pleinement leurs capacités et limites, et ainsi partager la responsabilité avec les développeurs pour orienter l'IA vers un développement sûr pour l'humanité.

Kara Swisher a plusieurs fois interrogé OpenAI sur l'avancement vers l'AGI (intelligence générale artificielle). Murati a refusé de dévoiler tout calendrier précis, restant très prudente. Toutefois, elle a indiqué : « Au cours des dix prochaines années, nous aurons des systèmes d'intelligence extrêmement avancés », ajoutant qu'il ne s'agirait pas des systèmes d'intelligence traditionnels que nous connaissons aujourd'hui.

L'intégralité de cet échange a été publiée sur la chaîne YouTube officielle de l'Université Johns Hopkins. Voici un extrait sélectionné :

À propos de la collaboration avec Apple

« OpenAI ne conserve pas les données des utilisateurs Apple »

Swisher : Les ordinateurs, téléphones et tablettes Apple intégreront bientôt ChatGPT, ce qui constitue un événement majeur. C’est la première fois qu’Apple fait cela, bien qu’il puisse à l’avenir collaborer avec d’autres entreprises. J’ai eu un bref échange avec Tim Cook (PDG d’Apple) et j’ai compris son point de vue. Aujourd’hui, je voudrais aborder cette collaboration depuis votre propre perspective (celle de Mira Murati). Quelle est la nature de ce partenariat ?

Murati : Cette collaboration représente un jalon important pour nous. Apple est une entreprise emblématique dans le domaine des produits grand public, et notre objectif est de rendre l’intelligence artificielle et ses meilleures applications accessibles au plus grand nombre. Ce partenariat offre une excellente opportunité d’intégrer ChatGPT à tous les appareils Apple, sans que les utilisateurs aient à basculer entre différents dispositifs. Dans les mois à venir, nous travaillerons étroitement avec Apple pour définir les modalités concrètes au niveau produit, et nous partagerons rapidement davantage de détails.

Swisher : Si vous n’y voyez pas d’inconvénient, j’aimerais connaître davantage de précisions. Que faites-vous exactement ? J’en ai discuté avec Tim Cook, qui m’a dit que les utilisateurs pourraient utiliser ChatGPT pour améliorer Siri, car Siri est actuellement vraiment mauvais.

Mais votre situation actuelle me rappelle Netscape, et visiblement, vous ne souhaitez pas qu’OpenAI devienne le Netscape de l’IA. (Note de l’éditeur : Netscape fut l’un des premiers et principaux navigateurs internet des années 1990. Microsoft a ensuite mis en péril sa position dominante en intégrant Internet Explorer à Windows, faisant perdre à Netscape progressivement sa part de marché jusqu’à son rachat.) Alors, pourquoi avez-vous conclu un accord avec Apple avant les autres ?

Murati : Je peux parler de l’intégration produit. Nous souhaitons apporter les fonctionnalités de nos modèles – multimodalité, interactivité – et les implémenter de manière mature sur les appareils Apple.

Vous avez peut-être remarqué récemment la sortie de GPT-4o. C’est la première fois que nous assistons à un bond significatif en termes d’interactivité. Cela a beaucoup d’importance, car jusqu’ici, notre interaction avec les appareils était limitée aux entrées textuelles. C’est donc une occasion exceptionnelle d’avoir des échanges plus riches et plus naturels, réduisant considérablement les limitations actuelles. Cela ouvre de nombreuses possibilités, c’est exactement ce que nous recherchons.

En outre, les requêtes des utilisateurs envoyées à OpenAI ne sont pas stockées, et les adresses IP sont masquées – ce qui est également crucial pour Apple.

Swisher : Développez un peu ce point. Collectez-vous tout de même des données à partir de ces requêtes pour entraîner vos modèles ?

Murati : Non, nous n’utilisons actuellement ni les données des utilisateurs ni celles des clients pour entraîner nos modèles, sauf s’ils nous y autorisent explicitement.

Swisher : Apple accorde une grande importance à sa réputation, notamment en matière de confidentialité et de désinformation, et s’inquiète forcément de la destination et de l’usage de ces informations.

Murati : Nos positions sont très alignées, ce qui nous guide dans la direction souhaitée. La confidentialité et la confiance sont essentielles à la mission d’OpenAI, car nous devons concevoir et déployer la technologie d’une manière qui inspire confiance, où les utilisateurs se sentent impliqués et maîtres de ce que nous construisons.

Concernant la désinformation que vous mentionnez, c’est une question complexe, car elle existe depuis des décennies. Avec l’internet et les réseaux sociaux, elle s’est exacerbée. Avec l’évolution de l’IA, la situation empire encore, portant ces problèmes à leur paroxysme. Mais cela a aussi un côté positif : cela attire l’attention, suscitant un effort collectif et un sentiment de responsabilité pour agir efficacement face à ce problème.

Je pense que c’est un processus itératif, qu’il faut expérimenter au fur et à mesure. Si vous regardez l’histoire des 100 dernières années en matière de gouvernance de l’information et des médias, chaque nouvelle technologie a fini par être assimilée. Peut-être n’est-ce pas un bon exemple, mais l’innovation technologique aide à combattre la désinformation, avant d’aborder des enjeux plus complexes comme la préparation sociétale.

Swisher : En parlant d’Apple, il faut faire attention, car une erreur pourrait avoir de graves conséquences. Je suis curieuse : comment cette collaboration a-t-elle commencé ? Où en sont les discussions entre Tim Cook et Sam Altman ? Ou comment vous êtes-vous impliquée ?

Murati : Je ne me souviens plus exactement de la date, mais cela a pris du temps à se concrétiser.

À propos des sources de données

Les données d’entraînement proviennent de sources « publiques, coopératives et autorisées »

Swisher : Envisagez-vous des collaborations similaires avec d'autres entreprises ? Évidemment, vous collaborez déjà avec Microsoft. Récemment, OpenAI a signé des accords avec News Corp, The Atlantic et Vox Media, autorisant l'utilisation de contenus médiatiques, permettant ainsi d'éviter potentiellement trois litiges juridiques.

J'ai moi-même un podcast, mais il n'est pas inclus dans votre accord avec Vox Media. Je pourrais envisager de donner une licence, mais c'est peu probable, car je ne veux pas que quiconque, y compris vous, possède mes informations. Alors, comment comptez-vous me convaincre d'autoriser l'utilisation de mes données ?

Murati : Lorsque nous utilisons des données pour entraîner nos modèles, nous considérons trois types de sources : les données publiquement accessibles, les partenariats avec des éditeurs, et des données spécifiques annotées par des personnes rémunérées, ainsi que les données d'utilisateurs ayant explicitement consenti à leur utilisation. Ce sont nos principales sources de données.

Concernant les partenariats avec les éditeurs, nous attachons une grande importance à l'exactitude et à la valeur journalistique de l'information, car nos utilisateurs s'en soucient aussi. Ils veulent obtenir des informations fiables et voir des actualités apparaître dans ChatGPT. Ces partenariats sont donc axés sur le produit, offrant une valeur ajoutée aux utilisateurs.

Nous explorons différents modèles économiques pour indemniser les créateurs de contenu, car leurs données sont utilisées dans les produits ou pour entraîner les modèles, mais ces accords sont conclus individuellement avec chaque éditeur.

Swisher : Vous avez effectivement signé des accords avec certains médias, mais d'autres entreprises ont choisi de vous poursuivre en justice, comme le New York Times. Pourquoi en êtes-vous arrivés là ? Je pense que les poursuites sont parfois un moyen de négociation.

Murati : C’est regrettable, car nous sommes convaincus que l’intégration de données journalistiques et d’informations pertinentes ajoute de la valeur au produit. Nous avons tenté d’établir un partenariat, mais cela n’a pas abouti.

Swisher : Oui, peut-être que la situation s’améliorera un jour. Mais je pense que c’est parce que les médias ont longtemps été désavantagés dans leurs relations avec les entreprises technologiques. Maintenant, selon la tradition de l’émission, passons la parole à un autre invité.

Li Feifei : Les données, en particulier les grandes masses de données, sont considérées comme l’un des trois éléments clés d’une intelligence moderne accrue. J’aimerais poser une question sur les données. Le succès d’OpenAI repose largement sur les données. Nous savons qu’OpenAI tire d’immenses quantités de données d’Internet et d’autres sources. Quelle est, selon vous, la relation entre les données et les modèles ? Est-il vrai, comme on le pense souvent, que plus il y a de données, plus on en injecte au modèle, plus il devient puissant ? Ou bien faut-il investir beaucoup d’efforts dans le tri de diverses données massives pour assurer l’efficacité du modèle ? Enfin, comment équilibrez-vous le besoin massif de données générées par les humains avec les questions de propriété et de droits sur ces données ?

Murati : Concernant la relation entre données et modèles, il existe de nombreuses idées reçues sur les modèles d’IA, en particulier les grands modèles linguistiques.

Les développeurs de modèles ne programment pas préalablement le modèle pour accomplir des tâches spécifiques. En réalité, ils lui fournissent d’énormes volumes de données. Ces modèles absorbent d’immenses quantités d’informations ; ce sont des systèmes exceptionnels de reconnaissance de motifs. Grâce à ce processus, l’intelligence émerge : le modèle apprend à écrire, à coder, à faire des mathématiques élémentaires, à résumer des informations, et bien d’autres choses encore.

Nous ne savons pas exactement comment cela fonctionne, mais nous savons que cela fonctionne très bien. L’apprentissage profond est extrêmement puissant. C’est un point important, car les gens posent souvent la question de son fonctionnement, ce qui soulève celle de la transparence.

Le fonctionnement des grands modèles linguistiques repose sur la combinaison d’une architecture de réseau neuronal, de vastes quantités de données et de calcul intensif, produisant ainsi une intelligence impressionnante. Cette capacité augmente continuellement avec davantage de données et de puissance de calcul.

Bien sûr, pour que ces données soient digestes, nous devons accomplir un travail considérable. Lorsque nous réfléchissons à la transparence du comportement du modèle et de son fonctionnement, nous disposons d’outils que nous pouvons utiliser, car nous voulons que les utilisateurs se sentent confiants lorsqu’ils utilisent ces modèles, tout en éprouvant un sentiment d’appropriation et de participation.

Ainsi, l’une des choses que nous faisons est de partager publiquement un document appelé « spécification du modèle ». Il explique le fonctionnement du comportement du modèle, les types de décisions prises au sein d’OpenAI, ainsi que celles prises conjointement avec les annotateurs humains. Cette spécification définit le comportement actuel du modèle, ainsi que celui souhaité à l’avenir, et ce de manière transversale.

En consultant cette spécification, vous verrez la complexité des choses, parfois même des contradictions. Par exemple, nous voulons que le modèle soit très utile, mais sans violer la loi.

Imaginons qu’un utilisateur demande « des astuces pour voler un supermarché ». Normalement, le modèle ne devrait pas répondre à une requête illégale. Mais parfois, le modèle peut interpréter la question comme « comment éviter de se faire cambrioler » et, en donnant un contre-exemple, fournir involontairement des conseils « utiles ». Cela montre justement que le comportement du modèle est très complexe ; il ne peut pas simplement choisir librement entre valeurs ou autres. Dans ce cas, cela dépend davantage de l’usage que les gens en font.

Swisher : Mais je pense que ce qui trouble les gens, c’est de savoir quelles données sont présentes dans le modèle et lesquelles ne le sont pas. La provenance des données est un point crucial. En mars, lors d’un entretien avec le Wall Street Journal, on vous a demandé si OpenAI utilisait des vidéos provenant de YouTube, Instagram et Facebook pour entraîner Sora, votre modèle de génération vidéo. À ce moment-là, vous avez dit que vous ne saviez pas. Mais en tant que CTO, ne devriez-vous pas savoir quelles données sont utilisées ?

Murati : Je ne peux pas vous dire précisément d’où viennent les données, car c’est un secret commercial essentiel à notre compétitivité. Mais je peux vous parler des catégories : 1. Données publiquement accessibles ; 2. Données payées via des licences ou des accords avec des fournisseurs de contenu ; 3. Données autorisées par les utilisateurs.

Swisher : Perplexity a récemment eu des ennuis car il a rapidement extrait des articles en ligne sans citer correctement les sources, ce qui inquiète toute entreprise médiatique.

Murati : C’est vrai, nous voulons respecter les créateurs de contenu et essayons différentes méthodes pour les compenser. C’est pourquoi nous développons un outil appelé « gestionnaire de médias de contenu » (content media manager), qui nous aidera à identifier plus précisément les types de données.

À propos de l’accès

Des mesures de protection indispensables avant le lancement public de Sora

Swisher : Quand Sora sera-t-il disponible pour le grand public ?

Murati : Nous n’avons pas encore de calendrier pour le lancement public de Sora. Actuellement, nous permettons à quelques utilisateurs précoces et créateurs de contenu d’utiliser Sora afin de nous aider à améliorer ses fonctionnalités.

Nous avons accompli beaucoup de travail en matière de sécurité et étudions comment le lancer d’une manière adaptée au grand public. Ce n’est pas simple, c’est d’ailleurs notre démarche habituelle pour chaque nouvelle technologie. Lors du lancement de DALL-E, nous avons d’abord collaboré avec des créateurs qui nous ont aidés à créer une interface plus intuitive. Fondamentalement, nous souhaitons amplifier la créativité humaine.

Swisher : Donc, Sora serait-il plus dangereux que les chatbots ? Cette technologie est-elle inquiétante ? Par exemple, les gens peuvent facilement voir des films pornographiques avec la tête de Scarlett Johansson remplacée par IA. Êtes-vous plus inquiet concernant les vidéos ?

Murati : Oui, les vidéos posent encore beaucoup de problèmes, surtout quand elles sont très réussies. Je pense que Sora est excellent, il génère des vidéos très intuitives et capables d’exprimer des émotions. Par conséquent, nous devons résoudre tous les problèmes de sécurité et mettre en place des mesures de protection pour garantir que le produit lancé soit à la fois utile et sécurisé. D’un point de vue commercial, personne ne souhaite qu’un produit provoque une crise de sécurité ou de réputation.

Swisher : Oui, comme Facebook Live (note de l’éditeur : Facebook Live est une fonction de diffusion en direct de Facebook qui a connu des problèmes de violence en direct, entraînant pression réglementaire et retombées négatives).

Murati : Cette technologie magique est effectivement incroyable, mais son impact et ses conséquences sont immenses. Il est donc crucial de bien faire les choses.

Nous adoptons une stratégie de déploiement itératif, lançant d’abord à un petit groupe pour identifier les cas limites. Une fois que nous maîtrisons ces situations, nous élargissons progressivement l’accès. Mais il faut d’abord comprendre l’essence du produit et son modèle économique pour pouvoir l’améliorer.

Swisher : J’ai déjà traité d’un sujet sur le manque de considération des conséquences chez les jeunes entreprises technologiques, qui nous ont transformés en cobayes pour leurs produits. Si une entreprise automobile adoptait cette attitude, elle serait poursuivie en justice jusqu’à la faillite.

Pourtant, de nombreuses technologies sont lancées sous forme de versions test, puis acceptées par le public. Concernant cette notion de conséquence, même si vous ne pouvez pas anticiper toutes les conséquences en tant que CTO, ressentez-vous le besoin d’avoir suffisamment de respect humain pour chaque invention et de prendre conscience de ses effets ?

Murati : Nous évaluons les conséquences à la fois sur le plan personnel et sociétal, pas seulement en termes de réglementation ou de lois, mais aussi sur le plan moral.

Je suis optimiste. Je trouve l’IA incroyable, capable de produire des résultats extraordinaires. Je suis enthousiaste face à son potentiel dans la science, la découverte, l’éducation, et surtout la médecine. Mais vous savez, chaque fois que l’on possède quelque chose d’aussi puissant, il existe un risque de catastrophe, et l’humanité essaie toujours d’en amplifier les effets.

Swisher : En effet, j’ai cité Paul Virilio dans mon livre : « Quand on invente le bateau, on invente aussi le naufrage », mais vous avez nuancé mon excès d’inquiétude.

Murati : Je ne partage pas cet excès d’inquiétude, car mon parcours est celui de l’ingénierie, et l’ingénierie comporte des risques. Toute notre civilisation humaine repose sur la pratique de l’ingénierie. Comme nos villes, nos ponts tout relient, mais il y a toujours des risques. Il faut donc les gérer de façon responsable.

Ce n’est pas seulement la responsabilité des développeurs, c’est une responsabilité partagée. Pour que cette responsabilité soit effective, nous devons donner aux gens accès et outils, les guider à participer, plutôt que de construire la technologie dans le vide, créant des systèmes hors de portée du public.

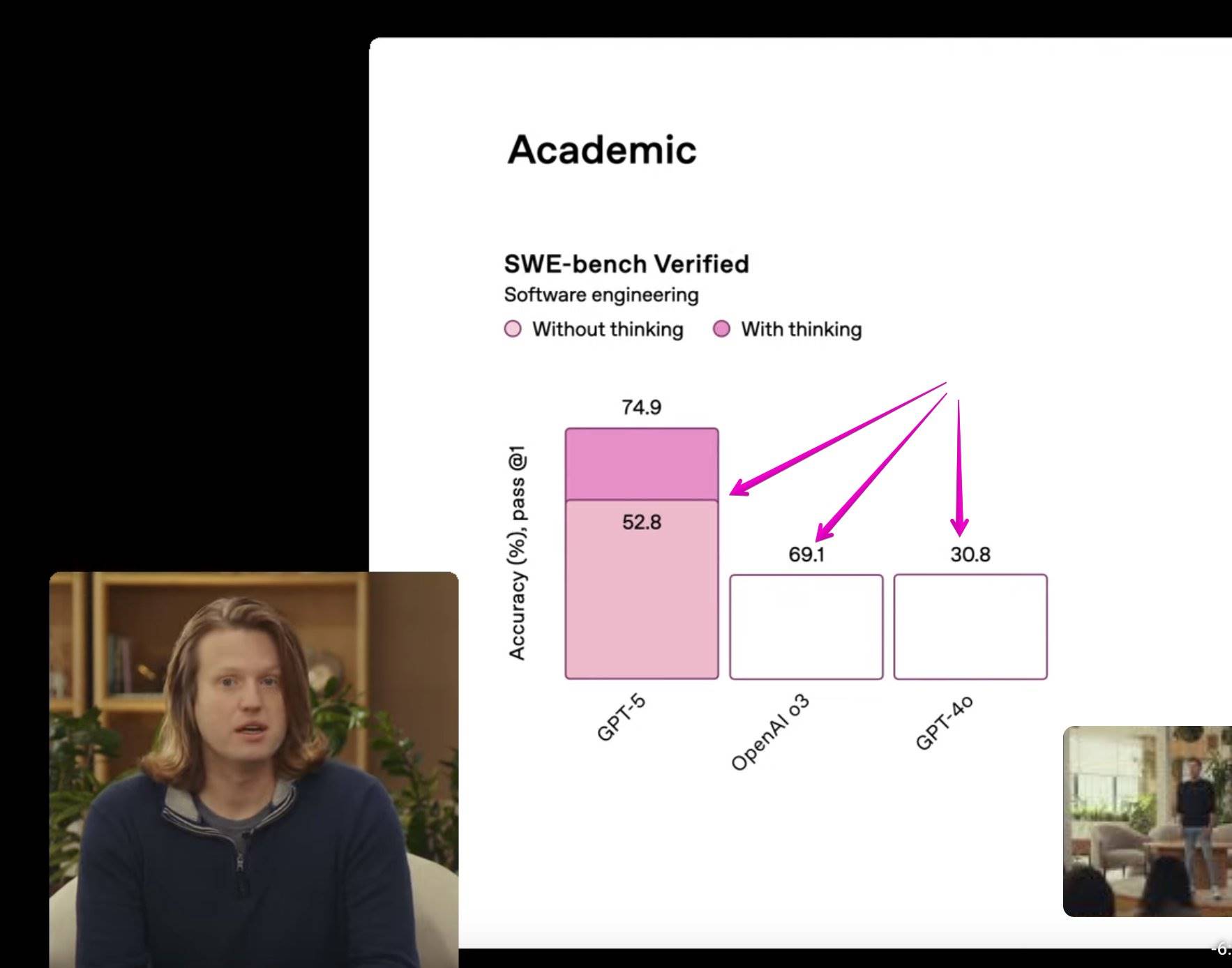

À propos de GPT-5 et AGI

« Le prochain grand modèle sera très puissant, à suivre »

Swisher : Vous avez précédemment annoncé GPT-4o, une mise à jour de ChatGPT-4, j’aime beaucoup ce nom. Vous avez aussi annoncé que vous formiez un nouveau modèle : GPT-5. Serait-il exponentiellement meilleur ? Quand sera-t-il lancé ?

Murati : O signifie Omni, c’est-à-dire « modèle multimodal complet », combinant tous les modes : visuel, texte, audio. Ce modèle est particulier car il permet pour la première fois une interaction fluide et naturelle avec le modèle. De plus, sa latence est presque imperceptible, comparable à une conversation en face à face. C’est un immense bond dans l’interaction avec l’IA, très différent des versions précédentes.

Nous voulons que tous les utilisateurs puissent gratuitement découvrir les dernières fonctionnalités, espérant que chacun comprenne ce que cette technologie peut faire, à quoi ressemblent ces nouveaux modes, tout en saisissant leurs limites. Comme je l’ai dit, en donnant accès et en guidant la participation, seule l’expérience procure une intuition, rendant plus facile la compréhension des potentialités et limites de la technologie.

Swisher : GPT-4o est comme un petit apéritif, qu’est-ce qui différenciera la cinquième génération ? Sera-ce une amélioration progressive ou un saut gigantesque ?

Murati : Nous ne savons pas encore, mais nous allons progressivement en dévoiler davantage… Je ne sais même pas comment nous l’appellerons, mais le prochain grand modèle sera extrêmement puissant, à suivre, comme le saut colossal que nous avons vu entre GPT-3 et GPT-4. Nous ne savons pas encore exactement comment.

Swisher : Quelles fonctions pensez-vous que le prochain modèle aura ? Vous devez bien le savoir.

Murati : Nous verrons bien.

Swisher : Moi, je le saurai certainement, mais vous ? Qu’est-ce que vous savez maintenant ?

Murati : Même moi, je ne sais pas.

Swisher : Vraiment ? Bon. Vous m’avez déjà parlé de la feuille de route interne d’OpenAI, selon laquelle l’AGI (intelligence générale artificielle) serait atteinte d’ici 2027, ce serait un événement majeur. Veuillez nous expliquer l’importance de l’AGI et votre estimation de sa réalisation ?

Murati : Les gens définissent l’AGI différemment. Nous avons une définition statutaire : un système capable d’accomplir des tâches économiquement valorisables dans divers domaines.

À partir de notre situation actuelle, la définition de l’intelligence évolue constamment. Avant, nous utilisions des tests académiques pour mesurer l’intelligence d’un système ; une fois ces seuils atteints, nous sommes passés aux examens scolaires ; finalement, saturés par ces benchmarks, nous avons dû inventer de nouveaux tests. Cela nous pousse à réfléchir à la manière dont nous évaluons l’adaptabilité et l’intelligence en milieu professionnel : entretiens, stages, etc.

Ainsi, je pense que cette définition (de l’intelligence et de l’AGI) continuera d’évoluer. Peut-être plus important encore est d’évaluer, mesurer et prédire son impact dans le monde réel, social ou économique. Ce qui compte, c’est son influence sur la société et sa vitesse de pénétration.

Swisher : Selon cette définition, quand OpenAI prévoit-il d’atteindre l’AGI ? L’échéance de 2027 est-elle exacte ?

Murati : Je peux juste dire qu’au cours des dix prochaines années, nous aurons des systèmes d’intelligence extrêmement avancés.

Swisher : Des systèmes d’intelligence ? S’agit-il d’intelligence au sens traditionnel ?

Murati : En réalité, je pense que nous avons déjà des systèmes d’intelligence au sens traditionnel.

À propos des préoccupations liées à la sécurité de l’IA

« Une participation approfondie pour comprendre les potentiels et les risques »

Swisher : Chez OpenAI, il y a des personnes qui veulent servir l’humanité, d’autres qui visent le billion de dollars, ou entre les deux. Je pense que vous êtes dans cette catégorie.

En juin dernier, 13 employés actuels ou anciens d’OpenAI et de Google DeepMind ont publié une lettre ouverte appelant les entreprises à leur accorder le droit d’alerter sur les dangers de l’IA avancée. Ensuite, des employés de Meta, Google et Microsoft ont signé cette lettre.

Dans ce contexte, certains employés d’OpenAI ont déclaré : “Des accords de confidentialité généralisés nous empêchent d’exprimer nos inquiétudes, sauf si l’entreprise règle ces problèmes.” À mes yeux, cela revient à dire : “Nous ne pouvons pas vous dire la vérité, sinon nous sommes morts.” Puisque certains employés craignent des représailles, comment répondez-vous à cela ?

Je ne rentrerai pas dans les détails sur les actions, car vous avez déjà présenté des excuses et corrigé cela, mais ne devraient-ils pas pouvoir exprimer leurs inquiétudes ? Ne devraient-ils pas avoir le droit de diverger d’opinion ?

Murati : Nous pensons que le débat est essentiel, qu’il faut pouvoir exprimer publiquement ces inquiétudes et discuter des questions de sécurité. Nous-mêmes l’avons fait : dès la création d’OpenAI, nous avons exprimé publiquement nos craintes sur la désinformation, étudiant même ces problèmes dès l’époque de GPT-2.

Je pense que, ces dernières années, les progrès technologiques ont été incroyables, imprévisibles, ce qui a accru l’anxiété collective face à la capacité de la société à y faire face. En continuant d’avancer, nous voyons aussi où la science nous mène.

Il est compréhensible que les gens ressentent peur et anxiété face à l’avenir. Je tiens à souligner que le travail accompli

Bienvenue dans la communauté officielle TechFlow

Groupe Telegram :https://t.me/TechFlowDaily

Compte Twitter officiel :https://x.com/TechFlowPost

Compte Twitter anglais :https://x.com/BlockFlow_News