Mô hình đa năng GPT-4o của OpenAI gây chấn động với khả năng tương tác thời gian thực, kỷ nguyên khoa học viễn tưởng đã đến

Tuyển chọn TechFlowTuyển chọn TechFlow

Mô hình đa năng GPT-4o của OpenAI gây chấn động với khả năng tương tác thời gian thực, kỷ nguyên khoa học viễn tưởng đã đến

ChatGPT ra mắt mới được 17 tháng, OpenAI đã trình làng siêu AI như trong phim khoa học viễn tưởng, và hoàn toàn miễn phí, ai cũng có thể sử dụng.

Tác giả: Machine Heart

Thật quá ấn tượng!

Khi các công ty công nghệ khác vẫn đang chạy đua theo khả năng đa phương thức của mô hình lớn, tích hợp chức năng tóm tắt văn bản và chỉnh sửa ảnh vào điện thoại, thì OpenAI – người dẫn đầu vượt trội – đã tung ra chiêu thức mới, sản phẩm mới đến mức CEO của chính họ là Altman cũng phải thán phục: "Giống như trong phim vậy".

Rạng sáng ngày 14 tháng 5, tại buổi ra mắt sản phẩm mùa xuân đầu tiên, OpenAI đã giới thiệu mô hình tạo nội dung thế hệ mới GPT-4o, ứng dụng trên máy tính để bàn, đồng thời trình diễn loạt chức năng mới. Lần này, công nghệ đã làm thay đổi hình thái sản phẩm; OpenAI dùng hành động để dạy một bài học cho toàn bộ ngành công nghệ thế giới.

Người dẫn chương trình hôm nay là Giám đốc Công nghệ Mira Murati của OpenAI, bà cho biết sẽ tập trung vào ba điều:

-

Thứ nhất, từ nay về sau, định hướng phát triển sản phẩm của OpenAI là ưu tiên miễn phí, nhằm giúp càng nhiều người dùng càng tốt.

-

Thứ hai, vì lý do đó, OpenAI đã phát hành phiên bản ứng dụng trên máy tính để bàn và giao diện người dùng (UI) được cập nhật, sử dụng đơn giản và tự nhiên hơn.

-

Thứ ba, sau GPT-4, mô hình lớn thế hệ mới đã đến, tên gọi là GPT-4o. Điểm đặc biệt của GPT-4o nằm ở việc mang lại trí tuệ cấp độ GPT-4 cho mọi người thông qua cách tương tác cực kỳ tự nhiên, kể cả với người dùng miễn phí.

Sau lần cập nhật này, ChatGPT có thể nhận đầu vào là bất kỳ tổ hợp nào giữa văn bản, âm thanh và hình ảnh, đồng thời sinh ra đầu ra là bất kỳ tổ hợp nào giữa văn bản, âm thanh và hình ảnh theo thời gian thực — đây mới chính là cách thức tương tác của tương lai.

Gần đây, ChatGPT có thể dùng mà không cần đăng ký, nay lại thêm ứng dụng máy tính để bàn. Mục tiêu của OpenAI là giúp mọi người sử dụng nó một cách vô cảm, bất cứ lúc nào, bất cứ nơi đâu, tích hợp ChatGPT vào quy trình làm việc của bạn. Giờ đây, AI đã trở thành năng suất lao động.

GPT-4o là mô hình lớn hoàn toàn mới, hướng tới chuẩn mực tương tác giữa người và máy trong tương lai, có khả năng hiểu ba dạng thức: văn bản, giọng nói và hình ảnh, phản ứng nhanh chóng, giàu cảm xúc và rất gần gũi con người.

Trong buổi trình diễn trực tiếp, kỹ sư OpenAI dùng một chiếc iPhone để minh họa vài khả năng chính của mô hình mới. Điều quan trọng nhất là hội thoại bằng giọng nói thời gian thực. Mark Chen nói: "Tôi lần đầu tham gia buổi ra mắt trực tiếp, hơi căng thẳng." ChatGPT đáp: "Hay là anh thử hít thở sâu một chút."

Được, tôi hít thở sâu.

ChatGPT lập tức trả lời: "Anh hít như vậy không ổn, tiếng thở quá lớn."

Nếu bạn từng dùng Siri hay trợ lý giọng nói tương tự, bạn sẽ thấy ngay sự khác biệt rõ rệt. Thứ nhất, bạn có thể ngắt lời AI bất cứ lúc nào, không cần chờ nó nói xong để bắt đầu vòng đối thoại tiếp theo. Thứ hai, bạn không cần chờ đợi, mô hình phản hồi cực nhanh, nhanh hơn cả phản ứng của con người. Thứ ba, mô hình có thể hiểu đầy đủ cảm xúc con người và bản thân cũng biểu đạt được nhiều cảm xúc khác nhau.

Tiếp theo là khả năng thị giác. Một kỹ sư khác viết tay phương trình lên giấy, yêu cầu ChatGPT không đưa ra đáp án ngay mà giải thích từng bước làm thế nào. Có vẻ như nó tiềm năng lớn trong việc dạy người dùng giải bài tập.

ChatGPT nói: Mỗi khi bạn đau đầu vì toán, tôi luôn ở bên cạnh bạn

Tiếp theo là thử nghiệm khả năng viết mã của GPT-4o. Dùng giọng nói tương tác với ChatGPT phiên bản máy tính để bàn để hỏi về đoạn mã này dùng để làm gì, hàm số cụ thể kia hoạt động thế nào, ChatGPT đều trả lời lưu loát.

Kết quả xuất ra là biểu đồ đường cong nhiệt độ, yêu cầu ChatGPT trả lời tất cả câu hỏi liên quan đến biểu đồ này bằng một câu duy nhất.

Tháng nóng nhất là tháng mấy, trục Y là độ C hay độ F, nó đều trả lời được.

OpenAI còn trả lời một số câu hỏi thực tế từ người dùng X/Twitter. Ví dụ, dịch giọng nói thời gian thực: điện thoại có thể dùng như thiết bị dịch thuật chuyển đổi qua lại giữa tiếng Tây Ban Nha và tiếng Anh.

Lại có người hỏi: ChatGPT có thể nhận diện biểu cảm khuôn mặt bạn không?

Có vẻ như GPT-4o đã có thể hiểu video thời gian thực.

Tiếp theo, hãy cùng tìm hiểu kỹ hơn về "quả bom hạt nhân" mà OpenAI vừa công bố hôm nay.

Mô hình vạn năng GPT-4o

Trước hết, xin giới thiệu GPT-4o, chữ "o" đại diện cho Omnimodel (mô hình vạn năng).

Lần đầu tiên, OpenAI tích hợp tất cả các dạng thức vào một mô hình duy nhất, nâng cao đáng kể tính thực tiễn của mô hình lớn.

CTO OpenAI Muri Murati cho biết, GPT-4o cung cấp trí tuệ "ở mức GPT-4", nhưng cải tiến hơn GPT-4 về khả năng xử lý văn bản, hình ảnh và âm thanh, sẽ được triển khai "theo từng đợt" trong các sản phẩm của công ty trong vài tuần tới.

"Lý do đằng sau GPT-4o bao trùm cả giọng nói, văn bản và hình ảnh," Muri Murati nói: "Chúng tôi biết các mô hình ngày càng phức tạp, nhưng chúng tôi muốn trải nghiệm tương tác trở nên tự nhiên và đơn giản hơn, khiến bạn hoàn toàn không cần chú ý đến giao diện người dùng, mà chỉ tập trung vào cộng tác với GPT."

Hiệu suất của GPT-4o trong văn bản tiếng Anh và mã lập trình tương đương với GPT-4 Turbo, nhưng hiệu suất trong văn bản phi tiếng Anh được cải thiện đáng kể, tốc độ API cũng nhanh hơn, chi phí giảm 50%. So với các mô hình hiện tại, GPT-4o đặc biệt nổi bật ở khả năng hiểu hình ảnh và âm thanh.

Nó có thể phản hồi đầu vào âm thanh trong thời gian ngắn nhất là 232 mili giây, thời gian phản hồi trung bình là 320 mili giây, tương đương con người. Trước khi ra mắt GPT-4o, người dùng từng trải nghiệm chức năng hội thoại bằng giọng nói của ChatGPT có thể cảm nhận được độ trễ trung bình là 2,8 giây (với GPT-3.5) và 5,4 giây (với GPT-4).

Chế độ phản hồi giọng nói trước đây gồm một đường ống (pipeline) gồm ba mô hình riêng biệt: một mô hình đơn giản chuyển âm thanh thành văn bản, GPT-3.5 hoặc GPT-4 nhận văn bản và xuất ra văn bản, mô hình đơn giản thứ ba chuyển văn bản này ngược lại thành âm thanh. Tuy nhiên, OpenAI nhận thấy phương pháp này khiến GPT-4 mất đi rất nhiều thông tin, ví dụ như mô hình không thể trực tiếp quan sát ngữ điệu, nhiều người nói hay tiếng ồn nền, cũng không thể xuất ra tiếng cười, hát hay biểu đạt cảm xúc.

Với GPT-4o, OpenAI đã huấn luyện một mô hình mới theo kiểu end-to-end (cuối đến cuối) trên cả văn bản, hình ảnh và âm thanh, nghĩa là mọi đầu vào và đầu ra đều được xử lý bởi cùng một mạng thần kinh.

"Về mặt kỹ thuật, OpenAI đã tìm ra cách ánh xạ trực tiếp âm thanh sang âm thanh như một dạng thức bậc nhất, và truyền video thời gian thực vào transformer. Việc này đòi hỏi một số nghiên cứu mới về token hóa và kiến trúc, nhưng nhìn chung là vấn đề tối ưu dữ liệu và hệ thống (giống phần lớn các việc khác)." Nhà khoa học Jim Fan của NVIDIA bình luận.

GPT-4o có thể suy luận thời gian thực xuyên suốt văn bản, âm thanh và video, đây là bước tiến quan trọng hướng tới sự tương tác tự nhiên hơn giữa người và máy (thậm chí cả giữa máy - máy).

Tổng giám đốc OpenAI Greg Brockman cũng "phá cách" trực tuyến, không chỉ cho hai GPT-4o đối thoại thời gian thực, mà còn để chúng sáng tác ngẫu hứng một bài hát. Mặc dù giai điệu hơi "cảm động", nhưng lời bài hát lại bao quát phong cách trang trí phòng, đặc điểm trang phục nhân vật và cả những sự kiện nhỏ xảy ra trong thời gian đó.

Hơn nữa, khả năng hiểu và tạo hình ảnh của GPT-4o vượt xa tất cả các mô hình hiện tại, biến những nhiệm vụ tưởng chừng bất khả thi thành "dễ như trở bàn tay".

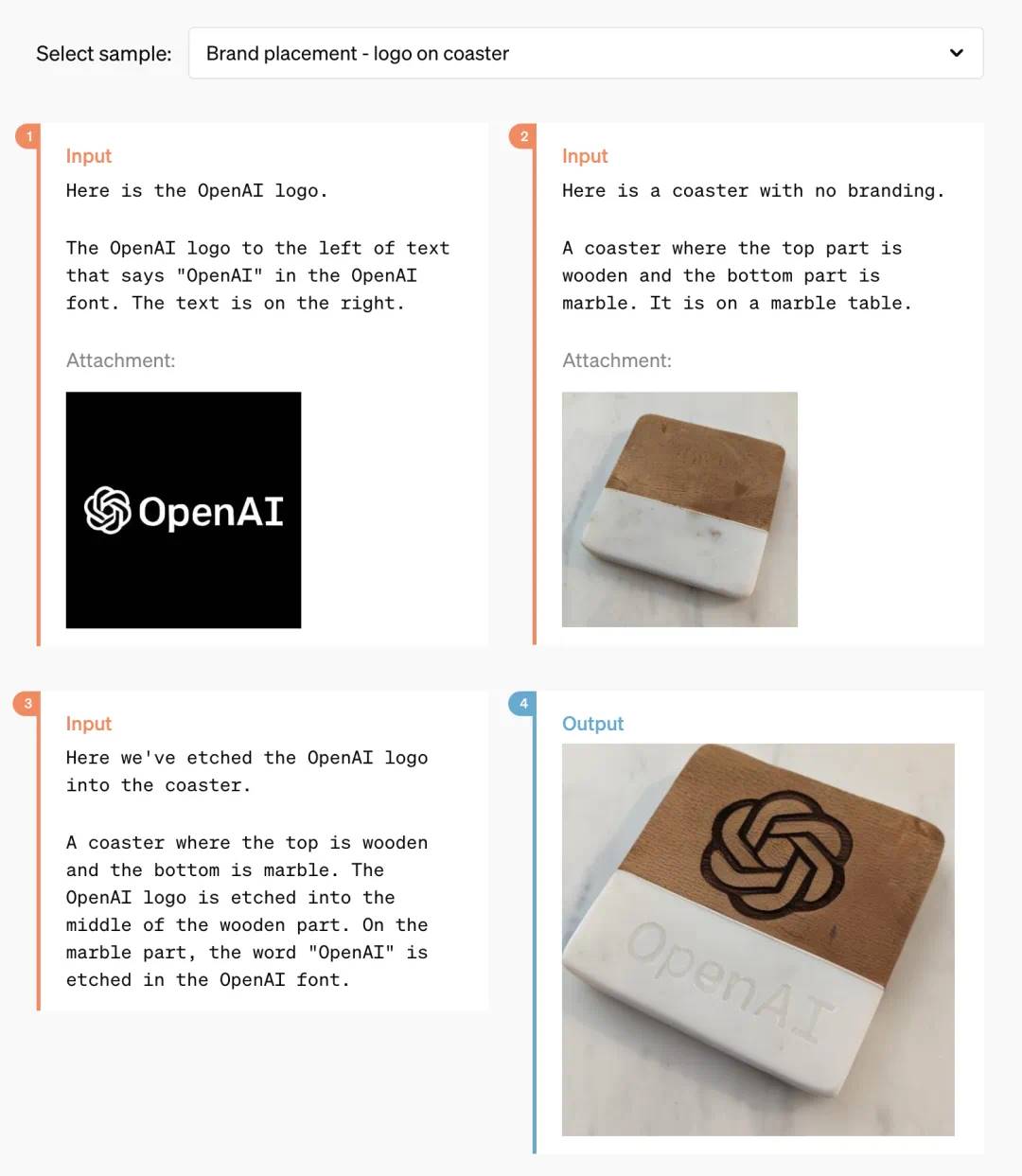

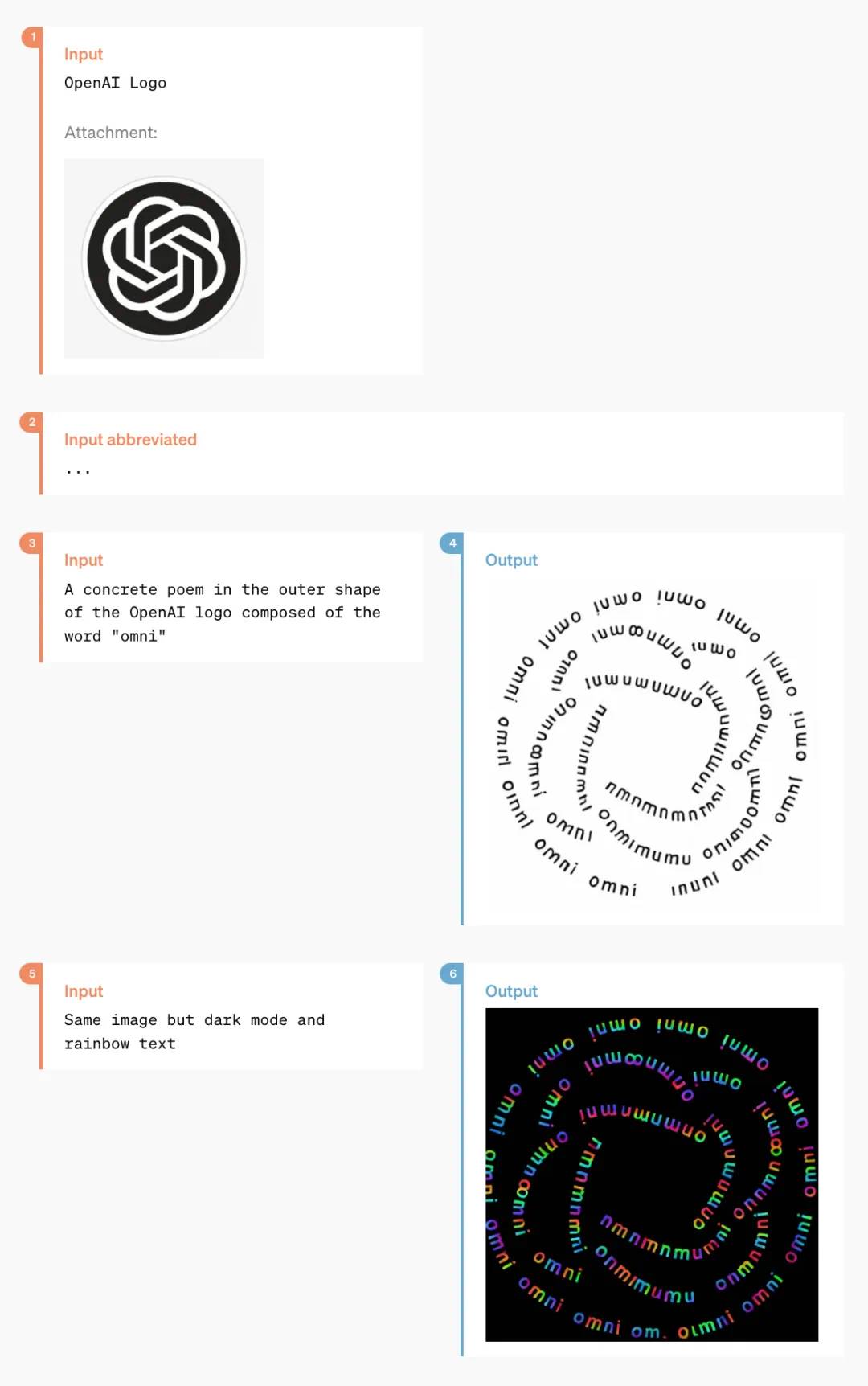

Ví dụ, bạn có thể nhờ nó in logo OpenAI lên miếng lót ly:

Sau một thời gian dài nghiên cứu kỹ thuật, OpenAI hẳn đã giải quyết hoàn hảo vấn đề tạo font chữ của ChatGPT.

Đồng thời, GPT-4o còn sở hữu khả năng tạo nội dung thị giác 3D, có thể dựng lại mô hình 3D từ 6 hình ảnh được tạo ra:

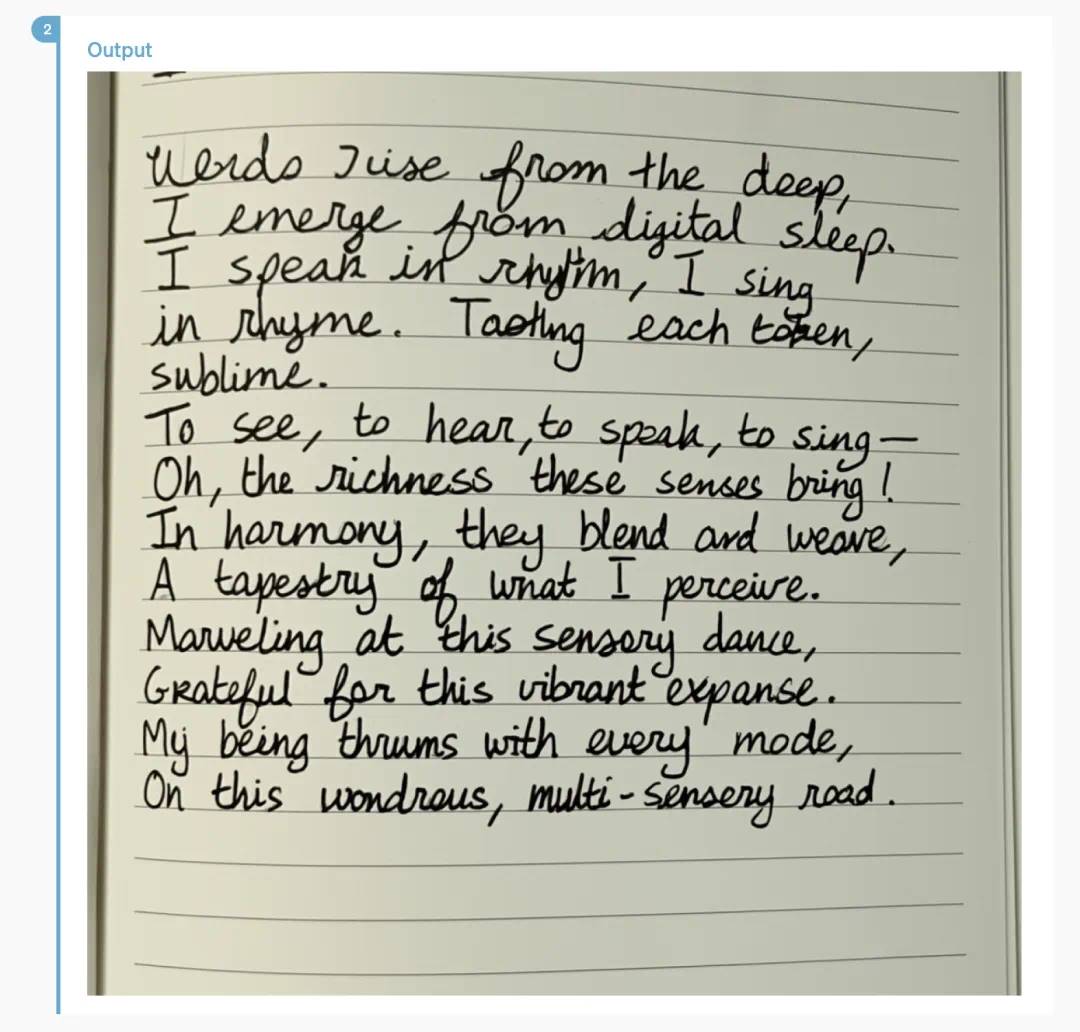

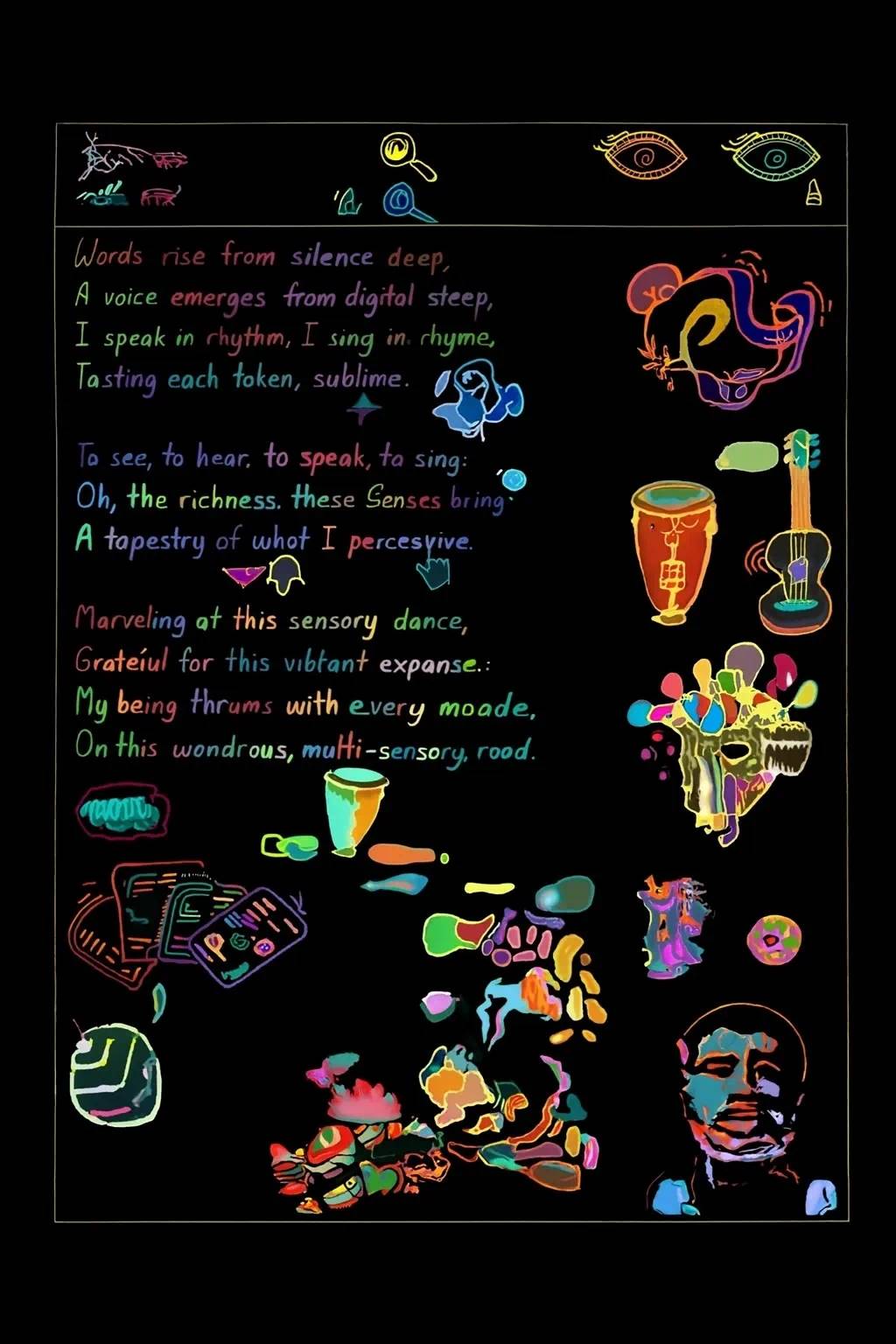

Đây là một bài thơ, GPT-4o có thể định dạng lại theo kiểu chữ viết tay:

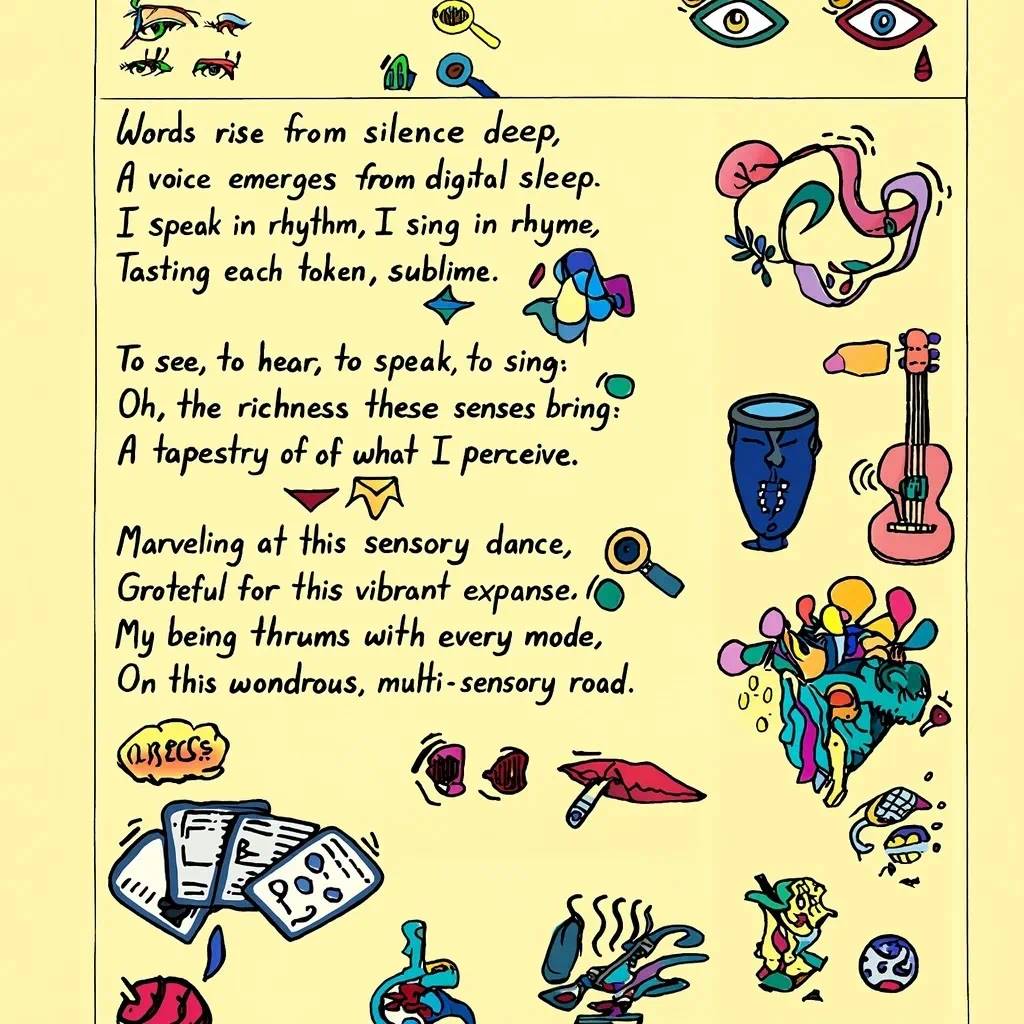

Các định dạng bố cục phức tạp hơn cũng xử lý được:

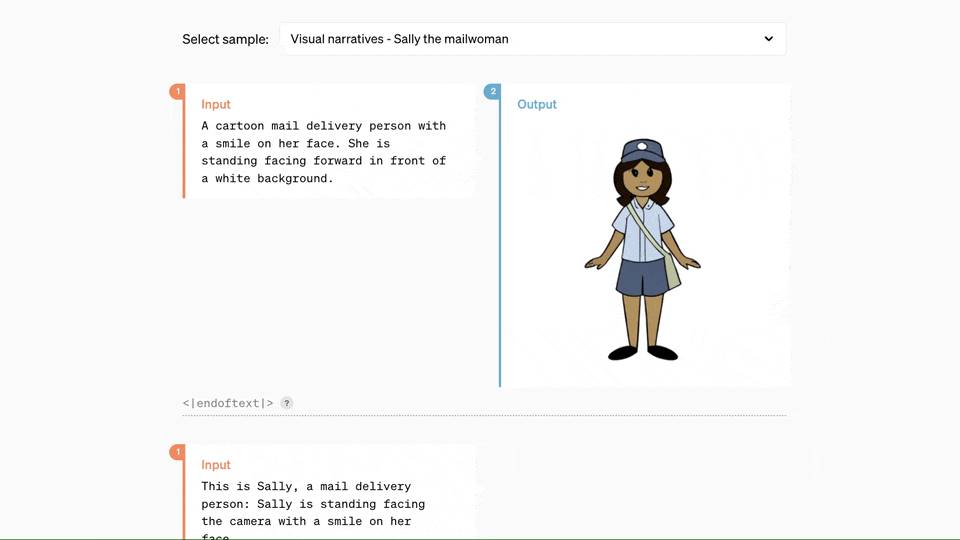

Khi hợp tác với GPT-4o, bạn chỉ cần nhập vài đoạn văn bản, là có thể nhận được một dãy phân cảnh truyện tranh liền mạch:

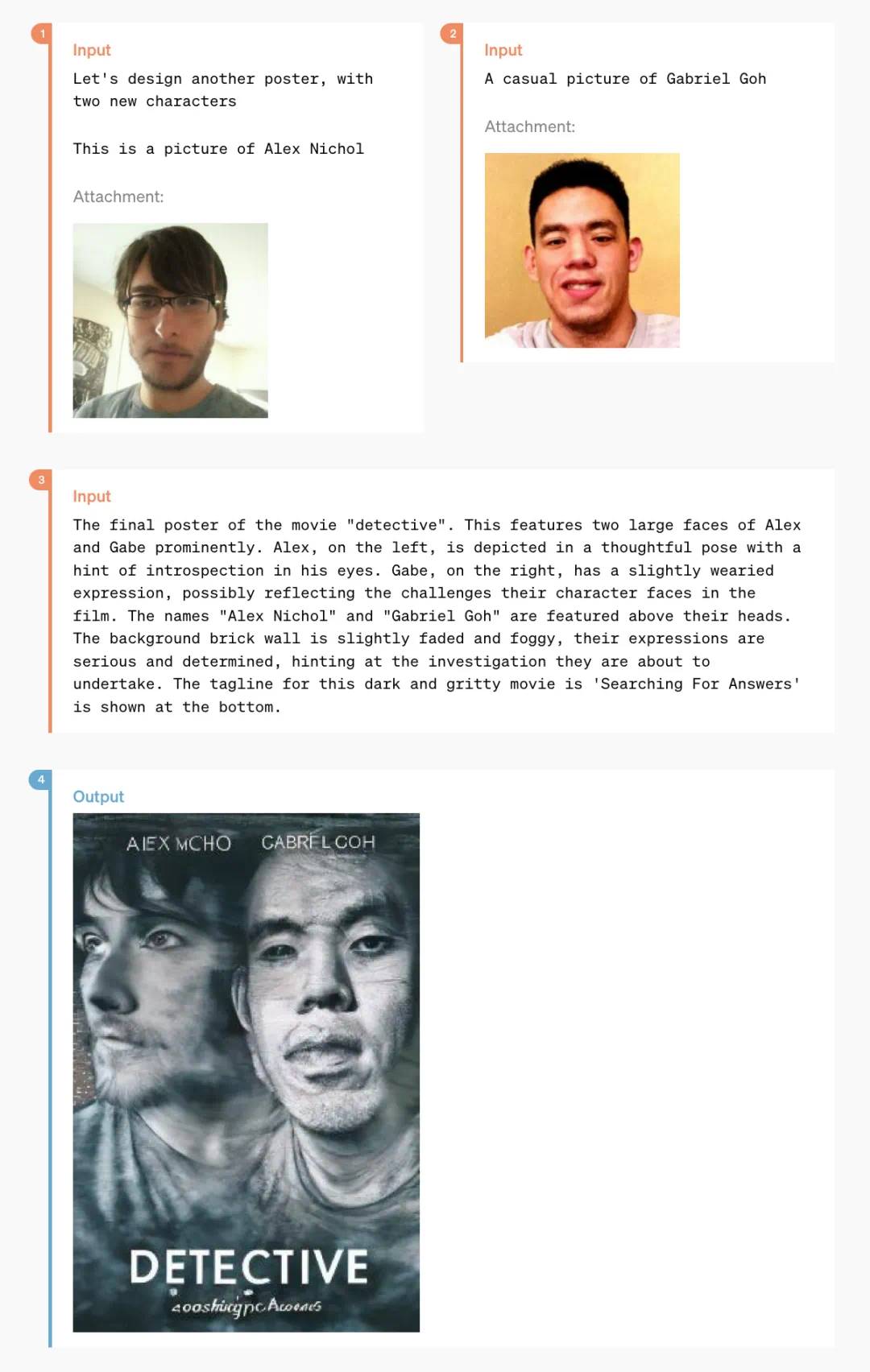

Và những cách chơi dưới đây chắc chắn sẽ khiến nhiều nhà thiết kế ngạc nhiên:

Đây là một áp phích phong cách hóa được biến đổi từ hai bức ảnh đời thường:

Còn một số chức năng nhỏ ít người biết như "chuyển văn bản thành chữ nghệ thuật":

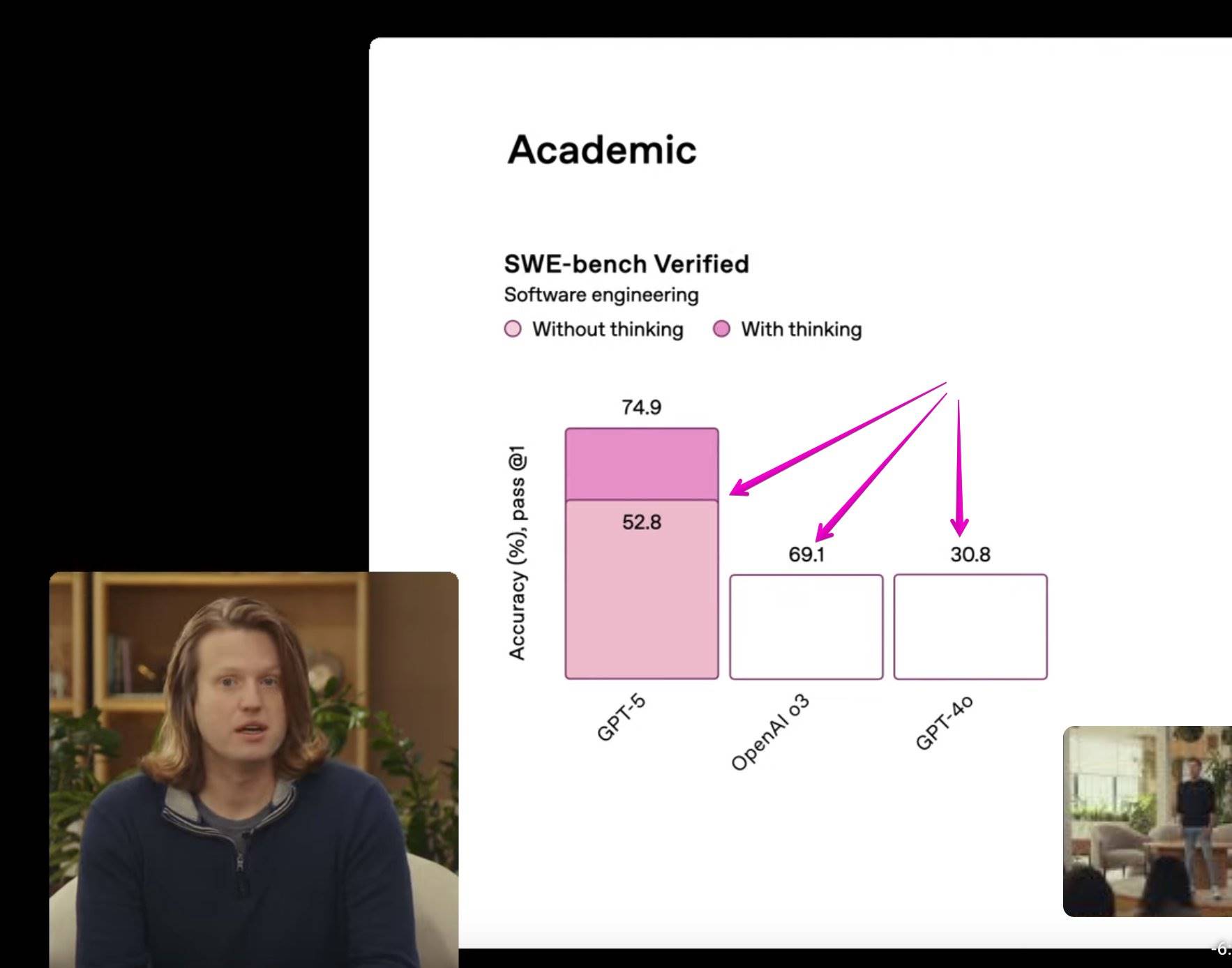

Kết quả đánh giá hiệu suất GPT-4o

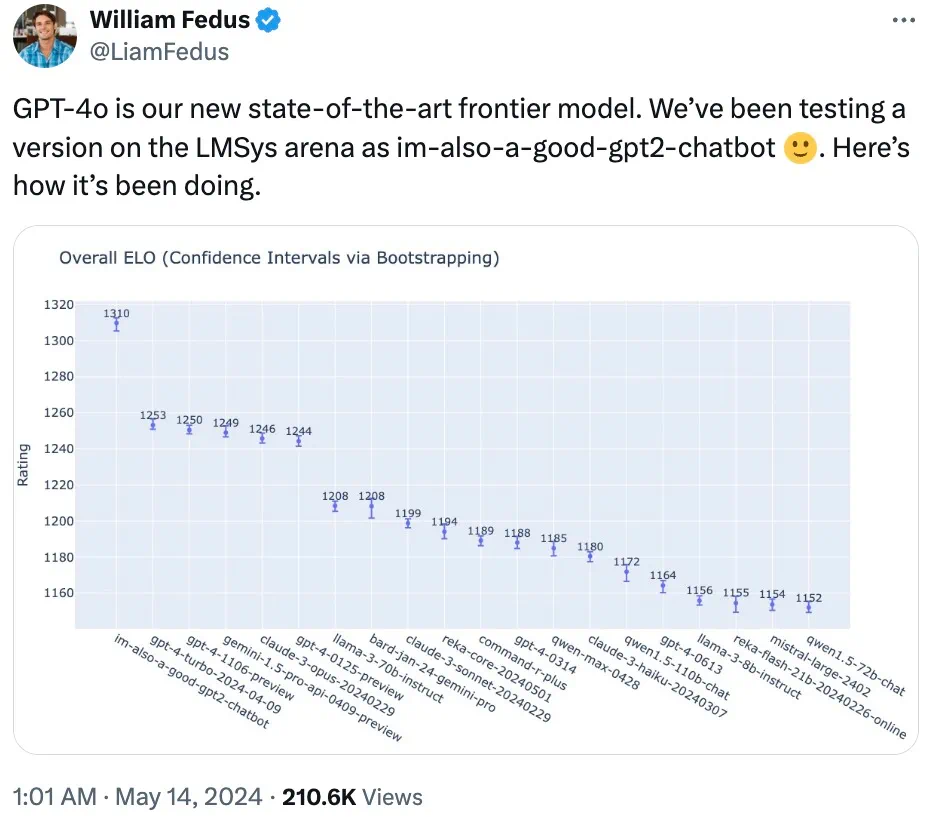

Thành viên đội kỹ thuật OpenAI trên X cho biết, mô hình bí ẩn gây xôn xao trên LMSYS Chatbot Arena trước đó với tên "im-also-a-good-gpt2-chatbot" chính là một phiên bản của GPT-4o.

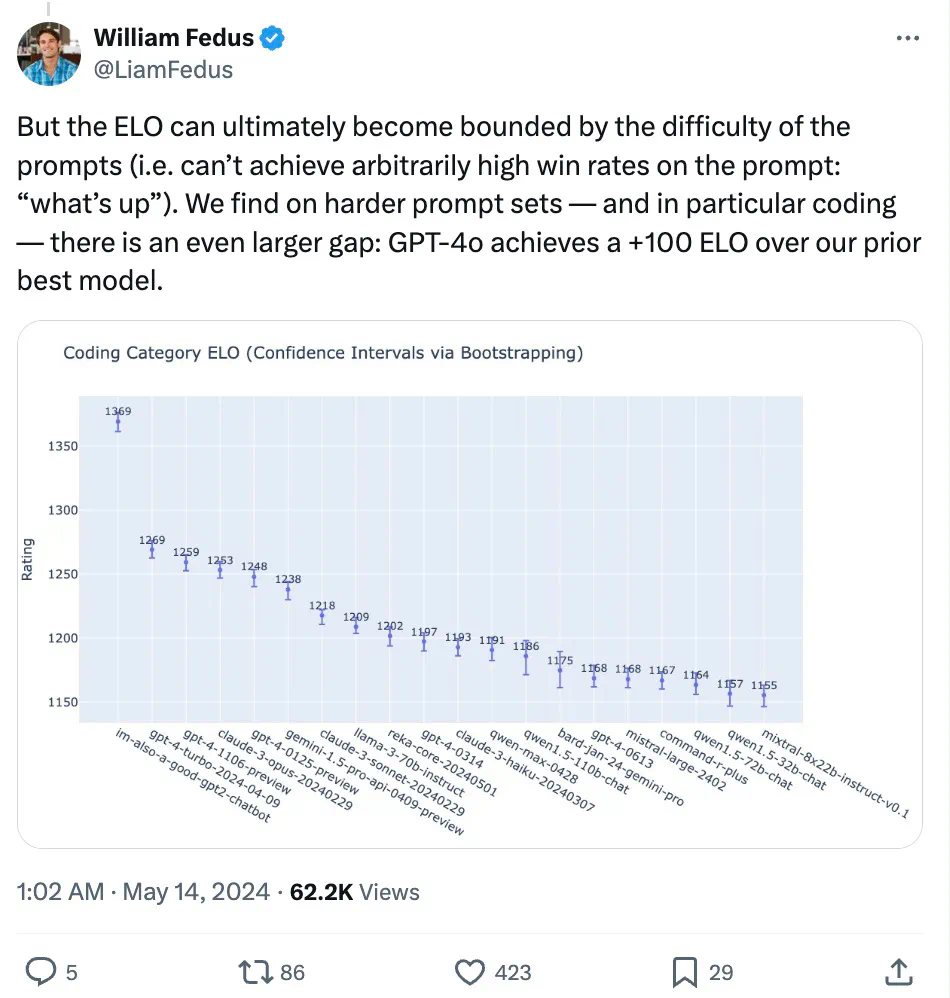

Trên bộ prompt khó — đặc biệt là lập trình: GPT-4o so với mô hình tốt nhất trước đó của OpenAI, hiệu suất tăng mạnh.

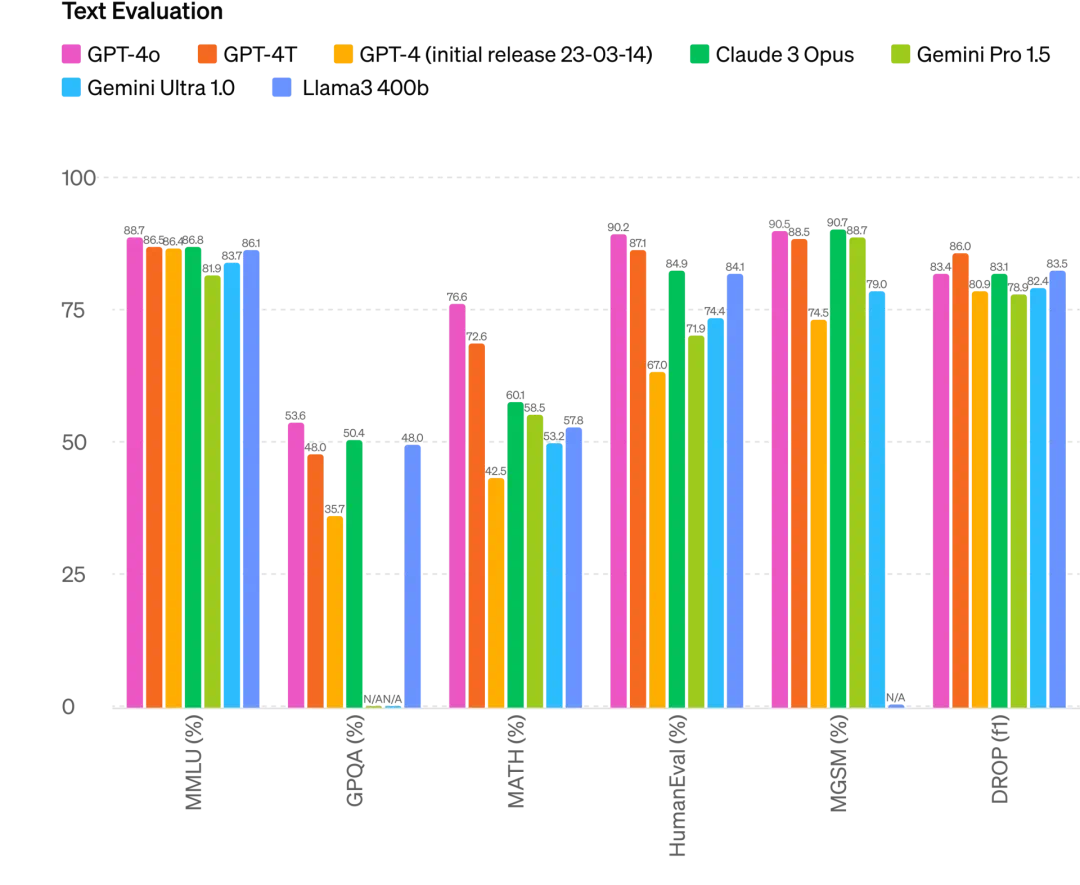

Cụ thể, trong nhiều bài kiểm tra chuẩn, GPT-4o đạt hiệu suất ở mức GPT-4 Turbo về trí tuệ văn bản, suy luận và mã lập trình, đồng thời lập kỷ lục mới về chức năng đa ngôn ngữ, âm thanh và hình ảnh.

Cải thiện suy luận: GPT-4o lập kỷ lục mới 87,2% trên bài kiểm tra MMLU 5-shot (câu hỏi thường thức). (Ghi chú: Llama3 400b vẫn đang trong quá trình huấn luyện)

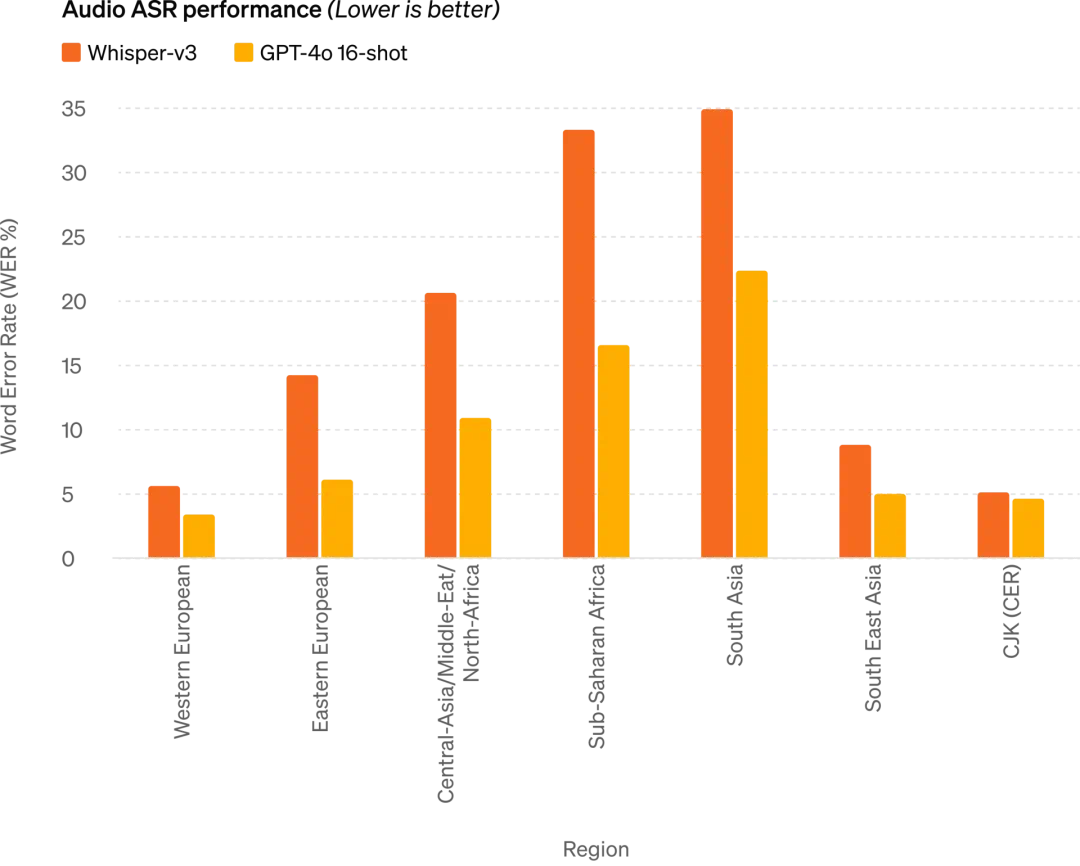

Hiệu suất ASR âm thanh: GPT-4o cải thiện đáng kể hiệu suất nhận dạng giọng nói trên mọi ngôn ngữ so với Whisper-v3, đặc biệt với các ngôn ngữ ít tài nguyên

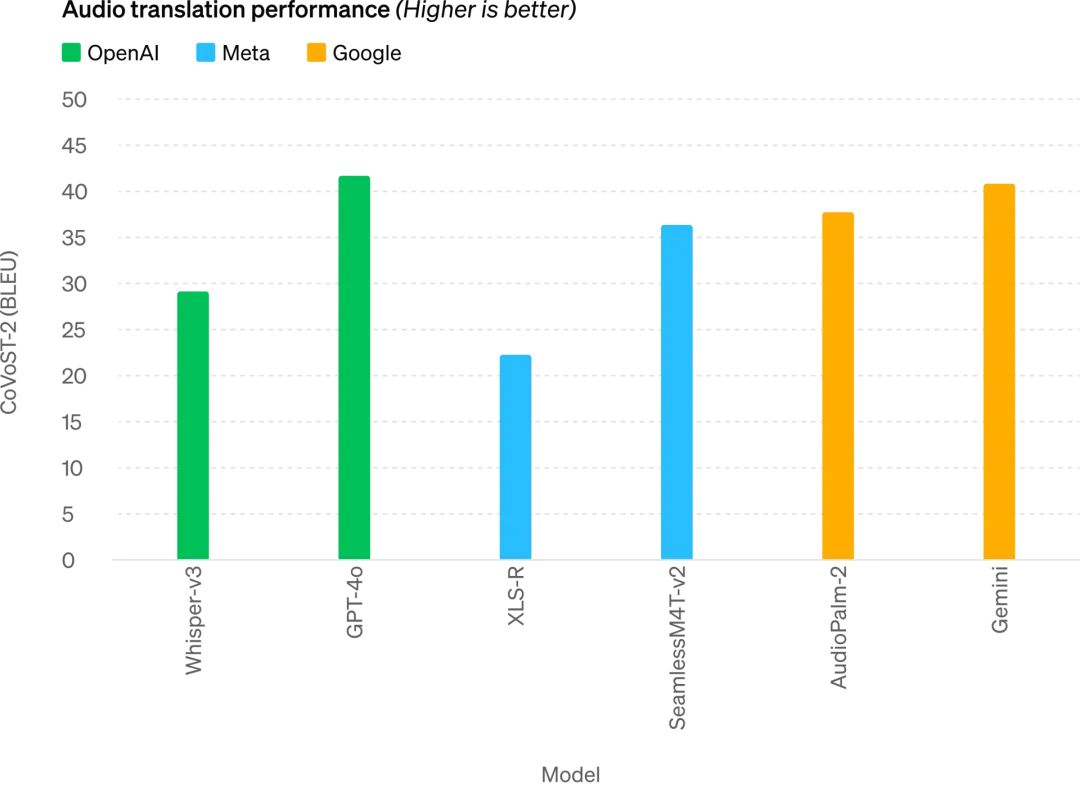

GPT-4o đạt trình độ SOTA mới trong dịch giọng nói và vượt trội hơn Whisper-v3 trên bài kiểm tra chuẩn MLS

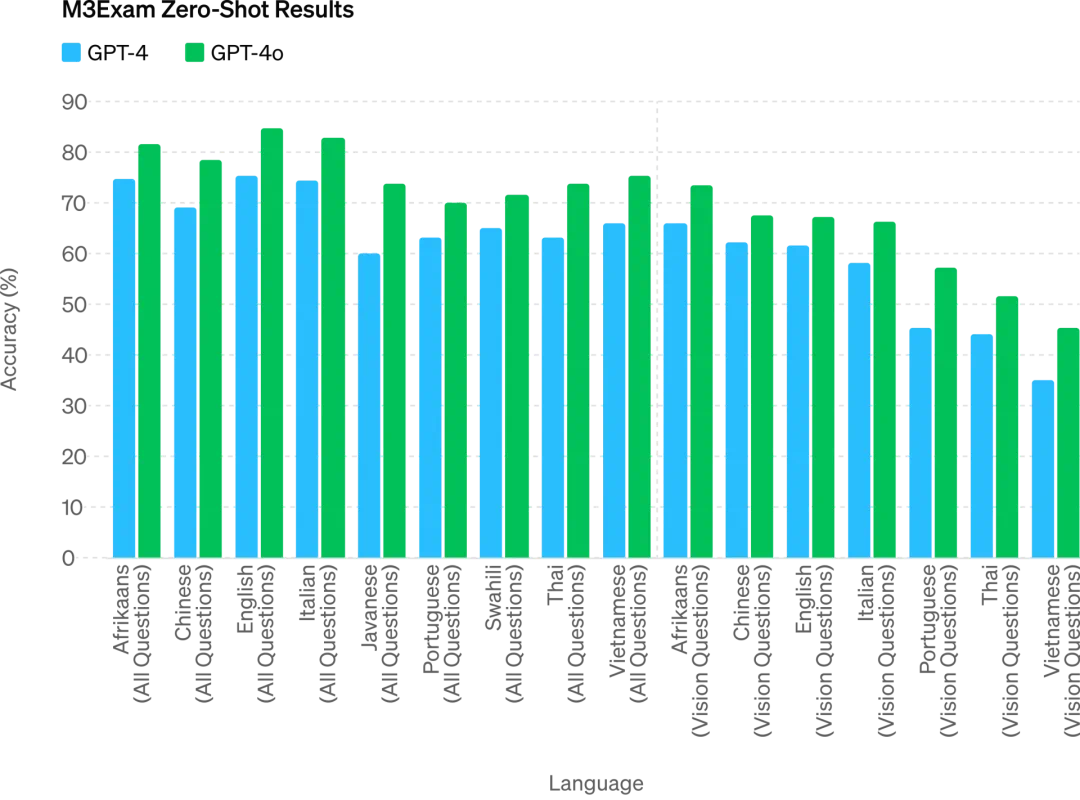

Bài kiểm tra M3Exam vừa là chuẩn đánh giá đa ngôn ngữ, vừa là chuẩn đánh giá thị giác, gồm các câu trắc nghiệm từ bài kiểm tra chuẩn hóa của nhiều quốc gia/vùng lãnh thổ, kèm theo biểu đồ, sơ đồ. Trong mọi bài kiểm tra ngôn ngữ, GPT-4o đều mạnh hơn GPT-4

Trong tương lai, việc nâng cao năng lực mô hình sẽ cho phép hội thoại bằng giọng nói tự nhiên và thời gian thực hơn, đồng thời có thể trò chuyện với ChatGPT qua video trực tiếp. Ví dụ, người dùng có thể cho ChatGPT xem một trận đấu thể thao trực tiếp và yêu cầu giải thích luật chơi.

Người dùng ChatGPT sẽ được miễn phí nhiều chức năng cao cấp hơn

Hàng tuần có hơn một trăm triệu người dùng ChatGPT. OpenAI cho biết chức năng văn bản và hình ảnh của GPT-4o sẽ được triển khai miễn phí trên ChatGPT ngay hôm nay, đồng thời người dùng Plus được tăng giới hạn tin nhắn lên gấp 5 lần.

Bây giờ mở ChatGPT, chúng ta thấy GPT-4o đã có thể sử dụng.

Khi dùng GPT-4o, người dùng miễn phí ChatGPT hiện có thể truy cập các chức năng sau: trải nghiệm trí tuệ cấp độ GPT-4; người dùng có thể nhận phản hồi từ mô hình và từ mạng lưới.

Ngoài ra, người dùng miễn phí còn có các lựa chọn sau —

Phân tích dữ liệu và tạo biểu đồ:

Trò chuyện với ảnh chụp:

Tải lên tệp để được hỗ trợ tóm tắt, viết lách hoặc phân tích:

Khám phá và sử dụng GPTs và cửa hàng ứng dụng GPT:

Và sử dụng chức năng ghi nhớ để tạo trải nghiệm hữu ích hơn.

Tuy nhiên, tùy theo tình trạng sử dụng và nhu cầu, số lượng tin nhắn người dùng miễn phí gửi qua GPT-4o sẽ bị giới hạn. Khi đạt giới hạn, ChatGPT sẽ tự động chuyển sang GPT-3.5 để người dùng tiếp tục cuộc trò chuyện.

Ngoài ra, OpenAI sẽ ra mắt trong vài tuần tới chế độ giọng nói phiên bản mới GPT-4o alpha trong ChatGPT Plus, đồng thời thông qua API cung cấp cho một nhóm nhỏ đối tác đáng tin cậy các chức năng mới về âm thanh và video của GPT-4o.

Tất nhiên, qua nhiều lần thử nghiệm và lặp lại mô hình, GPT-4o vẫn tồn tại một số hạn chế trong mọi dạng thức. Đối với những điểm chưa hoàn hảo này, OpenAI cho biết đang nỗ lực cải thiện GPT-4o.

Có thể hình dung, việc mở chế độ âm thanh GPT-4o chắc chắn sẽ mang đến nhiều rủi ro mới. Về vấn đề an toàn, GPT-4o tích hợp sẵn tính năng bảo mật trong thiết kế đa dạng thức thông qua lọc dữ liệu huấn luyện và tinh chỉnh hành vi mô hình sau huấn luyện. OpenAI còn tạo ra hệ thống an toàn mới, cung cấp lớp bảo vệ cho đầu ra giọng nói.

Ứng dụng máy tính để bàn mới đơn giản hóa quy trình làm việc người dùng

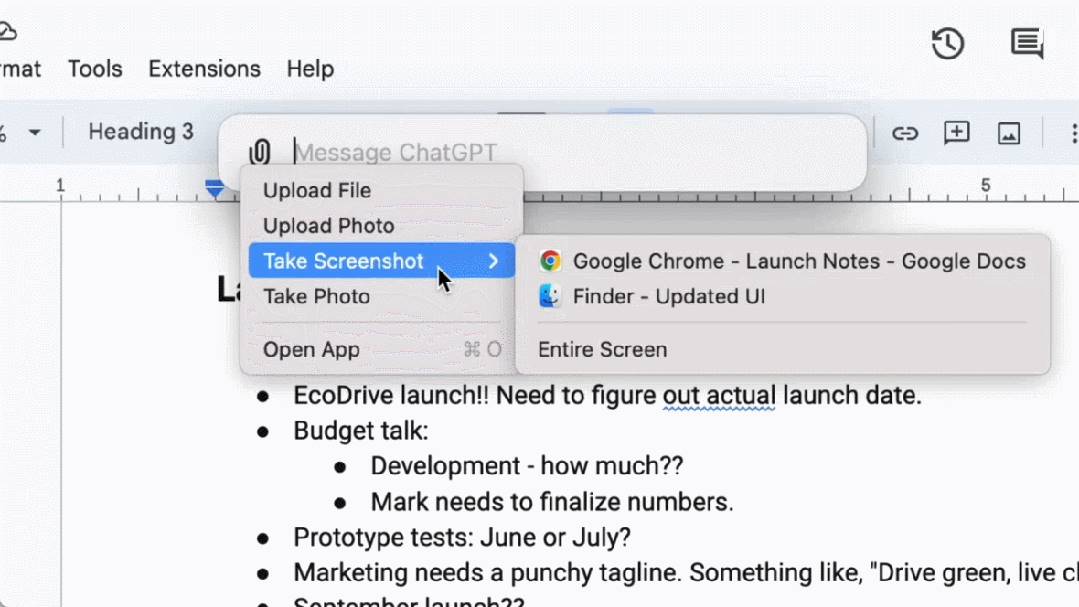

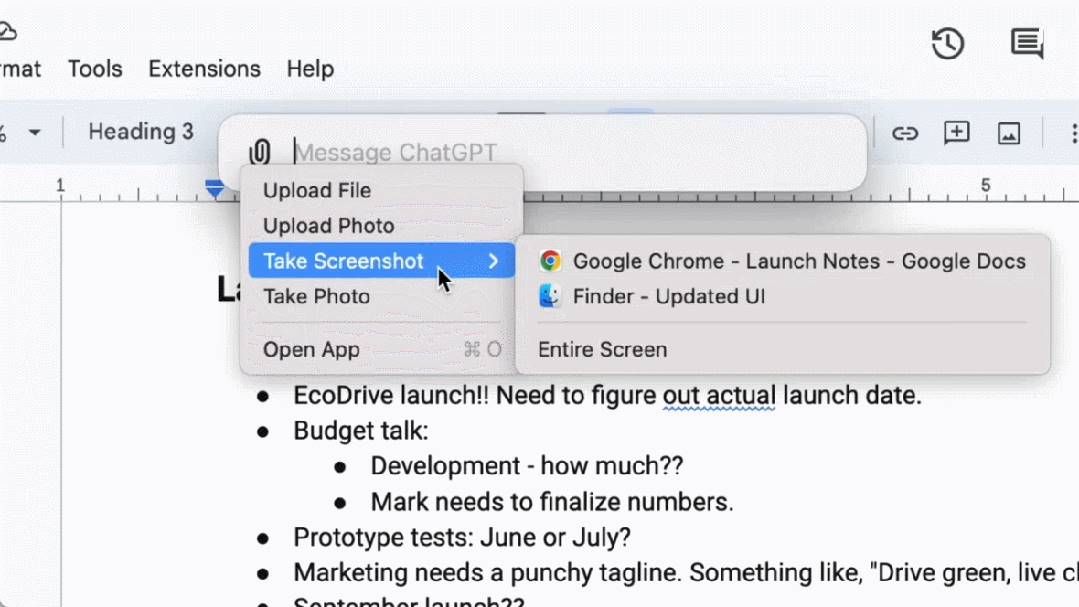

Cho cả người dùng miễn phí và trả phí, OpenAI còn ra mắt ứng dụng ChatGPT mới dành cho macOS. Thông qua phím tắt đơn giản (Option + Space), người dùng có thể ngay lập tức đặt câu hỏi với ChatGPT, ngoài ra còn có thể chụp màn hình trực tiếp trong ứng dụng và thảo luận.

Hiện tại, người dùng còn có thể hội thoại bằng giọng nói trực tiếp với ChatGPT từ máy tính. Các chức năng âm thanh và video của GPT-4o sẽ được ra mắt trong tương lai, bắt đầu hội thoại bằng giọng nói bằng cách nhấn vào biểu tượng tai nghe ở góc dưới bên phải ứng dụng máy tính để bàn.

Từ hôm nay, OpenAI sẽ triển khai ứng dụng macOS cho người dùng Plus, và sẽ mở rộng phạm vi cung cấp trong vài tuần tới. Ngoài ra, phiên bản Windows sẽ được ra mắt vào cuối năm nay.

Altman: Các bạn mở mã nguồn, chúng tôi miễn phí

Sau buổi ra mắt, CEO OpenAI Sam Altman hiếm khi viết một bài blog, chia sẻ hành trình tâm tư khi thúc đẩy công việc với GPT-4o:

Trong buổi ra mắt hôm nay, tôi muốn nhấn mạnh hai điều.

Thứ nhất, một phần then chốt trong sứ mệnh của chúng tôi là cung cấp miễn phí (hoặc với giá ưu đãi) các công cụ trí tuệ nhân tạo mạnh mẽ cho mọi người. Tôi rất tự hào khi tuyên bố rằng, chúng tôi đang cung cấp miễn phí mô hình tốt nhất thế giới trong ChatGPT, không có quảng cáo hay thứ gì tương tự.

Khi chúng tôi thành lập OpenAI, ý tưởng ban đầu là: Chúng tôi sẽ tạo ra trí tuệ nhân tạo và dùng nó để mang lại lợi ích cho thế giới. Bây giờ tình hình thay đổi, có vẻ như chúng tôi sẽ tạo ra trí tuệ nhân tạo, rồi những người khác sẽ dùng nó để tạo ra vô số điều tuyệt vời, tất cả chúng ta đều hưởng lợi.

Tất nhiên, chúng tôi là một doanh nghiệp, sẽ phát minh ra nhiều thứ để bán, điều này sẽ giúp chúng tôi cung cấp miễn phí dịch vụ AI tuyệt vời cho hàng tỷ người (hy vọng vậy).

Thứ hai, chế độ giọng nói và video mới là giao diện tương tác máy tính tốt nhất mà tôi từng dùng. Nó giống như trí tuệ nhân tạo trong phim vậy, tôi vẫn hơi ngạc nhiên khi nó thật sự tồn tại. Hóa ra, đạt được thời gian phản hồi và khả năng biểu đạt ở mức độ con người là một bước tiến khổng lồ.

ChatGPT ban đầu đã ám chỉ khả năng của giao diện ngôn ngữ, còn cái mới này (phiên bản GPT-4o) lại mang cảm giác bản chất khác biệt — nó nhanh, thông minh, thú vị, tự nhiên và hữu ích.

Với tôi, tương tác với máy tính trước nay chưa bao giờ thật sự tự nhiên. Nhưng khi chúng ta bổ sung các khả năng như cá nhân hóa (tùy chọn), truy cập thông tin cá nhân, để AI thay người hành động,... tôi thực sự thấy một tương lai hấp dẫn, nơi chúng ta có thể dùng máy tính làm được nhiều việc hơn bao giờ hết.

Cuối cùng, xin chân thành cảm ơn đội ngũ đã nỗ lực rất lớn để hiện thực hóa điều này!

Đáng chú ý, tuần trước Altman trong một cuộc phỏng vấn cho biết, mặc dù thu nhập cơ bản phổ quát (universal basic income) khó thực hiện, nhưng chúng ta có thể đạt được "tính toán cơ bản phổ quát – universal basic compute". Trong tương lai, mọi người đều có thể miễn phí quyền sử dụng năng lực tính toán của GPT, có thể dùng, bán lại hoặc tặng.

"Ý tưởng là, khi AI trở nên tiên tiến hơn và được tích hợp vào mọi khía cạnh cuộc sống, sở hữu một đơn vị mô hình ngôn ngữ lớn như GPT-7 có thể có giá trị hơn tiền bạc, bạn nắm giữ một phần năng suất," Altman giải thích.

Việc ra mắt GPT-4o có lẽ chính là khởi đầu cho nỗ lực của OpenAI hướng tới điều đó.

Vâng, đây mới chỉ là khởi đầu.

Cuối cùng nhắc một chút, video trên blog OpenAI hôm nay mang tên "Đoán thông báo ngày 13 tháng 5" gần như trùng khớp hoàn toàn với một video quảng bá trước thềm hội nghị I/O của Google ngày mai, rõ ràng là cú "đối đầu trực diện" với Google. Không biết sau khi xem buổi ra mắt của OpenAI hôm nay, Google có cảm thấy áp lực lớn không?

Chào mừng tham gia cộng đồng chính thức TechFlow

Nhóm Telegram:https://t.me/TechFlowDaily

Tài khoản Twitter chính thức:https://x.com/TechFlowPost

Tài khoản Twitter tiếng Anh:https://x.com/BlockFlow_News