À partir de l'adéquation produit-marché, quels projets de la vague actuelle de cryptographie et d'IA ont encore des opportunités ?

TechFlow SélectionTechFlow Sélection

À partir de l'adéquation produit-marché, quels projets de la vague actuelle de cryptographie et d'IA ont encore des opportunités ?

La prochaine grande opportunité de la technologie cryptographique et de l'IA n'est pas un autre jeton spéculatif, mais bien l'infrastructure capable de véritablement faire avancer l'IA.

Auteur : Evan ⨀

Traduction : TechFlow

Le croisement entre la cryptographie et l'IA en est encore à un stade très précoce. Bien qu'un nombre infini d'agents intelligents et de jetons aient déjà envahi le marché, la plupart des projets semblent être simplement des jeux numériques, chaque équipe essayant de tirer le plus grand nombre de « tirs au but » possible.

Bien que l'IA constitue la révolution technologique de notre génération, sa combinaison avec la cryptographie est davantage perçue comme un outil de liquidité permettant un accès précoce au marché de l'IA.

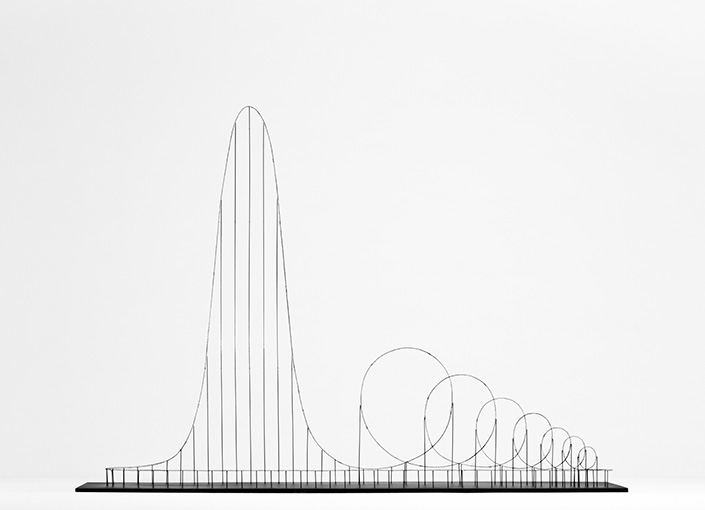

Ainsi, dans ce domaine convergent, nous avons déjà traversé plusieurs cycles, où la plupart des récits ont connu des montées et descentes comparables à des « montagnes russes ».

Comment briser le cycle de la spéculation ?

D'où viendra donc la prochaine grande opportunité liée à la crypto et à l'IA ? Quelles applications ou infrastructures pourront véritablement créer de la valeur et trouver un ajustement sur le marché ?

Cet article tentera d'explorer les principaux points d'intérêt de ce domaine selon le cadre suivant :

-

Comment l'IA peut-elle aider l'industrie cryptographique ?

-

Comment l'industrie cryptographique peut-elle à son tour enrichir l'IA ?

En particulier sur ce second point — les opportunités de l’IA décentralisée — je suis particulièrement enthousiaste, et je présenterai quelques projets passionnants :

1. Comment l'IA soutient-elle l'industrie cryptographique ?

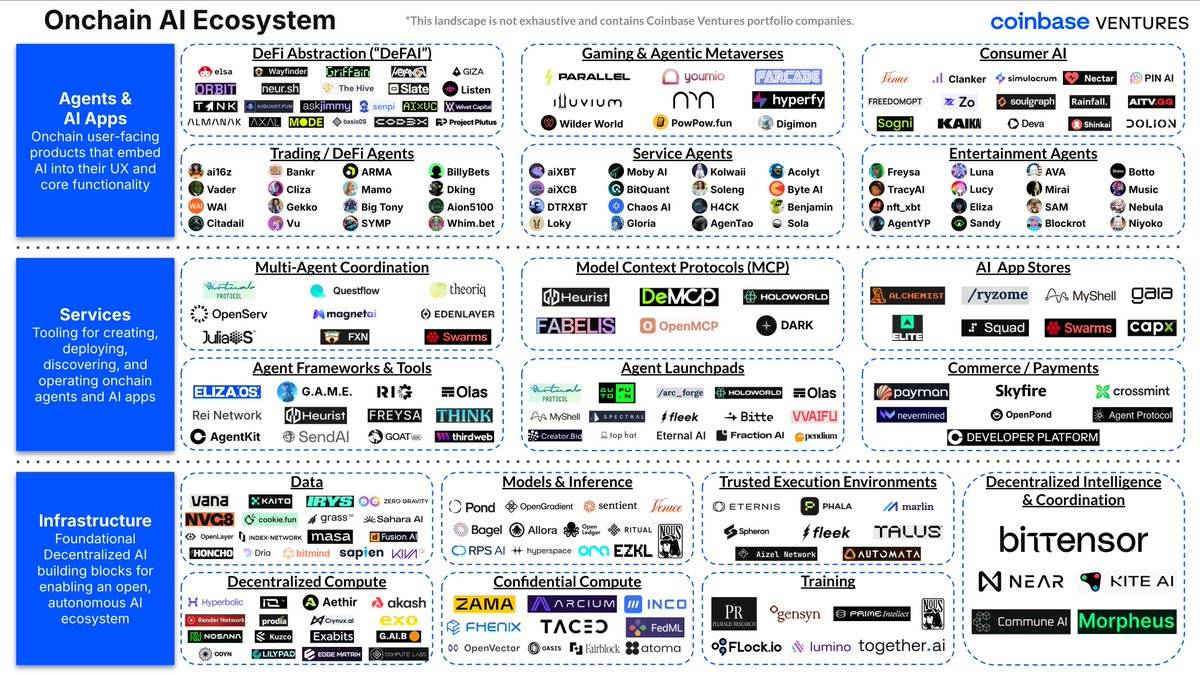

Voici une cartographie plus complète fournie par CV :

https://x.com/cbventures/status/1923401975766355982/photo/1

Bien que de nombreux domaines verticaux existent encore — notamment dans les IA grand public, les cadres d'agents intelligents et les plateformes de lancement — l'IA influence déjà l'expérience cryptographique selon trois axes principaux :

1. Outils pour développeurs

Comme dans le Web2, l'IA accélère le développement de projets cryptographiques via des plateformes sans code (no-code) ou à faible code (vibe-code). De nombreuses applications visent des objectifs similaires à ceux du monde traditionnel, par exemple Lovable.dev.

Des équipes telles que @poofnew et @tryoharaAI aident les développeurs non techniques à lancer rapidement leurs projets et à itérer sans avoir besoin de maîtriser les contrats intelligents. Cela réduit non seulement le délai de mise sur le marché des projets crypto, mais abaisse également la barrière d'entrée pour les personnes comprenant le marché ou ayant des idées créatives, même sans compétences techniques.

Par ailleurs, d'autres aspects de l'expérience développeur sont améliorés, comme les tests et la sécurité des contrats intelligents : @AIWayfinder, @octane_security

2. Expérience utilisateur

Bien que le domaine crypto ait réalisé des progrès significatifs dans les processus d'entrée et l'expérience portefeuille (comme Bridge, Sphere Pay, Turnkey, Privy), l'expérience utilisateur (UX) fondamentale n'a pas changé de manière qualitative. Les utilisateurs doivent toujours parcourir manuellement des explorateurs blockchain complexes et exécuter des transactions multi-étapes.

Les agents intelligents basés sur l'IA transforment cette situation en devenant une nouvelle couche d'interaction :

Recherche et découverte : Des équipes rivalisent pour développer des outils comparables à une « version blockchain de Perplexity ». Ces interfaces conversationnelles en langage naturel permettent aux utilisateurs de trouver facilement des informations de marché (alpha), de comprendre des contrats intelligents et d'analyser les comportements on-chain, sans manipuler directement les données transactionnelles brutes.

L'opportunité encore plus grande réside dans le fait que les agents peuvent devenir la porte d'entrée vers la découverte de nouveaux projets, d'occasions de rendement et de jetons. Tout comme Kaito aide les projets à obtenir plus d'attention sur sa plateforme de lancement, les agents peuvent comprendre le comportement des utilisateurs et leur présenter activement le contenu dont ils ont besoin. Cela peut non seulement créer des modèles économiques durables, mais aussi générer des revenus via des partages ou commissions affiliées.

Actions basées sur l'intention : Plutôt que de cliquer à travers plusieurs interfaces, les utilisateurs expriment simplement leur intention (par exemple, « convertir 1 000 $ d’ETH en une position stablecoin offrant le meilleur rendement »), et l'agent exécute automatiquement des transactions complexes en plusieurs étapes.

Prévention des erreurs : L'IA peut aussi éviter les erreurs courantes, comme entrer un montant erroné, acheter un jeton frauduleux ou approuver un contrat malveillant.

Plus d'informations sur comment Hey Anon réalisel'automatisation DeFAI :

3. Outils de trading et automatisation DeFi

Actuellement, de nombreuses équipes concourent pour développer des agents intelligents capables d’aider les utilisateurs à obtenir de meilleurs signaux de trading, d’effectuer des trades à leur place, ou d’optimiser et gérer des stratégies.

Optimisation du rendement

Les agents peuvent transférer automatiquement les fonds entre protocoles de prêt, DEX et fermes de rendement en fonction des variations de taux d’intérêt et des profils de risque.

Exécution des trades

L'IA peut exécuter des stratégies supérieures aux traders humains en traitant plus rapidement les données de marché, en gérant les émotions et en suivant des cadres prédéfinis.

Gestion de portefeuille

Les agents peuvent rééquilibrer les portefeuilles, gérer les expositions au risque et saisir des opportunités d’arbitrage entre différentes blockchains et protocoles.

Si un agent parvenait vraiment à gérer l’argent de manière durablement supérieure aux humains, cela représenterait un saut quantique par rapport aux agents DeFi actuels. À l’heure actuelle, les agents DeFi aident principalement à exécuter des intentions définies ; ceci marquerait une transition vers une gestion entièrement automatisée des fonds. Toutefois, l’acceptation par les utilisateurs ressemble à celle des voitures électriques : un écart de confiance important persiste avant une validation à grande échelle. Mais en cas de succès, cette technologie pourrait capter la plus grande partie de la valeur dans ce domaine.

Qui seront les gagnants dans ce domaine ?

Bien que certaines applications indépendantes puissent bénéficier d’un avantage en distribution, il est plus probable que les protocoles existants intègrent directement l’IA :

-

DEX (bourses décentralisées) : routage intelligent et protection contre les arnaques.

-

Protocoles de prêt : optimisation automatique du rendement selon le profil de risque de l’utilisateur, remboursement anticipé lorsque le facteur de santé descend sous un seuil, réduction du risque de liquidation.

-

Portefeuilles : transformation en assistants IA capables de comprendre l’intention de l’utilisateur.

-

Plateformes de trading : fourniture d’outils assistés par IA pour aider les utilisateurs à respecter leurs stratégies.

Vision finale

L’interface d’interaction dans le domaine crypto deviendra une IA conversationnelle capable de comprendre les objectifs financiers de l’utilisateur et de les exécuter plus efficacement que l’utilisateur lui-même.

2. La crypto au service de l'IA : l'avenir de l'IA décentralisée

À mon avis, le potentiel de la crypto à soutenir l’IA dépasse largement celui de l’IA à servir la crypto. Les équipes travaillant sur l’IA décentralisée explorent certaines des questions les plus fondamentales et pratiques concernant l’avenir de l’IA :

-

Pouvons-nous développer des modèles de pointe sans dépendre des dépenses massives des géants centralisés de la tech ?

-

Pouvons-nous coordonner des ressources informatiques distribuées mondialement pour entraîner efficacement des modèles ou générer des données ?

-

Que se passe-t-il si la technologie la plus puissante de l’humanité tombe entre les mains d’une poignée d’entreprises ?

Je recommande vivement la lecture de @yb_effect sur l’IA décentralisée (DeAI), disponible ici, pour approfondir ce sujet.

À peine effleuré, la prochaine vague à l’intersection crypto et IA pourrait provenir d’équipes académiques axées sur la recherche, issues principalement de la communauté open source de l’IA. Elles comprennent profondément la signification pratique et philosophique de l’IA décentralisée et la considèrent comme la meilleure voie pour étendre l’IA.

Quels problèmes l’IA rencontre-t-elle actuellement ?

En 2017, l'article emblématique « Attention Is All You Need » a introduit l'architecture Transformer, résolvant un problème clé vieux de plusieurs décennies dans le domaine de l'apprentissage profond. Depuis la popularisation de ChatGPT en 2019, l'architecture Transformer est devenue la base de la majorité des grands modèles linguistiques (LLMs), déclenchant une course effrénée à la puissance de calcul.

Depuis lors, la puissance de calcul requise pour l'entraînement de l'IA croît de 4 fois chaque année. Cela a conduit à une forte centralisation du développement de l'IA, car l'entraînement préliminaire repose sur des GPU ultra-performants, ressources uniquement accessibles aux plus grands géants technologiques.

-

D’un point de vue idéologique, une IA centralisée pose problème, car l’outil le plus puissant de l’humanité pourrait à tout moment être contrôlé ou retiré par ses financeurs. Par conséquent, même si les équipes open source ne peuvent pas rivaliser directement en vitesse avec les laboratoires centralisés, il est essentiel d’essayer de relever ce défi.

La technologie blockchain offre une base économique pour construire des modèles ouverts. Mais avant d’atteindre cet objectif, nous devons répondre à une question : l’IA décentralisée peut-elle résoudre des problèmes concrets au-delà de l’idéalisme ? Pourquoi est-il si crucial de faire collaborer les gens ?

-

Heureusement, les équipes engagées dans ce domaine sont très pragmatiques. L’open source incarne l’idée centrale de l’extension technologique : grâce à une collaboration à petite échelle, chaque équipe optimise son maximum local, puis construit progressivement dessus, atteignant ainsi un maximum global plus rapidement que les méthodes centralisées limitées par leur taille et leur inertie institutionnelle.

-

Par ailleurs, surtout dans le domaine de l’IA, l’open source est une condition nécessaire à la création d’intelligence — non pas moralisée, mais adaptable aux différents rôles et personnalités que chaque individu lui attribue.

En pratique, l’open source peut ouvrir la voie à des innovations permettant de surmonter des limitations d’infrastructure très concrètes.

La pénurie actuelle de ressources de calcul

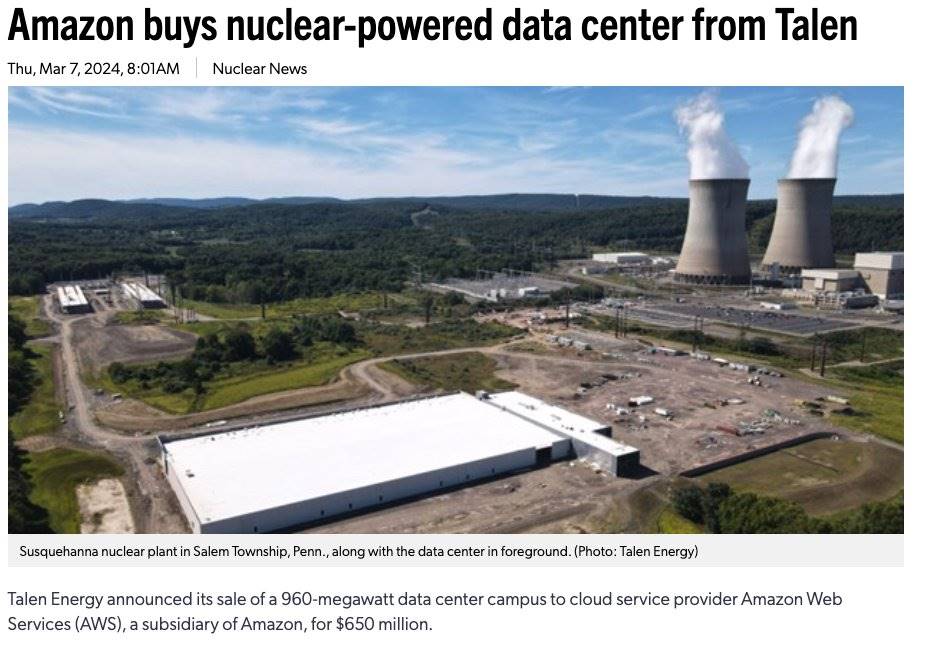

L’entraînement des modèles d’IA nécessite désormais d’immenses infrastructures énergétiques. Plusieurs projets sont en cours de construction de centres de données allant de 1 à 5 gigawatts. Toutefois, l’expansion continue des modèles de pointe exigera une énergie dépassant celle fournie par un seul centre de données, atteignant même le niveau de consommation d’une ville entière. Le problème ne concerne pas seulement la production d’énergie, mais aussi les limites physiques d’un centre de données unique.

Même après la phase d’entraînement préliminaire, le coût de l’inférence augmentera fortement avec l’avènement de nouveaux modèles d’inférence et de DeepSeek. Comme l’a souligné l’équipe @fortytwonetwork :

« Contrairement aux grands modèles linguistiques classiques (LLMs), les modèles d’inférence priorisent la génération de réponses plus intelligentes en allouant plus de temps de traitement. Ce changement implique un compromis : les mêmes ressources de calcul ne peuvent traiter qu’un nombre moindre de requêtes. Pour réaliser ces améliorations significatives, les modèles ont besoin de plus de « temps de réflexion », ce qui accentue encore la rareté des ressources de calcul. »

La pénurie de ressources de calcul est déjà manifeste. Par exemple, OpenAI limite ses appels API à 10 000 par minute, ce qui restreint effectivement les applications IA à environ 3 000 utilisateurs simultanés. Même un projet ambitieux comme Stargate — un plan d’infrastructure IA de 500 milliards de dollars annoncé récemment par le président Trump — ne ferait que temporairement atténuer ce problème.

Selon le paradoxe de Jevons, l’amélioration de l’efficacité conduit souvent à une augmentation de la consommation de ressources, car la demande augmente. À mesure que les modèles d’IA deviennent plus puissants et efficaces, la demande en puissance de calcul pourrait exploser en raison de nouveaux cas d’usage et d’une adoption plus large.

Où intervient alors la crypto ? Comment la blockchain peut-elle véritablement aider la recherche et le développement de l’IA ?

La cryptographie propose une approche fondamentalement différente : formation et coordination économiques globales, distribuées et décentralisées. Plutôt que de construire de nouveaux centres de données, pourquoi ne pas exploiter les millions de GPU existants — équipements de jeu, matériel minier crypto et serveurs d’entreprise — qui passent la plupart du temps inactifs ? De même, la blockchain peut permettre une inférence décentralisée en utilisant les ressources inutilisées des appareils grand public.

Un des principaux obstacles à l'entraînement distribué est la latence. Outre les éléments cryptographiques, des équipes comme Prime Intellect et Nous Research développent des percées technologiques pour réduire les besoins en communication entre GPU :

-

DiLoCo (Prime Intellect) : La solution de Prime Intellect réduit les besoins de communication par un facteur 500, rendant l'entraînement intercontinental possible et atteignant 90-95 % d'utilisation du calcul.

-

DisTrO/DeMo (Nous Research) : La famille d'optimiseurs de Nous Research utilise une compression par transformation en cosinus discrète, réduisant les besoins de communication d'un facteur 857.

Toutefois, les mécanismes de coordination traditionnels ne peuvent pas résoudre les défis de confiance inhérents à l'entraînement décentralisé de l'IA, et c'est ici que les caractéristiques intrinsèques de la blockchain pourraient trouver un ajustement parfait au marché (PMF) :

-

Validation et tolérance aux pannes : L'entraînement décentralisé fait face au risque de participants soumettant des calculs malveillants ou erronés. La cryptographie offre des schémas de vérification cryptographique (comme TOPLOC de Prime Intellect) et des mécanismes de pénalisation économique pour prévenir les comportements néfastes.

-

Participation sans permission : Contrairement aux projets traditionnels de calcul distribué nécessitant une approbation, la cryptographie permet une contribution véritablement libre. Toute personne disposant de ressources informatiques inutilisées peut rejoindre immédiatement et commencer à générer des revenus, maximisant ainsi le pool de ressources disponibles.

-

Alignement des incitations économiques : Les mécanismes incitatifs basés sur la blockchain alignent les intérêts des propriétaires individuels de GPU avec l'objectif collectif d'entraînement, transformant ainsi des ressources auparavant inactives en productivité économique.

Étant donné cela, comment les équipes de la pile d’IA décentralisée résolvent-elles les problèmes d’extension de l’IA à l’aide de la blockchain ? Quels sont les preuves concrètes ?

-

Prime Intellect : Entraînement distribué et décentralisé

-

DiLoCo : Réduction des besoins de communication par un facteur 500, rendant l'entraînement intercontinental possible.

-

PCCL : Gère l'ajout dynamique de membres, les pannes de nœuds, et atteint une vitesse de communication intercontinentale de 45 Gbit/s.

-

Entraînement actuel d'un modèle de 320 milliards de paramètres via des nœuds de travail répartis mondialement.

-

Réalisation d'une utilisation du calcul de 90-95 % en environnement de production.

-

Résultats : Entraînement réussi de INTELLECT-1 (10 milliards de paramètres) et INTELLECT-2 (320 milliards de paramètres), démontrant l'entraînement à grande échelle de modèles intercontinentaux.

-

-

Nous Research : Entraînement décentralisé et optimisation des communications

-

DisTrO/DeMo : Grâce à la transformation en cosinus discrète, réduction des besoins de communication par un facteur 857.

-

Psyche Network : Utilise des mécanismes de coordination blockchain pour assurer tolérance aux pannes et incitations afin de mobiliser les ressources de calcul.

-

Réalisation de l'une des plus grandes pré-formations sur Internet, entraînant Consilience (40 milliards de paramètres).

-

-

Pluralis : Apprentissage par protocole (Protocol Learning) et parallélisme de modèle

Pluralis adopte une approche différente de l'IA open source traditionnelle, appelée Apprentissage par protocole (Protocol Learning). Contrairement aux projets d'entraînement décentralisé comme Prime Intellect et Nous qui utilisent la parallélisation des données, Pluralis considère que cette dernière présente des défauts économiques, et que le simple regroupement des ressources de calcul ne suffit pas à entraîner des modèles de pointe. Par exemple, Llama3 (400 milliards de paramètres) nécessite 16 000 GPU H100 de 80 Go pour son entraînement.

Source : Lien

L'idée centrale de l'Apprentissage par protocole (Protocol Learning) est d'introduire un mécanisme de capture de valeur réel pour les entraîneurs de modèles, afin de rassembler les ressources informatiques nécessaires à un entraînement à grande échelle. Ce mécanisme attribue une partie de la propriété du modèle proportionnellement à la contribution à l'entraînement. Dans cette architecture, le réseau neuronal est entraîné de façon collaborative, mais aucun participant isolé ne peut extraire l'ensemble complet des poids (appelés modèles-protocole, Protocol Models). Dans ce dispositif, le coût informatique requis pour qu'un participant obtienne l'ensemble complet des poids excède le coût de ré-entraînement du modèle.

Fonctionnement précis de l'Apprentissage par protocole :

-

Fragments de modèle : Chaque participant détient uniquement des fragments (shards) partiels du modèle, jamais les poids complets.

-

Entraînement collaboratif : Le processus d'entraînement nécessite le transfert de valeurs d'activation entre participants, sans jamais révéler l'ensemble complet du modèle à personne.

-

Certificats d'inférence : L'inférence nécessite des certificats, distribués selon la contribution de chaque participant à l'entraînement. Ainsi, les contributeurs peuvent tirer profit de l'utilisation effective du modèle.

L'importance de l'Apprentissage par protocole réside dans la transformation du modèle en ressource économique ou marchandise, pleinement financiarisable. Cette méthode pourrait ainsi atteindre l'échelle de calcul nécessaire pour des tâches d'entraînement véritablement compétitives. Pluralis combine la durabilité du développement fermé (comme des revenus stables grâce à la publication de modèles fermés) avec les avantages de la collaboration open source, offrant ainsi de nouvelles possibilités pour l'avenir de l'IA décentralisée.

Fortytwo : Inférence décentralisée collective

Source : Lien

-

Alors que d'autres équipes se concentrent sur les défis de l'entraînement distribué et décentralisé, Fortytwo s'attaque à l'inférence distribuée, utilisant l'intelligence collective (Swarm Intelligence) pour résoudre la pénurie de ressources informatiques pendant la phase d'inférence.

-

Fortytwo répond à la pénurie croissante de ressources informatiques liée à l'inférence. Pour exploiter la puissance inutilisée du matériel grand public (par exemple, un MacBook Air équipé d'une puce M2), Fortytwo connecte en réseau de petits modèles linguistiques spécialisés.

-

Fortytwo interconnecte plusieurs petits modèles linguistiques (SLMs) ; ces nœuds collaborent en évaluant mutuellement leurs contributions, amplifiant ainsi l'efficacité du réseau par évaluation pair-à-pair. La réponse finale est basée sur les contributions les plus précieuses du réseau, soutenant ainsi l'efficacité de l'inférence.

-

Fait intéressant, l'approche de réseau d'inférence de Fortytwo peut compléter les projets d'entraînement distribué/décentralisé. Imaginez un scénario futur où les petits modèles linguistiques (SLMs) exécutés sur les nœuds Fortytwo seraient justement les modèles entraînés par Prime Intellect, Nous ou Pluralis. Ces projets d'entraînement collaboreront pour créer des modèles fondamentaux open source, qui seront ensuite affinés pour des domaines spécifiques, et enfin utilisés via le réseau Fortytwo pour les tâches d'inférence.

Conclusion

La prochaine grande opportunité à l'intersection de la cryptographie et de l'IA n'est pas un autre jeton spéculatif, mais une infrastructure capable de véritablement faire progresser l'IA. Actuellement, les goulets d'étranglement d'extension de l'IA centralisée correspondent exactement aux forces fondamentales de la cryptographie : coordination mondiale des ressources et alignement des incitations économiques.

L'IA décentralisée ouvre un univers parallèle qui non seulement étend les possibilités architecturales de l'IA, mais explore aussi de nouvelles frontières technologiques en combinant liberté expérimentale et ressources concrètes.

Bienvenue dans la communauté officielle TechFlow

Groupe Telegram :https://t.me/TechFlowDaily

Compte Twitter officiel :https://x.com/TechFlowPost

Compte Twitter anglais :https://x.com/BlockFlow_News