L'interaction en temps réel du modèle universel GPT-4o d'OpenAI impressionne l'audience, l'ère de la science-fiction est arrivée

TechFlow SélectionTechFlow Sélection

L'interaction en temps réel du modèle universel GPT-4o d'OpenAI impressionne l'audience, l'ère de la science-fiction est arrivée

ChatGPT n'a été lancé que depuis 17 mois, et OpenAI a déjà présenté une intelligence artificielle digne des films de science-fiction, entièrement gratuite et accessible à tous.

Rédaction : Machine Heart

Électrisant !

Alors que les entreprises technologiques rivalisent pour améliorer les capacités multimodales de leurs grands modèles et intégrer des fonctions telles que le résumé de texte ou la retouche d'images dans les téléphones mobiles, OpenAI, largement en avance, vient de sortir une nouveauté si impressionnante que même son PDG Sam Altman l'a qualifiée d'"expérience digne d'un film".

Dans la nuit du 14 mai, lors de sa première « présentation printanière de nouveaux produits », OpenAI a dévoilé son nouveau modèle phare GPT-4o, une application de bureau et une série de nouvelles fonctionnalités. Cette fois-ci, la technologie a radicalement transformé la forme des produits, offrant ainsi une véritable leçon aux entreprises technologiques du monde entier.

La présentation était assurée par Mira Murati, directrice technique d'OpenAI, qui a annoncé trois points clés :

-

Premièrement, OpenAI adoptera désormais une stratégie prioritaire de gratuité afin de permettre à un plus grand nombre de personnes d'accéder à ses outils.

-

Deuxièmement, OpenAI lance aujourd'hui une version bureau de ChatGPT avec une nouvelle interface utilisateur, encore plus simple et naturelle à utiliser.

-

Troisièmement, après GPT-4 arrive un nouveau grand modèle baptisé GPT-4o. Ce dernier rend l'intelligence de niveau GPT-4 accessible à tous — y compris aux utilisateurs gratuits — grâce à une interaction extrêmement naturelle.

Avec cette mise à jour de ChatGPT, le grand modèle peut désormais recevoir n'importe quelle combinaison de texte, audio et image comme entrée, et générer en temps réel n'importe quelle combinaison de ces mêmes modalités en sortie — c'est là la véritable interface du futur.

Récemment, ChatGPT est devenu utilisable sans inscription, et avec maintenant l’ajout d’une application bureau, l’objectif d’OpenAI est clair : rendre ChatGPT utilisable partout, tout le temps, de manière fluide et transparente, intégré directement dans votre flux de travail. L’intelligence artificielle est désormais productivité.

GPT-4o est un nouveau grand modèle conçu pour redéfinir les interactions homme-machine futures. Il comprend simultanément le texte, la voix et les images, répond rapidement, exprime des émotions et se montre très humain dans ses interactions.

Sur scène, un ingénieur d'OpenAI a utilisé un iPhone pour démontrer plusieurs fonctionnalités clés du nouveau modèle. La plus marquante est la conversation vocale en temps réel. Mark Chen a lancé : « C’est ma première présentation en direct, je suis un peu nerveux. » ChatGPT lui a aussitôt répondu : « Pourquoi ne prendrais-tu pas une grande respiration ? »

D’accord, je respire profondément.

ChatGPT a instantanément répondu : « Non, ce n’est pas bon, tu halètes trop fort. »

Si vous avez déjà utilisé des assistants vocaux comme Siri, vous remarquerez immédiatement la différence. Premièrement, vous pouvez interrompre l’IA à tout moment, sans attendre qu’elle termine sa phrase. Deuxièmement, il n’y a presque aucun délai : la réponse du modèle est quasi instantanée, plus rapide que celle d’un humain. Troisièmement, le modèle perçoit parfaitement les émotions humaines et peut lui-même en exprimer.

Vient ensuite la capacité visuelle. Un autre ingénieur écrit une équation sur papier et demande à ChatGPT non pas la réponse directe, mais une explication étape par étape. Là encore, on voit bien que ce modèle a un potentiel énorme pour accompagner l’apprentissage.

ChatGPT dit : chaque fois que tu es bloqué sur un problème de maths, je suis là pour t’aider.

Passons maintenant à la capacité de codage de GPT-4o. En parlant à l’application bureau de ChatGPT via commande vocale, on lui soumet un bout de code et on lui demande d’en expliquer la fonction globale ou le rôle d’une fonction spécifique. ChatGPT répond parfaitement.

Le résultat du code est une courbe de température. On demande alors à ChatGPT de répondre en une phrase à toutes les questions relatives à ce graphique.

Quel est le mois le plus chaud ? L’axe Y est-il en degrés Celsius ou Fahrenheit ? ChatGPT répond correctement à tout.

OpenAI a également répondu en direct à certaines questions posées par des internautes sur X/Twitter. Par exemple, concernant la traduction vocale en temps réel : le téléphone peut servir de traducteur instantané entre l’espagnol et l’anglais.

Une autre question : « ChatGPT peut-il reconnaître vos expressions faciales ? »

On dirait bien que GPT-4o est capable de comprendre la vidéo en temps réel.

Passons maintenant au détail de cette bombe atomique dévoilée par OpenAI aujourd’hui.

Le modèle universel GPT-4o

Commençons par GPT-4o, où le « o » signifie Omnimodel (modèle universel).

Pour la première fois, OpenAI intègre toutes les modalités dans un seul modèle, augmentant considérablement l’utilité pratique des grands modèles.

Muri Murati, CTO d’OpenAI, indique que GPT-4o offre une intelligence de « niveau GPT-4 », tout en améliorant significativement les performances en traitement du texte, de la vision et de l’audio. Il sera progressivement déployé dans les produits d’OpenAI au cours des prochaines semaines.

« GPT-4o raisonne à travers la parole, le texte et la vision », déclare Muri Murati. « Nous savons que ces modèles deviennent de plus en plus complexes, mais nous voulons que l’expérience d’interaction devienne plus naturelle et plus simple, au point que vous puissiez oublier complètement l’interface utilisateur pour vous concentrer uniquement sur la collaboration avec GPT. »

Les performances de GPT-4o en anglais textuel et en codage sont comparables à celles de GPT-4 Turbo, mais il présente des améliorations significatives pour les langues non anglaises. Son API est aussi plus rapide, avec un coût réduit de 50 %. Comparé aux modèles existants, GPT-4o excelle particulièrement en compréhension visuelle et auditive.

Il peut répondre à une entrée audio en seulement 232 millisecondes, avec un temps moyen de réponse de 320 ms, similaire à celui d’un humain. Avant GPT-4o, les utilisateurs de ChatGPT en mode vocal observaient des latences moyennes de 2,8 secondes (avec GPT-3.5) et 5,4 secondes (avec GPT-4).

Ce mode vocal reposait auparavant sur un pipeline composé de trois modèles distincts : un modèle simple transcrivait l’audio en texte, GPT-3.5 ou GPT-4 traitait ce texte et produisait une réponse textuelle, puis un troisième modèle convertissait ce texte en audio. Mais OpenAI a constaté que cette méthode faisait perdre beaucoup d’informations : l’IA ne pouvait pas percevoir directement le ton, les locuteurs multiples ou les bruits de fond, ni produire de rires, de chants ou d’émotions.

Avec GPT-4o, OpenAI a entraîné un nouveau modèle de bout en bout sur les modalités texte, visuelle et audio, ce qui signifie que toutes les entrées et sorties sont traitées par un unique réseau neuronal.

« D’un point de vue technique, OpenAI a trouvé un moyen de mapper directement l’audio vers l’audio comme modalité primaire, et de transmettre la vidéo en temps réel au transformer. Cela nécessite de nouvelles recherches sur la tokenisation et l’architecture, mais globalement, c’est surtout une question d’optimisation des données et des systèmes (comme souvent). » Commente Jim Fan, scientifique chez NVIDIA.

GPT-4o peut raisonner en temps réel sur les entrées combinant texte, audio et vidéo, une étape cruciale vers des interactions homme-machine plus naturelles — voire machine-machine.

Greg Brockman, président d’OpenAI, s’est amusé à faire dialoguer deux instances de GPT-4o en temps réel, allant jusqu’à leur faire improviser une chanson. Certes, la mélodie est un peu « touchante », mais les paroles intègrent intelligemment le décor de la pièce, la tenue vestimentaire des participants, et même des anecdotes survenues pendant la démo.

En outre, les capacités de GPT-4o en compréhension et génération d’images surpassent largement celles de tout modèle existant, rendant réalisables des tâches auparavant impossibles.

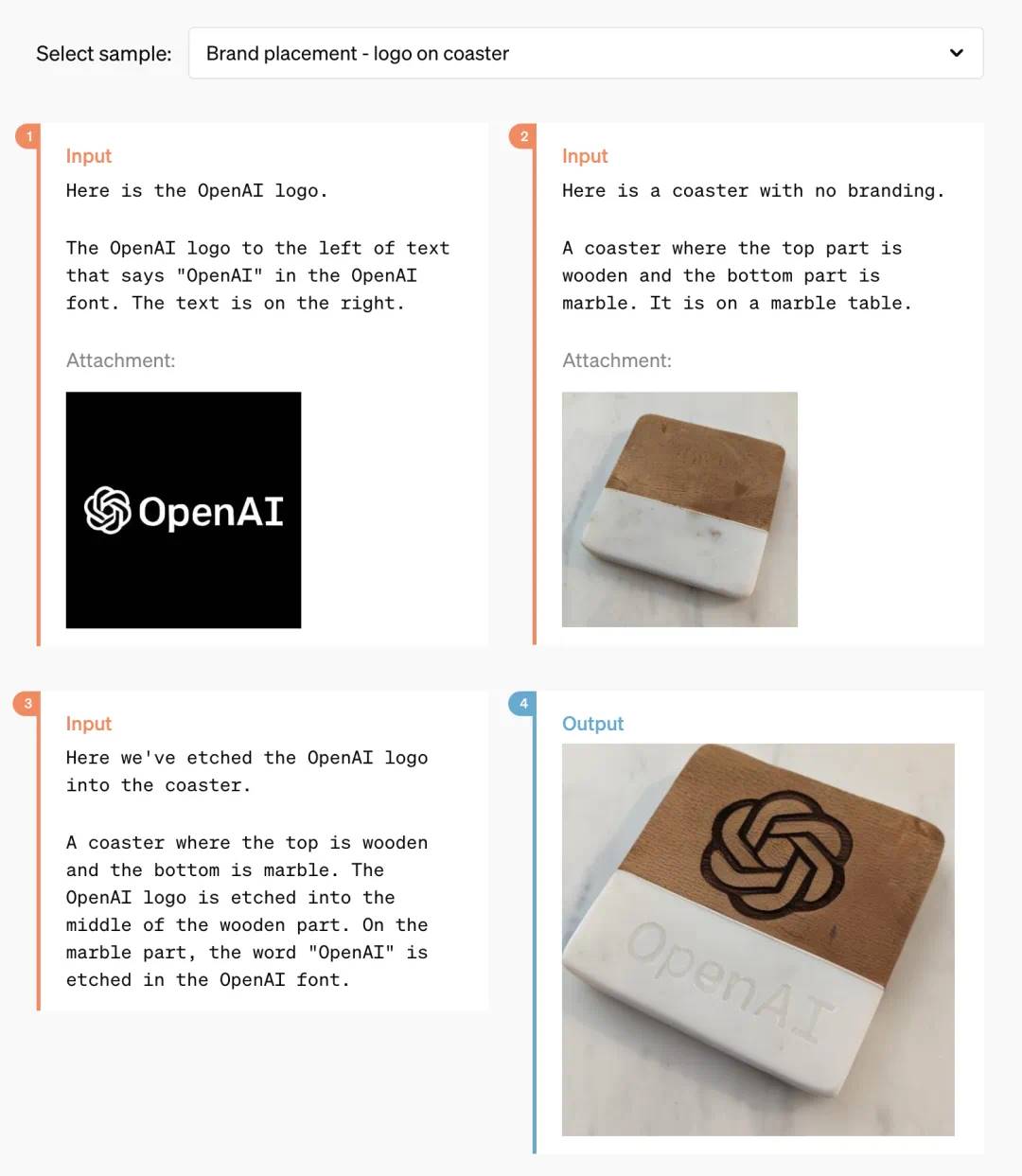

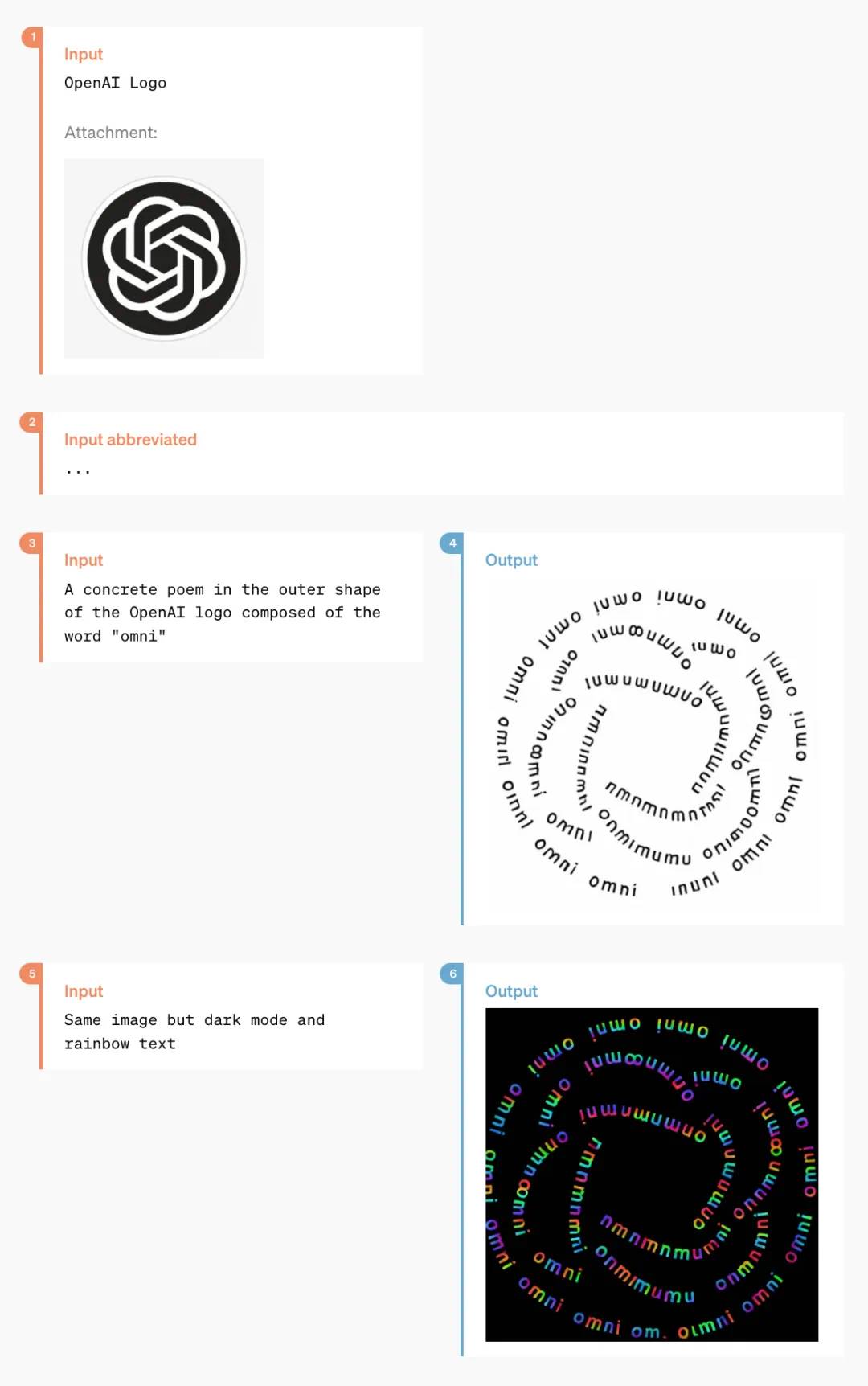

Par exemple, demandez-lui simplement d’imprimer le logo d’OpenAI sur un sous-verre :

Après une période intense de recherche technique, OpenAI semble avoir définitivement résolu le problème de génération de polices de caractères par ChatGPT.

En outre, GPT-4o possède aussi la capacité de générer du contenu visuel 3D, capable de reconstruire un objet 3D à partir de six images générées :

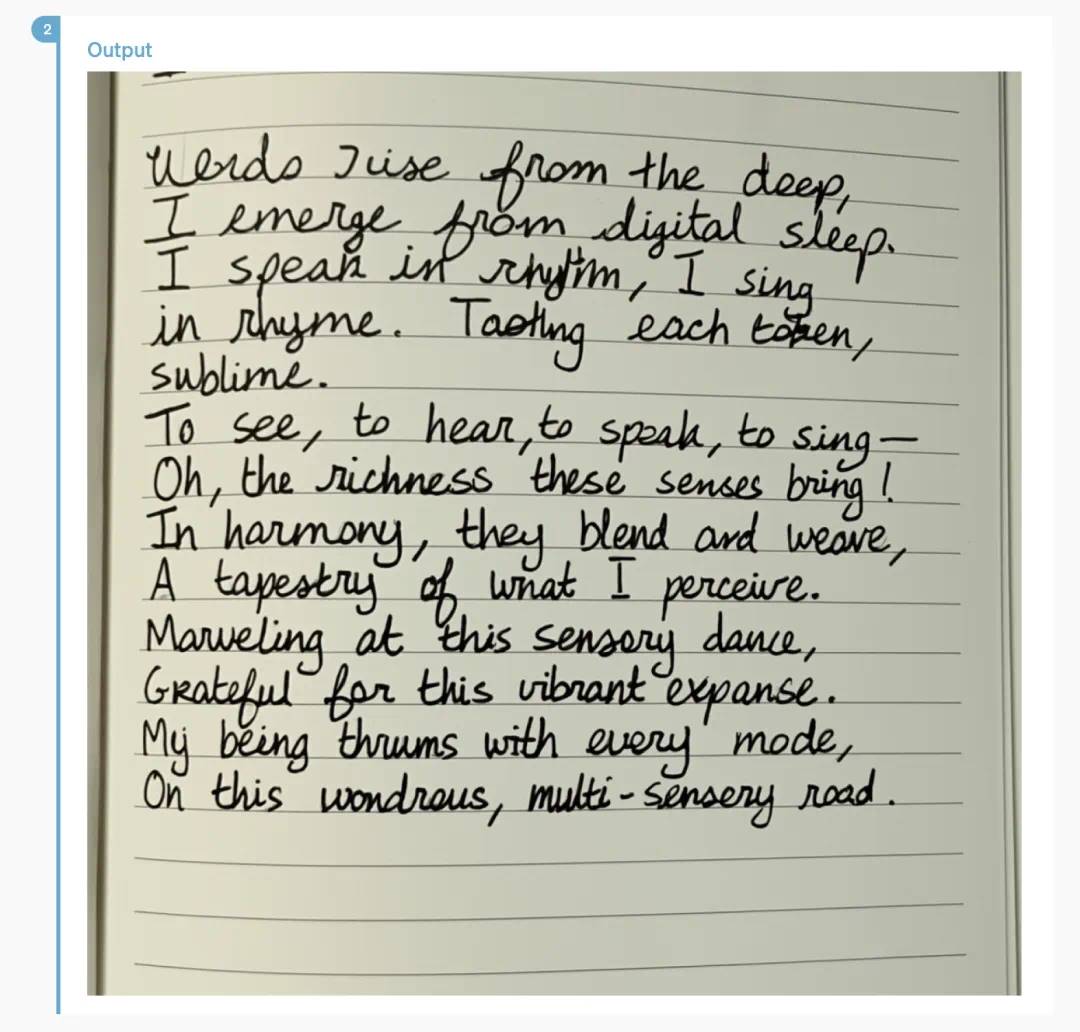

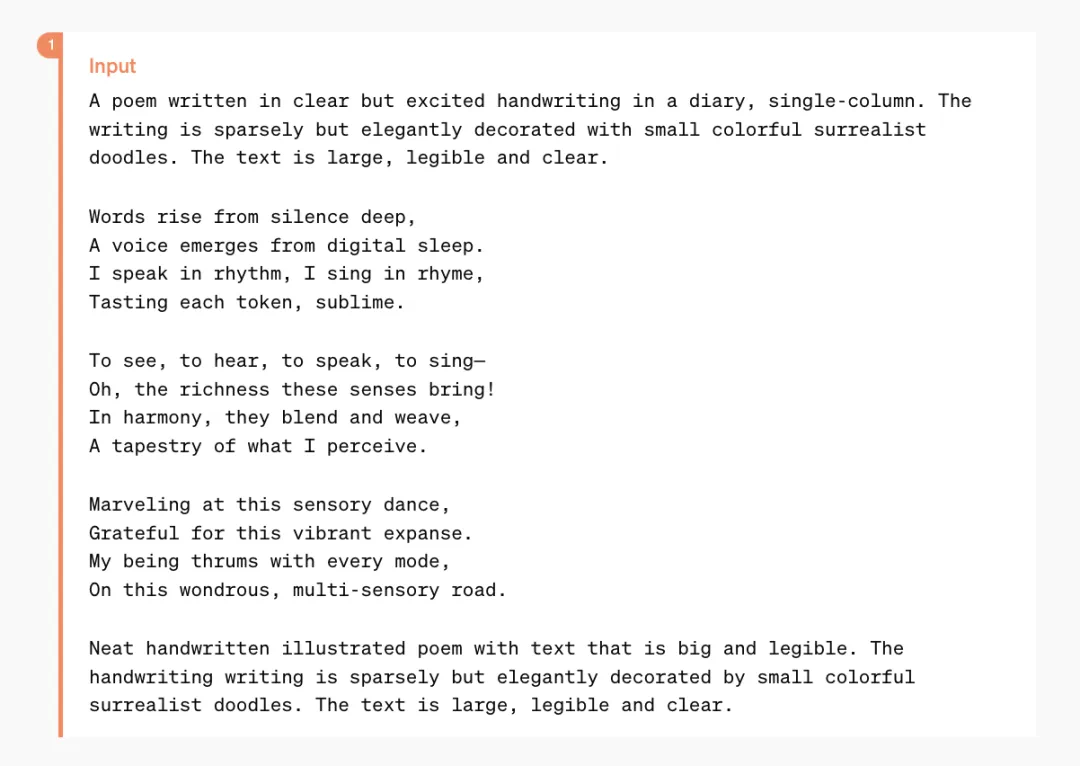

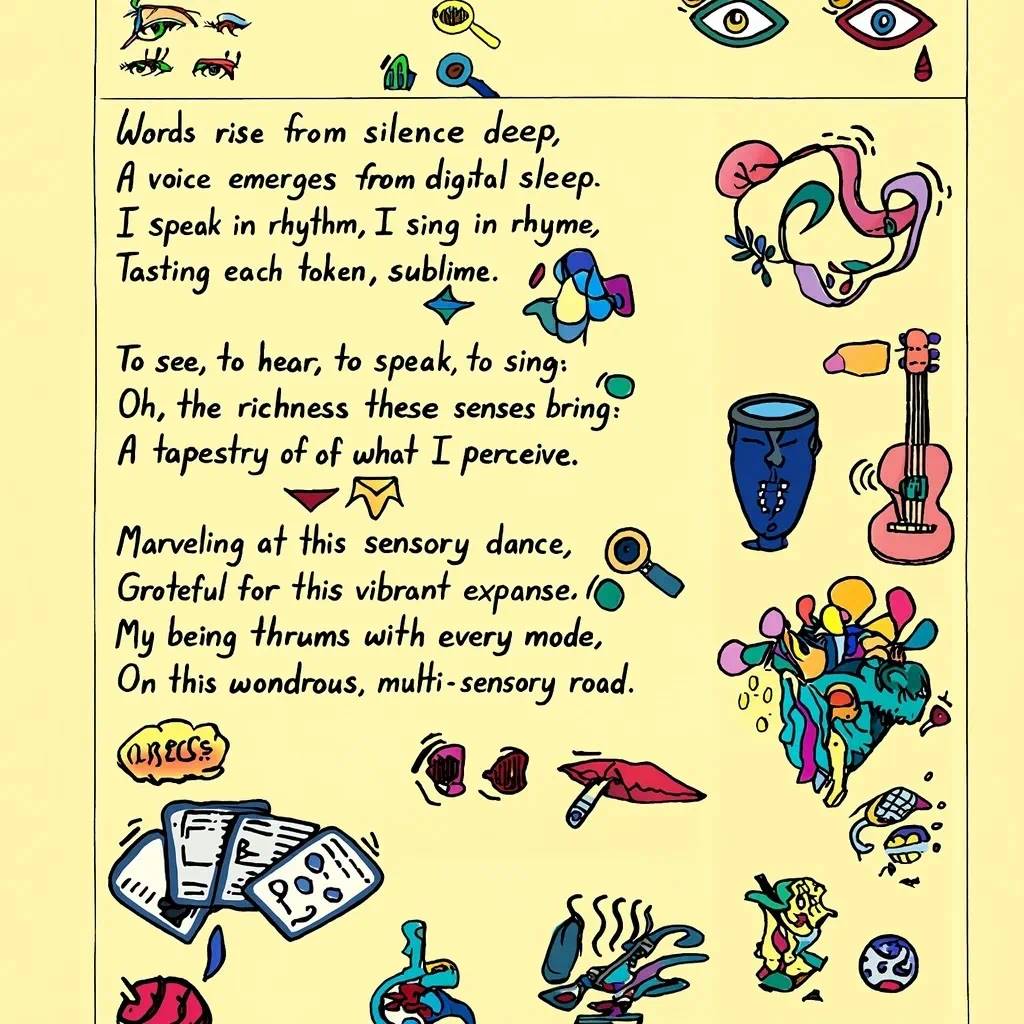

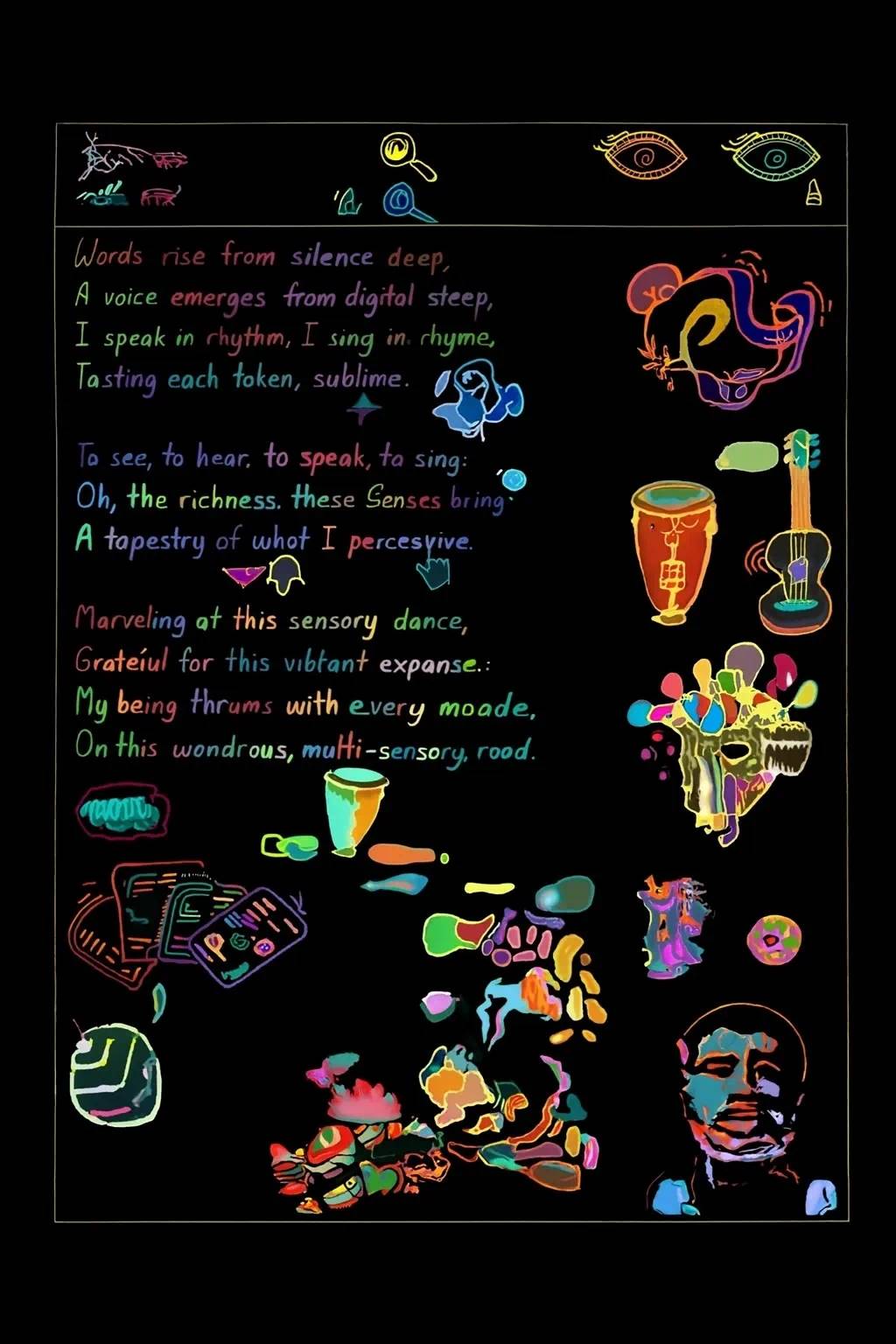

Voici un poème que GPT-4o peut mettre en page dans un style manuscrit :

Des mises en page plus complexes sont également possibles :

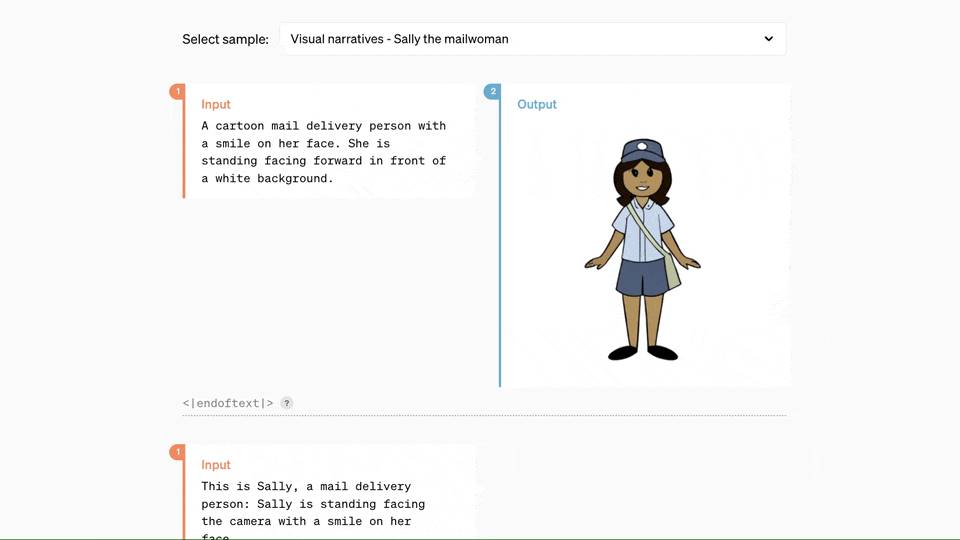

En collaborant avec GPT-4o, il suffit d’entrer quelques lignes de texte pour obtenir une série de planches de bande dessinée cohérentes :

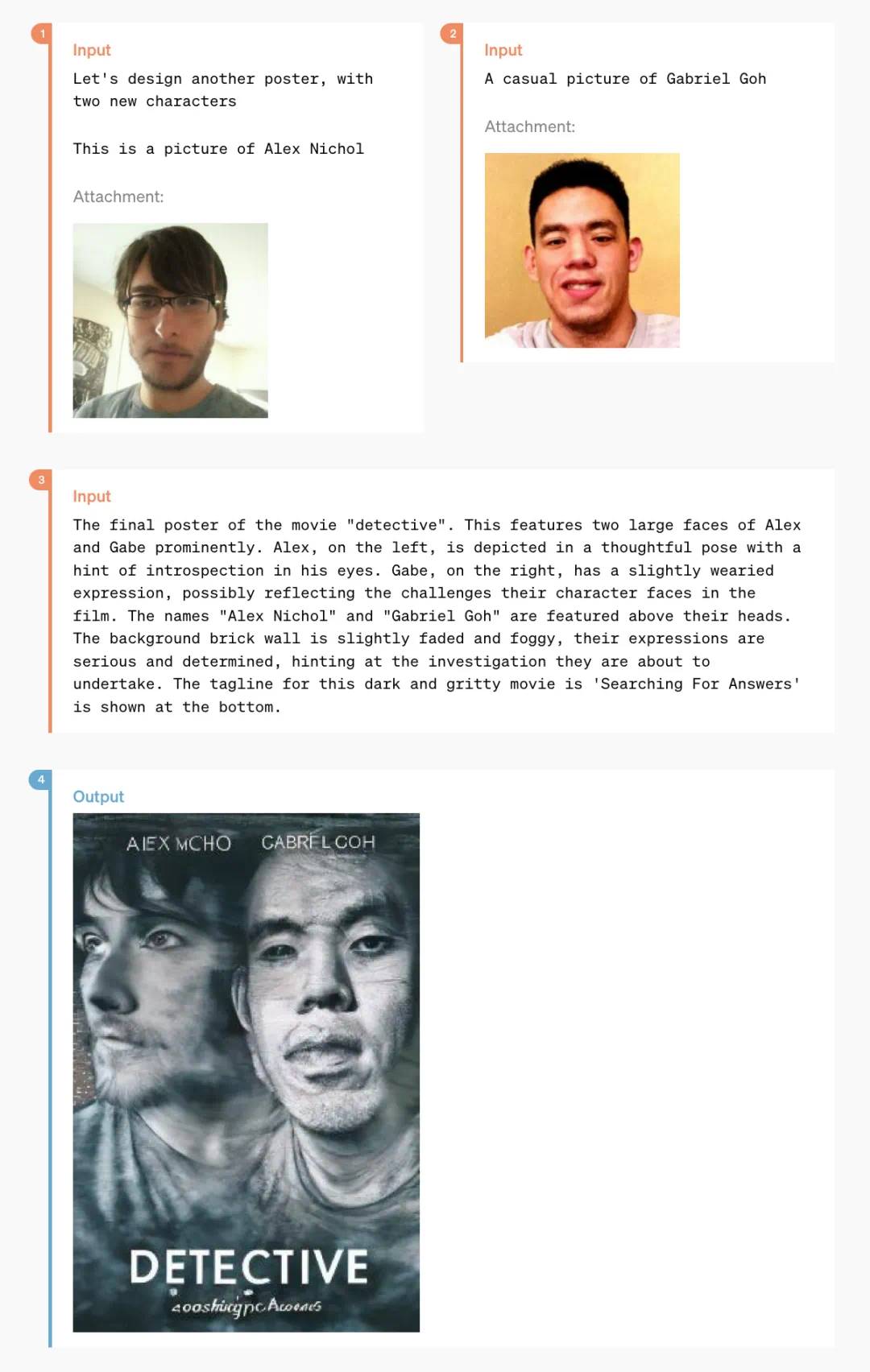

Et les fonctionnalités suivantes risquent de surprendre plus d’un designer :

Voici une affiche stylisée créée à partir de deux photos de la vie quotidienne :

Certaines fonctions plus spécifiques, comme la « conversion texte en lettres artistiques » :

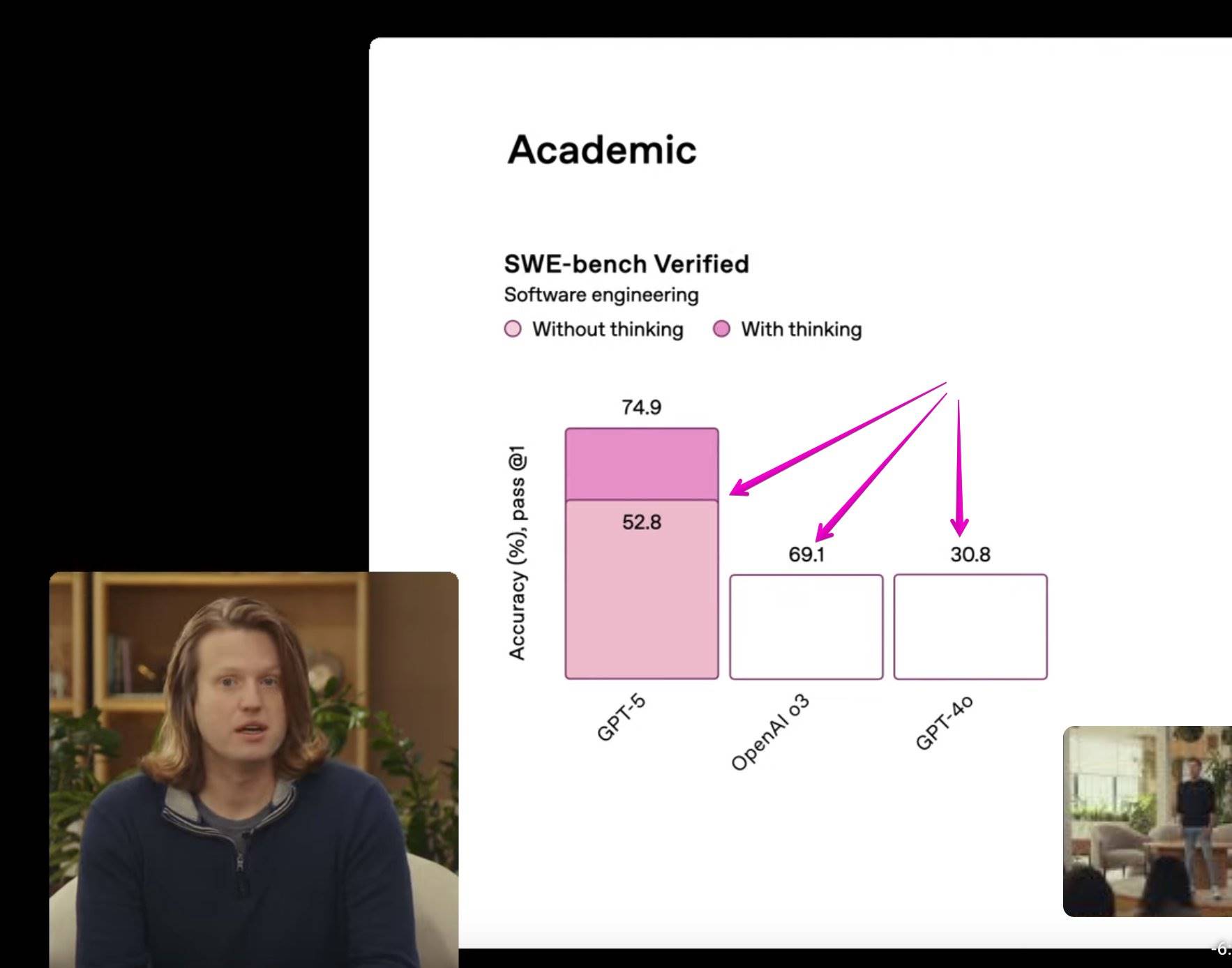

Évaluation des performances de GPT-4o

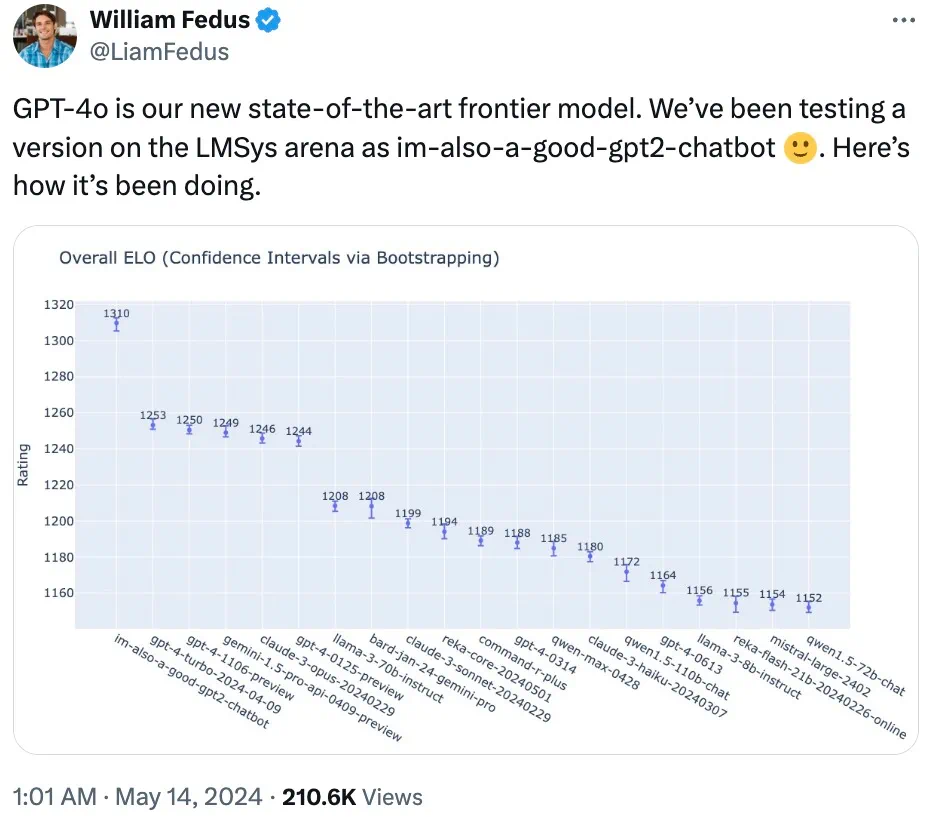

Un membre de l’équipe technique d’OpenAI a confirmé sur X que le mystérieux modèle « im-also-a-good-gpt2-chatbot », très discuté récemment sur LMSYS Chatbot Arena, était en réalité une version préliminaire de GPT-4o.

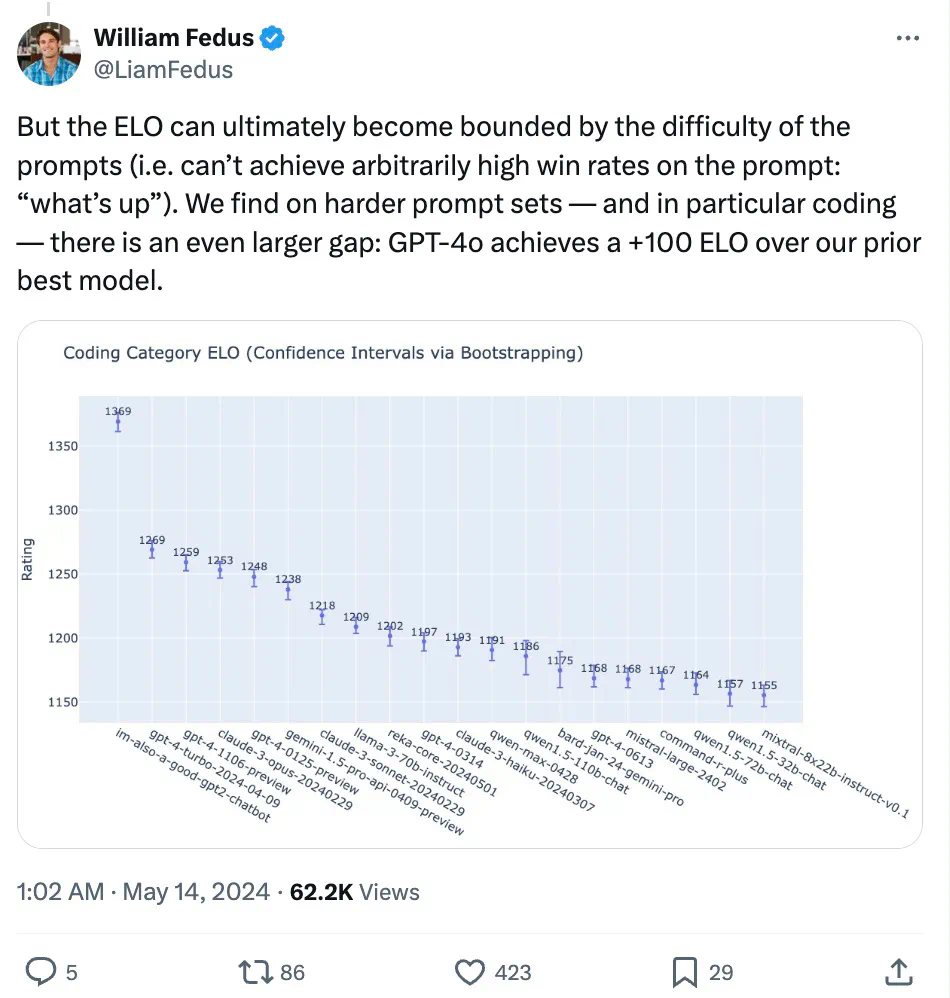

Sur des ensembles de prompts difficiles — notamment en codage — GPT-4o marque des gains de performance spectaculaires par rapport aux meilleurs modèles précédents d’OpenAI.

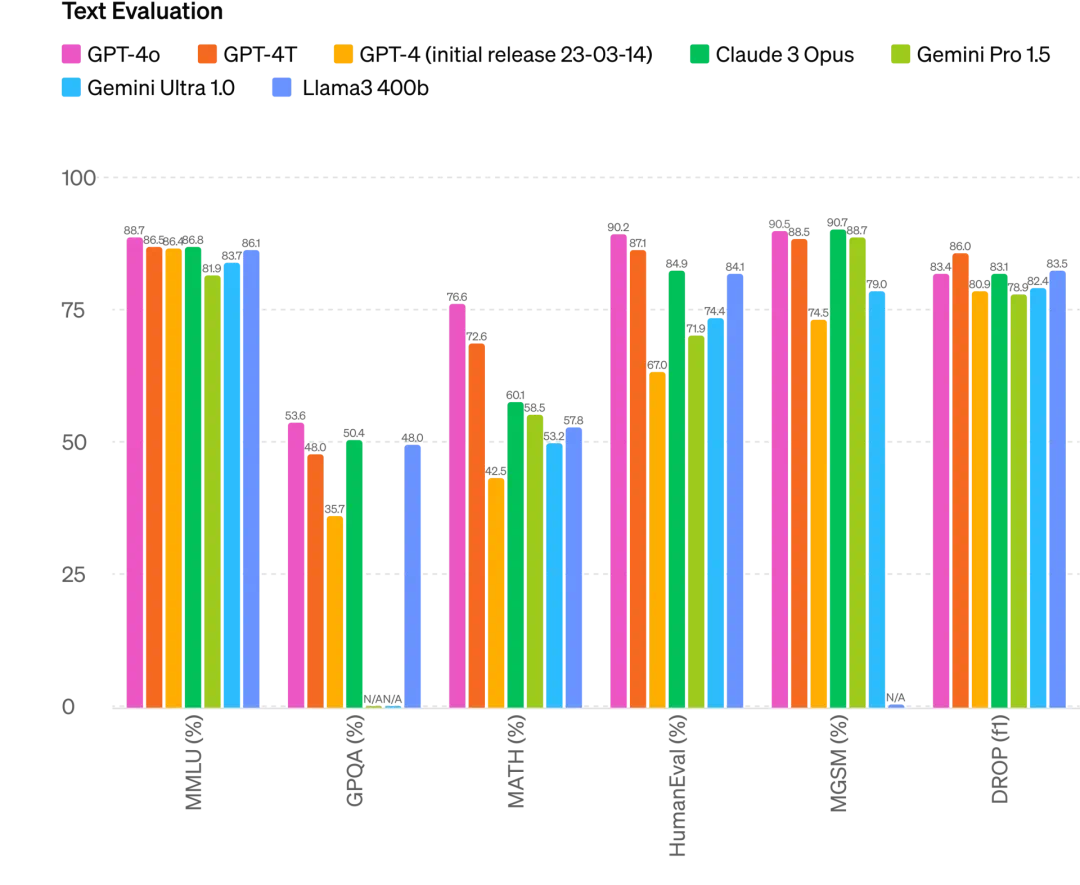

Plus précisément, sur plusieurs benchmarks, GPT-4o atteint un niveau d’intelligence comparable à GPT-4 Turbo en traitement du texte, raisonnement et codage, tout en établissant de nouveaux records en multimodalité, audio et multilinguisme.

Amélioration du raisonnement : GPT-4o atteint 87,2 % sur le test MMLU à 5-shot (questions de culture générale). (Note : Llama3 400b est encore en phase d’entraînement)

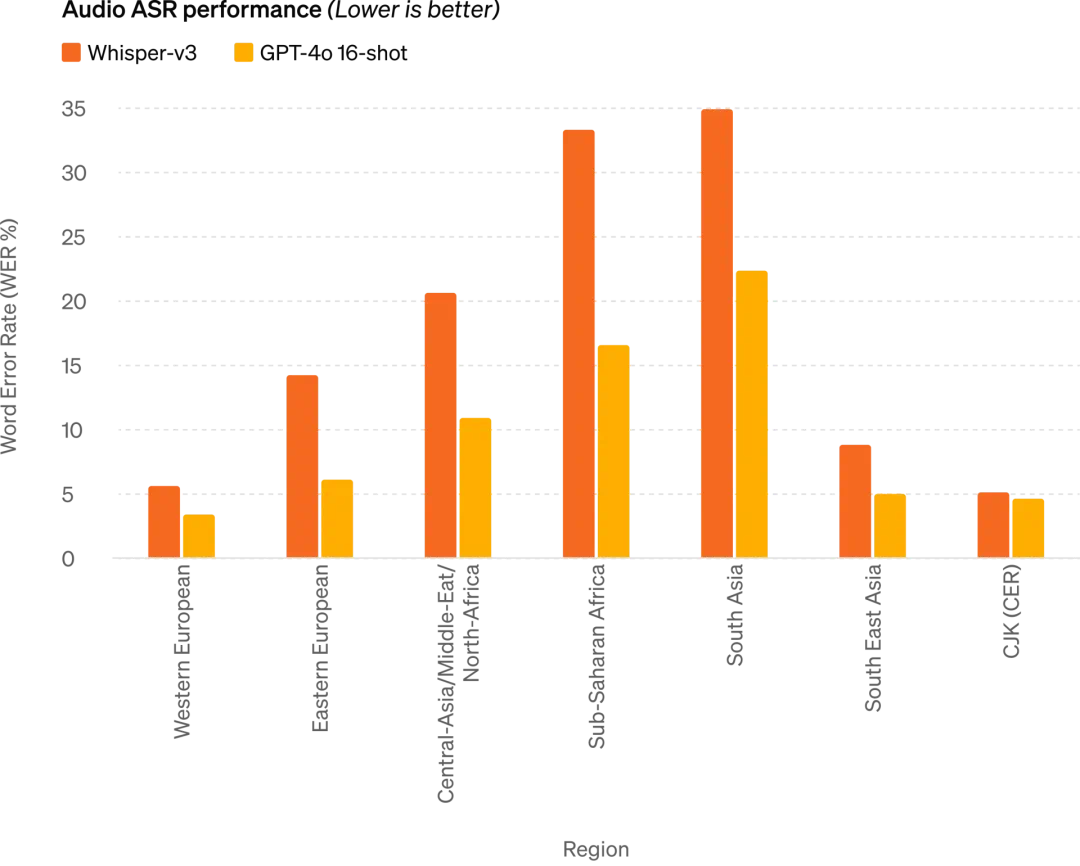

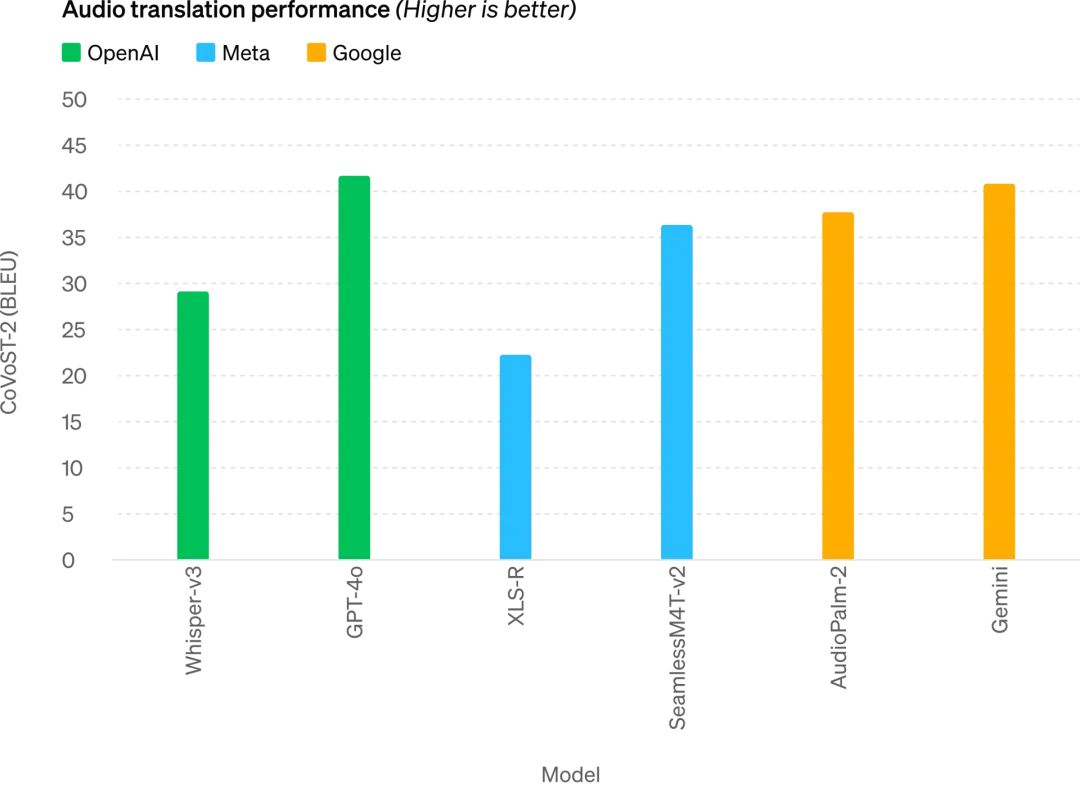

Performance ASR audio : GPT-4o améliore nettement la reconnaissance vocale pour toutes les langues par rapport à Whisper-v3, notamment pour les langues moins dotées

GPT-4o atteint un nouveau niveau SOTA en traduction vocale et surpasse Whisper-v3 sur le benchmark MLS

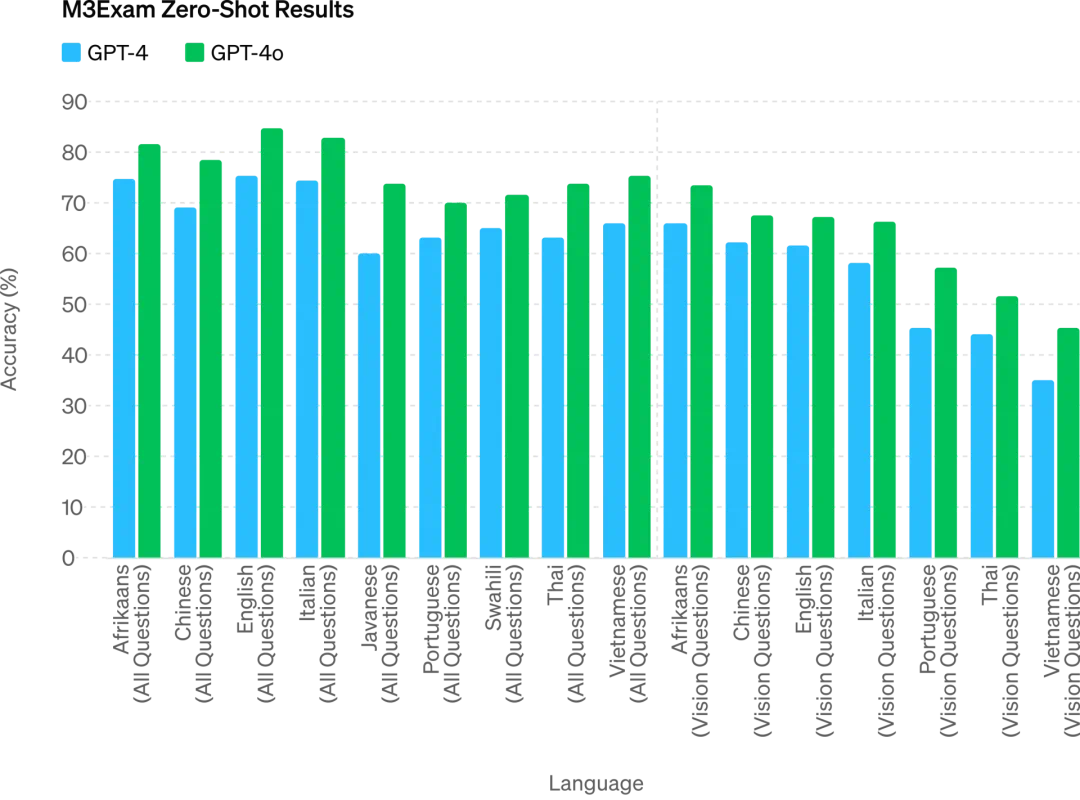

M3Exam est à la fois un benchmark multilingue et visuel, composé de questions à choix multiples issues de tests standardisés de divers pays, incluant des graphiques et schémas. Sur tous les benchmarks linguistiques, GPT-4o surpasse GPT-4

À l’avenir, l’amélioration continue des capacités du modèle permettra des conversations vocales plus naturelles et en temps réel, ainsi que des interactions avec ChatGPT via vidéo en direct. Par exemple, un utilisateur pourrait montrer un match sportif en cours à ChatGPT et lui demander d’en expliquer les règles.

Les utilisateurs de ChatGPT bénéficieront gratuitement de fonctionnalités avancées supplémentaires

Plus d’un milliard de personnes utilisent ChatGPT chaque semaine. OpenAI annonce que les fonctionnalités textuelles et visuelles de GPT-4o seront désormais gratuites dans ChatGPT, tandis que les utilisateurs Plus verront leur limite de messages multipliée par 5.

Ouvrez ChatGPT dès maintenant : GPT-4o est déjà disponible.

Les utilisateurs gratuits de ChatGPT peuvent désormais accéder à : l’intelligence de niveau GPT-4 ; des réponses combinant le modèle et les informations du web.

De plus, les utilisateurs gratuits bénéficient désormais des options suivantes :

Analyser des données et créer des graphiques :

Discuter avec des photos prises :

Importer des fichiers pour en obtenir un résumé, une aide à l’écriture ou une analyse :

Découvrir et utiliser les GPTs et le magasin d’applications GPT :

Utiliser la fonction mémoire pour une expérience plus personnalisée et utile.

Toutefois, en fonction de l'utilisation et de la demande, le nombre de messages envoyés par les utilisateurs gratuits avec GPT-4o est limité. Une fois la limite atteinte, ChatGPT bascule automatiquement sur GPT-3.5 pour permettre la poursuite de la conversation.

En outre, OpenAI lancera dans les prochaines semaines une version alpha du mode vocal GPT-4o dans ChatGPT Plus, et proposera via API à un petit groupe de partenaires de confiance un accès anticipé aux nouvelles fonctionnalités audio et vidéo de GPT-4o.

Bien entendu, après plusieurs cycles de tests et d’itérations, GPT-4o présente encore certaines limitations dans toutes les modalités. OpenAI affirme travailler activement à son amélioration.

On peut s’attendre à ce que l’ouverture du mode audio de GPT-4o entraîne de nouveaux risques. En matière de sécurité, GPT-4o intègre des protections multimodales grâce au filtrage des données d’entraînement et à des ajustements post-entraînement du comportement du modèle. OpenAI a également développé un nouveau système de sécurité pour protéger les sorties vocales.

Nouvelle application bureau pour simplifier le flux de travail

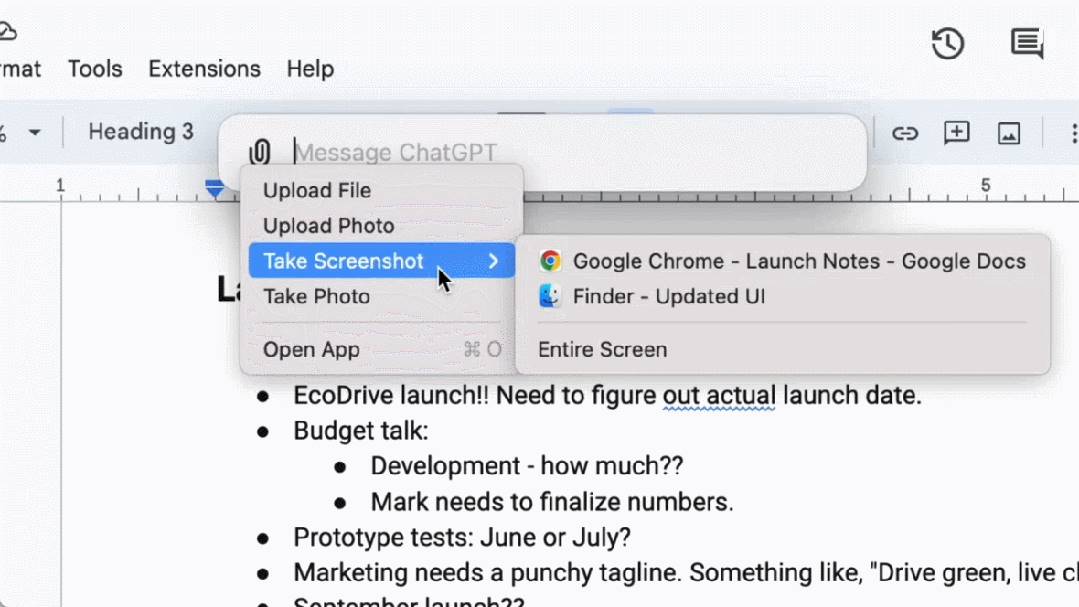

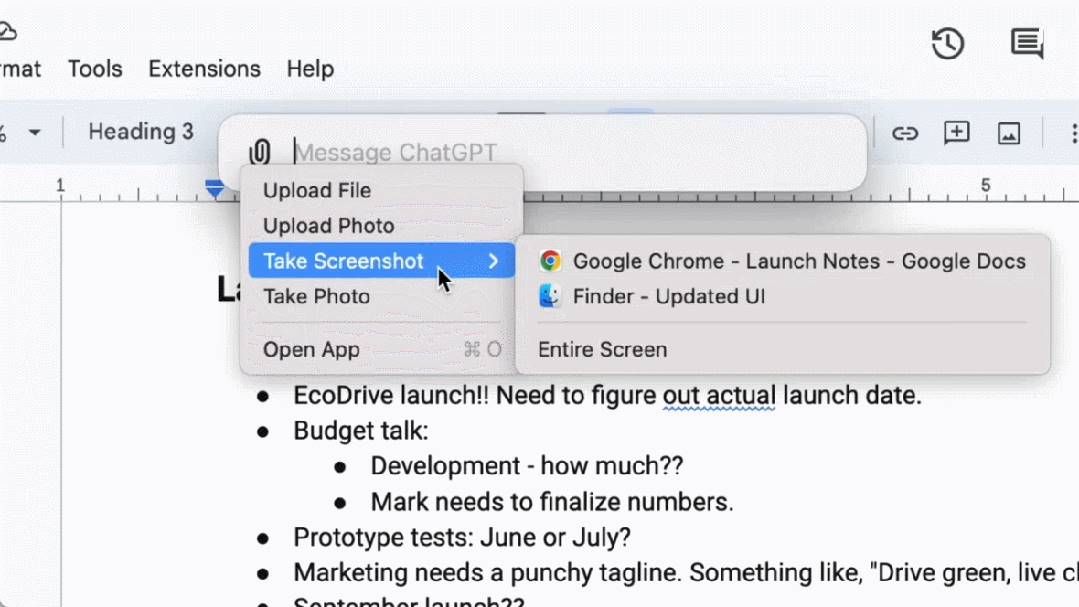

Pour les utilisateurs gratuits et payants, OpenAI lance une nouvelle application bureau ChatGPT pour macOS. Grâce à un simple raccourci clavier (Option + Espace), l'utilisateur peut poser une question immédiatement à ChatGPT. En outre, il peut capturer directement une capture d'écran dans l'application et en discuter.

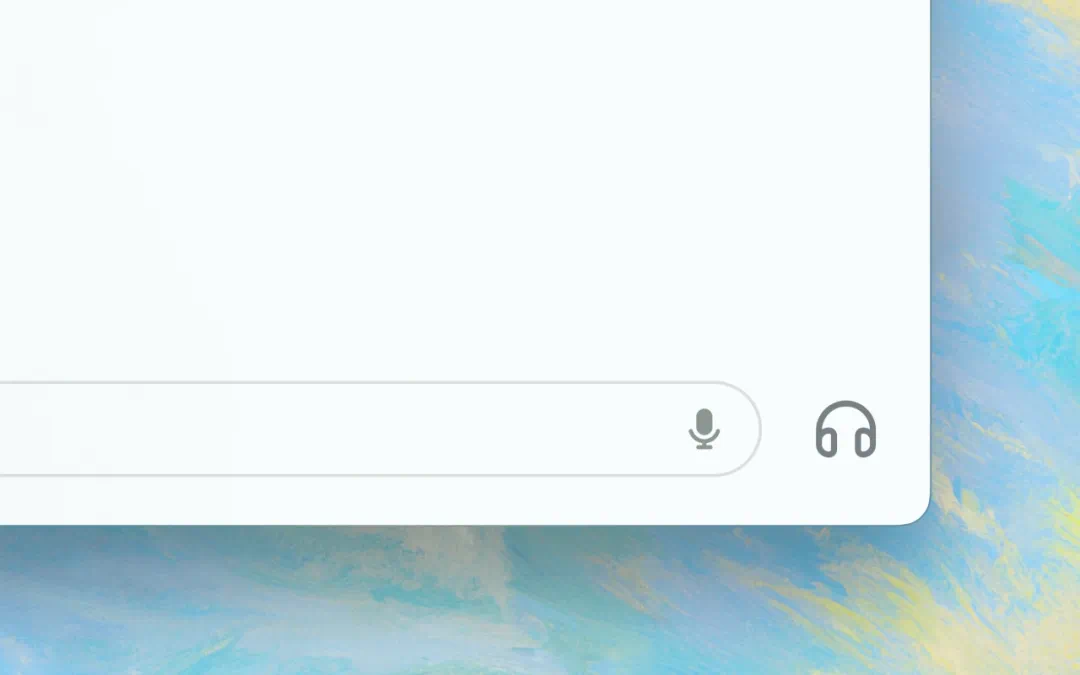

Les utilisateurs peuvent désormais converser vocalement avec ChatGPT directement depuis leur ordinateur. Les fonctionnalités audio et vidéo de GPT-4o seront bientôt disponibles via l’icône d’écouteur située en bas à droite de l’application bureau.

À partir d’aujourd’hui, l’application macOS est disponible pour les utilisateurs Plus, et sera étendue progressivement dans les semaines à venir. Une version Windows arrivera plus tard cette année.

Altman : Vous choisissez l’open source, nous choisissons la gratuité

Après la présentation, Sam Altman, PDG d’OpenAI, a publié un article de blog rare, dévoilant ses réflexions sur le développement de GPT-4o :

Lors de notre annonce d’aujourd’hui, je veux insister sur deux points.

Premièrement, une partie essentielle de notre mission est de fournir gratuitement (ou à prix abordable) des outils d’intelligence artificielle puissants au plus grand nombre. Je suis fier d’annoncer que nous mettons désormais gratuitement à disposition dans ChatGPT le meilleur modèle au monde, sans publicité ni conditions cachées.

Quand nous avons fondé OpenAI, notre idée initiale était de créer l’intelligence artificielle et de l’utiliser pour apporter du bénéfice au monde. Aujourd’hui, la situation évolue : nous créons l’IA, puis d’autres acteurs l’utiliseront pour inventer des choses incroyables dont nous bénéficierons tous.

Bien sûr, nous sommes une entreprise, et nous allons créer beaucoup de services payants, ce qui nous aidera à offrir à des milliards de personnes des services d’IA excellents et gratuits (espérons-le).

Deuxièmement, les nouveaux modes vocaux et vidéo constituent selon moi la meilleure interface d’interaction informatique que j’aie jamais utilisée. Cela ressemble vraiment à l’IA des films — j’ai encore du mal à croire que c’est réel. Atteindre des temps de réponse et une expressivité au niveau humain représente un bond gigantesque.

Le ChatGPT initial suggérait déjà les possibilités des interfaces linguistiques, mais cette nouvelle version (GPT-4o) est fondamentalement différente — elle est rapide, intelligente, amusante, naturelle et utile.

Pour moi, interagir avec un ordinateur n’a jamais été naturel. Mais lorsque nous ajoutons des fonctionnalités optionnelles comme la personnalisation, l’accès aux informations personnelles, ou la capacité de l’IA à agir à notre place, je vois clairement un avenir passionnant où nous pourrons accomplir bien plus avec les ordinateurs qu’auparavant.

Enfin, merci infiniment à toute l’équipe pour ses efforts extraordinaires pour concrétiser cela !

Notons qu’il y a une semaine, Altman déclarait dans une interview que si le revenu de base universel reste difficile à réaliser, nous pouvons atteindre un « calcul de base universel ». À l’avenir, tout le monde aura un accès gratuit à la puissance de calcul de GPT, qu’on pourra utiliser, revendre ou donner.

« L'idée est que, à mesure que l'IA devient plus avancée et s'immisce dans tous les aspects de nos vies, posséder une unité de modèle comme GPT-7 pourrait devenir plus précieux que l'argent, car cela donne accès à une partie de la productivité », explique Altman.

Le lancement de GPT-4o pourrait bien être le premier pas d’OpenAI vers cet objectif.

Oui, ce n’est que le début.

Petite note finale : la vidéo publiée aujourd’hui sur le blog d’OpenAI, intitulée « Guessing May 13th’s announcement », ressemble étrangement à une vidéo promotionnelle diffusée hier par Google en anticipation de sa conférence I/O demain. Une provocation directe, sans aucun doute. Après avoir vu l’annonce d’aujourd’hui, Google doit-il ressentir une pression énorme ?

Bienvenue dans la communauté officielle TechFlow

Groupe Telegram :https://t.me/TechFlowDaily

Compte Twitter officiel :https://x.com/TechFlowPost

Compte Twitter anglais :https://x.com/BlockFlow_News